Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Andrej Karpathy verdiente schnell 2.500 Sterne und schrieb eine minGPT-Bibliothek neu

Andrej Karpathy verdiente schnell 2.500 Sterne und schrieb eine minGPT-Bibliothek neu

Andrej Karpathy verdiente schnell 2.500 Sterne und schrieb eine minGPT-Bibliothek neu

Als repräsentatives Werk der „gewalttätigen Ästhetik“ im Bereich der künstlichen Intelligenz kann man sagen, dass GPT den 117 Millionen Parametern von GPT zu Beginn seiner Geburt das Rampenlicht gestohlen hat stieg bis auf 175 Milliarden Parameter von GPT-3. Mit der Veröffentlichung von GPT-3 hat OpenAI seine kommerzielle API für die Community geöffnet und alle dazu ermutigt, weitere Experimente mit GPT-3 durchzuführen. Für die Verwendung der API ist jedoch eine Anwendung erforderlich, und Ihre Anwendung wird wahrscheinlich zu nichts führen.

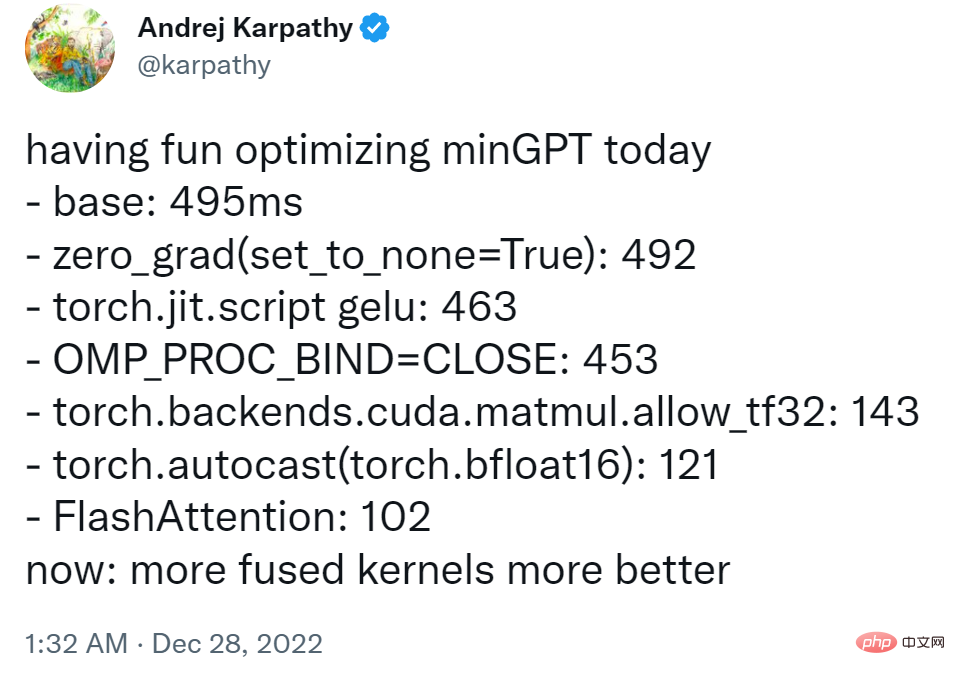

Um Forschern mit begrenzten Ressourcen den Spaß am Spielen mit großen Modellen zu ermöglichen, basierte der ehemalige Tesla-KI-Chef Andrej Karpathy auf PyTorch und verwendete nur etwa 300 Zeilen Code hat eine kleine GPT-Trainingsbibliothek erstellt und sie minGPT genannt. Dieses minGPT kann Additionsoperationen und Sprachmodellierung auf Zeichenebene durchführen, und die Genauigkeit ist nicht schlecht.

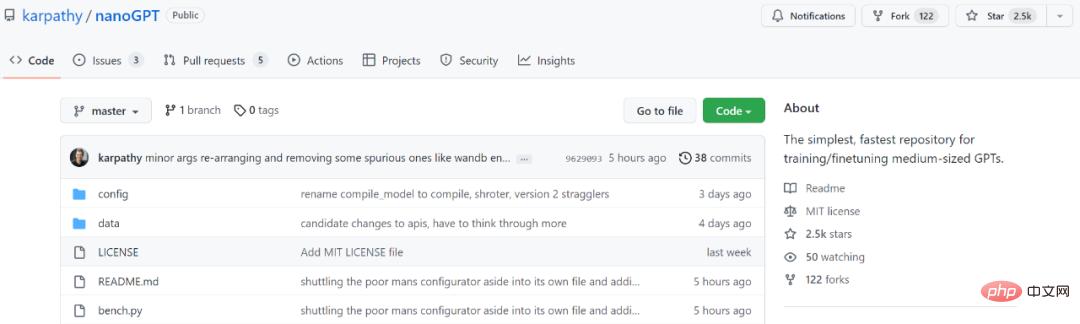

Nach zwei Jahren wurde minGPT aktualisiert und Karpathy hat eine neue Version namens NanoGPT auf den Markt gebracht. Diese Bibliothek wird zum Training und zur Feinabstimmung von GPT mittlerer Größe verwendet. In nur wenigen Tagen seit seiner Einführung hat es 2,5.000 Sterne gesammelt.

Projektadresse: https:/ /github.com/karpathy/nanoGPT

In der Projekteinführung schrieb Karpathy: „NanoGPT ist das beliebteste Tool für Training und Feinabstimmung -scale GPT. Es ist eine Neufassung von minGPT, die für mich noch in der Entwicklung ist und derzeit an der Reproduktion von GPT-2 auf dem OpenWebText-Datensatz arbeitet 🎜#

Das Ziel des NanoGPT-Codedesigns besteht darin, einfach und leicht lesbar zu sein, wobei train.py ein Code mit etwa 300 Zeilen ist; model.py ist eine GPT-Modelldefinition mit etwa 300 Zeilen Die Option, GPT-2-Gewichte von OpenAI zu laden, muss der Benutzer zunächst einige Daten als indiziertes 1D-Array hinzufügen.$ cd data/openwebtext

$ python prepare.py

$ python train.py

Wenn Sie PyTorch Distributed Data Parallelism (DDP) für das Training verwenden möchten, verwenden Sie bitte Torchrun, um das Skript auszuführen.

$ torchrun --standalone --nproc_per_node=4 train.py

Um den Code effizienter zu gestalten, können Benutzer auch Beispiele aus dem Modell verwenden:

$ python sample.py

Karpathy Angeblich hat das Projekt derzeit einen Trainingsverlust von etwa 3,74 auf einer A100 40-GB-GPU über Nacht und etwa 3,60 auf 4 GPUs. Das Training sank auf 3,1 atm mit 400.000 Iterationen (~1 Tag) auf 8 x A100 40-GB-Knoten.

Informationen zur Feinabstimmung von GPT für neuen Text finden Benutzer unter data/shakespeare und Prepare.py. Im Gegensatz zu OpenWebText wird dies in Sekunden ausgeführt. Die Feinabstimmung nimmt sehr wenig Zeit in Anspruch, z. B. nur wenige Minuten auf einer einzelnen GPU. Das Folgende ist ein Beispiel für die Feinabstimmung im laufenden Betrieb.

Freunde, die es ausprobieren möchten, können sich auf das Originalprojekt beziehen.

Das obige ist der detaillierte Inhalt vonAndrej Karpathy verdiente schnell 2.500 Sterne und schrieb eine minGPT-Bibliothek neu. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Die Vibe -Codierung verändert die Welt der Softwareentwicklung, indem wir Anwendungen mit natürlicher Sprache anstelle von endlosen Codezeilen erstellen können. Inspiriert von Visionären wie Andrej Karpathy, lässt dieser innovative Ansatz Dev

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Februar 2025 war ein weiterer bahnbrechender Monat für die Generative KI, die uns einige der am meisten erwarteten Modell-Upgrades und bahnbrechenden neuen Funktionen gebracht hat. Von Xais Grok 3 und Anthropics Claude 3.7 -Sonett, um g zu eröffnen

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Yolo (Sie schauen nur einmal) war ein führender Echtzeit-Objekterkennungsrahmen, wobei jede Iteration die vorherigen Versionen verbessert. Die neueste Version Yolo V12 führt Fortschritte vor, die die Genauigkeit erheblich verbessern

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 ist derzeit verfügbar und weit verbreitet, wodurch im Vergleich zu seinen Vorgängern wie ChatGPT 3.5 signifikante Verbesserungen beim Verständnis des Kontextes und des Generierens kohärenter Antworten zeigt. Zukünftige Entwicklungen können mehr personalisierte Inters umfassen

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google Deepmind: Eine revolutionäre KI für die Wettervorhersage Die Wettervorhersage wurde einer dramatischen Transformation unterzogen, die sich von rudimentären Beobachtungen zu ausgefeilten AI-angetriebenen Vorhersagen überschreitet. Google DeepMinds Gencast, ein Bodenbrei

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Der Artikel erörtert KI -Modelle, die Chatgpt wie Lamda, Lama und Grok übertreffen und ihre Vorteile in Bezug auf Genauigkeit, Verständnis und Branchenauswirkungen hervorheben. (159 Charaktere)

O1 gegen GPT-4O: Ist OpenAIs neues Modell besser als GPT-4O?

Mar 16, 2025 am 11:47 AM

O1 gegen GPT-4O: Ist OpenAIs neues Modell besser als GPT-4O?

Mar 16, 2025 am 11:47 AM

Openais O1: Ein 12-tägiger Geschenkbummel beginnt mit ihrem bisher mächtigsten Modell Die Ankunft im Dezember bringt eine globale Verlangsamung, Schneeflocken in einigen Teilen der Welt, aber Openai fängt gerade erst an. Sam Altman und sein Team starten ein 12-tägiges Geschenk Ex

So verwenden Sie Mistral OCR für Ihr nächstes Lappenmodell

Mar 21, 2025 am 11:11 AM

So verwenden Sie Mistral OCR für Ihr nächstes Lappenmodell

Mar 21, 2025 am 11:11 AM

Mistral OCR: revolutionäre retrieval-ausgereifte Generation mit multimodalem Dokumentverständnis RAG-Systeme (Abrufen-Augment-Augmented Generation) haben erheblich fortschrittliche KI