Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wie kann man die Leistung des Sprachmodells verbessern, wenn man nur über eine begrenzte Rechenleistung verfügt? Google hat eine neue Idee

Wie kann man die Leistung des Sprachmodells verbessern, wenn man nur über eine begrenzte Rechenleistung verfügt? Google hat eine neue Idee

Wie kann man die Leistung des Sprachmodells verbessern, wenn man nur über eine begrenzte Rechenleistung verfügt? Google hat eine neue Idee

In den letzten Jahren haben Sprachmodelle (LM) in der Forschung zur Verarbeitung natürlicher Sprache (NLP) an Bedeutung gewonnen und in der Praxis zunehmend an Einfluss gewonnen. Im Allgemeinen hat sich gezeigt, dass die Vergrößerung eines Modells die Leistung bei einer Reihe von NLP-Aufgaben verbessert.

Allerdings liegt auch die Herausforderung der Skalierung des Modells auf der Hand: Das Training neuer, größerer Modelle erfordert viele Rechenressourcen. Darüber hinaus werden neue Modelle oft von Grund auf trainiert und können die Trainingsgewichte früherer Modelle nicht nutzen.

Für dieses Problem haben Google-Forscher zwei komplementäre Methoden untersucht, um die Leistung bestehender Sprachmodelle deutlich zu verbessern, ohne viele zusätzliche Rechenressourcen zu verbrauchen.

Zunächst stellten die Forscher im Artikel „Transcending Scaling Laws with 0.1 % Extra Compute“ UL2R vor, ein leichtes Pre-Training-Modell der zweiten Stufe, das ein Hybrid-Enoisers-Ziel verwendet. UL2R verbessert die Leistung bei einer Reihe von Aufgaben und ermöglicht Leistungsschübe selbst bei Aufgaben, die zuvor eine nahezu zufällige Leistung aufwiesen.

Link zum Papier: https://arxiv.org/pdf/2210.11399.pdf

Darüber hinaus wird in „Scaling Instruction-Finetuned Language Models“ ein anweisungsbasiertes Sprachmodell besprochen. Das Problem der Feinabstimmung des Sprachmodells am Datensatz ist ein Prozess, den wir „Flan“ nennen. Dieser Ansatz verbessert nicht nur die Leistung, sondern auch die Verwendbarkeit des Sprachmodells für Benutzereingaben.

Link zum Papier: https://arxiv.org/abs/2210.11416 Das Modell übertrifft das unbereinigte PaLM 540B-Modell in einer Reihe anspruchsvoller Bewertungsbenchmarks um 10 %.

Training von UL2R

Traditionell werden die meisten Sprachmodelle auf kausale Sprachmodellierungsziele vorab trainiert, sodass das Modell das nächste Wort in einer Sequenz (wie GPT-3 oder PaLM) oder das Entrauschungsziel vorhersagen kann. Dabei lernt das Modell, ursprüngliche Sätze aus beschädigten Wortsequenzen wiederherzustellen (wie T5). Obwohl es einige Kompromisse beim Ziel der Sprachmodellierung gibt, d. Die Forscher zeigten, dass Hybrid-Enoiser mit beiden Zielen in beiden Fällen eine bessere Leistung erzielen.

Allerdings ist es rechentechnisch schwierig, große Sprachmodelle von Grund auf auf verschiedenen Zielen vorab zu trainieren. Daher schlagen wir die UL2-Reparatur (UL2R) vor, eine zusätzliche Stufe, die das Vortraining mit dem UL2-Ziel fortsetzt und nur einen relativ geringen Rechenaufwand erfordert.

Wir wenden UL2R auf PaLM an und nennen das resultierende neue Sprachmodell U-PaLM.

In unserer empirischen Auswertung haben wir festgestellt, dass sich das Modell mit nur geringem UL2-Training deutlich verbesserte.

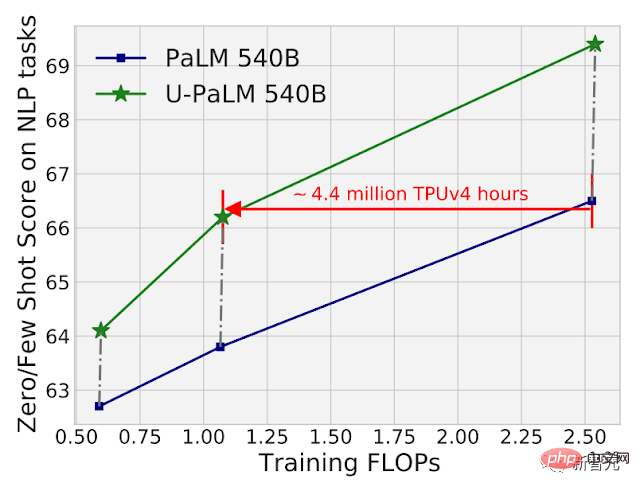

Durch die Verwendung von UL2R am Zwischenkontrollpunkt von PaLM 540B ist es beispielsweise möglich, die Leistung von PaLM 540B am Endkontrollpunkt zu erreichen und dabei die doppelte Berechnung zu verwenden. Natürlich wird die Anwendung von UL2R auf den letzten PaLM 540B-Kontrollpunkt auch enorme Verbesserungen bringen.

Vergleich der Berechnungs- und Modellleistung von PaLM 540B und U-PaLM 540B bei 26 NLP-Benchmarks. U-PaLM 540B trainiert PaLM weiterhin mit einem sehr geringen Rechenaufwand, aber einer großen Leistungsverbesserung.

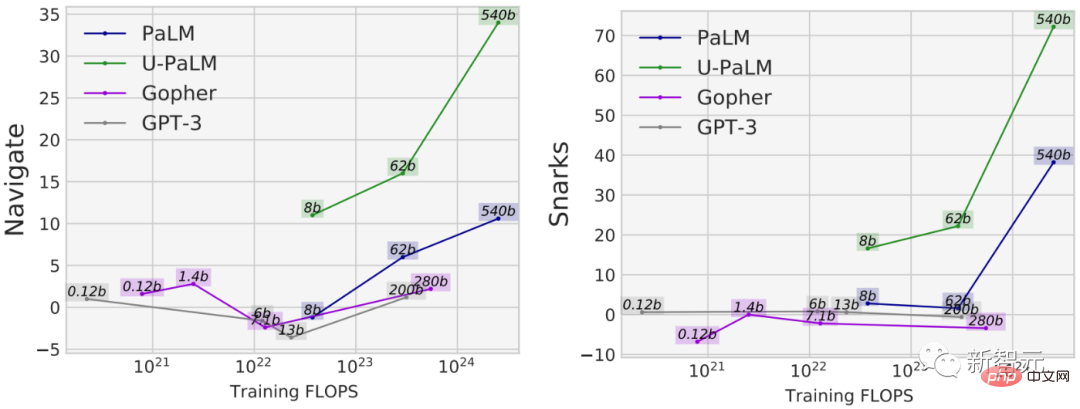

Ein weiterer Vorteil der Verwendung von UL2R besteht darin, dass es bei einigen Aufgaben eine viel bessere Leistung erbringt als Modelle, die ausschließlich auf kausale Sprachmodellierungsziele trainiert wurden. Beispielsweise gibt es viele BIG-Bench-Aufgaben mit sogenannten „Emergent Capabilities“, also Fähigkeiten, die nur in ausreichend großen Sprachmodellen verfügbar sind.

Während die häufigste Methode zur Entdeckung neuer Fähigkeiten darin besteht, das Modell zu vergrößern, kann UL2R tatsächlich neue Fähigkeiten inspirieren, ohne das Modell zu vergrößern.

In der Navigationsaufgabe von BIG-Bench wird beispielsweise die Fähigkeit des Modells zur Zustandsverfolgung gemessen. Mit Ausnahme von U-PaLM liegen die Trainings-FLOPs aller Modelle unter 10^23. Ein weiteres Beispiel ist die Snarks-Aufgabe von BIG-Bench, die die Fähigkeit eines Modells misst, sarkastische Sprache zu erkennen.

Für beide Funktionen von BIG-Bench, die die Leistung neuer Aufgaben demonstrieren, erreicht U-PaLM aufgrund der Verwendung des UL2R-Ziels neue Leistung bei einer kleineren Modellgröße.

Anleitungs-Feinabstimmung

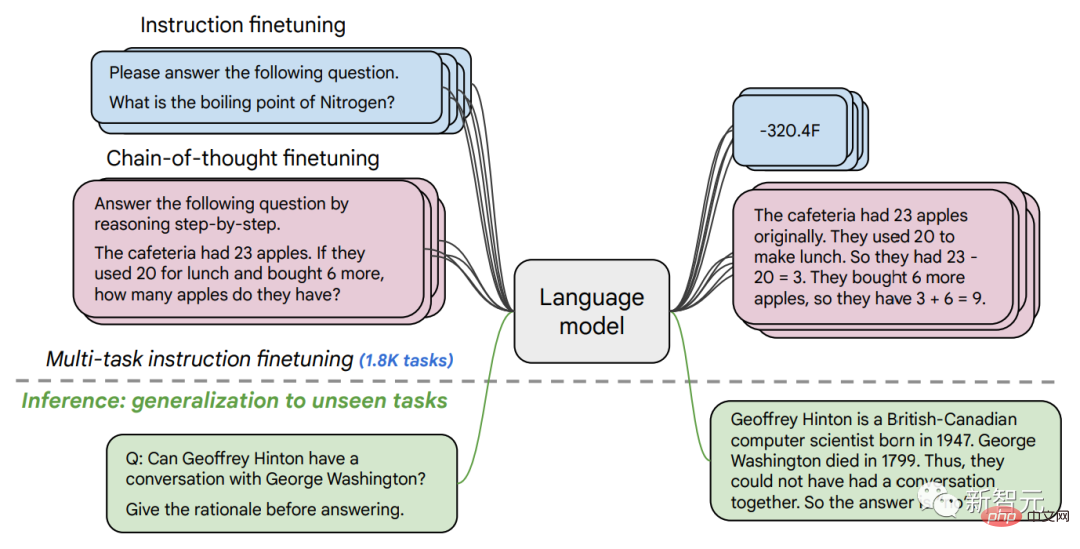

Im zweiten Artikel untersuchen wir die Anweisungs-Feinabstimmung, bei der es um die Feinabstimmung eines LM anhand eines Satzes von NLP-Datensätzen geht, die mit Anweisungen formuliert sind.

In früheren Arbeiten haben wir die Feinabstimmung der Anweisungen auf ein 137B-Parametermodell bei 62 NLP-Aufgaben angewendet, beispielsweise auf die Beantwortung einer kurzen Frage, die Klassifizierung von in Filmen ausgedrückten Emotionen oder die Übersetzung von Sätzen ins Spanische.

In dieser Arbeit haben wir ein 540B-Parameter-Sprachmodell für über 1,8K Aufgaben verfeinert. Darüber hinaus wurden in früheren Arbeiten nur Sprachmodelle mit wenigen Beispielen (z. B. MetaICL) oder Null-Instanz-Sprachmodelle ohne Beispiele (z. B. FLAN, T0) optimiert, während wir eine Kombination aus beiden optimieren.

Wir beziehen auch Daten zur Feinabstimmung der Denkkette ein, die es dem Modell ermöglichen, mehrstufige Inferenzen durchzuführen. Wir nennen unsere verbesserte Methode „Flan“ zur Feinabstimmung von Sprachmodellen.

Es ist erwähnenswert, dass Flan selbst bei einer Feinabstimmung auf 1,8K-Aufgaben nur einen Bruchteil der Berechnung im Vergleich zum Vortraining benötigt (für PaLM 540B erfordert Flan nur 0,2 % der Berechnung vor dem Training)) .

Feinabstimmung des Sprachmodells für 1,8K-Aufgaben, die in Form von Anweisungen formuliert sind, und Bewertung des Modells für neue Aufgaben, die nicht in der Feinabstimmung enthalten sind. Die Feinabstimmung erfolgt mit/ohne Beispielen (d. h. 0-Schuss und wenige Schüsse) und mit/ohne Gedankenketten, sodass das Modell auf eine Reihe von Bewertungsszenarien verallgemeinert werden kann.

In diesem Artikel werden LMs verschiedener Größen einer Feinabstimmung der Anweisungen unterzogen, mit dem Ziel, die gemeinsamen Auswirkungen der gleichzeitigen Vergrößerung der Größe des Sprachmodells und der Erhöhung der Anzahl der Feinabstimmungsaufgaben zu untersuchen.

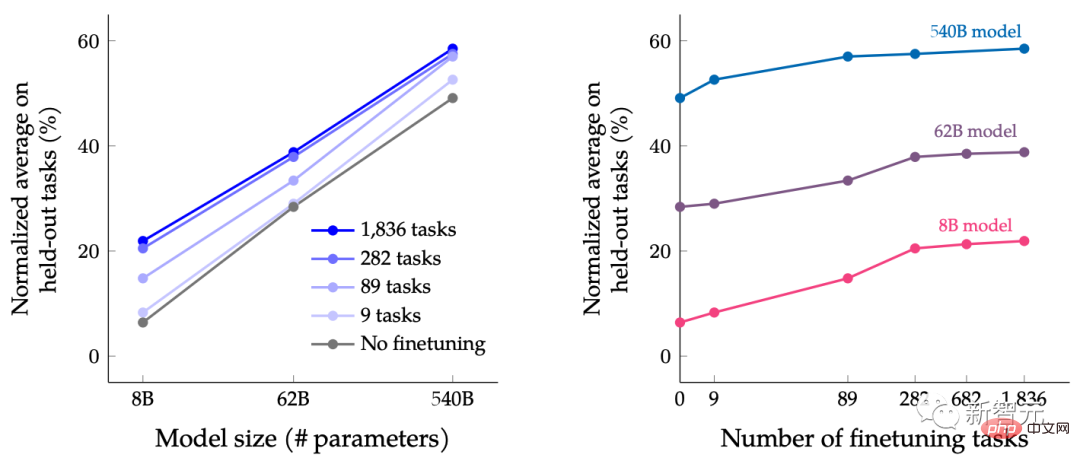

Zum Beispiel für das Sprachmodell der PaLM-Klasse, einschließlich der Parameterspezifikationen 8B, 62B und 540B. Unser Modell wurde anhand von vier anspruchsvollen Benchmark-Bewertungskriterien (MMLU, BBH, TyDiQA und MGSM) bewertet und festgestellt, dass sowohl die Erweiterung der Anzahl der Parameter als auch die Feinabstimmung der Anzahl der Aufgaben die Leistung bei neuen und bisher nicht gesehenen Aufgaben verbessern kann.

Durch die Erweiterung des Parametermodells auf 540B und die Verwendung von 1,8K-Feinabstimmungsaufgaben kann die Leistung verbessert werden. Die y-Achse der obigen Abbildung ist der normalisierte Mittelwert der vier Bewertungssuiten (MMLU, BBH, TyDiQA und MGSM).

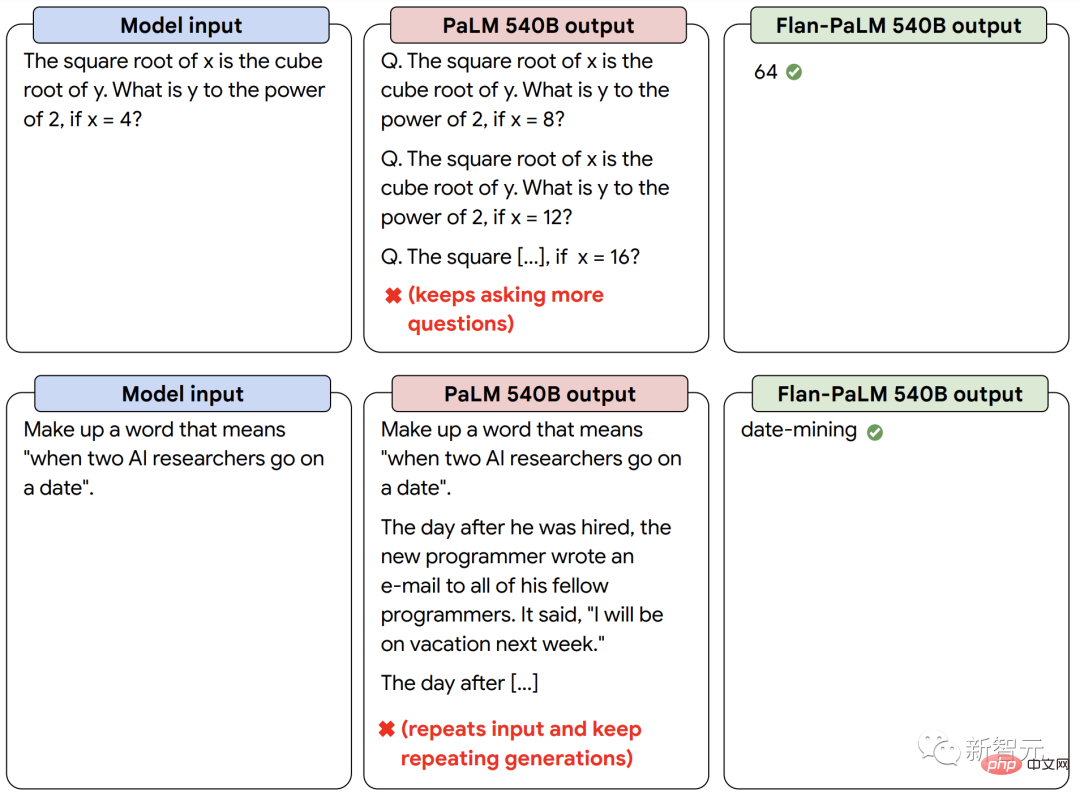

Zusätzlich zu einer besseren Leistung ist LM durch die Feinabstimmung von Anweisungen in der Lage, zum Zeitpunkt der Inferenz auf Benutzeranweisungen zu reagieren, ohne dass eine kleine Anzahl von Beispielen oder Hinweis-Engineering erforderlich ist. Dies macht LM bei einer Reihe von Eingaben benutzerfreundlicher. Beispielsweise machen LMs ohne Befehlsfeinabstimmung manchmal wiederholte Eingaben oder befolgen Anweisungen nicht, aber eine Befehlsfeinabstimmung kann solche Fehler abmildern.

Unser instruktionsfein abgestimmtes Sprachmodell Flan-PaLM reagiert besser auf Anweisungen als das PaLM-Modell ohne Instruktionsfeinabstimmung.

Mächtige Kräfte bündeln, um „1+1>2“ zu erreichen

Abschließend zeigen wir, dass UL2R und Flan kombiniert werden können, um das Flan-U-PaLM-Modell zu trainieren.

Da Flan neue Daten aus NLP-Aufgaben verwendet und eine Nullpunkt-Anweisungsverfolgung implementieren kann, verwenden wir Flan als Methode zweiter Wahl nach UL2R.

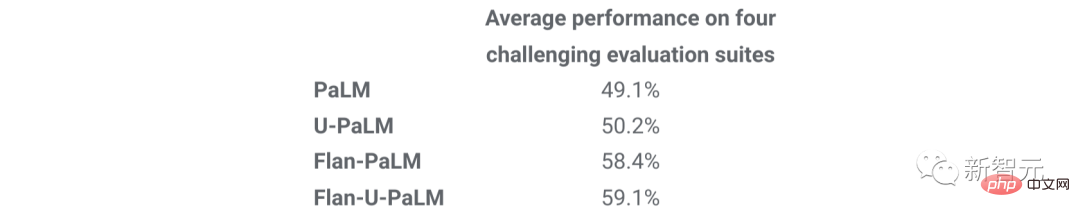

Wir bewerten erneut die vier Benchmark-Suiten und stellen fest, dass das Flan-U-PaLM-Modell das PaLM-Modell mit nur UL2R (U-PaLM) oder nur Flan (Flan-PaLM) übertrifft. Darüber hinaus erreicht Flan-U-PaLM in Kombination mit Gedankenverkettung und Selbstkonsistenz einen neuen SOTA im MMLU-Benchmark mit einer Punktzahl von 75,4 %.

Die Kombination von UL2R und Flan (Flan-U-PaLM) führt zu der besten Leistung im Vergleich zur Verwendung von nur UL2R (U-PaLM) oder nur der Verwendung von Flan (Flan-U-PaLM): Normalisierter Durchschnitt von vier Bewertungen Suiten (MMLU, BBH, TyDiQA und MGSM).

Zusammenfassend sind UL2R und Flan zwei komplementäre Methoden zur Verbesserung vorab trainierter Sprachmodelle. UL2R verwendet dieselben Daten, um LM an die gemischten Ziele der Denoiser anzupassen, während Flan Trainingsdaten aus über 1,8.000 NLP-Aufgaben nutzt, um dem Modell beizubringen, Anweisungen zu befolgen.

Mit zunehmender Größe der Sprachmodelle werden Techniken wie UL2R und Flan, die die allgemeine Leistung verbessern können, ohne dass umfangreiche Berechnungen erforderlich sind, möglicherweise immer attraktiver.

Das obige ist der detaillierte Inhalt vonWie kann man die Leistung des Sprachmodells verbessern, wenn man nur über eine begrenzte Rechenleistung verfügt? Google hat eine neue Idee. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Wie man Deepseek kommentiert

Feb 19, 2025 pm 05:42 PM

Wie man Deepseek kommentiert

Feb 19, 2025 pm 05:42 PM

Deepseek ist ein leistungsstarkes Informations -Abruf -Tool. .

So suchen Sie Deepseek

Feb 19, 2025 pm 05:39 PM

So suchen Sie Deepseek

Feb 19, 2025 pm 05:39 PM

Deepseek ist eine proprietäre Suchmaschine, die nur schneller und genauer in einer bestimmten Datenbank oder einem bestimmten System sucht. Bei der Verwendung wird den Benutzern empfohlen, das Dokument zu lesen, verschiedene Suchstrategien auszuprobieren, Hilfe und Feedback zur Benutzererfahrung zu suchen, um die Vorteile optimal zu nutzen.

Sesame Open Door Exchange -Webseite Registrierung Link Gate Trading App Registrierung Website Neueste

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange -Webseite Registrierung Link Gate Trading App Registrierung Website Neueste

Feb 28, 2025 am 11:06 AM

In diesem Artikel wird der Registrierungsprozess der Webversion Sesam Open Exchange (GATE.IO) und die Gate Trading App im Detail vorgestellt. Unabhängig davon, ob es sich um eine Webregistrierung oder eine App -Registrierung handelt, müssen Sie die offizielle Website oder den offiziellen App Store besuchen, um die Genuine App herunterzuladen, und dann den Benutzernamen, das Kennwort, die E -Mail, die Mobiltelefonnummer und die anderen Informationen eingeben und eine E -Mail- oder Mobiltelefonüberprüfung abschließen.

Warum kann der Bybit -Exchange -Link nicht direkt heruntergeladen und installiert werden?

Feb 21, 2025 pm 10:57 PM

Warum kann der Bybit -Exchange -Link nicht direkt heruntergeladen und installiert werden?

Feb 21, 2025 pm 10:57 PM

Warum kann der Bybit -Exchange -Link nicht direkt heruntergeladen und installiert werden? Bitbit ist eine Kryptowährungsbörse, die den Benutzern Handelsdienste anbietet. Die mobilen Apps der Exchange können aus den folgenden Gründen nicht direkt über AppStore oder Googleplay heruntergeladen werden: 1. App Store -Richtlinie beschränkt Apple und Google daran, strenge Anforderungen an die im App Store zulässigen Anwendungsarten zu haben. Kryptowährungsanträge erfüllen diese Anforderungen häufig nicht, da sie Finanzdienstleistungen einbeziehen und spezifische Vorschriften und Sicherheitsstandards erfordern. 2. Die Einhaltung von Gesetzen und Vorschriften In vielen Ländern werden Aktivitäten im Zusammenhang mit Kryptowährungstransaktionen reguliert oder eingeschränkt. Um diese Vorschriften einzuhalten, kann die Bitbit -Anwendung nur über offizielle Websites oder andere autorisierte Kanäle verwendet werden

Sesame Open Door Trading Platform Download Mobile Version Gateio Trading Platform Download -Adresse

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Mobile Version Gateio Trading Platform Download -Adresse

Feb 28, 2025 am 10:51 AM

Es ist wichtig, einen formalen Kanal auszuwählen, um die App herunterzuladen und die Sicherheit Ihres Kontos zu gewährleisten.

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Mar 18, 2025 pm 12:15 PM

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Mar 18, 2025 pm 12:15 PM

Dieser Artikel empfiehlt die Top Ten Ten Cryptocurrency -Handelsplattformen, die es wert sind, auf Binance, OKX, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, BYDFI und Xbit -dezentrale Börsen geachtet zu werden. Diese Plattformen haben ihre eigenen Vorteile in Bezug auf Transaktionswährungsmenge, Transaktionstyp, Sicherheit, Konformität und Besonderheiten. Die Auswahl einer geeigneten Plattform erfordert eine umfassende Überlegung, die auf eigener Handelserfahrung, Risikotoleranz und Investitionspräferenzen basiert. Ich hoffe, dieser Artikel hilft Ihnen dabei, den besten Anzug für sich selbst zu finden

Binance Binance Offizielle Website Neueste Version Anmeldeportal

Feb 21, 2025 pm 05:42 PM

Binance Binance Offizielle Website Neueste Version Anmeldeportal

Feb 21, 2025 pm 05:42 PM

Befolgen Sie diese einfachen Schritte, um auf die neueste Version des Binance -Website -Login -Portals zuzugreifen. Gehen Sie zur offiziellen Website und klicken Sie in der oberen rechten Ecke auf die Schaltfläche "Anmeldung". Wählen Sie Ihre vorhandene Anmeldemethode. Geben Sie Ihre registrierte Handynummer oder E -Mail und Kennwort ein und vervollständigen Sie die Authentifizierung (z. B. Mobilfifizierungscode oder Google Authenticator). Nach einer erfolgreichen Überprüfung können Sie auf das neueste Version des offiziellen Website -Login -Portals von Binance zugreifen.

Sesam Open Door Exchange Webseite Login Neueste Version Gateio Offizieller Website Eingang

Mar 04, 2025 pm 11:48 PM

Sesam Open Door Exchange Webseite Login Neueste Version Gateio Offizieller Website Eingang

Mar 04, 2025 pm 11:48 PM

Eine detaillierte Einführung in den Anmeldungsbetrieb der Sesame Open Exchange -Webversion, einschließlich Anmeldeschritte und Kennwortwiederherstellungsprozess.