Nachdem Metas „Alles teilen“-Modell herauskam, haben die Leute in der Branche bereits ausgerufen, dass es keinen Lebenslauf gibt.

Nur einen Tag nach der Veröffentlichung von SAM entwickelte das heimische Team eine darauf basierende weiterentwickelte Version „Grounded-SAM“.

Hinweis: Das Projektlogo wurde vom Team in einer Stunde mit Midjourney#🎜🎜 erstellt #

Grounded-SAM integriert SAM mit BLIP und Stable Diffusion und integriert die drei Funktionen „Bildsegmentierung“, „Erkennung“ und „Generierung“. Visuelle Zero-Shot-Anwendung.

Internetnutzer äußerten, dass es zu lockig sei! „Das ist zu schnell“, sagte Wenhu Chen, Forscher bei Google Brain und Assistenzprofessor für Informatik an der University of Waterloo.

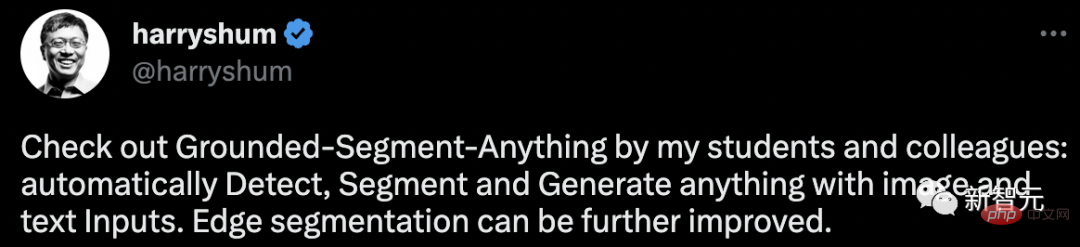

AI-Chef Shen Xiangyang hat dieses neueste Projekt auch allen empfohlen: #🎜🎜 ##🎜 🎜#Grounded-Segment-Anything: Alles mit Bild- und Texteingabe automatisch erkennen, segmentieren und generieren. Die Kantensegmentierung kann weiter verbessert werden.

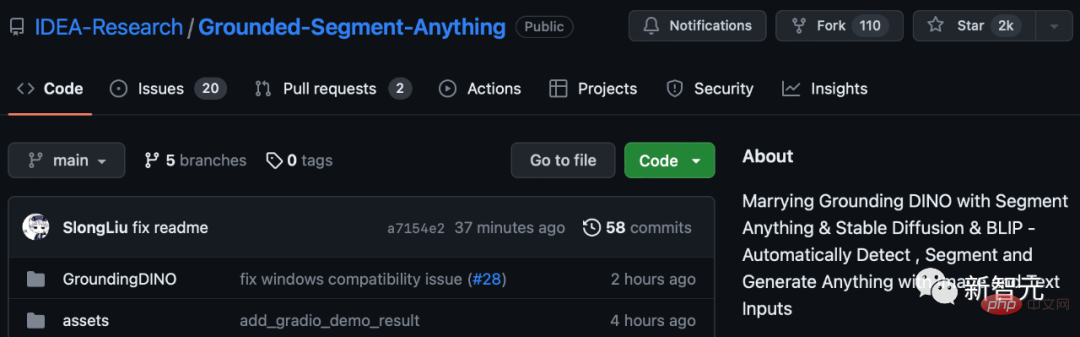

Bisher hat dieses Projekt 2.000 Sterne auf GitHub gesammelt.

#🎜 🎜#Letzte Woche läutete die Veröffentlichung von SAM den GPT-3-Moment für CV ein. Meta AI behauptet sogar, dass dies das erste grundlegende Bildsegmentierungsmodell in der Geschichte sei.

Dieses Modell kann einen Punkt, einen Begrenzungsrahmen und einen Satz im einheitlichen Framework-Prompt-Encoder angeben, um jedes Objekt mit einem Klick direkt zu segmentieren.

SAM verfügt über eine große Vielseitigkeit, das heißt, es weist keine Probenmigration auf. Leistungsstark Genug, um eine Vielzahl von Anwendungsfällen abzudecken, ist keine zusätzliche Schulung erforderlich und kann sofort in neuen Bildgebungsbereichen eingesetzt werden, sei es Unterwasserfotos oder Zellmikroskopie.

Man kann sagen, dass SAM extrem stark ist.

Man kann sagen, dass SAM extrem stark ist.

Nun haben inländische Forscher eine neue Idee basierend auf diesem Modell entwickelt, indem sie den leistungsstarken Zero-Sample-Zieldetektor Grounding DINO damit kombinieren und ihn eingeben können Durch Text alles erkennen und segmentieren.

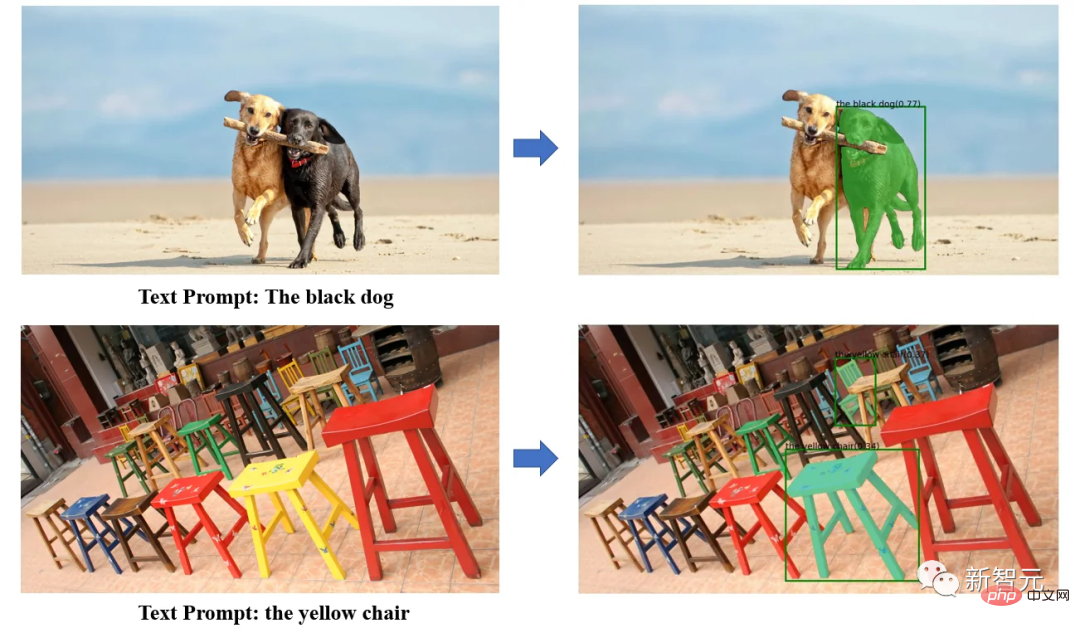

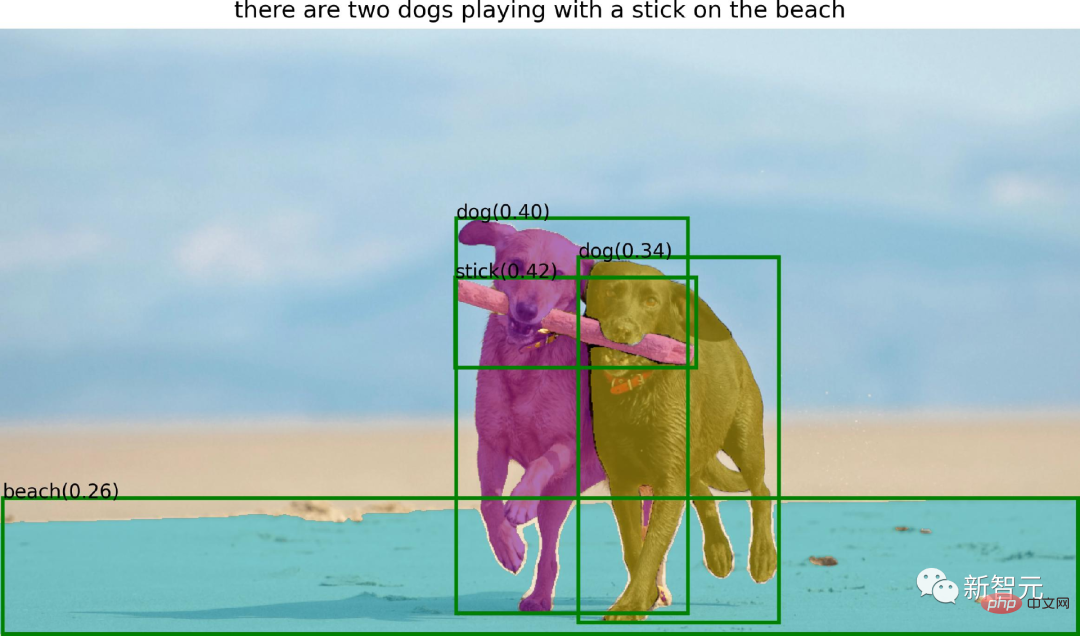

Mit der leistungsstarken Zero-Sample-Erkennungsfunktion von Grounding DINO kann Grounded SAM jedes Objekt im Bild anhand einer Textbeschreibung finden und dann die leistungsstarke Segmentierungsfunktion von SAM zur Feinabstimmung nutzen -Tune Granulare Segmentierung von Mas.

Mit der leistungsstarken Zero-Sample-Erkennungsfunktion von Grounding DINO kann Grounded SAM jedes Objekt im Bild anhand einer Textbeschreibung finden und dann die leistungsstarke Segmentierungsfunktion von SAM zur Feinabstimmung nutzen -Tune Granulare Segmentierung von Mas.

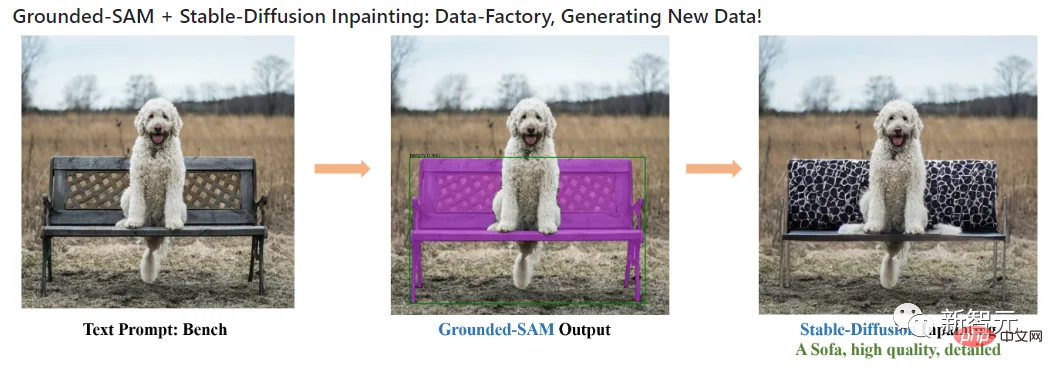

Schließlich können Sie Stable Diffusion auch verwenden, um steuerbare Texte und Bilder in den segmentierten Bereichen zu generieren.

In der spezifischen Praxis von Grounded-SAM kombinierten die Forscher Segment-Anything mit drei leistungsstarken Zero-Shot-Modellen, um einen automatischen Etikettierungssystemprozess aufzubauen, und zeigten sehr, sehr beeindruckende Ergebnisse!

Dieses Projekt kombiniert die folgenden Modelle:

· BLIP: ein leistungsstarkes Bildanmerkungsmodell

· Grounding DINO: ein hochmoderner Nullschussdetektor

· Segmentieren - Alles: Leistungsstarkes Zero-Shot-Segmentierungsmodell

· Stabile Diffusion: Ausgezeichnetes generatives Modell

Alle Modelle können in Kombination oder unabhängig voneinander verwendet werden. Erstellen Sie ein leistungsstarkes visuelles Workflow-Modell. Der gesamte Workflow verfügt über die Fähigkeit, alles zu erkennen, alles zu segmentieren und alles zu generieren.

Zu den Funktionen dieses Systems gehören:

BLIP+Grounded-SAM = Automatischer Etikettierer

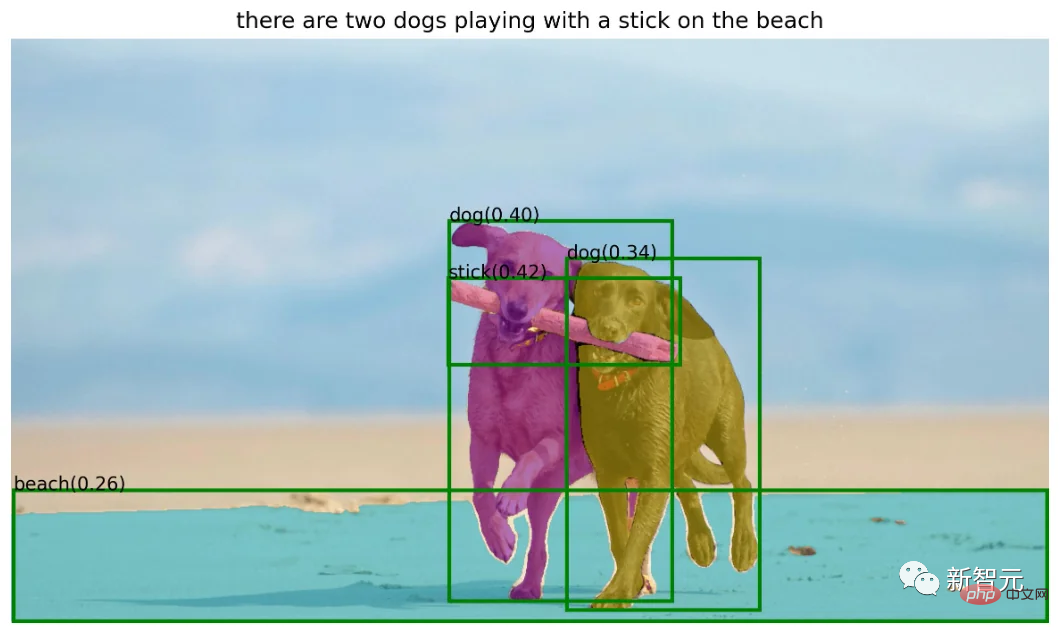

Verwendet das BLIP-Modell zum Generieren von Titeln, extrahiert Etiketten und verwendet Ground-SAM zum Generieren von Boxen und Masken:

· Halbautomatisches Anmerkungssystem: Erkennt eingegebenen Text und liefert genaue Feld- und Maskenanmerkungen.

· Vollautomatisches Anmerkungssystem:

verwendet zunächst das BLIP-Modell, um zuverlässige Anmerkungen für das Eingabebild zu generieren, lässt dann Grounding DINO die Entitäten in den Anmerkungen erkennen und verwendet dann SAM seine Box-Tipps Führen Sie eine Instanzsegmentierung durch.

Stable Diffusion+Grounded-SAM=Data Factory

· Wird als Datenfabrik zum Generieren neuer Daten verwendet: Sie können das Diffusionsreparaturmodell verwenden, um basierend auf neue Daten zu generieren die Maske.

Segment Anything+HumanEditing

In diesem Zweig verwendet der Autor Segment Anything, um menschliches Haar/Gesicht zu bearbeiten.

·SAM+Hair Editor

·SAM+Fashion Editor

Der Autor hat einige Vorschläge für den Grounded- SAM-Modell Mögliche zukünftige Forschung Anweisungen:

Bilder automatisch generieren, um neue Datensätze zu erstellen; leistungsfähigeres Basismodell, vorab trainiert für die Segmentierung; eine vollständige Pipeline zum automatischen Kommentieren von Bildern (einschließlich Begrenzungsrahmen und Masken); ein neues Bild.

Vorstellung des AutorsEiner der Forscher des Grounded-SAM-Projekts ist Liu Shilong, ein Doktorand im dritten Jahr am Fachbereich Informatik der Tsinghua-Universität.

Er hat kürzlich das neueste Projekt, das er und sein Team erstellt haben, auf GitHub vorgestellt und gesagt, dass es noch verbessert wird.

Jetzt ist Liu Shilong Praktikant am Computer Vision and Robotics Research Center des Guangdong-Hong Kong-Macao Greater Bay Area Digital Economy Research Institute (IDEA Research Institute). Hauptforschungsrichtungen sind Zielerkennung und multimodales Lernen.

Zuvor erhielt er 2020 einen Bachelor-Abschluss in Wirtschaftsingenieurwesen von der Tsinghua-Universität und absolvierte 2019 ein Praktikum bei Megvii.

Persönliche Homepage: http://www.lsl.zone/

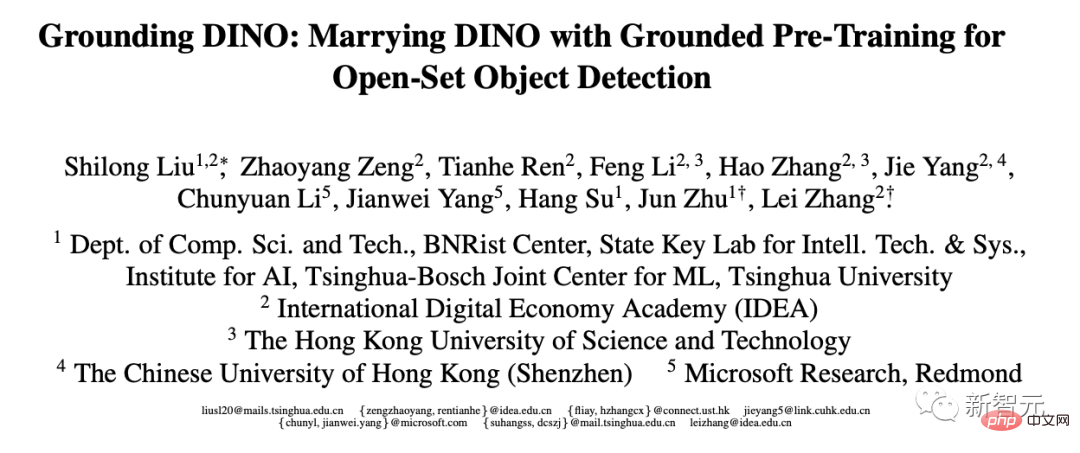

Liu Shilong ist übrigens auch eine Arbeit des Zielerkennungsmodells Grounding DINO, das im März dieses Jahres veröffentlicht wurde.

Darüber hinaus wurden 4 seiner Arbeiten von CVPR 2023, 2 Arbeiten von ICLR 2023 und 1 Papier von AAAI 2023 angenommen.

Papieradresse: https://arxiv.org/pdf/2303.05499.pdf

Und der große Chef, den Liu Shilong erwähnt hat – Ren Tianhe, arbeitet derzeit als Forscher am IDEA Research Institute Ingenieur für Computer-Vision-Algorithmen, ebenfalls betreut von Professor Zhang Lei, dessen Hauptforschungsrichtungen Zielerkennung und Multimodalität sind.

Zu den Projektmitarbeitern gehören außerdem Li Kunchang, ein Doktorand im dritten Jahr an der Universität der Chinesischen Akademie der Wissenschaften, dessen Hauptforschungsrichtungen Videoverständnis und multimodales Lernen sind; Cao He, ein Praktikant am Computer Vision and Robotics Research Center des IDEA Institute, dessen Hauptforschungsrichtung generative Modelle sind, und Chen Jiayu, leitender Algorithmusingenieur bei Alibaba Cloud.

Ren Tianhe, Liu Shilong

Das Projekt erfordert die Installation von Python 3.8 und höher, Pytorch 1.7 und höher und Torchvision 0.8 und höher. Darüber hinaus empfiehlt der Autor dringend die Installation von PyTorch und TorchVision, die CUDA unterstützen.

Segment Anything installieren:

python -m pip install -e segment_anything

GroundingDINO installieren:

python -m pip install -e GroundingDINO

Diffusoren installieren:

pip install --upgrade diffusers[torch]

Maskennachbearbeitung installieren, Maske im COCO-Format speichern, Beispielnotizbuch und Modell exportieren ONNX-Format Erforderlich optionale Abhängigkeiten. Gleichzeitig benötigt das Projekt auch Jupyter, um das Beispielnotebook auszuführen.

pip install opencv-python pycocotools matplotlib onnxruntime onnx ipykernel

Groundingdino-Checkpoint herunterladen:

cd Grounded-Segment-Anything wget https://github.com/IDEA-Research/GroundingDINO/releases/download/v0.1.0-alpha/groundingdino_swint_ogc.pth

Demo ausführen:

export CUDA_VISIBLE_DEVICES=0 python grounding_dino_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --input_image assets/demo1.jpg --output_dir "outputs" --box_threshold 0.3 --text_threshold 0.25 --text_prompt "bear" --device "cuda"

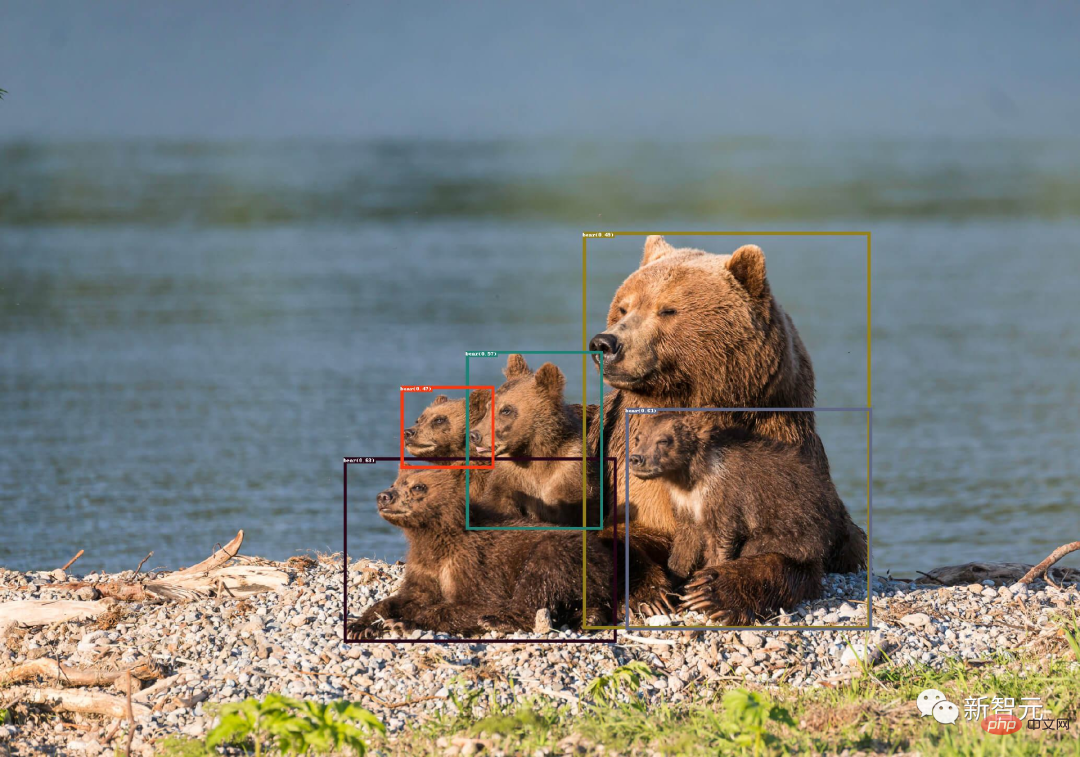

Die Modellvorhersagevisualisierung wird wie unten gezeigt im Ausgabeverzeichnis gespeichert:

Das automatische Generieren von Pseudo-Labels ist einfach:

1. Verwenden Sie BLIP (oder ein anderes Annotationsmodell), um eine Annotation zu generieren.

2. Extrahieren Sie Tags aus Anmerkungen und verwenden Sie ChatGPT, um potenziell komplexe Sätze zu verarbeiten.

3. Verwenden Sie Grounded-Segment-Anything, um Boxen und Masken zu generieren.

export CUDA_VISIBLE_DEVICES=0 python automatic_label_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --sam_checkpoint sam_vit_h_4b8939.pth --input_image assets/demo3.jpg --output_dir "outputs" --openai_key your_openai_key --box_threshold 0.25 --text_threshold 0.2 --iou_threshold 0.5 --device "cuda"

伪标签和模型预测可视化将保存在output_dir中,如下所示:

CUDA_VISIBLE_DEVICES=0 python grounded_sam_inpainting_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --sam_checkpoint sam_vit_h_4b8939.pth --input_image assets/inpaint_demo.jpg --output_dir "outputs" --box_threshold 0.3 --text_threshold 0.25 --det_prompt "bench" --inpaint_prompt "A sofa, high quality, detailed" --device "cuda"

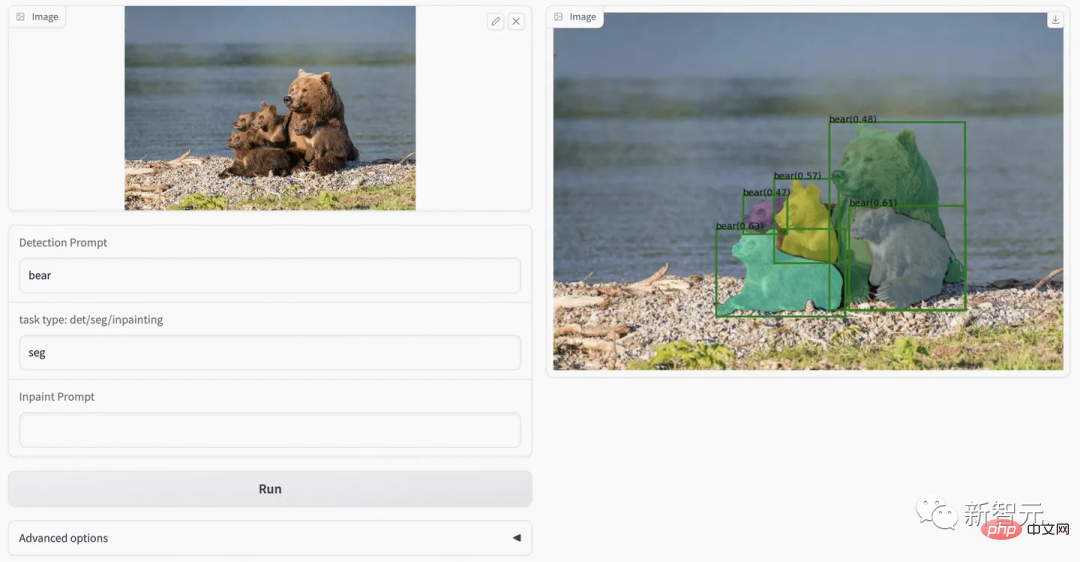

python gradio_app.py

作者在此提供了可视化网页,可以更方便的尝试各种例子。

对于这个项目logo,还有个深层的含义:

一只坐在地上的马赛克风格的熊。坐在地面上是因为ground有地面的含义,然后分割后的Die superentwickelte Version von Meta „Divide Everything ist da! IDEA führt das beste nationale Team an, um alles zu erkennen, zu segmentieren und zu generieren und sich 2.000 Sterne zu sichern可以认为是一种马赛克风格,而且马塞克谐音mask,之所以用熊作为logo主体,是因为作者主要示例的Die superentwickelte Version von Meta „Divide Everything ist da! IDEA führt das beste nationale Team an, um alles zu erkennen, zu segmentieren und zu generieren und sich 2.000 Sterne zu sichern是熊。

看到Grounded-SAM后,网友表示,知道要来,但没想到来的这么快。

项目作者任天和称,「我们用的Zero-Shot检测器是目前来说最好的。」

未来,还会有web demo上线。

最后,作者表示,这个项目未来还可以基于生成模型做更多的拓展应用,例如多领域精细化编辑、高质量可信的数据工厂的构建等等。欢迎各个领域的人多多参与。

Das obige ist der detaillierte Inhalt vonDie superentwickelte Version von Meta „Divide Everything' ist da! IDEA führt das beste nationale Team an, um alles zu erkennen, zu segmentieren und zu generieren und sich 2.000 Sterne zu sichern. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!