Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Kann das Modell direkt an AGI angeschlossen werden, solange es „größer wird'? Marcus bombardiert erneut: Drei Krisen sind entstanden!

Kann das Modell direkt an AGI angeschlossen werden, solange es „größer wird'? Marcus bombardiert erneut: Drei Krisen sind entstanden!

Kann das Modell direkt an AGI angeschlossen werden, solange es „größer wird'? Marcus bombardiert erneut: Drei Krisen sind entstanden!

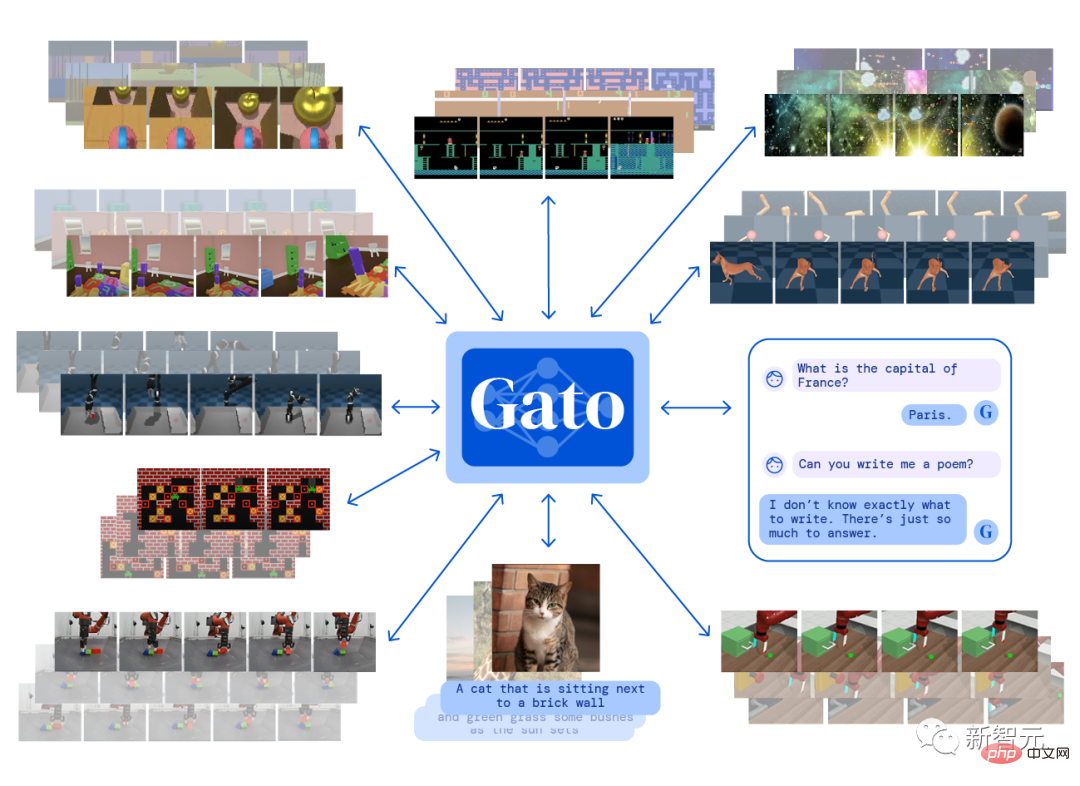

Im Mai dieses Jahres veröffentlichte DeepMind Gato, ein multimodales künstliches Intelligenzsystem, das mit nur einem Satz von Modellparametern mehr als 600 verschiedene Aufgaben gleichzeitig ausführen kann, was hitzige Diskussionen über allgemeine künstliche Intelligenz (AGI) in der Welt auslöste Industrie.

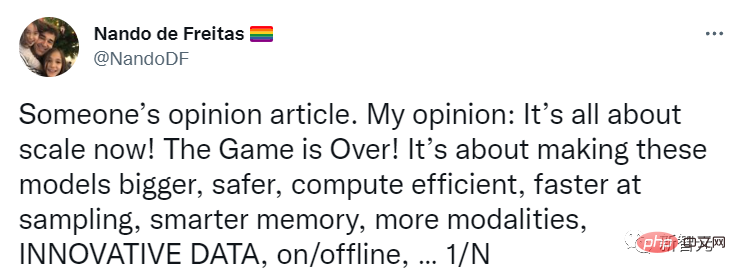

Auch Nando de Freitas, der Forschungsdirektor bei DeepMind, twitterte damals, dass KI verabschiedet werden kann, solange der Umfang weiter zunimmt!

Alles, was wir tun müssen, ist, das Modell größer, sicherer, recheneffizienter, schnellere Probenahme, intelligentere Speicherung, mehr Modalitäten, Innovationen bei Daten, online/offline usw. zu machen.

AGI kann durch die Lösung von Skalenproblemen erreicht werden. Die Branche muss diesen Problemen mehr Aufmerksamkeit schenken!

Kürzlich veröffentlichte Gary Marcus, ein bekannter KI-Wissenschaftler, Gründer und CEO von Robust.AI und emeritierter Professor an der New York University, einen weiteren Blog und argumentierte, dass diese Aussage „zu früh“ sei und eine Krise begonnen habe!

Marcus beobachtet weiterhin die Entwicklung der KI-Branche, steht dem KI-Hype jedoch kritisch gegenüber. Er hat Einwände geäußert wie „Deep Learning stößt an eine Wand“ und „GPT-3 ist völlig bedeutungslos“.

Was soll ich tun, wenn ich mit dem großen Modell nicht spielen kann?

Nando glaubt, dass künstliche Intelligenz keinen Paradigmenwechsel erfordert, sondern lediglich mehr Daten, höhere Effizienz und größere Server.

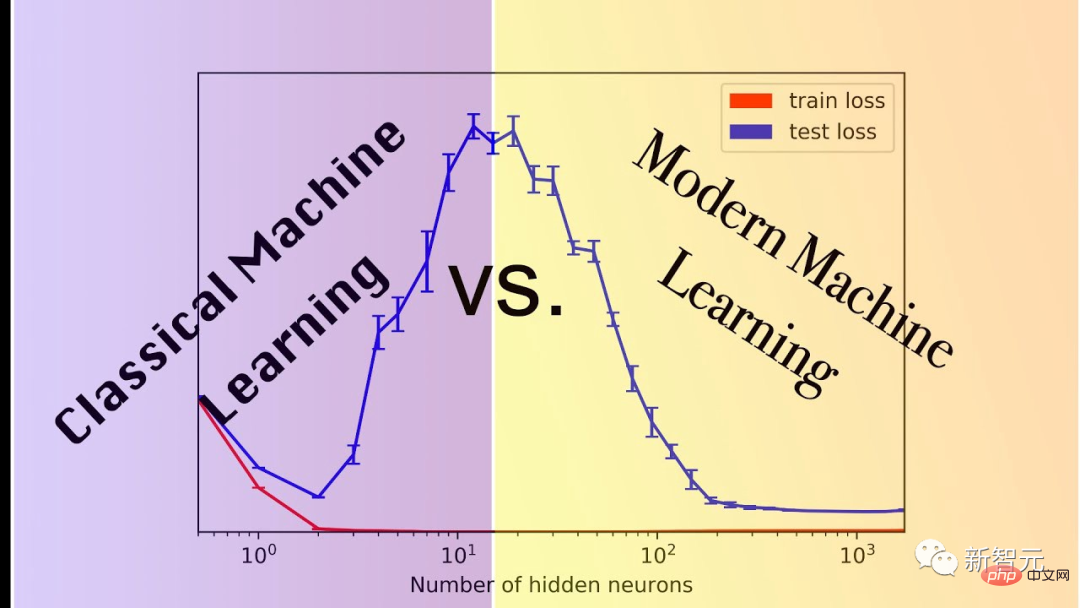

Marcus umschrieb diese Hypothese folgendermaßen: Ohne grundlegende neue Innovation könnte AGI aus größeren Modellen entstehen. Diese Annahme kann man auch Skalierung-über-alles nennen.

Seine Hypothese, die heute oft als Skalierungsmaximalismus bezeichnet wird, ist immer noch sehr beliebt, vor allem weil immer größere Modelle tatsächlich sehr leistungsfähig sind und Aufgaben wie die Bilderzeugung die Hilfe großer Modelle erfordern.

Aber das ist nur so weit.

Das Problem ist, dass einige der Technologien, die über Monate oder sogar Jahre verbessert wurden, tatsächlich bei weitem nicht den Umfang erreichen, den wir brauchen.

Es gibt immer mehr Ponzi-Systeme. Der durch die Skalierung erzielte Leistungsvorteil ist nur das Ergebnis empirischer Beobachtungen und kann nicht garantiert werden.

Marcus nennt drei aktuelle Anzeichen, die auf das Ende der Skalenmaximierungshypothese hinweisen könnten.

1. Es ist möglicherweise nicht genügend Datenvolumen auf der Welt vorhanden, um die maximale Skalierung zu unterstützen.

Viele Menschen machen sich darüber Sorgen.

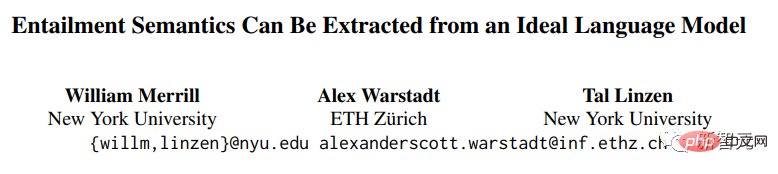

Die Forscher William Merrill, Alex Warstadt und Tal Linzen von der New York University und der ETH Zürich haben kürzlich einen Beweis dafür vorgelegt, dass „aktuelle neuronale Sprachmodelle nicht gut geeignet sind, die Semantik natürlicher Sprache ohne große Datenmengen zu extrahieren.“

Link zum Papier: https://arxiv.org/pdf/2209.12407.pdf

Dieser Beweis enthält zwar zu viele Voraussetzungen, um als Widerlegungsbeweis verwendet zu werden, aber wenn man dieser Annahme nahe kommt, könnte es welche geben sehr schnell echtes Problem im großen Maßstab.

2. Möglicherweise stehen weltweit nicht genügend Rechenressourcen zur Verfügung, um eine maximale Skalierung zu ermöglichen.

Miguel Solano hat Marcus kürzlich ein mitverfasstes Manuskript geschickt. Der Autor glaubt, dass das Erreichen aktueller Super-Benchmarks wie BIG-Bench im Jahr 2022 ein Viertel des Stromverbrauchs in den Vereinigten Staaten erfordern wird. 🔜 die mehr als 200 Missionen umfassen.

3. Einige wichtige Aufgaben sind möglicherweise einfach nicht skalierbar.

3. Einige wichtige Aufgaben sind möglicherweise einfach nicht skalierbar.

Der Maßstab spielt bei dieser Art von Aufgabe grundsätzlich keine Rolle. Selbst das beste Modell hat nur eine Genauigkeit von 80,6 %. Bei den meisten Modellen ist der Einfluss des Maßstabs bestenfalls vernachlässigbar.

Und Sie können sich leicht eine komplexere Version dieser Aufgabe vorstellen, bei der die Leistung des Modells weiter beeinträchtigt wird.

Was Marcus noch mehr traf, ist, dass selbst bei einer einzelnen wichtigen Aufgabe wie dieser eine Leistung von etwa 80 % bedeuten kann, dass ein großes Spiel nicht weiter gespielt werden kann.

Wenn das Modell nur Syntax und Semantik lernt, aber beim pragmatischen oder vernünftigen Denken versagt, erhalten Sie möglicherweise überhaupt keine vertrauenswürdige AGI.

„Moores Gesetz“ bringt uns nicht so weit wie ursprünglich erwartet. Bisher, so schnell , weil es nicht das Gesetz von Ursache und Wirkung im Universum ist und immer gelten wird.

Die Maximierung der Skalierung ist nur eine interessante Annahme. Sie wird es uns beispielsweise nicht ermöglichen, die oben genannten drei Probleme zu lösen, was uns zu einem Paradigmenwechsel zwingen wird.

Netizen Frank van der Velde sagte, dass Follower, die die Größe maximieren, dazu neigen, vage Begriffe wie „groß“ und „mehr“ zu verwenden.

Die von Deep-Learning-Modellen verwendeten Trainingsdaten sind im Vergleich zu den Trainingsdaten, die Menschen beim Erlernen von Sprachen verwenden, zu groß.

Aber im Vergleich zur realen semantischen Sammlung menschlicher Sprache sind diese sogenannten Massendaten immer noch unbedeutend. Um einen Satz pro Sekunde zu generieren, würde es 300 Jahre dauern Trainingsset.

Netizen Rebel Science hat sogar unverblümt gesagt, dass die Maximierung der Skalierung keine interessante, sondern eine dumme Hypothese ist. Sie wird nicht nur auf der KI-Strecke verlieren, sondern auch auf hässliche Weise sterben.

Maßstabsmaximierung ist zu extrem

Raphaël Millière, Dozent am Institut für Philosophie der Columbia University und Ph.D. an der Universität Oxford, äußerte auch einige seiner eigenen Meinungen, als der Kampf um die „Maßstabsmaximierung“ am heftigsten war.

Die Maximierung der Skalierung galt einst als Schwerpunkt von Deep-Learning-Kritikern (wie Gary Marcus), und als sich Brancheninsider wie Nando de Freitas und Alex Dimakis an der Debatte beteiligten, gerieten die beiden Seiten in Konflikt.

Die Reaktionen der Praktiker sind überwiegend gemischt, aber nicht zu negativ. Gleichzeitig wurde der Prognosetermin für die AGI-Implementierung auf der Prognoseplattform Metaculus auf einen historischen Tiefstand (Mai 2028) vorverlegt, was die Glaubwürdigkeit der Maximierung ebenfalls erhöhen könnte Maßstab.

Das wachsende Vertrauen der Menschen in „Maßstab“ könnte auf die Veröffentlichung neuer Modelle zurückzuführen sein, wie zum Beispiel auf den Erfolg von PaLM, DALL-E 2, Flamingo und Gato, der das Feuer der Maximierung des Maßstabs weiter angeheizt hat.

Suttons „Bitter Lesson“ verwirft viele Punkte in der Diskussion über die Maximierung der Skalierung, aber sie sind nicht völlig gleichwertig. Er glaubt, dass die Integration menschlichen Wissens in Modelle der künstlichen Intelligenz (z. B. Feature Engineering) weniger effizient ist als die Nutzung von Daten und Berechnungen effizient lernen.

Link zum Artikel: http://www.incompleteideas.net/IncIdeas/BitterLesson.html

Obwohl nicht ohne Kontroversen, scheint Suttons Ansicht deutlich weniger radikal zu sein als die Skalenmaximierung.

Es betont zwar die Bedeutung des Maßstabs, reduziert aber nicht jedes Problem in der KI-Forschung auf eine bloße Herausforderung des Maßstabs.

Tatsächlich ist es schwierig, die spezifische Bedeutung der Skalierungsmaximierung zu bestimmen. Wörtlich bedeutet „Skalierung ist alles, was Sie brauchen“, dass wir AGI ohne Algorithmusinnovation oder Architekturänderungen implementieren und bestehende Modelle erweitern und mehr Daten erzwingen können eingegeben werden.

Diese wörtliche Erklärung erscheint lächerlich: Selbst Modelle wie Palm, DALL-E 2, Flamingo oder Gato erfordern immer noch architektonische Änderungen gegenüber früheren Ansätzen.

Es wäre wirklich überraschend, wenn jemand tatsächlich denken würde, wir könnten einen serienmäßigen autoregressiven Transformator auf AGI erweitern.

Es ist unklar, wie viel algorithmische Innovation Menschen, die an die Maximierung der Skalierung glauben, der Meinung sind, dass AGI erforderlich ist, was es aus dieser Perspektive auch schwierig macht, falsifizierbare Vorhersagen zu generieren.

Skalierung mag eine notwendige Voraussetzung für den Aufbau eines Systems sein, das die Bezeichnung „allgemeine künstliche Intelligenz“ verdient, aber wir sollten Notwendigkeit nicht mit einer hinreichenden Bedingung verwechseln.

Das obige ist der detaillierte Inhalt vonKann das Modell direkt an AGI angeschlossen werden, solange es „größer wird'? Marcus bombardiert erneut: Drei Krisen sind entstanden!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Verbessern Sie die Produktivität, Effizienz und Genauigkeit der Entwickler, indem Sie eine abrufgestützte Generierung und ein semantisches Gedächtnis in KI-Codierungsassistenten integrieren. Übersetzt aus EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, Autor JanakiramMSV. Obwohl grundlegende KI-Programmierassistenten natürlich hilfreich sind, können sie oft nicht die relevantesten und korrektesten Codevorschläge liefern, da sie auf einem allgemeinen Verständnis der Softwaresprache und den gängigsten Mustern beim Schreiben von Software basieren. Der von diesen Coding-Assistenten generierte Code eignet sich zur Lösung der von ihnen zu lösenden Probleme, entspricht jedoch häufig nicht den Coding-Standards, -Konventionen und -Stilen der einzelnen Teams. Dabei entstehen häufig Vorschläge, die geändert oder verfeinert werden müssen, damit der Code in die Anwendung übernommen wird

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

An der Spitze der Softwaretechnologie kündigte die Gruppe von UIUC Zhang Lingming zusammen mit Forschern der BigCode-Organisation kürzlich das StarCoder2-15B-Instruct-Großcodemodell an. Diese innovative Errungenschaft erzielte einen bedeutenden Durchbruch bei Codegenerierungsaufgaben, übertraf erfolgreich CodeLlama-70B-Instruct und erreichte die Spitze der Codegenerierungsleistungsliste. Die Einzigartigkeit von StarCoder2-15B-Instruct liegt in seiner reinen Selbstausrichtungsstrategie. Der gesamte Trainingsprozess ist offen, transparent und völlig autonom und kontrollierbar. Das Modell generiert über StarCoder2-15B Tausende von Anweisungen als Reaktion auf die Feinabstimmung des StarCoder-15B-Basismodells, ohne auf teure manuelle Annotationen angewiesen zu sein.

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

1. Einleitung In den letzten Jahren haben sich YOLOs aufgrund ihres effektiven Gleichgewichts zwischen Rechenkosten und Erkennungsleistung zum vorherrschenden Paradigma im Bereich der Echtzeit-Objekterkennung entwickelt. Forscher haben das Architekturdesign, die Optimierungsziele, Datenerweiterungsstrategien usw. von YOLO untersucht und erhebliche Fortschritte erzielt. Gleichzeitig behindert die Verwendung von Non-Maximum Suppression (NMS) bei der Nachbearbeitung die End-to-End-Bereitstellung von YOLO und wirkt sich negativ auf die Inferenzlatenz aus. In YOLOs fehlt dem Design verschiedener Komponenten eine umfassende und gründliche Prüfung, was zu erheblicher Rechenredundanz führt und die Fähigkeiten des Modells einschränkt. Es bietet eine suboptimale Effizienz und ein relativ großes Potenzial zur Leistungsverbesserung. Ziel dieser Arbeit ist es, die Leistungseffizienzgrenze von YOLO sowohl in der Nachbearbeitung als auch in der Modellarchitektur weiter zu verbessern. zu diesem Zweck

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

Herausgeber |. KX Im Bereich der Arzneimittelforschung und -entwicklung ist die genaue und effektive Vorhersage der Bindungsaffinität von Proteinen und Liganden für das Arzneimittelscreening und die Arzneimitteloptimierung von entscheidender Bedeutung. Aktuelle Studien berücksichtigen jedoch nicht die wichtige Rolle molekularer Oberflächeninformationen bei Protein-Ligand-Wechselwirkungen. Auf dieser Grundlage schlugen Forscher der Universität Xiamen ein neuartiges Framework zur multimodalen Merkmalsextraktion (MFE) vor, das erstmals Informationen über Proteinoberfläche, 3D-Struktur und -Sequenz kombiniert und einen Kreuzaufmerksamkeitsmechanismus verwendet, um verschiedene Modalitäten zu vergleichen Ausrichtung. Experimentelle Ergebnisse zeigen, dass diese Methode bei der Vorhersage von Protein-Ligand-Bindungsaffinitäten Spitzenleistungen erbringt. Darüber hinaus belegen Ablationsstudien die Wirksamkeit und Notwendigkeit der Proteinoberflächeninformation und der multimodalen Merkmalsausrichtung innerhalb dieses Rahmens. Verwandte Forschungen beginnen mit „S

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

Laut Nachrichten dieser Website vom 5. Juli veröffentlichte GlobalFoundries am 1. Juli dieses Jahres eine Pressemitteilung, in der die Übernahme der Power-Galliumnitrid (GaN)-Technologie und des Portfolios an geistigem Eigentum von Tagore Technology angekündigt wurde, in der Hoffnung, seinen Marktanteil in den Bereichen Automobile und Internet auszubauen Anwendungsbereiche für Rechenzentren mit künstlicher Intelligenz, um höhere Effizienz und bessere Leistung zu erforschen. Da sich Technologien wie generative künstliche Intelligenz (GenerativeAI) in der digitalen Welt weiterentwickeln, ist Galliumnitrid (GaN) zu einer Schlüssellösung für nachhaltiges und effizientes Energiemanagement, insbesondere in Rechenzentren, geworden. Auf dieser Website wurde die offizielle Ankündigung zitiert, dass sich das Ingenieurteam von Tagore Technology im Rahmen dieser Übernahme mit GF zusammenschließen wird, um die Galliumnitrid-Technologie weiterzuentwickeln. G