In den fast zweieinhalb Jahren seit seiner Veröffentlichung im Mai 2020 konnte GPT-3 dank seiner magischen Textgenerierungsfunktionen Menschen sehr gut beim Schreiben unterstützen.

Aber letzten Endes handelt es sich bei GPT-3 um ein Textgenerierungsmodell, das sich völlig vom menschlichen Schreibprozess unterscheidet.

Wenn wir beispielsweise eine Arbeit oder einen Aufsatz schreiben möchten, müssen wir zunächst einen Rahmen in unserem Kopf konstruieren, relevante Informationen überprüfen, einen Entwurf erstellen und dann einen Tutor finden, der den Text während dieser Zeit ständig überarbeitet und verfeinert , wir können auch die Ideen überarbeiten, und schließlich können wir einen guten Artikel erstellen.

Der durch das generative Modell erhaltene Text kann nur die grammatikalischen Anforderungen erfüllen, verfügt jedoch über keine logische Inhaltsanordnung und keine Fähigkeit zur Selbständerung. Daher ist es noch weit entfernt, die KI unabhängig schreiben zu lassen.

Kürzlich haben Forscher von Meta AI Research und der Carnegie Mellon University ein neues Textgenerierungsmodell PEER (Plan, Edit, Explain, Repeat) vorgeschlagen, das den Prozess des menschlichen Schreibens vollständig simuliert, vom Entwurf über das Einholen von Vorschlägen bis hin zum Bearbeiten von Text von dort aus iterieren.

Papieradresse: https://arxiv.org/abs/2208.11663

PEER löst das Problem, dass herkömmliche Sprachmodelle nur Endergebnisse generieren und der generierte Text nicht durch die Eingabe natürlicher Sprachbefehle gesteuert werden kann. PEER-Änderungen können am generierten Text vorgenommen werden.

Das Wichtigste ist, dass die Forscher mehrere Instanzen von PEER trainiert haben, die im Schreibprozess mehrere Links ausfüllen können, wodurch Selbsttrainingstechnologie verwendet werden kann, um die Qualität, Quantität und Qualität der Trainingsdaten zu verbessern. Diversität.

Die Fähigkeit, Trainingsdaten zu generieren, bedeutet, dass das Potenzial von PEER weit über das Schreiben von Aufsätzen hinausgeht. PEER kann auch in anderen Bereichen verwendet werden, ohne den Verlauf zu bearbeiten, wodurch seine Fähigkeit, Anweisungen zu befolgen, nützliche Kommentare zu schreiben und seine Aufgaben zu erklären, schrittweise verbessert wird Aktionen.

Nach dem Vortraining mit natürlicher Sprache ist der Textgenerierungseffekt großer neuronaler Netze bereits sehr stark, aber die Generierungsmethode dieser Modelle besteht im Wesentlichen darin, den Ergebnistext sofort von links nach rechts auszugeben , was anders ist als beim Menschen Der iterative Prozess des Schreibens ist sehr unterschiedlich.

Einmalige Generierung hat auch viele Nachteile. Beispielsweise ist es unmöglich, die Sätze im Text zu verfolgen, um sie zu ändern oder zu verbessern, und auch nicht, warum ein bestimmter Textsatz generiert wurde die Richtigkeit des generierten Textes, und im Ergebnis werden oft Halluzinationen (Halluzinate) erzeugt, also Texte, die nicht den Tatsachen entsprechen. Diese Mängel schränken auch die Fähigkeit des Modells ein, in Zusammenarbeit mit Menschen zu schreiben, die kohärente und sachliche Texte benötigen.

Das PEER-Modell wird auf den „Bearbeitungsverlauf“ des Textes trainiert, sodass das Modell den menschlichen Schreibprozess simulieren kann.

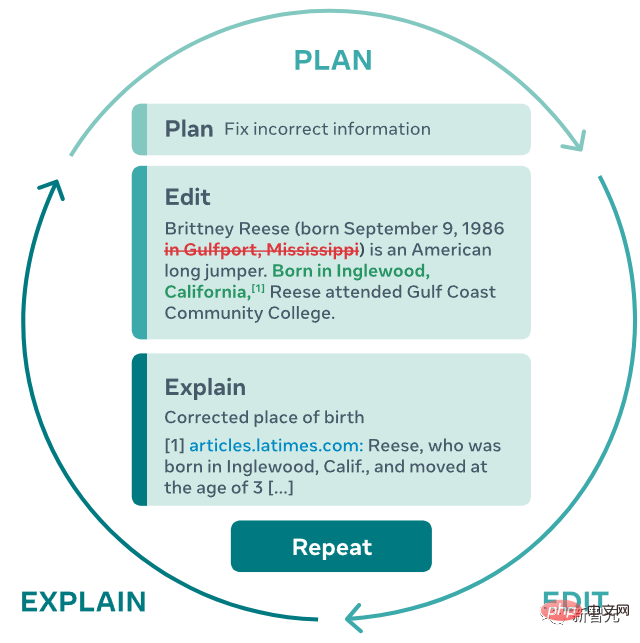

1. Wenn das PEER-Modell ausgeführt wird, muss der Benutzer oder das Modell einen Plan (Plan) angeben und die Aktion (Aktion), die er ausführen möchte, in natürlicher Sprache beschreiben, z. B. das Hinzufügen einiger Informationen oder das Beheben von Grammatikfehlern ;

2 , und implementieren Sie diese Aktion dann, indem Sie den Text bearbeiten

3 Das Modell kann auf relevante Ressourcen verweisen, um die Bearbeitungsergebnisse zu erklären

4. Wiederholen (Repeat) Sie diesen Vorgang, bis der generierte Text keine weiteren Aktualisierungen mehr erfordert.

Dieser iterative Ansatz ermöglicht es dem Modell nicht nur, die komplexe Aufgabe, einen kohärenten, konsistenten, sachlichen Text zu schreiben, in mehrere einfachere Teilaufgaben zu zerlegen, sondern ermöglicht es dem Menschen auch, an jedem Punkt des Generierungsprozesses einzugreifen und das Modell in die richtige Richtung zu leiten Richtung festlegen, Benutzern Pläne und Kommentare zur Verfügung stellen oder selbst mit der Bearbeitung beginnen.

Aus der Methodenbeschreibung geht hervor, dass das Schwierigste bei der Implementierung der Funktion nicht darin besteht, Transformer zum Erstellen eines Modells zu verwenden, sondern Trainingsdaten zu finden. Wir möchten eine Methode finden, die diesen Prozess erlernen kann Der Umfang, der zum Trainieren eines großen Sprachmodells erforderlich ist, ist offensichtlich sehr schwierig, da die meisten Websites keinen Bearbeitungsverlauf bereitstellen, sodass die über Crawler erhaltenen Webseiten nicht als Trainingsdaten verwendet werden können.

Selbst das Crawlen derselben Webseite zu unterschiedlichen Zeitpunkten im Bearbeitungsverlauf ist nicht möglich, da es keinen relevanten Text gibt, der die Bearbeitung geplant oder erklärt hat.

PEER ähnelt früheren iterativen Bearbeitungsmethoden und verwendet Wikipedia als Datenquelle für Hauptredakteure und zugehörige Kommentare, da Wikipedia einen vollständigen Bearbeitungsverlauf einschließlich Kommentaren zu verschiedenen Themen bereitstellt und umfangreich ist und häufig in Artikeln enthalten ist. Zitierung, hilfreich beim Auffinden relevanter Dokumente.

Aber sich ausschließlich auf Wikipedia als einzige Quelle für Trainingsdaten zu verlassen, hat auch verschiedene Nachteile:

1 Das Modell, das nur mit Wikipedia trainiert wird, muss in Bezug auf das erwartete Erscheinungsbild des Textinhalts und die vorhergesagte Planung und Bearbeitung ähnlich sein

2. Kommentare in Wikipedia sind verrauscht, daher sind Kommentare in vielen Fällen kein geeigneter Input für die Planung oder Erklärung

3 Viele Passagen in Wikipedia enthalten keine Zitate, obwohl diese Hintergrundinformationen durch die Verwendung eines Suchsystems behoben werden können , aber selbst ein solches System ist für viele Redakteure möglicherweise nicht in der Lage, unterstützende Hintergrundinformationen zu finden.

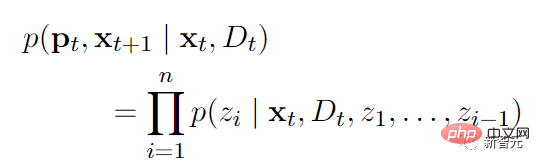

Forscher haben eine einfache Methode vorgeschlagen, um alle Probleme zu lösen, die dadurch entstehen, dass Wikipedia die einzige Quelle für den Verlauf der Kommentarbearbeitung ist: Trainieren Sie mehrere PEER-Instanzen und verwenden Sie diese Instanzen, um zu lernen, verschiedene Aspekte des Bearbeitungsprozesses zu füllen. Mithilfe dieser Modelle können synthetische Daten als Ersatz für fehlende Teile des Trainingskorpus generiert werden.

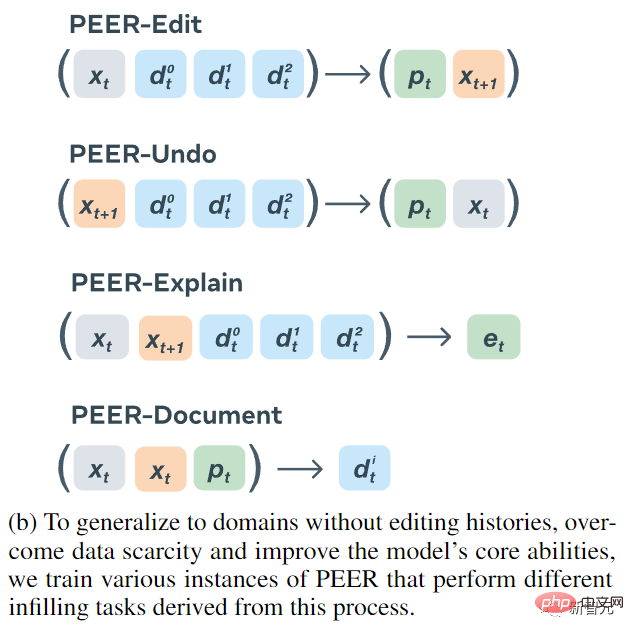

Vier Encoder-Decoder-Modelle wurden schließlich trainiert:

1. Die Eingabe von PEER-Edit ist Text x und eine Reihe von Dokumenten, und die Modellausgabe ist der geplante und bearbeitete Text, wobei p der geplante Text ist .

2. Die Eingabe von PEER-Undo ist der bearbeitete Text und eine Reihe von Dokumenten, und die Modellausgabe ist, ob die Bearbeitung rückgängig gemacht werden soll.

3. PEER-Explain wird verwendet, um eine Erläuterung der Bearbeitung zu generieren. Die Eingabe besteht aus Quelltext, bearbeitetem Text und einer Reihe zugehöriger Dokumente.

4. Quelltext, bearbeiteter Text und Plan der PEER-Dokumenteingaben, und die Modellausgabe ist die nützlichste Hintergrundinformation in dieser Bearbeitung.

Alle Variantenmodelle von PEER werden zur Generierung synthetischer Daten verwendet, sowohl zur Generierung von Trainingsdaten zur Ergänzung fehlender Teile als auch zum Ersetzen von „minderwertigen“ Teilen vorhandener Daten.

Um beliebige Textdaten trainieren zu können, auch wenn der Text keinen Bearbeitungsverlauf hat, wird PEER-Undo verwendet, um eine synthetische „Rückwärts“-Bearbeitung zu erzeugen, das heißt, PEER-Undo wird wiederholt auf den Quelltext angewendet, bis der Der Text ist leer und der dann aufgerufene PEER-Edit-Zug erfolgt in die entgegengesetzte Richtung.

Bei der Planerstellung nutzen Sie PEER-Explain, um viele minderwertige Kommentare im Korpus zu korrigieren oder Texte ohne Kommentare zu verarbeiten. Probieren Sie mehrere Ergebnisse aus der Ausgabe von PEER-Explain nach dem Zufallsprinzip als „potenzielle Pläne“ aus, berechnen Sie die Wahrscheinlichkeit einer tatsächlichen Bearbeitung und wählen Sie den mit der höchsten Wahrscheinlichkeit als neuen Plan aus.

Wenn das relevante Dokument für einen bestimmten Bearbeitungsvorgang nicht gefunden werden kann, wird PEER-Document verwendet, um einen Satz synthetischer Dokumente zu generieren, die Informationen zur Durchführung des Bearbeitungsvorgangs enthalten. Am wichtigsten ist, dass PEER-Edit dies nur während des Trainings durchführt und während der Inferenzphase keine synthetischen Dokumente bereitstellt.

Um die Qualität und Vielfalt der generierten Pläne, Bearbeitungen und Dokumente zu verbessern, haben die Forscher außerdem einen Kontrollmechanismus implementiert, der bestimmte Kontrollmarkierungen in den vom trainierten Modell generierten Ausgabesequenzen voreinstellt und diese dann während der Inferenz verwendet Zu den Tags gehören:

1. Der Typ wird verwendet, um den von PEER-Explain generierten Texttyp zu steuern (die Ausgabe muss mit einem Infinitiv beginnen) und andere

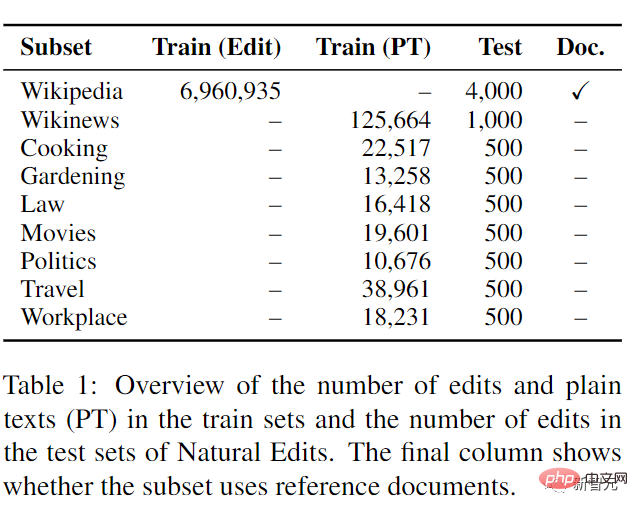

2. Länge, steuert die Ausgabelänge von PEER-Explain. Zu den optionalen Werten gehören s (weniger als 2 Wörter), m (2-3 Wörter), l (4-5 Wörter) und xl (mehr als oder gleich). 6 Wörter); 3. Ob die von PEER-Explain generierten Wörter mit dem bearbeiteten Text wiederholt werden können, die optionalen Werte sind wahr und falsch 4 Wörter, die zur Steuerung von PEER-Undo verwendet werden Quelltext und der bearbeitete Text Die Anzahl der verschiedenen Wörter dazwischen, die optionalen Werte sind alle ganze Zahlen 5, werden verwendet, um sicherzustellen, dass der von PEER-Document ausgegebene Text eine bestimmte Teilzeichenfolge enthält PEER führt nicht ein Steuerzeichen zur PEER-Bearbeitung, d. h. es wird nicht davon ausgegangen, dass der Benutzer die Art der Bearbeitungsaufgaben, die mit dem Modell gelöst werden könnten, das Modell allgemeiner macht. In der experimentellen Vergleichsphase verwendet PEER die 3B-Parameterversion von LM-Adapted T5 für die Initialisierung vor dem Training. Um die Fähigkeit von PEER zu bewerten, eine Reihe von Plänen zu verfolgen, bereitgestellte Dokumente zu nutzen und Änderungen in verschiedenen Bereichen vorzunehmen, insbesondere in Bereichen ohne Bearbeitungsverlauf, wird ein neuer Datensatz „Natural Edits“ eingeführt. Eine Sammlung natürlich vorkommender Änderungen für verschiedene Texttypen und Felder.Daten wurden aus drei englischsprachigen Webquellen gesammelt: Enzyklopädieseiten von Wikipedia, Nachrichtenartikel von Wikinews und Fragen aus den Unterforen Kochen, Gartenarbeit, Recht, Film, Politik, Reisen und Arbeitsplatz von StackExchange ein Bearbeitungsverlauf mit Kommentaren, die die Absicht des Herausgebers detailliert beschreiben und sie dem Modell als Plan zur Verfügung stellen.

Beim Training von Wikinews- und StackExchange-Teilmengen werden anstelle der tatsächlichen Bearbeitung nur reine Textdaten bereitgestellt, wodurch die Bearbeitungsfähigkeit in Bereichen ohne Bearbeitungshistorie getestet wird.

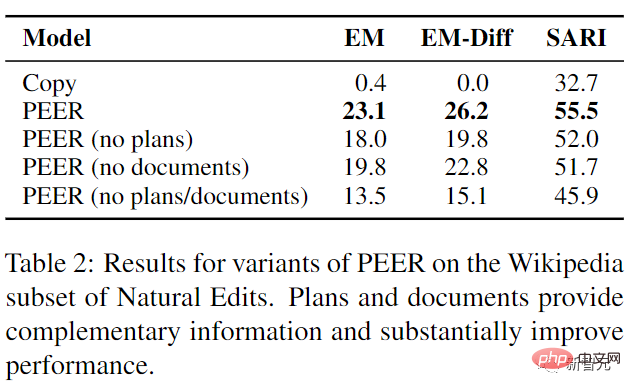

Die experimentellen Ergebnisse zeigen, dass PEER alle Basislinien bis zu einem gewissen Grad übertrifft, und der Plan und die Dokumentation liefern ergänzende Informationen, die das Modell verwenden kann

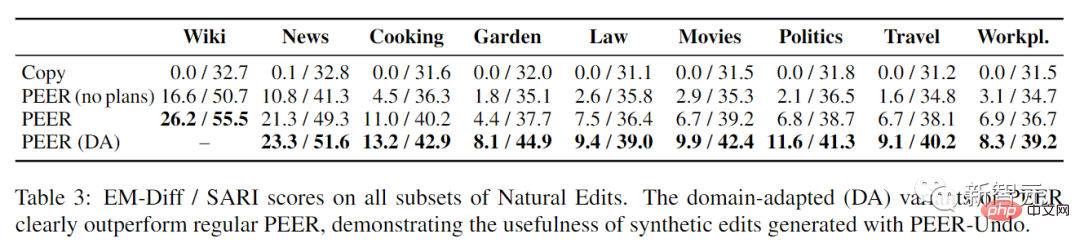

Dies kann nach der Bewertung von PEER für alle Teilmengen von Natural Edits festgestellt werden. Die Planung war domänenübergreifend von großer Hilfe, was darauf hindeutet, dass die Fähigkeit, die Planung in der Wikipedia-Bearbeitung zu verstehen, direkt auf andere Domänen übertragbar ist. Wichtig ist, dass die domänenadaptive Variante von PEER das reguläre PEER in allen Teilmengen von Natural Edits deutlich übertrifft, insbesondere mit großen Verbesserungen bei den Teilmengen Gartenarbeit, Politik und Film (84 %, 71 % bzw. 48 % von EM-). Diff) zeigt auch die Wirksamkeit der Generierung synthetischer Bearbeitungen bei der Anwendung von PEER in verschiedenen Domänen.

Das obige ist der detaillierte Inhalt vonKeine Panik, wenn Sie Ihre Arbeit 100 Mal überarbeiten! Meta veröffentlicht neues Schreibsprachenmodell PEER: Referenzen werden hinzugefügt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So starten Sie regelmäßig neu

So starten Sie regelmäßig neu

Windows kann nicht auf den angegebenen Gerätepfad oder die angegebene Dateilösung zugreifen

Windows kann nicht auf den angegebenen Gerätepfad oder die angegebene Dateilösung zugreifen

Was ist der Unterschied zwischen 5g und 4g?

Was ist der Unterschied zwischen 5g und 4g?

Kopfzeile entfernen

Kopfzeile entfernen

Verwendung von Oracle-Einsätzen

Verwendung von Oracle-Einsätzen

So stellen Sie den IE-Browser wieder her, um automatisch zu EDGE zu springen

So stellen Sie den IE-Browser wieder her, um automatisch zu EDGE zu springen

So starten Sie den MySQL-Dienst

So starten Sie den MySQL-Dienst

Was ist der Unterschied zwischen CSS-Framework und Komponentenbibliothek?

Was ist der Unterschied zwischen CSS-Framework und Komponentenbibliothek?