Das Ziel von

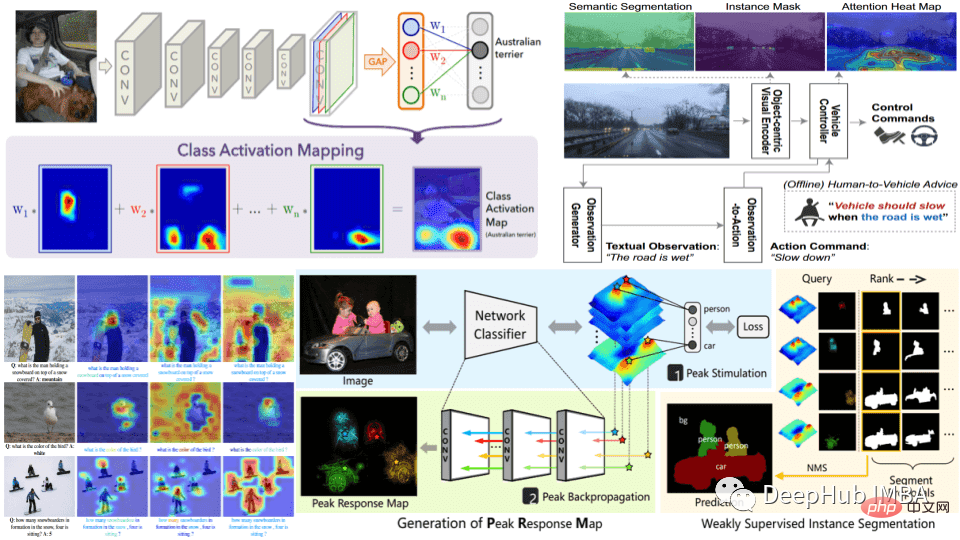

In der Praxis kann XAI durch eine Vielzahl von Methoden erreicht werden, z. B. durch die Verwendung von Merkmalswichtigkeitsmaßen, Visualisierungstechniken oder durch die Erstellung von Modellen, die inhärent interpretierbar sind, wie z. B. Entscheidungsbäume oder lineare Regressionsmodelle. Die Wahl der Methode hängt von der Art des zu lösenden Problems und dem erforderlichen Maß an Interpretierbarkeit ab.

KI-Systeme werden in einer wachsenden Zahl von Anwendungen eingesetzt, darunter im Gesundheitswesen, im Finanzwesen und in der Strafjustiz, wo die potenziellen Auswirkungen von KI auf das Leben der Menschen groß sind und es von entscheidender Bedeutung ist, zu verstehen, warum eine Entscheidung getroffen wurde. Da die Kosten für Fehlentscheidungen in diesen Bereichen hoch sind (es steht viel auf dem Spiel), wird XAI immer wichtiger, da auch von KI getroffene Entscheidungen sorgfältig auf Gültigkeit und Erklärbarkeit überprüft werden müssen.

Modelltraining: Das Modell wird auf vorbereiteten Daten trainiert, entweder einem traditionellen Modell für maschinelles Lernen oder einem neuronalen Deep-Learning-Netzwerk. Die Wahl des Modells hängt vom zu lösenden Problem und dem erforderlichen Grad der Interpretierbarkeit ab. Je einfacher das Modell, desto einfacher sind die Ergebnisse zu interpretieren, aber die Leistung einfacher Modelle ist nicht sehr hoch.

Modellbewertung: Die Auswahl geeigneter Bewertungsmethoden und Leistungsmetriken ist notwendig, um die Interpretierbarkeit des Modells aufrechtzuerhalten. In dieser Phase ist es auch wichtig, die Interpretierbarkeit des Modells zu bewerten, um sicherzustellen, dass es sinnvolle Erklärungen für seine Vorhersagen liefern kann.

Erklärungsgenerierung: Dies kann mithilfe verschiedener Techniken wie Merkmalswichtigkeitsmaßen, Visualisierungstechniken oder durch die Erstellung inhärent erklärbarer Modelle erfolgen.

Erklärungsüberprüfung: Überprüfen Sie die Richtigkeit und Vollständigkeit der vom Modell generierten Erklärungen. Dies trägt dazu bei, dass die Erklärung glaubwürdig ist.

Bereitstellung und Überwachung: Die Arbeit von XAI endet nicht mit der Modellerstellung und -validierung. Nach der Bereitstellung sind fortlaufende Erklärungsarbeiten erforderlich. Bei der Überwachung in einer realen Umgebung ist es wichtig, die Leistung und Interpretierbarkeit des Systems regelmäßig zu bewerten.

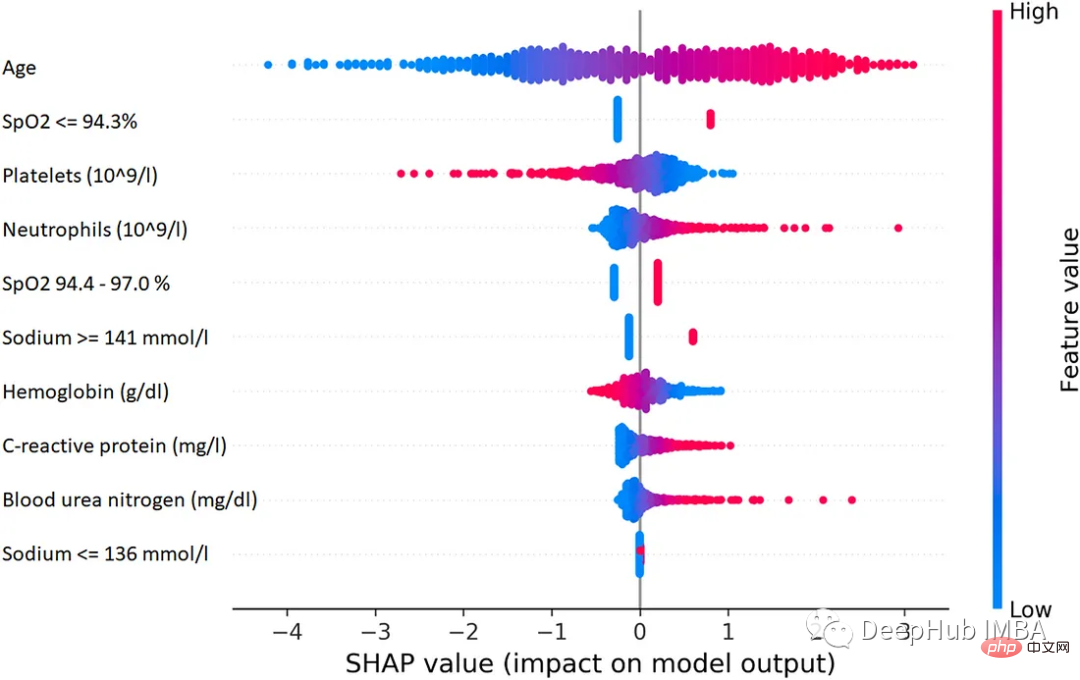

1. SHAP (SHapley Additive exPlanations)

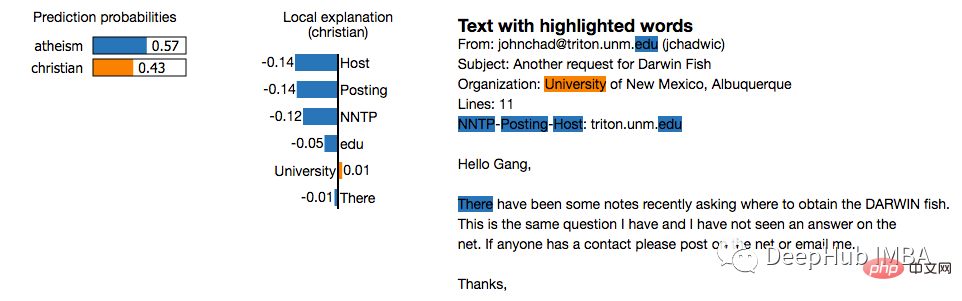

2. LIME (Local Interpretable Model-agnostic Explanations)

2. LIME (Local Interpretable Model-agnostic Explanations)

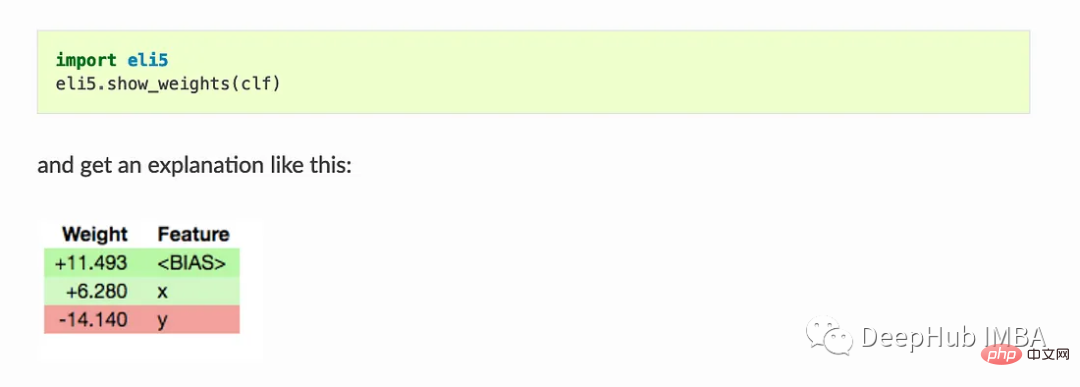

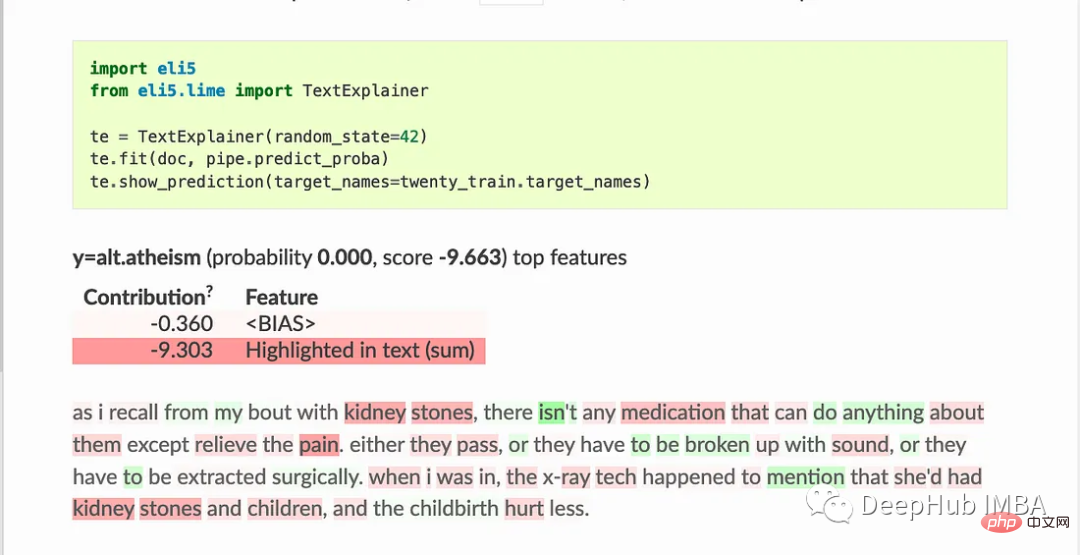

3. Eli5

3. Eli5

Show_weights() zeigt alle Gewichte des Modells an, Show_prediction() kann verwendet werden, um einzelne Vorhersagen des Modells zu überprüfen

ELI5 implementiert auch einige Algorithmen zur Überprüfung von Black-Box-Modellen:

TextExplainer verwendet den LIME-Algorithmus, um die Vorhersagen eines beliebigen Textklassifikators zu erklären. Die Permutationswichtigkeitsmethode kann zur Berechnung der Merkmalswichtigkeit für Black-Box-Schätzer verwendet werden.

Shapash bietet verschiedene Arten von Visualisierungen, um das Verständnis des Modells zu erleichtern. Verwenden Sie die Zusammenfassung, um die vom Modell vorgeschlagenen Entscheidungen zu verstehen. Dieses Projekt wird von MAIF-Datenwissenschaftlern entwickelt. Shapash erklärt das Modell hauptsächlich durch eine Reihe hervorragender Visualisierungen.

Shapash funktioniert über den Webanwendungsmechanismus und kann perfekt in Jupyter/ipython integriert werden.

from shapash import SmartExplainer

xpl = SmartExplainer(

model=regressor,

preprocessing=encoder, # Optional: compile step can use inverse_transform method

features_dict=house_dict# Optional parameter, dict specifies label for features name

)

xpl.compile(x=Xtest,

y_pred=y_pred,

y_target=ytest, # Optional: allows to display True Values vs Predicted Values

)

xpl.plot.contribution_plot("OverallQual")

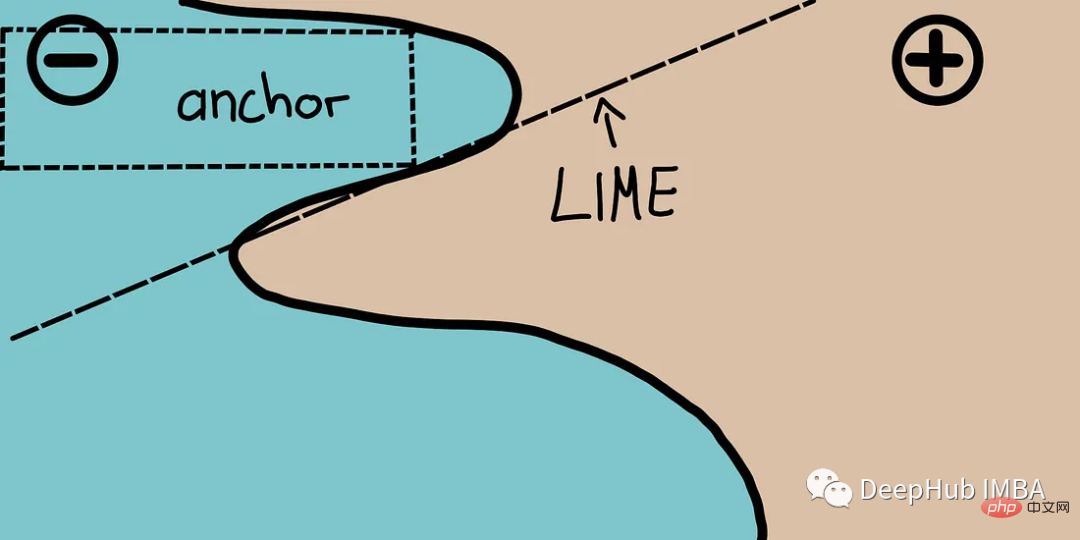

Anker erklären das Verhalten komplexer Modelle mithilfe hochpräziser Regeln, sogenannter Ankerpunkte, die lokale „ausreichende“ Vorhersagebedingungen darstellen. Der Algorithmus kann die Erklärung jedes Black-Box-Modells mit hohen Wahrscheinlichkeitsgarantien effizient berechnen.

Anker können als LIME v2 betrachtet werden, wo einige Einschränkungen von LIME (z. B. die Unfähigkeit, Modelle für unsichtbare Instanzen der Daten anzupassen) korrigiert wurden. Anker nutzen lokale Bereiche und nicht jeden einzelnen Standpunkt. Es ist rechenintensiv als SHAP und kann daher mit hochdimensionalen oder großen Datensätzen verwendet werden. Einige Einschränkungen bestehen jedoch darin, dass Beschriftungen nur ganze Zahlen sein können.

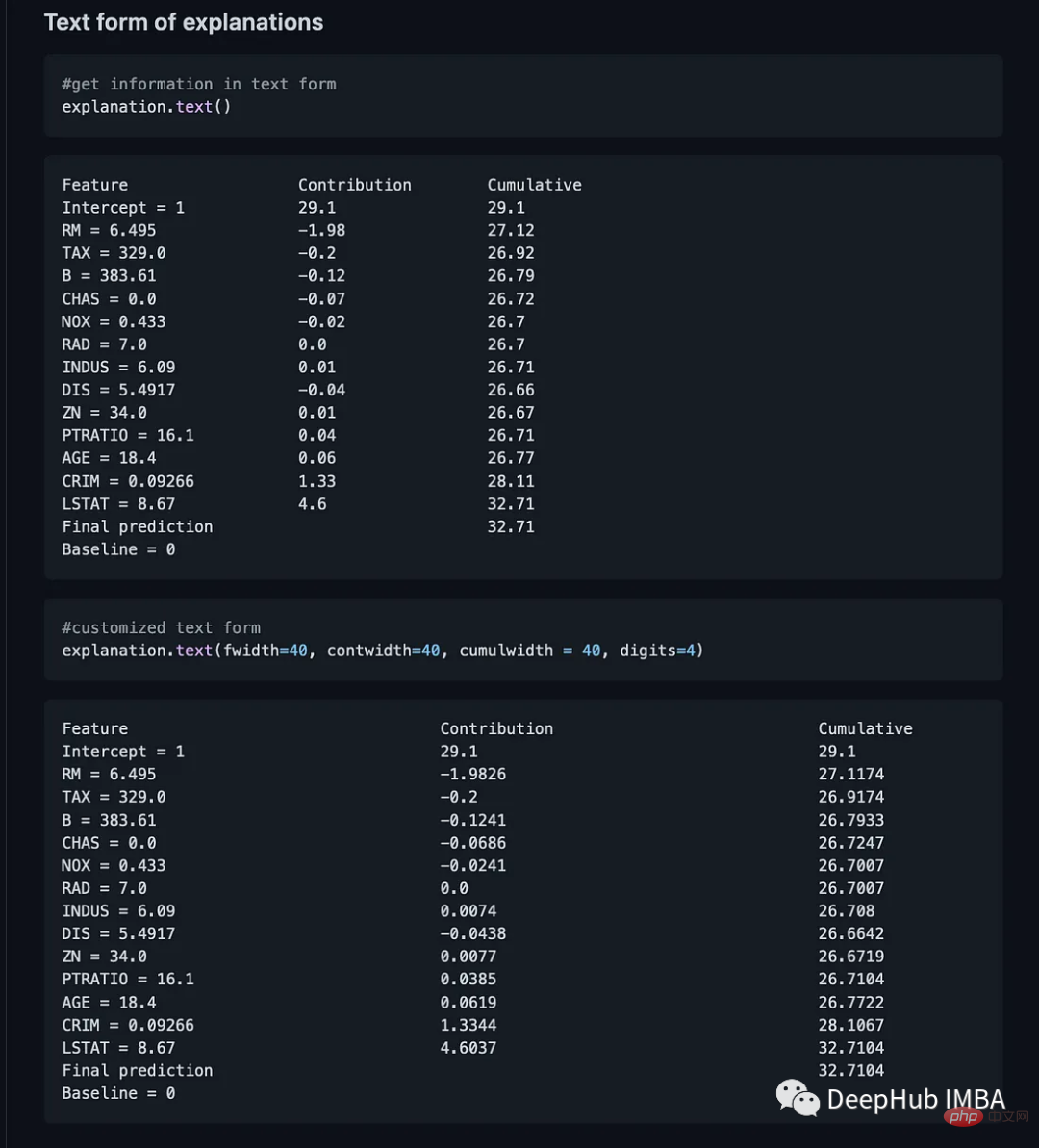

BreakDown ist ein Tool, mit dem lineare Modellvorhersagen erklärt werden können. Dabei wird die Ausgabe des Modells in den Beitrag jedes Eingabemerkmals zerlegt. Dieses Paket enthält zwei Hauptmethoden. Explainer() und Explanation()

model = tree.DecisionTreeRegressor() model = model.fit(train_data,y=train_labels) #necessary imports from pyBreakDown.explainer import Explainer from pyBreakDown.explanation import Explanation #make explainer object exp = Explainer(clf=model, data=train_data, colnames=feature_names) #What do you want to be explained from the data (select an observation) explanation = exp.explain(observation=data[302,:],direction="up")

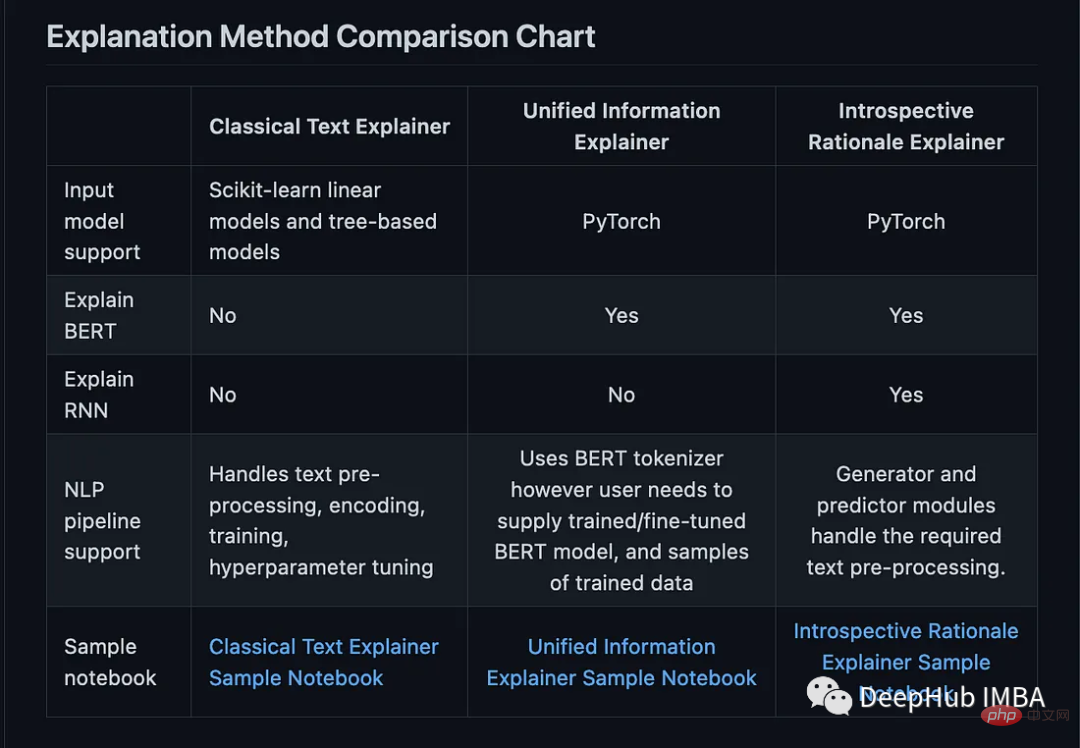

Interpret-Text kombiniert die von der Community für NLP-Modelle entwickelte Interpretierbarkeitstechnologie und ein Visualisierungspanel zum Anzeigen von Ergebnissen. Experimente können auf mehreren hochmodernen Interpretern durchgeführt und vergleichend analysiert werden. Dieses Toolkit kann Modelle des maschinellen Lernens global für jedes Tag oder lokal für jedes Dokument interpretieren.

Hier ist die Liste der in diesem Paket verfügbaren Dolmetscher:

OmniXAI (Omni explable AI的缩写),解决了在实践中解释机器学习模型产生的判断的几个问题。

它是一个用于可解释AI (XAI)的Python机器学习库,提供全方位的可解释AI和可解释机器学习功能,并能够解决实践中解释机器学习模型所做决策的许多痛点。OmniXAI旨在成为一站式综合库,为数据科学家、ML研究人员和从业者提供可解释的AI。

from omnixai.visualization.dashboard import Dashboard # Launch a dashboard for visualization dashboard = Dashboard( instances=test_instances,# The instances to explain local_explanations=local_explanations, # Set the local explanations global_explanations=global_explanations, # Set the global explanations prediction_explanations=prediction_explanations, # Set the prediction metrics class_names=class_names, # Set class names explainer=explainer# The created TabularExplainer for what if analysis ) dashboard.show()

XAI 库由 The Institute for Ethical AI & ML 维护,它是根据 Responsible Machine Learning 的 8 条原则开发的。它仍处于 alpha 阶段因此请不要将其用于生产工作流程。

Das obige ist der detaillierte Inhalt vonZehn Python-Bibliotheken für erklärbare KI. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!