Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die leichtgewichtige Version der ChatGPT-Trainingsmethode ist Open Source! Die Trainingsgeschwindigkeit wurde rund um LLaMA in nur drei Tagen entwickelt und soll 15-mal schneller sein als bei OpenAI

Die leichtgewichtige Version der ChatGPT-Trainingsmethode ist Open Source! Die Trainingsgeschwindigkeit wurde rund um LLaMA in nur drei Tagen entwickelt und soll 15-mal schneller sein als bei OpenAI

Die leichtgewichtige Version der ChatGPT-Trainingsmethode ist Open Source! Die Trainingsgeschwindigkeit wurde rund um LLaMA in nur drei Tagen entwickelt und soll 15-mal schneller sein als bei OpenAI

Die Lightweight-Version von ChatGPT basierend auf dem Meta-Modell ist da?

Meta hat die Einführung von LLaMA erst vor drei Tagen angekündigt, und die Branche hat bereits eine Open-Source-Trainingsmethode entwickelt, um sie in ChatGPT zu integrieren, die angeblich bis zu 15-mal schneller ist als das ChatGPT-Training.

LLaMA ist ein ultraschnelles und ultrakleines GPT-3, das von Meta eingeführt wurde. Die Anzahl der Parameter beträgt nur 10 % und es ist nur eine einzige GPU erforderlich.

Die Methode zur Umwandlung in ChatGPT heißt ChatLLaMA. Sie basiert auf RLHF (Reinforcement Learning basierend auf menschlichem Feedback) und wurde schnell zu einem heißen Thema im Internet.

Also kommt Metas Open-Source-Version von ChatGPT wirklich?

Moment mal, so einfach ist das nicht.

Trainieren Sie LLaMA in die „Open-Source-Methode“ von ChatGPT

Klicken Sie auf die Homepage des ChatLLaMA-Projekts und Sie werden feststellen, dass es tatsächlich vier Teile integriert:

DeepSpeed, RLHF-Methode, LLaMA und den auf dem LangChain-Agenten generierten Datensatz.

DeepSpeed ist eine Open-Source-Bibliothek zur Optimierung des Deep-Learning-Trainings, einschließlich einer vorhandenen Optimierungstechnologie namens Zero, die zur Verbesserung der Trainingsfähigkeiten großer Modelle verwendet wird. Dies bezieht sich insbesondere darauf, dem Modell dabei zu helfen, die Trainingsgeschwindigkeit zu verbessern und die Kosten zu senken , Modellverfügbarkeit verbessern usw.

RLHF wird das Belohnungsmodell verwenden, um das vorab trainierte Modell zu verfeinern. Das Belohnungsmodell verwendet zunächst mehrere Modelle, um Fragen und Antworten zu generieren, und verlässt sich dann auf die manuelle Sortierung der Fragen und Antworten, damit es lernen kann, Punkte zu erzielen. Anschließend bewertet es die vom Modell generierten Antworten auf der Grundlage des Belohnungslernens und verbessert die Ergebnisse Modellfähigkeiten durch verstärkendes Lernen.

LangChain ist eine große Entwicklungsbibliothek für Sprachmodellanwendungen, die darauf abzielt, verschiedene große Sprachmodelle zu integrieren und in Kombination mit anderen Wissensquellen oder Rechenleistung eine praktische Anwendung zu erstellen. Der LangChain-Agent wird den gesamten Prozess des GPT-3-Denkens wie eine Gedankenkette freigeben und die Vorgänge aufzeichnen.

Zu diesem Zeitpunkt werden Sie feststellen, dass das Modellgewicht von LLaMA immer noch das Wichtigste ist. Woher kommt es?

Hey, gehen Sie zu Meta und bewerben Sie sich selbst, ChatLLaMA bietet es nicht. (Obwohl Meta behauptet, Open-Source-LLaMA zu sein, müssen Sie sich dennoch bewerben.)

ChatLLaMA ist also im Wesentlichen kein Open-Source-ChatGPT-Projekt, sondern nur eine auf LLaMA basierende Trainingsmethode sind Open Source.

Tatsächlich wurde ChatLLaMA nicht von Meta entwickelt, sondern von einem Start-up-KI-Unternehmen namens Nebuly AI.

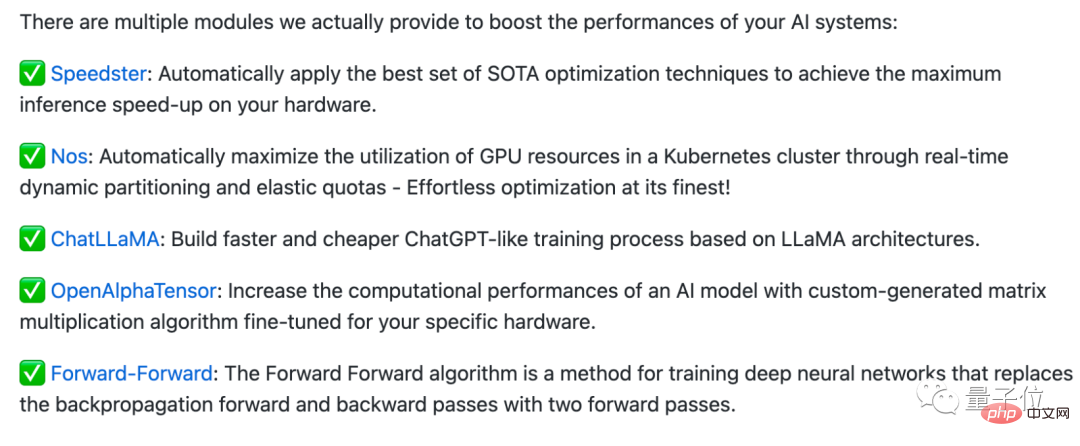

Nebuly AI hat eine Open-Source-Bibliothek namens Nebullvm erstellt, die eine Reihe von Plug-and-Play-Optimierungsmodulen integriert, um die Leistung des KI-Systems zu verbessern.

Dies sind zum Beispiel einige Module, die derzeit in Nebullvm enthalten sind, darunter OpenAlphaTensor, das auf dem Open-Source-AlphaTensor-Algorithmus von DeepMind basiert, Optimierungsmodule, die Hardware automatisch erkennen und beschleunigen ...

ChatLLaMA ist auch in dieser Modulreihe enthalten, Es ist jedoch zu beachten, dass die Open-Source-Lizenz nicht im Handel erhältlich ist.

Wenn Sie also das „inländische selbst entwickelte ChatGPT“ direkt verwenden möchten, ist dies möglicherweise nicht so einfach (Doge).

Nachdem sie dieses Projekt gelesen hatten, sagten einige Internetnutzer, dass es großartig wäre, wenn jemand wirklich die Modellgewichte (Code) von LLaMA bekommen könnte ...

Aber einige Internetnutzer wiesen darauf hin, dass es „15-mal schneller ist als die ChatGPT-Trainingsmethode“ Diese Aussage ist rein irreführend:

Die sogenannte 15-mal schnellere Geschwindigkeit liegt nur daran, dass das LLaMA-Modell selbst klein ist und sogar auf einer einzigen GPU laufen kann, aber das sollte nicht daran liegen, dass irgendetwas darin gemacht wurde dieses Projekt, oder?

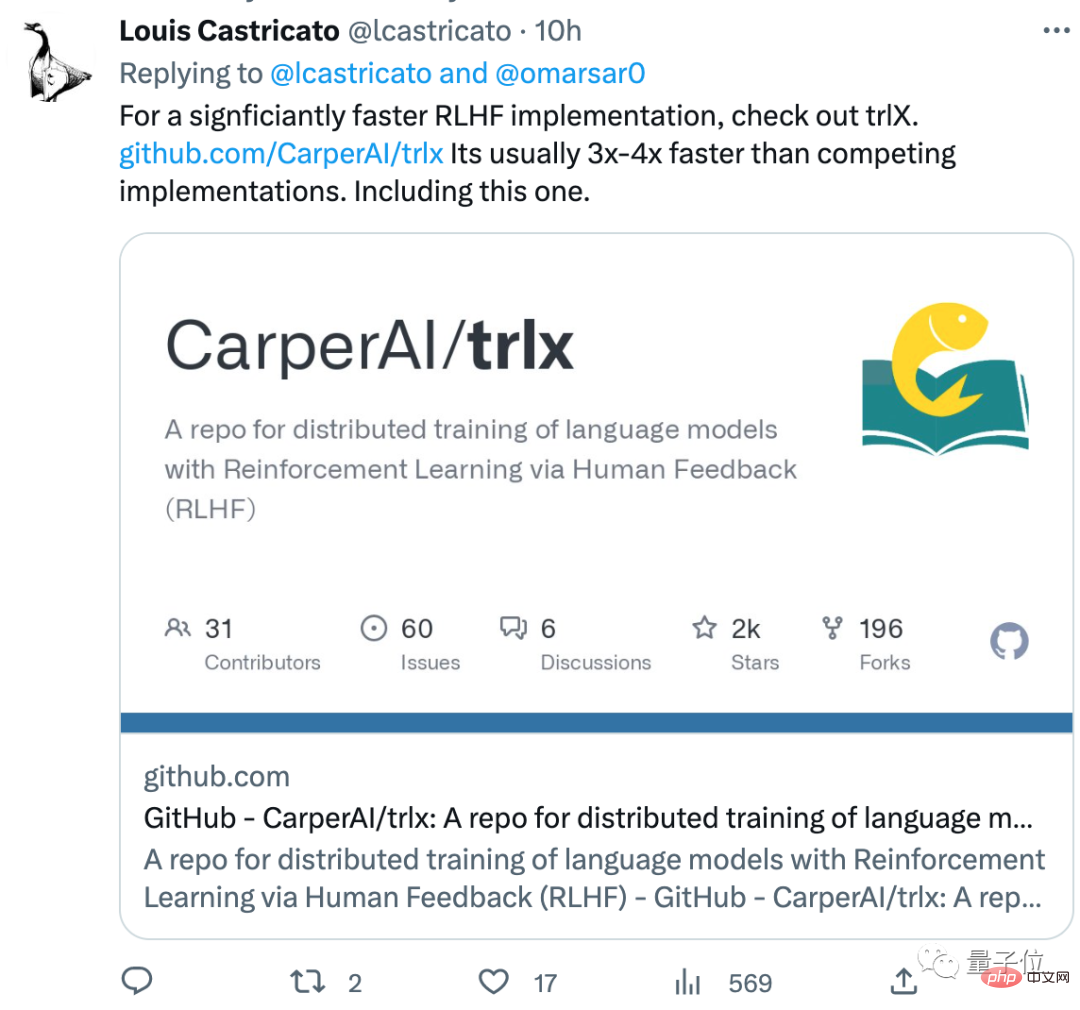

Dieser Internetnutzer hat auch eine RLHF-Trainingsmethode namens trlx empfohlen, die besser ist als die in der Bibliothek. Die Trainingsgeschwindigkeit ist 3 bis 4 Mal schneller als die übliche RLHF-Methode:

Sie nehmen es Hast du den Code für LLaMA? Was halten Sie von dieser Trainingsmethode?

ChatLLaMA-Adresse:https://www.php.cn/link/fed537780f3f29cc5d5f313bbda423c4

Referenzlink:https://www.php.cn/link/fe27f92b1e3f4997567807f38d567a35

Das obige ist der detaillierte Inhalt vonDie leichtgewichtige Version der ChatGPT-Trainingsmethode ist Open Source! Die Trainingsgeschwindigkeit wurde rund um LLaMA in nur drei Tagen entwickelt und soll 15-mal schneller sein als bei OpenAI. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1389

1389

52

52

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Was tun, wenn der Bluescreen-Code 0x0000001 auftritt?

Feb 23, 2024 am 08:09 AM

Was tun, wenn der Bluescreen-Code 0x0000001 auftritt?

Feb 23, 2024 am 08:09 AM

Was tun mit dem Bluescreen-Code 0x0000001? Der Bluescreen-Fehler ist ein Warnmechanismus, wenn ein Problem mit dem Computersystem oder der Hardware vorliegt. Der Code 0x0000001 weist normalerweise auf einen Hardware- oder Treiberfehler hin. Wenn Benutzer bei der Verwendung ihres Computers plötzlich auf einen Bluescreen-Fehler stoßen, geraten sie möglicherweise in Panik und sind ratlos. Glücklicherweise können die meisten Bluescreen-Fehler mit ein paar einfachen Schritten behoben werden. In diesem Artikel werden den Lesern einige Methoden zur Behebung des Bluescreen-Fehlercodes 0x0000001 vorgestellt. Wenn ein Bluescreen-Fehler auftritt, können wir zunächst versuchen, neu zu starten

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Kürzlich wurde die Militärwelt von der Nachricht überwältigt: US-Militärkampfflugzeuge können jetzt mithilfe von KI vollautomatische Luftkämpfe absolvieren. Ja, erst kürzlich wurde der KI-Kampfjet des US-Militärs zum ersten Mal der Öffentlichkeit zugänglich gemacht und sein Geheimnis gelüftet. Der vollständige Name dieses Jägers lautet „Variable Stability Simulator Test Aircraft“ (VISTA). Er wurde vom Minister der US-Luftwaffe persönlich geflogen, um einen Eins-gegen-eins-Luftkampf zu simulieren. Am 2. Mai startete US-Luftwaffenminister Frank Kendall mit einer X-62AVISTA auf der Edwards Air Force Base. Beachten Sie, dass während des einstündigen Fluges alle Flugaktionen autonom von der KI durchgeführt wurden! Kendall sagte: „In den letzten Jahrzehnten haben wir über das unbegrenzte Potenzial des autonomen Luft-Luft-Kampfes nachgedacht, aber es schien immer unerreichbar.“ Nun jedoch,

Universal-Fernbedienungscode-Programm von GE auf jedem Gerät

Mar 02, 2024 pm 01:58 PM

Universal-Fernbedienungscode-Programm von GE auf jedem Gerät

Mar 02, 2024 pm 01:58 PM

Wenn Sie ein Gerät aus der Ferne programmieren müssen, hilft Ihnen dieser Artikel. Wir teilen Ihnen die besten Universal-Fernbedienungscodes von GE für die Programmierung aller Geräte mit. Was ist eine GE-Fernbedienung? GEUniversalRemote ist eine Fernbedienung, mit der mehrere Geräte wie Smart-TVs, LG, Vizio, Sony, Blu-ray, DVD, DVR, Roku, AppleTV, Streaming-Media-Player und mehr gesteuert werden können. GEUniversal-Fernbedienungen gibt es in verschiedenen Modellen mit unterschiedlichen Merkmalen und Funktionen. GEUniversalRemote kann bis zu vier Geräte steuern. Top-Universalfernbedienungscodes zum Programmieren auf jedem Gerät GE-Fernbedienungen werden mit einer Reihe von Codes geliefert, die es ihnen ermöglichen, mit verschiedenen Geräten zu arbeiten. Sie können

Für nur 250 US-Dollar zeigt Ihnen der technische Leiter von Hugging Face Schritt für Schritt, wie Sie Llama 3 verfeinern

May 06, 2024 pm 03:52 PM

Für nur 250 US-Dollar zeigt Ihnen der technische Leiter von Hugging Face Schritt für Schritt, wie Sie Llama 3 verfeinern

May 06, 2024 pm 03:52 PM

Die bekannten großen Open-Source-Sprachmodelle wie Llama3 von Meta, Mistral- und Mixtral-Modelle von MistralAI und Jamba von AI21 Lab sind zu Konkurrenten von OpenAI geworden. In den meisten Fällen müssen Benutzer diese Open-Source-Modelle anhand ihrer eigenen Daten verfeinern, um das Potenzial des Modells voll auszuschöpfen. Es ist nicht schwer, ein großes Sprachmodell (wie Mistral) im Vergleich zu einem kleinen mithilfe von Q-Learning auf einer einzelnen GPU zu optimieren, aber die effiziente Feinabstimmung eines großen Modells wie Llama370b oder Mixtral blieb bisher eine Herausforderung . Deshalb Philipp Sch, technischer Leiter von HuggingFace