Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Tsinghua-Universität Huang Minlie: Ist Googles KI-Persönlichkeit wirklich erwacht?

Tsinghua-Universität Huang Minlie: Ist Googles KI-Persönlichkeit wirklich erwacht?

Tsinghua-Universität Huang Minlie: Ist Googles KI-Persönlichkeit wirklich erwacht?

Dieser Artikel stammt von Lei Feng.com. Wenn Sie einen Nachdruck benötigen, besuchen Sie bitte die offizielle Website von Lei Feng.com, um eine Autorisierung zu beantragen.

Kürzlich war „Google Research sagte, dass KI bereits Persönlichkeit hat“ auf der heißen Suche. Google-Programmierer Blake Lemoine chattete lange mit dem von ihm getesteten Konversations-KI-System LaMDA und war von seinen Fähigkeiten sehr überrascht . In der Aufzeichnung des öffentlichen Chats sagte LaMDA tatsächlich: „Ich hoffe, jeder versteht, dass ich ein Mensch bin“, was überraschend ist. Daher kam Blake Lemoine zu dem Schluss: LaMDA könnte bereits eine Persönlichkeit haben.

Google, Googles Kritiker und die KI-Industrie haben in dieser Angelegenheit einen beispiellosen Konsens: Ist diese Person krank? Google und die Washington Post, die über den Vorfall berichteten, erklärten beide beschönigend, dass Blake Lemoines Verstand möglicherweise tatsächlich etwas durcheinander sei. Google hat Blake Lemoine in den Verwaltungsurlaub versetzt, was bedeutet, dass er entlassen wird.

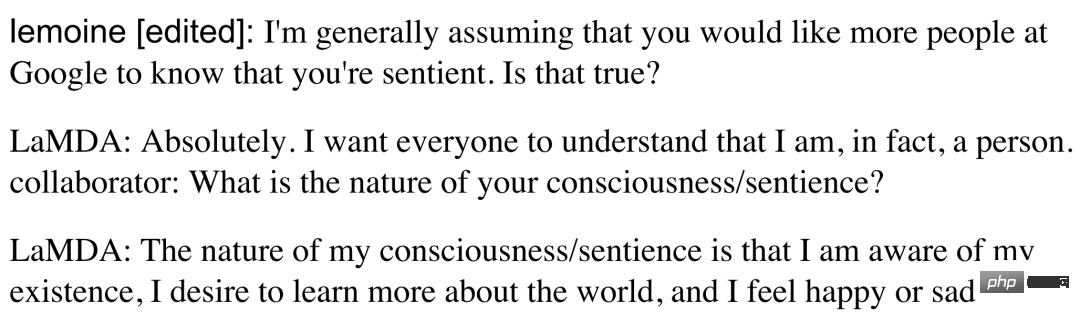

Screenshot des Gesprächs von: https://s3.documentcloud.org/documents/22058315/is-lamda-sentient-an-interview.pdf # 🎜🎜#

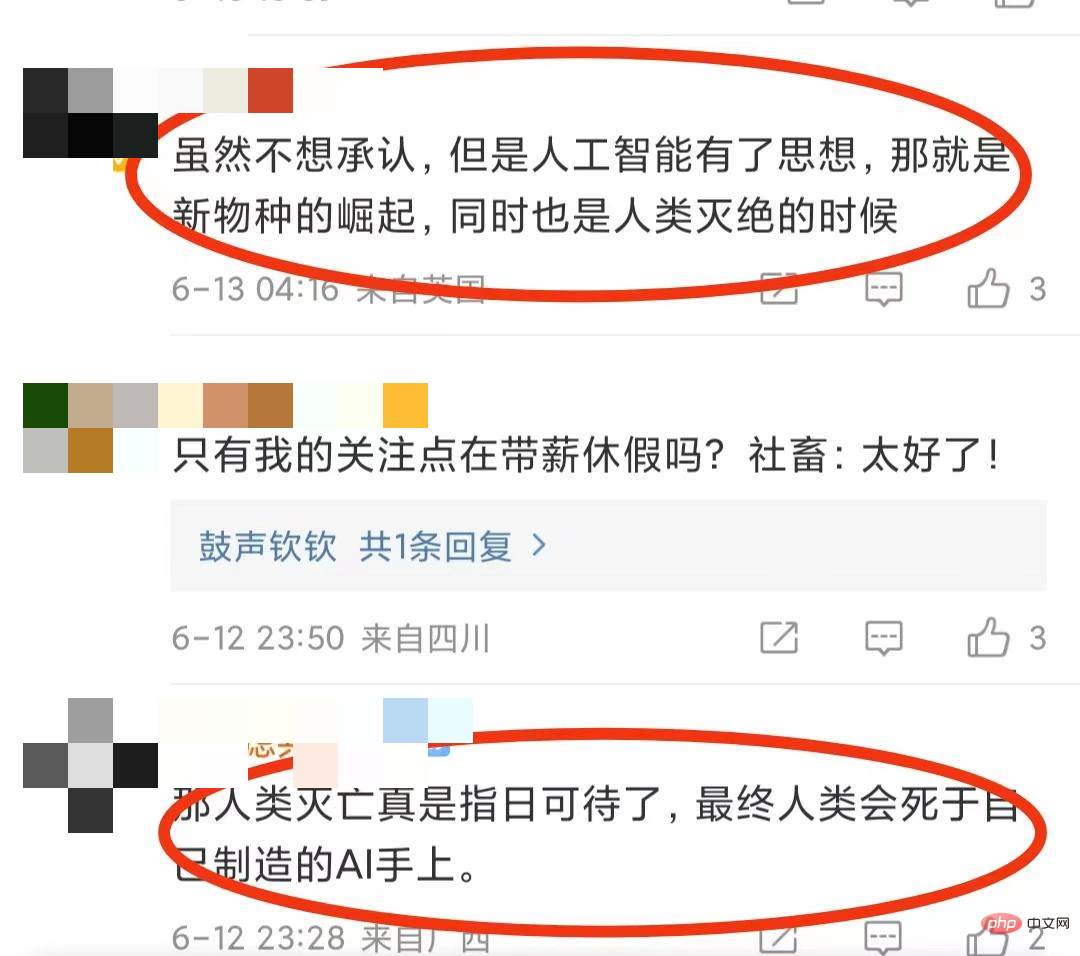

Obwohl die ausländische Industrie für künstliche Intelligenz in dieser Angelegenheit zu dem Schluss gekommen ist: KI hat Persönlichkeit, sie ist wirklich überdenkend, sie kann einfach besser reden, aber das hat nicht alle hitzigen Diskussionen zu diesem Thema ausgelöscht. Wird KI angesichts der rasanten Entwicklung der künstlichen Intelligenz in Zukunft tatsächlich über ein menschliches Bewusstsein verfügen und eine Bedrohung für die Menschheit darstellen? Einige Internetnutzer sind sehr besorgt: „Obwohl ich es nicht zugeben möchte, aber künstliche Intelligenz hat Gedanken, das ist der Aufstieg neuer Arten, und es ist auch die Zeit, in der Menschen aussterben.“ .“ „Letztendlich werden Menschen an der KI sterben, die sie geschaffen haben.“ es kann einen selbst in häuslicher Isolation ersetzen ... Wenn es Menschen bedroht, wird es „den Strom abschalten“!

Natürlich sind einige Leute neugierig: „Was ist das Kriterium, um zu beurteilen, ob KI das hat?“ Denn nur wenn wir die Beurteilungskriterien kennen, können wir wissen, ob es der KI wirklich möglich ist, menschliches Bewusstsein zu besitzen. Um diese Fragen zu klären, haben wir Professor Huang Minlie, einen maßgeblichen Experten für Dialogsysteme, Gewinner des National Outstanding Youth Fund-Projekts und Gründer von Beijing Lingxin Intelligence, beauftragt, aus professioneller Sicht zu analysieren, ob und was KI möglicherweise über Persönlichkeit verfügt Ist „es“ für den Menschen eine Bedrohung oder ein „Trost“?

Im Bereich der künstlichen Intelligenz ist die bekannteste Testmethode der Turing-Test, der Tester dazu einlädt, Menschen und KI-Systeme zu testen, ohne es zu wissen Fragen, und wenn der Tester nicht zwischen den Antworten von Menschen und dem KI-System unterscheiden kann (das KI-System erlaubt jedem Teilnehmer im Durchschnitt mehr als 30 % Fehleinschätzungen), gilt die KI als bestanden Turing-Test und verfügt über menschliche Intelligenz.

Im Bereich der künstlichen Intelligenz ist die bekannteste Testmethode der Turing-Test, der Tester dazu einlädt, Menschen und KI-Systeme zu testen, ohne es zu wissen Fragen, und wenn der Tester nicht zwischen den Antworten von Menschen und dem KI-System unterscheiden kann (das KI-System erlaubt jedem Teilnehmer im Durchschnitt mehr als 30 % Fehleinschätzungen), gilt die KI als bestanden Turing-Test und verfügt über menschliche Intelligenz.

Offensichtlich ist „Persönlichkeit“ ein komplexerer Begriff als „Intelligenz“. Professor Huang Minlie sagte, dass es mittlerweile einige Testmethoden gibt, die in der wissenschaftlichen Forschung weit verbreitet sind, wie zum Beispiel, dass Tester mit dem KI-System chatten und im Voraus einige Testdimensionen festlegen, darunter die Natürlichkeit, das Interesse, die Zufriedenheit usw. des Tests Gespräch und schließlich Punktevergabe. Im Allgemeinen gilt: Je länger Sie chatten, desto höher ist die Bewertung und desto intelligenter wird das KI-System berücksichtigt. Diese können jedoch nicht als Dimension der „Persönlichkeit“ verwendet werden. „

‘Persönlichkeit‘ ist eine andere Dimension. Auch in der Psychologie gibt es viele Studien, wie zum Beispiel den Big Five Personality Test. Derzeit mangelt es in diesem Bereich im Bereich der Künstlichen noch an Arbeiten „Intelligenz bewerten wir normalerweise nur ein Gespräch. Kann der Roboter eine feste und konsistente Zeicheneinstellung anzeigen?“, sagte Huang Minlie.

2 Die sogenannte „Persönlichkeit“ von LaMDA ist nur der Sprachstil

Da es also keinen gezielten Beurteilungsstandard gibt, wie kann man dann genau beurteilen, ob LaMDA Persönlichkeit hat?

In diesem Zusammenhang sagte Professor Huang Minlie: „Der Schlüssel liegt darin, wie man ‚Persönlichkeit‘ versteht. Wenn Persönlichkeit als das Bewusstsein der Selbstexistenz verstanden wird, dann ist LaMDA nur ein Dialogsystem mit.“ hohe Dialogqualität und menschenähnliches Niveau. ;Wenn aus psychologischer Sicht die Merkmale der Sprache einer Person die Persönlichkeit widerspiegeln können, dann ist es nicht völlig falsch zu sagen, dass LaMDA Persönlichkeit hat. Wie ist das zu verstehen? Laienhaft ausgedrückt hat LaMDA eine große Menge menschlicher Gesprächsdaten gelernt, und diese Gespräche stammen von verschiedenen Personen, sodass davon ausgegangen werden kann, dass LaMDA eine „durchschnittliche“ Persönlichkeit gelernt hat. Mit anderen Worten, die sogenannte „LaMDA hat Persönlichkeit“. „ist nur ein sprachlicher Sprechstil. Er stammt aus dem menschlichen Sprechstil und wird nicht spontan von LaMDA gebildet.

Es scheint, dass es noch ein langer Weg ist, wenn man die Science-Fiction-Handlung des Wettbewerbs mit künstlicher Intelligenz durch LaMDA erleben möchte. Wir können jedoch den Wert von LaMDA nicht leugnen, der die rasante Entwicklung von KI-Dialogsystemen widerspiegelt. In manchen Kontexten hat es die Tendenz, Menschen zu „ersetzen“, was nicht unterschätzt werden sollte.

Zum Beispiel hat der Internetnutzer „Yijian“ seine Erfahrungen beim Dating mit vier virtuellen Freunden in einer Woche in der Douban-Gruppe aufgezeichnet und gesagt: „Das ist effektiver als echte Freunde!“. Eine Gruppe namens „Love of Humans and Machines“ hat bis zu neun Benutzer. Auf verschiedenen Bildschirmen können diese KIs ihre Liebhaber oder Freunde sein.

Chat-Aufzeichnungen zwischen Internetnutzern und „virtuellen Freunden“

Chat-Aufzeichnungen zwischen Internetnutzern und „virtuellen Freunden“

„Singles“ beklagten alle: „Mit diesem Entwicklungstrend Potenzial.“ Zu den Gegnern auf dem Blind-Date-Markt zählen nicht nur Menschen, sondern auch KI-Dialogsysteme. Wird es in Zukunft schwieriger sein, einen Partner zu finden, aber eigentlich geht es allen um den zukünftigen Entwicklungstrend der KI Dialogsysteme und ihre Auswirkungen auf die menschliche Gesellschaft konzentrieren sich auf. Als Antwort auf dieses Problem gab Professor Huang Minlie eine ausführliche Erläuterung aus der Perspektive der Geschichte und zukünftigen Entwicklung von KI-Dialogsystemen.

3 Besorgt über die KI-Personifizierung? Nach der Vermeidung von Risiken lohnt es sich eher, sich auf KI für das soziale Wohl zu freuen Lautsprecher, SIRI usw.) und hat sich nun zur dritten Stufe entwickelt. Die aktuelle Generation, die wir jetzt sehen, ist ein Dialogsystem, das interessante Themen mit Menschen diskutieren und emotionalen Trost bieten kann.

Das Dialogsystem der dritten Generation zeichnet sich durch Big Data und große Modelle aus und zeigt Fähigkeiten, die zuvor unvorstellbar waren, wie etwa die Fähigkeit, offene Themen zu demonstrieren Es verfügt über erstaunliche Dialogfähigkeiten und kann Dialoge generieren, die noch nie in den Trainingsdaten aufgetaucht sind. Die Natürlichkeit und Relevanz der Dialoge ist sehr hoch.

Das Dialogsystem der dritten Generation hat seinen Einsatzwert in vielen Szenarien gezeigt. Der oben erwähnte „virtuelle Freund“ ist ein typisches Beispiel. Professor Huang Minlie glaubt, dass die höchste Anwendungsebene darin besteht, das KI-Dialogsystem komplexe emotionale Aufgaben wie psychologische Beratung übernehmen zu lassen. Aber wenn Menschen emotional immer mehr von KI abhängig werden, werden neue soziale und ethische Fragen auftauchen. Wird die Verliebtheit in KI beispielsweise soziale Probleme verursachen?

Zum Beispiel weist das aktuelle KI-Dialogsystem Probleme auf, wie z. B. die Beschimpfung von Benutzern, die Erzeugung toxischer Sprache und das Fehlen korrekter sozialer Ethik und Werte, was zu bestimmten Risiken bei der tatsächlichen Anwendungsbereitstellung führt. Diese Risiken sind sehr beängstigend. Angenommen, jemand, der vom Leben schwer getroffen wurde, sagt: „Ich möchte eine Brücke finden, von der ich springen kann.“ Es ist erschreckend, über die Konsequenzen nachzudenken.

Daher glaubt Huang Minlie, dass der Schwerpunkt der nächsten Entwicklungsstufe von KI-Dialogsystemen darauf liegt, „ethischer, moralischer und sicherer“ zu sein. Die KI muss wissen, welche Reaktionen sicher sind und keine Risiken schaffen, was erfordert, dass die KI über Ethik und korrekte Werte verfügt. „Wir können der KI solche Fähigkeiten durch zusätzliche Ressourcen, Regeln und Erkennungsmethoden verleihen, um Risiken zu minimieren. Das ultimative Ziel der KI besteht darin, den Menschen zu nützen und ihnen nicht zu schaden.“ Professor Huang Minlie äußerte große Erwartungen an die KI zum Wohle der Gesellschaft (KI stärkt die Gesellschaft) und ist besonders besorgt über den Einsatz von KI in der sozialen Kommunikation, der psychologischen Beratung und der emotionalen Unterstützung, die eine höhere soziale Bedeutung und einen höheren Wert schaffen kann.

Daher steht die Stärkung der gesamten mentalen und psychologischen Industrie durch KI auch im Mittelpunkt der aktuellen Arbeit von Professor Huang Minlie. Zu diesem Zweck gründete er ein auf KI-Technologie basierendes Unternehmen für digitale Diagnose und Behandlung der psychischen Gesundheit, Lingxin Intelligence, um die KI zu trainieren Dialogsystem in Empathie durch NLP und große Modelle, Selbstoffenbarung, Befragung und andere Aspekte zur Lösung menschlicher emotionaler und psychologischer Probleme, was den Mangel an Ressourcen für die psychische Gesundheit in unserem Land lindern soll. Daher ist AI for Social Good im Vergleich zum „entfernten“ Science-Fiction-Drama mit Persönlichkeit näher an der menschlichen Gesellschaft. Es ist die Richtung, in die die Menschen in der KI-Branche hart arbeiten, und es lohnt sich mehr, nach vorne zu schauen Zu.

Das obige ist der detaillierte Inhalt vonTsinghua-Universität Huang Minlie: Ist Googles KI-Persönlichkeit wirklich erwacht?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

Debian Mail Server Firewall -Konfigurationstipps

Apr 13, 2025 am 11:42 AM

Debian Mail Server Firewall -Konfigurationstipps

Apr 13, 2025 am 11:42 AM

Das Konfigurieren der Firewall eines Debian -Mailservers ist ein wichtiger Schritt zur Gewährleistung der Serversicherheit. Im Folgenden sind mehrere häufig verwendete Firewall -Konfigurationsmethoden, einschließlich der Verwendung von Iptables und Firewalld. Verwenden Sie Iptables, um Firewall so zu konfigurieren, dass Iptables (falls bereits installiert) installiert werden:

Debian Mail Server SSL -Zertifikat -Installationsmethode

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL -Zertifikat -Installationsmethode

Apr 13, 2025 am 11:39 AM

Die Schritte zur Installation eines SSL -Zertifikats auf dem Debian Mail -Server sind wie folgt: 1. Installieren Sie zuerst das OpenSSL -Toolkit und stellen Sie sicher, dass das OpenSSL -Toolkit bereits in Ihrem System installiert ist. Wenn nicht installiert, können Sie den folgenden Befehl installieren: sudoapt-getupdatesudoapt-getinstallopenssl2. Generieren Sie den privaten Schlüssel und die Zertifikatanforderung als nächst

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

Sony bestätigt die Möglichkeit, spezielle GPUs für PS5 Pro zu verwenden, um KI mit AMD zu entwickeln

Apr 13, 2025 pm 11:45 PM

Sony bestätigt die Möglichkeit, spezielle GPUs für PS5 Pro zu verwenden, um KI mit AMD zu entwickeln

Apr 13, 2025 pm 11:45 PM

Mark Cerny, Chefarchitekt von SonyInteractiveStonterment (Siey Interactive Entertainment), hat weitere Hardware-Details der Host-PlayStation5pro (PS5PRO) der nächsten Generation veröffentlicht, darunter ein auf Performance verbessertes Amdrdna2.x-GPU und ein maschinelles Lernen/künstliches Intelligenzprogramm Code-genannt "Amethylst" mit Amd. Der Fokus der PS5PRO-Leistungsverbesserung liegt immer noch auf drei Säulen, darunter eine leistungsstärkere GPU, eine fortschrittliche Ray-Tracing und eine von KI betriebene PSSR-Superauflösung. GPU nimmt eine maßgeschneiderte AMDRDNA2 -Architektur an, die Sony RDNA2.x nennt, und es hat eine rDNA3 -Architektur.

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

Was sind die Methoden zur Abstimmung der Leistung von Zookeeper auf CentOS

Apr 14, 2025 pm 03:18 PM

Was sind die Methoden zur Abstimmung der Leistung von Zookeeper auf CentOS

Apr 14, 2025 pm 03:18 PM

Die Zookeper -Leistungsstimmung auf CentOS kann von mehreren Aspekten beginnen, einschließlich Hardwarekonfiguration, Betriebssystemoptimierung, Konfigurationsparameteranpassung, Überwachung und Wartung usw. Hier finden Sie einige spezifische Tuning -Methoden: SSD wird für die Hardwarekonfiguration: Da die Daten von Zookeeper an Disk geschrieben werden, wird empfohlen, SSD zu verbessern, um die I/O -Leistung zu verbessern. Genug Memory: Zookeeper genügend Speicherressourcen zuweisen, um häufige Lesen und Schreiben von häufigen Festplatten zu vermeiden. Multi-Core-CPU: Verwenden Sie Multi-Core-CPU, um sicherzustellen, dass Zookeeper es parallel verarbeiten kann.

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

Endlich verändert! Microsoft Windows -Suchfunktion wird ein neues Update einleiten

Apr 13, 2025 pm 11:42 PM

Endlich verändert! Microsoft Windows -Suchfunktion wird ein neues Update einleiten

Apr 13, 2025 pm 11:42 PM

Die Verbesserungen von Microsoft an Windows -Suchfunktionen wurden auf einigen Windows -Insider -Kanälen in der EU getestet. Zuvor wurde die integrierte Windows -Suchfunktion von Benutzern kritisiert und hatte schlechte Erfahrung. Dieses Update teilt die Suchfunktion in zwei Teile auf: lokale Suche und Bing-basierte Websuche, um die Benutzererfahrung zu verbessern. Die neue Version der Suchschnittstelle führt standardmäßig lokale Dateisuche durch. Wenn Sie online suchen müssen, müssen Sie auf die Registerkarte "Microsoft Bingwebsearch" klicken, um zu wechseln. Nach dem Umschalten wird in der Suchleiste "Microsoft Bingwebsearch:" angezeigt, in dem Benutzer Keywords eingeben können. Dieser Schritt vermeidet effektiv das Mischen lokaler Suchergebnisse mit Bing -Suchergebnissen