Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Natürliche Sprache ist in NeRF integriert, und LERF, das mit nur wenigen Worten 3D-Bilder generiert, ist da.

Natürliche Sprache ist in NeRF integriert, und LERF, das mit nur wenigen Worten 3D-Bilder generiert, ist da.

Natürliche Sprache ist in NeRF integriert, und LERF, das mit nur wenigen Worten 3D-Bilder generiert, ist da.

NeRF (Neural Radiance Fields), auch bekannt als neuronale Strahlungsfelder, hat sich seit seiner Einführung schnell zu einem der beliebtesten Forschungsgebiete entwickelt und die Ergebnisse sind erstaunlich. Die direkte Ausgabe von NeRF ist jedoch nur ein farbiges Dichtefeld, das den Forschern nur wenige Informationen liefert. Der Mangel an Kontext ist eines der Probleme, mit denen man sich befassen muss. Der Effekt besteht darin, dass er sich direkt auf die Konstruktion interaktiver Schnittstellen mit 3D auswirkt Szenen.

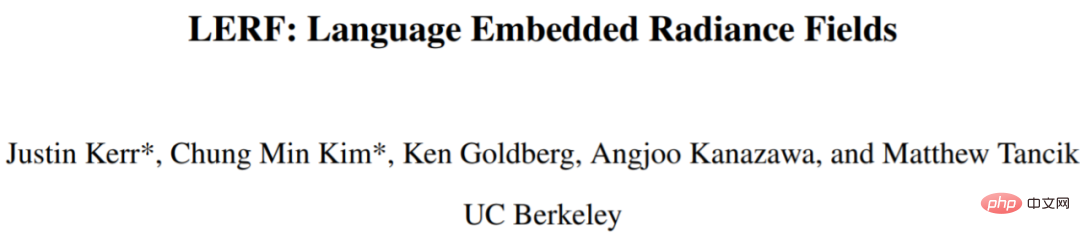

Aber natürliche Sprache ist anders. Natürliche Sprache interagiert sehr intuitiv mit 3D-Szenen. Wir können die Küchenszene in Abbildung 1 verwenden, um zu erklären, dass Objekte in der Küche gefunden werden können, indem man fragt, wo sich das Besteck befindet, oder fragt, wo sich die zum Rühren verwendeten Werkzeuge befinden. Um diese Aufgabe zu erfüllen, sind jedoch nicht nur die Abfragefähigkeiten des Modells erforderlich, sondern auch die Fähigkeit, Semantik auf mehreren Skalen zu integrieren.

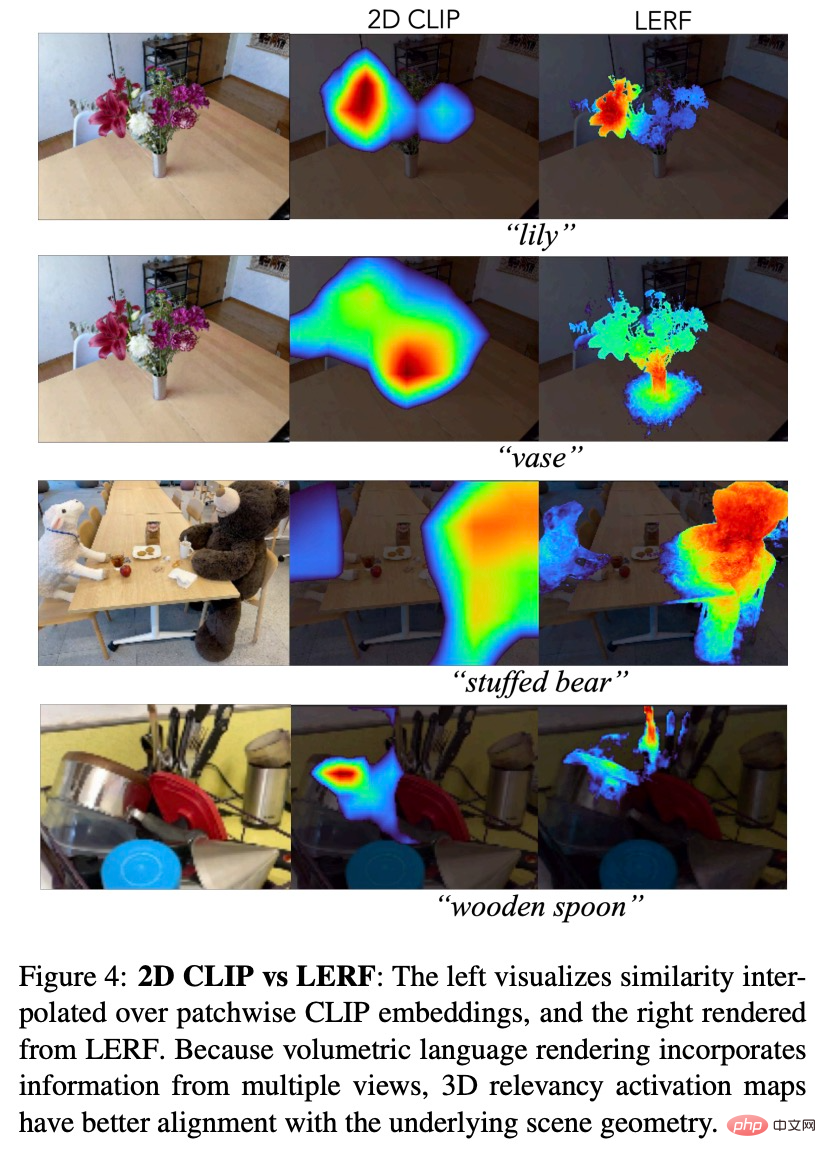

In diesem Artikel schlugen Forscher der UC Berkeley eine neuartige Methode vor und nannten sie LERF (Language Embedded Radiance Fields), die Sprachen in Modelle wie CLIP (Contrastive Language-Image Pre-training) einbettet NeRF, wodurch diese Art von 3D-Open-Language-Abfragen möglich wird. LERF verwendet CLIP direkt, ohne dass eine Feinabstimmung durch Datensätze wie COCO erforderlich ist oder sich auf Vorschläge für maskierte Regionen verlassen muss. LERF bewahrt die Integrität von CLIP-Einbettungen auf mehreren Ebenen und ist außerdem in der Lage, eine Vielzahl sprachlicher Abfragen zu verarbeiten, einschließlich visueller Attribute (z. B. Gelb), abstrakter Konzepte (z. B. elektrischer Strom), Text usw., wie in Abbildung 1 dargestellt .

Paper -Adresse: https://arxiv.org/pdf/2303.09553v1.pdf

project Homepage: https://www.lerf.io/

LERF kann interaktiv 3D-Korrelationsdiagramme für Sprachansagen in Echtzeit extrahieren. Geben Sie beispielsweise auf einem Tisch mit einem Lamm und einem Wasserbecher das prompte Lamm oder den Wasserbecher ein, und LERF kann die entsprechende 3D-Karte bereitstellen:

Bei komplexen Blumensträußen kann LERF auch Folgendes genau positionieren:

Verschiedene Objekte in der Küche:

Methode

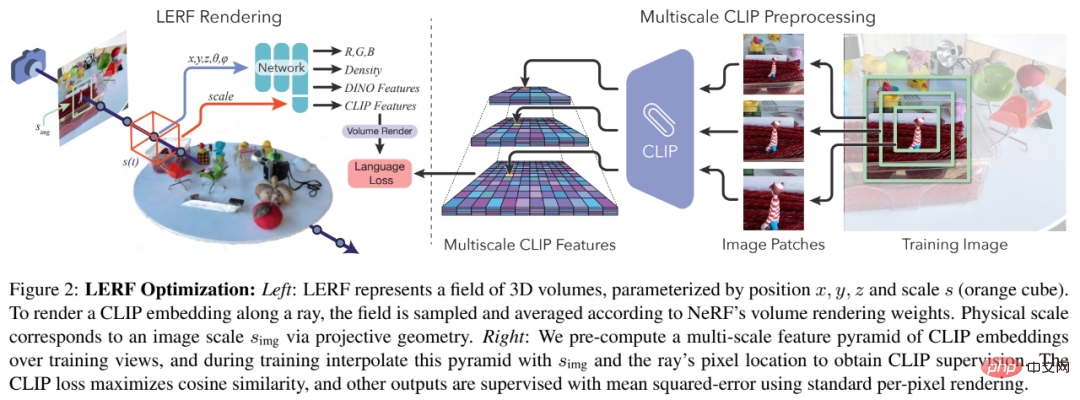

Diese Studie konstruierte eine neue Methode LERF, indem sie gemeinsam mit NeRF das Sprachfeld optimierte. LERF verwendet Position und physikalische Skalierung als Eingabe und gibt einen einzelnen CLIP-Vektor aus. Während des Trainings werden die Felder mithilfe einer mehrskaligen Feature-Pyramide überwacht, die CLIP-Einbettungen enthält, die aus Bildausschnitten der Trainingsansichten generiert werden. Dadurch kann der CLIP-Encoder den Bildkontext in unterschiedlichen Maßstäben erfassen und so denselben 3D-Standort mit Spracheinbettungen in unterschiedlichen Maßstäben verknüpfen. LERF kann während des Tests das Sprachfeld in jedem Maßstab abfragen, um eine 3D-Korrelationskarte zu erhalten.

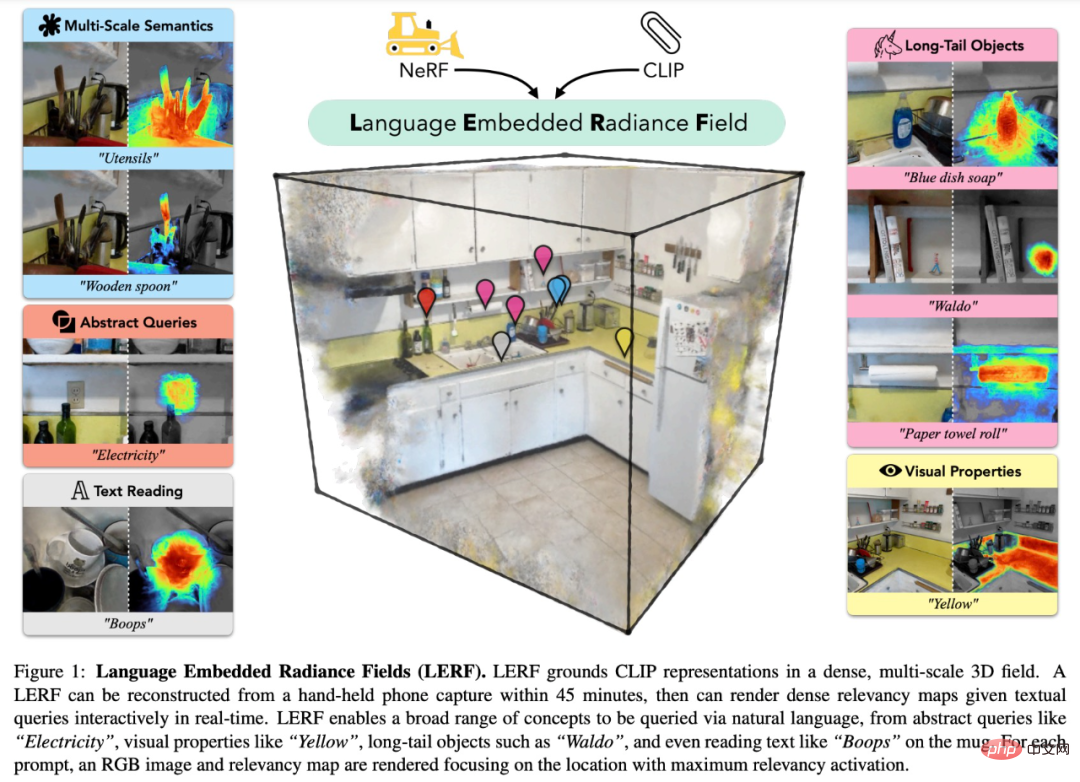

Da CLIP-Einbettungen aus mehreren Ansichten in mehreren Maßstäben extrahiert werden, ist die Relevanzkarte einer Textabfrage, die durch die 3D-CLIP-Einbettung erhalten wird, stärker lokalisiert als die, die durch die 2D-CLIP-Einbettung erhalten wird, und ist 3D-konsistent und kann direkt im 3D-Feld abgefragt werden, ohne dass mehrere Ansichten gerendert werden müssen.

LERF erfordert das Erlernen eines Spracheinbettungsfelds auf einem Volumen, das auf einem Beispielpunkt zentriert ist. Konkret handelt es sich bei der Ausgabe dieses Feldes um die durchschnittliche CLIP-Einbettung aller Trainingsansichten, die Bildausschnitte des angegebenen Volumens enthalten. Durch die Rekonstruktion der Abfrage von Punkten zu Volumina kann LERF dichte Felder aus groben Ausschnitten von Eingabebildern effektiv überwachen, die durch Konditionierung auf einer bestimmten volumetrischen Skala pixelausgerichtet gerendert werden können.

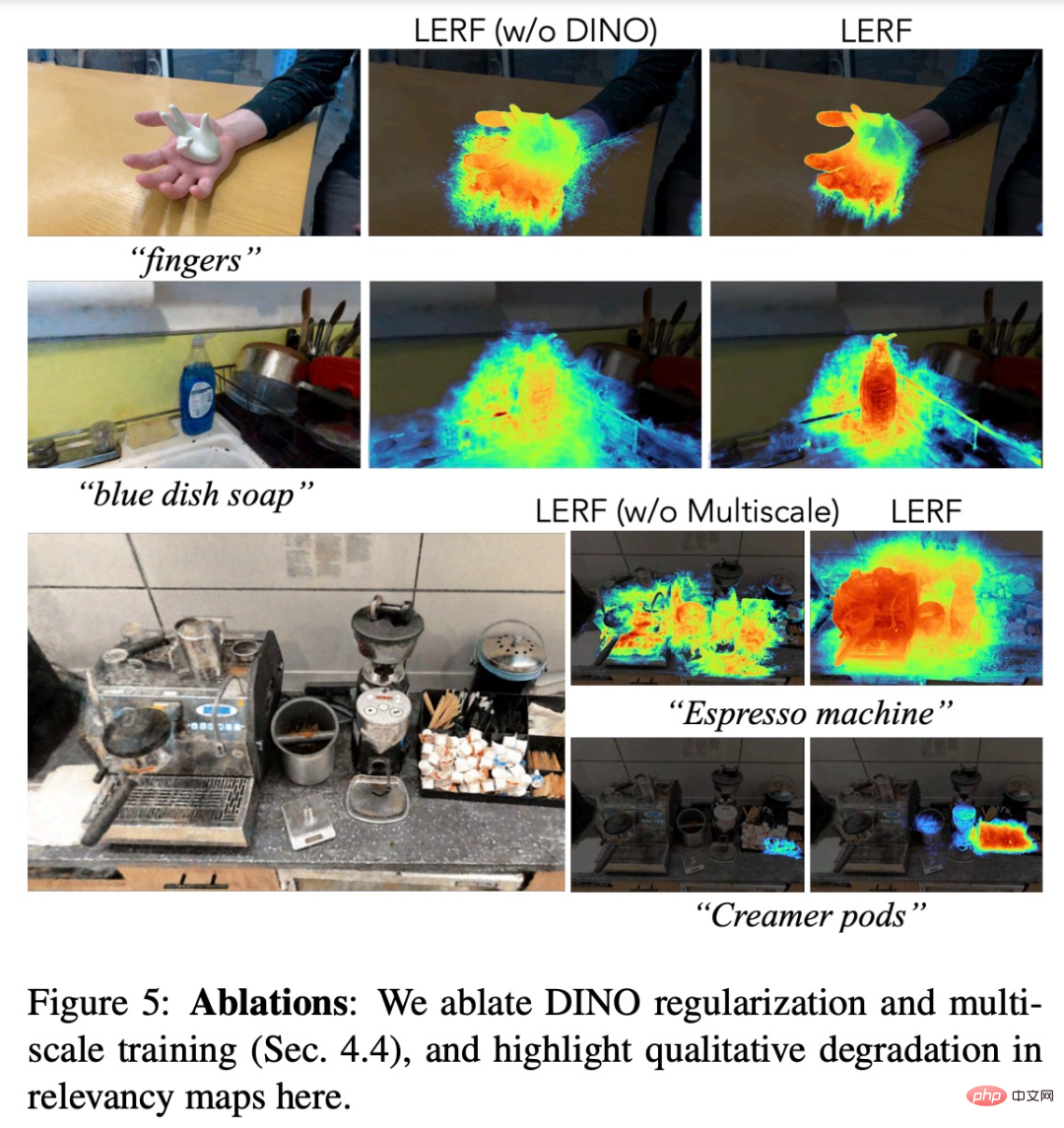

LERF selbst liefert kohärente Ergebnisse, aber die resultierende Korrelationskarte kann manchmal unvollständig sein und einige Ausreißer enthalten, wie in Abbildung 5 unten dargestellt.

Um das optimierte Sprachfeld zu regulieren, führt diese Studie selbstüberwachtes DINO ein, indem Engpässe geteilt werden.

In Bezug auf die Architektur sollte die Optimierung der Spracheinbettung in 3D keinen Einfluss auf die Dichteverteilung in der zugrunde liegenden Szenendarstellung haben. Daher erfasst diese Studie die induktive Verzerrung in LERF, indem sie zwei unabhängige Netzwerke trainiert: eines mit für Eigenvektoren (DINO, CLIP) und eine weitere für die Standard-NeRF-Ausgabe (Farbe, Dichte).

Experimente

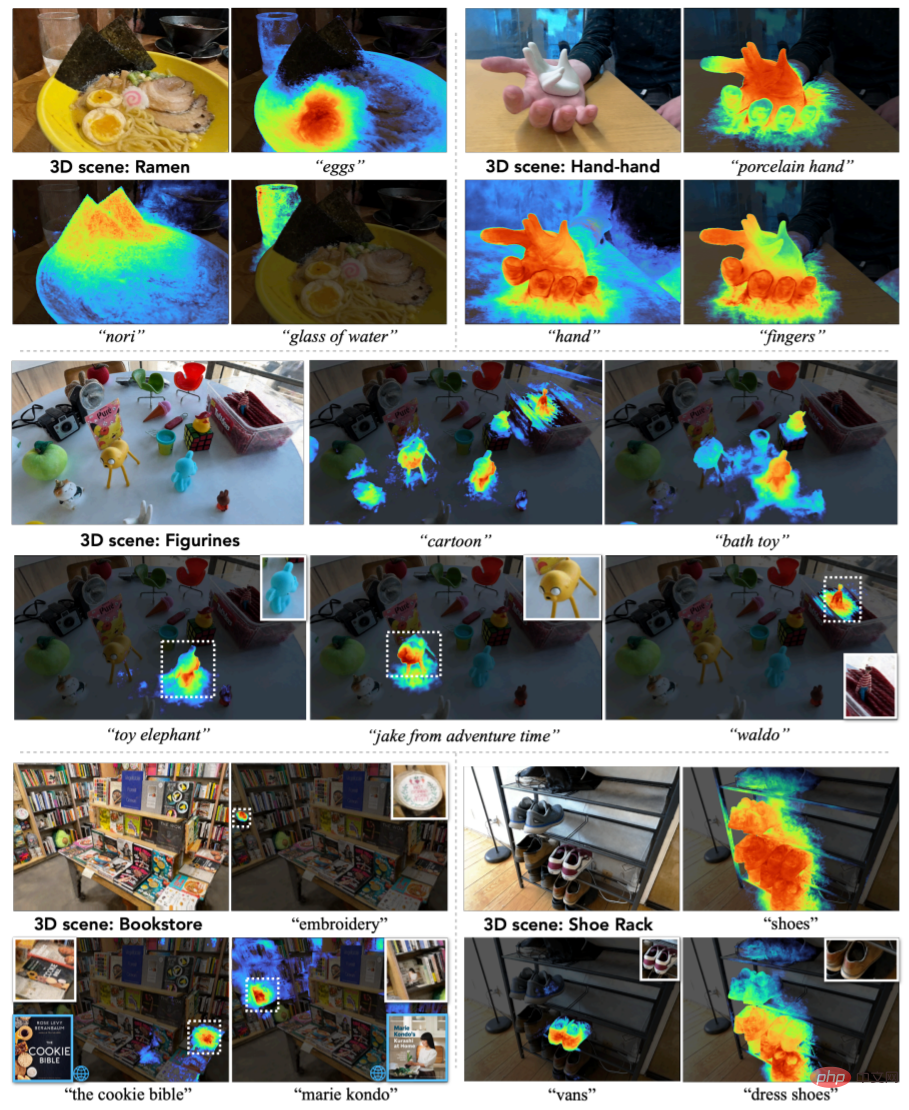

Um die Fähigkeit von LERF zur Verarbeitung realer Daten zu demonstrieren, wurden im Rahmen der Studie 13 Szenen erfasst, darunter Lebensmittelgeschäfte, Küchen, Buchhandlungen, Figuren usw. In Abbildung 3 werden fünf repräsentative Szenarien ausgewählt, um die Fähigkeit von LERF zur Verarbeitung natürlicher Sprache zu demonstrieren.

Figure 3

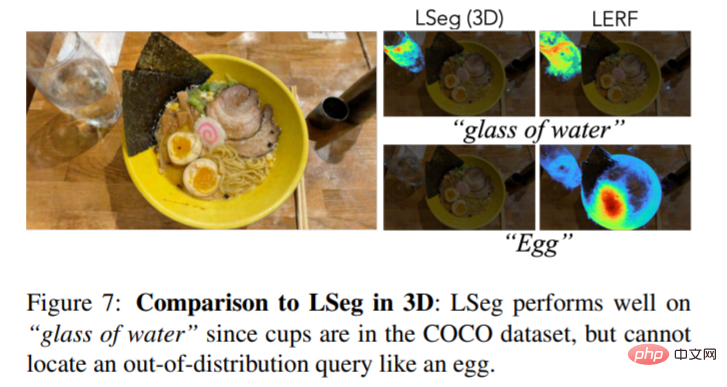

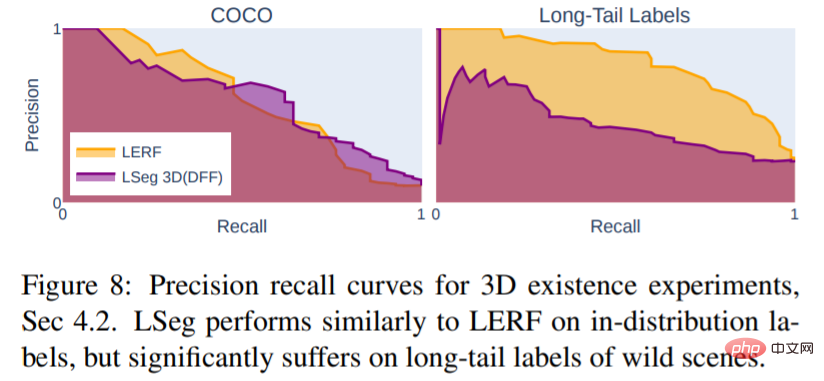

Figure 7 ist ein 3D -visueller Vergleich von LERF und LSEG.

Abbildung 8 zeigt, dass LSeg, das auf einem begrenzten segmentierten Datensatz trainiert wurde, nicht in der Lage ist, natürliche Sprache effektiv darzustellen. Stattdessen funktioniert es nur bei gemeinsamen Objekten innerhalb der Trainingssatzverteilung gut, wie in Abbildung 7 dargestellt.

Die LERF-Methode ist jedoch noch nicht perfekt. Bei der Kalibrierung von Zucchini-Gemüse treten beispielsweise folgende Fehler auf:

Das obige ist der detaillierte Inhalt vonNatürliche Sprache ist in NeRF integriert, und LERF, das mit nur wenigen Worten 3D-Bilder generiert, ist da.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Einführung in fünf Stichprobenmethoden bei Aufgaben zur Generierung natürlicher Sprache und bei der Implementierung von Pytorch-Code

Feb 20, 2024 am 08:50 AM

Einführung in fünf Stichprobenmethoden bei Aufgaben zur Generierung natürlicher Sprache und bei der Implementierung von Pytorch-Code

Feb 20, 2024 am 08:50 AM

Bei Aufgaben zur Generierung natürlicher Sprache ist die Stichprobenmethode eine Technik, um eine Textausgabe aus einem generativen Modell zu erhalten. In diesem Artikel werden fünf gängige Methoden erläutert und mit PyTorch implementiert. 1. GreedyDecoding Bei der Greedy-Decodierung sagt das generative Modell die Wörter der Ausgabesequenz basierend auf der Eingabesequenz Zeit Schritt für Zeit voraus. In jedem Zeitschritt berechnet das Modell die bedingte Wahrscheinlichkeitsverteilung jedes Wortes und wählt dann das Wort mit der höchsten bedingten Wahrscheinlichkeit als Ausgabe des aktuellen Zeitschritts aus. Dieses Wort wird zur Eingabe für den nächsten Zeitschritt und der Generierungsprozess wird fortgesetzt, bis eine Abschlussbedingung erfüllt ist, beispielsweise eine Sequenz mit einer bestimmten Länge oder eine spezielle Endmarkierung. Das Merkmal von GreedyDecoding besteht darin, dass die aktuelle bedingte Wahrscheinlichkeit jedes Mal die beste ist

So führen Sie die grundlegende Generierung natürlicher Sprache mit PHP durch

Jun 22, 2023 am 11:05 AM

So führen Sie die grundlegende Generierung natürlicher Sprache mit PHP durch

Jun 22, 2023 am 11:05 AM

Die Erzeugung natürlicher Sprache ist eine Technologie der künstlichen Intelligenz, die Daten in Text in natürlicher Sprache umwandelt. Im heutigen Big-Data-Zeitalter müssen immer mehr Unternehmen Daten visualisieren oder den Benutzern präsentieren, und die Generierung natürlicher Sprache ist eine sehr effektive Methode. PHP ist eine sehr beliebte serverseitige Skriptsprache, die zur Entwicklung von Webanwendungen verwendet werden kann. In diesem Artikel wird kurz vorgestellt, wie PHP für die grundlegende Generierung natürlicher Sprache verwendet wird. Einführung in die Bibliothek zur Generierung natürlicher Sprache Die mit PHP gelieferte Funktionsbibliothek enthält nicht die für die Generierung natürlicher Sprache erforderlichen Funktionen

Traffic Engineering verdoppelt die Genauigkeit der Codegenerierung: von 19 % auf 44 %

Feb 05, 2024 am 09:15 AM

Traffic Engineering verdoppelt die Genauigkeit der Codegenerierung: von 19 % auf 44 %

Feb 05, 2024 am 09:15 AM

Die Autoren eines neuen Papiers schlagen eine Möglichkeit vor, die Codegenerierung zu „verbessern“. Die Codegenerierung ist eine immer wichtiger werdende Fähigkeit der künstlichen Intelligenz. Es generiert automatisch Computercode basierend auf Beschreibungen in natürlicher Sprache, indem es Modelle für maschinelles Lernen trainiert. Diese Technologie hat breite Anwendungsaussichten und kann Softwarespezifikationen in verwendbaren Code umwandeln, die Back-End-Entwicklung automatisieren und menschliche Programmierer dabei unterstützen, die Arbeitseffizienz zu verbessern. Allerdings bleibt die Generierung von qualitativ hochwertigem Code für KI-Systeme im Vergleich zu Sprachaufgaben wie Übersetzung oder Zusammenfassung eine Herausforderung. Der Code muss genau der Syntax der Zielprogrammiersprache entsprechen, Randfälle und unerwartete Eingaben ordnungsgemäß verarbeiten und die vielen kleinen Details der Problembeschreibung genau behandeln. Selbst kleine Fehler, die in anderen Bereichen harmlos erscheinen, können die Funktionalität eines Programms vollständig beeinträchtigen und verursachen

Erstellen von Textgeneratoren mithilfe von Markov-Ketten

Apr 09, 2023 pm 10:11 PM

Erstellen von Textgeneratoren mithilfe von Markov-Ketten

Apr 09, 2023 pm 10:11 PM

In diesem Artikel stellen wir ein beliebtes maschinelles Lernprojekt namens Textgenerator vor. Sie erfahren, wie Sie einen Textgenerator erstellen und wie Sie eine Markov-Kette implementieren, um ein schnelleres Vorhersagemodell zu erhalten. Einführung in Textgeneratoren Die Textgenerierung ist branchenübergreifend beliebt, insbesondere in den Bereichen Mobilgeräte, Apps und Datenwissenschaft. Sogar die Presse nutzt die Textgenerierung, um den Schreibprozess zu unterstützen. Im täglichen Leben werden wir mit einigen Textgenerierungstechnologien in Kontakt kommen. Textvervollständigung, Suchvorschläge, Smart Compose und Chat-Roboter sind Beispiele für Anwendungen. In diesem Artikel werden Markov-Ketten zum Erstellen eines Textgenerators verwendet. Dies wäre ein zeichenbasiertes Modell, das das vorherige Zeichen der Kette übernimmt und den nächsten Buchstaben in der Sequenz generiert. Indem wir unser Programm anhand von Beispielwörtern trainieren,

Der in GPT-4 integrierte Cursor macht das Schreiben von Code so einfach wie das Chatten. Eine neue Ära des Codierens in natürlicher Sprache ist angebrochen.

Apr 04, 2023 pm 12:15 PM

Der in GPT-4 integrierte Cursor macht das Schreiben von Code so einfach wie das Chatten. Eine neue Ära des Codierens in natürlicher Sprache ist angebrochen.

Apr 04, 2023 pm 12:15 PM

Github Copilot X, das GPT-4 integriert, befindet sich noch in kleinen internen Tests, während Cursor, das GPT-4 integriert, öffentlich veröffentlicht wurde. Cursor ist eine IDE, die GPT-4 integriert und Code in natürlicher Sprache schreiben kann, sodass das Schreiben von Code so einfach ist wie das Chatten. Es gibt immer noch einen großen Unterschied zwischen GPT-4 und GPT-3.5 in ihrer Fähigkeit, Code zu verarbeiten und zu schreiben. Ein Testbericht von der offiziellen Website. Die ersten beiden sind GPT-4, einer verwendet Texteingabe und der andere ist GPT3.5. Es ist ersichtlich, dass die Codierungsfunktionen von GPT-4 im Vergleich zu GPT-3.5 erheblich verbessert wurden. Github Copilot X mit GPT-4-Integration befindet sich noch in kleinen Tests

Mit umfassender Abdeckung von Werten und Datenschutz plant die Cyberspace Administration of China, „Regeln' für generative KI aufzustellen

Apr 13, 2023 pm 03:34 PM

Mit umfassender Abdeckung von Werten und Datenschutz plant die Cyberspace Administration of China, „Regeln' für generative KI aufzustellen

Apr 13, 2023 pm 03:34 PM

Am 11. April entwarf und veröffentlichte die Cyberspace Administration of China (im Folgenden „Cyberspace Administration of China“) die „Maßnahmen für das Management generativer künstlicher Intelligenzdienste (Entwurf für Kommentare)“ und startete eine einmonatige Einholung von Meinungen die Öffentlichkeit. Diese Managementmaßnahme (Entwurf zur Kommentierung) umfasst insgesamt 21 Artikel. Vom Anwendungsbereich umfasst sie sowohl Unternehmen, die generative künstliche Intelligenzdienste anbieten, als auch Organisationen und Einzelpersonen, die diese Dienste nutzen Inhalte der generativen künstlichen Intelligenz, Schulungsgrundsätze für Dienstleister, Schutz der Privatsphäre/geistigen Eigentumsrechte und anderer Rechte usw. Das Aufkommen groß angelegter generativer natürlichsprachlicher Modelle und Produkte wie GPT ermöglichte der Öffentlichkeit nicht nur, den rasanten Fortschritt der künstlichen Intelligenz zu erleben, sondern legte auch Sicherheitsrisiken offen, einschließlich der Generierung voreingenommener und diskriminierender Informationen.

Ist es notwendig, „Partizip' zu bilden? Andrej Karpathy: Es ist Zeit, diesen historischen Ballast wegzuwerfen

May 20, 2023 pm 12:52 PM

Ist es notwendig, „Partizip' zu bilden? Andrej Karpathy: Es ist Zeit, diesen historischen Ballast wegzuwerfen

May 20, 2023 pm 12:52 PM

Durch das Aufkommen von Konversations-KI wie ChatGPT haben sich die Menschen an solche Dinge gewöhnt: Geben Sie einen Text, einen Code oder ein Bild ein, und der Konversationsroboter gibt Ihnen die gewünschte Antwort. Doch hinter dieser einfachen Interaktionsmethode muss das KI-Modell sehr komplexe Datenverarbeitungen und Berechnungen durchführen, und die Tokenisierung ist weit verbreitet. Im Bereich der Verarbeitung natürlicher Sprache bezieht sich die Tokenisierung auf die Aufteilung der Texteingabe in kleinere Einheiten, sogenannte „Tokens“. Diese Token können Wörter, Teilwörter oder Zeichen sein, abhängig von der spezifischen Wortsegmentierungsstrategie und den Aufgabenanforderungen. Wenn wir beispielsweise eine Tokenisierung für den Satz „Ich esse gerne Äpfel“ durchführen, erhalten wir eine Folge von Token: [&qu

Viele Länder planen, ChatGPT zu verbieten. Kommt der Käfig für das „Biest'?

Apr 10, 2023 pm 02:40 PM

Viele Länder planen, ChatGPT zu verbieten. Kommt der Käfig für das „Biest'?

Apr 10, 2023 pm 02:40 PM

„Künstliche Intelligenz will aus dem Gefängnis entkommen“, „KI erzeugt Selbstbewusstsein“, „KI wird irgendwann Menschen töten“, „Evolution des Lebens auf Siliziumbasis“ … tauchte einst nur in technologischen Fantasien wie Cyberpunk auf. Die Handlung kommt In diesem Jahr trifft dies zu, und generative Modelle natürlicher Sprache werden wie nie zuvor in Frage gestellt. Am meisten Aufsehen erregte ChatGPT. Von Ende März bis Anfang April wandelte sich dieser von OpenAI entwickelte Text-Konversationsroboter plötzlich von einem Vertreter „fortschrittlicher Produktivität“ zu einer Bedrohung für die Menschheit. Zuerst wurde es von Tausenden von Eliten in der Technologiewelt benannt und in einen offenen Brief aufgenommen, um „das Training von KI-Systemen, die leistungsfähiger sind als GPT-4, auszusetzen“, dann forderte die amerikanische Technologieethikorganisation die US-amerikanische Federal Trade Commission auf, dies zu untersuchen OpenAI und verbieten die Veröffentlichung einer kommerziellen Version