Die Beliebtheit von ChatGPT ist für alle offensichtlich, und für die Technologie hinter seinem Erfolg sind die Feinabstimmung des überwachten Unterrichts und das verstärkende Lernen auf der Grundlage menschlichen Feedbacks von entscheidender Bedeutung. Diese Techniken werden nach und nach auch auf andere KI-Bereiche ausgeweitet, einschließlich Computer Vision (CV).

Wir wissen, dass beim Umgang mit komplexen Ausgaben in der Computer Vision das Hauptkriterium für den Erfolg nicht darin besteht, wie gut das Modell für die Trainingsziele optimiert ist, sondern wie gut die Vorhersagefähigkeiten zur Aufgabe passen, d. h. wie gut Das Modell erfüllt seinen vorgesehenen Zweck.

Um diese Konsistenz zu erreichen, haben einige Forscher einige Verbesserungen in der Modellarchitektur, den Daten, der Optimierung, der Probenahme, der Nachbearbeitung usw. vorgenommen. Bei der Objekterkennungsaufgabe verwendeten die Forscher beispielsweise NMS (nicht maximale Unterdrückung), satzbasierten globalen Verlust und die Änderung der Eingabedaten, um Modelle mit verbessertem Verhalten zum Testzeitpunkt zu erhalten. Obwohl diese Methoden erhebliche Vorteile bringen, sind sie oft nur für bestimmte Aufgaben nützlich und optimieren Missionsrisiken nur indirekt.

Nicht nur der Lebenslauf, sondern auch die Verarbeitung natürlicher Sprache (NLP), das Reinforcement Learning (RL) und andere Bereiche untersuchen dieses Phänomen umfassend. In diesen Bereichen ist es sehr schwierig, Optimierungsziele für weniger genau definierte Aufgaben wie die Übersetzung oder die Generierung von Zusammenfassungen zu formulieren. Bei der Lösung dieser Art von Problem Ein beliebter Ansatz besteht darin, zu lernen, die Ausgabe des Beispiels nachzuahmen und dann Verstärkungslernen durchzuführen, um das Modell an der Belohnungsfunktion auszurichten. Der Bereich NLP hat mit diesem Ansatz, der große vorab trainierte Sprachmodelle und durch menschliches Feedback definierte Belohnungen nutzt, um ansonsten schwer zu spezifizierende Aufgaben zu bewältigen, spannende Ergebnisse hervorgebracht.

Darüber hinaus wird die gleiche Methode häufig bei Bildunterschriftenaufgaben verwendet, bei denen CIDEr (vorgeschlagen von Vedantam et al. 2015) als Belohnung verwendet wird. Dennoch wurde die Belohnungsoptimierung nach unserem besten Wissen bisher noch nicht bei (nicht-textuellen) Computer-Vision-Aufgaben untersucht.

Kürzlich haben Forscher des Google Brain-Teams in der Arbeit „Tuning computer vision models with task rewards“ bewiesen, dass den REINFORCE-Algorithmus (1992 von Williams vorgeschlagen) verwendet wird, um ein vorab trainiertes Modell abzustimmen (zu optimieren). eine Belohnungsfunktion Kann sofort für eine Vielzahl von Computer-Vision-Aufgaben verwendet werden .

Tatsächlich wird in vielen Studien zu verstärkenden Lernaufgaben der REINFORCE-Algorithmus von Williams erwähnt, was die Bedeutung dieses Algorithmus zeigt. Man kann sagen, dass der REINFORCE-Algorithmus ein typischer Vertreter des Policy-Gradienten und sogar des Reinforcement-Lernens ist.

Papieradresse: https://arxiv.org/pdf/2302.08242v1.pdf

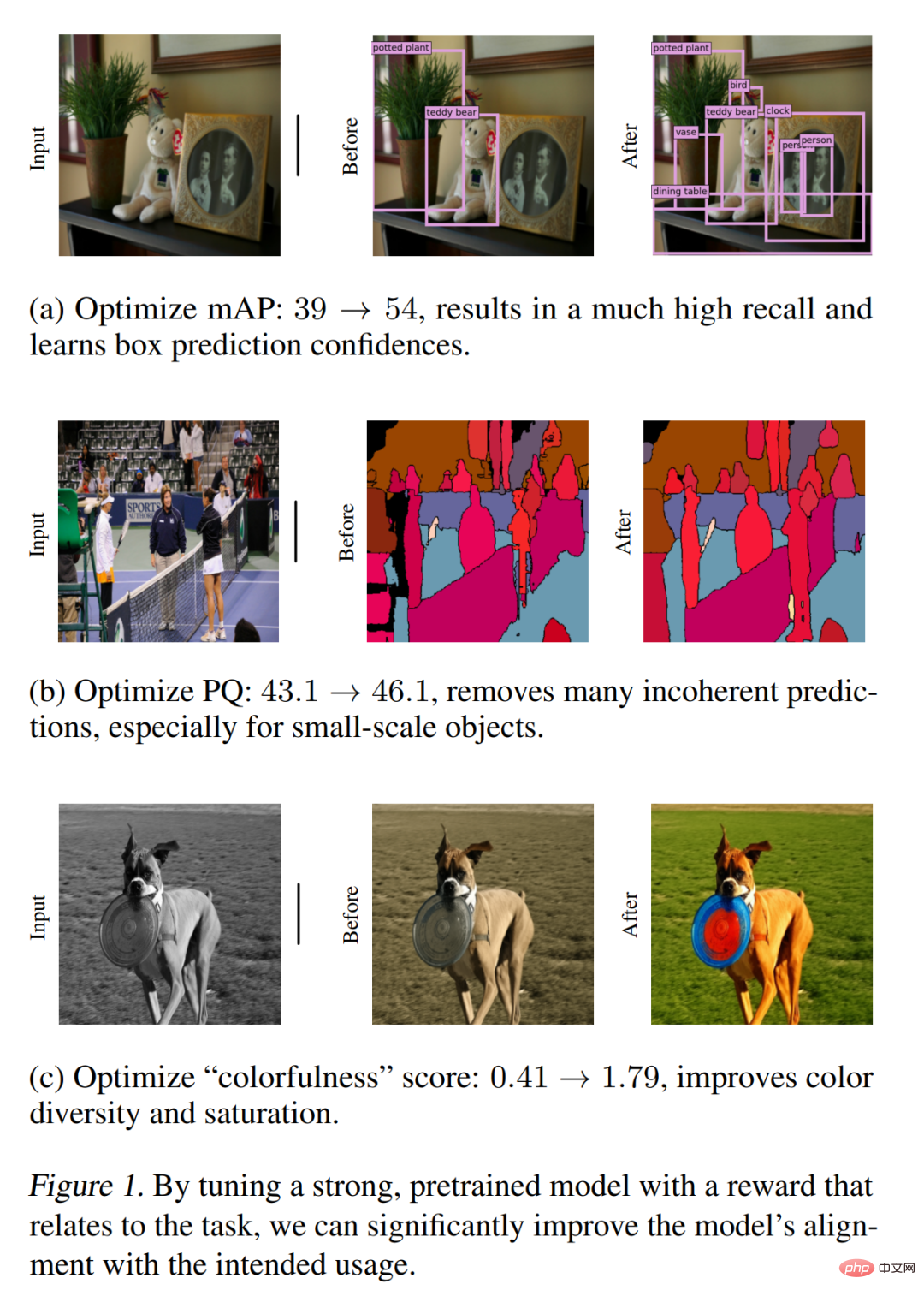

Abbildung 1 zeigt einige wichtige Ergebnisse, hauptsächlich einschließlich Belohnungsoptimierungsbändern für die Zielerkennung, Panoramasegmentierung und quantitative Bildfärbung und qualitative Verbesserungen. Die in dieser Studie vorgeschlagene Methode ist einfach und effektiv bei der Bewältigung verschiedener Lebenslaufaufgaben und zeigt ihre Vielseitigkeit und Anpassungsfähigkeit. Obwohl in diesem Artikel hauptsächlich Belohnungen in Form von Bewertungsmetriken verwendet werden, zeigen diese vorläufigen Ergebnisse, dass diese Methode auch eine effektive Möglichkeit sein kann, Computer-Vision-Modelle zu optimieren, die komplexere und schwieriger zu spezifizierende Belohnungen haben, wie z. B. menschliches Feedback oder die Gesamtleistung .

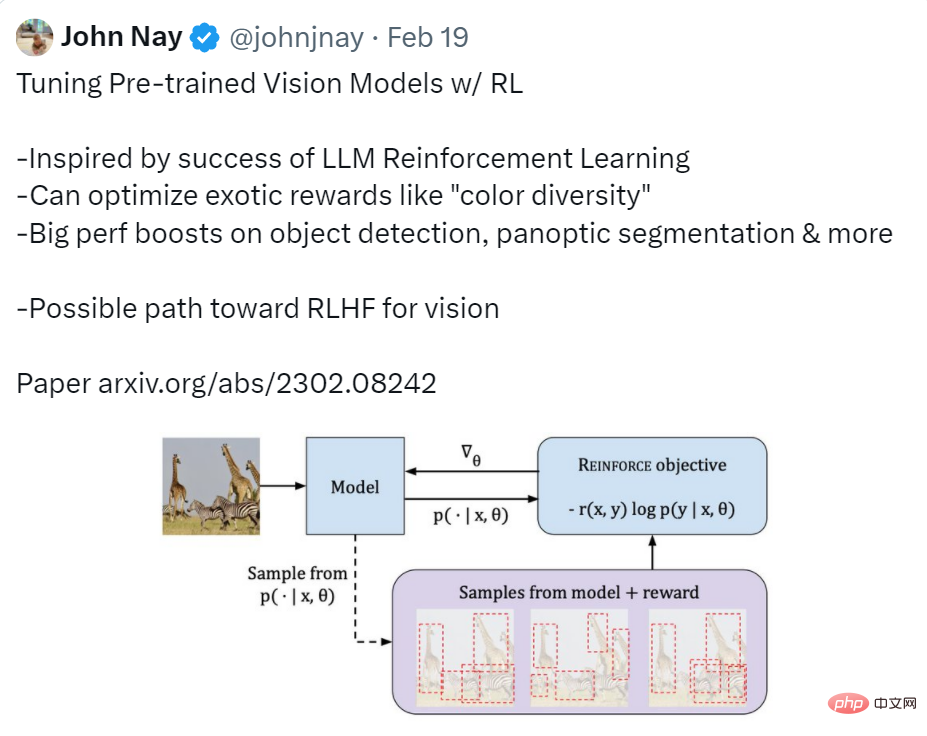

Twitter-Benutzer haben diesen Artikel relativ ausführlich zusammengefasst. Das heißt, die in diesem Artikel implementierte Funktion besteht darin, RL zum Anpassen des vorab trainierten visuellen Modells zu verwenden. Die Motivation für die Forschung wurde durch den Erfolg des LLM-Verstärkungslernens inspiriert; der Effekt war eine deutliche Verbesserung der Leistung bei der Zielerkennung, der Panoramasegmentierung usw. Er erklärte auch, dass diese Forschung ein wirksamer Weg sein könnte, um visuelles RLHF (Reinforcement Learning from Human Feedback) zu erreichen.

Quelle: https://twitter.com/johnjnay/status/1627009121378598912

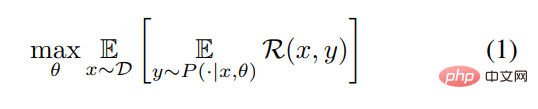

Ohne die Verallgemeinerung zu verlieren, beschreibt die Studie die CV-Aufgabe als den Prozess des Lernens einer Funktion, die als Eingabe Map zur Ausgabe y = [y_1, y_1,. .., y_n] (Text-Token-Sequenz, Bounding-Box-Sequenz usw.). Diese Forschung zielt darauf ab, eine bedingte Verteilung P (y|x, θ) mit θ als Parameter zu lernen, um die Belohnungsfunktion R zu maximieren. Um es mit einer abstrakten Formel zu beschreiben, werden in diesem Artikel die folgenden Optimierungsprobleme gelöst.

Da das Problem nun gelöst ist, ist der nächste Schritt die Lösung Dieser Artikel ist in zwei Teile gegliedert. Schritt: Verwenden Sie zunächst die Maximum-Likelihood-Schätzung, um das Modell vorab zu trainieren. Werfen wir einen Blick auf den spezifischen Prozess dieser beiden Schritte:

Maximum-Likelihood-Vortraining#🎜🎜 ## 🎜🎜#

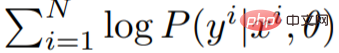

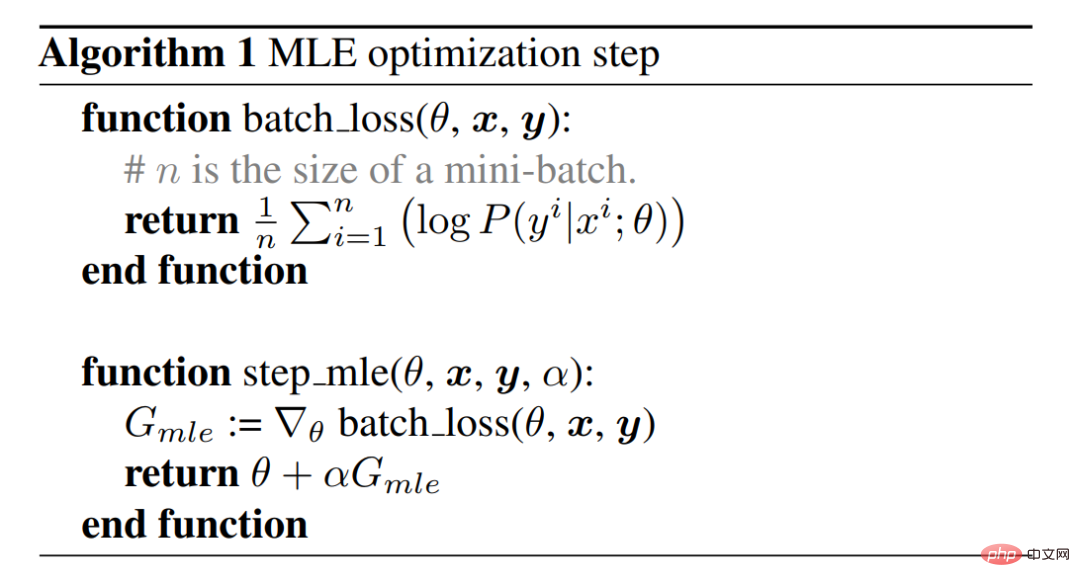

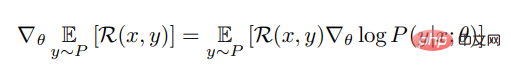

Schätzen Sie zunächst den Parameter θ mithilfe des Maximum-Likelihood-Prinzips und erfassen Sie die Verteilung der Trainingsdaten. Dies wird mithilfe des Gradientenabstiegsalgorithmus erreicht, der die Log-Likelihood der Trainingsdaten maximiert. Algorithmus 1 und Abbildung 2 beschreiben den MLE-Optimierungsschritt (Maximum Likelihood Estimation), die gebräuchlichste Methode zum Trainieren von Modellen. Wenn Sie diesen Schritt abschließen, erhalten Sie ein MLE-Modell. Der REINFORC-Algorithmus maximiert die Belohnungen . Für eine gegebene Eingabe x verwendet diese Studie den REINFORCE-Algorithmus, um den Gradienten der erwarteten Belohnung für ein gegebenes x abzuschätzen. Die Formel lautet wie folgt: #

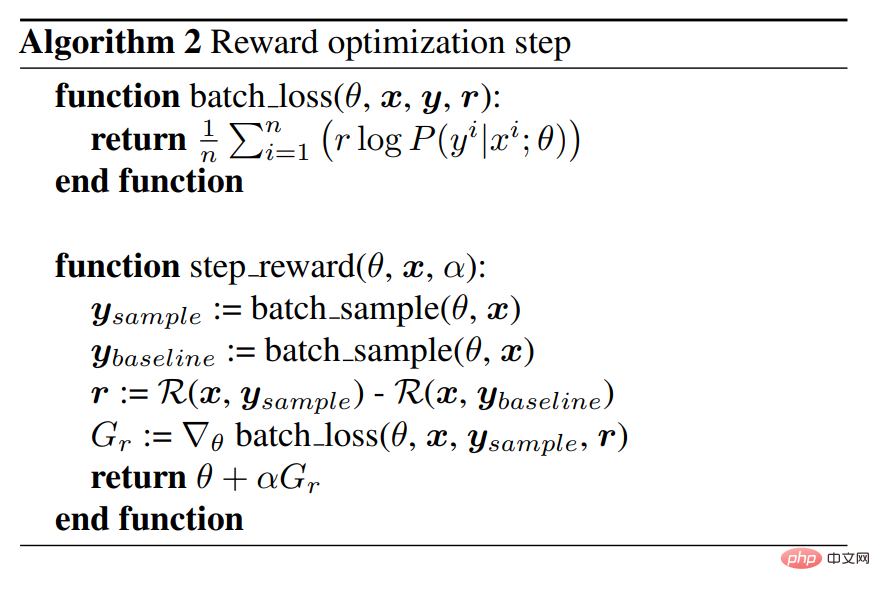

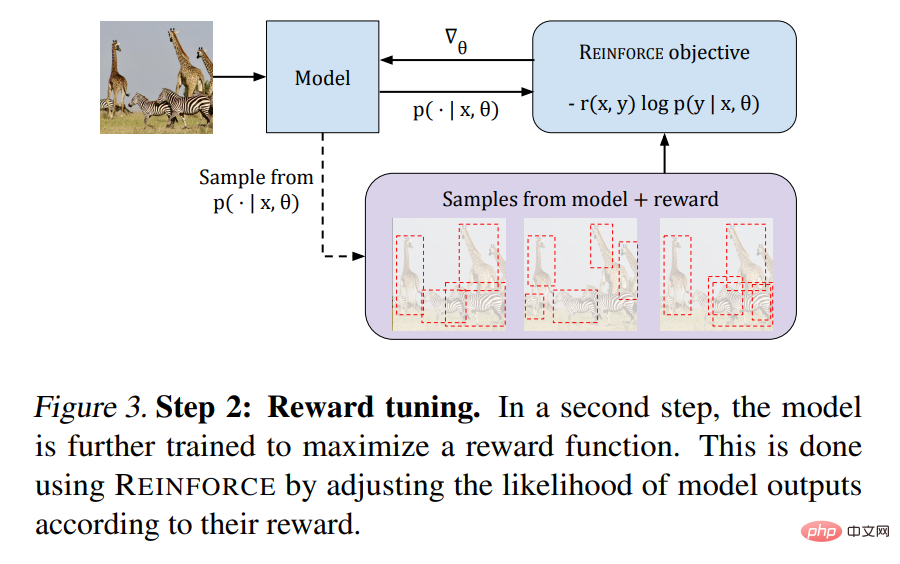

Algorithmus 2 stellt Pseudocode bereit und Abbildung 3 veranschaulicht den Prozess: #🎜🎜 #

#🎜🎜 #

#🎜🎜 #

# 🎜🎜#

Als nächstes werfen wir einen Blick auf die Leistung der in diesem Artikel vorgeschlagenen Methode zu visuellen Aufgaben.

Panoramasegmentierung

Wie in Tabelle 1 unten gezeigt, ist die Tuning-Prozess Deutlich verbesserte MLE-Modelle. Die Ergebnisse nach der visuellen Prüfung zeigen, dass das Modell nach dem Tuning besser in der Lage ist, inkohärente Vorhersagen zu vermeiden, insbesondere für kleinräumige Objekte, siehe Abbildung 1.

Wie in Tabelle 1 unten gezeigt, ist die Tuning-Prozess Deutlich verbesserte MLE-Modelle. Die Ergebnisse nach der visuellen Prüfung zeigen, dass das Modell nach dem Tuning besser in der Lage ist, inkohärente Vorhersagen zu vermeiden, insbesondere für kleinräumige Objekte, siehe Abbildung 1.

#🎜🎜. #

Ziel Erkennung

Tabelle 2 zeigt, dass diese Studie durch Optimierung den mAP-Score des ursprünglichen MLE-Modells deutlich von 39,2 % auf 54,3 % verbesserte. In Pix2seq erreichte das gleich große ViT-B-Modell mit einer etwas größeren Auflösung von 1333 x 1333 und vielen Heuristiken 47,1 %. Bei Verwendung des größeren ViT-L-Backbones meldete Pix2seq das beste Zielerkennungsergebnis von 50,0 %.

Tabelle 2 zeigt, dass diese Studie durch Optimierung den mAP-Score des ursprünglichen MLE-Modells deutlich von 39,2 % auf 54,3 % verbesserte. In Pix2seq erreichte das gleich große ViT-B-Modell mit einer etwas größeren Auflösung von 1333 x 1333 und vielen Heuristiken 47,1 %. Bei Verwendung des größeren ViT-L-Backbones meldete Pix2seq das beste Zielerkennungsergebnis von 50,0 %.

色#🎜🎜 # Die in Abbildung 4 dargestellten qualitativen Ergebnisse zeigen deutlich, dass das neue Modell durchweg farbenfrohere Bilder erzeugt.

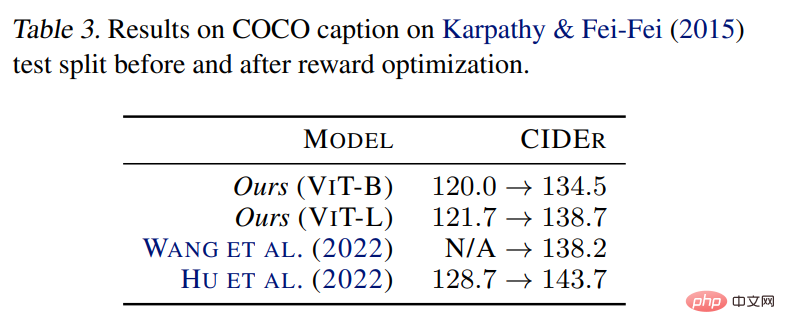

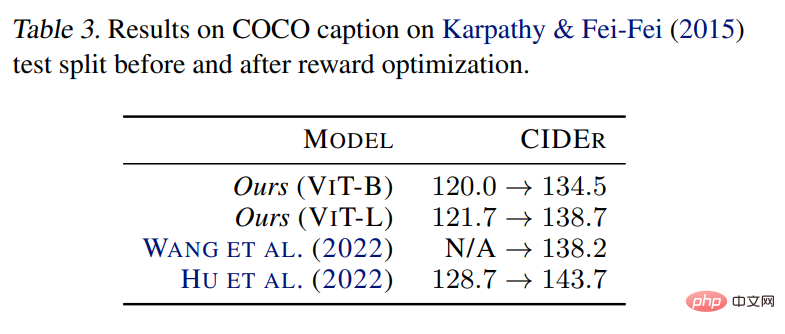

Bildbeschreibung

Tabelle 3 Die Ergebnisse zeigen, dass die Anwendung der vorgeschlagenen Methode das MLE-Modell verbessern kann, was mit früheren Beobachtungen in der Literatur übereinstimmt. Dies demonstriert die Wirksamkeit dieser Methode bei der Abstimmung spezifischer Missionsrisiken.

Das obige ist der detaillierte Inhalt vonGoogle verwendet klassische Algorithmen von vor 30 Jahren und CV führt Reinforcement Learning ein: Kommt visuelles RLHF?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Welche Fähigkeiten sind erforderlich, um in der PHP-Branche zu arbeiten?

Welche Fähigkeiten sind erforderlich, um in der PHP-Branche zu arbeiten?

Welches hat eine schnellere Lesegeschwindigkeit, Mongodb oder Redis?

Welches hat eine schnellere Lesegeschwindigkeit, Mongodb oder Redis?

Standby-Tastenkombination

Standby-Tastenkombination

Was bedeutet OEM?

Was bedeutet OEM?

Java konfiguriert JDK-Umgebungsvariablen

Java konfiguriert JDK-Umgebungsvariablen

So rufen Sie das BIOS auf einem HP-Computer auf

So rufen Sie das BIOS auf einem HP-Computer auf

Was tun, wenn Ajax verstümmelte chinesische Zeichen überträgt?

Was tun, wenn Ajax verstümmelte chinesische Zeichen überträgt?

Abfragetool für Registrierungsdomänennamen

Abfragetool für Registrierungsdomänennamen

amd240

amd240