Aufsatz 1: Ein Modell, um sie alle zu bearbeiten: Textgesteuerte Bildmanipulation in freier Form mit semantischen Modulationen

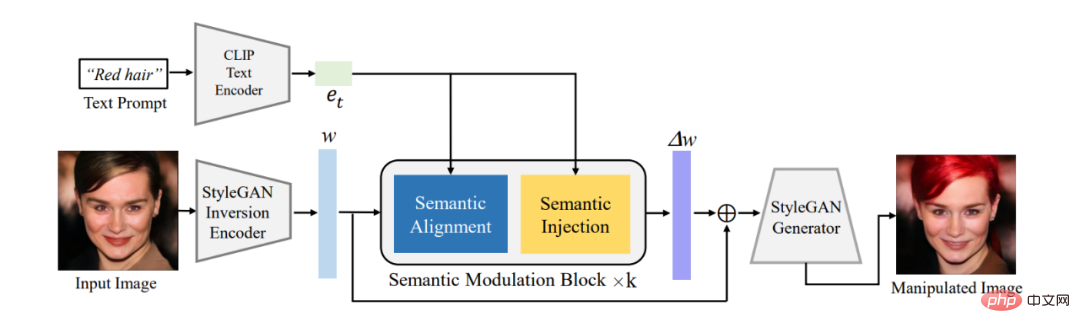

Zusammenfassung: Dieser Artikel verwendet zunächst den vorhandenen Encoder, um das zu bearbeitende Bild in die latente Codierung w in der W^+-Semantik umzuwandeln Raum von StyleGAN, und dann wird die latente Codierung durch das vorgeschlagene semantische Modulationsmodul adaptiv moduliert. Das semantische Modulationsmodul umfasst semantische Ausrichtungs- und semantische Injektionsmodule. Es richtet zunächst die Semantik zwischen der Textkodierung und der latenten Kodierung von GAN über den Aufmerksamkeitsmechanismus aus und fügt dann die Textinformationen in die ausgerichtete latente Kodierung ein, wodurch sichergestellt wird, dass die Cain-Kodierung erfolgt besitzt die Textinformationen und erhält dadurch die Möglichkeit, Bilder mithilfe von Text zu bearbeiten.

Im Gegensatz zum klassischen StyleCLIP-Modell muss unser Modell nicht für jeden Text ein separates Modell trainieren, um Bilder effektiv zu bearbeiten, sodass unser Modell zur FFCLIP-freien Text-gesteuerten Bildmanipulation wird . Gleichzeitig hat unser Modell bei den klassischen Kirchen-, Gesichts- und Autodatensätzen sehr gute Ergebnisse erzielt.

Abbildung 1: Gesamtrahmendiagramm

Empfohlen: Neues Paradigma der Text- und Bildbearbeitung, ein einziges Modell realisiert die durch mehrere Texte geführte Bildbearbeitung.

Papier 2: Gedruckte organische Photovoltaikmodule auf übertragbaren ultradünnen Substraten als additive Stromquellen

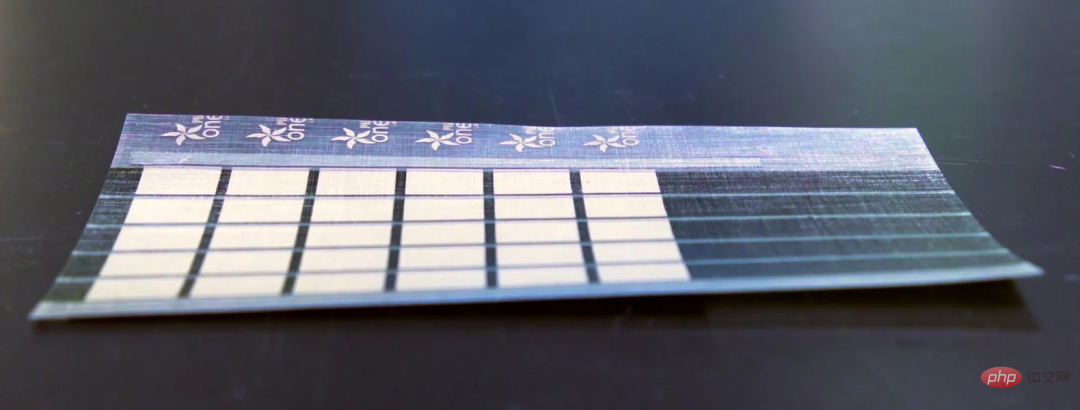

Zusammenfassung: Forscher am MIT haben eine skalierbare Fertigungstechnologie entwickelt, mit der ultradünne, leichte Solarzellen und Batterien hergestellt werden können, die verlegt werden können auf jeder Oberfläche.

MIT-Forscher haben Solarmodule entwickelt, die dünner als ein menschliches Haar sind und 18-mal mehr Energie pro Kilogramm liefern als aktuelle Solarmodule auf Glas- und Siliziumbasis. Diese Solarmodule wiegen nur ein Prozent herkömmlicher Photovoltaikzellen.

Dieses ultradünne Solarpanel kann auch auf Segeln, Drohnenflügeln und Zelten installiert werden. Sie sind besonders nützlich in abgelegenen Gebieten und bei Katastrophenhilfeeinsätzen.

Empfohlen: MIT stellt hauchdünne Solarmodule her.

Papier 3: Ein Überblick über Deep Learning für mathematisches Denken

Zusammenfassung:In einem kürzlich veröffentlichten Bericht überprüften Forscher der UCLA und anderer Institutionen systematisch die Fortschritte des Deep Learning im mathematischen Denken.

Insbesondere werden in diesem Artikel verschiedene Aufgaben und Datensätze (Abschnitt 2) erörtert und neuronale Netze (Abschnitt 3) und vorab trainierte Sprachmodelle (Abschnitt 4) im Bereich des mathematischen Fortschritts untersucht. Die schnelle Entwicklung des kontextuellen Lernens großer Sprachmodelle im mathematischen Denken wird ebenfalls untersucht (Abschnitt 5). Der Artikel analysiert bestehende Benchmarks weiter und stellt fest, dass multimodalen und ressourcenarmen Umgebungen weniger Aufmerksamkeit geschenkt wird (Abschnitt 6.1). Evidenzbasierte Forschung zeigt, dass die aktuellen Darstellungen der Rechenkapazitäten unzureichend sind und Deep-Learning-Methoden in Bezug auf mathematisches Denken inkonsistent sind (Abschnitt 6.2). Anschließend schlagen die Autoren Verbesserungen der aktuellen Arbeit in Bezug auf Verallgemeinerung und Robustheit, vertrauenswürdiges Denken, Lernen aus Feedback und multimodales mathematisches Denken vor (Abschnitt 7).

Empfohlen: Wie tiefes Lernen langsam die Tür zum mathematischen Denken öffnet.

Paper 4: Muse: Text-To-Image Generation via Masked Generative Transformers

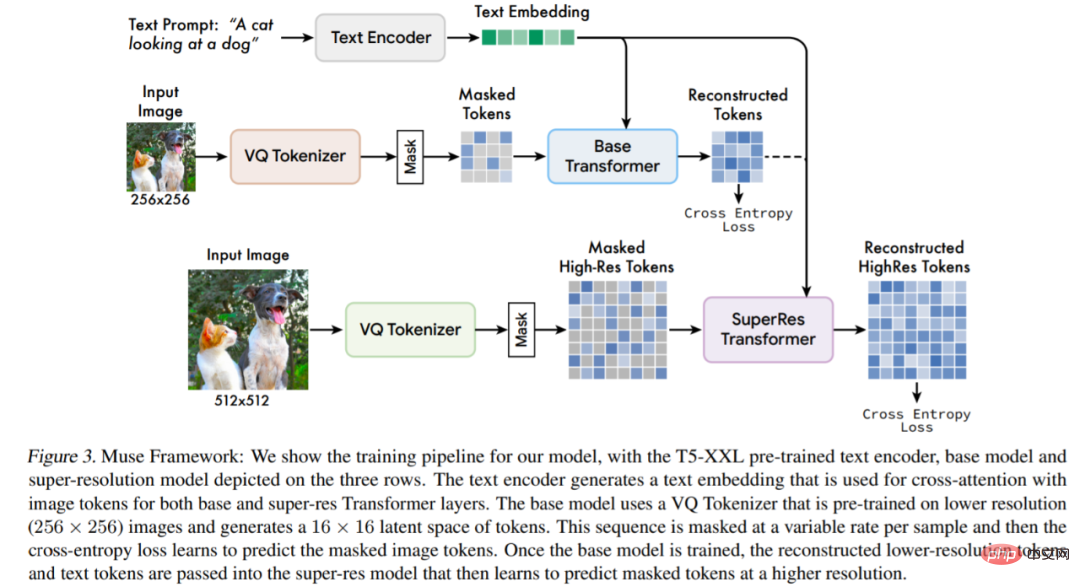

#🎜🎜 #Zusammenfassung: Die Studie schlägt ein neues Modell für die Text-zu-Bild-Synthese unter Verwendung eines maskierten Bildmodellierungsansatzes vor, bei dem die Bilddecoderarchitektur auf Einbettungen von vorab trainierten und eingefrorenen T5-XXL-LLM-Encodern (Large Language Model) basiert.

Mit Imagen (Saharia et al., 2022) oder Dall-E2 (Ramesh et al., 2022) wird die Effizienz von Muse durch den Einsatz diskreter Systeme deutlich verbessert Token. Im Vergleich zum autoregressiven SOTA-Modell Parti (Yu et al., 2022) ist Muse aufgrund der Verwendung paralleler Dekodierung effizienter.

Basierend auf experimentellen Ergebnissen mit TPU-v4 schätzen Forscher, dass Muse in der Inferenzgeschwindigkeit mehr als zehnmal schneller ist als Imagen-3B- oder Parti-3B-Modelle, und zwar schneller als Stable Diffusion v1.4 (Rombach et al., 2022) ist 2x schneller. Forscher glauben, dass Muse schneller ist als Stable Diffusion, da das Diffusionsmodell in Stable Diffusion v1.4 verwendet wird, was offensichtlich mehr Iterationen während der Inferenz erfordert.

Übersicht über die Modellarchitektur.

Empfohlen: Die Inferenzgeschwindigkeit ist 2-mal schneller als bei Stable Diffusion, und die Erzeugung und Reparatur von Bildern kann erfolgen gemacht mit einem Google-Modell.

Papier 5: Positiver Anreizlärm #Autor: Li 🎜#Papieradresse: https://ieeexplore.ieee.org/document/10003114#🎜 🎜#

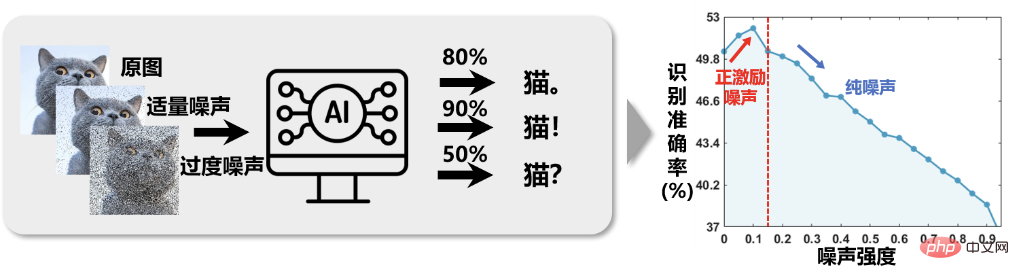

Abbildung 1 Die Bilderkennungsgenauigkeit zeigt eine „kontraintuitive“ Beziehung von „zuerst zunehmend und dann abnehmend“, wenn die Intensität des Bildrauschens zunimmt.

Empfohlen: Professor Li Xuelong von der Western Polytechnic University schlug einen mathematischen Analyserahmen vor, der auf Aufgabenentropie basiert.

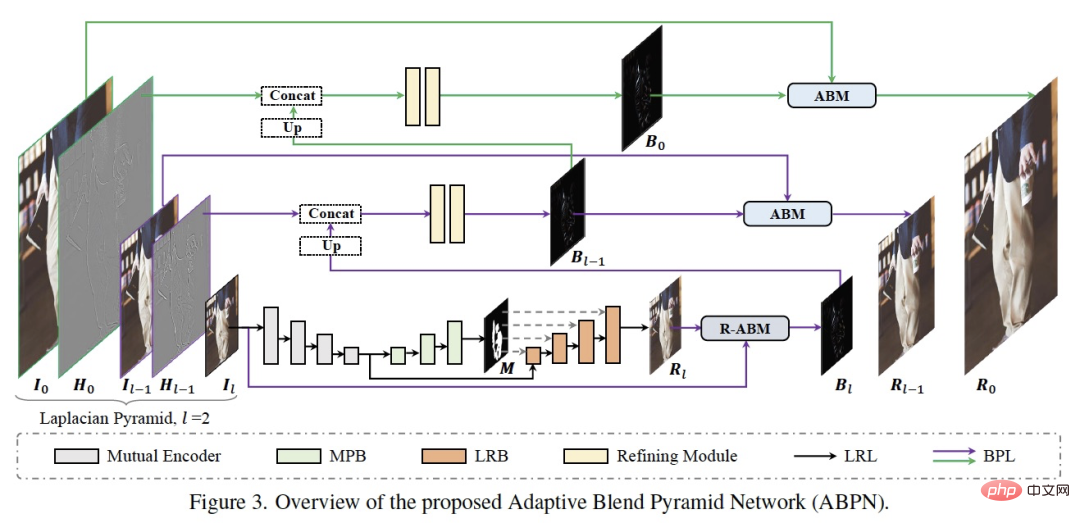

Artikel 6: ABPN: Adaptive Blend Pyramid Network für lokale Echtzeit-Retusche von ultrahochauflösenden Fotos

Zusammenfassung: Forscher der DAMO Academy haben das Ziel Erzielen Sie intelligente Hautpflege auf professionellem Niveau, Forschung und Entwicklung Es wurde eine Reihe ultrafeiner lokaler Retuschealgorithmen (ABPN) für hochauflösende Bilder entwickelt, die gute Ergebnisse und Anwendungen bei der Hautverschönerung und Faltenentfernung in Kleidung in ultrahochauflösenden Bildern erzielt haben.

Wie in der Abbildung oben gezeigt, besteht die Netzwerkstruktur hauptsächlich aus zwei Teilen: der kontextbewussten lokalen Modifikationsschicht (LRL) und der adaptiven Mischpyramidenschicht (BPL). Der Zweck von LRL besteht darin, das heruntergesampelte Bild mit niedriger Auflösung lokal zu modifizieren und ein Ergebnisbild mit niedriger Auflösung zu generieren, wobei die globalen Kontextinformationen und lokalen Texturinformationen vollständig berücksichtigt werden. Darüber hinaus wird BPL verwendet, um die in LRL generierten Ergebnisse mit niedriger Auflösung schrittweise auf Ergebnisse mit hoher Auflösung zu skalieren. Unter anderem haben wir ein adaptives Mischmodul (ABM) und sein Umkehrmodul (R-ABM) entwickelt. Mithilfe der Zwischenmischschicht Bi können wir eine adaptive Konvertierung und Aufwärtserweiterung zwischen dem Originalbild und dem Ergebnisbild realisieren und so eine leistungsstarke Skalierbarkeit aufweisen und Detailtreuefunktionen. Wir haben eine große Anzahl von Experimenten in den beiden Datensätzen Gesichtsmodifikation und Kleidungsmodifikation durchgeführt und die Ergebnisse zeigen, dass unsere Methode den bestehenden Methoden in Bezug auf Wirksamkeit und Effizienz deutlich voraus ist. Es ist erwähnenswert, dass unser Modell die Echtzeit-Inferenz von 4K-Bildern mit ultrahoher Auflösung auf einer einzigen P100-Karte erreicht.

Empfohlen: Entfernen Sie Hautunreinheiten und Falten mit einem Klick.

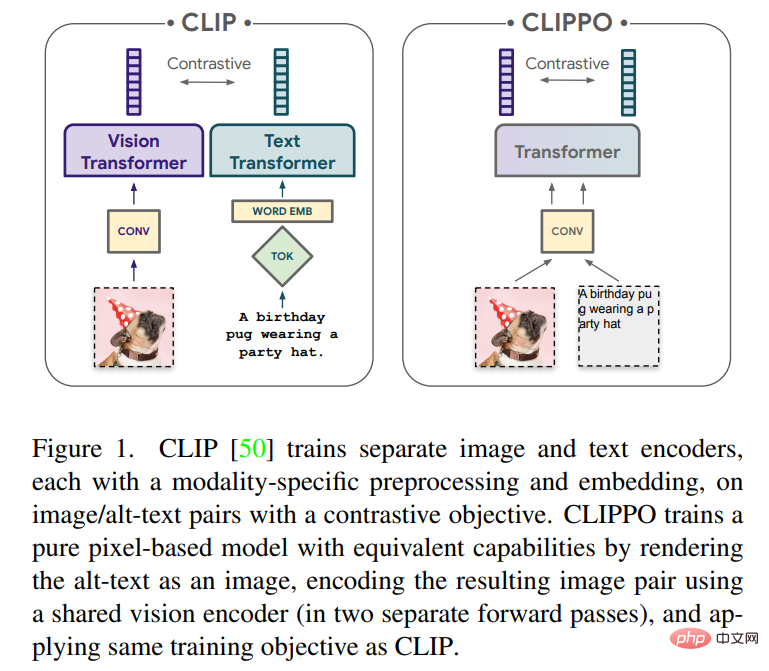

Papier 7: Bild- und Sprachverständnis nur aus Pixeln

Zusammenfassung: Die Entwicklung eines einzigen End-to-End-Modells, das jede Modalität oder Kombination von Modalitäten bewältigen kann, wird ein wichtiger Schritt in Richtung multimodales Lernen sein. In diesem Artikel konzentrieren sich Forscher von Google Research (Google Brain-Team) in Zürich hauptsächlich auf Bilder und Text.

In diesem Artikel wird das multimodale Lernen von Text und Bildern mithilfe rein pixelbasierter Modelle untersucht. Das Modell ist ein separater visueller Transformer, der visuelle Eingaben oder Text oder beides zusammen verarbeitet und alles als RGB-Bilder gerendert. Alle Modalitäten verwenden die gleichen Modellparameter, einschließlich der Low-Level-Feature-Verarbeitung; das heißt, es gibt keine modalitätsspezifischen anfänglichen Faltungen, Tokenisierungsalgorithmen oder Eingabeeinbettungstabellen. Das Modell wird mit nur einer Aufgabe trainiert: kontrastivem Lernen, wie es von CLIP und ALIGN populär gemacht wird. Daher heißt das Modell CLIP-Pixels Only (CLIPPO).

Empfohlen: Parameter werden halbiert und so gut wie CLIP die Bild- und Textvereinheitlichung ausgehend von Pixeln realisiert.

Heart of Machine kooperiert mit der von Chu Hang und Luo Ruotian initiierten ArXiv Weekly Radiostation und wählt diese Woche weitere wichtige Artikel auf der Grundlage von 7 Artikeln aus, darunter jeweils 10 ausgewählte Artikel in den Bereichen NLP, CV und ML , und stellen Sie eine Audiozusammenfassung des Papiers bereit. Die Details lauten wie folgt:

10 NLP-PapiereAudio:00:0020:02

Die 10 ausgewählten NLP-Artikel dieser Woche sind:

1. Rethinking with Retrieval: Faithful Large Language Model Inference.

2. Politische Polarisierung mithilfe von Sprachmodellen verstehen: Ein Datensatz und eine Methode. (Von Bhiksha Raj) Rhetorik mit epistemischer Haltungserkennung.

in Implicit Hate Speech Detection. (von Jessica Lin)

7 Interviewgenerator. (von Tao Zhang)

9. Memory Augmented Lookup Dictionary-basierte Sprachmodellierung (von Yuxuan Wang)10. Parametereffiziente Feinabstimmung von Designräumen )

10 Lebenslaufunterlagen

Audio:

00:0021:06

Die 10 ausgewählten Lebenslaufpapiere dieser Woche sind: ?? Malik) Vipin Kumar)3. Ein skalenbewusster maskierter Autoencoder für das Lernen der räumlichen Darstellung in mehreren Maßstäben. (von Trevor Darrell)4 . (von Rama Chellappa)5. Text-zu-Bild-Generierung über maskierte generative Transformatoren Durch neuronalen Kollaps. (von Xiangyu Zhang, Jiaya Jia)

7. Cross Modal Transformer über Koordinatenkodierung für die 3D-Objekterkennung. (von Xiangyu Zhang)

8 . (von Alan Yuille)9. Lernen durch Sortieren: Selbstüberwachtes Lernen mit Gruppenordnungsbeschränkungen

10. AttEntropy: Segmentierung unbekannter Objekte in komplexen Szenen mithilfe der räumlichen Aufmerksamkeitsentropie semantischer Segmentierungstransformatoren. (von Pascal Fua)

10 ML Papers音频:00:0023:15

本周 10 篇 ML 精选Beschreibung:

1. Selbstorganisiertes Lernen mit erhaltener Graphstruktur mit dem Prinzip relevanter Informationen. (von Philip S. Yu)

2. Modifizierte Abfrageerweiterung durch generative gegnerische Netzwerke zur Informationsextraktion im E-Commerce. (von Altan Cakir)

3. Entwirrte Erklärungen neuronaler Netzwerkvorhersagen durch Auffinden relevanter Unterräume. (von Klaus-Robert Müller)

4. L-HYDRA: Mehrköpfige, physikinformierte neuronale Netze. (von George Em Karniadakis)

5. Zur Transformation des Reinforcement Learning durch Transformer: Der Entwicklungsverlauf. (von Dacheng Tao)

6. Förderung neuronaler Netze zur Dekompilierung optimierter Binärdateien. (von Kai Chen)

7. NeuroExplainer: Feinkörnige Aufmerksamkeitsdekodierung zur Aufdeckung kortikaler Entwicklungsmuster von Frühgeborenen. (von Dinggang Shen)

8. Eine Theorie des menschenähnlichen Few-Shot-Lernens. (von Ming Li)

9. Temporales Differenzlernen mit komprimierten Updates: Fehler-Feedback trifft auf verstärkendes Lernen. (von George J. Pappas)

10. Schätzung latenter Bevölkerungsströme aus aggregierten Daten durch Umkehrung des multimarginalen optimalen Transports. (von Hongyuan Zha)

Das obige ist der detaillierte Inhalt vonDie Inferenzgeschwindigkeit ist doppelt so hoch wie bei Stable Diffusion; Visual Transformer vereinheitlicht Bildtext. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Verwendung von UpdatePanel

Verwendung von UpdatePanel

Wie richte ich WeChat so ein, dass meine Zustimmung erforderlich ist, wenn mich jemand zu einer Gruppe hinzufügt?

Wie richte ich WeChat so ein, dass meine Zustimmung erforderlich ist, wenn mich jemand zu einer Gruppe hinzufügt?

So verwenden Sie Spyder

So verwenden Sie Spyder

Was ist der Unterschied zwischen CSS-Framework und Komponentenbibliothek?

Was ist der Unterschied zwischen CSS-Framework und Komponentenbibliothek?

Konfigurieren Sie die HOSTS-Datei

Konfigurieren Sie die HOSTS-Datei

Welche Methoden der Fernwartung von Computern gibt es?

Welche Methoden der Fernwartung von Computern gibt es?

Was sind die gängigen Testtechniken?

Was sind die gängigen Testtechniken?

Verwendung von Kordelzug

Verwendung von Kordelzug

Wie ist die Leistung von thinkphp?

Wie ist die Leistung von thinkphp?