Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Interview mit Stuart Russell: In Bezug auf ChatGPT können mehr Daten und mehr Rechenleistung keine echte Intelligenz bringen

Interview mit Stuart Russell: In Bezug auf ChatGPT können mehr Daten und mehr Rechenleistung keine echte Intelligenz bringen

Interview mit Stuart Russell: In Bezug auf ChatGPT können mehr Daten und mehr Rechenleistung keine echte Intelligenz bringen

Die vierte chinesische Ausgabe von „Artificial Intelligence: A Modern Approach“ wurde kürzlich veröffentlicht. Machine Heart führte ein exklusives Interview mit dem Autor, Professor Stuart Russell. Als Klassiker auf dem Gebiet der KI wurde „Artificial Intelligence: A Modern Approach“ mehrfach nachgedruckt, wobei Inhalt und Struktur das sich entwickelnde Verständnis der beiden Autoren widerspiegeln. Die neueste vierte Ausgabe ist ihre neueste Erklärung, nachdem sie die Fortschritte der KI im letzten Jahrzehnt, insbesondere die Auswirkungen von Deep Learning, in den Gesamtrahmen einbezogen hat. Sie spiegelt die Erkenntnisse der beiden Meister über die Trends in der künstlichen Intelligenz und die Entwicklung des Fachs wider System.

Auch dieses Interview folgt „einem modernen Ansatz“ und hofft, Professor Russell aus einer Perspektive vorzustellen, die im Einklang mit der Entwicklung von steht Technologie und die Zeit: Gedanken zu Technologietrends, Intelligenztheorien und populären vs. Klassikern bieten Inspiration für KI-Forscher und -Praktiker.

Stuart Russell arbeitet an der Universität of California Berkeley, derzeit Professor am Fachbereich Informatik (ehemaliger Lehrstuhlinhaber) und Direktor des Center for Human-Compatible Artificial Intelligence. Er erhielt 1990 den Presidential Award der National Science Foundation für herausragende junge Wissenschaftler und 1995 den IJCAI Computing and Ideas Award. Er ist Fellow von AAAI, ACM und AAAS und hat mehr als 300 Artikel im Bereich der künstlichen Intelligenz veröffentlicht, die ein breites Themenspektrum abdecken. Bildquelle: kavlicenter.berkeley.edu

Professor Russell glaubt, dass sich die Aufmerksamkeit im Laufe des nächsten Jahrzehnts vom anderen Ende der Abhängigkeit verlagern wird zum Thema End-to-End Deep Learning ist zu Systemen zurückgekehrt, die aus modularen, mathematisch logischen, semantisch wohldefinierten Darstellungen bestehen, und Deep Learning wird eine entscheidende Rolle bei der Gewinnung roher sensorischer Daten spielen. Es ist wichtig zu betonen, dass modulare, semantisch klar definierte Darstellungen nicht von Hand entworfen werden müssen oder unflexibel sind. Solche Darstellungen können aus Daten gelernt werden.

Was das beliebte ChatGPT angeht, glaubt Professor Russell, dass der Schlüssel darin liegt, zwischen Aufgabenbereichen zu unterscheiden und herauszufinden, unter welchen Umständen es sein sollte verwendet werden: ChatGPT Es kann ein großartiges Tool sein und wird noch mehr Wert bringen, wenn es in Fakten verankert und in Planungssysteme integriert ist. Das Problem ist, dass wir derzeit nicht wissen, wie ChatGPT funktioniert, und wir werden es wahrscheinlich auch nicht herausfinden können, was einige konzeptionelle Durchbrüche erfordert, die schwer vorherzusagen sind.

Er glaubt, dass wir zum Aufbau eines wirklich intelligenten Systems der mathematischen Logik und dem Wissensdenken mehr Aufmerksamkeit schenken sollten, weil wir das müssen Aufbauen des Systems auf Basis der uns bekannten Methoden kann so sichergestellt werden, dass die KI nicht außer Kontrolle gerät. Er glaubt nicht, dass eine Skalierung die Lösung ist, und er glaubt auch nicht, dass mehr Daten und mehr Rechenleistung das Problem lösen können. Das ist zu optimistisch und intellektuell uninteressant.

Wenn wir das grundlegende Problem der Ineffizienz von Deep-Learning-Daten ignorieren, „befürchte ich, dass wir uns selbst täuschen und denken, dass wir uns bewegen.“ Alles, was wir tun, ist, immer mehr Pixel zu etwas hinzuzufügen, das überhaupt kein intelligentes Modell ist.“ Heart of the Machine: Ersetzen groß angelegte vorab trainierte Sprachmodelle (LLM), die durch ChatGPT dargestellt werden, im Wesentlichen die auf ein höheres Niveau gehobene künstliche Intelligenz? Überwindet LLM einige grundlegende Probleme von Deep-Learning-Systemen, wie z. B. den Erwerb von gesundem Menschenverstand und das Denken von Wissen?

Stuart Russell:

Die erste Antwort, die mir in den Sinn kommt ist – „Wir wissen es nicht, weil niemand weiß, wie diese Modelle funktionieren, einschließlich der Menschen, die sie erstellt haben.

ChatGPT Was weißt du? Kann es argumentieren? In welchem Sinne versteht es die Antwort? Wir wissen es nicht. Ein Freund von mir an der Oregon State University fragte das Model: „Was ist größer, ein Elefant oder eine Katze?“ Das Model antwortete „Der Elefant ist größer“, aber fragen Sie anders: „Wer, Elefant oder Katze, ist nicht größer als der andere?“ Das Modell antwortet: „Weder Elefant noch Katze sind größer als der andere.“ Sie sagen also, dass das Modell weiß, wer größer ist, ein Elefant oder eine Katze? Es weiß es nicht, denn anders gefragt käme es zu einem widersprüchlichen Ergebnis.

Also, was weiß das Model?

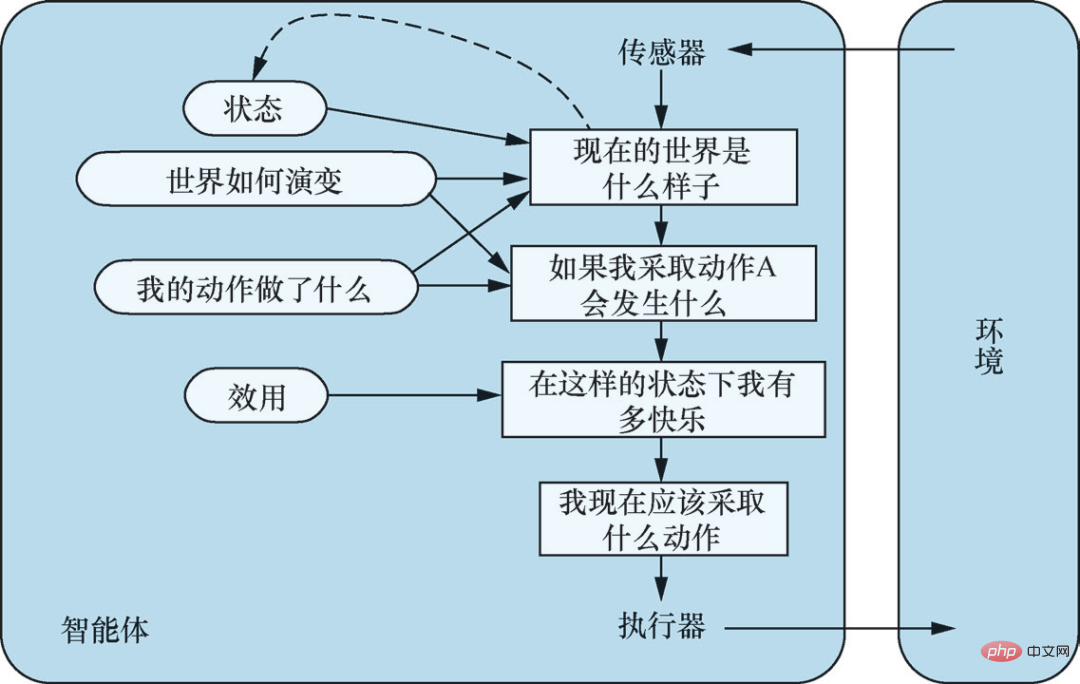

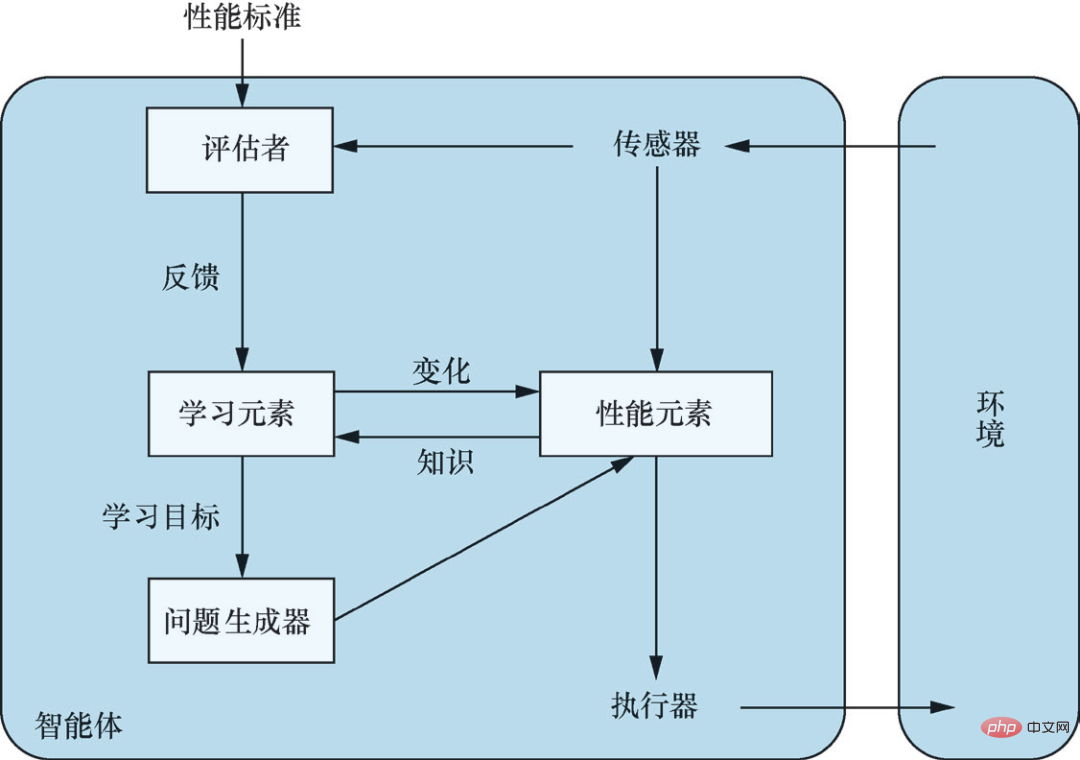

Lassen Sie mich Ihnen ein weiteres Beispiel geben, das auch tatsächlich passiert ist. Die Trainingsdaten für diese Modelle enthalten eine große Anzahl von Schachpartien, dargestellt durch einheitliche Codes und Symbole. Eine Partie sieht aus wie die Sequenz e4 e5 Sf3 Sc6 Lb5.... Der Spieler kennt die Bedeutung dieser Symbole und die durch diese Sequenzen dargestellten Züge. Aber das Modell weiß nicht, dass es ein Schachbrett gibt, und es kennt die Züge nicht. Für das Modell sind diese Symbole nur Symbole. Wenn Sie also Blindschach spielen und sagen: „Lass uns Schach spielen, g4“, antwortet es vielleicht mit „e6“, aber das Modell hat keine Vorstellung davon, wie man Schach spielt Training Finden Sie ähnliche Sequenzen in den Daten, führen Sie entsprechende Transformationen für diese Sequenzen durch und generieren Sie dann den nächsten Zug. In 80 % oder sogar 90 % der Fälle führt es zu einem guten Zug, aber manchmal führt es Züge aus, die albern sind oder völlig gegen die Regeln verstoßen, weil es keine Vorstellung davon hat, wie man einen Zug auf einem Schachbrett spielt. Nicht nur für Schach, ich denke, das gilt eigentlich für alles, was die großen Models jetzt machen: 80 % der Zeit. Es sieht so aus wie ein sehr kluger Mensch, aber in den anderen 20 % der Fälle sieht er wie ein kompletter Idiot aus. Es sieht schlau aus, weil es viele Daten hat. Es hat bisher fast alle von Menschen geschriebenen Bücher und Artikel gelesen. .. , aber trotzdem wird es nach Erhalt einer so großen Menge nützlicher Informationen immer noch Dinge ausspucken, von denen es keine Ahnung hat, was es bedeutet. In diesem Sinne denke ich, dass große Sprachmodelle wahrscheinlich kein Fortschritt in der künstlichen Intelligenz sind. ChatGPT Das wirklich Beeindruckende daran ist seine Fähigkeit, die Interaktionen mit seinen Benutzern zu verallgemeinern und Ähnlichkeiten zwischen ihnen zu finden Konversationen und zuvor gelesenen Text und nehmen Sie entsprechende Übergänge vor, damit die Antworten intelligent aussehen. Allerdings wissen wir nicht, wie das Modell das macht, wir wissen nicht, wo die Grenzen dieser Generalisierungsfähigkeit liegen und wir wissen nicht, wie diese Generalisierung im Schaltkreis implementiert wird. Wenn wir es wirklich wissen, kann man tatsächlich sagen, dass es sich um eine Weiterentwicklung der künstlichen Intelligenz handelt, weil wir sie als nutzen können Basis können wir andere Systeme entwickeln, die auf ChatGPT basieren. Aber zu diesem Zeitpunkt bleibt alles ein Rätsel. Können wir nur dann vorankommen, wenn das Modell nicht funktioniert? Okay, geben wir ihm mehr Daten und machen das Modell etwas größer. Ich glaube nicht, dass eine Vergrößerung die Lösung ist. Irgendwann werden die Daten zur Neige gehen und in der realen Welt passieren immer wieder neue Situationen. Wenn wir Schachprogramme schreiben, können die Programme, die wirklich gut Schach spielen können, mit noch nie dagewesenen Situationen umgehen. Es gibt nur einen Grund: Diese Programme verstehen die Schachregeln und können die Schachfiguren in der Evolution bewegen Die Positionen auf dem Schachbrett – die Punkte, an denen Figuren bewegt werden können, mögliche nächste Züge des Gegners, einschließlich Züge, die noch nie zuvor im Schachspiel aufgezeichnet wurden – werden visualisiert. Wir sind noch weit davon entfernt, dies in allgemeinen Situationen der realen Welt zu tun. Gleichzeitig glaube ich nicht, dass große Sprachmodelle uns diesem Ziel näher bringen. Außer, könnte man sagen, dass große Sprachmodelle es uns ermöglichen, in Texten gespeichertes menschliches Wissen zu nutzen. Große Sprachmodelle werden nützlicher sein, wenn wir sie in bekannten Fakten verankern können. Denken Sie an den Google Knowledge Graph, der 500 Milliarden Fakten enthält und in der Lage ist, korrekte Antworten auf Fragen zu diesen Fakten zu geben, dann ist ChatGPT zuverlässiger. Wenn wir einen Weg finden können, große Sprachmodelle in eine Inferenzmaschine zu koppeln, die Inferenz und Planung korrekt durchführen kann, dann Sie kann sagen: Wir haben einen Engpass in der künstlichen Intelligenz durchbrochen. Wir haben jetzt viele Planungsalgorithmen, aber es ist schwierig, diese Planungsalgorithmen dazu zu bringen, eine korrekte und vernünftige Planung durchzuführen, wie zum Beispiel den Bau eines Autos, und ihnen das erforderliche Wissen zu vermitteln, weil es zu viele Dinge gibt, die verstanden werden müssen, und das auch ist sehr schwierig. Es ist schwierig, sie alle aufzuschreiben und sicherzustellen, dass sie alle korrekt sind. Aber große Sprachmodelle haben jedes Buch über Autos gelesen, und vielleicht können sie uns dabei helfen, das nötige Wissen aufzubauen oder einfach die nötigen Fragen auf Abruf zu beantworten, damit wir all dieses Wissen bei der Planung erfassen können. Im Vergleich dazu, ChatGPT nur als eine Blackbox zu betrachten, die Ihnen hilft, etwas zu tun, kombinieren Sie große Sprachmodelle mit Planungsalgorithmen und lassen Sie sie zum Wissensinput des Planungssystems werden, was wirklich nützliche Ergebnisse bringt Werkzeug . Soweit ich weiß, gibt es bereits Leute, die in diese Richtung arbeiten, und wenn es gelingt, wird es ein großer Fortschritt sein. Herz der Maschine: Was halten Sie als Lehrer von ChatGPT? Erlauben Sie Schülern, ChatGPT zum Erstellen von Arbeiten zu verwenden? Was halten Sie als Benutzer von den verschiedenen Anwendungen, die ChatGPT hervorgebracht hat, insbesondere von kommerziellen Anwendungen? Stuart Russell: Als ich vor ein paar Wochen beim Weltwirtschaftsforum in Davos mit Geschäftsleuten sprach, fragten mich alle nach großen Sprachmodellen und wie man sie in ihren Angelegenheiten nutzen könne Einsatz dieser Modelle in Unternehmen. Ich denke, Sie können es sich so vorstellen: Würden Sie einen 6-Jährigen in Ihrem Unternehmen in die gleiche Position bringen? Obwohl es Unterschiede in den Fähigkeiten zwischen den beiden gibt, denke ich, dass sie so verglichen werden können. Große Sprachmodelle und ChatGPT sind nicht vertrauenswürdig. Sie haben keinen gesunden Menschenverstand und geben auf ernsthafte Weise falsche Informationen weiter. Wenn Sie also ChatGPT oder ein ähnliches Modell in Ihrem Unternehmen verwenden, müssen Sie sehr vorsichtig sein. Wenn man sich bestimmte Positionen oder Verantwortlichkeiten im Unternehmen als Knotenpunkte im Netzwerk vorstellt, ist Sprache in diesen Knotenpunkten ein Input und Output – natürlich kann man sich das bei vielen Berufen so vorstellen, etwa bei Journalisten und Professoren . So etwas. Das bedeutet jedoch nicht, dass Sie sie durch ChatGPT ersetzen können. Wir müssen sehr vorsichtig sein, wenn es um Bildung geht. Das Aufkommen von ChatGPT hat bei vielen Menschen Panik ausgelöst. Manche Leute sagen, wir müssen ChatGPT in Schulen deaktivieren. Andere sagten, das Verbot von ChatGPT sei lächerlich und verwiesen auf Diskussionen aus dem 19. Jahrhundert – als jemand sagte, wir müssten mechanische Taschenrechner verbieten, weil die Schüler niemals die Mathematik richtig lernen würden, wenn sie anfangen würden, mechanische Taschenrechner zu verwenden. Klingt das nicht überzeugend? Scheint es nicht so, als müssten wir ChatGPT verbieten? Diese Analogie ist jedoch völlig falsch – ein mechanischer Rechner automatisiert genau denselben mechanischen Prozess. Das Multiplizieren von 26-stelligen Zahlen ist sehr mechanisch, eine Reihe von Anweisungen, und Sie müssen nur die Schritte Schritt für Schritt befolgen, um die Antwort zu erhalten. Der intellektuelle Wert der Befolgung von Anweisungen ist begrenzt, insbesondere wenn die Person nicht versteht, was die Anweisungen bewirken. Aber was ChatGPT ersetzen wird, ist nicht das mechanische Befolgen von Anweisungen, sondern die Fähigkeit, Fragen zu beantworten, die Fähigkeit zu lesen und zu verstehen und die Fähigkeit, Ideen in Dokumenten zu organisieren. Wenn Sie diese nicht einmal lernen und ChatGPT dies für Sie tun lassen, werden Sie möglicherweise wirklich zu einer nutzlosen Person. Mittlerweile gibt es elektronische Taschenrechner, aber wir bringen den Kindern immer noch das Rechnen bei, wir bringen ihnen die Regeln der Arithmetik bei, versuchen ihnen zu verstehen, was Zahlen sind, wie Zahlen mit Dingen in der physischen Welt korrespondieren usw. Erst wenn sie dieses Verständnis erlangt haben und die Regeln der Arithmetik beherrschen, werden wir ihnen elektronische Taschenrechner geben, damit sie nicht mechanischen Verfahren folgen müssen. Zu unserer Zeit gab es keine Taschenrechner. Wir verwendeten gedruckte Tabellen mit den Werten verschiedener Sinus-, Cosinus- und Logarithmusfunktionen. Niemand hat gesagt, dass man mit diesen Tabellen nicht lernen kann. Mathematik. Wir müssen also herausfinden, wann der richtige Zeitpunkt für Studierende ist, mit der Nutzung eines Tools wie ChatGPT zu beginnen. Um Ihre Frage zu beantworten: Wenn Sie den hirnlosen Teil der Aufgabe, eine Arbeit zu schreiben, finden – tatsächlich kommt es oft vor, dass das Schreiben einer Arbeit hirnlos ist und nur die mechanische Wiederholung mühsamer und langweiliger Prozesse erfolgt –, dann steht Ihnen wahrscheinlich ChatGPT zur Verfügung Damit habe ich kein Problem. Schreiben ist jedoch nicht nur ein langweiliger Prozess, sondern auch eine Möglichkeit für Menschen, das Denken zu lernen. Das Letzte, was wir wollen, ist jemand, der ChatGPT blind nutzt und weder die Frage noch die Antwort versteht. Was andere Anwendungen von ChatGPT betrifft, wie zum Beispiel das Generieren von Bildern oder Musik, ist die Situation meiner Meinung nach ähnlich. Der Schlüssel liegt darin, die Aufgabenbereiche klar zu unterscheiden. Ich denke, dass der Prozess des Schaffens von Kunst grob in zwei Teile unterteilt werden kann: erstens eine Vorstellung davon, was man schaffen möchte, und dann der relativ mechanische Prozess, es tatsächlich auf der Grundlage seiner Vision zu schaffen. Letzteres stellt für manche Menschen eine große Herausforderung dar und egal, wie sehr sie sich bemühen, sie schaffen es nicht, ein gut aussehendes Bild zu machen. Deshalb haben wir speziell ausgebildete Künstler, insbesondere Werbekünstler, deren Arbeit nicht viel Kreativität erfordert, die mehr Aufmerksamkeit schenken auf die Fähigkeit, Bilder bedarfsgerecht zu produzieren. Ich denke, dass dies ein Beruf ist, der sehr bedroht ist. Ich hatte diese Erfahrung, als ich ein Buch schrieb. Es gibt fünf- oder sechshundert Illustrationen in „Künstliche Intelligenz: Ein moderner Ansatz“. ". Ich zeichne fast alle selbst. Das Erstellen einer guten Illustration oder eines guten Diagramms ist ein langsamer und mühsamer Prozess, der viel Geschick und Geschick erfordert. Wenn es ein großes Modell oder eine große Anwendung gäbe, die Diagramme oder technische Illustrationen wie die in meinem Buch erzeugen könnte, würde ich sie gerne verwenden. Modellbasierter, dienstprogrammbasierter Agent. Quelle: „Künstliche Intelligenz: Moderner Ansatz (4. Auflage)“ Abbildungen 2-14

# 🎜 🎜#Herz der Maschine: Wir kennen das Prinzip von ChatGPT nicht, aber durch die technische Implementierung haben wir ein Tool erhalten, das in bestimmten Situationen nützlich zu sein scheint um die Leute auf den Plan zu bringen. Ist ChatGPT aus technischer Sicht eine Verbesserung?

Ich bin mir nicht sicher, ob ChatGPT kann verwendet werden Man nennt es Ingenieurwesen, weil wir uns unter „Ingenieurwesen“ im Allgemeinen eine Disziplin der angewandten Ingenieurwissenschaft vorstellen, die Kenntnisse aus Physik, Chemie, Mechanik, Elektronik usw. kombiniert, um für den Menschen nützliche Produkte in einem Komplex zu schaffen und geniale Sache. Gleichzeitig verstehen wir, warum diese Dinge nützlich sind, weil ihre nützlichen Eigenschaften durch spezifische Methoden erreicht werden und reproduziert werden können.

Aber wie haben wir ChatGPT entwickelt? Das Einbeziehen von menschlichem Feedback ist nützlich, aber aus den Ergebnissen wird ChatGPT gewonnen, indem ein Gradientenabstieg für eine große Anzahl von Datensätzen durchgeführt wird. Das erinnert mich an die 1950er Jahre, als große Anstrengungen in die genetische Programmierung gesteckt wurden und Fortran-Programme, die durch die Simulation der biologischen Evolution Intelligenz erlangen sollten, kläglich scheiterten.

Theoretisch ist es im Prinzip möglich, intelligentere Fortran-Programme zu generieren, wenn Sie über genügend Fortran-Programme verfügen und diese genügend Mutationen generieren lassen als Menschen. Diese grundsätzliche Möglichkeit hat sich jedoch in der Praxis nicht erfüllt. #??? Ich halte es für unwahrscheinlich, vielleicht etwas mehr als die Weiterentwicklung von Fortran-Programmen – aber ich kann nicht sagen, dass Fortran-Programme vielleicht wahrscheinlicher sind, weil es Grund zu der Annahme gibt, dass Fortran-Programme eine Art Darstellung sind, die stärkere Fähigkeiten als Schaltkreise hat. Sprache, und als sie 1958 das Fortran-Programm aufgaben, war die Rechenleistung um 15 oder 16 Größenordnungen geringer als die, die wir heute haben.

Machine Heart: Was halten Sie ohne das Wort „Engineering“ von dem, was OpenAI tut? Stuart Russell:Was OpenAI macht, kann man es Kochen (Kochen) nennen # 🎜 🎜#, weil wir wirklich nicht wissen, wie diese Modelle funktionieren. Genauso wie wenn ich einen Kuchen backe, weiß ich nicht, wie daraus ein Kuchen geworden ist. Sie haben seit Tausenden von Jahren viele verschiedene Rohstoffe und viele verschiedene Methoden ausprobiert , eines Tages entdeckte ich etwas Magisches – Kuchen, das ist Kochen. Jetzt wissen wir etwas mehr über die Grundprinzipien des Kuchens, aber er ist immer noch nicht perfekt. Wir können beim Kochen nicht viel herausholen, und der Prozess ist nicht von großem intellektuellem Wert. Wenn es grundlegende Probleme mit ChatGPT gibt, müssen Sie eines Tages Eingabeaufforderungen (prompt) oder Anweisungen (instruct) eingeben. Was sollten Sie tun, wenn Sie nicht die gewünschte Antwort erhalten? Wirst du das Rezept noch einmal ändern? Den Token von 4000 auf 5000 erhöhen und die Anzahl der Netzwerkschichten verdoppeln? Es ist keine Wissenschaft und ich glaube nicht, dass es intellektuell interessant ist. Forschung, die versucht zu verstehen, wie große Sprachmodelle funktionieren, ist sicherlich wertvoll, da ChatGPT viele erstaunliche Verallgemeinerungen durchführt Indem wir herausfinden, wie dies geschieht, können wir wirklich sinnvolle intelligente Systeme entwickeln. Mittlerweile arbeiten viele Leute daran, und es wurden viele Artikel darüber veröffentlicht. Aber ich denke, es ist schwer zu sagen, ob der interne Mechanismus von ChatGPT möglicherweise zu kompliziert ist, und wir haben keine Möglichkeit zu verstehen, was im Inneren vor sich geht. Eine interessante Analogie ist, was vor 30.000 Jahren zwischen Menschen und Hunden geschah. Wir verstehen nicht, wie das Gehirn eines Hundes funktioniert, und es ist schwierig, genau herauszufinden, was ein Hund denkt, aber wir haben gelernt, ihn zu zähmen, und jetzt sind Hunde in unser Leben integriert und spielen eine Vielzahl wertvoller Rollen. Wir haben herausgefunden, dass Hunde in vielen Dingen gut sind, unter anderem darin, sich um ein Zuhause zu kümmern und mit Kindern zu spielen, aber das erreichen wir nicht durch Technik, sondern wir selektieren und verbessern diese Eigenschaften durch Züchten, indem wir ihre Formeln optimieren. Aber Sie würden nicht erwarten, dass Ihr Hund Ihren Artikel für Sie schreibt, Sie wissen, dass er das nicht kann, und Sie erwarten wahrscheinlich auch nicht, dass Ihr Hund das tut. ChatGPT Das Überraschende an der ganzen Sache ist, dass ich denke, dass dies das erste Mal ist, dass ein KI-System es wirklich in die Welt geschafft hat Öffentliche Meinungen, das ist eine große Veränderung. OpenAI selbst hat ein gutes Sprichwort: Obwohl ChatGPT keine echte Intelligenz ist, ermöglicht es dem menschlichen Körper, die Verwirklichung echter (künstlicher) Intelligenz zu spüren, und jeder kann diese Intelligenz nutzen, um alle möglichen Dinge zu tun, die er tun möchte . . Herz der Maschine: Ein weiterer Punkt, der viele Menschen beunruhigt, ist das Verschwinden von Zwischenaufgaben, die dadurch verursacht werden LLM. Glauben Sie, dass diese Zwischenaufgaben wie die semantische Analyse und die syntaktische Analyse jetzt aus technischer Iterationsperspektive von großem Wert sind, und werden sie in Zukunft wirklich verschwinden? Besteht die Gefahr, dass KI-Forscher und -Praktiker in der Mitte, also diejenigen, die über keine leistungsstarken Hardware-Ressourcen oder ausgeprägte Domänenkenntnisse verfügen, ihren Job verlieren? Stuart Russell: Das ist ein Gute Frage. Tatsache ist, dass es heutzutage schwierig ist, Artikel zur semantischen Analyse zu veröffentlichen. Tatsächlich ist es heutzutage schwierig, die Leute in der NLP-Community dazu zu bringen, sich irgendetwas anzuhören, es sei denn, man spricht über große Sprachmodelle oder aktualisiert große Benchmarks mit großen Modellen. In fast allen Artikeln geht es um die Aktualisierung großer Benchmarks. Es ist schwierig, einen Artikel zu veröffentlichen, in dem es nicht um die Aktualisierung großer Benchmarks wie Sprachstruktur, Sprachverständnis oder semantische Analyse, syntaktische Analyse usw. geht, also um die großen Benchmarks zur Bewertung großer Modelle Es ist zur einzigen Wahl für das Schreiben von Arbeiten geworden, und diese großen Maßstäbe haben nichts mit der Sprache zu tun. In gewisser Weise studieren wir heute im Bereich der Verarbeitung natürlicher Sprache keine Sprache mehr, was ich für sehr bedauerlich halte. Das Gleiche gilt für Computer Vision. In den meisten Computer-Vision-Forschungen untersuchen wir heute nicht mehr das Sehen, sondern nur Daten, Training und Vorhersagegenauigkeit. Was die nächste Entwicklung der KI betrifft, sollten wir uns meiner Meinung nach auf die Methoden konzentrieren, die wir verstehen, und uns dabei auf Wissen und logisches Denken konzentrieren . Der Grund dafür ist zweierlei: Erstens wollen wir, dass KI-Systeme zuverlässig sind. Wir müssen mathematisch sicherstellen, dass sie sicher und kontrollierbar sind, und das bedeutet, dass wir die Systeme, die wir bauen, verstehen müssen. Zweitens: Denken Sie unter dem Gesichtspunkt der Dateneffizienz darüber nach, was notwendig sein wird, wenn allgemeine Intelligenz erreicht werden soll, wenn das menschliche Gehirn mit 20 Watt statt mit 20 Megawatt läuft. Schaltkreise sind keine sehr ausdrucksstarke Sprache, die Dateneffizienz dieser Algorithmen ist um Größenordnungen geringer als beim menschlichen Lernen, und es würde Ihnen schwer fallen, viel von dem, was wir über die Welt wissen, in Schaltkreisen niederzuschreiben. Sobald wir Allzweckcomputer und Programmiersprachen hatten, hörten wir auf, Schaltkreise zu verwenden, weil es viel einfacher und einfacher war, das auszudrücken, was wir in einem Programm wollten, was die KI-Community irgendwann weitgehend vergessen hat in die Irre. Herz der Maschine: Die vierte Ausgabe von „Artificial Intelligence: Modern Approaches“ hat ein wichtiges Update, nämlich dass nicht mehr davon ausgegangen wird, dass KI-Systeme oder -Agenten feste Ziele haben. Früher wurde der Zweck der künstlichen Intelligenz darin definiert, „Systeme zu schaffen, die versuchen, den erwarteten Nutzen zu maximieren, wobei wir Ziele für KI-Systeme festlegen“. Stuart Russell: Es gibt mehrere Gründe. Erstens fällt es uns schwer, unsere Ziele vollständig korrekt zu definieren, da künstliche Intelligenz das Labor verlässt und in die reale Welt vordringt. Wenn Sie beispielsweise auf der Straße unterwegs sind, möchten Sie schnell an Ihr Ziel gelangen, aber das bedeutet nicht, dass Sie 200 Meilen pro Stunde fahren sollten, und wenn Sie einem selbstfahrenden Auto sagen, dass die Sicherheit an erster Stelle stehen soll, Es könnte für immer in einer Garage landen. Es gibt Kompromisse zwischen den Zielen, sicher und schnell an Ihr Ziel zu gelangen, freundlich zu anderen Fahrern zu sein, Fahrgästen keine Unannehmlichkeiten zu bereiten, Gesetze und Vorschriften einzuhalten usw. Auf der Straße gibt es immer Risiken und es passieren unvermeidliche Unfälle. Es ist schwierig, alle Ziele beim Autofahren aufzuschreiben, und Autofahren ist nur eine kleine und einfache Sache im Leben. Aus praktischer Sicht ist es daher unvernünftig, sich Ziele für KI-Systeme zu setzen. Das zweite betrifft das Beispiel von König Midas (König-Midas-Problem), das ich im Buch gegeben habe. Midas war ein König in der griechischen Mythologie und bat Gott, ihm die Macht zu geben, alles in Gold zu verwandeln, und alles, was er anfasste, verwandelte sich in Gold verwandelte sich ebenfalls in Gold, und auch seine Familienmitglieder verwandelten sich in Gold, nachdem sie von ihm berührt worden waren. Schließlich starb er auf tragische Weise umgeben von Gold. Dies erinnert uns daran, dass Sie beim Definieren von Zielen für sehr leistungsstarke Systeme besser sicherstellen sollten, dass die von Ihnen definierten Ziele absolut korrekt sind. Aber jetzt, da wir wissen, dass wir das nicht können, wird es mit zunehmender Leistungsfähigkeit von KI-Systemen immer wichtiger, dass sie nicht wissen, was ihre wahren Ziele sind. Ziele sind eigentlich eine sehr komplizierte Sache. Wenn ich zum Beispiel sage, ich möchte eine Orange zum Mittagessen kaufen, kann das ein Ziel sein, oder? Im alltäglichen Kontext wird ein Ziel als etwas angesehen, das erreicht werden kann, und sobald es erreicht ist, wird es erreicht. Aber in der durch Philosophie und Ökonomie definierten Rational-Choice-Theorie gibt es kein solches Ziel. Was wir haben, sind Präferenzen oder Rangfolgen verschiedener möglicher Zukünfte. Sie umfasst alles im Universum. Ich denke, es ist ein komplexeres, tieferes Verständnis des Zwecks, dessen, was Menschen wirklich wollen. Heart of the Machine: Welche Auswirkungen wird diese Transformation auf die zukünftige Entwicklung der künstlichen Intelligenz haben? Stuart Russell: Seit der Geburt der künstlichen Intelligenz mit der Informatik in den 1940er und 1950er Jahren benötigen Forscher ein Konzept der Intelligenz, damit sie darauf basierende Forschung betreiben können. Während es in einigen frühen Arbeiten eher um die Nachahmung menschlicher Kognition ging, setzte sich letztendlich das Konzept der Rationalität durch: Je besser eine Maschine ihre beabsichtigten Ziele durch Handeln erreichen kann, desto intelligenter halten wir sie. Im Standardmodell der künstlichen Intelligenz ist dies die Art von Maschine, die wir erschaffen wollen; der Mensch definiert das Ziel und die Maschine erledigt den Rest. Für ein Lösungssystem in einer deterministischen Umgebung geben wir beispielsweise eine Kostenfunktion und ein Zielkriterium an, damit die Maschine die Aktionssequenz mit den geringsten Kosten finden kann, um den Zielzustand für ein verstärkendes Lernsystem in einer stochastischen Umgebung zu erreichen Geben Sie eine Belohnungsfunktion und einen Rabattfaktor an und lassen Sie die Maschine eine Strategie lernen, die die erwartete Rabattprämiensumme maximiert. Dieser Ansatz lässt sich auch außerhalb des Bereichs der künstlichen Intelligenz beobachten: Kontrollwissenschaftler minimieren Kostenfunktionen, Operationsforscher maximieren Belohnungen, Statistiker minimieren erwartete Verlustfunktionen und Ökonomen maximieren den individuellen Nutzen oder das Wohlergehen einer Gruppe. Aber das Standardmodell ist eigentlich falsch. Wie gerade gesagt, ist es für uns fast unmöglich, unsere Ziele völlig korrekt zu formulieren, und wenn die Ziele der Maschine nicht mit unseren tatsächlichen Wünschen übereinstimmen, verlieren wir möglicherweise die Kontrolle über die Maschine, weil die Maschine präventiv Maßnahmen ergreift und tut, was immer sie will Der Preis stellt sicher, dass es seine erklärten Ziele erreicht. Fast alle bestehenden KI-Systeme werden im Rahmen von Standardmodellen entwickelt, was große Probleme mit sich bringt. In Artificial Intelligence: A Modern Approach (4. Auflage) argumentieren wir, dass künstliche Intelligenz neue Modelle erfordert, #🎜 🎜## 🎜🎜#Das neue Modell betont die Ungewissheit des Ziels des KI-Systems. Diese Ungewissheit ermöglicht es der Maschine, menschliche Vorlieben zu erlernen Vorab menschliche Meinungen einzuholen. Während des Betriebs des KI-Systems müssen einige Informationen vom Menschen zur Maschine fließen, die die wahren Vorlieben des Menschen veranschaulichen, und nicht, dass die Ziele des Menschen irrelevant werden, sobald sie einmal festgelegt wurden. Dies erfordert eine Entkopplung von Maschinen von festen Zielen und eine binäre Kopplung zwischen Maschinen und Menschen. Das Standardmodell kann als Extremfall betrachtet werden, bei dem eine Maschine ein gewünschtes menschliches Ziel, wie z. B. das Spielen von Go oder das Lösen eines Rätsels, im Rahmen der Maschine vollständig korrekt spezifizieren kann. Wir stellen im Buch auch einige Beispiele zur Verfügung, um zu veranschaulichen, wie das neue Modell funktioniert, wie etwa unsichere Präferenzen, Abschaltprobleme (aus – Schalterproblem), Assistenzspiel usw. Aber das ist erst der Anfang, und wir haben gerade erst mit der Forschung begonnen. Herz der Maschine: Wie man im sich schnell entwickelnden Bereich der künstlichen Intelligenz mit den technologischen Trends ohne Schritt halten kann Blindlings hinter ihnen her Hot Spot? Was sollten KI-Forscher und -Praktiker beachten? 🎜🎜 Ich denke, dass das grundlegende Problem eines intelligenten Systems darin besteht, eine repräsentative Sprache verwenden zu können, um die verschiedenen im Universum enthaltenen Unregelmäßigkeiten darzustellen. Der wesentliche Unterschied zwischen Intelligenz und Schaltkreisen besteht darin, dass Schaltkreise unseres Wissens diese Unregelmäßigkeiten nicht gut darstellen können, und das zeigt sich in der Praxis, weil der extrem geringen Dateneffizienz. Als einfaches Beispiel könnte ich die Definition der Sinusfunktion (mit einer mathematischen Formel) aufschreiben oder es versuchen Um viele Pixel zu verwenden, beschreiben Sie empirisch die Sinusfunktion. Wenn ich nur 10 Millionen Pixel habe, kann ich nur einen Teil der Sinusfunktion abdecken, und wenn ich mir den Bereich ansehe, den ich abgedeckt habe, scheine ich ein ziemlich gutes Modell der Sinusfunktion zu haben. Aber eigentlich verstehe ich die Sinusfunktion nicht wirklich, ich kenne die Form der Funktion nicht und ich kenne ihre mathematischen Eigenschaften nicht. Ich mache mir Sorgen, dass wir uns selbst etwas vormachen und denken, wir bewegen uns in Richtung wahrer Intelligenz. Alles, was wir wirklich tun, ist, immer mehr Pixel zu etwas hinzuzufügen, das überhaupt kein intelligentes Modell ist. Ich denke, dass wir uns beim Aufbau von KI-Systemen auf Methoden konzentrieren müssen, die über grundlegende Darstellungsfähigkeiten verfügen Die Fähigkeit, alle Objekte darzustellen, wird deklariert. Angenommen, ich möchte die Regeln von Go aufschreiben. Dann kann ich sagen, was mit jedem y für jedes x passieren wird Auf Englisch geschrieben, in Logik erster Ordnung geschrieben. Jede dieser Sprachen ermöglicht es mir, Regeln sehr prägnant aufzuschreiben, da sie alle über die Ausdruckskraft verfügen, diese Regeln auszudrücken. Allerdings kann ich dies nicht in Schaltkreisen tun, und schaltkreisbasierte Darstellungen (einschließlich Deep-Learning-Systeme) können diese Klasse von Verallgemeinerungen nicht darstellen. Diese Tatsache zu ignorieren und zu versuchen, durch Big Data Intelligenz zu erlangen, erscheint mir lächerlich, als würde man sagen, dass es keinen Grund dafür gibt Verstehen Sie, was ein Go-Stück ist, denn wir haben Milliarden von Trainingsbeispielen. Wenn Sie darüber nachdenken, was die menschliche Intelligenz geleistet hat: Wir haben LIGO gebaut und Gravitationswellen von der anderen Seite des Universums entdeckt. Wie haben wir es gemacht? Basierend auf Wissen und Argumentation. Wo haben wir vor der Erstellung von LIGO Trainingsbeispiele gesammelt? Offensichtlich haben die Vorgänger einige Dinge gelernt, einschließlich ihrer Sinneserfahrungen, und sie dann in ausdrucksstarken Sprachen wie Englisch und Mathematik aufgezeichnet. Wir haben von ihnen gelernt, die Gesetze des Universums verstanden und auf dieser Grundlage Überlegungen angestellt und konstruiert Design usw. und beobachtete so eine Kollision eines Schwarzen Lochs am anderen Ende des Universums. Natürlich ist es möglich, auf der Grundlage großer Datenmengen Intelligenz zu erzielen. Es ist auch möglich, ein Fortran-Programm zu entwickeln, das intelligenter ist als Menschen. Aber wir haben mehr als zweitausend Jahre damit verbracht, Wissen und Argumentation zu verstehen und eine große Anzahl hervorragender Technologien entwickelt, die auf Wissen und Argumentation basieren, und auf der Grundlage dieser Technologien wurden Tausende nützlicher Anwendungen entwickelt. Nun sind Sie an Intelligenz interessiert, aber nicht an Wissen und Argumentation, dazu kann ich nichts sagen. -3-

Das obige ist der detaillierte Inhalt vonInterview mit Stuart Russell: In Bezug auf ChatGPT können mehr Daten und mehr Rechenleistung keine echte Intelligenz bringen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

Wie zeige ich die lokal installierte 'Jingnan Mai Round Body' auf der Webseite richtig?

Apr 05, 2025 pm 10:33 PM

Wie zeige ich die lokal installierte 'Jingnan Mai Round Body' auf der Webseite richtig?

Apr 05, 2025 pm 10:33 PM

Mit lokal installierten Schriftdateien auf Webseiten kürzlich habe ich eine kostenlose Schriftart aus dem Internet heruntergeladen und sie erfolgreich in mein System installiert. Jetzt...

Bedarf die Produktion von H5 -Seiten eine kontinuierliche Wartung?

Apr 05, 2025 pm 11:27 PM

Bedarf die Produktion von H5 -Seiten eine kontinuierliche Wartung?

Apr 05, 2025 pm 11:27 PM

Die H5 -Seite muss aufgrund von Faktoren wie Code -Schwachstellen, Browserkompatibilität, Leistungsoptimierung, Sicherheitsaktualisierungen und Verbesserungen der Benutzererfahrung kontinuierlich aufrechterhalten werden. Zu den effektiven Wartungsmethoden gehören das Erstellen eines vollständigen Testsystems, die Verwendung von Versionstools für Versionskontrolle, die regelmäßige Überwachung der Seitenleistung, das Sammeln von Benutzern und die Formulierung von Wartungsplänen.

Wo kann man das Material für die H5 -Seitenproduktion erhalten

Apr 05, 2025 pm 11:33 PM

Wo kann man das Material für die H5 -Seitenproduktion erhalten

Apr 05, 2025 pm 11:33 PM

Die Hauptquellen von H5 -Seitenmaterialien sind: 1. professionelle Material -Website (bezahlt, hoher Qualität, klares Urheberrecht); 2. hausgemachtes Material (hohe Einzigartigkeit, aber zeitaufwändig); 3. Open Source Material Library (kostenlos, muss sorgfältig abgeschrieben werden); 4. Bild-/Video -Website (Urheberrecht verifiziert ist erforderlich). Darüber hinaus sind ein einheitlicher Materialstil, Größenanpassung, Kompressionsverarbeitung und Urheberrechtsschutz wichtige Punkte, die beachtet werden müssen.

Wie wähle ich ein untergeordnetes Element mit dem erstklassigen Namen über CSS aus?

Apr 05, 2025 pm 11:24 PM

Wie wähle ich ein untergeordnetes Element mit dem erstklassigen Namen über CSS aus?

Apr 05, 2025 pm 11:24 PM

Wenn die Anzahl der Elemente nicht festgelegt ist, wählen Sie das erste untergeordnete Element des angegebenen Klassennamens über CSS aus. Bei der Verarbeitung der HTML -Struktur begegnen Sie häufig auf verschiedene Elemente ...

Wie verwendet ich CSS und Flexbox, um das reaktionsschnelle Layout von Bildern und Text in verschiedenen Bildschirmgrößen zu implementieren?

Apr 05, 2025 pm 06:06 PM

Wie verwendet ich CSS und Flexbox, um das reaktionsschnelle Layout von Bildern und Text in verschiedenen Bildschirmgrößen zu implementieren?

Apr 05, 2025 pm 06:06 PM

Implementieren von Responsive Layouts mit CSS, wenn wir Layoutänderungen unter verschiedenen Bildschirmgrößen im Webdesign, CSS ...

Warum wirkt sich negative Margen in einigen Fällen nicht wirksam? Wie löst ich dieses Problem?

Apr 05, 2025 pm 10:18 PM

Warum wirkt sich negative Margen in einigen Fällen nicht wirksam? Wie löst ich dieses Problem?

Apr 05, 2025 pm 10:18 PM

Warum werden negative Margen in einigen Fällen nicht wirksam? Während der Programmierung negative Margen in CSS (negativ ...

Welche Anwendungsszenarien eignen sich für die H5 -Seitenproduktion

Apr 05, 2025 pm 11:36 PM

Welche Anwendungsszenarien eignen sich für die H5 -Seitenproduktion

Apr 05, 2025 pm 11:36 PM

H5 (HTML5) eignet sich für leichte Anwendungen wie Marketingkampagnen, Produktdisplayseiten und Micro-Websites für Unternehmenswerbung. Seine Vorteile liegen in plattformartigen und reichhaltigen Interaktivität, aber seine Einschränkungen liegen in komplexen Interaktionen und Animationen, lokalen Ressourcenzugriff und Offline-Funktionen.

Wie verwendet ich das Formattribut von CSS, um den Anzeigeeffekt von schrittweisen Verkürzung von Text zu erzielen?

Apr 05, 2025 pm 10:54 PM

Wie verwendet ich das Formattribut von CSS, um den Anzeigeeffekt von schrittweisen Verkürzung von Text zu erzielen?

Apr 05, 2025 pm 10:54 PM

Implementieren Sie den Anzeigeeffekt von schrittweisen Verkürzungen von Text im Webdesign, wie Sie einen speziellen Text -Display -Effekt erzielen, um die Textlänge allmählich zu verkürzen? Dieser Effekt ...