Backend-Entwicklung

Backend-Entwicklung

Python-Tutorial

Python-Tutorial

Vollständige Codedemonstration der Dokumentenanalyse mit Python und OCR (Code im Anhang)

Vollständige Codedemonstration der Dokumentenanalyse mit Python und OCR (Code im Anhang)

Vollständige Codedemonstration der Dokumentenanalyse mit Python und OCR (Code im Anhang)

Beim Parsen von Dokumenten werden Daten in Dokumenten untersucht und nützliche Informationen extrahiert. Durch die Automatisierung kann eine Menge manueller Arbeit reduziert werden. Eine beliebte Parsing-Strategie besteht darin, Dokumente in Bilder umzuwandeln und Computer Vision zur Erkennung zu verwenden. Unter Dokumentbildanalyse versteht man die Technologie zur Gewinnung von Informationen aus den Pixeldaten des Bildes eines Dokuments. In manchen Fällen gibt es keine klare Antwort auf die erwarteten Ergebnisse (Text, Bilder, Diagramme, Zahlen, Tabellen, Formeln). ..).

OCR (Optical Character Recognition, optische Zeichenerkennung) ist der Prozess der Erkennung und Extraktion von Text in Bildern durch Computer Vision. Es wurde während des Ersten Weltkriegs erfunden, als der israelische Wissenschaftler Emanuel Goldberg eine Maschine entwickelte, die Zeichen lesen und in Telegraphencodes umwandeln konnte. Mittlerweile hat das Gebiet ein sehr anspruchsvolles Niveau erreicht und vereint Bildverarbeitung, Textlokalisierung, Zeichensegmentierung und Zeichenerkennung. Im Grunde eine Objekterkennungstechnik für Text.

In diesem Artikel werde ich zeigen, wie man OCR zum Parsen von Dokumenten verwendet. Ich zeige einige nützliche Python-Codes, die problemlos in anderen ähnlichen Situationen verwendet werden können (einfach kopieren, einfügen, ausführen), und stelle einen vollständigen Quellcode-Download bereit.

Hier nehmen wir als Beispiel den Jahresabschluss im PDF-Format eines börsennotierten Unternehmens (Link unten).

https://s2.q4cdn.com/470004039/files/doc_financials/2021/q4/_10-K-2021-(As-Filed).pdf

Text in diesem PDF erkennen und extrahieren, Grafiken und Tabellen

Umgebungseinstellungen

Das Ärgerliche an der Dokumentenanalyse ist, dass es so viele Tools für verschiedene Datentypen (Text, Grafiken, Tabellen) gibt und keines davon perfekt funktioniert. Hier sind einige der beliebtesten Methoden und Pakete:

- Verarbeiten Sie Dokumente als Text: Verwenden Sie PyPDF2 zum Extrahieren von Text, verwenden Sie Camelot oder TabulaPy zum Extrahieren von Tabellen und verwenden Sie PyMuPDF zum Extrahieren von Grafiken.

- Dokumente in Bilder konvertieren (OCR): Verwenden Sie pdf2image zur Konvertierung, PyTesseract und viele andere Bibliotheken zum Extrahieren von Daten oder verwenden Sie einfach LayoutParser.

Vielleicht fragen Sie sich: „Warum nicht die PDF-Datei direkt verarbeiten, sondern die Seiten in Bilder konvertieren?“ Der Hauptnachteil dieser Strategie ist das Kodierungsproblem: Dokumente können in mehreren Kodierungen vorliegen (z. B. UTF-8, ASCII, Unicode), sodass die Konvertierung in Text zu Datenverlust führen kann. Um dieses Problem zu vermeiden, verwende ich OCR und konvertiere die Seite mit pdf2image in ein Bild. Beachten Sie, dass die PDF-Rendering-Bibliothek Poppler erforderlich ist.

# with pip pip install python-poppler # with conda conda install -c conda-forge poppler

Sie können die Datei einfach lesen:

# READ AS IMAGE

import pdf2imagedoc = pdf2image.convert_from_path("doc_apple.pdf")

len(doc) #<-- check num pages

doc[0] #<-- visualize a pageGenau wie in unserem Screenshot können Sie den folgenden Code verwenden, wenn Sie das Seitenbild lokal speichern möchten:

# Save imgs import osfolder = "doc" if folder not in os.listdir(): os.makedirs(folder)p = 1 for page in doc: image_name = "page_"+str(p)+".jpg" page.save(os.path.join(folder, image_name), "JPEG") p = p+1

Abschließend müssen wir die CV-Engine einrichten, die wir verwenden werden verwenden. LayoutParser scheint das erste Allzweckpaket für OCR zu sein, das auf Deep Learning basiert. Zur Erfüllung dieser Aufgabe werden zwei bekannte Modelle verwendet:

Erkennung: Facebooks fortschrittlichste Objekterkennungsbibliothek (hier wird die zweite Version Detectron2 verwendet).

pip install layoutparser torchvision && pip install "git+https://github.com/facebookresearch/detectron2.git@v0.5#egg=detectron2"

Tesseract: Das bekannteste OCR-System, 1985 von Hewlett-Packard entwickelt und derzeit von Google entwickelt.

pip install "layoutparser[ocr]"

Jetzt können Sie das OCR-Programm zur Informationserkennung und -extraktion starten.

import layoutparser as lp import cv2 import numpy as np import io import pandas as pd import matplotlib.pyplot as plt

Erkennung

(Ziel-)Erkennung ist der Prozess, Informationselemente in einem Bild zu finden und sie dann mit einem rechteckigen Rahmen zu umgeben. Beim Parsen von Dokumenten handelt es sich bei den Informationen um Titel, Texte, Grafiken, Tabellen ...

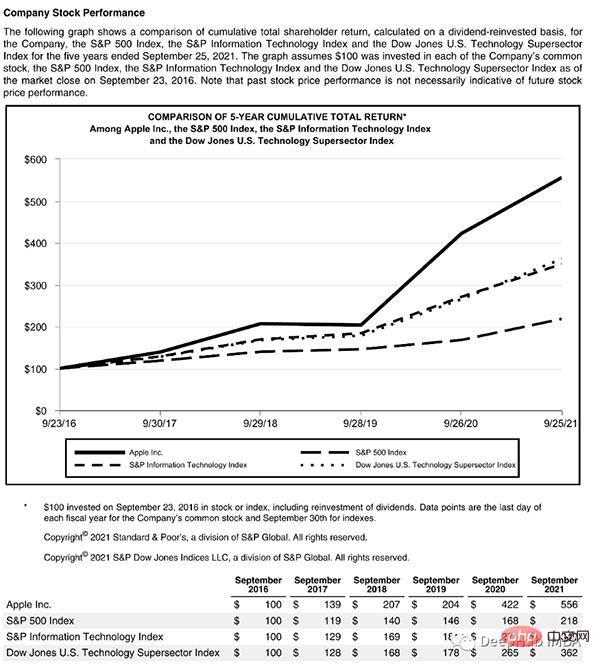

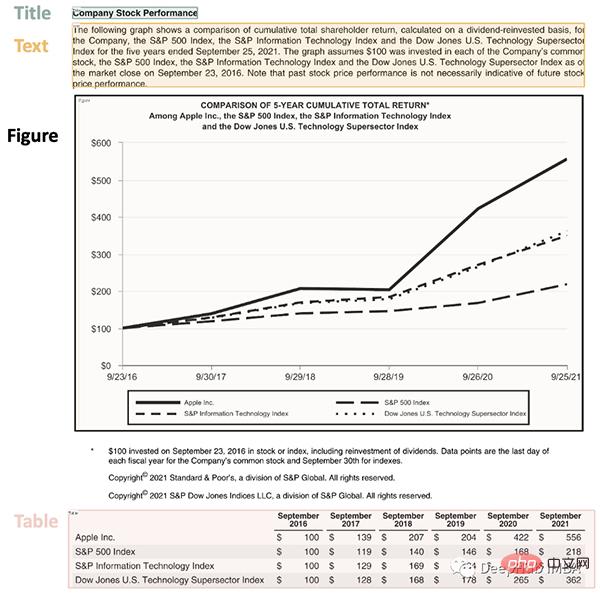

Schauen wir uns eine komplexe Seite an, die einige Dinge enthält:

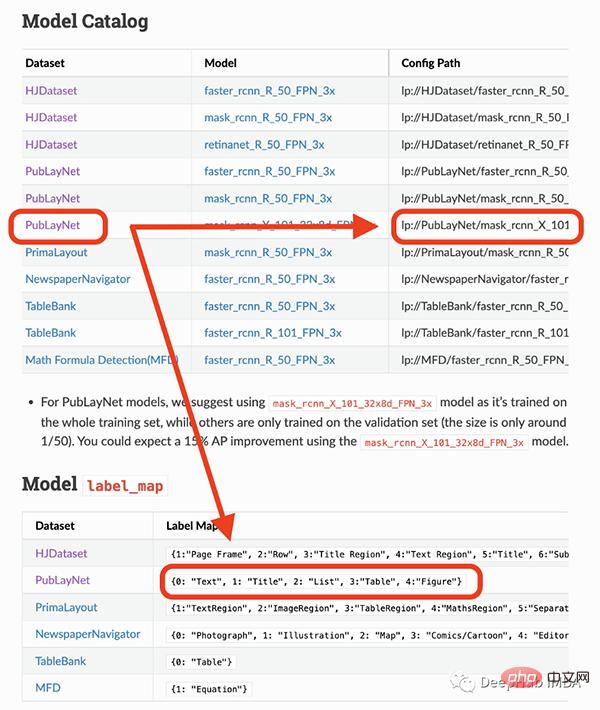

Diese Seite beginnt mit einem Titel und hat einen Textblock. dann ein Diagramm und eine Tabelle, daher benötigen wir ein trainiertes Modell, um diese Objekte zu erkennen. Glücklicherweise ist Detectron dazu in der Lage, wir müssen hier nur ein Modell auswählen und seinen Pfad im Code angeben.

Das Modell, das ich verwenden werde, kann nur 4 Objekte erkennen (Text, Titel, Liste, Tabelle, Grafik). Wenn Sie daher andere Dinge (wie Gleichungen) identifizieren müssen, müssen Sie andere Modelle verwenden.

## load pre-trained model

model = lp.Detectron2LayoutModel(

"lp://PubLayNet/mask_rcnn_X_101_32x8d_FPN_3x/config",

extra_config=["MODEL.ROI_HEADS.SCORE_THRESH_TEST", 0.8],

label_map={0:"Text", 1:"Title", 2:"List", 3:"Table", 4:"Figure"})

## turn img into array

i = 21

img = np.asarray(doc[i])

## predict

detected = model.detect(img)

## plot

lp.draw_box(img, detected, box_width=5, box_alpha=0.2,

show_element_type=True)

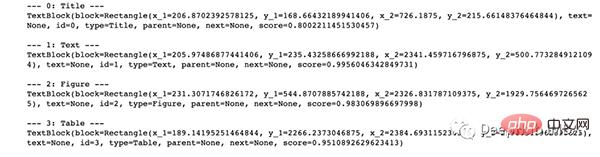

结果包含每个检测到的布局的细节,例如边界框的坐标。根据页面上显示的顺序对输出进行排序是很有用的:

## sort

new_detected = detected.sort(key=lambda x: x.coordinates[1])

## assign ids

detected = lp.Layout([block.set(id=idx) for idx,block in

enumerate(new_detected)])## check

for block in detected:

print("---", str(block.id)+":", block.type, "---")

print(block, end='nn')

完成OCR的下一步是正确提取检测到内容中的有用信息。

提取

我们已经对图像完成了分割,然后就需要使用另外一个模型处理分段的图像,并将提取的输出保存到字典中。

由于有不同类型的输出(文本,标题,图形,表格),所以这里准备了一个函数用来显示结果。

'''

{'0-Title': '...',

'1-Text': '...',

'2-Figure': array([[ [0,0,0], ...]]),

'3-Table': pd.DataFrame,

}

'''

def parse_doc(dic):

for k,v in dic.items():

if "Title" in k:

print('x1b[1;31m'+ v +'x1b[0m')

elif "Figure" in k:

plt.figure(figsize=(10,5))

plt.imshow(v)

plt.show()

else:

print(v)

print(" ")首先看看文字:

# load model

model = lp.TesseractAgent(languages='eng')

dic_predicted = {}

for block in [block for block in detected if block.type in ["Title","Text"]]:

## segmentation

segmented = block.pad(left=15, right=15, top=5,

bottom=5).crop_image(img)

## extraction

extracted = model.detect(segmented)

## save

dic_predicted[str(block.id)+"-"+block.type] =

extracted.replace('n',' ').strip()

# check

parse_doc(dic_predicted)

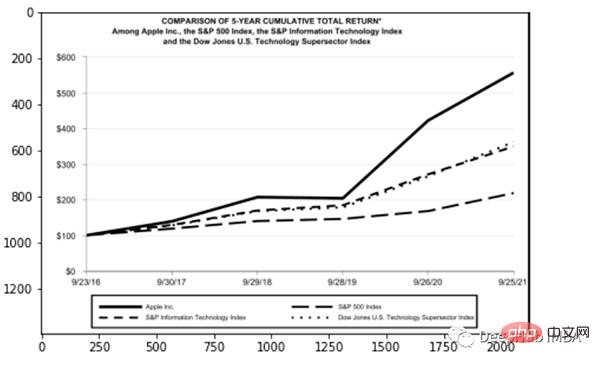

再看看图形报表

for block in [block for block in detected if block.type == "Figure"]: ## segmentation segmented = block.pad(left=15, right=15, top=5, bottom=5).crop_image(img) ## save dic_predicted[str(block.id)+"-"+block.type] = segmented # check parse_doc(dic_predicted)

上面两个看着很不错,那是因为这两种类型相对简单,但是表格就要复杂得多。尤其是我们上看看到的的这个,因为它的行和列都是进行了合并后产生的。

for block in [block for block in detected if block.type == "Table"]: ## segmentation segmented = block.pad(left=15, right=15, top=5, bottom=5).crop_image(img) ## extraction extracted = model.detect(segmented) ## save dic_predicted[str(block.id)+"-"+block.type] = pd.read_csv( io.StringIO(extracted) ) # check parse_doc(dic_predicted)

正如我们的预料提取的表格不是很好。好在Python有专门处理表格的包,我们可以直接处理而不将其转换为图像。这里使用TabulaPy 包:

import tabula

tables = tabula.read_pdf("doc_apple.pdf", pages=i+1)

tables[0]

结果要好一些,但是名称仍然错了,但是效果要比直接OCR好的多。

总结

本文是一个简单教程,演示了如何使用OCR进行文档解析。使用Layoutpars软件包进行了整个检测和提取过程。并展示了如何处理PDF文档中的文本,数字和表格。

Das obige ist der detaillierte Inhalt vonVollständige Codedemonstration der Dokumentenanalyse mit Python und OCR (Code im Anhang). Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

Muss MySQL bezahlen?

Apr 08, 2025 pm 05:36 PM

MySQL hat eine kostenlose Community -Version und eine kostenpflichtige Enterprise -Version. Die Community -Version kann kostenlos verwendet und geändert werden, die Unterstützung ist jedoch begrenzt und für Anwendungen mit geringen Stabilitätsanforderungen und starken technischen Funktionen geeignet. Die Enterprise Edition bietet umfassende kommerzielle Unterstützung für Anwendungen, die eine stabile, zuverlässige Hochleistungsdatenbank erfordern und bereit sind, Unterstützung zu bezahlen. Zu den Faktoren, die bei der Auswahl einer Version berücksichtigt werden, gehören Kritikalität, Budgetierung und technische Fähigkeiten von Anwendungen. Es gibt keine perfekte Option, nur die am besten geeignete Option, und Sie müssen die spezifische Situation sorgfältig auswählen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Die MySQL-Datenbankleistung Optimierungshandbuch In ressourcenintensiven Anwendungen spielt die MySQL-Datenbank eine entscheidende Rolle und ist für die Verwaltung massiver Transaktionen verantwortlich. Mit der Erweiterung der Anwendung werden jedoch die Datenbankleistung Engpässe häufig zu einer Einschränkung. In diesem Artikel werden eine Reihe effektiver Strategien zur Leistungsoptimierung von MySQL -Leistung untersucht, um sicherzustellen, dass Ihre Anwendung unter hohen Lasten effizient und reaktionsschnell bleibt. Wir werden tatsächliche Fälle kombinieren, um eingehende Schlüsseltechnologien wie Indexierung, Abfrageoptimierung, Datenbankdesign und Caching zu erklären. 1. Das Design der Datenbankarchitektur und die optimierte Datenbankarchitektur sind der Eckpfeiler der MySQL -Leistungsoptimierung. Hier sind einige Kernprinzipien: Die Auswahl des richtigen Datentyps und die Auswahl des kleinsten Datentyps, der den Anforderungen entspricht, kann nicht nur Speicherplatz speichern, sondern auch die Datenverarbeitungsgeschwindigkeit verbessern.

Hadidb: Eine leichte, horizontal skalierbare Datenbank in Python

Apr 08, 2025 pm 06:12 PM

Hadidb: Eine leichte, horizontal skalierbare Datenbank in Python

Apr 08, 2025 pm 06:12 PM

Hadidb: Eine leichte, hochrangige skalierbare Python-Datenbank Hadidb (HadIDB) ist eine leichte Datenbank in Python mit einem hohen Maß an Skalierbarkeit. Installieren Sie HadIDB mithilfe der PIP -Installation: PipinstallHadIDB -Benutzerverwaltung erstellen Benutzer: createUser (), um einen neuen Benutzer zu erstellen. Die Authentication () -Methode authentifiziert die Identität des Benutzers. fromHadidb.operationImportUseruser_obj = user ("admin", "admin") user_obj.

Braucht MySQL das Internet?

Apr 08, 2025 pm 02:18 PM

Braucht MySQL das Internet?

Apr 08, 2025 pm 02:18 PM

MySQL kann ohne Netzwerkverbindungen für die grundlegende Datenspeicherung und -verwaltung ausgeführt werden. Für die Interaktion mit anderen Systemen, Remotezugriff oder Verwendung erweiterte Funktionen wie Replikation und Clustering ist jedoch eine Netzwerkverbindung erforderlich. Darüber hinaus sind Sicherheitsmaßnahmen (wie Firewalls), Leistungsoptimierung (Wählen Sie die richtige Netzwerkverbindung) und die Datensicherung für die Verbindung zum Internet von entscheidender Bedeutung.

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Es ist unmöglich, das MongoDB -Passwort direkt über Navicat anzuzeigen, da es als Hash -Werte gespeichert ist. So rufen Sie verlorene Passwörter ab: 1. Passwörter zurücksetzen; 2. Überprüfen Sie die Konfigurationsdateien (können Hash -Werte enthalten). 3. Überprüfen Sie Codes (May Hardcode -Passwörter).

Kann sich MySQL Workbench mit Mariadb verbinden?

Apr 08, 2025 pm 02:33 PM

Kann sich MySQL Workbench mit Mariadb verbinden?

Apr 08, 2025 pm 02:33 PM

MySQL Workbench kann eine Verbindung zu MariADB herstellen, vorausgesetzt, die Konfiguration ist korrekt. Wählen Sie zuerst "Mariadb" als Anschlusstyp. Stellen Sie in der Verbindungskonfiguration Host, Port, Benutzer, Kennwort und Datenbank korrekt ein. Überprüfen Sie beim Testen der Verbindung, ob der Mariadb -Dienst gestartet wird, ob der Benutzername und das Passwort korrekt sind, ob die Portnummer korrekt ist, ob die Firewall Verbindungen zulässt und ob die Datenbank vorhanden ist. Verwenden Sie in fortschrittlicher Verwendung die Verbindungspooling -Technologie, um die Leistung zu optimieren. Zu den häufigen Fehlern gehören unzureichende Berechtigungen, Probleme mit Netzwerkverbindung usw. Bei Debugging -Fehlern, sorgfältige Analyse von Fehlerinformationen und verwenden Sie Debugging -Tools. Optimierung der Netzwerkkonfiguration kann die Leistung verbessern

Benötigt MySQL einen Server?

Apr 08, 2025 pm 02:12 PM

Benötigt MySQL einen Server?

Apr 08, 2025 pm 02:12 PM

Für Produktionsumgebungen ist in der Regel ein Server erforderlich, um MySQL auszuführen, aus Gründen, einschließlich Leistung, Zuverlässigkeit, Sicherheit und Skalierbarkeit. Server haben normalerweise leistungsstärkere Hardware, redundante Konfigurationen und strengere Sicherheitsmaßnahmen. Bei kleinen Anwendungen mit niedriger Last kann MySQL auf lokalen Maschinen ausgeführt werden, aber Ressourcenverbrauch, Sicherheitsrisiken und Wartungskosten müssen sorgfältig berücksichtigt werden. Für eine größere Zuverlässigkeit und Sicherheit sollte MySQL auf Cloud oder anderen Servern bereitgestellt werden. Die Auswahl der entsprechenden Serverkonfiguration erfordert eine Bewertung basierend auf Anwendungslast und Datenvolumen.