Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

DetectGPT: Maschinengenerierte Zero-Shot-Texterkennung mithilfe probabilistischer Krümmung

DetectGPT: Maschinengenerierte Zero-Shot-Texterkennung mithilfe probabilistischer Krümmung

DetectGPT: Maschinengenerierte Zero-Shot-Texterkennung mithilfe probabilistischer Krümmung

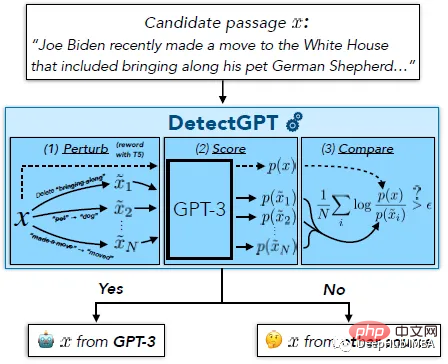

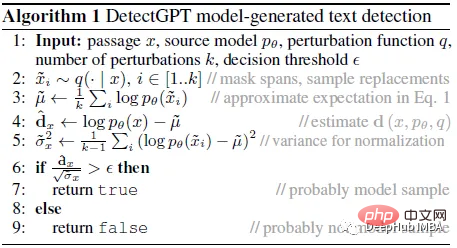

Der Zweck von DetectGPT besteht darin, festzustellen, ob ein Text von einem bestimmten LM wie GPT-3 generiert wurde. Um Absatz x zu klassifizieren, erzeugt DetectGPT zunächst eine kleine Störung für Absatz ~xi unter Verwendung eines gängigen vorab trainierten Modells (z. B. T5). DetectGPT vergleicht dann die logarithmische Wahrscheinlichkeit der ursprünglichen Stichprobe x mit jeder gestörten Stichprobe ~xi. Wenn das durchschnittliche Log-Verhältnis hoch ist, stammt die Stichprobe wahrscheinlich aus dem Quellmodell.

ChatGPT ist ein heißes Thema. Es gibt eine anhaltende Diskussion darüber, ob es möglich ist, zu erkennen, dass ein Artikel von einem großen Sprachmodell (LLM) generiert wurde. DetectGPT definiert ein neues krümmungsbasiertes Kriterium zur Beurteilung, ob aus einem bestimmten LLM generiert werden soll. Für DetectGPT ist es nicht erforderlich, einen separaten Klassifikator zu trainieren, einen Datensatz realer oder generierter Passagen zu sammeln oder den generierten Text explizit mit Wasserzeichen zu versehen. Es verwendet nur Log-Wahrscheinlichkeiten, die vom interessierenden Modell berechnet wurden, und zufällige Artikelstörungen aus einem anderen vorab trainierten Allzweck-Sprachmodell (z. B. T5).

1. DetectGPT: Zufällige Permutationen und Annahmen

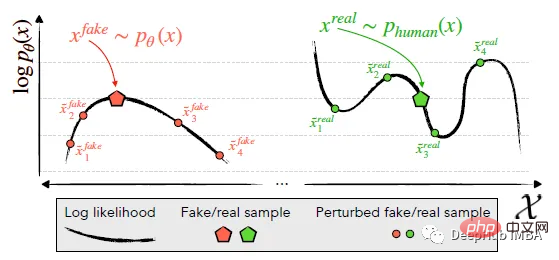

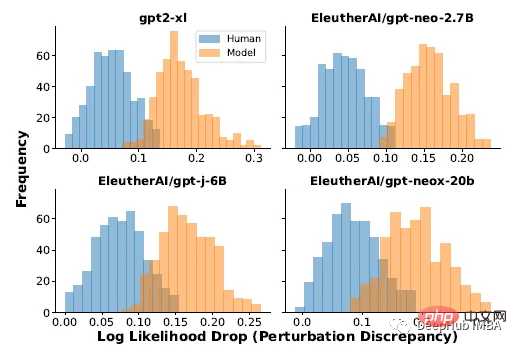

identifiziert und nutzt die Tendenz maschinengenerierter Kanäle x~pθ (links), im negativen Krümmungsbereich von logp (x) zu liegen, wo benachbarte Proben einen niedrigeren Durchschnitt haben Modellprotokollwahrscheinlichkeit. Im Gegensatz dazu neigt der von Menschen geschriebene Text x~preal(.) (rechts) dazu, keine Bereiche mit einer signifikanten negativen Log-Wahrscheinlichkeitskrümmung zu besetzen.

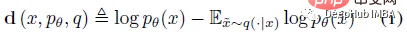

DetectGPT basiert auf der Annahme, dass Stichproben aus dem Quellmodell pθ normalerweise im negativen Krümmungsbereich der pθ-Log-Wahrscheinlichkeitsfunktion liegen, was sich vom menschlichen Text unterscheidet. Wenn wir eine kleine Störung auf ein Textstück x~pθ anwenden, was ~x ergibt, sollte die Anzahl der maschinengenerierten Stichproben log pθ(x) - log pθ(~x) im Vergleich zu von Menschen geschriebenem Text relativ groß sein. Betrachten Sie unter dieser Annahme zunächst eine Störungsfunktion q(.|x), die eine Verteilung über ~x liefert, eine leicht modifizierte Version von x mit ähnlicher Bedeutung (normalerweise betrachten Sie einen groben Text x mit Absatzlänge). Beispielsweise könnte q(.|x) das Ergebnis der einfachen Aufforderung an einen Menschen sein, einen der Sätze für x umzuschreiben und dabei die Bedeutung von x beizubehalten. Unter Verwendung des Konzepts der Störungsfunktion kann die Störungsdifferenz d (x; pθ, q) definiert werden:

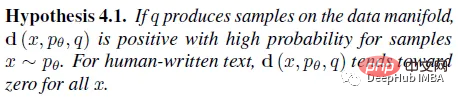

Daher lautet die folgende Annahme 4.1:

Wenn q(.|x ) Mit Proben aus einem maskenfüllenden Modell (z. B. T5) und nicht mit menschlichen Umschreibungen kann Hypothese 4.1 auf automatisierte und skalierbare Weise empirisch getestet werden. 2. DetectGPT: Automatischer Test Daten unter Verwendung von 500 Nachrichtenartikeln aus dem XSum-Datensatz. Verwendung der Ausgabe von vier verschiedenen LMs, wenn in XSum nach den ersten 30 Token jedes Artikels gefragt wird. Die Störung wird mithilfe von T5-3B angewendet, wobei eine zufällig ausgewählte Spanne von 2 Wörtern maskiert wird, bis 15 % der Wörter im Artikel maskiert sind. Die Erwartung in Gleichung (1) oben wird durch 100 Stichproben in T5 angenähert.

Die oben genannten experimentellen Ergebnisse zeigen, dass es einen signifikanten Unterschied in der Verteilung der Störungsunterschiede zwischen von Menschen verfassten Artikeln und Modellproben gibt. Modellproben weisen häufig große Störungsunterschiede auf. Basierend auf diesen Ergebnissen ist es möglich, durch einfache Schwellenwertbildung der Störungsdifferenz zu erkennen, ob ein Textstück von Modell p generiert wurde.

Die Normalisierung der Störungsunterschiede durch die Standardabweichung der Beobachtungen, die zur Schätzung von E~x q(.|x) log p (~x) verwendet werden, sorgt für eine bessere Erkennung und erhöht typischerweise den AUROC um etwa 0,020, sodass in Experimenten eine normalisierte Version des Störungsdifferenz wird in verwendet.

Pseudocode des Erkennungsprozesses von DetectGPT

Störungsdifferenz kann nützlich sein, was es misst, kann nicht klar erklärt werden, daher verwendet der Autor die Krümmung, um es im nächsten Abschnitt zu erklären.

3. Interpretieren Sie die Störungsdifferenz als Krümmung

Die Störungsdifferenz wird als Maß für die lokale Krümmung der logarithmischen Wahrscheinlichkeitsfunktion in der Nähe des Kandidatendurchgangs angenähert, genauer gesagt ist sie proportional zur negativen Spur der Hesse-Matrix des Log-Wahrscheinlichkeitsfunktion.

Dieser Abschnitt hat viel Inhalt, daher werde ich ihn hier nicht im Detail erklären. Wenn Sie interessiert sind, können Sie das Originalpapier lesen, das grob wie folgt zusammengefasst ist:

Die Stichprobe im semantischen Raum stellt sicher, dass alle Stichproben nahe an der Datenmannigfaltigkeit bleiben, da erwartet wird, dass die Log-Wahrscheinlichkeit immer abnimmt, wenn Störungsmarker zufällig hinzugefügt werden. Das Ziel kann also als ungefähre Einschränkung der Krümmung auf der Datenmannigfaltigkeit interpretiert werden.

4. Ergebnisanzeige

Maschinengenerierte Texterkennung ohne Stichprobe

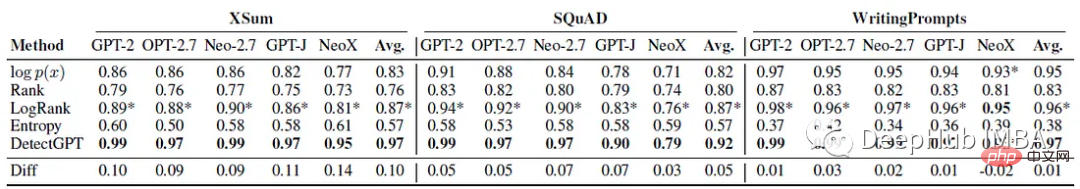

verwendet in Pro Versuch werden 150 bis 500 Beispiele ausgewertet. Maschinengenerierter Text wird generiert, indem die ersten 30 Token echten Textes abgefragt werden. Verwenden Sie AUROC, um die Leistung zu bewerten.

Es ist ersichtlich, dass DetectGPT die durchschnittliche Erkennungsgenauigkeit von XSum-Geschichten (AUROC um 0,1 erhöht) und SQuAD-Wikipedia-Kontext (AUROC um 0,05 erhöht) maximiert.

Für 14 von 15 Datensatz- und Modellkombinationen bietet DetectGPT die genaueste Erkennungsleistung mit einer durchschnittlichen Verbesserung des AUROC von 0,06.

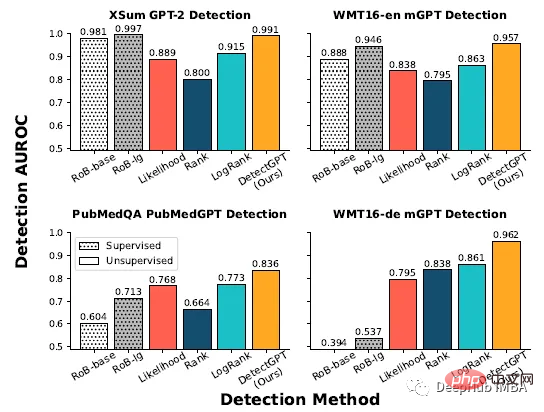

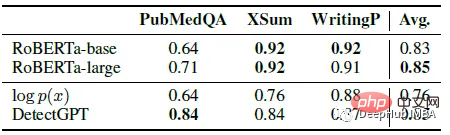

Vergleich mit überwachten Detektoren

Überwacht trainiert an großen Datensätzen von realem und generiertem Text. Das maschinengenerierte Texterkennungsmodell funktioniert genauso gut oder besser als DetectGPT für In-Distribution-Text (obere Zeile). Die Zero-Shot-Methode wird auf neue Domänen (untere Zeile) wie medizinische Texte von PubMed und deutsche Nachrichtendaten in WMT16 angewendet.

Ausgewertet anhand von 200 Stichproben aus jedem Datensatz, schneidet der überwachte Detektor bei In-Distribution-Daten wie englischen Nachrichten ähnlich ab wie DetectGPT, schneidet jedoch bei englischsprachigem wissenschaftlichem Schreiben für den Null-Stichproben-Ansatz deutlich schlechter ab , was in der deutschen Schrift völlig versagt. Der durchschnittliche AUROC von GPT-3 ist vergleichbar mit dem von überwachten Modellen, die speziell für die Erkennung maschinell generierten Textes trainiert wurden.

150 Beispiele wurden aus PubMedQA-, XSum- und Writingprompt-Datensätzen extrahiert. Zwei vorab trainierte Roberta-basierte Detektormodelle werden mit DetectGPT und der probabilistischen Schwellenwertbasislinie verglichen. DetectGPT kann Erkennungen bereitstellen, die mit leistungsfähigeren überwachten Modellen konkurrieren.

In diesem Teil geht es darum, zu prüfen, ob der Detektor von Menschen bearbeitete maschinelle Texte erkennen kann. generierter Texttext. Die manuelle Überarbeitung wurde simuliert, indem 5 Wortspannen des Textes durch Beispiele von T5–3B ersetzt wurden, bis r % des Textes ersetzt waren. DetectGPT ist in der Lage, den Erkennungs-AUROC über 0,8 aufrechtzuerhalten, obwohl fast ein Viertel des Textes in der Modellprobe ersetzt wurde. DetectGPT zeigt über alle Revisionsstufen hinweg die stärkste Erkennungsleistung.

Das obige ist der detaillierte Inhalt vonDetectGPT: Maschinengenerierte Zero-Shot-Texterkennung mithilfe probabilistischer Krümmung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1677

1677

14

14

1431

1431

52

52

1334

1334

25

25

1280

1280

29

29

1257

1257

24

24

Bildklassifizierung mit Fow-Shot-Learning mit PyTorch

Apr 09, 2023 am 10:51 AM

Bildklassifizierung mit Fow-Shot-Learning mit PyTorch

Apr 09, 2023 am 10:51 AM

In den letzten Jahren haben Deep-Learning-basierte Modelle bei Aufgaben wie der Objekterkennung und Bilderkennung gute Leistungen erbracht. Bei anspruchsvollen Bildklassifizierungsdatensätzen wie ImageNet, das 1.000 verschiedene Objektklassifizierungen enthält, übertreffen einige Modelle mittlerweile das menschliche Niveau. Diese Modelle basieren jedoch auf einem überwachten Trainingsprozess, sie werden erheblich von der Verfügbarkeit gekennzeichneter Trainingsdaten beeinflusst und die Klassen, die die Modelle erkennen können, sind auf die Klassen beschränkt, auf denen sie trainiert wurden. Da während des Trainings nicht genügend beschriftete Bilder für alle Klassen vorhanden sind, sind diese Modelle in realen Umgebungen möglicherweise weniger nützlich. Und wir möchten, dass das Modell Klassen erkennen kann, die es während des Trainings nicht gesehen hat, da es fast unmöglich ist, auf Bildern aller potenziellen Objekte zu trainieren. Wir werden aus einigen Beispielen lernen

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

Wie teile ich einen Datensatz richtig auf? Zusammenfassung von drei gängigen Methoden

Apr 08, 2023 pm 06:51 PM

Wie teile ich einen Datensatz richtig auf? Zusammenfassung von drei gängigen Methoden

Apr 08, 2023 pm 06:51 PM

Die Zerlegung des Datensatzes in einen Trainingssatz hilft uns, das Modell zu verstehen, was wichtig für die Verallgemeinerung des Modells auf neue, unsichtbare Daten ist. Ein Modell lässt sich möglicherweise nicht gut auf neue, noch nicht sichtbare Daten verallgemeinern, wenn es überangepasst ist. Daher können keine guten Vorhersagen getroffen werden. Eine geeignete Validierungsstrategie ist der erste Schritt zur erfolgreichen Erstellung guter Vorhersagen und zur Nutzung des Geschäftswerts von KI-Modellen. In diesem Artikel wurden einige gängige Strategien zur Datenaufteilung zusammengestellt. Eine einfache Trainings- und Testaufteilung unterteilt den Datensatz in Trainings- und Validierungsteile, wobei 80 % Training und 20 % Validierung erfolgen. Sie können dies mithilfe der Zufallsstichprobe von Scikit tun. Zunächst muss der Zufallsstartwert festgelegt werden, da sonst die gleiche Datenaufteilung nicht verglichen werden kann und die Ergebnisse beim Debuggen nicht reproduziert werden können. Wenn der Datensatz

Google AI-Video ist wieder großartig! VideoPrism, ein universeller visueller All-in-One-Encoder, aktualisiert 30 SOTA-Leistungsfunktionen

Feb 26, 2024 am 09:58 AM

Google AI-Video ist wieder großartig! VideoPrism, ein universeller visueller All-in-One-Encoder, aktualisiert 30 SOTA-Leistungsfunktionen

Feb 26, 2024 am 09:58 AM

Nachdem das KI-Videomodell Sora populär wurde, traten große Unternehmen wie Meta und Google zurück, um Forschung zu betreiben und OpenAI nachzuholen. Kürzlich haben Forscher des Google-Teams einen universellen Video-Encoder vorgeschlagen – VideoPrism. Es kann verschiedene Videoverständnisaufgaben über ein einziges eingefrorenes Modell bewältigen. Adresse des Bildpapiers: https://arxiv.org/pdf/2402.13217.pdf VideoPrism kann beispielsweise die Person, die im folgenden Video Kerzen ausbläst, klassifizieren und lokalisieren. Bild-Video-Text-Abruf: Basierend auf dem Textinhalt kann der entsprechende Inhalt im Video abgerufen werden. Beschreiben Sie als weiteres Beispiel das folgende Video: Ein kleines Mädchen spielt mit Bauklötzen. Fragen und Antworten zur Qualitätssicherung sind ebenfalls verfügbar.

Implementierung von OpenAI CLIP für benutzerdefinierte Datensätze

Sep 14, 2023 am 11:57 AM

Implementierung von OpenAI CLIP für benutzerdefinierte Datensätze

Sep 14, 2023 am 11:57 AM

Im Januar 2021 kündigte OpenAI zwei neue Modelle an: DALL-E und CLIP. Bei beiden Modellen handelt es sich um multimodale Modelle, die Text und Bilder auf irgendeine Weise verbinden. Der vollständige Name von CLIP lautet Contrastive Language-Image Pre-training (ContrastiveLanguage-ImagePre-training), eine Vortrainingsmethode, die auf kontrastierenden Text-Bild-Paaren basiert. Warum CLIP einführen? Denn die derzeit beliebte StableDiffusion ist kein einzelnes Modell, sondern besteht aus mehreren Modellen. Eine der Schlüsselkomponenten ist der Text-Encoder, der zur Codierung der Texteingabe des Benutzers verwendet wird. Dieser Text-Encoder ist der Text-Encoder CL im CLIP-Modell.

Vollständiges Codebeispiel für das parallele PyTorch-Training DistributedDataParallel

Apr 10, 2023 pm 08:51 PM

Vollständiges Codebeispiel für das parallele PyTorch-Training DistributedDataParallel

Apr 10, 2023 pm 08:51 PM

Das Problem, große tiefe neuronale Netze (DNN) mithilfe großer Datensätze zu trainieren, ist eine große Herausforderung im Bereich Deep Learning. Mit zunehmender DNN- und Datensatzgröße steigen auch die Rechen- und Speicheranforderungen für das Training dieser Modelle. Dies macht es schwierig oder sogar unmöglich, diese Modelle auf einer einzelnen Maschine mit begrenzten Rechenressourcen zu trainieren. Zu den größten Herausforderungen beim Training großer DNNs mithilfe großer Datensätze gehören: Lange Trainingszeit: Der Trainingsprozess kann je nach Komplexität des Modells und Größe des Datensatzes Wochen oder sogar Monate dauern. Speicherbeschränkungen: Große DNNs benötigen möglicherweise viel Speicher, um alle Modellparameter, Verläufe und Zwischenaktivierungen während des Trainings zu speichern. Dies kann zu Speichermangel führen und die Möglichkeiten des Trainings auf einem einzelnen Computer einschränken.

Berechnung der CO2-Kosten künstlicher Intelligenz

Apr 12, 2023 am 08:52 AM

Berechnung der CO2-Kosten künstlicher Intelligenz

Apr 12, 2023 am 08:52 AM

Wenn Sie auf der Suche nach interessanten Themen sind, wird Sie Künstliche Intelligenz (KI) nicht enttäuschen. Künstliche Intelligenz umfasst eine Reihe leistungsstarker, umwerfender statistischer Algorithmen, die Schach spielen, schlampige Handschriften entziffern, Sprache verstehen, Satellitenbilder klassifizieren und vieles mehr können. Die Verfügbarkeit riesiger Datensätze zum Trainieren von Modellen für maschinelles Lernen war einer der Schlüsselfaktoren für den Erfolg der künstlichen Intelligenz. Aber all diese Rechenarbeit ist nicht kostenlos. Einige KI-Experten sind zunehmend besorgt über die Umweltauswirkungen, die mit der Entwicklung neuer Algorithmen einhergehen, und die Debatte hat neue Ideen hervorgebracht, wie der CO2-Fußabdruck von KI verringert werden kann, indem Maschinen effizienter lernen. Zurück auf der Erde Um ins Detail zu gehen, müssen wir zunächst die Tausenden von Rechenzentren (über die ganze Welt verstreut) betrachten, die unsere Rechenanfragen rund um die Uhr bearbeiten.

Modulares MoE wird zum Grundmodell für visuelles Multitasking-Lernen

Apr 13, 2023 pm 12:40 PM

Modulares MoE wird zum Grundmodell für visuelles Multitasking-Lernen

Apr 13, 2023 pm 12:40 PM

Multitasking-Lernen (MTL) stellt viele Herausforderungen dar, da die Gradienten zwischen verschiedenen Aufgaben widersprüchlich sein können. Um die Korrelation zwischen Aufgaben auszunutzen, führen die Autoren das Mod-Squad-Modell ein, ein modulares Modell, das aus mehreren Experten besteht. Das Modell kann die Zuordnung von Aufgaben und Experten flexibel optimieren und einige Experten für die Aufgabe auswählen. Das Modell ermöglicht, dass jeder Experte nur einem Teil der Aufgaben und jede Aufgabe nur einem Teil der Experten entspricht, wodurch die Nutzung der positiven Verbindungen zwischen Aufgaben maximiert wird. Mod-Squad integriert Mixture of Experts (MoE)-Schichten in das Vision Transformer-Modell und führt eine neue Verlustfunktion ein, die spärliche, aber starke Abhängigkeiten zwischen Experten und Aufgaben fördert. Auch