Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Fast zehntausend Menschen sahen sich Hintons neueste Rede an: Der Vortrag „Forward Neural Network Training Algorithm' wurde veröffentlicht

Fast zehntausend Menschen sahen sich Hintons neueste Rede an: Der Vortrag „Forward Neural Network Training Algorithm' wurde veröffentlicht

Fast zehntausend Menschen sahen sich Hintons neueste Rede an: Der Vortrag „Forward Neural Network Training Algorithm' wurde veröffentlicht

Die NeurIPS 2022-Konferenz ist in vollem Gange. Experten und Wissenschaftler aus allen Bereichen kommunizieren und diskutieren viele unterteilte Bereiche wie Deep Learning, Computer Vision, groß angelegtes maschinelles Lernen, Lerntheorie, Optimierung und Sparse-Theorie.

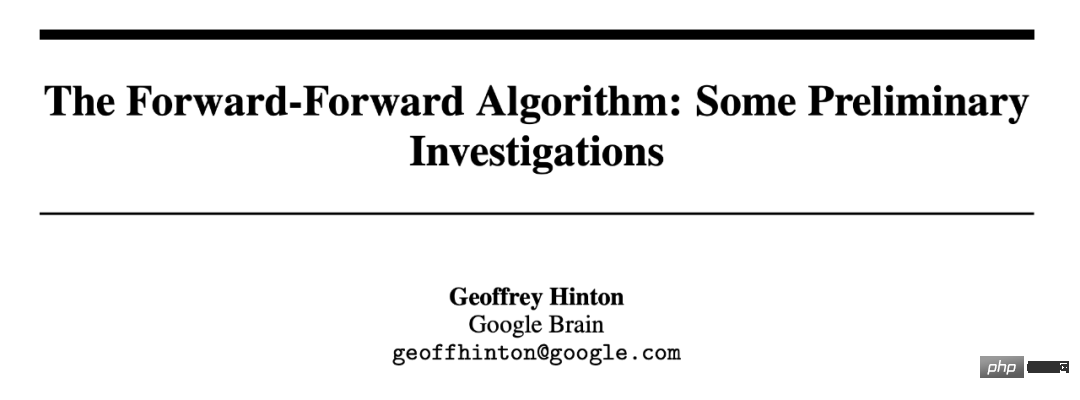

Bei dem Treffen wurde der Turing-Award-Gewinner und Deep-Learning-Pionier Geoffrey Hinton eingeladen, eine Rede in Anerkennung der Arbeit „ImageNet Classification with Deep Convolutional Neural Networks“ zu halten, die er gemeinsam mit seinen Doktoranden Alex Krizhevsky und Ilya verfasst hatte Sutskever wurde vor zehn Jahren für seine „enorme Wirkung“ auf diesem Gebiet mit dem Time-testing Award ausgezeichnet. Diese 2012 veröffentlichte Arbeit war das erste Mal, dass ein Faltungs-Neuronales Netzwerk im ImageNet-Bilderkennungswettbewerb eine Leistung auf menschlichem Niveau erreichte, und es war ein Schlüsselereignis, das die dritte Welle der künstlichen Intelligenz einleitete.

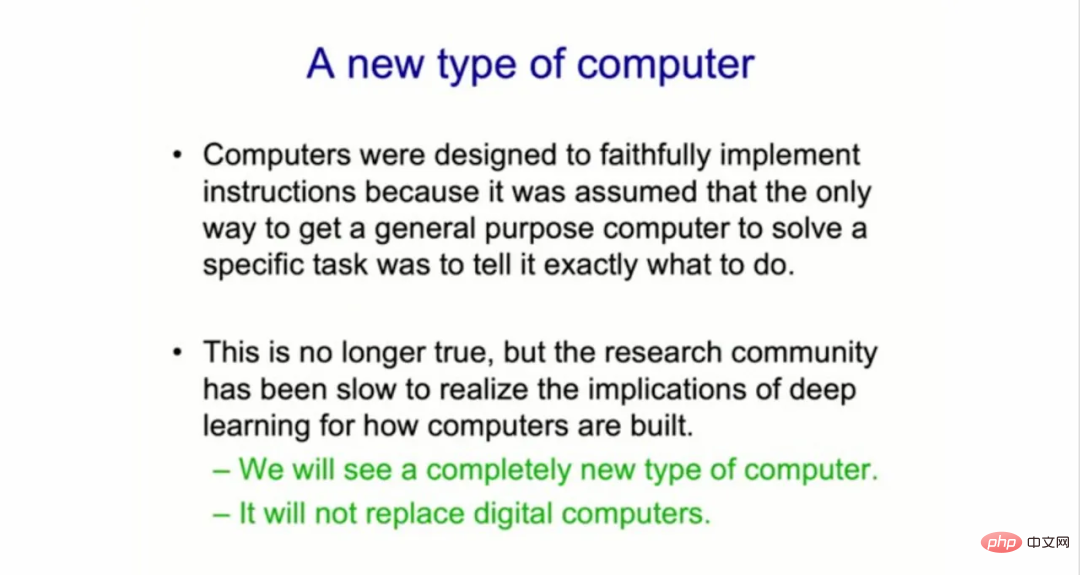

Hinton Das Thema dieser Rede ist „Der Vorwärts-Vorwärts-Algorithmus für das Training tiefer neuronaler Netze“. In seiner Rede sagte Geoffrey Hinton: „Die Forschungsgemeinschaft des maschinellen Lernens hat die Auswirkungen von Deep Learning auf die Art und Weise, wie Computer gebaut werden, nur langsam erkannt.“ Er glaubt, dass Formen des maschinellen Lernens der künstlichen Intelligenz Veränderungen in Computersystemen auslösen werden , das ist eine neue weiche und harte Kombination, die KI „in Ihren Toaster“ bringt.

Er fuhr fort: „Ich denke, wir werden einen völlig anderen Computertyp sehen, und obwohl dies erst in ein paar Jahren möglich sein wird, gibt es gute Gründe, an diesem völlig anderen Computer zu arbeiten

.“

Bau eines völlig anderen neuen Computertyps

Bis heute wurden alle digitalen Computer so gebaut, dass sie „unsterblich“ sind, wobei die Hardware auf äußerste Zuverlässigkeit ausgelegt ist, sodass überall die gleiche Software laufen kann. „Wir können das gleiche Programm auf unterschiedlicher physischer Hardware ausführen, und Wissen ist unsterblich.“

Hinton sagte, dass diese Designanforderung bedeutet, dass digitale Computer „die verschiedenen Variablen, Zufälligkeit und Instabilität der Hardware, Simulation und Unzuverlässigkeit“ vermissen Funktionen", die für uns sehr nützlich sein können.

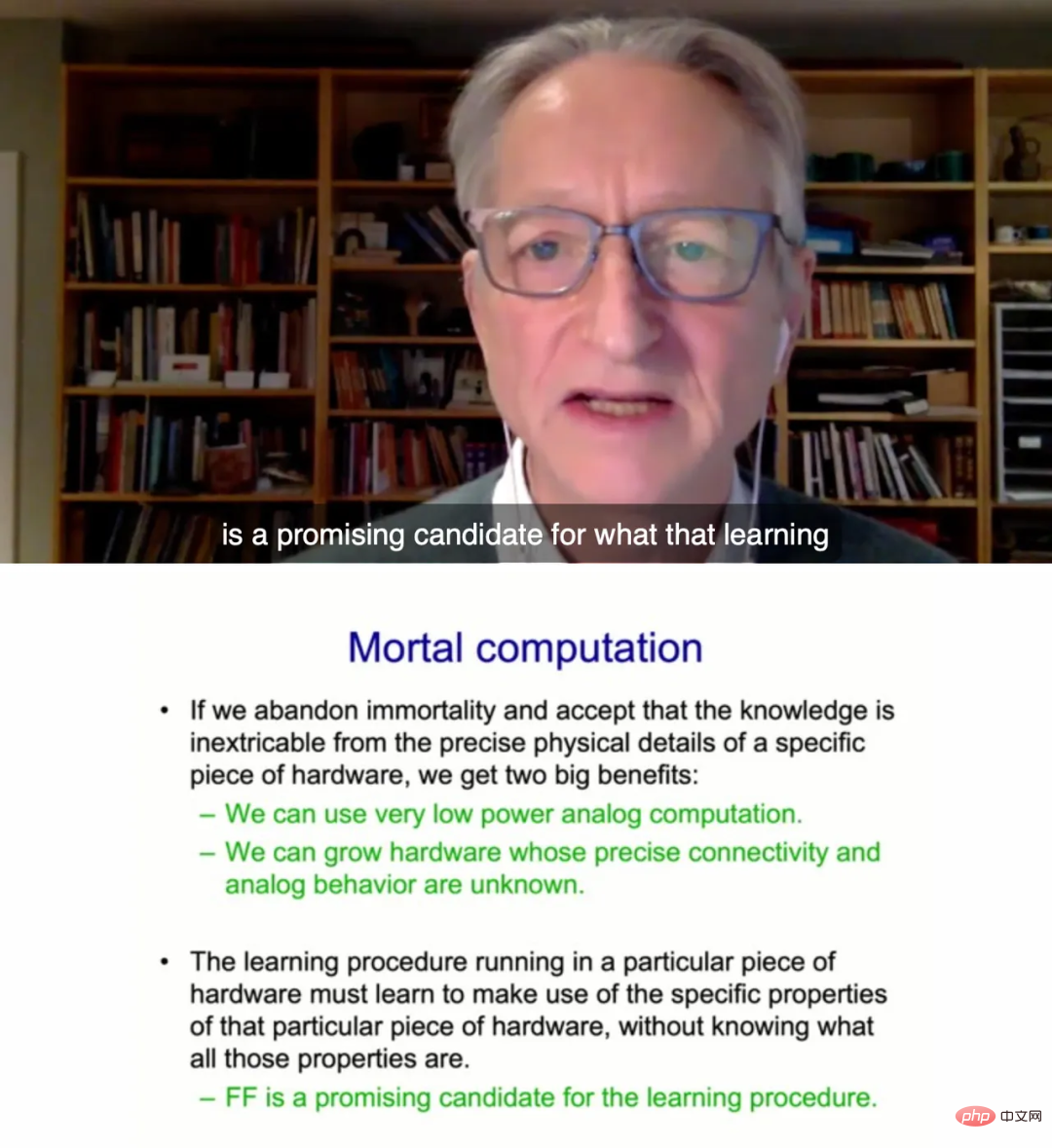

Nach Hintons Ansicht werden zukünftige Computersysteme einen anderen Ansatz verfolgen: Sie werden „neuromorph“ und sterblich sein . Das bedeutet, dass jeder Computer eine enge Verbindung von neuronaler Netzwerksoftware und unzusammenhängender Hardware sein wird, in dem Sinne, dass er über analoge statt digitale Komponenten verfügt, die ein Element der Unsicherheit enthalten und sich im Laufe der Zeit weiterentwickeln können.

Hinton erklärte: „Die Alternative besteht jetzt darin, dass wir die Trennung von Hardware und Software aufgeben, aber Informatikern gefällt dieser Ansatz wirklich nicht.“

Sogenannte Mortal Computation also Das vom System und der Hardware erlernte Wissen ist untrennbar miteinander verbunden. Diese gewöhnlichen Computer können aus teuren Chip-Produktionsanlagen „herauswachsen“.

Hinton weist darauf hin, dass wir, wenn wir dies tun, analoge Berechnungen mit extrem geringem Stromverbrauch verwenden und Memristorgewichte verwenden können, um Teraflops paralleler Verarbeitung durchzuführen. Dabei handelt es sich um einen jahrzehntealten Experimentalchip, der auf nichtlinearen Schaltungskomponenten basiert. Darüber hinaus können wir Hardware weiterentwickeln, ohne die genaue Qualität des genauen Verhaltens verschiedener Hardwareteile zu verstehen.

Allerdings sagte Hinton auch, dass der neue gewöhnliche Computer den herkömmlichen digitalen Computer nicht ersetzen wird: „Es ist kein Computer, der Ihr Bankkonto kontrolliert, und er weiß auch nicht genau, wie viel Geld Sie haben.“ Dieser Computer beherbergte (d. h. verarbeitete) andere Dinge, zum Beispiel konnte er für einen Dollar „so etwas wie den GPT-3 in Ihren Toaster stecken“, sodass er nur ein paar Watt Leistung benötigte, um seine eigene Toaster-Konversation zu ermöglichen.

FF-Netzwerke, die für gängige Computerhardware geeignet sind

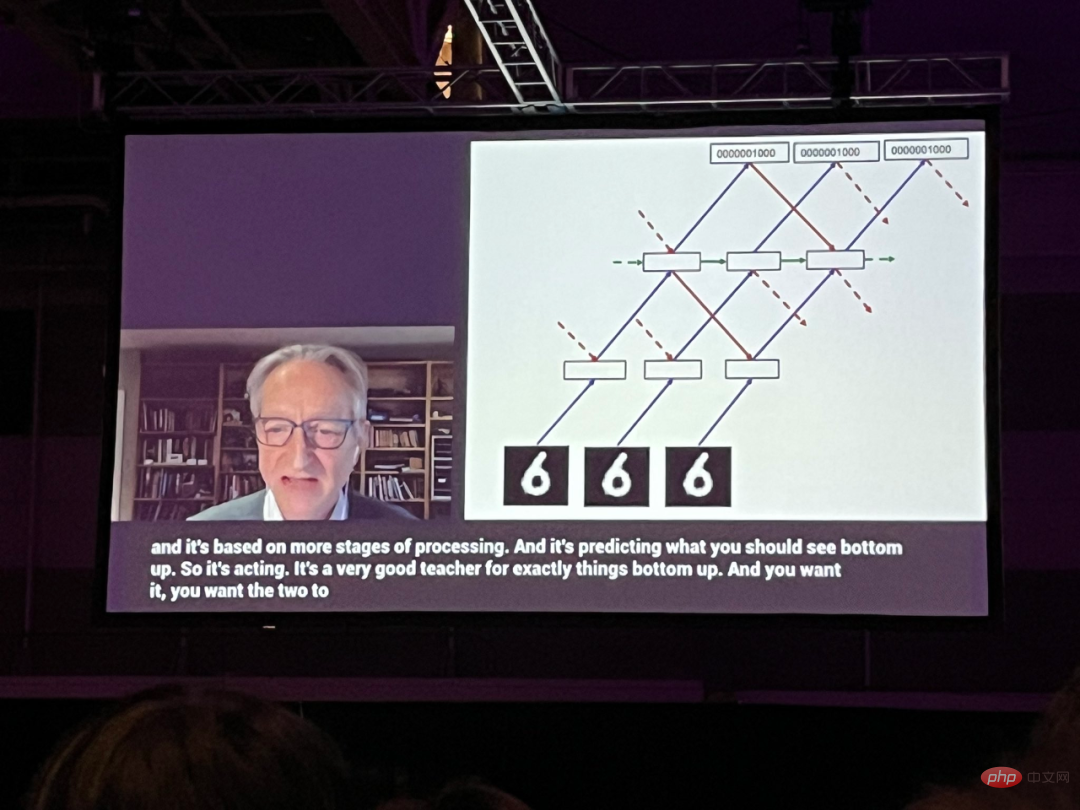

In diesem Vortrag verbrachte Hinton den größten Teil des Vortrags damit, über einen neuen neuronalen Netzwerkansatz zu sprechen, den er Forward-Forward (FF)-Netzwerke nannte und der die bisher verwendete Backpropagation-Technik fast vollständig ersetzte neuronale Netze. Hinton schlug vor, dass Vorwärtsnetzwerke durch die Beseitigung der Backpropagation besser annähern könnten, was im wirklichen Leben im Gehirn passiert.

Dieser Papierentwurf ist auf der Hinton-Homepage der University of Toronto veröffentlicht:

Papierlink: https://www.cs.toronto.edu/~hinton/FFA13.pdf

Hinton sagte, dass die FF-Methode möglicherweise besser für gewöhnliche Computerhardware geeignet sei. „Um so etwas derzeit zu machen, brauchen wir ein Lernprogramm, das auf proprietärer Hardware läuft, und es muss lernen, die spezifischen Eigenschaften dieser proprietären Hardware auszunutzen, ohne zu wissen, was all diese Eigenschaften sind. Aber ich denke, das Der Vorwärtsalgorithmus ist eine Option mit Potenzial.“ Ein Hindernis beim Bau neuer analoger Computer sei die Bedeutung, die der Zuverlässigkeit der Ausführung einer Software auf Millionen von Geräten beigemessen werde. „Jedes dieser Telefone muss als Babyphone beginnen und lernen, wie man ein Telefon wird“, sagte Hinton. „Und das ist sehr schmerzhaft.“

Selbst die erfahrensten Ingenieure werden aus Angst vor Unsicherheit das Paradigma eines perfekten, identischen unsterblichen Computers nur ungern aufgeben.

Hinton sagte: „Unter den Menschen, die sich für analoges Rechnen interessieren, gibt es immer noch eine sehr kleine Anzahl von Menschen, die bereit sind, die Unsterblichkeit aufzugeben. Das liegt an der Bindung an Konsistenz und Vorhersehbarkeit. Aber wenn Sie wollen.“

Papierinhalt

In dem Papier stellt Hinton ein neues Lernverfahren für neuronale Netze vor und beweist experimentell, dass es funktioniert Bei einigen kleinen Aufgaben ist die Auswirkung auf die Frage gut genug. Der konkrete Inhalt lautet wie folgt:Was ist falsch an der Backpropagation?

Der Erfolg des Deep Learning im letzten Jahrzehnt hat die Wirksamkeit der Durchführung eines stochastischen Gradientenabstiegs mit einer großen Anzahl von Parametern und großen Datenmengen bewiesen. Der Gradient wird normalerweise durch Backpropagation berechnet, was zu einem Interesse an der Frage geführt hat, ob das Gehirn Backpropagation implementiert oder ob es andere Möglichkeiten gibt, die zum Anpassen der Verbindungsgewichte erforderlichen Gradienten zu erhalten.Backpropagation bleibt als Modell dafür, wie die Großhirnrinde lernt, unplausibel, trotz erheblicher Bemühungen, sie wie echte Neuronen umzusetzen. Derzeit gibt es keine überzeugenden Beweise dafür, dass die Großhirnrinde Fehlerableitungen explizit weiterleitet oder neuronale Aktivität für die Verwendung bei der anschließenden Rückausbreitung speichert. Top-Down-Verbindungen von einem kortikalen Bereich zu Bereichen früher im Sehweg verliefen nicht wie erwartet, d. h. es würden Bottom-Up-Verbindungen auftreten, wenn Backpropagation im visuellen System verwendet würde. Stattdessen bilden sie Schleifen, in denen die neuronale Aktivität in zwei Regionen etwa ein halbes Dutzend kortikaler Schichten durchläuft und dann dorthin zurückkehrt, wo sie begonnen hat.

Die zeitliche Rückausbreitung ist als Methode zum Erlernen von Sequenzen besonders unzuverlässig. Um einen Strom sensorischer Eingaben ohne häufige Auszeiten zu verarbeiten, muss das Gehirn sensorische Daten durch verschiedene Phasen der sensorischen Verarbeitung weiterleiten. Dazu ist ein Lernprogramm erforderlich, das „on the fly“ lernen kann. Darstellungen in späteren Phasen der Pipeline können Top-Down-Informationen liefern, die sich auf Darstellungen in früheren Phasen der Pipeline in nachfolgenden Zeitschritten auswirken, aber das Wahrnehmungssystem muss in Echtzeit schlussfolgern und lernen, ohne die Backpropagation anzuhalten.

Eine weitere schwerwiegende Einschränkung der Backpropagation besteht darin, dass für die Berechnung der korrekten Ableitungen vollständige Kenntnisse der im Vorwärtsdurchlauf durchgeführten Berechnungen erforderlich sind. Wenn wir im Vorwärtsdurchlauf eine Blackbox einfügen, ist eine Rückausbreitung nicht mehr möglich, es sei denn, wir lernen ein differenzierbares Modell der Blackbox. Wie wir sehen werden, ändert die Blackbox den Lernvorgang des FF-Algorithmus überhaupt nicht, da keine Rückwärtsausbreitung durch sie erforderlich ist.

In Ermangelung eines perfekten Vorwärtspassmodells könnte man auf eine der vielen Formen des verstärkenden Lernens zurückgreifen. Die Idee besteht darin, zufällige Störungen an den Gewichten oder der neuronalen Aktivität vorzunehmen und diese Störungen mit Änderungen in der Auszahlungsfunktion in Beziehung zu setzen. Allerdings leiden Reinforcement-Learning-Programme unter einer hohen Variabilität: Es ist schwer, die Auswirkung der Störung einer Variablen zu erkennen, wenn viele andere Variablen gleichzeitig gestört werden. Um das durch alle anderen Störungen verursachte Rauschen zu mitteln, muss die Lernrate umgekehrt proportional zur Anzahl der gestörten Variablen sein, was bedeutet, dass Reinforcement Learning schlecht skaliert und für große Netzwerke mit Millionen oder Milliarden von Variablen nicht mit der Umkehrung verglichen werden kann Parameter. Kommunikationswettbewerb.

Der Hauptpunkt dieser Arbeit ist, dass neuronale Netze, die unbekannte Nichtlinearitäten enthalten, nicht auf Verstärkungslernen zurückgreifen müssen. Der FF-Algorithmus ist in seiner Geschwindigkeit mit der Backpropagation vergleichbar, hat jedoch den Vorteil, dass er verwendet werden kann, wenn die genauen Details der Vorwärtsberechnung nicht bekannt sind. Es hat auch den Vorteil, dass es lernen kann, während es auf sequentiellen Daten durch ein neuronales Netzwerk verarbeitet wird, ohne dass neuronale Aktivität gespeichert oder die Ausbreitung von Fehlerableitungen gestoppt werden muss.

Im Allgemeinen ist der FF-Algorithmus langsamer als die Backpropagation, und seine Verallgemeinerung ist für mehrere in diesem Artikel untersuchte Spielzeugprobleme nicht ideal. Daher ist es unwahrscheinlich, dass er die Backpropagation in Anwendungen ersetzt, die nicht zu stark auf die Leistung beschränkt sind. Bei sehr großen Modellen, die auf sehr großen Datensätzen trainiert wurden, wird bei dieser Art der Erkundung weiterhin die Backpropagation verwendet. Der FF-Algorithmus ist möglicherweise in zweierlei Hinsicht besser als die Backpropagation: Zum einen als Lernmodell der Großhirnrinde und zum anderen als Simulationshardware mit sehr geringem Stromverbrauch, ohne auf Verstärkungslernen zurückzugreifen. FF-Algorithmus

Der Forward-Forward-Algorithmus ist ein gieriges mehrschichtiges Lernverfahren, das von Boltzmann-Maschinen und der kontrastiven Rauschschätzung inspiriert ist.

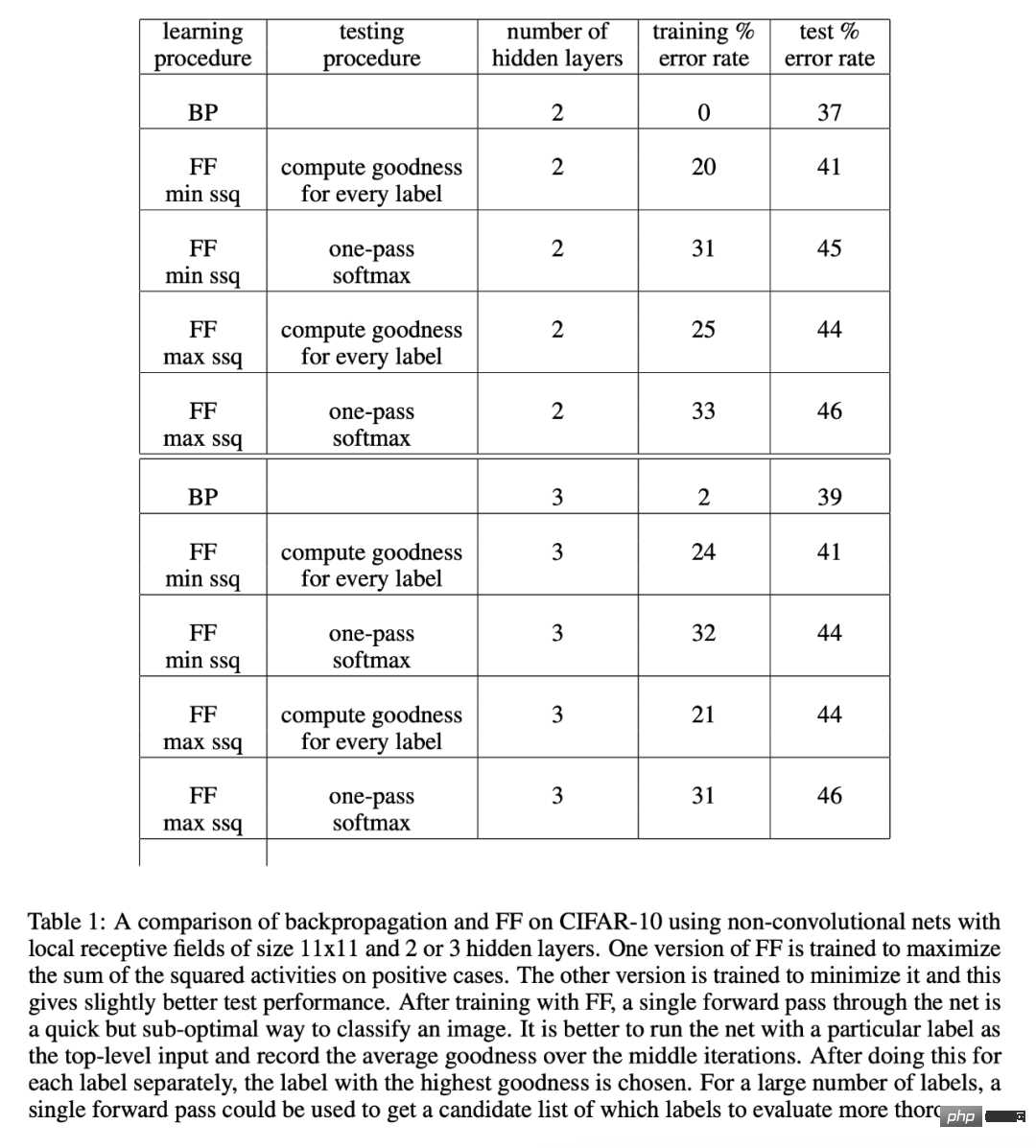

Die Idee besteht darin, zwei Vorwärtspässe zu verwenden, um die Vorwärts- und Rückwärtspässe der Backpropagation zu ersetzen. Diese beiden Vorwärtspässe wirken aufeinander auf genau die gleiche Weise, aber aufgrund unterschiedlicher Daten sind die Ziele auch gegenteilig . Unter anderem arbeitet der positive Durchgang mit den realen Daten und passt die Gewichte an, um die Güte in jeder verborgenen Schicht zu erhöhen. Der negative Durchgang arbeitet mit den negativen Daten und passt die Gewichte an, um die Güte in jeder verborgenen Schicht zu verringern. In dem Artikel demonstrierte Hinton die Leistung des FF-Algorithmus durch Experimente mit CIFAR-10.

CIFAR-10 verfügt über 50.000 Trainingsbilder mit einer Größe von 32 x 32 Pixeln und drei Farbkanälen pro Pixel. Daher hat jedes Bild 3072 Dimensionen. Die Hintergründe dieser Bilder sind komplex und sehr variabel und können mit solch begrenzten Trainingsdaten nicht gut modelliert werden. Wenn ein vollständig verbundenes Netzwerk mit zwei bis drei verborgenen Schichten mit der Backpropagation-Methode trainiert wird, ist der Überanpassungseffekt im Allgemeinen sehr gering, es sei denn, die verborgene Schicht ist sehr klein, sodass fast alle gemeldeten Ergebnisse für Faltungsnetzwerke gelten.

Da FF für den Einsatz in Netzwerken gedacht ist, in denen eine Gewichtsverteilung nicht möglich ist, wurde es mit einem Backpropagation-Netzwerk verglichen, das lokale Empfangsfelder verwendet, um die Anzahl der Gewichte zu begrenzen, ohne die Anzahl der versteckten Einheiten übermäßig zu begrenzen. Der Zweck besteht lediglich darin, zu zeigen, dass FF bei einer großen Anzahl versteckter Einheiten eine vergleichbare Leistung erbringt wie die Backpropagation für Bilder mit stark variablen Hintergründen.

Tabelle 1 zeigt die Testleistung des mit Backpropagation und FF trainierten Netzwerks, die beide Gewichtsabnahme nutzen, um Überanpassung zu reduzieren.

Weitere Forschungsdetails finden Sie im Originalpapier.

Weitere Forschungsdetails finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonFast zehntausend Menschen sahen sich Hintons neueste Rede an: Der Vortrag „Forward Neural Network Training Algorithm' wurde veröffentlicht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Heute diskutieren wir darüber, wie Deep-Learning-Technologie die Leistung von visionbasiertem SLAM (Simultaneous Localization and Mapping) in komplexen Umgebungen verbessern kann. Durch die Kombination von Methoden zur Tiefenmerkmalsextraktion und Tiefenanpassung stellen wir hier ein vielseitiges hybrides visuelles SLAM-System vor, das die Anpassung in anspruchsvollen Szenarien wie schlechten Lichtverhältnissen, dynamischer Beleuchtung, schwach strukturierten Bereichen und starkem Jitter verbessern soll. Unser System unterstützt mehrere Modi, einschließlich erweiterter Monokular-, Stereo-, Monokular-Trägheits- und Stereo-Trägheitskonfigurationen. Darüber hinaus wird analysiert, wie visuelles SLAM mit Deep-Learning-Methoden kombiniert werden kann, um andere Forschungen zu inspirieren. Durch umfangreiche Experimente mit öffentlichen Datensätzen und selbst abgetasteten Daten demonstrieren wir die Überlegenheit von SL-SLAM in Bezug auf Positionierungsgenauigkeit und Tracking-Robustheit.

CLIP-BEVFormer: Überwacht explizit die BEVFormer-Struktur, um die Leistung der Long-Tail-Erkennung zu verbessern

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: Überwacht explizit die BEVFormer-Struktur, um die Leistung der Long-Tail-Erkennung zu verbessern

Mar 26, 2024 pm 12:41 PM

Oben geschrieben und das persönliche Verständnis des Autors: Derzeit spielt das Wahrnehmungsmodul im gesamten autonomen Fahrsystem eine entscheidende Rolle Das Steuermodul im autonomen Fahrsystem trifft zeitnahe und korrekte Urteile und Verhaltensentscheidungen. Derzeit sind Autos mit autonomen Fahrfunktionen in der Regel mit einer Vielzahl von Dateninformationssensoren ausgestattet, darunter Rundumsichtkamerasensoren, Lidar-Sensoren und Millimeterwellenradarsensoren, um Informationen in verschiedenen Modalitäten zu sammeln und so genaue Wahrnehmungsaufgaben zu erfüllen. Der auf reinem Sehen basierende BEV-Wahrnehmungsalgorithmus wird von der Industrie aufgrund seiner geringen Hardwarekosten und einfachen Bereitstellung bevorzugt, und seine Ausgabeergebnisse können problemlos auf verschiedene nachgelagerte Aufgaben angewendet werden.

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Zu den häufigsten Herausforderungen, mit denen Algorithmen für maschinelles Lernen in C++ konfrontiert sind, gehören Speicherverwaltung, Multithreading, Leistungsoptimierung und Wartbarkeit. Zu den Lösungen gehören die Verwendung intelligenter Zeiger, moderner Threading-Bibliotheken, SIMD-Anweisungen und Bibliotheken von Drittanbietern sowie die Einhaltung von Codierungsstilrichtlinien und die Verwendung von Automatisierungstools. Praktische Fälle zeigen, wie man die Eigen-Bibliothek nutzt, um lineare Regressionsalgorithmen zu implementieren, den Speicher effektiv zu verwalten und leistungsstarke Matrixoperationen zu nutzen.

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

In der heutigen Welle rasanter technologischer Veränderungen sind künstliche Intelligenz (KI), maschinelles Lernen (ML) und Deep Learning (DL) wie helle Sterne und führen die neue Welle der Informationstechnologie an. Diese drei Wörter tauchen häufig in verschiedenen hochaktuellen Diskussionen und praktischen Anwendungen auf, aber für viele Entdecker, die neu auf diesem Gebiet sind, sind ihre spezifische Bedeutung und ihre internen Zusammenhänge möglicherweise noch immer rätselhaft. Schauen wir uns also zunächst dieses Bild an. Es ist ersichtlich, dass zwischen Deep Learning, maschinellem Lernen und künstlicher Intelligenz ein enger Zusammenhang und eine fortschreitende Beziehung besteht. Deep Learning ist ein spezifischer Bereich des maschinellen Lernens und des maschinellen Lernens

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Fast 20 Jahre sind vergangen, seit das Konzept des Deep Learning im Jahr 2006 vorgeschlagen wurde. Deep Learning hat als Revolution auf dem Gebiet der künstlichen Intelligenz viele einflussreiche Algorithmen hervorgebracht. Was sind Ihrer Meinung nach die zehn besten Algorithmen für Deep Learning? Im Folgenden sind meiner Meinung nach die besten Algorithmen für Deep Learning aufgeführt. Sie alle nehmen hinsichtlich Innovation, Anwendungswert und Einfluss eine wichtige Position ein. 1. Hintergrund des Deep Neural Network (DNN): Deep Neural Network (DNN), auch Multi-Layer-Perceptron genannt, ist der am weitesten verbreitete Deep-Learning-Algorithmus. Als er erstmals erfunden wurde, wurde er aufgrund des Engpasses bei der Rechenleistung in Frage gestellt Jahre, Rechenleistung, Der Durchbruch kam mit der Datenexplosion. DNN ist ein neuronales Netzwerkmodell, das mehrere verborgene Schichten enthält. In diesem Modell übergibt jede Schicht Eingaben an die nächste Schicht und

Entdecken Sie die zugrunde liegenden Prinzipien und die Algorithmusauswahl der C++-Sortierfunktion

Apr 02, 2024 pm 05:36 PM

Entdecken Sie die zugrunde liegenden Prinzipien und die Algorithmusauswahl der C++-Sortierfunktion

Apr 02, 2024 pm 05:36 PM

Die unterste Ebene der C++-Sortierfunktion verwendet die Zusammenführungssortierung, ihre Komplexität beträgt O(nlogn) und bietet verschiedene Auswahlmöglichkeiten für Sortieralgorithmen, einschließlich schneller Sortierung, Heap-Sortierung und stabiler Sortierung.

Verbesserter Erkennungsalgorithmus: zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern

Jun 06, 2024 pm 12:33 PM

Verbesserter Erkennungsalgorithmus: zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern

Jun 06, 2024 pm 12:33 PM

01Ausblicksübersicht Derzeit ist es schwierig, ein angemessenes Gleichgewicht zwischen Detektionseffizienz und Detektionsergebnissen zu erreichen. Wir haben einen verbesserten YOLOv5-Algorithmus zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern entwickelt, der mehrschichtige Merkmalspyramiden, Multierkennungskopfstrategien und hybride Aufmerksamkeitsmodule verwendet, um die Wirkung des Zielerkennungsnetzwerks in optischen Fernerkundungsbildern zu verbessern. Laut SIMD-Datensatz ist der mAP des neuen Algorithmus 2,2 % besser als YOLOv5 und 8,48 % besser als YOLOX, wodurch ein besseres Gleichgewicht zwischen Erkennungsergebnissen und Geschwindigkeit erreicht wird. 02 Hintergrund und Motivation Mit der rasanten Entwicklung der Fernerkundungstechnologie wurden hochauflösende optische Fernerkundungsbilder verwendet, um viele Objekte auf der Erdoberfläche zu beschreiben, darunter Flugzeuge, Autos, Gebäude usw. Objekterkennung bei der Interpretation von Fernerkundungsbildern

Kann künstliche Intelligenz Kriminalität vorhersagen? Entdecken Sie die Möglichkeiten von CrimeGPT

Mar 22, 2024 pm 10:10 PM

Kann künstliche Intelligenz Kriminalität vorhersagen? Entdecken Sie die Möglichkeiten von CrimeGPT

Mar 22, 2024 pm 10:10 PM

Die Konvergenz von künstlicher Intelligenz (KI) und Strafverfolgung eröffnet neue Möglichkeiten zur Kriminalprävention und -aufdeckung. Die Vorhersagefähigkeiten künstlicher Intelligenz werden häufig in Systemen wie CrimeGPT (Crime Prediction Technology) genutzt, um kriminelle Aktivitäten vorherzusagen. Dieser Artikel untersucht das Potenzial künstlicher Intelligenz bei der Kriminalitätsvorhersage, ihre aktuellen Anwendungen, die Herausforderungen, denen sie gegenübersteht, und die möglichen ethischen Auswirkungen der Technologie. Künstliche Intelligenz und Kriminalitätsvorhersage: Die Grundlagen CrimeGPT verwendet Algorithmen des maschinellen Lernens, um große Datensätze zu analysieren und Muster zu identifizieren, die vorhersagen können, wo und wann Straftaten wahrscheinlich passieren. Zu diesen Datensätzen gehören historische Kriminalstatistiken, demografische Informationen, Wirtschaftsindikatoren, Wettermuster und mehr. Durch die Identifizierung von Trends, die menschliche Analysten möglicherweise übersehen, kann künstliche Intelligenz Strafverfolgungsbehörden stärken