Groß angelegte generative Modelle haben in den letzten zwei Jahren große Durchbrüche bei der Verarbeitung natürlicher Sprache und sogar beim Computer Vision gebracht. In jüngster Zeit hat sich dieser Trend auch auf das Verstärkungslernen ausgewirkt, insbesondere auf das Offline-Verstärkungslernen (Offline-RL), wie z. B. Decision Transformer (DT)[1], Trajectory Transformer (TT)[2], Gato[3], Diffuser[4] usw Diese Methode betrachtet Reinforcement-Learning-Daten (einschließlich Status, Aktion, Belohnung und Return-to-Go) als eine Reihe destrukturierter Sequenzdaten und modelliert diese Sequenzdaten als Kernaufgabe des Lernens. Diese Modelle können mit überwachten oder selbstüberwachten Lernmethoden trainiert werden, wodurch die instabilen Gradientensignale beim herkömmlichen verstärkenden Lernen vermieden werden. Selbst unter Verwendung komplexer Richtlinienverbesserungs- und Wertschätzungsmethoden zeigen sie eine sehr gute Leistung beim Offline-Lernen zur Verstärkung.

In diesem Artikel wird kurz auf diese auf Sequenzmodellierung basierenden Methoden des Verstärkungslernens eingegangen. Im nächsten Artikel stellt der Autor unseren neu vorgeschlagenen Trajectory Autoencoding Planner (TAP) vor, der Vector Quantised Variational AutoEncoder (VQ-VAE) verwendet. Eine Methode zur Sequenzmodellierung und effizienten Planung im latenten Aktionsraum.

Die Transformer-Architektur [5] wurde 2017 vorgeschlagen und löste langsam eine Revolution in der Verarbeitung natürlicher Sprache aus. Das anschließende BERT und GPT-3 brachten die Kombination aus Selbstüberwachung + Transformer schrittweise auf ein neues Niveau Während Eigenschaften wie das Wenig-Schuss-Lernen im Bereich der Verarbeitung natürlicher Sprache ständig auftauchen, beginnen sie sich auch auf Bereiche wie Computer Vision auszudehnen [6][7].

Für das verstärkende Lernen scheint dieser Prozess jedoch nicht vor 2021 besonders offensichtlich zu sein. Im Jahr 2018 wurde der Multi-Head-Aufmerksamkeitsmechanismus auch in das verstärkende Lernen eingeführt [8]. Diese Art von Arbeit wird grundsätzlich in Bereichen angewendet, die dem semisymbolischen (subsymbolischen) ähneln, um zu versuchen, das Problem der Verallgemeinerung des verstärkenden Lernens zu lösen. Seitdem waren solche Versuche verhalten. Nach der persönlichen Erfahrung des Autors weist Transformer beim Verstärkungslernen tatsächlich keinen stabilen und überwältigenden Vorteil auf und ist auch schwer zu trainieren. In einer unserer 20-jährigen Arbeiten zur Verwendung von relationalem GCN für verstärktes Lernen [9] haben wir Transformer tatsächlich hinter den Kulissen ausprobiert, aber es war im Grunde viel schlechter als die traditionelle Struktur (ähnlich wie CNN) und es war schwierig, stabil zu trainieren und eine brauchbare Police erhalten. Warum Transformer nicht mit herkömmlichem Online-Lernen zur Verstärkung (Online-RL) kompatibel ist, ist immer noch eine offene Frage. Melo [10] erklärte beispielsweise, dass die Parameterinitialisierung des herkömmlichen Transformers nicht für das Lernen zur Verstärkung geeignet sei, weshalb ich nicht darauf eingehen werde es weiter hier.

Mitte 2021 löste die Veröffentlichung von Decision Transformer (DT) und Trajectory Transformer (TT) eine neue Welle von Transformer-Anwendungen in RL aus. Die Idee dieser beiden Arbeiten ist eigentlich sehr einfach: Wenn Transformer und Online-Lernalgorithmen für Verstärkung nicht sehr kompatibel sind, wie wäre es dann, Verstärkungslernen einfach als selbstüberwachte Lernaufgabe zu behandeln? Unter Ausnutzung der Tatsache, dass das Konzept des Offline-Verstärkungslernens ebenfalls sehr beliebt ist, haben beide Arbeiten ihre Hauptzielaufgaben auf die Modellierung von Offline-Datensätzen beschränkt und verwenden dann dieses Sequenzmodell zur Steuerung und Entscheidungsfindung.

Für das verstärkende Lernen ist die sogenannte Sequenz die Trajektorie  bestehend aus Zustand s, Aktion

bestehend aus Zustand s, Aktion  , Belohnung r und Wert v. Der Wert wird derzeit im Allgemeinen durch Return-to-Go ersetzt, was als Monte-Carlo-Schätzung angesehen werden kann. Der Offline-Datensatz besteht aus diesen Trajektorien. Die Erzeugung von Trajektorien hängt mit der Dynamik der Umgebung und der Verhaltenspolitik zusammen. Die sogenannte Sequenzmodellierung besteht darin, die Wahrscheinlichkeitsverteilung (Verteilung) zu modellieren, die diese Sequenz generiert, oder streng genommen einige der bedingten Wahrscheinlichkeiten.

, Belohnung r und Wert v. Der Wert wird derzeit im Allgemeinen durch Return-to-Go ersetzt, was als Monte-Carlo-Schätzung angesehen werden kann. Der Offline-Datensatz besteht aus diesen Trajektorien. Die Erzeugung von Trajektorien hängt mit der Dynamik der Umgebung und der Verhaltenspolitik zusammen. Die sogenannte Sequenzmodellierung besteht darin, die Wahrscheinlichkeitsverteilung (Verteilung) zu modellieren, die diese Sequenz generiert, oder streng genommen einige der bedingten Wahrscheinlichkeiten.

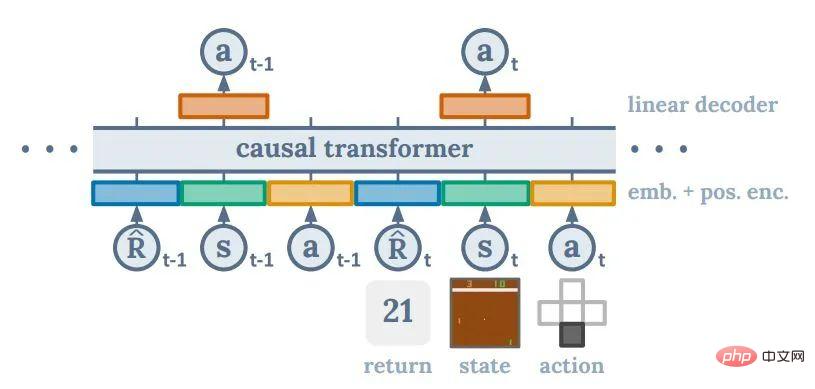

Der Ansatz von DT besteht darin, eine Abbildung von vergangenen Daten und Werten auf Aktionen zu modellieren (rückgabebedingte Richtlinie), also die Bedingungen einer Aktion zu modellieren Der mathematische Erwartungswert der Wahrscheinlichkeit . Diese Idee ist Upside Down RL [11] sehr ähnlich, aber es ist sehr wahrscheinlich, dass die direkte Motivation dahinter darin besteht, die Methode von GPT2/3 zur Erledigung nachgelagerter Aufgaben basierend auf Eingabeaufforderungen zu imitieren. Ein Problem bei diesem Ansatz besteht darin, dass es keine systematische Möglichkeit gibt, den besten Zielwert zu bestimmen. Die Autoren von DT stellten jedoch fest, dass die endgültige Leistung von DT sehr gut sein kann, selbst wenn der Zielwert auf die höchste Rendite im gesamten Datensatz festgelegt ist.

. Diese Idee ist Upside Down RL [11] sehr ähnlich, aber es ist sehr wahrscheinlich, dass die direkte Motivation dahinter darin besteht, die Methode von GPT2/3 zur Erledigung nachgelagerter Aufgaben basierend auf Eingabeaufforderungen zu imitieren. Ein Problem bei diesem Ansatz besteht darin, dass es keine systematische Möglichkeit gibt, den besten Zielwert zu bestimmen. Die Autoren von DT stellten jedoch fest, dass die endgültige Leistung von DT sehr gut sein kann, selbst wenn der Zielwert auf die höchste Rendite im gesamten Datensatz festgelegt ist.

Für Menschen mit einem Hintergrund in Beim verstärkten Lernen ist es sehr kontraintuitiv, dass eine Methode wie DT eine starke Leistung erzielen kann. Wenn Methoden wie DQN und Policy Gradient das neuronale Netzwerk nur als Anpassungsfunktion betrachten können, die zur Interpolation und Verallgemeinerung verwendet werden kann, sind Richtlinienverbesserung und -bewertung beim Reinforcement Learning immer noch der Kern der Richtlinienkonstruktion. Man kann sagen, dass DT vollständig auf neuronalen Netzen basiert. Der gesamte Prozess, der dahinter steckt, wie ein potenziell unrealistisch hoher Zielwert mit einer geeigneten Aktion verknüpft wird, ist völlig Black Box. Aus Sicht des verstärkenden Lernens kann man sagen, dass der Erfolg von DT etwas unvernünftig ist, aber ich denke, das ist der Reiz dieser Art empirischer Forschung. Der Autor glaubt, dass die Generalisierungsfähigkeit neuronaler Netze oder Transformer die bisherigen Erwartungen der gesamten RL-Community übertreffen könnte. DT ist unter allen Sequenzmodellierungsmethoden auch sehr einfach, und fast alle Kernprobleme des Verstärkungslernens werden in Transformer gelöst. Diese Einfachheit ist einer der Gründe, warum es derzeit am beliebtesten ist. Aufgrund seiner Black-Box-Natur verlieren wir jedoch auch viel Kontrolle über die Ebene des Algorithmusdesigns, und einige Errungenschaften des traditionellen Verstärkungslernens lassen sich nur schwer darin integrieren. Die Wirksamkeit dieser Ergebnisse wurde in einigen sehr groß angelegten Experimenten (wie AlphaGo, AlphaStar, VPT) wiederholt bestätigt.

Trajectory Transformer

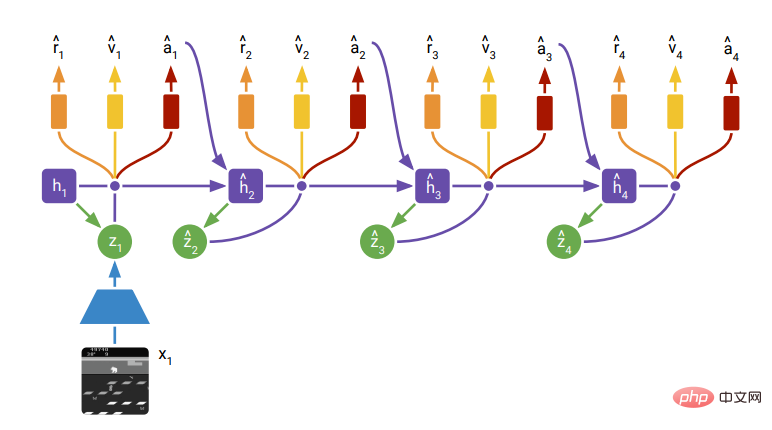

Der Ansatz von TT ähnelt eher der traditionellen modellbasierten Planungsmethode für verstärkendes Lernen (modellbasiertes RL). Bei der Modellierung werden die Elemente in der gesamten Sequenz diskretisiert und anschließend eine diskrete autoregressive Methode wie GPT-2 verwendet, um den gesamten Offline-Datensatz zu modellieren. Dies ermöglicht es, die Fortsetzung einer bestimmten Sequenz abzüglich des Return-to-go

zu modellieren. Da TT die Verteilung nachfolgender Sequenzen modelliert, wird es tatsächlich zu einem Sequenzgenerierungsmodell. Durch die Suche nach einer Sequenz mit besserer Wertschätzung in der generierten Sequenz kann TT einen „optimalen Plan“ ausgeben. Als Methode zum Finden der optimalen Sequenz verwendet TT eine Methode, die häufig in natürlicher Sprache verwendet wird: eine Variante der Strahlsuche. Im Grunde geht es darum, immer den optimalen Teil der erweiterten Sequenzen beizubehalten und dann basierend darauf den nächsten optimalen Sequenzsatz zu finden  .

.

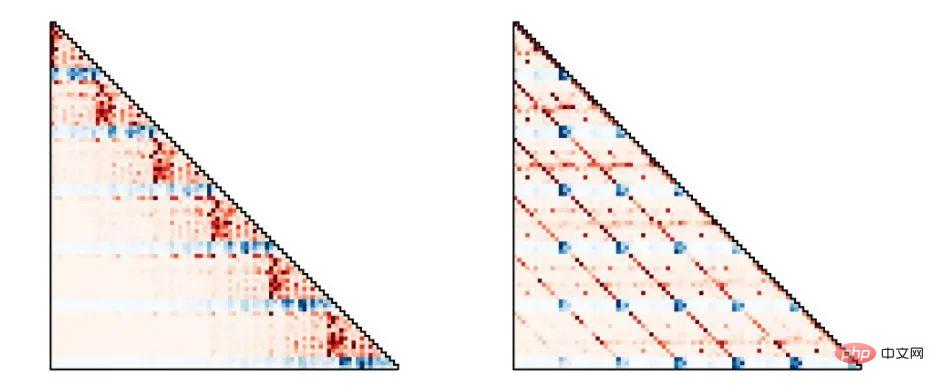

Aus der Perspektive des verstärkenden Lernens ist TT nicht so unorthodox wie DT. Das Interessante daran ist, dass es (wie DT) die Kausalgraphenstruktur des ursprünglichen Markov-Entscheidungsprozesses beim verstärkenden Lernen vollständig aufgibt. Frühere modellbasierte Methoden wie PETS, Weltmodell, Dramev2 usw. folgen alle der Definition von Richtlinienfunktionen, Übertragungsfunktionen, Belohnungsfunktionen usw. im Markov-Prozess (oder impliziten Markov), dh der Bedingung von Die Statusverteilung ist der Status des vorherigen Schritts, und Aktionen, Belohnungen und Werte werden alle durch den aktuellen Status bestimmt. Die gesamte Community des Verstärkungslernens glaubt im Allgemeinen, dass dies die Stichprobeneffizienz verbessern kann, aber eine solche Diagrammstruktur kann tatsächlich eine Einschränkung darstellen. Der Übergang von RNN zu Transformer im Bereich der natürlichen Sprache und von CNN zu Transformer im Bereich Computer Vision spiegelt tatsächlich wider: Wenn die Datenmenge zunimmt, ist es förderlicher, das Netzwerk die Diagrammstruktur selbst lernen zu lassen, um ein Modell mit besserer Leistung zu erhalten . #🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#Dreamerv2, Abbildung 3### 🎜🎜 ## 🎜🎜#Aufgrund TT Grundsätzlich werden alle Sequenzvorhersageaufgaben an den Transformer übergeben, und der Transformer kann aus den Daten flexibler eine bessere Diagrammstruktur erlernen. Wie in der folgenden Abbildung dargestellt, zeigen die von TT modellierten Verhaltensstrategien je nach Aufgaben und Datensatz unterschiedliche Diagrammstrukturen. Die linke Seite der Abbildung entspricht der traditionellen Markov-Strategie und die rechte Seite der Abbildung entspricht einer Action-Moving-Average-Strategie.

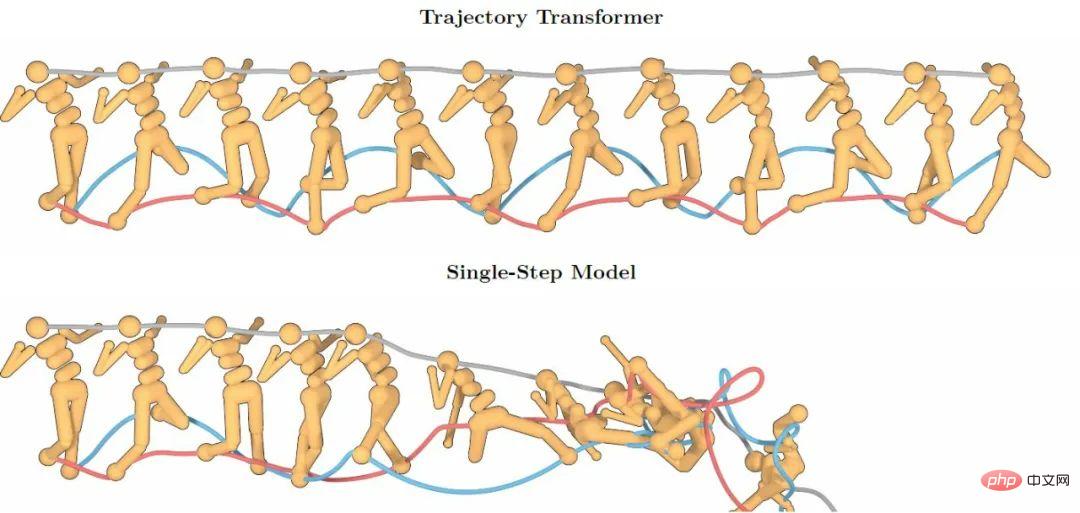

Flugbahntransformator, Abbildung 4# 🎜🎜#Die leistungsstarken Sequenzmodellierungsfunktionen von Transformer sorgen für eine höhere Genauigkeit der Modellierung langer Sequenzen. Die folgende Abbildung zeigt, dass die Vorhersagen von TT über 100 Schritte hinweg immer noch eine hohe Genauigkeit beibehalten, während sie den Markov-Eigenschaften folgen. Das einstufige Vorhersagemodell brach aufgrund des Problems schnell zusammen der Überlagerung von Vorhersagefehlern.

Flugbahntransformator, Abbildung 2

TT Obwohl es sich in Bezug auf die spezifische Modellierung und Vorhersage von herkömmlichen Methoden unterscheidet, bieten die Vorhersagefähigkeiten, die es bietet, dennoch einen guten Ausgangspunkt für andere Ergebnisse, die in der Zukunft mit Reinforcement Learning integriert werden. TT weist jedoch ein großes Problem hinsichtlich der Vorhersagegeschwindigkeit auf: Da es die Verteilung der gesamten Sequenz modellieren muss, werden alle Elemente in der Sequenz entsprechend den Dimensionen diskretisiert. Dies bedeutet, dass ein 100-dimensionaler Zustand 100 Elemente in der Sequenz belegen muss . Position, wodurch die tatsächliche Länge der modellierten Sequenz leicht besonders lang werden kann. Für Transformer beträgt die Rechenkomplexität für die Sequenzlänge N

, was das Abtasten einer Vorhersage für die Zukunft aus TT sehr teuer macht. Selbst eine TT-Aufgabe mit weniger als 100 Dimensionen benötigt mehrere Sekunden oder sogar mehrere zehn Sekunden, um eine einstufige Entscheidung zu treffen. Ein solches Modell lässt sich nur schwer in die Echtzeit-Robotersteuerung oder das Online-Lernen integrieren.

Gato ist ein von Deepmind veröffentlichtes „generalistisches Modell“, bei dem es sich eigentlich um ein modalübergreifendes Multitasking-Generierungsmodell handelt. Mit demselben Transformer können verschiedene Aufgaben erledigt werden, von der Beantwortung von Fragen in natürlicher Sprache über die Beschreibung von Bildern, das Spielen von Videospielen bis hin zur Robotersteuerung. Gatos Ansatz zur Modellierung der kontinuierlichen Steuerung ähnelt im Wesentlichen dem von TT. Es ist nur so, dass Gato kein Verstärkungslernen im engeren Sinne durchführt. Es modelliert lediglich die von der Expertenstrategie generierten Sequenzdaten und muss dann nur die nächste Aktion abtasten. Es handelt sich tatsächlich um eine Nachahmung der Expertenstrategie . #🎜🎜 ##### 🎜🎜 ## 🎜🎜 ## 🎜🎜##🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#g🎜🎜 ## 🎜🎜 ## 🎜🎜# Andere Modelle zur Sequenzgenerierung: Diffusionsmodell Das Diffusionsmodell erfreut sich in letzter Zeit im Bereich der Bildgenerierung großer Beliebtheit. DALLE-2 und Stable Diffusion basieren darauf zur Bilderzeugung. Diffuser hat diese Methode auch auf das Offline-Lernen zur Verstärkung angewendet. Die Idee ähnelt der von TT. Sie modelliert zunächst die bedingte Verteilung der Sequenz und probiert dann mögliche zukünftige Sequenzen basierend auf dem aktuellen Status aus.

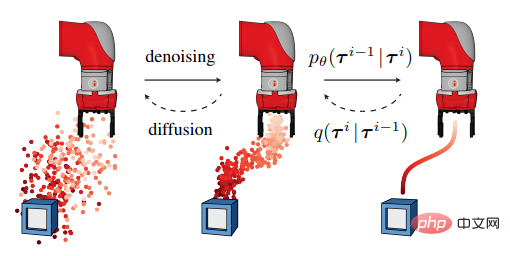

Das Diffusionsmodell erfreut sich in letzter Zeit im Bereich der Bildgenerierung großer Beliebtheit. DALLE-2 und Stable Diffusion basieren darauf zur Bilderzeugung. Diffuser hat diese Methode auch auf das Offline-Lernen zur Verstärkung angewendet. Die Idee ähnelt der von TT. Sie modelliert zunächst die bedingte Verteilung der Sequenz und probiert dann mögliche zukünftige Sequenzen basierend auf dem aktuellen Status aus.

Diffusor ist flexibler als TT: Er kann das Modell den Mittelweg ausfüllen lassen und gleichzeitig den Start- und Endpunkt festlegen, sodass eine zielorientierte Steuerung (anstatt die Belohnungsfunktion zu maximieren) erreicht werden kann. Es kann auch mehrere Ziele und A-priori-Bedingungen zum Erreichen der Ziele kombinieren, um dem Modell bei der Erfüllung der Aufgabe zu helfen.

Diffuser Abbildung 1Diffuser ist im Vergleich zum traditionellen Reinforcement-Learning-Modell auch ziemlich subversiv. Der von ihm generierte Plan entfaltet sich nicht allmählich auf der Zeitachse, sondern wird im Sinne der gesamten Sequenz unscharf. Allmählich präzise. Weitere Forschungen zum Diffusionsmodell selbst sind ebenfalls ein heißes Thema im Bereich Computer Vision, und es ist wahrscheinlich, dass es in den nächsten Jahren einen Durchbruch beim Modell selbst geben wird.

Allerdings weist das Diffusionsmodell selbst derzeit einen besonderen Nachteil im Vergleich zu Modellen anderer Generationen auf, nämlich dass seine Generierungsgeschwindigkeit langsamer ist als bei Modellen anderer Generationen. Viele Experten in verwandten Bereichen gehen davon aus, dass dies in den nächsten Jahren gemildert werden könnte. Allerdings ist die Generierungszeit von mehreren Sekunden derzeit für Szenarien, in denen Reinforcement Learning eine Echtzeitsteuerung erfordert, nur schwer zu akzeptieren. Diffuser schlug eine Methode vor, mit der die Generierungsgeschwindigkeit verbessert werden kann: Beginnen Sie mit dem Plan des vorherigen Schritts und fügen Sie eine kleine Menge Rauschen hinzu, um den Plan des nächsten Schritts neu zu generieren. Dadurch wird jedoch die Leistung des Modells bis zu einem gewissen Grad verringert.

Das obige ist der detaillierte Inhalt vonVom Transformer zum Diffusionsmodell: Erfahren Sie in einem Artikel mehr über Methoden des verstärkenden Lernens, die auf der Sequenzmodellierung basieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was ist schwieriger, C-Sprache oder Python?

Was ist schwieriger, C-Sprache oder Python?

Big-Data-Analysetools

Big-Data-Analysetools

Was sind die vier Big-Data-Analysetools?

Was sind die vier Big-Data-Analysetools?

Welche Software ist Dreamweaver?

Welche Software ist Dreamweaver?

Bitcoin-Explorer

Bitcoin-Explorer

Grundlegende Verwendung der Insert-Anweisung

Grundlegende Verwendung der Insert-Anweisung

Methode zur Steuerung eines Schrittmotors

Methode zur Steuerung eines Schrittmotors

Was ist die Tastenkombination zum Wechseln des Benutzers?

Was ist die Tastenkombination zum Wechseln des Benutzers?