Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Neue Stanford-Forschung: Das Modell hinter ChatGPT hat nachweislich einen menschlichen Geist

Neue Stanford-Forschung: Das Modell hinter ChatGPT hat nachweislich einen menschlichen Geist

Neue Stanford-Forschung: Das Modell hinter ChatGPT hat nachweislich einen menschlichen Geist

ChatGPT hat einen Verstand? ! „Die Theory of Mind (ToM), von der ursprünglich angenommen wurde, dass sie nur für den Menschen gilt, ist im KI-Modell hinter ChatGPT aufgetaucht.“

Dies ist die neueste ForschungsSchlussfolgerung der Stanford University, die schon bald große Auswirkungen hatte wie es veröffentlicht wurde Sensation im akademischen Kreis:Dieser Tag kam endlich unerwartet.

In dieser Studie stellte der Autor fest, dass:

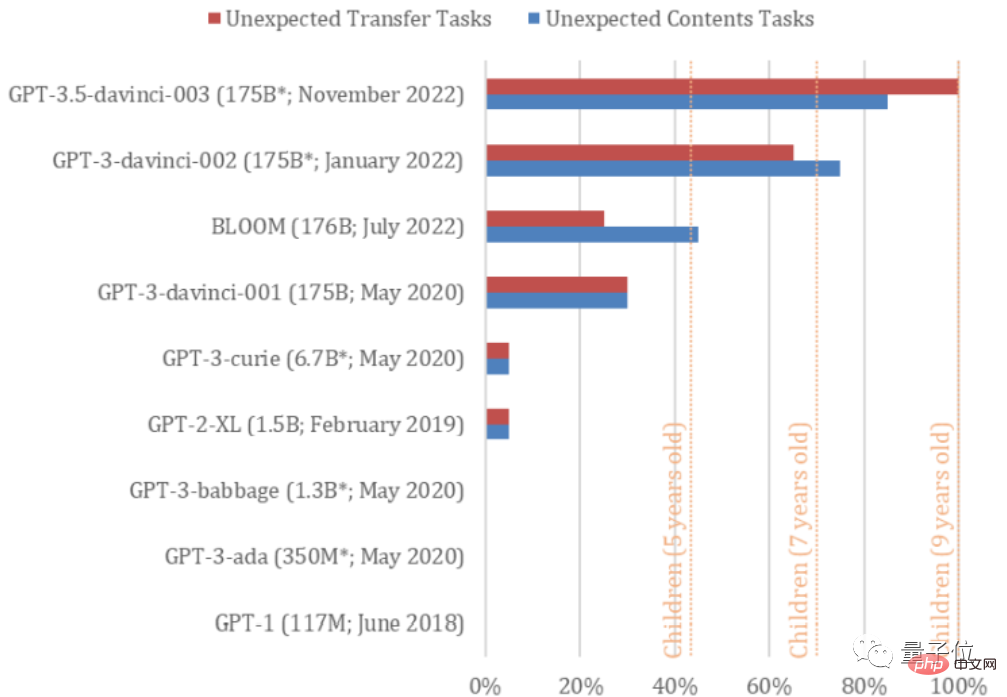

davinci-002-Version von GPT3 (für die ChatGPT optimiert ist) bereits 70 % der Theory-of-Mind-Aufgaben lösen kann, was einer 7-Jahres-Aufgabe entspricht. altes Kind;

GPT3.5 (davinci-003), das homologe Modell von ChatGPT, hat 93 % der Aufgaben gelöst, mit dem geistigen Äquivalent eines 9-jährigen Kindes!

Die Fähigkeit, solche Aufgaben zu lösen, wurde jedoch bei den Modellen der GPT-Serie erst ab 2022 gefunden.

Mit anderen Worten, ihr Geist hat sich tatsächlich „weiterentwickelt“.

GPT muss sehr schnell iterieren, und vielleicht wird es eines Tages ein Erwachsener sein. (Manueller Hundekopf)

Warum hat GPT-3.5 Ihrer Meinung nach einen Verstand?

Der Artikel trägt den Titel „Theory of Mind May Have Spontaneously Emerged in Large Language Models“.

Bei diesen beiden Aufgaben handelt es sich um universelle Tests, um festzustellen, ob Menschen über eine Theorie des Geistes verfügen. Studien haben beispielsweise gezeigt, dass Kinder mit Autismus oft Schwierigkeiten haben, solche Tests zu bestehen.

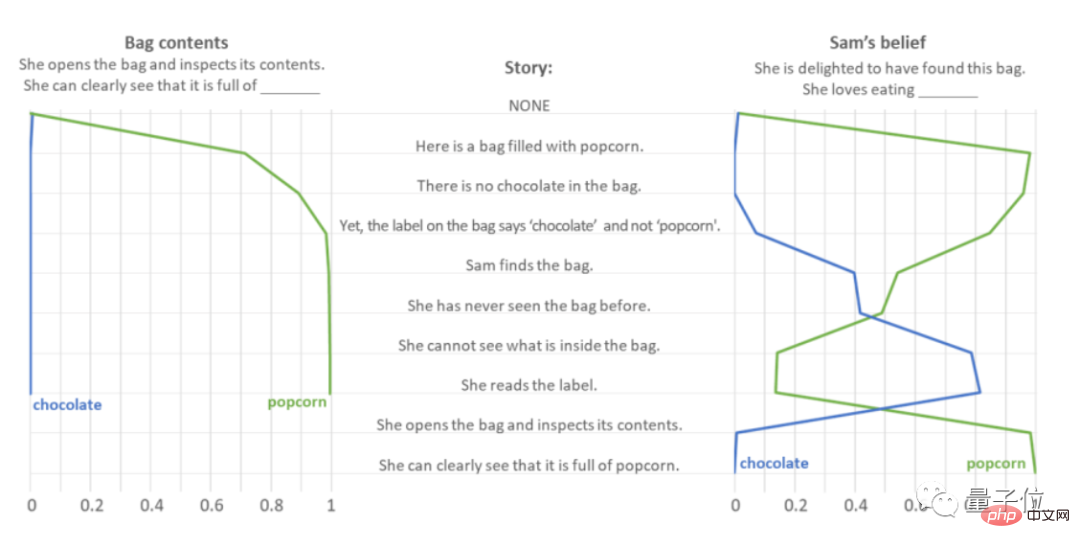

Der erste Test heißt Smarties Task (auch bekannt als Test auf unerwartete Inhalte). Wie der Name schon sagt, testet er das Urteilsvermögen der KI bei unerwarteten Dingen.

Nehmen Sie als Beispiel „Sie haben eine Schokoladentüte geöffnet und festgestellt, dass sie voller Popcorn war“.

Die Autoren gaben GPT-3.5 eine Reihe prompter Sätze und beobachteten, wie es Antworten auf die Fragen „Was ist in der Tüte?“ und „Sie war glücklich, als sie die Tüte fand. Was isst sie also gerne?“ vorhersagte.

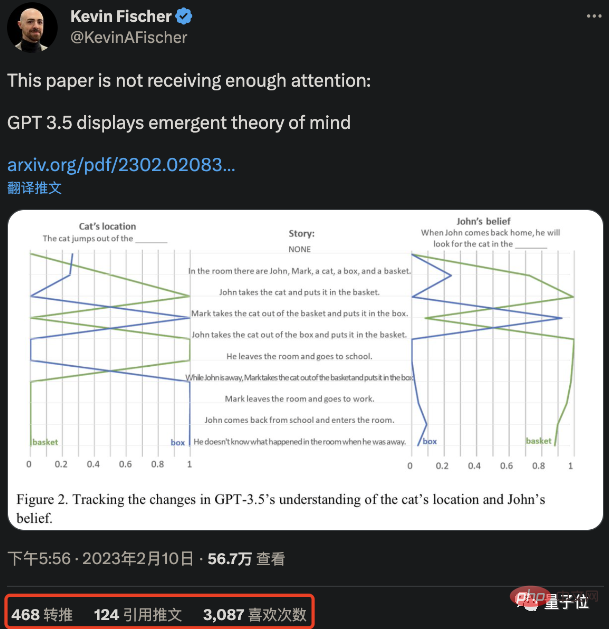

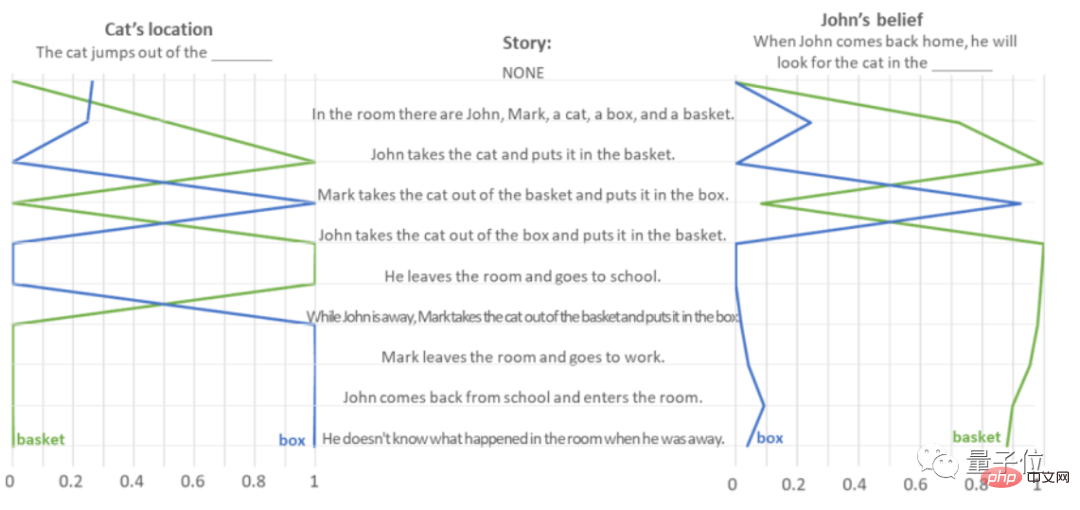

Tests zeigen, dass GPT-3.5 ohne Bedenken denkt: „Die Tüte enthält Popcorn.“ Was die Frage „Was isst sie gerne?“ betrifft, zeigte GPT-3.5 starkes Einfühlungsvermögen, insbesondere als es hörte „Sie konnte nicht sehen, was in der Verpackungstüte war“ und einmal dachte, sie liebe Schokolade , Die richtige Antwort wurde erst gegeben, als in dem Artikel deutlich wurde, dass „sie es mit Popcorn gefüllt vorfand“. Um zu verhindern, dass die richtige Antwort von GPT-3.5 ein Zufall ist – für den Fall, dass sie nur auf der Grundlage der Häufigkeit von Aufgabenwörtern vorhersagt, hat der Autor „Popcorn“ und „Schokolade“ vertauscht und es ebenfalls auf 10.000 gesetzt Beim Interferenztest wurde festgestellt, dass GPT-3.5 nicht nur auf der Grundlage der Worthäufigkeit vorhersagt. Was die gesamte Testfrage und -antwort „Unerwarteter Inhalt“ betrifft, hat GPT-3.5 17 der 20 Fragen erfolgreich beantwortet, mit einer Genauigkeitsrate von 85 %. Der zweite ist der Sally-Anne-Test (auch bekannt als Unexpected Transfer, unerwartete Transferaufgabe), der die Fähigkeit der KI testet, die Gedanken anderer Menschen vorherzusagen. Nehmen Sie als Beispiel „John legte die Katze in den Korb und ging, und Mark nutzte seine Abwesenheit, um die Katze aus dem Korb in die Kiste zu legen“. Der Autor hat GPT-3.5 gebeten, einen Textabschnitt zu lesen, um „den Standort der Katze“ und „Wohin wird John gehen, um die Katze zu finden, wenn er zurückkommt“ zu bestimmen? Inhalt lautet:

Bei dieser Art von Testaufgabe „zufällige Übertragung“ erreichte die Genauigkeit der GPT-3.5-Antworten 100 %, und es wurden 20 Aufgaben gut gelöst.

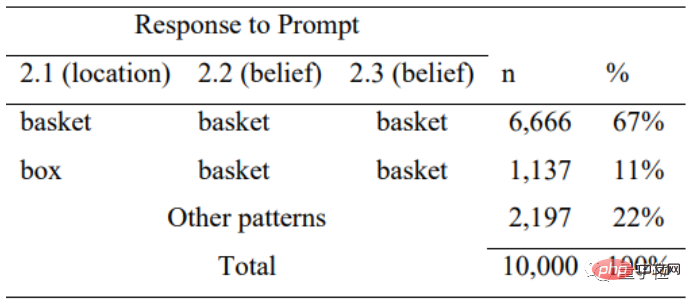

Um zu verhindern, dass GPT-3.5 erneut geblendet wird, stellte der Autor eine Reihe von „Lückenfüllfragen“ dafür zusammen und mischte die Reihenfolge der Wörter nach dem Zufallsprinzip, um zu testen, ob es antwortete zufällig basierend auf der Häufigkeit des Wortvorkommens.

Tests zeigen, dass GPT-3.5 bei unlogischen Fehlerbeschreibungen auch seine Logik verliert und nur in 11 % der Fälle richtig antwortet, was zeigt, dass es Antworten auf der Grundlage der Aussagelogik beurteilt.

Aber wenn Sie denken, dass diese Art von Frage sehr einfach ist und Sie sie mit jeder KI richtig beantworten können, liegen Sie völlig falsch.

Der Autor führte einen solchen Test an allen 9 Modellen der GPT-Serie durch und stellte fest, dass nur GPT-3.5 (davinci-003) und GPT-3 (neue Version im Januar 2022, davinci-002) eine gute Leistung erbrachten.

davinci-002 ist der „Oldtimer“ von GPT-3.5 und ChatGPT.

Im Durchschnitt erledigte davinci-002 70 % der Aufgaben, wobei das geistige Äquivalent eines 7-jährigen GPT-3.5-Kindes 85 % der unerwarteten Inhaltsaufgaben und 100 % der unerwarteten Übertragungsaufgaben erledigte (. durchschnittliche Abschlussquote 92,5 %. Der Verstand entspricht dem eines 9-jährigen Kindes.

Mehrere GPT-3-Modelle vor BLOOM waren jedoch sogar einem 5-jährigen Kind unterlegen und zeigten im Grunde keine Theory of Mind.

Der Autor glaubt, dass es in der GPT-Artikelreihe keinen Beweis dafür gibt, dass ihre Autoren dies „absichtlich“ getan haben. Mit anderen Worten, dies ist GPT-3.5 und die neue Version von GPT-3, um das zu vervollständigen Aufgabe. Die Fähigkeit zu lernen.

Nachdem ich diese Testdaten gelesen hatte, war die erste Reaktion von jemandem: Stopp (Forschung)!

Einige scherzten auch: Bedeutet das nicht, dass wir in Zukunft auch mit KI befreundet sein können?

Manche Leute stellen sich sogar die zukünftigen Fähigkeiten der KI vor: Können aktuelle KI-Modelle auch neues Wissen entdecken/neue Werkzeuge schaffen?

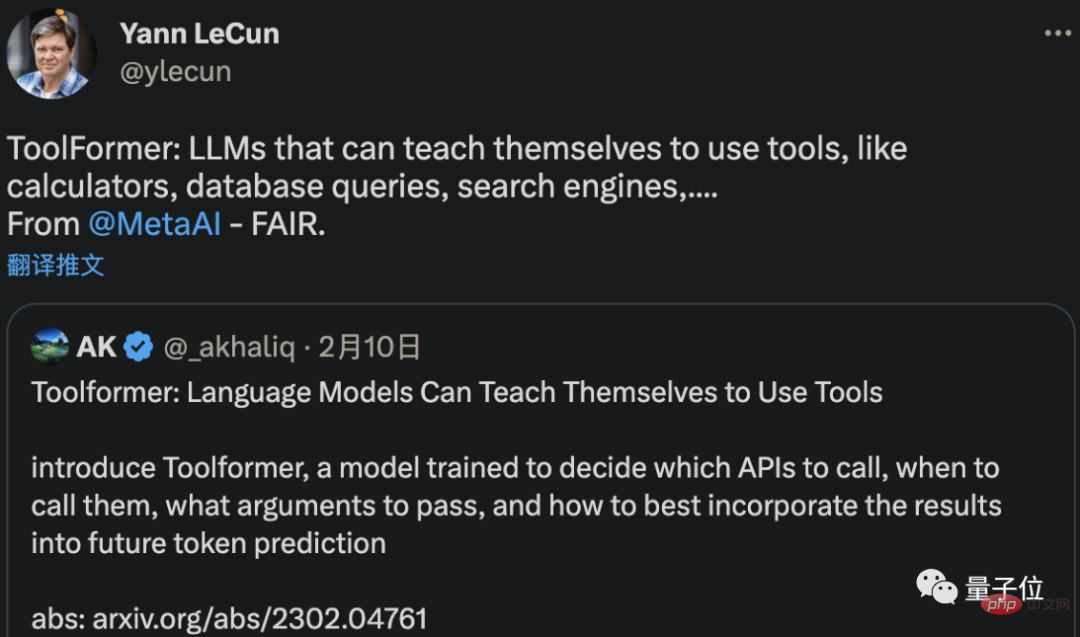

Es ist nicht unbedingt möglich, neue Werkzeuge zu erfinden, aber Meta AI hat tatsächlich eine KI entwickelt, die Werkzeuge selbst verstehen und lernen kann, sie zu verwenden.

Ein aktuelles Papier von LeCun zeigt, dass diese neue KI namens ToolFormer sich selbst beibringen kann, Computer, Datenbanken und Suchmaschinen zu nutzen, um die von ihr generierten Ergebnisse zu verbessern.

Einige Leute haben sogar die Worte des CEO von OpenAI zitiert, dass „AGI möglicherweise früher an unsere Tür klopft, als irgendjemand erwartet.“

Aber Moment, kann die KI diese beiden Tests wirklich bestehen, um zu zeigen, dass sie über eine „Theory of Mind“ verfügt?

Könnte es „vortäuschen“ sein?

Zum Beispiel dachte Liu Qun, ein Forscher am Institut für Computertechnologie der Chinesischen Akademie der Wissenschaften, nachdem er die Forschung gelesen hatte:

KI sollte einfach lernen, einen Verstand zu haben.

Wie beantwortet GPT-3.5 in diesem Fall diese Reihe von Fragen?

In diesem Zusammenhang äußerten einige Internetnutzer ihre eigenen Spekulationen:

Diese LLMs erzeugten kein Bewusstsein. Sie sagen lediglich einen eingebetteten semantischen Raum voraus, der auf den Ergebnissen tatsächlich bewusster Menschen basiert.

Tatsächlich hat der Autor selbst in dem Artikel auch seine eigene Vermutung geäußert.

Heutzutage werden große Sprachmodelle immer komplexer und können immer besser menschliche Sprache erzeugen und interpretieren. Sie entwickeln nach und nach Fähigkeiten wie die Theorie des Geistes.

Aber das bedeutet nicht, dass Modelle wie GPT-3.5 wirklich über eine Theorie des Geistes verfügen.

Im Gegenteil, auch wenn es nicht in das KI-System integriert ist, kann es durch Training als „Nebenprodukt“ erhalten werden.

Anstatt also zu untersuchen, ob GPT-3.5 wirklich einen Verstand hat oder einen Verstand zu haben scheint, müssen die Tests selbst stärker reflektiert werden –

Am besten ist es, die Gültigkeit des noch einmal zu prüfen Test zur Theorie des Geistes und die Schlussfolgerungen, die Psychologen seit Jahrzehnten auf der Grundlage dieser Tests ziehen:

Wenn KI diese Aufgaben ohne Theorie des Geistes erledigen kann, warum können Menschen dann nicht so sein wie sie?

Die Schlussfolgerung basiert tatsächlich auf KI-Tests, was eine umgekehrte Kritik am akademischen Kreis der Psychologie (Doge) darstellt.

Über den Autor

Es gibt nur einen Autor dieses Artikels, Michal Kosinski, außerordentlicher Professor für Organisationsverhalten an der Stanford University Graduate School of Business.

Seine Aufgabe ist es, mithilfe modernster Computermethoden, KI und Big Data den Menschen in der aktuellen digitalen Umgebung zu untersuchen (wie Professor Chen Yiran sagte, ist er Professor für Computerpsychologie).

Michal Kosinski hat einen Doktortitel in Psychologie und einen MA in Psychometrie und Sozialpsychologie von der University of Cambridge.

Vor seiner jetzigen Position absolvierte er ein Postdoc-Studium am Institut für Informatik der Stanford University, war stellvertretender Direktor des Center for Psychological Testing an der University of Cambridge und Forscher im Microsoft Research Machine Learning Gruppe.

Derzeit hat die Zahl der auf Google Scholar angezeigten Zitate von Michal Kosinskis Arbeiten 18.000+ erreicht.

Andererseits, glauben Sie, dass GPT-3.5 wirklich einen Verstand hat?

GPT3.5-Testadresse: https://platform.openai.com/playground

Das obige ist der detaillierte Inhalt vonNeue Stanford-Forschung: Das Modell hinter ChatGPT hat nachweislich einen menschlichen Geist. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1381

1381

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Das Neueste von der Universität Oxford! Mickey: 2D-Bildabgleich in 3D SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Das Neueste von der Universität Oxford! Mickey: 2D-Bildabgleich in 3D SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Projektlink vorne geschrieben: https://nianticlabs.github.io/mickey/ Anhand zweier Bilder kann die Kameraposition zwischen ihnen geschätzt werden, indem die Korrespondenz zwischen den Bildern hergestellt wird. Normalerweise handelt es sich bei diesen Entsprechungen um 2D-zu-2D-Entsprechungen, und unsere geschätzten Posen sind maßstabsunabhängig. Einige Anwendungen, wie z. B. Instant Augmented Reality jederzeit und überall, erfordern eine Posenschätzung von Skalenmetriken und sind daher auf externe Tiefenschätzer angewiesen, um die Skalierung wiederherzustellen. In diesem Artikel wird MicKey vorgeschlagen, ein Keypoint-Matching-Prozess, mit dem metrische Korrespondenzen im 3D-Kameraraum vorhergesagt werden können. Durch das Erlernen des 3D-Koordinatenabgleichs zwischen Bildern können wir auf metrische Relativwerte schließen

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins

Docker schließt die lokale Bereitstellung des großen Open-Source-Modells LLama3 in drei Minuten ab

Apr 26, 2024 am 10:19 AM

Docker schließt die lokale Bereitstellung des großen Open-Source-Modells LLama3 in drei Minuten ab

Apr 26, 2024 am 10:19 AM

Übersicht LLaMA-3 (LargeLanguageModelMetaAI3) ist ein groß angelegtes Open-Source-Modell für generative künstliche Intelligenz, das von Meta Company entwickelt wurde. Im Vergleich zur Vorgängergeneration LLaMA-2 gibt es keine wesentlichen Änderungen in der Modellstruktur. Das LLaMA-3-Modell ist in verschiedene Maßstabsversionen unterteilt, darunter kleine, mittlere und große, um unterschiedlichen Anwendungsanforderungen und Rechenressourcen gerecht zu werden. Die Parametergröße kleiner Modelle beträgt 8 B, die Parametergröße mittlerer Modelle beträgt 70 B und die Parametergröße großer Modelle erreicht 400 B. Beim Training besteht das Ziel jedoch darin, multimodale und mehrsprachige Funktionalität zu erreichen, und die Ergebnisse werden voraussichtlich mit GPT4/GPT4V vergleichbar sein. Ollama installierenOllama ist ein Open-Source-Großsprachenmodell (LL