Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Quantum CNN bietet eine hohe Testgenauigkeit für Datensätze, weist jedoch Einschränkungen auf

Quantum CNN bietet eine hohe Testgenauigkeit für Datensätze, weist jedoch Einschränkungen auf

Quantum CNN bietet eine hohe Testgenauigkeit für Datensätze, weist jedoch Einschränkungen auf

Bei der Bekanntgabe des Nobelpreises 2022 am 4. Oktober gewannen drei Wissenschaftler, Alain Aspect, John F. Clause und Anton Zeilinger, den Physikpreis für Quantenverschränkung, was im Bereich der Quantenforschung für Aufmerksamkeit und Diskussion von außen sorgte.

Unter anderem haben die Forschungsinvestitionen im Bereich Quantencomputing in den letzten Jahren erheblich zugenommen. Man hat damit begonnen, die Verwendung von Quantenmethoden zu erforschen, um bestehende klassische Computertechnologie in Bereichen wie Sicherheit und Netzwerkkommunikation zu untergraben.

Einige Forscher glauben, dass der Kern des Quantencomputings in der „Lösung klassischer Probleme durch Technologie mit geringeren Rechenkosten“ liegt. Mit der parallelen Entwicklung der Deep-Learning- und Quantencomputing-Forschung in den letzten Jahren haben auch viele Forscher begonnen, darauf zu achten Die Schnittstelle dieser beiden Bereiche: Quanten-Deep-Learning.

Kürzlich stellte Holly Emblem, Head of Insights bei Xbox Game Studio Rare, die bestehende Forschung und Anwendungen von Quantum Deep Learning in einem neuen Artikel „Quantum Deep Learning: A Quick Guide to Quantum Convolutional Neural Networks“ vor, der sich auf das konzentrierte Vor- und Nachteile von Quantum Convolutional Neural Networks (QCNN) im Vergleich zu klassischen Rechenmethoden werden diskutiert.

1 Der Unterschied zwischen klassischem Computing und Quantencomputing

Stellen Sie zunächst ein wichtiges Konzept über den Unterschied zwischen klassischem Computing und Quantencomputing vor. Wenn ein Programm auf einem klassischen Computer ausgeführt wird, wandelt ein Compiler die Programmanweisungen in binäre Bits um. Im Gegensatz zu einem klassischen Computer, bei dem Bits jederzeit entweder eine 1 oder eine 0 darstellen, können sich Qubits in beiden Zuständen befinden " Zwischen den Zuständen kollabiert das Qubit nur dann in einen seiner beiden Grundzustände 1 oder 0, wenn es gemessen wird.

Diese Eigenschaft wird Superposition genannt und spielt eine entscheidende Rolle bei Quantencomputeraufgaben. Durch Überlagerung können Quantencomputer Aufgaben parallel ausführen, ohne dass für die Ausführung eine vollständig parallele Architektur oder GPU erforderlich ist. Der Grund dafür ist, dass, wenn jeder Overlay-Status einem anderen Wert entspricht und eine Operation für den Overlay-Status ausgeführt wird, die Operation für alle Zustände gleichzeitig ausgeführt wird.

Hier ist ein Beispiel für die Überlagerung von Quantenzuständen:

Die Überlagerung von Quantenzuständen ist exponentiell, a und b beziehen sich auf Wahrscheinlichkeitsgrößen, die die Wahrscheinlichkeit der Projektion in einen Zustand angeben, sobald eine Messung durchgeführt wurde. Unter ihnen werden Überlagerungsquantenzustände mithilfe von Quantenlogikgattern erzeugt.

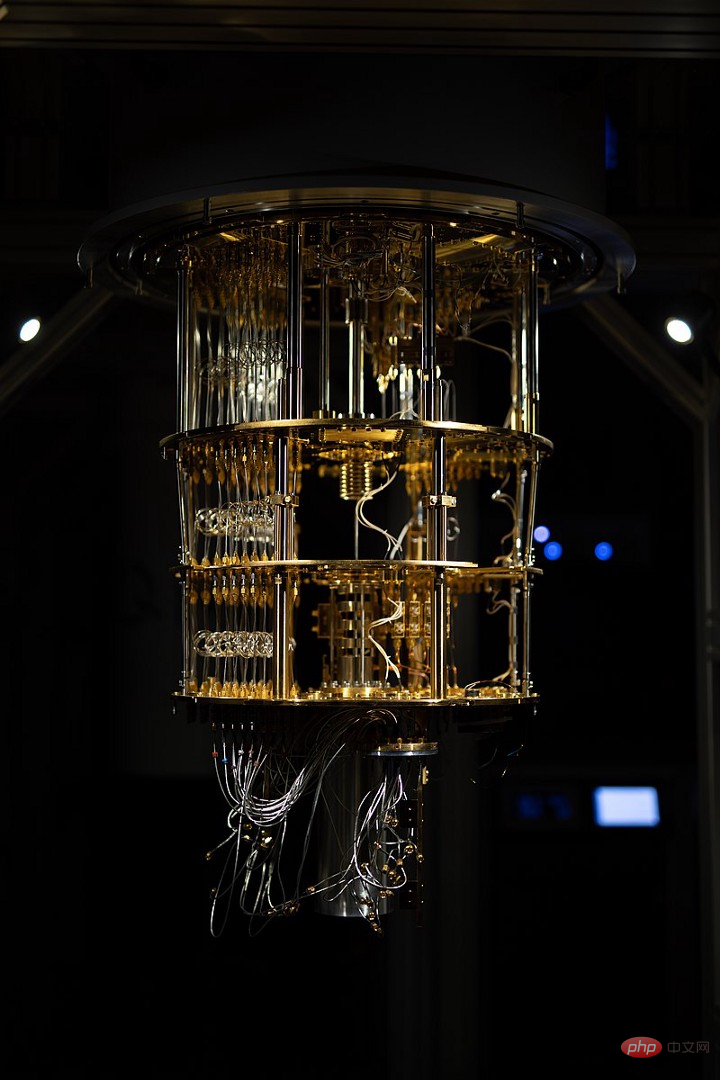

Bildunterschrift: Ragsxl IQM-Quantencomputer in Espoo, Finnland

2 Verschränkung und Bell-Zustände

Überlagerung ist in der Quantenphysik sehr wichtig, und ein weiteres Schlüsselprinzip ist die Verschränkung.

Verschränkung bezieht sich auf das Verhalten, das auf irgendeine Weise eine Wechselwirkung zwischen zwei oder mehr Teilchen erzeugt oder verursacht, was bedeutet, dass die Quantenzustände dieser Teilchen nicht mehr unabhängig voneinander beschrieben werden können, selbst wenn sie weit voneinander entfernt sind. Wenn Partikel verschränkt sind und ein Partikel gemessen wird, wird das andere Partikel, mit dem es verschränkt ist, sofort als entgegengesetzter Zustand gemessen (diese Partikel haben keinen lokalen Zustand).

Während sich das Verständnis von Qubits und der Verschränkung entwickelt, diskutieren wir dann die Bell-Zustände. Das Folgende zeigt den maximalen Verschränkungszustand von Qubits:

|00 → β → 1 √ 2 (|00 + |11 ) = | β00 ,

|01 → β → 1 √ 2 (|01 + |10 ) = |β01

|10 → β → 1 √ 2 (| 00 - |11 ) = |β10

|11 → β → 1 √ 2 (|01 - |10 ) = |β11

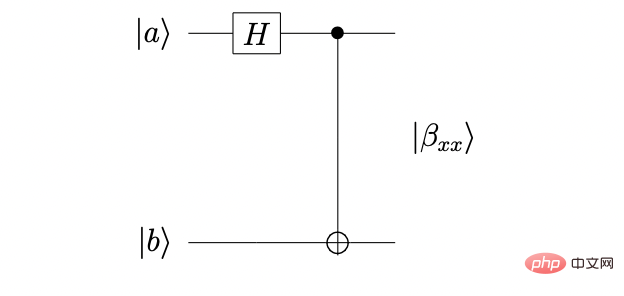

Verwenden Sie Quantenschaltkreise, um Bell-Zustände zu erzeugen:

Bildunterschrift: Bell-Zustandsschaltkreis in Perry's Temple of Quantum Computing

In der gezeigten Bell-Zustandsschaltung wird ein Qubit-Eingang verwendet und Hadamard-Gatter und CNOT-Gatter angewendet, um einen verschränkten Bell-Zustand zu erzeugen.

Derzeit werden Bell-Zustände zur Entwicklung einer Reihe von Quantencomputeranwendungen verwendet, darunter Hegazy, Bahaa-Eldin und Dakroury die Theorie, dass Bell-Zustände und ultradichte Codierung verwendet werden können, um „bedingungslose Sicherheit“ zu erreichen. .

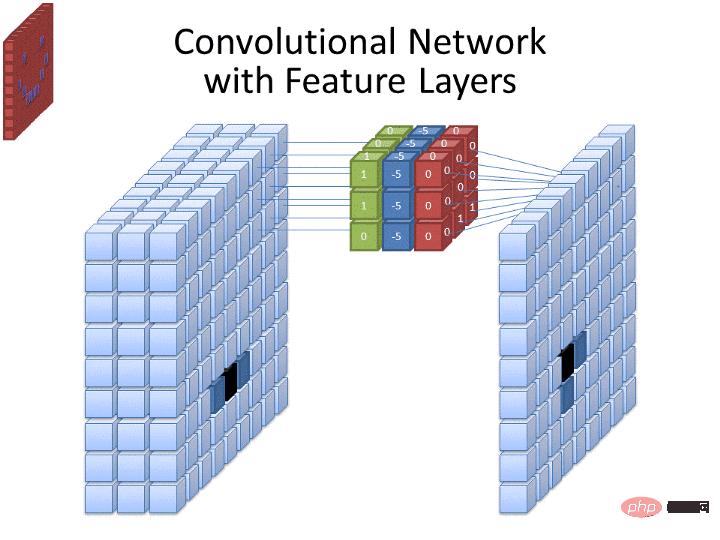

3 Der Aufbau von Musterhierarchien, z. B. die Darstellung von Linien zuerst und dann der Kanten dieser Linien, ermöglicht es CNNs, auf Informationen zwischen Ebenen aufzubauen und komplexe visuelle Daten darzustellen.

CNN verfügt über Faltungsschichten, die aus Filtern bestehen, die durch die Eingabe „gleiten“ und „Feature Maps“ erzeugen, die die Erkennung von Mustern in der Eingabe ermöglichen. Gleichzeitig kann CNN Pooling-Layer verwenden, um die Größe von Feature-Maps zu reduzieren und dadurch die für das Lernen erforderlichen Ressourcen zu reduzieren.

Bildunterschrift: Convolutional Neural Network demonstriert von Cecbur

Nachdem wir das klassische CNN definiert haben, können wir untersuchen, wie Quanten-CNN (Quantum Convolutional Neural Network, QCNN) diese Traditionsmethode nutzt und erweitert.

Garg und Ramakrishnan glauben, dass ein gemeinsamer Ansatz zur Entwicklung neuronaler Quantennetze darin besteht, einen „hybriden“ Ansatz zu entwickeln, der sogenannte „Quantenfaltungsschichten“ einführt, bei denen es sich um Transformationen handelt, die auf zufälligen Quantenschaltungen basieren. Erscheint als Ergänzung -on im klassischen CNN.

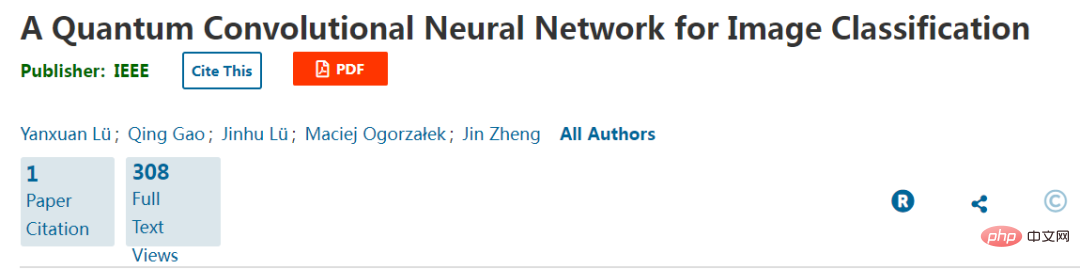

Das Folgende zeigt das hybride QCNN, das von Yanxuan Lü und anderen Forschern entwickelt und am MNIST-Datensatz handgeschriebener Ziffern getestet wurde:

In der Arbeit „A Quantum Convolutional Neural Network for Image Classification“ haben die Forscher Quantenschaltungen übernommen und Verschränkung wird als Teil eines klassischen Modells verwendet, um Eingabebilder aufzunehmen und Vorhersagen als Ausgaben zu generieren. Bei dieser Methode nimmt QCNN Bilddaten als Eingabe und kodiert sie in den Quantenzustand | Schaltungen und Vorhersagen aus Messungen.

Wobei die Optimierung durch stochastischen Gradientenabstieg (SGD) erfolgt, der verwendet werden kann, um den Unterschied zwischen Trainingsdatenbezeichnungen und QCNN-vorhergesagten Bezeichnungen zu verringern. Mit Fokus auf Quantenschaltungen werden in der Quantenfaltungsschicht folgende Gatter verwendet, einschließlich Rotationsoperatoren und CNOT-Gatter.

Messen Sie eine Teilmenge von Qubits in der Pooling-Schicht, und das Ergebnis bestimmt, ob ein einzelnes Qubit-Gate auf seine benachbarten Bits angewendet werden soll:

Die vollständig verbundene Schicht besteht aus einem „universellen einzelnen Qubit-Gate“ und zusammengesetzt von CNOT-Gattern, die verschränkte Zustände erzeugen, verwendeten die Forscher den MNIST-Datensatz mit simuliertem QCNN. Nach dem typischen Ansatz haben wir einen Trainings-/Testdatensatz erstellt und ein QCNN entwickelt, das aus den folgenden Schichten besteht:

2 Quantenfaltungsschichten

2 Quantenpooling-Schichten

1 vollständig verbundene Quantenschicht

- Die Testsatzgenauigkeit dieses QCNN für den Datensatz erreichte 96,65 %, und nach Tests gemäß den Daten von Papers with Code kann die höchste Genauigkeitsbewertung dieses Datensatzes im klassischen CNN 99,91 % erreichen.

- Es ist zu beachten, dass in diesem Experiment nur zwei Arten von MNIST-Datensätzen klassifiziert wurden, was bedeutet, dass es Einschränkungen beim vollständigen Vergleich der Leistung mit der Leistung anderer MNIST-Modelle geben wird.

-

4 Machbarkeitsbewertung und Zusammenfassung

Obwohl Forscher Methoden in QCNN entwickelt haben, besteht ein zentrales Problem auf diesem Gebiet derzeit darin, dass die für die Implementierung des theoretischen Modells erforderliche Hardware noch nicht vorhanden ist. Darüber hinaus stehen Hybridmethoden auch vor Herausforderungen beim Testen von Methoden, die gleichzeitig Quantenentwicklungsschichten in klassische CNN-Berechnungen einführen.

Wenn wir bedenken, dass einer der Vorteile des Quantencomputings die Fähigkeit ist, „klassisch unlösbare Probleme mit rechentechnisch günstigeren Techniken“ zu lösen, dann liegt ein wichtiger Aspekt dieser Lösungen in der „Quantenbeschleunigung“. Einige Forscher glauben, dass der Vorteil des quantenmechanischen Lernens im Vergleich zur klassischen Implementierung darin besteht, dass von Quantenalgorithmen polynomielle oder sogar exponentielle Beschleunigungszeiten erwartet werden.

Eine Einschränkung der oben gezeigten QCNN-Methode besteht jedoch darin, dass der „Quantenbeschleunigungsgewinn“ begrenzt ist, wenn wir Algorithmen (wie QCNN) benötigen, die klassische Daten und Messungen konsistent dekodieren/kodieren viele Informationen darüber, wie man die beste Kodierung/Dekodierung und Protokolle entwirft, die nur minimale Messungen erfordern, damit sie von der „Quantenbeschleunigung“ profitieren können.

Verschränkung hat sich als eine wichtige Eigenschaft des quantenmechanischen Lernens erwiesen. Die in diesem Artikel erwähnte Forschung über QCNN mit starken Verschränkungsschaltungen kann als vollständig verbundene Schicht verschränkte Zustände erzeugen, wodurch das Modell Vorhersagen treffen kann. Darüber hinaus wird die Verschränkung auch zur Unterstützung von Deep-Learning-Modellen in anderen Bereichen eingesetzt, beispielsweise bei der Extraktion wichtiger Merkmale aus Bildern. Die Verwendung der Verschränkung in Datensätzen kann dazu führen, dass Modelle aus kleineren Trainingsdatensätzen lernen können als bisher erwartet .

Dieser Artikel bietet einen Vergleich zwischen klassischen Deep-Learning-Methoden und Quanten-Deep-Learning-Methoden, erörtert QCNN, das Quantenschichten (einschließlich stark verschränkter Schaltkreise) zur Generierung von Vorhersagen nutzt, analysiert die Vorteile und Grenzen von Quanten-Deep-Learning und stellt die Verschränkung vor Wenn wir uns auf allgemeinere Anwendungen im maschinellen Lernen konzentrieren, bedeutet dies auch, dass wir über die nächsten Schritte für Quanten-Deep-Learning nachdenken können, insbesondere über die Anwendung von QCNN in weiteren Bereichen. Darüber hinaus wird auch die Quantenhardware ständig verbessert, und Unternehmen wie PsiQuantum haben sogar das Ziel vorgeschlagen, einen Quantenprozessor mit einer Million Qubits zu entwickeln.

Da die Forschung in den Bereichen Deep Learning und Quantencomputing weitergeht, können wir mit weiteren Entwicklungen im Quanten-Deep-Learning rechnen.

Das obige ist der detaillierte Inhalt vonQuantum CNN bietet eine hohe Testgenauigkeit für Datensätze, weist jedoch Einschränkungen auf. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Methoden und Schritte zur Verwendung von BERT für die Stimmungsanalyse in Python

Jan 22, 2024 pm 04:24 PM

Methoden und Schritte zur Verwendung von BERT für die Stimmungsanalyse in Python

Jan 22, 2024 pm 04:24 PM

BERT ist ein vorab trainiertes Deep-Learning-Sprachmodell, das 2018 von Google vorgeschlagen wurde. Der vollständige Name lautet BidirektionalEncoderRepresentationsfromTransformers, der auf der Transformer-Architektur basiert und die Eigenschaften einer bidirektionalen Codierung aufweist. Im Vergleich zu herkömmlichen Einweg-Codierungsmodellen kann BERT bei der Textverarbeitung gleichzeitig Kontextinformationen berücksichtigen, sodass es bei Verarbeitungsaufgaben in natürlicher Sprache eine gute Leistung erbringt. Seine Bidirektionalität ermöglicht es BERT, die semantischen Beziehungen in Sätzen besser zu verstehen und dadurch die Ausdrucksfähigkeit des Modells zu verbessern. Durch Vorschulungs- und Feinabstimmungsmethoden kann BERT für verschiedene Aufgaben der Verarbeitung natürlicher Sprache verwendet werden, wie z. B. Stimmungsanalyse und Benennung

Analyse häufig verwendeter KI-Aktivierungsfunktionen: Deep-Learning-Praxis von Sigmoid, Tanh, ReLU und Softmax

Dec 28, 2023 pm 11:35 PM

Analyse häufig verwendeter KI-Aktivierungsfunktionen: Deep-Learning-Praxis von Sigmoid, Tanh, ReLU und Softmax

Dec 28, 2023 pm 11:35 PM

Aktivierungsfunktionen spielen beim Deep Learning eine entscheidende Rolle. Sie können nichtlineare Eigenschaften in neuronale Netze einführen und es dem Netz ermöglichen, komplexe Eingabe-Ausgabe-Beziehungen besser zu lernen und zu simulieren. Die richtige Auswahl und Verwendung von Aktivierungsfunktionen hat einen wichtigen Einfluss auf die Leistung und Trainingsergebnisse neuronaler Netze. In diesem Artikel werden vier häufig verwendete Aktivierungsfunktionen vorgestellt: Sigmoid, Tanh, ReLU und Softmax. Beginnend mit der Einführung, den Verwendungsszenarien und den Vorteilen. Nachteile und Optimierungslösungen werden besprochen, um Ihnen ein umfassendes Verständnis der Aktivierungsfunktionen zu vermitteln. 1. Sigmoid-Funktion Einführung in die Sigmoid-Funktionsformel: Die Sigmoid-Funktion ist eine häufig verwendete nichtlineare Funktion, die jede reelle Zahl auf Werte zwischen 0 und 1 abbilden kann. Es wird normalerweise verwendet, um das zu vereinheitlichen

Latente Raumeinbettung: Erklärung und Demonstration

Jan 22, 2024 pm 05:30 PM

Latente Raumeinbettung: Erklärung und Demonstration

Jan 22, 2024 pm 05:30 PM

Latent Space Embedding (LatentSpaceEmbedding) ist der Prozess der Abbildung hochdimensionaler Daten auf niedrigdimensionalen Raum. Im Bereich des maschinellen Lernens und des tiefen Lernens handelt es sich bei der Einbettung latenter Räume normalerweise um ein neuronales Netzwerkmodell, das hochdimensionale Eingabedaten in einen Satz niedrigdimensionaler Vektordarstellungen abbildet. Dieser Satz von Vektoren wird oft als „latente Vektoren“ oder „latent“ bezeichnet Kodierungen". Der Zweck der Einbettung latenter Räume besteht darin, wichtige Merkmale in den Daten zu erfassen und sie in einer prägnanteren und verständlicheren Form darzustellen. Durch die Einbettung latenter Räume können wir Vorgänge wie das Visualisieren, Klassifizieren und Clustern von Daten im niedrigdimensionalen Raum durchführen, um die Daten besser zu verstehen und zu nutzen. Die Einbettung latenter Räume findet in vielen Bereichen breite Anwendung, z. B. bei der Bilderzeugung, der Merkmalsextraktion, der Dimensionsreduzierung usw. Die Einbettung des latenten Raums ist das Wichtigste

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Heute diskutieren wir darüber, wie Deep-Learning-Technologie die Leistung von visionbasiertem SLAM (Simultaneous Localization and Mapping) in komplexen Umgebungen verbessern kann. Durch die Kombination von Methoden zur Tiefenmerkmalsextraktion und Tiefenanpassung stellen wir hier ein vielseitiges hybrides visuelles SLAM-System vor, das die Anpassung in anspruchsvollen Szenarien wie schlechten Lichtverhältnissen, dynamischer Beleuchtung, schwach strukturierten Bereichen und starkem Jitter verbessern soll. Unser System unterstützt mehrere Modi, einschließlich erweiterter Monokular-, Stereo-, Monokular-Trägheits- und Stereo-Trägheitskonfigurationen. Darüber hinaus wird analysiert, wie visuelles SLAM mit Deep-Learning-Methoden kombiniert werden kann, um andere Forschungen zu inspirieren. Durch umfangreiche Experimente mit öffentlichen Datensätzen und selbst abgetasteten Daten demonstrieren wir die Überlegenheit von SL-SLAM in Bezug auf Positionierungsgenauigkeit und Tracking-Robustheit.

Sehen Sie sich von den Grundlagen bis zur Praxis die Entwicklungsgeschichte des Elasticsearch-Vektorabrufs an

Oct 23, 2023 pm 05:17 PM

Sehen Sie sich von den Grundlagen bis zur Praxis die Entwicklungsgeschichte des Elasticsearch-Vektorabrufs an

Oct 23, 2023 pm 05:17 PM

1. Einleitung Die Vektorabfrage ist zu einem Kernbestandteil moderner Such- und Empfehlungssysteme geworden. Es ermöglicht einen effizienten Abfrageabgleich und Empfehlungen, indem es komplexe Objekte (wie Text, Bilder oder Töne) in numerische Vektoren umwandelt und Ähnlichkeitssuchen in mehrdimensionalen Räumen durchführt. Schauen Sie sich von den Grundlagen bis zur Praxis die Entwicklungsgeschichte von Elasticsearch Vector Retrieval_elasticsearch an. Als beliebte Open-Source-Suchmaschine hat die Entwicklung von Elasticsearch im Bereich Vektor Retrieval schon immer große Aufmerksamkeit erregt. In diesem Artikel wird die Entwicklungsgeschichte des Elasticsearch-Vektorabrufs untersucht, wobei der Schwerpunkt auf den Merkmalen und dem Fortschritt jeder Phase liegt. Wenn Sie sich an der Geschichte orientieren, ist es für jeden praktisch, eine umfassende Palette zum Abrufen von Elasticsearch-Vektoren einzurichten.

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

Verstehen Sie in einem Artikel: die Zusammenhänge und Unterschiede zwischen KI, maschinellem Lernen und Deep Learning

Mar 02, 2024 am 11:19 AM

In der heutigen Welle rasanter technologischer Veränderungen sind künstliche Intelligenz (KI), maschinelles Lernen (ML) und Deep Learning (DL) wie helle Sterne und führen die neue Welle der Informationstechnologie an. Diese drei Wörter tauchen häufig in verschiedenen hochaktuellen Diskussionen und praktischen Anwendungen auf, aber für viele Entdecker, die neu auf diesem Gebiet sind, sind ihre spezifische Bedeutung und ihre internen Zusammenhänge möglicherweise noch immer rätselhaft. Schauen wir uns also zunächst dieses Bild an. Es ist ersichtlich, dass zwischen Deep Learning, maschinellem Lernen und künstlicher Intelligenz ein enger Zusammenhang und eine fortschreitende Beziehung besteht. Deep Learning ist ein spezifischer Bereich des maschinellen Lernens und des maschinellen Lernens

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Super stark! Top 10 Deep-Learning-Algorithmen!

Mar 15, 2024 pm 03:46 PM

Fast 20 Jahre sind vergangen, seit das Konzept des Deep Learning im Jahr 2006 vorgeschlagen wurde. Deep Learning hat als Revolution auf dem Gebiet der künstlichen Intelligenz viele einflussreiche Algorithmen hervorgebracht. Was sind Ihrer Meinung nach die zehn besten Algorithmen für Deep Learning? Im Folgenden sind meiner Meinung nach die besten Algorithmen für Deep Learning aufgeführt. Sie alle nehmen hinsichtlich Innovation, Anwendungswert und Einfluss eine wichtige Position ein. 1. Hintergrund des Deep Neural Network (DNN): Deep Neural Network (DNN), auch Multi-Layer-Perceptron genannt, ist der am weitesten verbreitete Deep-Learning-Algorithmus. Als er erstmals erfunden wurde, wurde er aufgrund des Engpasses bei der Rechenleistung in Frage gestellt Jahre, Rechenleistung, Der Durchbruch kam mit der Datenexplosion. DNN ist ein neuronales Netzwerkmodell, das mehrere verborgene Schichten enthält. In diesem Modell übergibt jede Schicht Eingaben an die nächste Schicht und

AlphaFold 3 wird auf den Markt gebracht und sagt die Wechselwirkungen und Strukturen von Proteinen und allen Lebensmolekülen umfassend und mit weitaus größerer Genauigkeit als je zuvor voraus

Jul 16, 2024 am 12:08 AM

AlphaFold 3 wird auf den Markt gebracht und sagt die Wechselwirkungen und Strukturen von Proteinen und allen Lebensmolekülen umfassend und mit weitaus größerer Genauigkeit als je zuvor voraus

Jul 16, 2024 am 12:08 AM

Herausgeber | Rettichhaut Seit der Veröffentlichung des leistungsstarken AlphaFold2 im Jahr 2021 verwenden Wissenschaftler Modelle zur Proteinstrukturvorhersage, um verschiedene Proteinstrukturen innerhalb von Zellen zu kartieren, Medikamente zu entdecken und eine „kosmische Karte“ jeder bekannten Proteininteraktion zu zeichnen. Gerade hat Google DeepMind das AlphaFold3-Modell veröffentlicht, das gemeinsame Strukturvorhersagen für Komplexe wie Proteine, Nukleinsäuren, kleine Moleküle, Ionen und modifizierte Reste durchführen kann. Die Genauigkeit von AlphaFold3 wurde im Vergleich zu vielen dedizierten Tools in der Vergangenheit (Protein-Ligand-Interaktion, Protein-Nukleinsäure-Interaktion, Antikörper-Antigen-Vorhersage) deutlich verbessert. Dies zeigt, dass dies innerhalb eines einzigen einheitlichen Deep-Learning-Frameworks möglich ist