Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Multimodalität wieder vereint! Meta veröffentlicht selbstüberwachten Algorithmus data2vec 2.0: Trainingseffizienz um das bis zu 16-fache erhöht!

Multimodalität wieder vereint! Meta veröffentlicht selbstüberwachten Algorithmus data2vec 2.0: Trainingseffizienz um das bis zu 16-fache erhöht!

Multimodalität wieder vereint! Meta veröffentlicht selbstüberwachten Algorithmus data2vec 2.0: Trainingseffizienz um das bis zu 16-fache erhöht!

Die meisten Durchbrüche auf dem Gebiet der künstlichen Intelligenz wurden in den letzten Jahren durch selbstüberwachtes Lernen vorangetrieben, zum Beispiel durch das in BERT vorgeschlagene MLM (Masked Language Model), bei dem einige Wörter im Text maskiert und dann erneut verwendet werden -Vorhersage, massive unbeschriftete Textdaten können zum Trainieren von Modellen verwendet werden, was seitdem eine neue Ära groß angelegter vorab trainierter Modelle eröffnet hat. Selbstüberwachte Lernalgorithmen weisen jedoch auch offensichtliche Einschränkungen auf. Sie eignen sich normalerweise nur für Daten in einer einzigen Modalität (z. B. Bilder, Text, Sprache usw.) und erfordern viel Rechenleistung, um aus großen Datenmengen zu lernen. Im Gegensatz dazu lernt der Mensch deutlich effizienter als aktuelle KI-Modelle und kann aus unterschiedlichen Datentypen lernen.

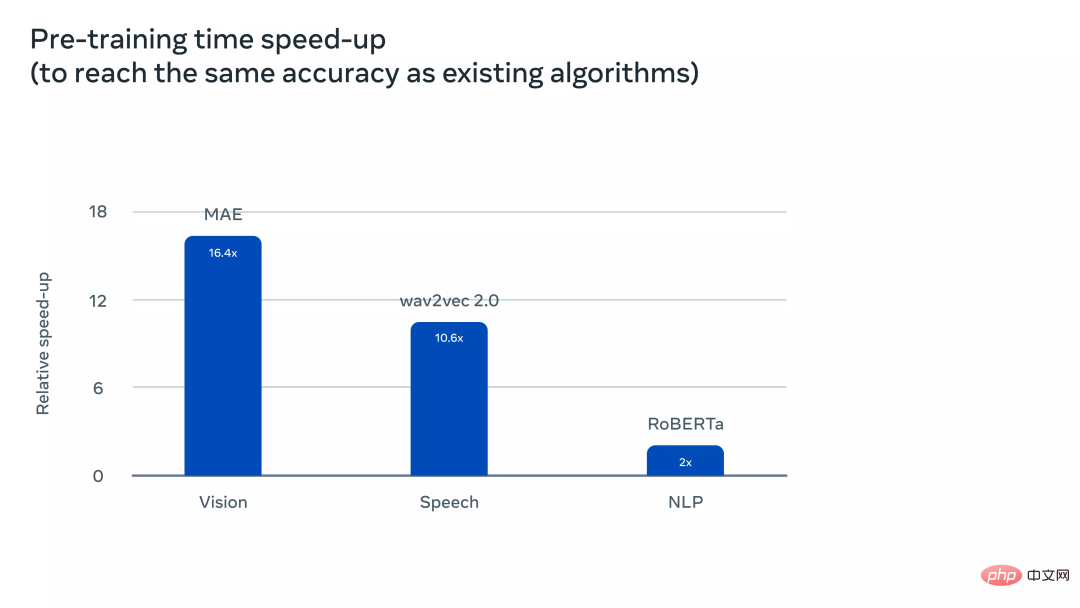

Im Januar 2022 veröffentlichte Meta AI das selbstüberwachte Lernframework data2vec, das drei Datenmodalitäten (Sprache, Bild und Text) über ein Framework integriert. Es gibt ein Tendenz zur Vereinheitlichung der Multimodalität. Kürzlich veröffentlichte Meta AI data2cec Version 2.0 , die die vorherige Generation vor allem hinsichtlich der Leistung verbesserte: Bei gleicher Genauigkeit wird die Trainingsgeschwindigkeit mit anderen verglichen Der Algorithmus wurde um das bis zu 16-fache verbessert! ??

effizient -Selbstüberwachtes-Lernen-mit-kontextualisierten-Zieldarstellungen-für-Vision-Sprache-und-Sprache Code-Link:

Code-Link:

https://github.com /facebookresearch/fairseq/tree/main/examples/data2vecdata2vec 1.0

Derzeit basieren die meisten Modelle für maschinelles Lernen noch auf überwachten Lernmodellen, die dediziert erforderlich sind Annotatoren können Zieldaten kennzeichnen, aber für einige Aufgaben (z. B. die Tausenden menschlicher Sprachen auf dem Planeten) ist das Sammeln gekennzeichneter Daten nicht möglich. Im Gegensatz dazu muss selbstüberwachtes Lernen dem Modell nicht sagen, was richtig und falsch ist, sondern ermöglicht es der Maschine, die Struktur von Bildern, Sprache und Text durch Beobachtung der Welt zu lernen. Verwandte Forschungsergebnisse haben die Entwicklung von Sprache (z. B. wave2vec 2.0), Computer Vision (z. B. maskierter Autoencoder) und Verarbeitung natürlicher Sprache (z. B. BERT) gefördert.

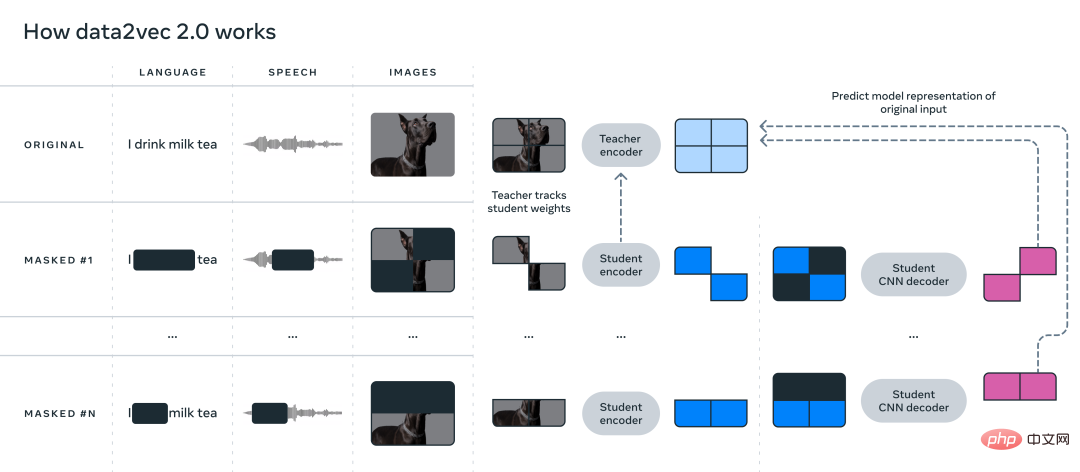

Die Hauptidee von data2vec besteht darin, zunächst ein Lehrernetzwerk aufzubauen und zunächst die Zieldarstellung aus Bildern, Text oder Sprache zu berechnen. Die Daten werden dann maskiert, um Teile der Eingabe zu verdecken, und der Vorgang wird mit einem Schülernetzwerk wiederholt, um die vom Lehrermodell erhaltenen Darstellungen vorherzusagen.

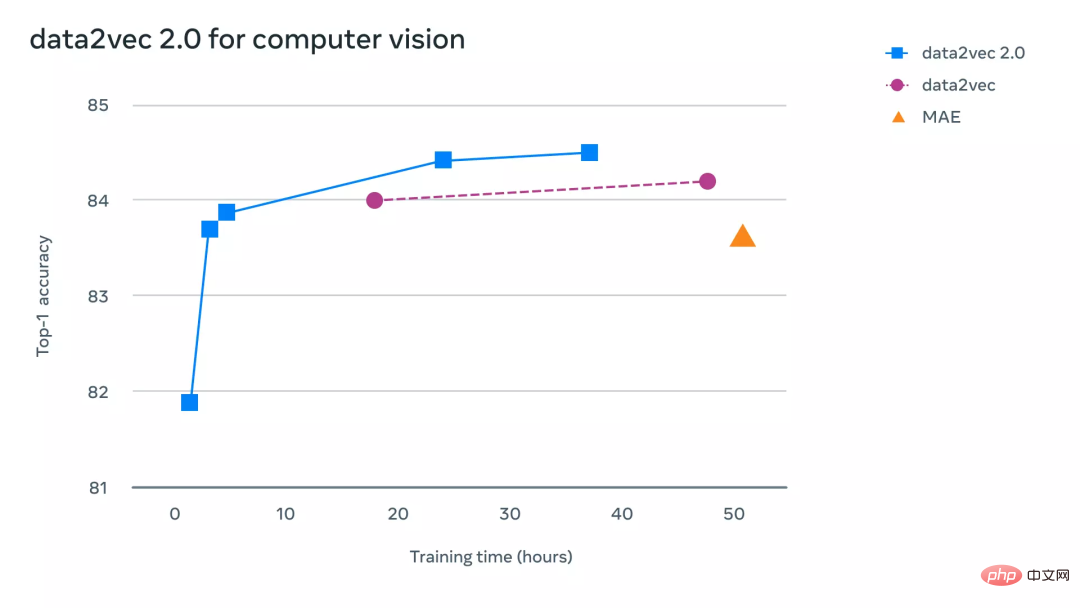

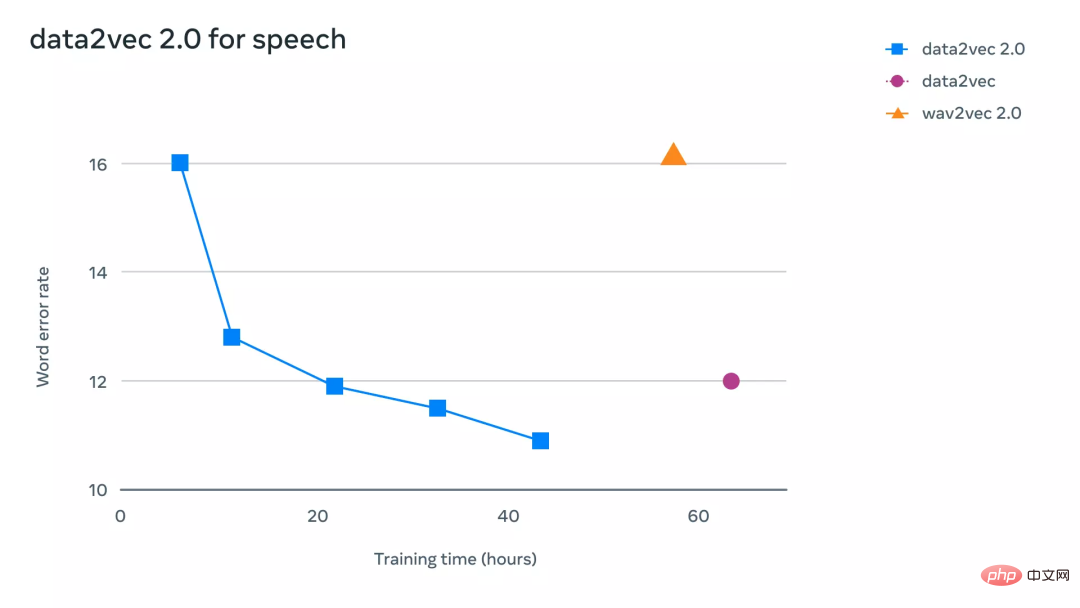

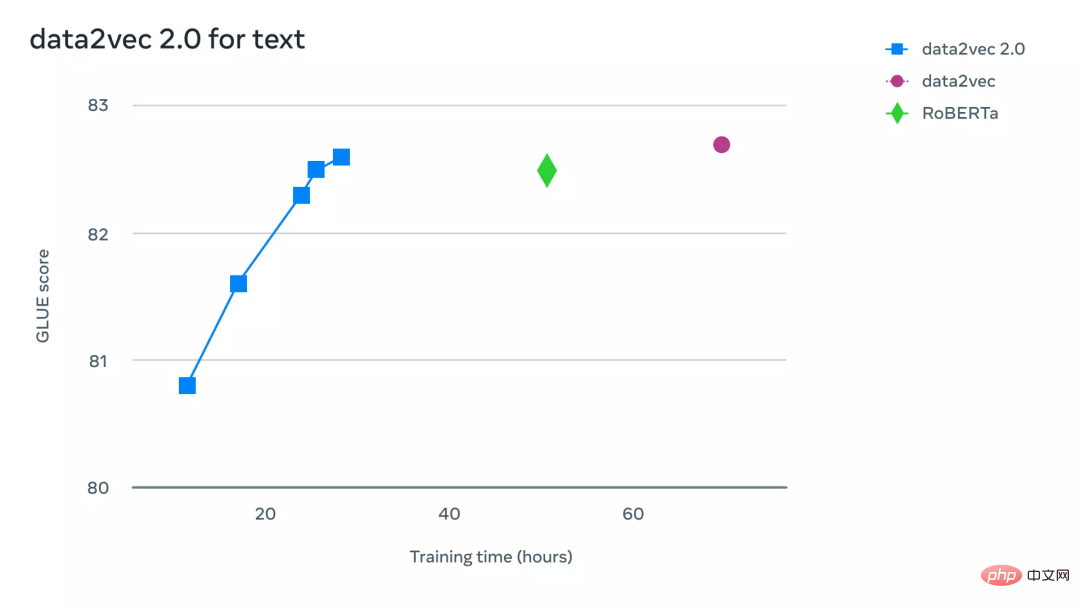

Mit anderen Worten, das Studentenmodell kann nur die Darstellung „vollständiger Eingabedaten“ vorhersagen und gleichzeitig „unvollständige Eingabeinformationen“ akzeptieren. Um die Konsistenz der beiden Modelle sicherzustellen, werden die Parameter der beiden Modelle gemeinsam genutzt, die Parameter des Lehrermodells werden jedoch in den frühen Phasen des Trainings schneller aktualisiert. In Bezug auf experimentelle Ergebnisse hat data2vec die Leistung im Vergleich zum Basismodell bei Sprache, Sehvermögen, Text und anderen Aufgaben deutlich verbessert. data2vec schlägt ein allgemeines Rahmenwerk für selbstüberwachtes Lernen vor, das das Lernen der drei modalen Daten Sprache, Sehen und Sprache vereinheitlicht, und data2vec2.0 löst hauptsächlich die Schwachstellen Das heißt, der Aufbau eines selbstüberwachten Modells erfordert eine große Menge an GPU-Rechenleistung, um das Training abzuschließen. Ähnlich wie der ursprüngliche data2vec-Algorithmus sagt data2vec 2.0 kontextualisierte Darstellungen von Daten oder Schichten neuronaler Netze voraus, anstatt Pixel in Bildern, Wörter in Textsegmenten oder Sprache vorherzusagen. Im Gegensatz zu herkömmlichen anderen Algorithmen sind diese sogenannten Zieldarstellungen kontextbezogen, was bedeutet, dass der Algorithmus das gesamte Trainingsbeispiel berücksichtigen muss. Zum Beispiel lernt das Modell die Darstellung des Wortes Bank basierend auf dem gesamten Satz, der Bank enthält, wodurch es einfacher wird, die korrekte Bedeutung des Wortes abzuleiten, z. B. um zu unterscheiden, ob es sich speziell auf „finanziell“ bezieht Institution“ oder „Land am Fluss““. Die Forscher glauben, dass kontextualisierte Ziele umfassendere Lernaufgaben ermöglichen und es data2vec 2.0 ermöglichen, schneller zu lernen als andere Algorithmen. data2vec 2.0 verbessert die Effizienz des ursprünglichen data2vec-Algorithmus auf die folgenden drei Arten: 1. Erstellen Sie eine Zieldarstellung für ein bestimmtes Trainingsbeispiel und verwenden Sie diese Darstellung in der Maske wieder Version. In der maskierten Version werden verschiedene Teile der Trainingsbeispiele zufällig ausgeblendet. Die von beiden Versionen erlernten Darstellungen werden dann in das Studentenmodell eingespeist, das die gleiche kontextualisierte Zieldarstellung für verschiedene Maskenversionen vorhersagt und so den für die Erstellung der Zieldarstellung erforderlichen Rechenaufwand effektiv amortisiert. 2. Ähnlich wie beim maskierten Autoencoder (MAE) bedient das Encodernetzwerk im Studentenmodell nicht den ausgeblendeten Teil der Trainingsbeispiele. In den Bildexperimenten waren etwa 80 % der Abschnitte leer, was zu erheblichen Einsparungen beim Rechenzyklus führte. 3. Es wird ein effektiveres Decodermodell verwendet, das nicht mehr auf dem Transformer-Netzwerk, sondern auf einem mehrschichtigen Faltungsnetzwerk basiert. Um intuitiver zu verstehen, wie viel effizienter data2vec 2.0 als data2vec und andere ähnliche Algorithmen ist, führten die Forscher umfangreiche Experimente zu Benchmarks im Zusammenhang mit Computer Vision, Sprache und Textaufgaben durch. Im Experiment wurden hauptsächlich die endgültige Genauigkeit und die für das Vortraining des Modells erforderliche Zeit berücksichtigt. Die experimentelle Umgebung befand sich auf derselben Hardware (GPU-Modell, Menge usw.), um die Laufgeschwindigkeit des Algorithmus zu messen. Bei Computer-Vision-Aufgaben bewerteten die Forscher data2vec 2.0 anhand des standardmäßigen Bildklassifizierungs-Benchmarks ImageNet-1K, einem Datensatz, aus dem das Modell Bilddarstellungen lernt. Experimentelle Ergebnisse zeigen, dass data2vec 2.0 die Genauigkeit des maskierten Autoencoders (MAE) erreichen kann, aber 16-mal schneller ist. Wenn Sie dem data2vec 2.0-Algorithmus weiterhin mehr Laufzeit geben, kann er eine höhere Genauigkeit erreichen und dennoch schneller als MAE sein. Bei der Sprachaufgabe testeten die Forscher sie mit dem LibriLanguage-Spracherkennungs-Benchmark und sie war mehr als 11-mal genauer als wave2vec 2.0. Für Aufgaben zur Verarbeitung natürlicher Sprache bewerteten die Forscher data2vec 2.0 anhand des GLUE-Benchmarks (General Language Understanding Evaluation) und erreichten in nur der Hälfte der Trainingszeit die gleiche Genauigkeit wie RoBERTa, eine Neuimplementierung von BERT. data2vec 2.0

Experimenteller Abschnitt

Das obige ist der detaillierte Inhalt vonMultimodalität wieder vereint! Meta veröffentlicht selbstüberwachten Algorithmus data2vec 2.0: Trainingseffizienz um das bis zu 16-fache erhöht!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1379

1379

52

52

Debian Mail Server Firewall -Konfigurationstipps

Apr 13, 2025 am 11:42 AM

Debian Mail Server Firewall -Konfigurationstipps

Apr 13, 2025 am 11:42 AM

Das Konfigurieren der Firewall eines Debian -Mailservers ist ein wichtiger Schritt zur Gewährleistung der Serversicherheit. Im Folgenden sind mehrere häufig verwendete Firewall -Konfigurationsmethoden, einschließlich der Verwendung von Iptables und Firewalld. Verwenden Sie Iptables, um Firewall so zu konfigurieren, dass Iptables (falls bereits installiert) installiert werden:

Wie Debian Readdir sich in andere Tools integriert

Apr 13, 2025 am 09:42 AM

Wie Debian Readdir sich in andere Tools integriert

Apr 13, 2025 am 09:42 AM

Die Readdir -Funktion im Debian -System ist ein Systemaufruf, der zum Lesen des Verzeichnisgehalts verwendet wird und häufig in der C -Programmierung verwendet wird. In diesem Artikel wird erläutert, wie Readdir in andere Tools integriert wird, um seine Funktionalität zu verbessern. Methode 1: Kombinieren Sie C -Sprachprogramm und Pipeline zuerst ein C -Programm, um die Funktion der Readdir aufzurufen und das Ergebnis auszugeben:#include#include#includeIntmain (intargc, char*argv []) {Dir*Dir; structDirent*Eintrag; if (argc! = 2) {{

So implementieren Sie die Dateisortierung nach Debian Readdir

Apr 13, 2025 am 09:06 AM

So implementieren Sie die Dateisortierung nach Debian Readdir

Apr 13, 2025 am 09:06 AM

In Debian -Systemen wird die Readdir -Funktion zum Lesen des Verzeichnisinhalts verwendet, aber die Reihenfolge, in der sie zurückgibt, ist nicht vordefiniert. Um Dateien in einem Verzeichnis zu sortieren, müssen Sie zuerst alle Dateien lesen und dann mit der QSORT -Funktion sortieren. Der folgende Code zeigt, wie Verzeichnisdateien mithilfe von Readdir und QSORT in Debian System sortiert werden:#include#include#include#include // benutzerdefinierte Vergleichsfunktion, verwendet für QSortIntCompare (constvoid*a, constvoid*b) {rettrcmp (*(*(*(

Debian Mail Server SSL -Zertifikat -Installationsmethode

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL -Zertifikat -Installationsmethode

Apr 13, 2025 am 11:39 AM

Die Schritte zur Installation eines SSL -Zertifikats auf dem Debian Mail -Server sind wie folgt: 1. Installieren Sie zuerst das OpenSSL -Toolkit und stellen Sie sicher, dass das OpenSSL -Toolkit bereits in Ihrem System installiert ist. Wenn nicht installiert, können Sie den folgenden Befehl installieren: sudoapt-getupdatesudoapt-getinstallopenssl2. Generieren Sie den privaten Schlüssel und die Zertifikatanforderung als nächst

So führen Sie die digitale Signaturüberprüfung mit Debian OpenSSL durch

Apr 13, 2025 am 11:09 AM

So führen Sie die digitale Signaturüberprüfung mit Debian OpenSSL durch

Apr 13, 2025 am 11:09 AM

Unter Verwendung von OpenSSL für die digitale Signaturüberprüfung im Debian -System können Sie folgende Schritte befolgen: Vorbereitung für die Installation von OpenSSL: Stellen Sie sicher, dass Ihr Debian -System OpenSSL installiert hat. Wenn nicht installiert, können Sie den folgenden Befehl verwenden, um es zu installieren: sudoaptupdatesudoaptininTallopenSSL, um den öffentlichen Schlüssel zu erhalten: Die digitale Signaturüberprüfung erfordert den öffentlichen Schlüssel des Unterzeichners. In der Regel wird der öffentliche Schlüssel in Form einer Datei wie Public_key.pe bereitgestellt

Wie Debian OpenSSL verhindert, dass Mann-in-the-Middle-Angriffe

Apr 13, 2025 am 10:30 AM

Wie Debian OpenSSL verhindert, dass Mann-in-the-Middle-Angriffe

Apr 13, 2025 am 10:30 AM

In Debian Systems ist OpenSSL eine wichtige Bibliothek für Verschlüsselung, Entschlüsselung und Zertifikatverwaltung. Um einen Mann-in-the-Middle-Angriff (MITM) zu verhindern, können folgende Maßnahmen ergriffen werden: Verwenden Sie HTTPS: Stellen Sie sicher, dass alle Netzwerkanforderungen das HTTPS-Protokoll anstelle von HTTP verwenden. HTTPS verwendet TLS (Transport Layer Security Protocol), um Kommunikationsdaten zu verschlüsseln, um sicherzustellen, dass die Daten während der Übertragung nicht gestohlen oder manipuliert werden. Überprüfen Sie das Serverzertifikat: Überprüfen Sie das Serverzertifikat im Client manuell, um sicherzustellen, dass es vertrauenswürdig ist. Der Server kann manuell durch die Delegate -Methode der URLSession überprüft werden

Wie man Debian Hadoop Log Management macht

Apr 13, 2025 am 10:45 AM

Wie man Debian Hadoop Log Management macht

Apr 13, 2025 am 10:45 AM

Wenn Sie Hadoop-Protokolle auf Debian verwalten, können Sie die folgenden Schritte und Best Practices befolgen: Protokollaggregation Aktivieren Sie die Protokollaggregation: Set Garn.log-Aggregation-Enable in true in der Datei marn-site.xml, um die Protokollaggregation zu aktivieren. Konfigurieren von Protokoll-Retentionsrichtlinien: Setzen Sie Garn.log-Aggregation.Retain-Sekunden, um die Retentionszeit des Protokolls zu definieren, z. B. 172800 Sekunden (2 Tage). Log Speicherpfad angeben: über Garn.n

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.