#? #

Zusammenfassung: Dieses Papier stellt einen neuen Ansatz zur Integration physikalischer Simulationen mit Szenen-NeRF-Modellen vor, um realistische Filme der Physik in diesen Szenen zu erstellen. In konkreten Ergebnissen kann die Methode die möglichen Auswirkungen des Klimawandels realistisch simulieren – wie würde ein Spielplatz nach einem kleinräumigen Hochwasser aussehen? Wie wäre es nach der großen Flut? Was ist nach dem Schneesturm?

Autor: Junxiong Wang et al 🎜🎜#

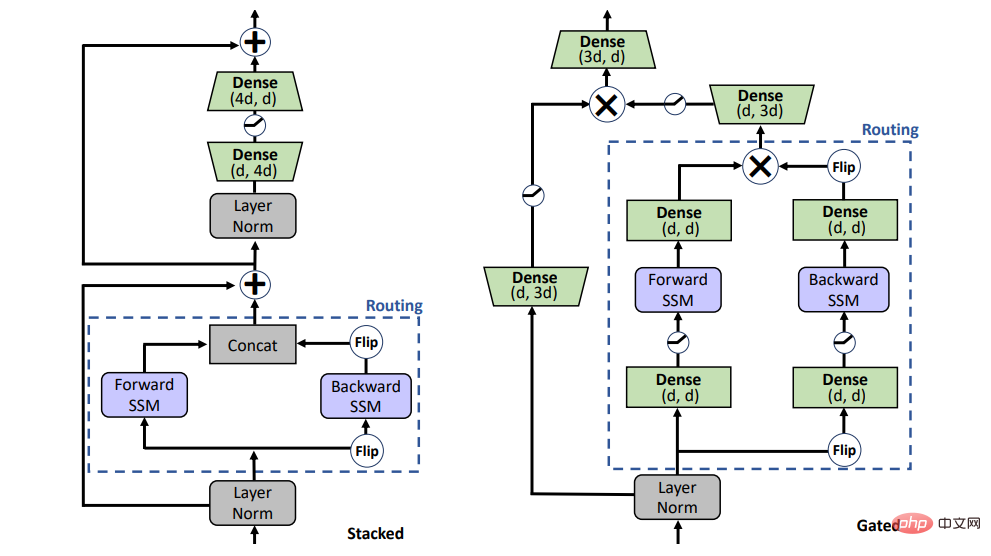

Zusammenfassung: Dieses Papier schlägt einen bidirektionalen Gated SSM vor (BiGS)-Modell kann in Kombination mit der Routing-Schicht und der auf Multiplikationsgattern basierenden Modellarchitektur eines Zustandsraummodells (SSM) die BERT-Vortrainingsergebnisse ohne Aufmerksamkeit reproduzieren und kann auf ein weitreichendes Vortraining von 4096 erweitert werden Token ohne die Notwendigkeit einer Annäherung.

Empfehlung: Vorschulung erfordert keine Aufmerksamkeit, Erweiterung auf 4096 Token ist nicht möglich Problem, vergleichbar mit BERT.

Papier Adresse: https://arxiv.org/pdf/2210.07883.pdf

Kürzlich Die verwendete textgesteuerte Bildbearbeitung hat große Fortschritte und Aufmerksamkeit erzielt, insbesondere basierend auf Entrauschungsdiffusionsmodellen wie StableDiffusion oder DALLE. Bei der GAN-basierten Text-Bild-Bearbeitung müssen jedoch noch einige Probleme gelöst werden. Im klassischen StyleCILP muss beispielsweise für jeden Text ein Modell trainiert werden Anwendungen. Dieser Artikel schlägt FFCLIP vor und löst dieses Problem. Für flexible unterschiedliche Texteingaben benötigt FFCLIP nur ein Modell, um das Bild entsprechend zu bearbeiten, ohne dass jeweils eine Neuschulung des Textes erforderlich ist Das Modell hat bei mehreren Datensätzen sehr gute Ergebnisse erzielt. Dieser Artikel wurde von NeurIPS 2022 angenommen.

Empfohlen: Ein neues Paradigma für die Text- und Bildbearbeitung, ein einziges Modell realisiert die durch mehrere Texte geführte Bildbearbeitung. Nr.

Empfohlen: Keine Notwendigkeit für manuelle Anmerkungen, das selbstgenerierte Anweisungs-Framework überwindet den Kostenengpass von LLM wie ChatGPT.

Papier 5: Ab Initio Calculation of Real Solids via Neural Network Ansatz

# 🎜🎜#

Maschinelles Lernen kann riesige Datenmengen verarbeiten, wissenschaftliche Probleme in komplexen Szenarien lösen und wissenschaftliche Erkundungen in neue Bereiche führen, die in der Vergangenheit unerreichbar waren. DeepMind nutzt beispielsweise die künstliche Intelligenz-Software AlphaFold, um hochpräzise Vorhersagen über fast alle der wissenschaftlichen Gemeinschaft bekannten Proteinstrukturen zu treffen. Die von Christian Lagemann vorgeschlagene Methode der Partikelbild-Velocimetrie (PIV) hat die ursprüngliche rein manuelle Einstellung erheblich verbessert Der Anwendungsbereich des Modells ist für die Forschung in vielen Bereichen wie Automobil, Luft- und Raumfahrt und biomedizinischer Technik von entscheidender Bedeutung. Kürzlich wurde die Arbeit „Ab-initio-Berechnung realer Feststoffe über einen Neural-Network-Ansatz“ vom Forschungsteam des ByteDance AI Lab und der Forschungsgruppe von Chen Ji an der Fakultät für Physik der Universität Peking veröffentlicht Diese Arbeit liefert eine neue Idee für das Studium der Physik der kondensierten Materie. Diese Arbeit schlägt die branchenweit erste neuronale Netzwerkwellenfunktion vor, die für Festkörpersysteme geeignet ist, realisiert First-Prinzipien-Berechnungen von Festkörpern und treibt die Berechnungsergebnisse an die thermodynamische Grenze. Dies ist ein starker Beweis dafür, dass neuronale Netze effiziente Werkzeuge für das Studium der Festkörperphysik sind, und weist auch darauf hin, dass Deep-Learning-Technologie eine immer wichtigere Rolle in der Physik der kondensierten Materie spielen wird. Relevante Forschungsergebnisse wurden am 22. Dezember 2022 im internationalen Top-Journal Nature Communication veröffentlicht.

Empfohlen:

Die branchenweit erste neuronale Netzwerkwellenfunktion, die für feste Systeme geeignet ist, wurde in einer Nature-Unterzeitschrift veröffentlicht.

Papier 6: Warum können GPT-Sprachmodelle heimlich im Kontext lernen und als Metaoptimierer dienen?# 🎜🎜#

Autor: Damai Dai et alEmpfohlen:

Warum funktioniert In-Context Learning, gesteuert durch GPT? Das Modell führt heimlich einen Gradientenabstieg durch.Paper 7: Experimentelle Hinweise auf nichtklassische Gehirnfunktionen

#🎜🎜 #Autor: Christian Matthias Kerskens et al

Eine aktuelle Studie der Trinity University Dublin zeigt, dass unser Gehirn Quantencomputing durchführt. Die Studie legt nahe, dass es im menschlichen Gehirn Gehirnfunktionsmediatoren gibt, die mit dem Bewusstsein zusammenhängen der Führung. Wenn diese Gehirnfunktionen auf nicht-klassische Weise funktionieren müssen, bedeutet dies, dass das Bewusstsein nicht-klassisch ist, d. h. die kognitiven Prozesse des Gehirns beinhalten Quantenberechnungen.

Empfehlung: Es gibt neue Beweise für diese Spekulation, dass das Denken des Gehirns Quantencomputing ist.

ArXiv Weekly Radiostation

Heart of the Machine kooperiert mit der von Chu Hang und Luo Ruotian initiierten ArXiv Weekly Radiostation und wählt diese Woche auf der Grundlage von 7 Artikeln weitere wichtige Artikel aus, darunter 10 ausgewählte Artikel in den Bereichen NLP, CV und ML, und stellt Audio bereit Format Die Zusammenfassung des Papiers, die Details sind wie folgt:

10 NLP-PapiereAudio: 00:0020:18

10 NLP vorgestellt Artikel dieser Woche Ja:

1. Benötigt die unbeaufsichtigte Grammatikinduktion Pixel? (von Serge Belongie, Kilian Q. Weinberger, Jitendra Malik, Trevor Darrell)

2 Messung und Zero-Shot-Debiasing. (von Bernhard Schölkopf) Regularisierung für die Ausrichtung der Sprachbeziehungen (von Ruslan Salakhutdinov, Louis-Philippe Morency) 5. Über die Verwendung paralleler Daten zur Bewertung der Übersetzungsqualität. Auf dem Weg zu einer menschenähnlichen Bewertung für die Erzeugung natürlicher Sprache mit Fehleranalyse. 7. Können aktuelle aufgabenorientierte Dialogmodelle reale Szenarien automatisieren? (von Kyunghyun Cho) 8. Über die blinden Flecken modellbasierter Bewertungsmetriken für die Textgenerierung 10. Der Einfluss symbolischer Darstellungen auf das kontextbezogene Lernen für das Few-Shot-Denken (von Li Erran Li, Eric Xing)

Die 10 ausgewählten Lebenslaufpapiere dieser Woche sind:

1. Revisiting Residual Networks for Adversarial Robustness: An Architectural Perspective. (von Kalyanmoy Deb)

2. Räumliches Benchmarking al-Beziehungen bei der Text-zu-Bild-Generierung.

3. Eine kurze Umfrage zur Personenerkennung aus der Ferne. (von Rama Chellappa)

5. Reversible Column Networks 7. Hi-LASSIE: High-Fidelity Articulated Shape and Skeleton Discovery (von Ming-Hsuan Yang)

8 -Hsuan Yang)

9. Die Kraft der visuellen Aufforderung auf Pixelebene freisetzen (von Alan Yuille) 10. Von Bildern zu Textaufforderungen: Zero-Shot-VQA mit eingefrorenen großen Sprachmodellen. (von Dacheng Tao, Steven C.H. Hoi)

Das obige ist der detaillierte Inhalt vonVorschulung ohne Aufmerksamkeit; In-Context Learning durch GPT. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So öffnen Sie HTML-Dateien

So öffnen Sie HTML-Dateien

Tutorial zur Linux-Systeminstallation

Tutorial zur Linux-Systeminstallation

Analyse der ICP-Münzaussichten

Analyse der ICP-Münzaussichten

Thunder VIP-Patch

Thunder VIP-Patch

Fehlerberichtslösung für den MySQL-Import einer SQL-Datei

Fehlerberichtslösung für den MySQL-Import einer SQL-Datei

So lösen Sie das Problem, wenn der Computer eingeschaltet wird, der Bildschirm schwarz wird und der Desktop nicht aufgerufen werden kann

So lösen Sie das Problem, wenn der Computer eingeschaltet wird, der Bildschirm schwarz wird und der Desktop nicht aufgerufen werden kann

Einführung in die Verwendung von vscode

Einführung in die Verwendung von vscode

Virtuelle Währungsumtauschplattform

Virtuelle Währungsumtauschplattform