Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

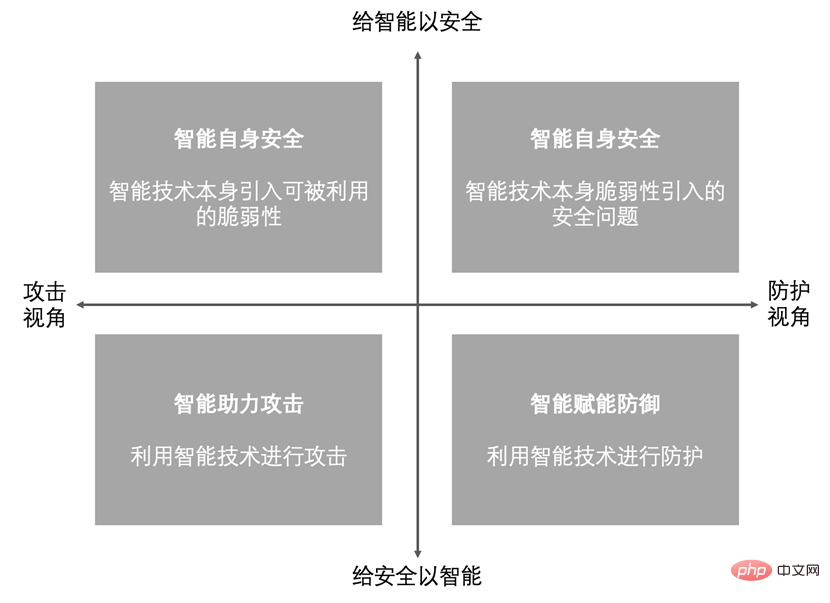

Gedanken zur KI-Netzwerksicherheit, hervorgerufen durch die Popularität von ChatGPT

Gedanken zur KI-Netzwerksicherheit, hervorgerufen durch die Popularität von ChatGPT

Gedanken zur KI-Netzwerksicherheit, hervorgerufen durch die Popularität von ChatGPT

1. Artificial Intelligence Development Track

Bevor das Konzept der künstlichen Intelligenz (Aritificial Intellige) erstmals 1956 auf dem Darmouth College Summer Academic Seminar vorgeschlagen wurde, hatten Menschen bei der schweren und repetitiven Arbeit bereits Menschen durch kontinuierliche Erforschung ersetzt auf der Straße.

Im Februar 1882 vollendete Nikola Tesla die Idee eines Wechselstromgenerators, die ihn fünf Jahre lang beschäftigt hatte, und rief begeistert aus: „Von nun an werden die Menschen nicht länger zu schwerer Handarbeit gezwungen sein, und meine Maschine wird uns befreien.“ , die ganze Welt wird so sein.“

Um die Existenz unentscheidbarer Sätze in der Mathematik zu beweisen, schlug Alan Turing 1948 die Idee einer „Turingmaschine“ vor. 1948 beschrieb er den größten Teil des Konnektionismus in der Arbeit „INTELLIGENT MACHINERY“. 1950 folgte die Veröffentlichung „COMPUTING MACHINERY AND INTELLIGENCE“ und der Vorschlag des berühmten „Turing-Tests“. Im selben Jahr bauten Marvin Minsky und sein Klassenkamerad Dunn Edmund den weltweit ersten neuronalen Netzwerkcomputer.

1955 nahm von Neumann die Einladung an, die Silliman-Vorlesung an der Yale University zu halten. Die Inhalte der Vorlesung wurden später in dem Buch „THE COMPUTER AND THE BRAIN“ zusammengefasst.

Künstliche Intelligenz hat seit ihrer Einführung im Jahr 1956 bis heute drei Entwicklungshöhepunkte erlebt.

Der erste Entwicklungshöhepunkt: Von 1956 bis 1980 nahm die durch Expertensysteme und klassisches maschinelles Lernen repräsentierte Symbolik (Symbolik) eine dominierende Stellung ein. Die Symbolik, auch als erste Generation der künstlichen Intelligenz bekannt, schlägt ein auf Wissen und Erfahrung basierendes Argumentationsmodell vor, um menschliches rationales, intelligentes Verhalten wie Denken, Planen, Entscheidungsfindung usw. zu simulieren. Daher werden in der Maschine eine Wissensbasis und ein Argumentationsmechanismus eingerichtet, um menschliches Argumentations- und Denkverhalten zu simulieren.

Die repräsentativste Errungenschaft der Symbolik ist der Sieg des IBM-Schachprogramms Deep Blue über den Weltmeister Kasparov im Mai 1997. Es gibt drei Faktoren für den Erfolg: Der erste Faktor ist das Wissen und die Erfahrung, die Deep Blue in der Vergangenheit gespielt hat Schachpartien und alle 5-6 Endspiele sind in den Schachregeln zusammengefasst.

Dann debuggen Sie durch das Spiel zwischen dem Master und der Maschine die Parameter in der Bewertungsfunktion und nehmen Sie die Erfahrung des Masters vollständig auf. Das zweite Element ist der Algorithmus Deep Blue verwendet den Alpha-Beta-Bereinigungsalgorithmus, der sehr schnell ist. Der dritte Faktor ist die Rechenleistung, die IBM damals verwendete, die Maschine RS/6000SP2, die 200 Millionen Schritte pro Sekunde analysieren und durchschnittlich 8-12 Schritte pro Sekunde vorhersagen konnte.

Der Vorteil der Symbolik besteht darin, dass sie den menschlichen Denk- und Denkprozess nachahmen kann, mit dem menschlichen Denkprozess übereinstimmt und Schlussfolgerungen aus einem Beispiel ziehen kann, sodass sie interpretierbar ist. Aber die Symbolik weist auch sehr gravierende Mängel auf. Erstens ist Expertenwissen sehr knapp und teuer. Zweitens muss Expertenwissen durch manuelle Programmierung eingegeben werden, was zeitaufwändig und arbeitsintensiv ist Wissen, das schwer auszudrücken ist, wie zum Beispiel Experten der traditionellen chinesischen Medizin, die Pulse messen. Solche Erfahrungen sind schwer auszudrücken, daher ist der Anwendungsbereich der Symbolik sehr begrenzt.

Der zweite Entwicklungshöhepunkt: 1980 ~ 1993, dargestellt durch Symbolik und Konnektionismus; Lernen simuliert die menschliche Wahrnehmung wie Sehen, Hören, Berühren usw. durch tiefe neuronale Netzwerkmodelle. Deep Learning hat zwei Vorteile: Der erste Vorteil besteht darin, dass kein Domänenexpertenwissen erforderlich ist und der technische Schwellenwert niedrig ist. Der zweite Vorteil besteht darin, dass die Daten, die verarbeitet werden können, umso größer sind.

Eines der typischsten Beispiele für Deep Learning ist das Go-Programm. Vor Oktober 2015 konnten Go-Programme, die mithilfe von Symbolik, also wissensbasierten Methoden, erstellt wurden, die höchste Stufe des Amateur-5-Dan erreichen. Im Oktober 2015 besiegte das Go-Programm den Europameister und im März 2016 den Weltmeister. Bis Oktober 2017 besiegte AlphaGo AlphaGo, um einen dreifachen Sprung im Level des Go-Programms zu erreichen, vom Profi-Level zum Weltmeister und vom Weltmeister zum Weltmeister Champion.

AlphaGo hat in zwei Jahren einen Dreifachsprung geschafft. Sein Erfolg beruht hauptsächlich auf drei Aspekten: Big Data, Algorithmus und Rechenleistung. AlphaGo lernte 30 Millionen bestehende Schachpartien und spielte weitere 30 Millionen Partien mit sich selbst, also insgesamt 60 Millionen Schachpartien. Es verwendete Monte-Carlo-Baumsuche, Reinforcement Learning, Deep Learning und andere Algorithmen und nutzte insgesamt 1202 CPUs und 280 Zu berechnende GPU.

Deep Learning weist auch große Einschränkungen auf, z. B. ist es nicht interpretierbar, unsicher, nicht leicht zu verallgemeinern und erfordert eine große Anzahl von Beispielen. Beispielsweise kann ein Bild eines menschlichen Gesichts nach einigen Modifikationen als Hund erkannt werden. Warum dies geschieht, ist für den Menschen unerklärlich.

Im Jahr 2016 erlangte der durch Reinforcement Learning repräsentierte Behaviorismus (Aktionismus) nach der Entstehung von AlphaZero große Aufmerksamkeit und wurde als einziger Weg zur allgemeinen künstlichen Intelligenz gefeiert.

Symbolismus, dargestellt durch logisches Denken, treibt Intelligenz durch Wissen voran, und Konnektionismus, dargestellt durch tiefes Lernen, treibt Intelligenz durch Daten voran. Beide haben große Mängel und einen begrenzten Anwendungsbereich.

Behaviorismus, dargestellt durch Verstärkungslernen, nutzt umfassend die vier Elemente Wissen, Daten, Algorithmen und Rechenleistung, um Mechanismen wie Feedback, seitliche Verbindungen, spärliche Entladung, Aufmerksamkeitsmechanismus, Multimodalität und Gedächtnis des menschlichen Gehirns einzuführen Es wird erwartet, dass es die Mängel der ersten beiden Generationen der künstlichen Intelligenz überwindet und eine breitere Anwendung findet.

2. Mehrere Mechanismen der menschlichen Gehirnarbeit

[Vorhersage- und Feedbackmechanismus]

Das Gehirn beobachtet die Welt und baut im Laufe des Lebens Gedächtnismodelle auf. Im täglichen Leben vergleicht das Gehirn automatisch die vorherigen Gedächtnismodelle und sagt voraus, was wird als nächstes passieren. Wenn es eine Situation erkennt, die nicht mit der Vorhersage übereinstimmt, löst es eine Rückmeldung vom Gehirn aus.

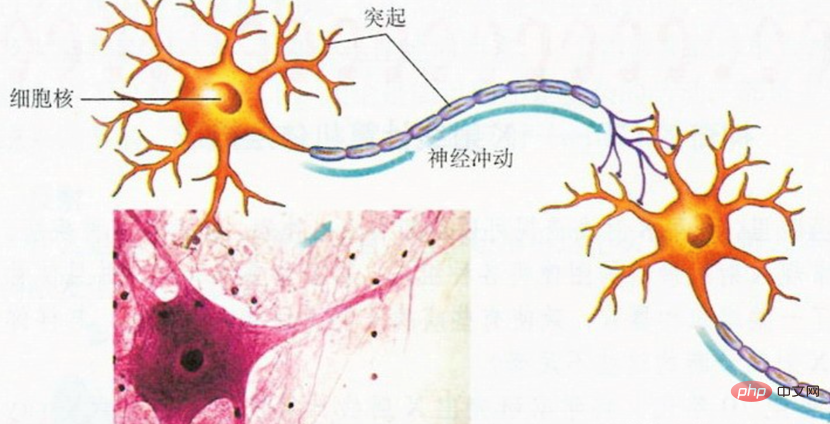

Gehirnzellen sind in der Lage, Informationen zu übertragen, weil sie magische Tentakel, Dendriten und Axone haben. Mit ihren kurzen Dendriten können Gehirnzellen Informationen von anderen Gehirnzellen empfangen, und mit ihren langen Axonen können Gehirnzellen Informationen an andere Gehirnzellen übermitteln (wie in der Abbildung unten dargestellt).

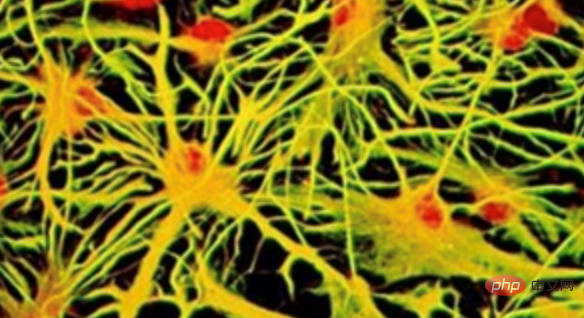

Informationen werden kontinuierlich zwischen Gehirnzellen übertragen und formen menschliche Gefühle und Gedanken. Das gesamte Gehirn ist ein großes Netzwerk miteinander verbundener Gehirnzellen, wie in der folgenden Abbildung dargestellt:

Um im Bereich des maschinellen Lernens zunächst ein solches künstliches neuronales Netzwerk zu erhalten, Ein neuronales Netzwerk muss definiert werden. Die Struktur des Netzwerks, wie viele Neuronen es im Netzwerk gibt und wie die Neuronen verbunden sind. Als nächstes müssen Sie eine Fehlerfunktion definieren. Die Fehlerfunktion wird verwendet, um zu bewerten, wie gut das Netzwerk derzeit funktioniert und wie die Neuronenverbindungen darin angepasst werden sollten, um Fehler zu reduzieren. Die synaptische Stärke bestimmt die neuronale Aktivität, die neuronale Aktivität bestimmt die Netzwerkausgabe und die Netzwerkausgabe bestimmt den Netzwerkfehler.

Derzeit ist „Backpropagation“ der am häufigsten verwendete und erfolgreichste Trainingsalgorithmus für tiefe neuronale Netze im Bereich des maschinellen Lernens. Mit Backpropagation trainierte Netzwerke nehmen in der jüngsten Welle des maschinellen Lernens eine tragende Stellung ein und erzielen gute Ergebnisse bei der Sprach- und Bilderkennung, Sprachübersetzung usw.

Es fördert auch den Fortschritt des unbeaufsichtigten Lernens, das für die Bild- und Spracherzeugung, die Sprachmodellierung und einige Vorhersageaufgaben höherer Ordnung unverzichtbar ist. In Zusammenarbeit mit Reinforcement Learning kann Backpropagation viele Kontrollprobleme (Kontrollprobleme) lösen, wie z. B. das Beherrschen von Atari-Spielen und das Besiegen der besten menschlichen Spieler in Go und Poker.

Der Backpropagation-Algorithmus sendet Fehlersignale in Rückkopplungsverbindungen, um dem neuronalen Netzwerk bei der Anpassung der synaptischen Stärke zu helfen. Er wird sehr häufig im Bereich des überwachten Lernens verwendet. Aber Rückkopplungsverbindungen im Gehirn scheinen unterschiedliche Funktionen zu haben, und ein Großteil des Lernens des Gehirns erfolgt unbeaufsichtigt. Kann der Backpropagation-Algorithmus daher den Feedback-Mechanismus des Gehirns erklären? Eine definitive Antwort gibt es derzeit nicht.

【Intrahirn-Verbindungen】

Die spezielle Verbindungsmethode zwischen Neuronen im menschlichen Gehirn ist eine wichtige Richtung bei der Erforschung der Einzigartigkeit des menschlichen Gehirns. Die Magnetresonanztomographie ist ein Schlüsselinstrument dieser Forschung. Mit dieser Technik können die langen Fasern sichtbar gemacht werden, die von Neuronen ausgehen und verschiedene Gehirnbereiche verbinden, ohne den Schädel zu öffnen. Diese Verbindungen wirken wie Drähte, die elektrische Signale zwischen Neuronen übertragen. Zusammen werden diese Verbindungen als Konnektom bezeichnet und liefern Hinweise darauf, wie das Gehirn Informationen verarbeitet.

Angenommen, dass jede Nervenzelle mit allen anderen Nervenzellen verbunden ist, ist diese Eins-zu-Viele-Verbindungsgruppe am effizientesten. Da dieses Modell jedoch viel Platz und Energie benötigt, um alle Anschlüsse unterzubringen und ihren normalen Betrieb aufrechtzuerhalten, ist dies definitiv nicht realisierbar. Ein anderer Modus ist eine Eins-zu-eins-Verbindung, bei der jedes Neuron nur mit einem einzigen anderen Neuron verbunden ist. Diese Art der Verbindung ist weniger schwierig, aber auch weniger effizient: Informationen müssen wie Trittsteine eine große Anzahl von Nervenzellen passieren, um von Punkt A nach Punkt B zu gelangen.

„Das wirkliche Leben liegt irgendwo dazwischen“, sagt Yaniv Assaf von der Universität Tel Aviv, der in Nature Neuroscience eine Untersuchung der Konnektome von 123 Säugetierarten veröffentlicht hat. Das Team fand heraus, dass die Anzahl der Trittsteine, die benötigt werden, um Informationen von einem Ort zum anderen zu transportieren, in den Gehirnen verschiedener Arten ungefähr gleich ist und dass die verwendeten Verbindungen ähnlich sind. Es gibt jedoch Unterschiede in der Art und Weise, wie die Anordnung der Verbindungen im Gehirn zwischen verschiedenen Arten realisiert wird. Bei Arten mit wenigen Fernverbindungen zwischen den beiden Hemisphären gibt es tendenziell mehr kürzere Verbindungen in jeder Hemisphäre, und benachbarte Gehirnregionen innerhalb der Hemisphäre kommunizieren häufig.

【Gedächtnis】

Im menschlichen Gehirn gibt es Milliarden von Nervenzellen. Sie interagieren über Synapsen miteinander und bilden äußerst komplexe Verbindungen. Beim Gedächtnis handelt es sich um die gegenseitigen Anrufe zwischen Gehirnnervenzellen. Einige der gegenseitigen Anrufe sind von kurzer Dauer, andere von langer Dauer und andere liegen irgendwo dazwischen.

Es gibt vier grundlegende Formen der Interaktion zwischen Gehirnneuronen:

- Einfache Erregung: Wenn ein Neuron erregt wird, erregt es ein anderes verbundenes Neuron.

- Einfache Hemmung: Die Erregung eines Neurons erhöht die sensorische Schwelle eines anderen verbundenen Neurons.

- Positives Feedback: Die Erregung eines Neurons stimuliert die Erregung eines anderen verbundenen Neurons, was wiederum direkt oder indirekt die Erregungsschwelle des ersteren senkt oder ein Signal an die sensorische Synapse des ersteren zurückmeldet .

- Negatives Feedback: Die Erregung eines Neurons stimuliert die Erregung eines anderen verbundenen Neurons, was wiederum direkt oder indirekt die Erregungsschwelle des ersteren erhöht, wodurch die Erregbarkeit des ersteren abnimmt.

Es gibt viele Arten von Neuronenzellen mit unterschiedlichen Aktivitäten im menschlichen Gehirn, die jeweils für das Kurzzeit-, Mittelfrist- und Langzeitgedächtnis verantwortlich sind.

Aktive Neuronenzellen sind für das Kurzzeitgedächtnis verantwortlich. Die Anzahl ist gering und bestimmt die kurzfristige Reaktionsfähigkeit einer Person. Wenn dieser Zelltyp durch ein Nervensignal stimuliert wird, sinkt seine Wahrnehmungsschwelle vorübergehend, aber seine Synapsen vermehren sich im Allgemeinen nicht, und die Abnahme der Wahrnehmungsschwelle kann nur einige Sekunden bis Minuten anhalten und kehrt dann auf normale Werte zurück.

Neutrale Neuronenzellen sind mit einer mittleren Anzahl für das mittelfristige Gedächtnis verantwortlich und bestimmen die Lernanpassungsfähigkeit einer Person. Wenn diese Art von Zelle durch eine angemessene Menge an Nervensignalen stimuliert wird, kommt es zu einer synaptischen Proliferation. Diese ist jedoch langsam und erfordert mehrere Stimulationen, um signifikante Veränderungen zu bewirken, und der Proliferationszustand kann nur Tage bis Wochen andauern wahrscheinlicher auftreten.

Lazy Neuronenzellen sind für das Langzeitgedächtnis verantwortlich. Ihre größere Anzahl bestimmt die Fähigkeit eines Menschen, Wissen anzusammeln. Dieser Zelltyp unterliegt nur dann einer synaptischen Proliferation, wenn er durch eine große Anzahl wiederholter Nervensignale stimuliert wird. Diese synaptische Proliferation ist äußerst langsam und erfordert viele wiederholte Stimulationen, um signifikante Veränderungen herbeizuführen. Der Proliferationszustand kann jedoch über Monate bis Jahrzehnte aufrechterhalten werden. , nicht leicht abzubauen.

Wenn eine Gehirnneuronenzelle stimuliert und erregt wird, vermehren sich ihre Synapsen oder die Induktionsschwelle sinkt. Bei Gehirnneuronenzellen, die häufig stimuliert und wiederholt erregt werden, werden ihre Synapsen stärker signalisiert Signalempfangsfähigkeiten als andere Gehirnneuronenzellen, die weniger stimuliert und erregt werden.

Wenn zwei neuronale Zellen mit benachbarten synaptischen Verbindungen gleichzeitig stimuliert und gleichzeitig erregt werden, vermehren sich die Synapsen der beiden neuronalen Zellen gleichzeitig, sodass die Die Interaktion benachbarter synaptischer Paare zwischen ihnen wird verstärkt. Wenn diese synchrone Stimulation viele Male wiederholt wird und die Interaktion benachbarter synaptischer Paare zweier Neuronenzellen eine bestimmte Intensität erreicht (einen bestimmten Schwellenwert erreicht oder überschreitet), besteht eine Beziehung zwischen ihnen Es kommt zu einer Erregungsausbreitung, das heißt, wenn eine Neuronenzelle zur Erregung angeregt wird, wird eine andere Neuronenzelle erregt, wodurch eine gegenseitige Echoverbindung zwischen Neuronenzellen entsteht, die eine Gedächtnisverbindung darstellt.

Daher bezieht sich Gedächtnis auf Erinnerung, die durch die Glätte der Verbindung zwischen Neuronenzellen bestimmt wird, dh die Stärke der Verbindung zwischen Neuronenzellen ist größer als die Induktionsschwelle und bildet eine dominante Beziehung Verbindung zwischen Neuronenzellen, das ist die Natur des Gehirngedächtnisses.

【Aufmerksamkeitsmechanismus】

Wenn das menschliche Gehirn liest, handelt es sich nicht um einen strengen Dekodierungsprozess, sondern um einen Mustererkennungsprozess. Das Gehirn ignoriert automatisch Informationen mit geringer Wahrscheinlichkeit und geringem Wert und korrigiert den Leseinhalt basierend auf Kontextinformationen automatisch auf „die Version, die das Gehirn für richtig hält“.

„Aufmerksamkeitsmechanismus“ ist eine Datenverarbeitungsmethode, die die Aufmerksamkeit des menschlichen Gehirns beim maschinellen Lernen simuliert. Sie wird häufig bei verschiedenen Arten der Verarbeitung natürlicher Sprache, der Bilderkennung und der Spracherkennung bei maschinellen Lernaufgaben verwendet. Beispielsweise wird bei der maschinellen Übersetzung häufig das Modell „LSTM+Aufmerksamkeit“ verwendet. LSTM (Long Short Term Memory) ist eine Anwendung von RNN (Recurrent Neural Network). Es kann einfach verstanden werden, dass jedes Neuron ein Eingangstor, ein Ausgangstor und ein Vergessenstor hat. Das Eingabe-Gate und das Ausgabe-Gate verbinden die LSTM-Neuronen Ende an Ende, während das Vergessen-Gate den bedeutungslosen Inhalt schwächt oder vergisst. Der „Aufmerksamkeitsmechanismus“ wird auf das Vergessenstor von LSTM angewendet, wodurch maschinelles Lesen den menschlichen Lesegewohnheiten näher kommt und die Übersetzungsergebnisse auch kontextuell relevant werden.

【Multimodale Neuronen】

Vor fünfzehn Jahren entdeckten Quiroga und andere, dass es im menschlichen Gehirn multimodale Neuronen gibt. Diese Neuronen reagieren auf abstrakte Konzepte rund um ein übergeordnetes Thema und nicht auf bestimmte visuelle Merkmale. Unter ihnen ist das Neuron „Halle Berry“ das bekannteste, das nur auf Fotos, Skizzen und Texte der amerikanischen Schauspielerin „Halle Berry“ reagiert. Dieses Beispiel wurde in „Scientific American“ und „The New York Times“ verwendet " [ 11].

Von OpenAI veröffentlichtes CLIP verwendet multimodale Neuronen, um ein allgemeines Bildverarbeitungssystem zu erreichen, das in der Leistung mit ResNet-50 vergleichbar ist. Bei einigen anspruchsvollen Datensätzen übertrifft die Leistung von CLIP die Leistung des vorhandenen Bildverarbeitungssystems.

Maschinelles Lernen führt multimodale Neuronen ein, was sich auf das tiefe mehrdimensionale semantische Verständnis multimodaler Daten und Informationen wie Text, Ton, Bilder, Videos usw. bezieht, einschließlich der Datensemantik. Wissenssemantik, verschiedene semantische Verständnistechnologien wie visuelle Semantik, Sprachsemantikintegration und Semantik natürlicher Sprache. Beispielsweise kann die visuelle Semantik es Maschinen ermöglichen, vom klaren Sehen zum Verstehen von Videos überzugehen und strukturiertes semantisches Wissen zu extrahieren.

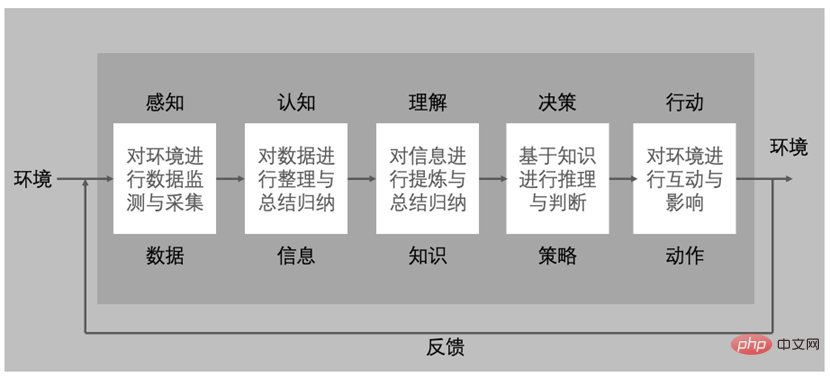

3. Der grundlegende Aufbau eines intelligenten Systems

Das autonome Fahrsystem ist ein typisches intelligentes System. Der US-amerikanische SAE-Klassifizierungsstandard für autonomes Fahren unterteilt autonome Fahrsysteme in fünf Stufen Automatisierung: #🎜 🎜#

| level#🎜 🎜 ##🎜 🎜 #Name | Definition | #🎜 🎜 ##🎜🎜 #L0 | |

| Keine Automatisierung | Der Fahrer übernimmt alle betrieblichen Aufgaben wie Lenken, Bremsen, Beschleunigen oder Abbremsen usw. | L1 | |

| Fahrerassistent #🎜 🎜 # | Der Fahrer kann mit Hilfe des automatisierten Fahrsystems des Fahrzeugs weiterhin alle Beschleunigungs- und Bremsvorgänge sowie die Überwachung der Umgebung bewältigen. L2 |

||

| #🎜 🎜 # Automatisierte Autofahrsysteme können bei Lenk- oder Beschleunigungsfunktionen unterstützen und es ermöglichen, den Fahrer von einigen seiner Aufgaben zu entlasten. Der Fahrer muss jederzeit bereit sein, die Kontrolle über das Fahrzeug zu übernehmen und für die meisten sicherheitskritischen Funktionen sowie die gesamte Umgebungsüberwachung verantwortlich zu bleiben. | L3 | ||

Das automatisierte Fahrsystem des Fahrzeugs selbst steuert die gesamte Überwachung der Umgebung. Die Aufmerksamkeit des Fahrers ist auf dieser Ebene immer noch wichtig, kann aber von „sicherheitskritischen“ Funktionen wie dem Bremsen entkoppelt werden. |

|||

L4 |

Hochautomatisiert | #🎜 🎜 #Das autonome Fahrsystem des Fahrzeugs benachrichtigt den Fahrer zunächst, wenn die Bedingungen sicher sind, und dann schaltet der Fahrer das Fahrzeug in diesen Modus. Es kann nicht zwischen dynamischeren Fahrsituationen wie Stau oder Einfahrt auf die Autobahn unterscheiden. Autonome Fahrzeugsysteme sind in der Lage zu lenken, zu bremsen, zu beschleunigen, das Fahrzeug und die Straße zu überwachen, auf Ereignisse zu reagieren und zu bestimmen, wann Spurwechsel, Abbiegen und die Verwendung von Signalen erforderlich sind. | |

| L5 | vollautomatisch #🎜 🎜 # | Autonome Fahrsysteme steuern alle kritischen Aufgaben, überwachen die Umgebung und erkennen einzigartige Fahrbedingungen wie Staus, ohne dass die Aufmerksamkeit des Fahrers erforderlich ist.

Level |

Name |

Definition |

|

L0 |

Keine Autonomie |

Abwehrmaßnahmen beruhen vollständig auf manuellen Bemühungen von Sicherheitsexperten. |

|

| L2 | Teilautonom | Das Schutzsystem erkennt und schützt bekannte Angriffe und Bedrohungen und kann auch unbekannte Bedrohungen erkennen. Andere Aufgaben wie die Optimierung der Genauigkeitsrate, der Falsch-Negativ-Rate und der Falsch-Positiv-Rate, Bedrohungsanalyse und Rückverfolgbarkeit erfordern jedoch manuelle Arbeit von Sicherheitsexperten. |

|

L3 |

Conditional Autonomous |

Das Schutzsystem erkennt und schützt vor bekannten und unbekannten Angriffen und Bedrohungen und kann außerdem die Genauigkeitsrate, Falsch-Negativ-Rate und Falsch-Positiv-Rate zur Bekämpfung kontinuierlich optimieren Autonomie Lernen und Aktualisieren, aber Bedrohungsanalyse, Quellenverfolgung, Reaktion und andere Aufgaben erfordern manuelle Arbeit durch Sicherheitsexperten. |

|

L4 |

Hochautonom |

Das Schutzsystem vervollständigt die Erkennung, Entscheidungsfindung, den Schutz, die Forschung und Beurteilung, die Rückverfolgbarkeit usw. aller Angriffe und Bedrohungen mit einem geringen Eingriffsaufwand und Reaktion von Sicherheitsexperten im Prozess. |

|

L5 |

Völlig autonom |

Das Schutzsystem führt unabhängig die gesamte Angriffs- und Bedrohungserkennung, Entscheidungsfindung, Schutz, Forschung und Beurteilung, Rückverfolgbarkeit usw. durch, ohne dass die Sicherheit eingreifen und reagieren muss Experten während des gesamten Prozesses. |

Das obige ist der detaillierte Inhalt vonGedanken zur KI-Netzwerksicherheit, hervorgerufen durch die Popularität von ChatGPT. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Verbessern Sie die Produktivität, Effizienz und Genauigkeit der Entwickler, indem Sie eine abrufgestützte Generierung und ein semantisches Gedächtnis in KI-Codierungsassistenten integrieren. Übersetzt aus EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, Autor JanakiramMSV. Obwohl grundlegende KI-Programmierassistenten natürlich hilfreich sind, können sie oft nicht die relevantesten und korrektesten Codevorschläge liefern, da sie auf einem allgemeinen Verständnis der Softwaresprache und den gängigsten Mustern beim Schreiben von Software basieren. Der von diesen Coding-Assistenten generierte Code eignet sich zur Lösung der von ihnen zu lösenden Probleme, entspricht jedoch häufig nicht den Coding-Standards, -Konventionen und -Stilen der einzelnen Teams. Dabei entstehen häufig Vorschläge, die geändert oder verfeinert werden müssen, damit der Code in die Anwendung übernommen wird

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Um mehr über AIGC zu erfahren, besuchen Sie bitte: 51CTOAI.x Community https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou unterscheidet sich von der traditionellen Fragendatenbank, die überall im Internet zu sehen ist erfordert einen Blick über den Tellerrand hinaus. Large Language Models (LLMs) gewinnen in den Bereichen Datenwissenschaft, generative künstliche Intelligenz (GenAI) und künstliche Intelligenz zunehmend an Bedeutung. Diese komplexen Algorithmen verbessern die menschlichen Fähigkeiten, treiben Effizienz und Innovation in vielen Branchen voran und werden zum Schlüssel für Unternehmen, um wettbewerbsfähig zu bleiben. LLM hat ein breites Anwendungsspektrum und kann in Bereichen wie der Verarbeitung natürlicher Sprache, der Textgenerierung, der Spracherkennung und Empfehlungssystemen eingesetzt werden. Durch das Lernen aus großen Datenmengen ist LLM in der Lage, Text zu generieren

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Maschinelles Lernen ist ein wichtiger Zweig der künstlichen Intelligenz, der Computern die Möglichkeit gibt, aus Daten zu lernen und ihre Fähigkeiten zu verbessern, ohne explizit programmiert zu werden. Maschinelles Lernen hat ein breites Anwendungsspektrum in verschiedenen Bereichen, von der Bilderkennung und der Verarbeitung natürlicher Sprache bis hin zu Empfehlungssystemen und Betrugserkennung, und es verändert unsere Lebensweise. Im Bereich des maschinellen Lernens gibt es viele verschiedene Methoden und Theorien, von denen die fünf einflussreichsten Methoden als „Fünf Schulen des maschinellen Lernens“ bezeichnet werden. Die fünf Hauptschulen sind die symbolische Schule, die konnektionistische Schule, die evolutionäre Schule, die Bayes'sche Schule und die Analogieschule. 1. Der Symbolismus, auch Symbolismus genannt, betont die Verwendung von Symbolen zum logischen Denken und zum Ausdruck von Wissen. Diese Denkrichtung glaubt, dass Lernen ein Prozess der umgekehrten Schlussfolgerung durch das Vorhandene ist

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

Herausgeber |. KX Im Bereich der Arzneimittelforschung und -entwicklung ist die genaue und effektive Vorhersage der Bindungsaffinität von Proteinen und Liganden für das Arzneimittelscreening und die Arzneimitteloptimierung von entscheidender Bedeutung. Aktuelle Studien berücksichtigen jedoch nicht die wichtige Rolle molekularer Oberflächeninformationen bei Protein-Ligand-Wechselwirkungen. Auf dieser Grundlage schlugen Forscher der Universität Xiamen ein neuartiges Framework zur multimodalen Merkmalsextraktion (MFE) vor, das erstmals Informationen über Proteinoberfläche, 3D-Struktur und -Sequenz kombiniert und einen Kreuzaufmerksamkeitsmechanismus verwendet, um verschiedene Modalitäten zu vergleichen Ausrichtung. Experimentelle Ergebnisse zeigen, dass diese Methode bei der Vorhersage von Protein-Ligand-Bindungsaffinitäten Spitzenleistungen erbringt. Darüber hinaus belegen Ablationsstudien die Wirksamkeit und Notwendigkeit der Proteinoberflächeninformation und der multimodalen Merkmalsausrichtung innerhalb dieses Rahmens. Verwandte Forschungen beginnen mit „S

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

Laut Nachrichten dieser Website vom 5. Juli veröffentlichte GlobalFoundries am 1. Juli dieses Jahres eine Pressemitteilung, in der die Übernahme der Power-Galliumnitrid (GaN)-Technologie und des Portfolios an geistigem Eigentum von Tagore Technology angekündigt wurde, in der Hoffnung, seinen Marktanteil in den Bereichen Automobile und Internet auszubauen Anwendungsbereiche für Rechenzentren mit künstlicher Intelligenz, um höhere Effizienz und bessere Leistung zu erforschen. Da sich Technologien wie generative künstliche Intelligenz (GenerativeAI) in der digitalen Welt weiterentwickeln, ist Galliumnitrid (GaN) zu einer Schlüssellösung für nachhaltiges und effizientes Energiemanagement, insbesondere in Rechenzentren, geworden. Auf dieser Website wurde die offizielle Ankündigung zitiert, dass sich das Ingenieurteam von Tagore Technology im Rahmen dieser Übernahme mit GF zusammenschließen wird, um die Galliumnitrid-Technologie weiterzuentwickeln. G