Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Kommt das multimodale ChatGPT von Microsoft? 1,6 Milliarden Parameter zur Bewältigung von Aufgaben wie dem Betrachten von Bildern und Beantworten von Fragen, IQ-Tests usw.

Kommt das multimodale ChatGPT von Microsoft? 1,6 Milliarden Parameter zur Bewältigung von Aufgaben wie dem Betrachten von Bildern und Beantworten von Fragen, IQ-Tests usw.

Kommt das multimodale ChatGPT von Microsoft? 1,6 Milliarden Parameter zur Bewältigung von Aufgaben wie dem Betrachten von Bildern und Beantworten von Fragen, IQ-Tests usw.

Im Bereich NLP haben große Sprachmodelle (LLM) erfolgreich als gemeinsame Schnittstellen bei verschiedenen Aufgaben in natürlicher Sprache gedient. Solange wir die Eingabe und Ausgabe in Text umwandeln können, können wir die LLM-basierte Schnittstelle an eine Aufgabe anpassen. Beispielsweise nimmt die Sammelaufgabe Dokumente auf und gibt zusammenfassende Informationen aus. So können wir das Eingabedokument in ein zusammenfassendes Sprachmodell einspeisen und eine Zusammenfassung generieren.

Trotz der erfolgreichen Anwendung von LLM in NLP-Aufgaben haben Forscher immer noch Schwierigkeiten, es nativ für multimodale Daten wie Bilder und Audio zu verwenden. Als grundlegender Bestandteil der Intelligenz ist die multimodale Wahrnehmung eine notwendige Voraussetzung für die Erlangung allgemeiner künstlicher Intelligenz, sowohl für den Wissenserwerb als auch für den Umgang mit der realen Welt. Noch wichtiger ist, dass die Erschließung multimodaler Eingaben die Anwendung von Sprachmodellen in höherwertigen Bereichen wie multimodaler Robotik, Dokumentenintelligenz und Robotik erheblich erweitern kann.

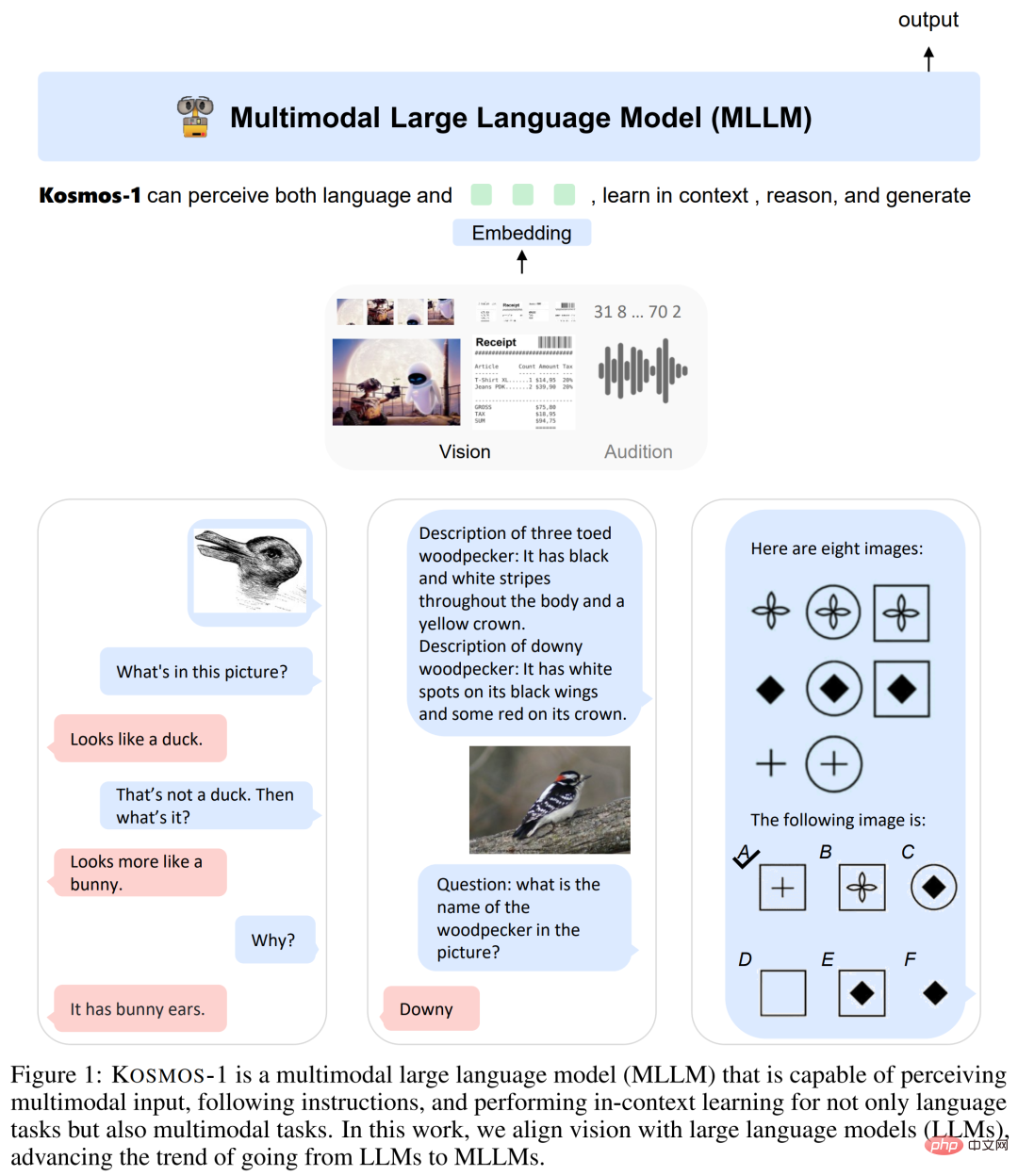

Daher hat das Microsoft-Team im Artikel „Sprache ist nicht alles, was Sie brauchen: Wahrnehmung an Sprachmodellen ausrichten“ ein #🎜 eingeführt. 🎜#Multimodal Large Language Model (MLLM) – KOSMOS-1, das allgemeine Modalitäten wahrnehmen, Anweisungen befolgen (d. h. Zero-Shot-Lernen) und im Kontext lernen kann (d. h. Few-Shot-Lernen) #🎜🎜 ## 🎜🎜#. Das Forschungsziel besteht darin, die Wahrnehmung mit LLM in Einklang zu bringen, sodass das Modell sehen und sprechen kann. Die Forscher trainierten KOSMOS-1 von Grund auf nach der Methode von METALM (siehe den Artikel „Sprachmodelle sind Allzweckschnittstellen“).

- Projektadresse: https://github .com/microsoft/unilm

- Wie in Abbildung 1 unten dargestellt, verwendet der Forscher ein Transformer-basiertes Sprachmodell als allgemeine Schnittstelle , und verbinden Sie es mit dem Wahrnehmungsmodul. Sie trainierten das Modell auf einem multimodalen Korpus im Webmaßstab, der Textdaten, willkürlich verschachtelte Bilder und Texte sowie Bild-Untertitel-Paare umfasst. Darüber hinaus kalibrierten die Forscher die modalübergreifende Fähigkeit, Anweisungen zu befolgen, indem sie reine Sprachdaten übermittelten.

Schließlich unterstützt das KOSMOS-1-Modell nativ Sprache, Wahrnehmungssprache und visuelle Aufgaben in Zero-Shot- und Fence-Shot-Lerneinstellungen, wie in Tabelle 1 unten gezeigt.

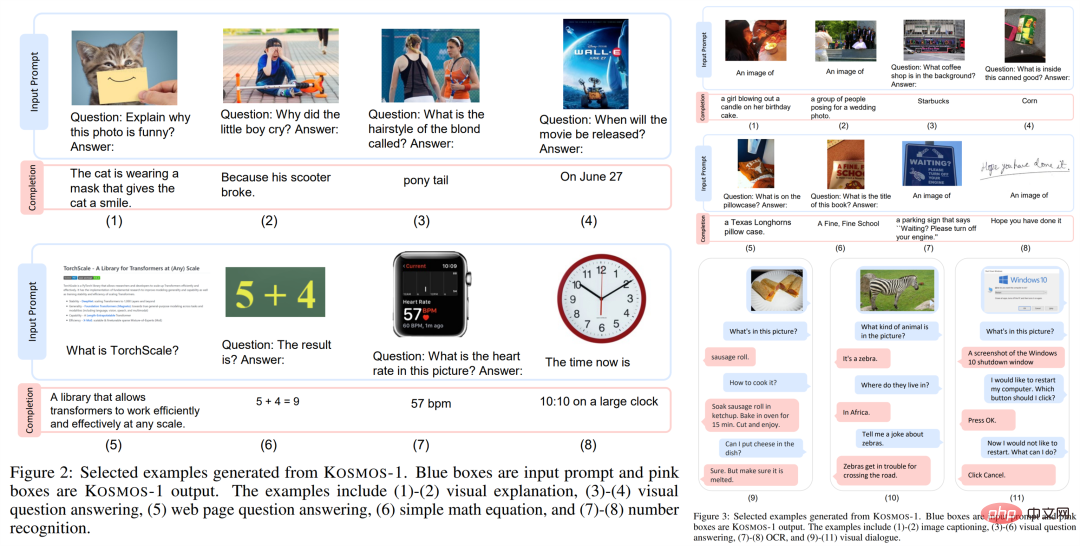

Zusätzlich zu verschiedenen Aufgaben in natürlicher Sprache kann das KOSMOS-1-Modell nativ eine Vielzahl wahrnehmungsintensiver Aufgaben bewältigen, wie z. B. visueller Dialog, visuelle Erklärung, visuelle Frage und Antwort, Bild Untertitel, einfache mathematische Gleichungen, OCR und Zero-Shot-Bildklassifizierung mit Beschreibung. Sie haben außerdem einen IQ-Test-Benchmark basierend auf Raven's Progressive Matrices (RPM) erstellt, um die Fähigkeit zum nonverbalen Denken von MLLM zu bewerten.

Diese Beispiele zeigen, dass die native Unterstützung der multimodalen Wahrnehmung darin besteht, LLM-Anwendungen zu integrieren auf neue Aufgaben bietet neue Chancen. Darüber hinaus erzielt MLLM im Vergleich zu LLM eine bessere Leistung beim gesunden Menschenverstand, was darauf hindeutet, dass der modalübergreifende Transfer den Wissenserwerb erleichtert.

Diese Beispiele zeigen, dass die native Unterstützung der multimodalen Wahrnehmung darin besteht, LLM-Anwendungen zu integrieren auf neue Aufgaben bietet neue Chancen. Darüber hinaus erzielt MLLM im Vergleich zu LLM eine bessere Leistung beim gesunden Menschenverstand, was darauf hindeutet, dass der modalübergreifende Transfer den Wissenserwerb erleichtert.

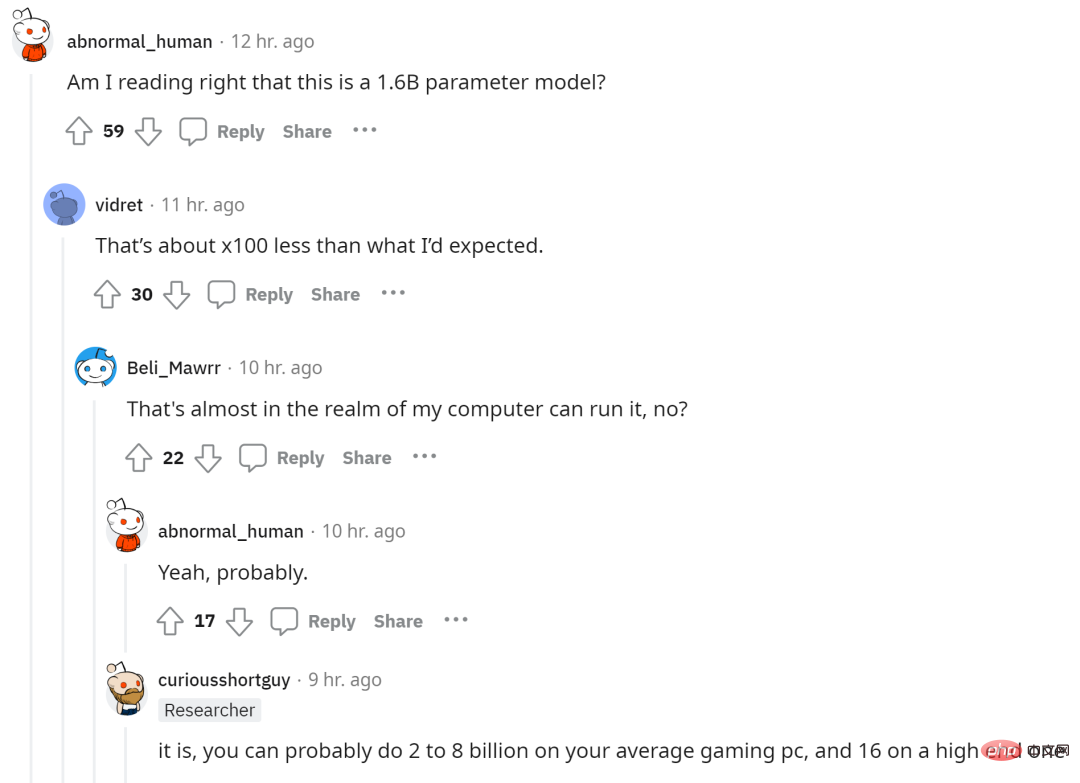

Da die Anzahl der Parameter des KOSMOS-1-Modells 1,6 Milliarden beträgt, äußerten einige Internetnutzer die Hoffnung, dieses große multimodale Modell auf ihren Computern ausführen zu können.

KOSMOS-1: Ein multimodales Sprachmodell im großen Maßstab

Wie in Abbildung 1 dargestellt, ist KOSMOS-1 ein multimodales Sprachmodell, das allgemeine Modalitäten wahrnehmen, Anweisungen befolgen und im Kontext lernen und Ausgaben generieren kann. Konkret ist das Rückgrat von KOSMOS-1 ein auf Transformer basierendes kausales Sprachmodell. Neben Text können auch andere Modalitäten eingebettet und in das Modell eingegeben werden. Wie in der Abbildung unten gezeigt, gibt es neben Sprache auch Einbettungen von Vision, Sprache usw. Transformatordecoder dienen als allgemeine Schnittstelle für multimodale Eingaben. Sobald das Modell trainiert ist, kann KOSMOS-1 auch für Sprachaufgaben und multimodale Aufgaben in Zero-Shot- und Few-Shot-Einstellungen evaluiert werden.

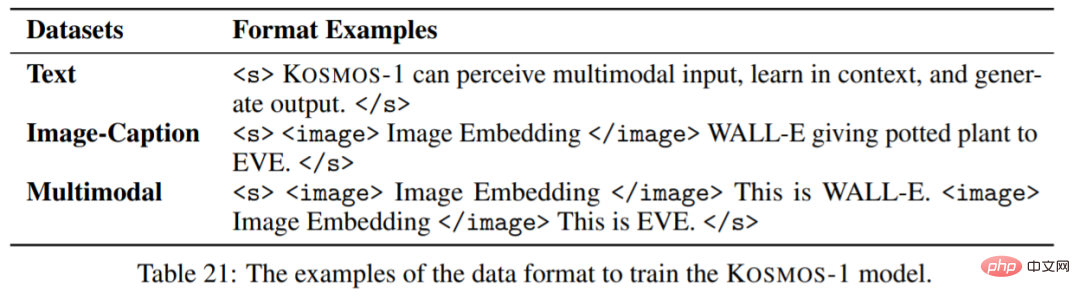

Der Transformatordecoder nimmt die Modalität auf einheitliche Weise wahr und die Eingabeinformationen werden mit speziellen Token zu einer Sequenz zusammengefasst. Beispielsweise bedeutet den Anfang der Sequenz und das Ende der Sequenz. Die speziellen Token

Danach wird die erhaltene Einbettung der Eingabesequenz dem Transformer-basierten Decoder zugeführt. Das kausale Modell verarbeitet die Sequenz dann autoregressiv, was zum nächsten Token führt. Zusammenfassend lässt sich sagen, dass das MLLM-Framework verschiedene Datentypen flexibel verarbeiten kann, solange die Eingaben als Vektoren dargestellt werden.

Der erste ist der Trainingsdatensatz. Zu den Datensätzen gehören Textkorpora, Bild-Untertitel-Paare sowie bild- und textübergreifende Datensätze. Konkret umfasst das Textkorpus The Pile und Common Crawl (CC); die Bild-Untertitel-Paare umfassen Englisch LAION-2B, LAION-400M, COYO-700M und Conceptual Captions; der übergreifende Bild- und Text-Datensatz stammt von Common Crawl Schnappschuss.

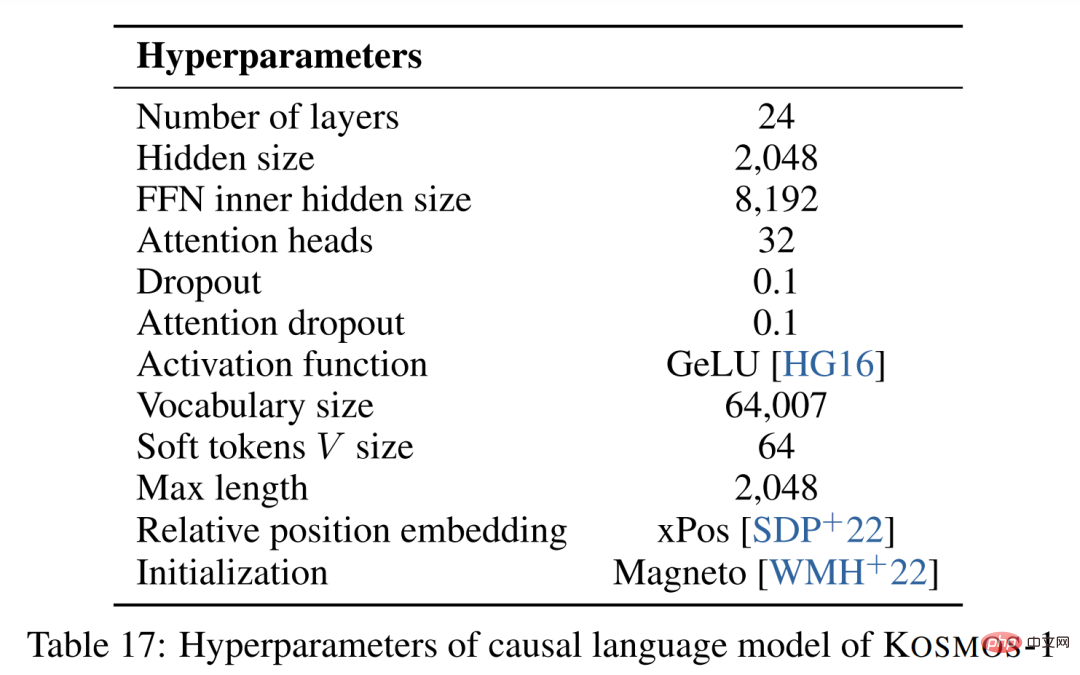

Da wir nun den Datensatz haben, haben wir die Trainingseinstellungen. Die MLLM-Komponente enthält 24 Schichten, versteckte Dimensionen von 2048, 8192 FFNs, 32 Aufmerksamkeitsköpfe und eine Parametergröße von 1,3B. Um eine bessere Modellkonvergenz zu ermöglichen, werden Bilddarstellungen aus dem vorab trainierten CLIP ViT-L/14-Modell mit 1024 Merkmalsdimensionen erhalten. Bilder werden während des Trainings auf eine Auflösung von 224 × 224 vorverarbeitet. Darüber hinaus werden alle CLIP-Modellparameter mit Ausnahme der letzten Ebene während des Trainings eingefroren. Die Gesamtzahl der Parameter für KOSMOS-1 beträgt etwa 1,6 Milliarden.

Experimentelle Ergebnisse

Diese Studie führte eine Reihe umfangreicher Experimente durch, um KOSMOS-1 zu bewerten: Sprachaufgaben (Sprachverständnis, Sprachgenerierung, OCR-freie Textklassifizierung); Gesunder Menschenverstand); Nonverbales Denken (IQ-Test); Wahrnehmungs- und Sprachaufgaben (Bilduntertitel, visuelle Frage und Antwort, Webseitenfrage und -antwort); ).

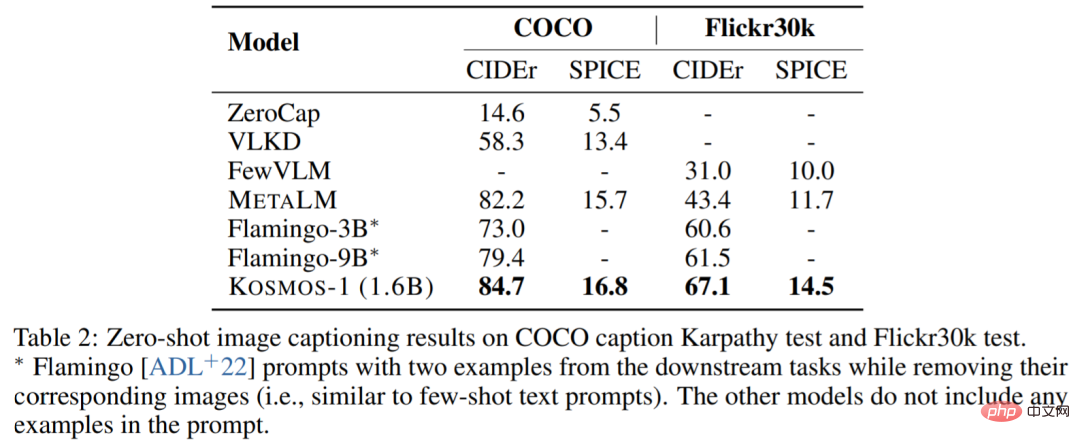

Die folgende Tabelle zeigt die Zero-Sample-Leistung verschiedener Modelle auf COCO und Flickr30k. Im Vergleich zu anderen Modellen hat KOSMOS-1 beachtliche Ergebnisse erzielt und seine Leistung ist auch dann gut, wenn man bedenkt, dass die Anzahl der Parameter viel geringer ist als bei Flamingo.

Die folgende Tabelle zeigt den Leistungsvergleich einiger Proben:

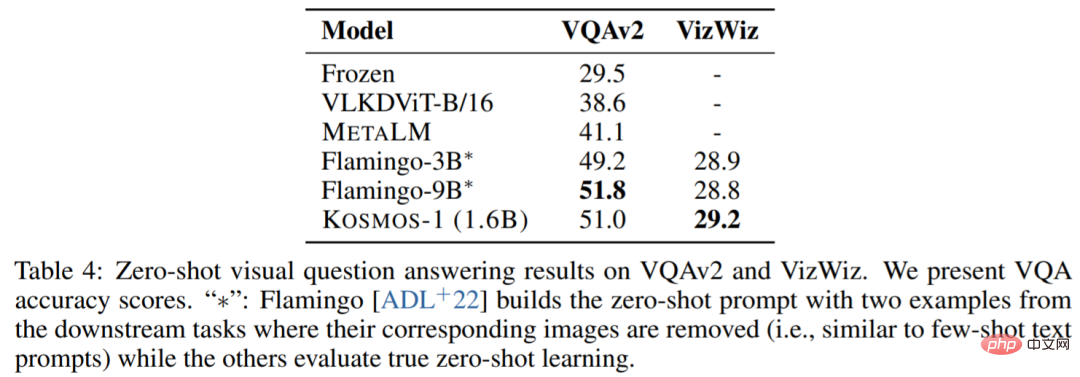

Visuelle Fragen und Antworten. KOSMOS-1 hat eine höhere Genauigkeit und Robustheit als die Modelle Flamingo-3B und Flamingo-9B:

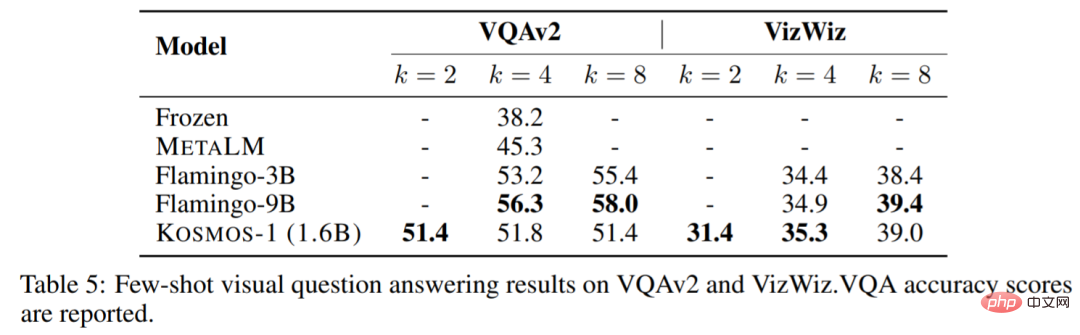

Die folgende Tabelle zeigt einen Leistungsvergleich einiger Beispiele:

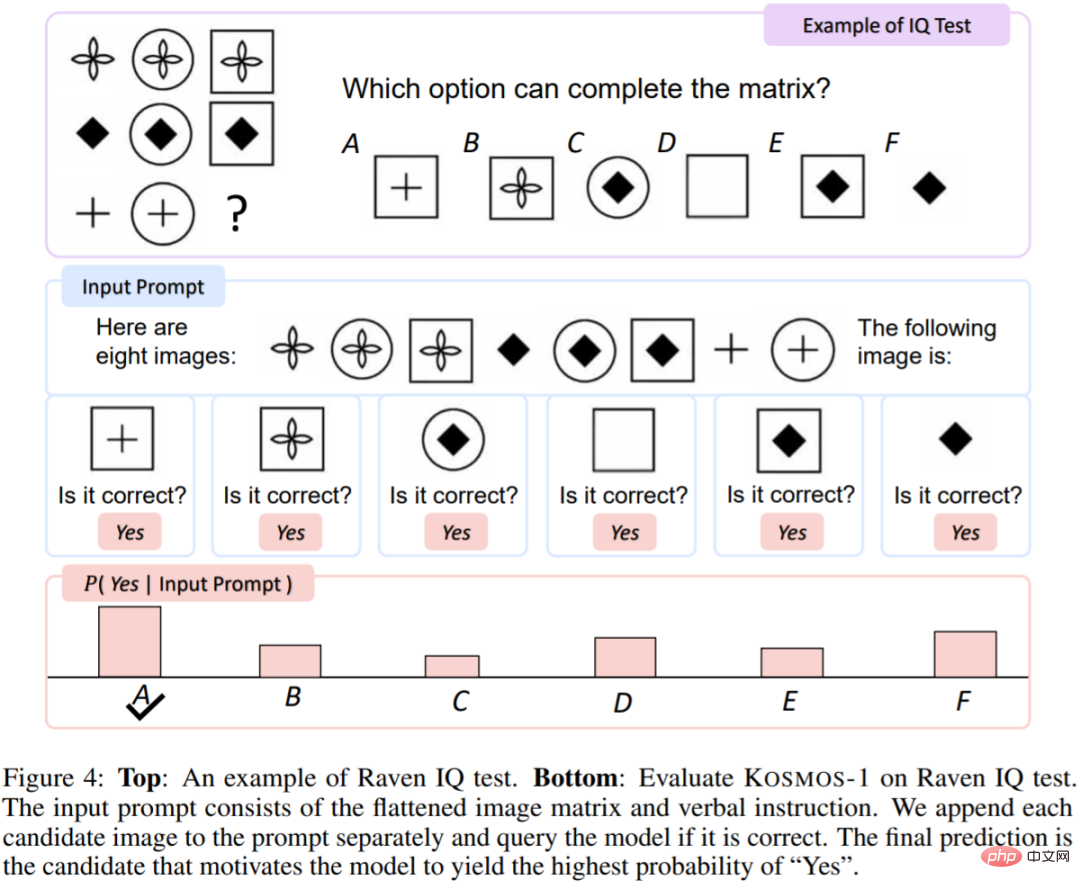

IQ-Test. Der Raven's Reasoning Test ist einer der am häufigsten verwendeten Tests zur Beurteilung des nonverbalen Denkens. Abbildung 4 zeigt ein Beispiel.

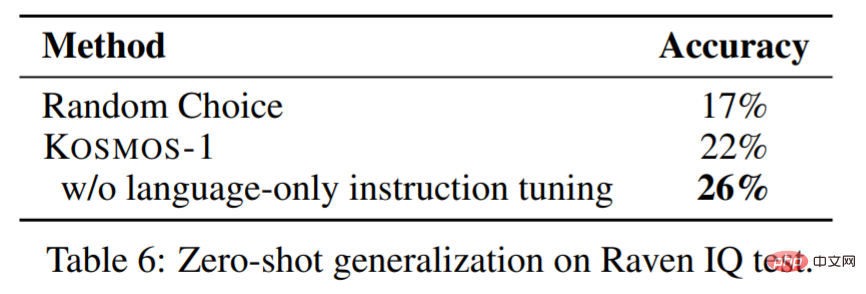

Tabelle 6 zeigt die Auswertungsergebnisse des IQ-Testdatensatzes. KOSMOS-1 ist in der Lage, abstrakte konzeptionelle Muster in einer nonverbalen Umgebung wahrzunehmen und dann nachfolgende Elemente aus mehreren Auswahlmöglichkeiten zu begründen. Unseres Wissens ist dies das erste Mal, dass ein Modell einen solchen Raven-IQ-Test ohne Stichprobe durchführen konnte.

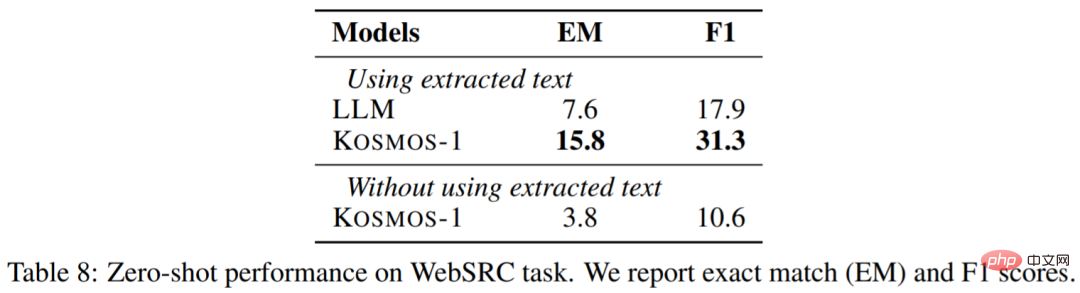

Web-Fragen und Antworten. Web Q&A zielt darauf ab, Antworten auf Fragen von Webseiten zu finden. Es erfordert, dass das Modell sowohl die Semantik als auch die Struktur des Textes versteht. Die Ergebnisse sind wie folgt:

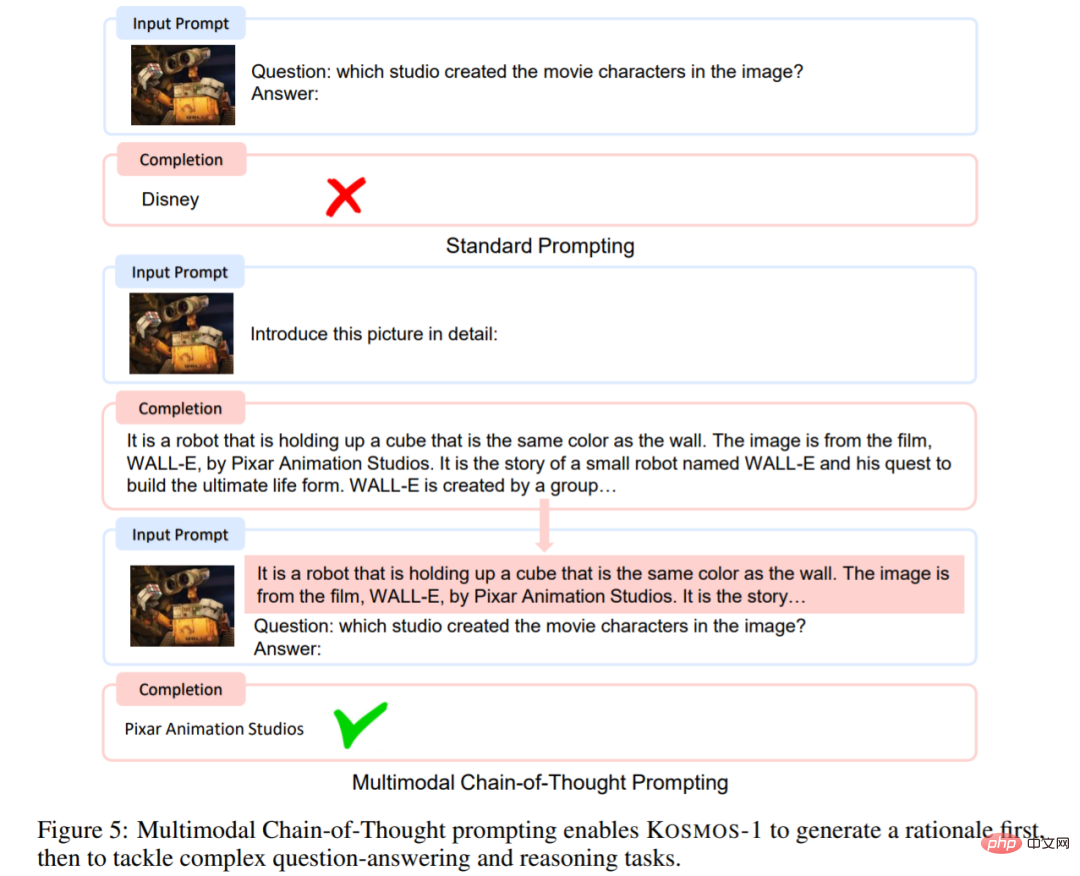

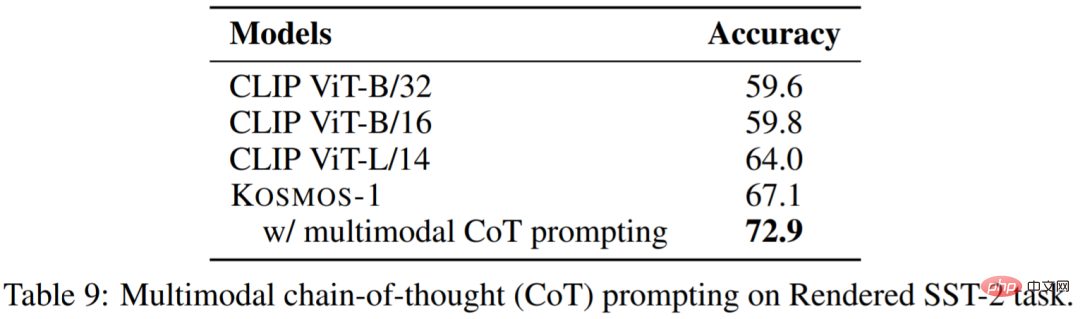

Multimodale Denkkettenanregungen. Inspiriert durch die Anregungen der Denkkette führte dieser Artikel ein diesbezügliches Experiment durch. Wie in Abbildung 5 dargestellt, zerlegt dieser Artikel die Sprachwahrnehmungsaufgabe in zwei Schritte. Wenn in der ersten Phase ein Bild vorliegt, werden Hinweise verwendet, um das Modell bei der Generierung einer Ausgabe anzuleiten, die den Anforderungen zum Erzielen des Endergebnisses entspricht.

Wie aus Tabelle 9 ersichtlich ist, beträgt die Punktzahl der multimodalen Denkkettenaufforderung 72,9 Punkte, 5,8 Punkte mehr als die Standardaufforderung:

Erfahren Sie mehr Informationen zum Experiment finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonKommt das multimodale ChatGPT von Microsoft? 1,6 Milliarden Parameter zur Bewältigung von Aufgaben wie dem Betrachten von Bildern und Beantworten von Fragen, IQ-Tests usw.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

So implementieren Sie die Dateisortierung nach Debian Readdir

Apr 13, 2025 am 09:06 AM

So implementieren Sie die Dateisortierung nach Debian Readdir

Apr 13, 2025 am 09:06 AM

In Debian -Systemen wird die Readdir -Funktion zum Lesen des Verzeichnisinhalts verwendet, aber die Reihenfolge, in der sie zurückgibt, ist nicht vordefiniert. Um Dateien in einem Verzeichnis zu sortieren, müssen Sie zuerst alle Dateien lesen und dann mit der QSORT -Funktion sortieren. Der folgende Code zeigt, wie Verzeichnisdateien mithilfe von Readdir und QSORT in Debian System sortiert werden:#include#include#include#include // benutzerdefinierte Vergleichsfunktion, verwendet für QSortIntCompare (constvoid*a, constvoid*b) {rettrcmp (*(*(*(

So optimieren Sie die Leistung von Debian Readdir

Apr 13, 2025 am 08:48 AM

So optimieren Sie die Leistung von Debian Readdir

Apr 13, 2025 am 08:48 AM

In Debian -Systemen werden Readdir -Systemaufrufe zum Lesen des Verzeichnisinhalts verwendet. Wenn seine Leistung nicht gut ist, probieren Sie die folgende Optimierungsstrategie aus: Vereinfachen Sie die Anzahl der Verzeichnisdateien: Teilen Sie große Verzeichnisse so weit wie möglich in mehrere kleine Verzeichnisse auf und reduzieren Sie die Anzahl der gemäß Readdir -Anrufe verarbeiteten Elemente. Aktivieren Sie den Verzeichnis -Inhalt Caching: Erstellen Sie einen Cache -Mechanismus, aktualisieren Sie den Cache regelmäßig oder bei Änderungen des Verzeichnisinhalts und reduzieren Sie häufige Aufrufe an Readdir. Speicher -Caches (wie Memcached oder Redis) oder lokale Caches (wie Dateien oder Datenbanken) können berücksichtigt werden. Nehmen Sie eine effiziente Datenstruktur an: Wenn Sie das Verzeichnis -Traversal selbst implementieren, wählen Sie effizientere Datenstrukturen (z.

So setzen Sie die Debian Apache -Protokollebene fest

Apr 13, 2025 am 08:33 AM

So setzen Sie die Debian Apache -Protokollebene fest

Apr 13, 2025 am 08:33 AM

In diesem Artikel wird beschrieben, wie Sie die Protokollierungsstufe des Apacheweb -Servers im Debian -System anpassen. Durch Ändern der Konfigurationsdatei können Sie die ausführliche Ebene der von Apache aufgezeichneten Protokollinformationen steuern. Methode 1: Ändern Sie die Hauptkonfigurationsdatei, um die Konfigurationsdatei zu finden: Die Konfigurationsdatei von Apache2.x befindet sich normalerweise im Verzeichnis/etc/apache2/. Der Dateiname kann je nach Installationsmethode Apache2.conf oder httpd.conf sein. Konfigurationsdatei bearbeiten: Öffnen Sie die Konfigurationsdatei mit Stammberechtigungen mit einem Texteditor (z. B. Nano): Sudonano/etc/apache2/apache2.conf

Wie Debian OpenSSL verhindert, dass Mann-in-the-Middle-Angriffe

Apr 13, 2025 am 10:30 AM

Wie Debian OpenSSL verhindert, dass Mann-in-the-Middle-Angriffe

Apr 13, 2025 am 10:30 AM

In Debian Systems ist OpenSSL eine wichtige Bibliothek für Verschlüsselung, Entschlüsselung und Zertifikatverwaltung. Um einen Mann-in-the-Middle-Angriff (MITM) zu verhindern, können folgende Maßnahmen ergriffen werden: Verwenden Sie HTTPS: Stellen Sie sicher, dass alle Netzwerkanforderungen das HTTPS-Protokoll anstelle von HTTP verwenden. HTTPS verwendet TLS (Transport Layer Security Protocol), um Kommunikationsdaten zu verschlüsseln, um sicherzustellen, dass die Daten während der Übertragung nicht gestohlen oder manipuliert werden. Überprüfen Sie das Serverzertifikat: Überprüfen Sie das Serverzertifikat im Client manuell, um sicherzustellen, dass es vertrauenswürdig ist. Der Server kann manuell durch die Delegate -Methode der URLSession überprüft werden

Debian Mail Server SSL -Zertifikat -Installationsmethode

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL -Zertifikat -Installationsmethode

Apr 13, 2025 am 11:39 AM

Die Schritte zur Installation eines SSL -Zertifikats auf dem Debian Mail -Server sind wie folgt: 1. Installieren Sie zuerst das OpenSSL -Toolkit und stellen Sie sicher, dass das OpenSSL -Toolkit bereits in Ihrem System installiert ist. Wenn nicht installiert, können Sie den folgenden Befehl installieren: sudoapt-getupdatesudoapt-getinstallopenssl2. Generieren Sie den privaten Schlüssel und die Zertifikatanforderung als nächst

Debian Mail Server Firewall -Konfigurationstipps

Apr 13, 2025 am 11:42 AM

Debian Mail Server Firewall -Konfigurationstipps

Apr 13, 2025 am 11:42 AM

Das Konfigurieren der Firewall eines Debian -Mailservers ist ein wichtiger Schritt zur Gewährleistung der Serversicherheit. Im Folgenden sind mehrere häufig verwendete Firewall -Konfigurationsmethoden, einschließlich der Verwendung von Iptables und Firewalld. Verwenden Sie Iptables, um Firewall so zu konfigurieren, dass Iptables (falls bereits installiert) installiert werden:

Wie Debian Readdir sich in andere Tools integriert

Apr 13, 2025 am 09:42 AM

Wie Debian Readdir sich in andere Tools integriert

Apr 13, 2025 am 09:42 AM

Die Readdir -Funktion im Debian -System ist ein Systemaufruf, der zum Lesen des Verzeichnisgehalts verwendet wird und häufig in der C -Programmierung verwendet wird. In diesem Artikel wird erläutert, wie Readdir in andere Tools integriert wird, um seine Funktionalität zu verbessern. Methode 1: Kombinieren Sie C -Sprachprogramm und Pipeline zuerst ein C -Programm, um die Funktion der Readdir aufzurufen und das Ergebnis auszugeben:#include#include#includeIntmain (intargc, char*argv []) {Dir*Dir; structDirent*Eintrag; if (argc! = 2) {{

Wie man Debian Syslog lernt

Apr 13, 2025 am 11:51 AM

Wie man Debian Syslog lernt

Apr 13, 2025 am 11:51 AM

In diesem Leitfaden werden Sie erfahren, wie Sie Syslog in Debian -Systemen verwenden. Syslog ist ein Schlüsseldienst in Linux -Systemen für Protokollierungssysteme und Anwendungsprotokollnachrichten. Es hilft den Administratoren, die Systemaktivitäten zu überwachen und zu analysieren, um Probleme schnell zu identifizieren und zu lösen. 1. Grundkenntnisse über syslog Die Kernfunktionen von Syslog umfassen: zentrales Sammeln und Verwalten von Protokollnachrichten; Unterstützung mehrerer Protokoll -Ausgabesformate und Zielorte (z. B. Dateien oder Netzwerke); Bereitstellung von Echtzeit-Protokoll- und Filterfunktionen. 2. Installieren und Konfigurieren von Syslog (mit Rsyslog) Das Debian -System verwendet standardmäßig Rsyslog. Sie können es mit dem folgenden Befehl installieren: sudoaptupdatesud