Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Schulungskostenoptimierungspraxis des Tencent-Werbemodells basierend auf „Tai Chi'

Schulungskostenoptimierungspraxis des Tencent-Werbemodells basierend auf „Tai Chi'

Schulungskostenoptimierungspraxis des Tencent-Werbemodells basierend auf „Tai Chi'

In den letzten Jahren haben sich Big-Data-Augmented-Modelle zum Standardparadigma für die Modellierung im KI-Bereich entwickelt. In der Werbeszene nutzen große Modelle mehr Modellparameter und nutzen mehr Trainingsdaten. Die Modelle verfügen über stärkere Speicherkapazitäten und Generalisierungsfähigkeiten, was mehr Raum für die Verbesserung der Werbeeffekte eröffnet. Allerdings sind auch die für große Modelle im Trainingsprozess benötigten Ressourcen exponentiell gestiegen und der Speicher- und Rechendruck stellt große Herausforderungen für die Plattform für maschinelles Lernen dar.

Die Tencent Taiji Machine Learning Platform erforscht weiterhin Lösungen zur Kostenreduzierung und Effizienzsteigerung. Sie nutzt Hybrid-Bereitstellungsressourcen in Offline-Werbeschulungsszenarien, um die Ressourcenkosten erheblich zu senken. Sie stellt Tencent Advertising täglich 50 W kostengünstige Hybrid-Bereitstellungsressourcen zur Verfügung Die Ressourcenkosten für das Offline-Modelltraining von Tencent Advertising werden um 30 % reduziert, und durch eine Reihe von Optimierungsmethoden entspricht die Stabilität der gemeinsam genutzten Ressourcen der von normalen Ressourcen.

1. Einführung

Da große Modelle in den letzten Jahren große Erfolge bei der Eroberung verschiedener Big-Data-Aufträge im Bereich NLP erzielt haben, sind Big-Data-Plus-Modelle zum Standardparadigma für die Modellierung im KI-Bereich geworden. Die Modellierung von Suche, Werbung und Empfehlung ist keine Ausnahme. Mit Hunderten von Milliarden Parametern auf Schritt und Tritt sind T-Modelle zum Standard für große Vorhersageszenarien geworden Unternehmen.

In der Werbeszene verwenden große Modelle mehr Modellparameter und mehr Trainingsdaten. Die Modelle verfügen über stärkere Gedächtnis- und Generalisierungsfähigkeiten, was mehr Raum für die Verbesserung der Werbeeffekte eröffnet. Allerdings sind auch die Ressourcen, die für große Modelle im Trainingsprozess benötigt werden, exponentiell gestiegen, und der Speicher- und Rechendruck stellt große Herausforderungen für die Plattform für maschinelles Lernen dar. Gleichzeitig wirkt sich die Anzahl der Experimente, die die Plattform unterstützen kann, direkt auf die Effizienz der Algorithmusiteration aus. Der Schwerpunkt der Bemühungen der Plattform liegt darin, mehr experimentelle Ressourcen zu geringeren Kosten bereitzustellen.

Die Tencent Taiji Machine Learning Platform erforscht weiterhin Lösungen zur Kostenreduzierung und Effizienzsteigerung. Sie nutzt Hybrid-Bereitstellungsressourcen in Offline-Werbeschulungsszenarien, um die Ressourcenkosten erheblich zu senken. Sie stellt Tencent Advertising täglich 50 W kostengünstige Hybrid-Bereitstellungsressourcen zur Verfügung Die Ressourcenkosten für die Offline-Modellschulung von Tencent Advertising werden um 30 % gesenkt, und durch eine Reihe von Optimierungsmethoden ist die Stabilität der am gleichen Standort befindlichen Ressourcen dieselbe wie bei normalen Ressourcen.

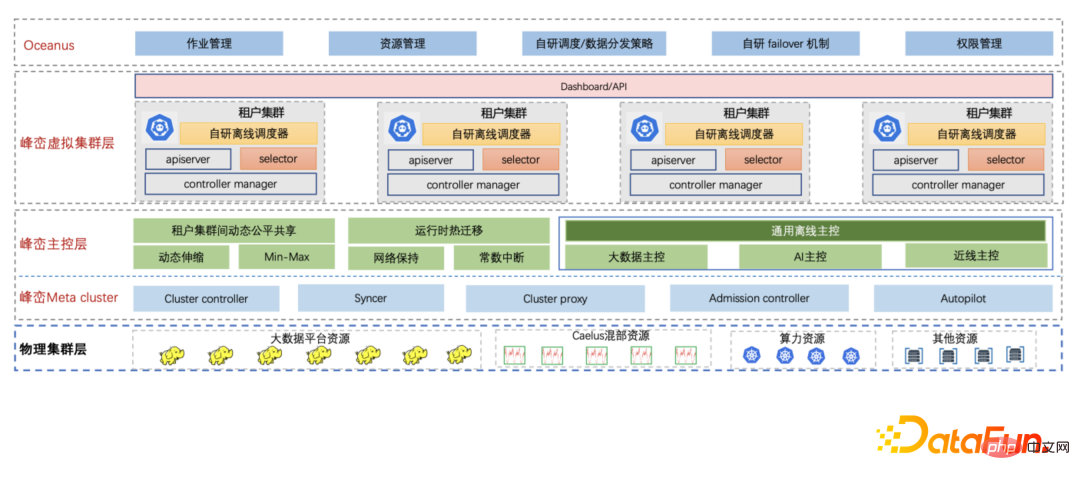

2, Einführung in die Taiji-Plattform für maschinelles Lernen

Die Taiji-Plattform für maschinelles Lernen ist bestrebt, Benutzern die Möglichkeit zu geben, sich stärker auf die Lösung und Anwendung von KI-Problemen im Unternehmen zu konzentrieren, und Algorithmus-Ingenieure bieten Lösungen aus einer Hand KI-Anwendungsprozess, Modellschulung, Modellservice und andere technische Fragen. Derzeit werden wichtige Unternehmen wie unternehmensinterne Werbung, Suche, Spiele, Tencent Conference und Tencent Cloud unterstützt.

Taiji Advertising Platform ist eine leistungsstarke Plattform für maschinelles Lernen, die von Taiji Advertising System entwickelt wurde und Modelltraining und Online-Argumentation integriert. Die Plattform verfügt über die Trainings- und Argumentationsfunktionen von Billionen-Parameter-Modellen. Derzeit unterstützt die Plattform Tencent-Werberückrufe, Grobranking, Feinranking, Dutzende von Modellschulungen und Online-Inferenzen. Gleichzeitig bietet die Taiji-Plattform eine zentrale Funktionsregistrierung, ergänzende Beispielaufzeichnung, Modellschulung, Modellbewertung und Online-Tests Fähigkeiten, wodurch die Fähigkeiten erheblich verbessert werden. Verbessern Sie die Entwicklereffizienz.

- Trainingsplattform: Derzeit unterstützt das Modelltraining zwei Trainingsmodi: CPU und GPU. Mithilfe selbst entwickelter effizienter Operatoren, gemischtem Präzisionstraining, 3D-Parallelität und anderen Technologien wird die Trainingsgeschwindigkeit im Vergleich zu um 1 erhöht die Größe der Open-Source-Systeme der Branche.

- Inference Framework: Taijis selbst entwickeltes heterogenes Computing-Framework HCF (Heterogeneous Computing Framework) bietet ultimative Leistungsoptimierung durch gemeinsame Optimierung der Hardwareschicht, Kompilierungsschicht und Softwareschicht.

3. Spezifische Umsetzung der Kostenoptimierung

(1) Einführung der Gesamtlösung

Mit der kontinuierlichen Weiterentwicklung der Taiji-Plattform nimmt die Anzahl der Aufgaben und Aufgabentypen zu und der Ressourcenbedarf steigt auch zunehmend. Um die Kosten zu senken und die Effizienz zu steigern, verbessert die Tai Chi-Plattform einerseits die Plattformleistung und erhöht andererseits die Trainingsgeschwindigkeit. Außerdem suchen wir nach günstigeren Ressourcen, um den wachsenden Ressourcenbedarf zu decken.

Fengluan – Tencents interne Cloud-native Big-Data-Plattform nutzt Cloud-native-Technologie, um die gesamte Big-Data-Architektur des Unternehmens zu aktualisieren. Um den kontinuierlich wachsenden Ressourcenbedarf des Big-Data-Geschäfts zu decken, hat Fengluan Co-Location-Ressourcen eingeführt, die nicht nur den Ressourcenbedarf decken, sondern auch die Ressourcenkosten erheblich senken können. Fengluan bietet eine Reihe von Lösungen für Co-Location-Ressourcen in verschiedenen Szenarien und wandelt instabile Co-Location-Ressourcen in stabile Ressourcen um, die für das Unternehmen transparent sind. Die Co-Location-Funktion von Fengluan unterstützt drei Arten von Co-Location-Ressourcen:

- Online-Leerlaufressourcen wiederverwenden. Aufgrund von Spitzen und Tiefpunkten der Online-Ressourcen, einer Überschätzung der Ressourcennutzung und einer Fragmentierung der Cluster-Ressourcen ist die Cluster-Ressourcenauslastung gering und es gibt eine große Anzahl ungenutzter Ressourcen. Fengluan nutzt diese vorübergehend ungenutzten Ressourcen, um Big-Data-Aufgaben auszuführen, und setzt sie derzeit in Szenarien wie Online-Werbung, Speicherung, soziale Unterhaltung und Spiele ein.

- Flexible Ausleihe von Offline-Ressourcen. Einige Aufgaben auf der Big-Data-Plattform weisen auch ein Gezeitenphänomen auf. Tagsüber, wenn die Ressourcennutzung des Big-Data-Clusters gering ist, unterstützt Fengluan die vorübergehende flexible Ausleihe einiger Ressourcen und nimmt diese Ressourcen dann vor dem Höhepunkt zurück Big-Data-Cluster kommt. Dieses Szenario eignet sich sehr gut zur Lösung des Problems, dass Online-Aufgaben während der Feiertage und bei großen Werbeaktionen vorübergehend eine große Menge an Ressourcen erfordern. Fengluan unterstützt derzeit große Feiertage wie das Frühlingsfest und 618.

- Computerressourcen wiederverwenden. Rechenressourcen werden aus den ungenutzten Ressourcen der Mica-Maschine in Form von CVM mit geringer Qualität abgebaut. Die sogenannte CVM mit geringer Qualität bezieht sich auf das Starten einer virtuellen CVM-Maschine mit einer niedrigeren CPU-Priorität auf der Mica-Maschine von anderen virtuellen Maschinen in Echtzeit überholt werden. Basierend auf den Ressourceninformationen, die von der zugrunde liegenden Rechenleistung bereitgestellt werden, hat Fengluan zahlreiche Optimierungen in Aspekten wie Planung, Überlastungsschutz und Rechenleistungsmigration vorgenommen. Derzeit laufen Big-Data-Aufgaben mit Millionen von Kernen stabil auf Rechenleistungsressourcen.

Gleichzeitig führt Fengluan die Cloud-native virtuelle Clustertechnologie ein, um die Streuungseigenschaften abzuschirmen, die durch die zugrunde liegenden gemischten Bereitstellungsressourcen verursacht werden aus verschiedenen Städten und Regionen. Die Taiji-Plattform stellt eine direkte Verbindung zum Fengluan-Mietercluster her, der einer Vielzahl zugrunde liegender Co-Location-Ressourcen entspricht. Der Mietercluster verfügt über eine unabhängige und vollständige Clusterperspektive, und die Taiji-Plattform kann auch nahtlos verbunden werden.

(2) Ressourcengemischter Bereitstellungsplan#🎜🎜 #

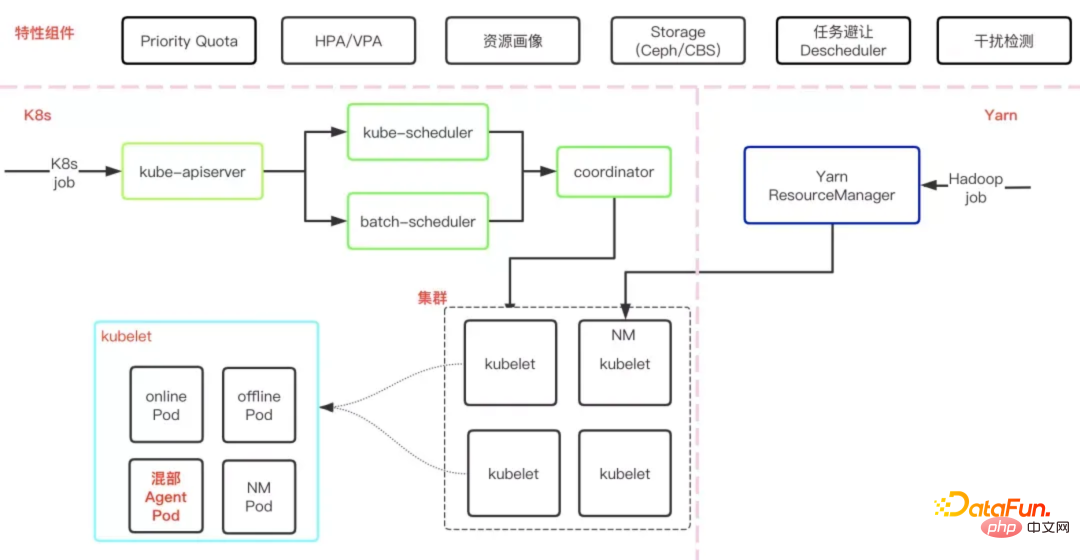

Online-Leerlaufressourcen

Fengluan hat die vollständige Offline-Mischbereitstellungslösung von Caelus selbst entwickelt, indem Online- und Offline-Operationen gemischt werden Auf diese Weise können wir die ungenutzten Ressourcen von Online-Maschinen vollständig nutzen, die Ressourcennutzung von Online-Maschinen verbessern und die Ressourcenkosten von Offline-Vorgängen senken.

Wie in der folgenden Abbildung dargestellt, handelt es sich um die Grundarchitektur von Caelus. Die verschiedenen Komponenten und Module arbeiten in vielen Fällen zusammen, um die Qualität der gemischten Bereitstellung sicherzustellen Aspekte.

Erstens gewährleistet Caelus in vollem Umfang die Servicequalität des Online-Betriebs, die auch eine der wichtigen Voraussetzungen für Co-Location ist, wie zum Beispiel: durch schnelle Störungserkennung und Verarbeitungsmechanismen. Erfassen Sie aktiv die Qualität von Online-Diensten, verarbeiten Sie diese zeitnah und unterstützen Sie Plug-in-Erweiterungsmethoden, um die spezifischen Interferenzerkennungsanforderungen des Unternehmens zu unterstützen und eine hohe Priorität von Online-Diensten durch volldimensionale Ressourcenisolierung sicherzustellen Ressourcenmanagementstrategien usw.

Zweitens gewährleistet Caelus die SLO von Offline-Jobs in vielerlei Hinsicht, wie zum Beispiel: Zuordnung geeigneter Ressourcen zu Jobs durch Co-Location-Ressourcen und Offline-Jobporträts, um Ressourcenkonkurrenz zu vermeiden, Priorisierung von Räumungen und Unterstützung eines ordnungsgemäßen Ausstiegs Die Strategie ist flexibel und kontrollierbar. Im Gegensatz zu Big-Data-Offline-Jobs, bei denen es sich meist um kurze Jobs (Minuten oder sogar Sekunden) handelt, dauert die Ausführung der meisten Tai-Chi-Jobs länger (Stunden oder sogar Tage). Durch langfristige Ressourcenvorhersagen und Jobporträts können wir die Planung besser steuern, um geeignete Ressourcen für Jobs mit unterschiedlichen Laufzeiten und unterschiedlichen Ressourcenanforderungen zu finden, und vermeiden, dass Jobs nach stunden- oder sogar tagelanger Ausführung verworfen werden, was zum Verlust des Jobstatus führt. Verschwendung von Ressourcen und Zeit. Wenn ein Offline-Job entfernt werden muss, wird zuerst die Live-Migration zur Laufzeit verwendet, um die Jobinstanz von einem Computer auf einen anderen zu migrieren, während der Speicherstatus und die IP unverändert bleiben. Dies hat nahezu keine Auswirkungen auf den Job, was die Leistung erheblich verbessert Arbeitseffizienz. Um die Co-Location-Ressourcen besser zu nutzen, verfügt Caelus auch über mehr Funktionen. Weitere Informationen finden Sie in der Offline-Co-Location-Lösung von Caelus /link /caaeb10544b465034f389991efc90877).

Gezeitenressourcen

Wie in der folgenden Abbildung dargestellt, erfordern die Ausgrabung, Bewirtschaftung und Nutzung von Gezeitenressourcen die Arbeitsteilung und Zusammenarbeit mehrerer Systeme:

Das auf Algorithmen des maschinellen Lernens basierende Big-Data-Ressourcenübertragungssystem findet die am besten geeigneten Maschinenknoten, die offline sind, um bestimmte Ressourcenanforderungen zu erfüllen und die geringsten Auswirkungen auf laufende Jobs zu haben. Anschließend wird die Planung neuer Jobs für diese Knoten verhindert und auf die Ausführung von Jobs auf diesen Knoten gewartet Nach Abschluss des Vorgangs werden die Auswirkungen auf Big-Data-Jobs minimiert.

- Caelus Mixed System: Obwohl Big Data nicht auf den durch die Übertragung frei gewordenen Maschinenressourcen ausgeführt wird system Der Job ist beendet, aber der HDFS-Dienst läuft noch darauf und bietet auch Dienste zum Lesen und Schreiben von Daten. Um den HDFS-Dienst zu schützen, wird das Caelus-Colocation-System eingeführt, das HDFS als Online-Dienst nutzt und sicherstellt, dass die Qualität des HDFS-Dienstes durch die Reihe von Online-Dienstsicherungsmethoden von Caelus nicht beeinträchtigt wird (z. B. Erkennung, ob sie beeinträchtigt ist). durch HDFS-Schlüsselindikatoren).

- Gezeitenressourcen durch virtuelle Cluster nutzen: Diese übertragenen Maschinenressourcen werden von Fengluo Management und vereinheitlicht Die Planung wird der Taiji-Plattform in Form eines virtuellen Clusters bereitgestellt, der native K8S-Schnittstellen bereitstellt. Dadurch werden die Unterschiede in den zugrunde liegenden Ressourcen von der oberen Plattform abgeschirmt und sichergestellt, dass Anwendungen Ressourcen auf die gleiche Weise nutzen. #? Um die Auswirkungen des Recyclings zu verringern, wurde beim Ausführen von Big-Data-Jobs die Haltepunkt-Wiederaufnahmefunktion der Spitzen- und Anwendungsschicht geöffnet, um einen Ressourcenwechsel ohne Unterbrechung des Trainings zu realisieren, und der weitere Betrieb des Unternehmens wird nach dem Wechsel nicht beeinträchtigt.

- Computerressourcen

- Die Eigenschaften von Computerressourcen sind: Was Das Unternehmen präsentiert ein exklusives CVM, das geschäftsfreundlicher ist. Die Herausforderung bei der Nutzung von Rechenressourcen besteht jedoch darin, dass die CPU-Ressourcen von CVM mit geringer Qualität auf Glimmermaschinenebene jederzeit durch Online-CVM unterdrückt werden, was zu sehr instabilen Rechenressourcen führt: #🎜 🎜## 🎜🎜#Die Rechenleistungsmaschine ist instabil: Die Rechenleistungsmaschine wird aufgrund fragmentierter Ressourcenkonsolidierung, unzureichender Leistung im Computerraum usw. offline gehen. Niedrige Priorität der Rechenressourcen: Um sicherzustellen, dass die Servicequalität normaler CVM-Maschinen nicht beeinträchtigt wird, haben Jobs auf Rechenressourcen die niedrigste Priorität und werden bedingungslos ausgeführt Hohe Arbeitszugeständnisse bei den Ressourcen führen zu einer äußerst instabilen Leistung.

Hohe Räumungshäufigkeit: Verschiedene Gründe (unzureichende Rechenressourcenleistung, unzureichender Speicherplatz, festsitzende Festplatte usw.) lösen eine aktive Räumung von Pods aus, was die Wahrscheinlichkeit von Pod-Ausfällen erhöht .

Um das Instabilitätsproblem der Rechenressourcen zu lösen, werden verschiedene Fähigkeiten durch die Hauptkontrollschicht auf Gipfeln und Bergen erweitert und die Rechenressourcen optimiert Viele Aspekte. Verbessern Sie die Stabilität der Rechenleistung: Bild und Vorhersage:

- Erkunden und sammeln Sie verschiedene Maschinenleistungsindikatoren, generieren Sie aggregierte Indikatoren und prognostizieren Sie die verfügbaren Ressourcen von CVM mit geringer Qualität in der Zukunft. Diese Informationen werden vom Planer verwendet, um Pods und die Räumungskomponente zur Räumung zu planen Pods, um die Ressourcenanforderungen der Pods zu erfüllen.

- ② Terminoptimierung: Um die Servicequalität von Tai Chi-Betrieben sicherzustellen, basierend auf den Bedürfnissen des Betriebs und den Merkmalen Für die Ressourcen gibt es einige Planungsstrategien. Weitere Optimierungen haben die Arbeitsleistung um mehr als das Zweifache verbessert.

- Intra-City-Planung: Die Planung von PST- und Schulungsaufträgen im selben Computerraum in derselben Stadt minimiert die Netzwerkverzögerung zwischen Jobinstanzen und die Kosten für die Netzwerkbandbreite in derselben Stadt sind ebenfalls geringer, was die Kosten senkt.

- Planungsoptimierung für einzelne Maschinen: Wählen Sie in Kombination mit den Ergebnissen der Ressourcenvorhersage und Indikatoren wie CPU-Stealtime eine CPU mit besserer Leistung für den Job aus und binden Sie Kerne, um die Jobleistung besser zu verbessern.

- Abgestufte Planung: Beschriften und bewerten Sie alle verwalteten Ressourcen automatisch und planen Sie Jobs mit hohen Disaster Recovery-Anforderungen wie Job Manager automatisch für relativ stabile Ressourcen.

- Planungsparameter optimieren: Basierend auf Ressourcenporträts und Prognosedaten priorisiert der Planer Knoten mit besserer Leistung und mehr Stabilität für Jobs. Um das durch inkonsistente Schritte verursachte Echelon-Ablaufproblem zu lösen, werden außerdem Instanzen desselben Jobs auf Maschinen mit ähnlicher Leistung geplant in der aktiven Eviction-Phase Migration, sodass das Geschäft grundsätzlich nicht wahrnehmbar ist: Um die Probleme der Ressourceninstabilität und des Anwendungsabbruchs aufgrund der Pod-Eviction zu bewältigen, wird eine Laufzeit-Hot-Migration implementiert und eine Vielzahl von Hot-Migration-Strategien bereitgestellt, um diese zu erfüllen die bedürfnisse von verschiedenen szenarien. Aktuellen Online-Daten zufolge beträgt die Unterbrechungszeit der Live-Migration bei Verwendung der Migrationsprioritätsstrategie für Container mit großem Speicher mehr als 10 Sekunden. Wir haben auch eine konstante Interrupt-Zeit unabhängig von der Speichergröße implementiert (eine Strategie, bei der die Wiederherstellung zuerst erfolgt). Derzeit werden jeden Tag mehr als 20.000 Pods erfolgreich aktiv migriert, und die Cluster-übergreifende Hot-Migration wird unterstützt, wodurch die Auswirkungen der Räumung erheblich reduziert werden.

- ④ Self-Feedback-Optimierung: Durch Ressourcenprofilierung werden Maschinen mit schlechter Leistung regelmäßig ausgetauscht und mit der zugrunde liegenden Plattform verbunden, um eine reibungslose Trennung von CVM zu erreichen, sodass Gipfel und Berge keinen Einfluss darauf haben Das Unternehmen migriert Anwendungsinstanzen einzeln, um die Auswirkungen auf die Instanzen zu reduzieren.

- ⑤ Verbessern Sie die Disaster-Recovery-Fähigkeit der Flink-Ebene, unterstützen Sie Single-Point-Restart und hierarchische Planung.

- Hot-Migration-Technologie: Bevor der Task-Manager entfernt werden soll, erkennt er den entsprechenden Task-Manager im Voraus und migriert ihn gleichzeitig in einen anderen Pod. Dabei werden Speicherkomprimierung, Streaming-Parallelität und Cluster-übergreifende Hot-Migration verwendet weitere Funktionen, um den Erfolg der Hot-Migration-Rate kontinuierlich zu optimieren.

- Neustart des Task-Managers: Wenn ein Task-Manager in der Aufgabe aufgrund einer Ausnahme oder Räumung fehlschlägt, schlägt nicht die gesamte Aufgabe fehl und wird stattdessen sofort beendet. Stattdessen wird zuerst der Status des Task-Managers und dann des Task-Managers gespeichert wird neu gestartet, wodurch die Wahrscheinlichkeit eines Scheiterns der gesamten Aufgabe verringert wird.

- Vollständige Wiederherstellung der Aufgabe: Wenn sich eine Aufgabe aufgrund eines abnormalen Flink-Status in einem nicht wiederherstellbaren Zustand befindet, wird der Neustart des Job Managers ausgelöst. Um die Stabilität des Job Managers sicherzustellen, stellt die Plattform den Job Manager bereit Stellen Sie in Bezug auf die Ressourcen sicher, dass der Aufgabenstatus normal ist.

- Wiederaufnahme des Trainings an Haltepunkten: Wenn die vorherigen Fehlertoleranzstrategien fehlschlagen, startet die Plattform die Aufgabe basierend auf einem bestimmten Cckpt im Verlauf neu.

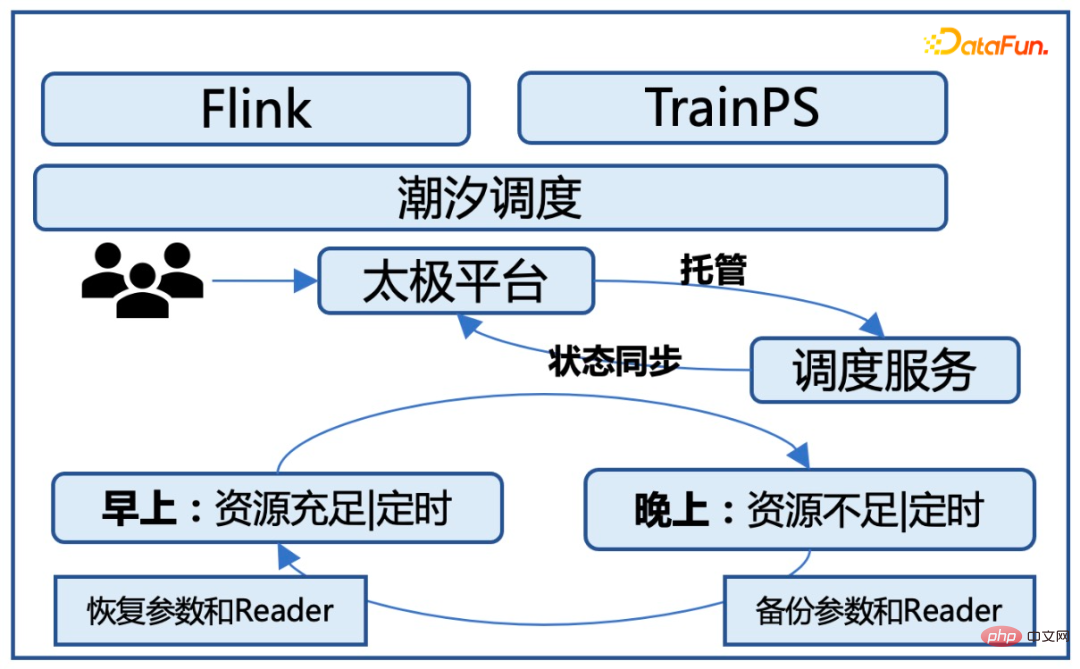

- Gezeitenphänomen: Ressourcen können tagsüber für Offline-Aufgaben bereitgestellt werden und müssen nachts recycelt werden.

- Dynamische Veränderungen der Ressourcen: Tagsüber sind die Ressourcen ebenfalls instabil und ändern sich jederzeit. Im Allgemeinen sind die Ressourcen morgens relativ gering, dann nehmen die Ressourcen allmählich zu und die Ressourcen erreichen nachts ihren Höhepunkt.

- Ressourcenbewusste Planungsstrategie: Da die Ressourcen am Morgen allmählich zunehmen, muss der Gezeitenplanungsdienst Ressourcenänderungen erkennen und die Ressourcenbedingungen verfolgen, um Aufgaben für die weitere Schulung zu starten.

- Automatische Modellsicherungsfunktion: Vor dem Ressourcen-Recycling in der Nacht müssen alle auf der aktuellen Plattform ausgeführten Aufgaben Schritt für Schritt gesichert werden. Dies setzt den Speicher und die Bandbreite der Plattform stark aus Es gibt Hunderte von Aufgaben auf der Plattform. Die Größe des Cold-Standby für jede Aufgabe reicht von einigen hundert G bis zu mehreren Terabyte. Wenn Cold-Standby gleichzeitig ausgeführt wird, müssen Hunderte von Terabyte an Daten in kurzer Zeit übertragen und gespeichert werden Zeit, was eine große Herausforderung für die Speicherung und das Netzwerk darstellt. Daher ist es notwendig, eine vernünftige Planungsstrategie zu haben und das Modell schrittweise zu speichern.

- Intelligente Ressourcenplanungsfunktion: Im Vergleich zum herkömmlichen Training verursacht die Gezeitenplanung einen zusätzlichen Aufwand, wenn es um die Modellsicherung für das Ressourcenrecycling in der Nacht geht und wenn die Aufgabe jeden Morgen neu gestartet wird. Wenn wir planen, müssen wir bewerten, welche Aufgaben am selben Tag erledigt werden können und welche Aufgaben über mehrere Tage ausgeführt werden müssen. Bei Aufgaben, die am selben Tag erledigt werden können, legen wir Wert darauf, ihnen mehr Ressourcen zuzuweisen, um dies sicherzustellen dass die Aufgaben noch am selben Tag erledigt werden.

Optimieren Sie die Räumungsstrategie, um die Auswirkungen der Räumung zu minimieren: Wenn jede Maschine geräumt wird, erhalten die nach der Räumung gestarteten Pods Priorität, um zu vermeiden, dass sich dies auf die bereits gestarteten Aufgaben auswirkt. Dadurch wird jeweils nur ein Knoten geräumt verhindert, dass Upstream und Downstream einer einzelnen Aufgabe gleichzeitig entfernt werden, was zu Neustarts auf Aufgabenebene führt, wenn ein Pod entfernt wird. Es stellt eine Verbindung zum übergeordneten Flink-Framework her und informiert Flink proaktiv für eine schnelle Einzelpunktwiederherstellung.

Die meisten Co-Location-Ressourcen sind temporäre Ressourcen und werden häufig offline gehen.

Co-Location-Ressourcen werden bedingungslos hochwertigen Ressourcen weichen. was zu einer extrem instabilen Maschinenleistung führt;

Co-Location-Ressourcen Der automatische Räumungsmechanismus erhöht auch die Ausfallwahrscheinlichkeit von Knoten und Pods erheblich.

Um sicherzustellen, dass Aufgaben stabil auf Co-Location-Ressourcen ausgeführt werden können, verwendet die Plattform eine dreistufige Fehlertoleranzstrategie. Die spezifische Lösung lautet wie folgt:

Durch die Fehlertoleranz der Geschäftsschicht ist die Stabilität von Aufgaben, die auf Co-Location-Ressourcen ausgeführt werden, von anfänglich weniger als 90 % auf 99,5 % am Ende gestiegen, was im Wesentlichen der Stabilität der ausgeführten Aufgaben entspricht auf gewöhnlichen exklusiven Ressourcen.

Gezeitenplanung für Aufgaben

Gemäß den Gezeitenressourcenanforderungen können Offline-Trainingsaufgaben nur tagsüber verwendet werden und müssen nachts für die Online-Geschäftsnutzung bereitgestellt werden Aufgaben entsprechend der Ressourcenverfügbarkeit während des Tages; in der Nacht einen Kalt-Standby für die Aufgabe durchführen und die entsprechende Trainingsaufgabe stoppen. Gleichzeitig wird die Priorität jeder Aufgabenplanung über die Aufgabenverwaltungswarteschlange verwaltet. Neue Aufgaben, die nachts gestartet werden, gelangen automatisch in den Warteschlangenstatus und warten darauf, dass am nächsten Morgen neue Aufgaben gestartet werden.

Kernherausforderung:

Lösung:

Durch diese Optimierungen können wir sicherstellen, dass Aufgaben stabil auf Gezeitenressourcen ausgeführt werden können und die Geschäftsschicht grundsätzlich nicht kennen. Gleichzeitig wird die Ausführungsgeschwindigkeit der Aufgabe nicht wesentlich beeinträchtigt und der zusätzliche Overhead, der durch die Start- und Stoppplanung der Aufgabe verursacht wird, wird innerhalb von 10 % kontrolliert.

4. Online-Effekte und Zukunftsaussichten

Die Offline-Hybrid-Vertriebsoptimierungslösung von Tai Chi wurde in Tencent-Werbeszenarien implementiert. Sie bietet 30-W-Kern-Allwetter-Hybrid-Bereitstellungsressourcen und 20-W-Kern-Gezeitenressourcen für die Offline-Modellforschung von Tencent Tägliches Training zur Unterstützung der Werbeerinnerung, Groblayout, Feinlayout-Training für Multi-Szenario-Modelle. In Bezug auf die Ressourcenkosten betragen die Ressourcenkosten der Hybridbereitstellung für Aufgaben mit derselben Rechenlast 70 % der Ressourcenkosten normaler Ressourcen. Nach der Optimierung sind die Systemstabilität und die Erfolgsrate der physischen Cluster-Aufgaben im Wesentlichen gleich.

Einerseits werden wir den Einsatz von Hybrid-Computing-Ressourcen weiter verstärken, insbesondere den Einsatz von Hybrid-Computing-Ressourcen, andererseits wird das Online-Geschäft des Unternehmens GPU-basiert, also in die Anwendung gemischter Ressourcen zusätzlich zu den herkömmlichen Zusätzlich zu den CPU-Ressourcen wird versucht, während des Offline-Trainings auch Online-GPU-Ressourcen zu verwenden.

Das war's für das heutige Teilen, vielen Dank an alle.

Das obige ist der detaillierte Inhalt vonSchulungskostenoptimierungspraxis des Tencent-Werbemodells basierend auf „Tai Chi'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

PHPs Fähigkeiten zur Verarbeitung von Big-Data-Strukturen

May 08, 2024 am 10:24 AM

PHPs Fähigkeiten zur Verarbeitung von Big-Data-Strukturen

May 08, 2024 am 10:24 AM

Fähigkeiten zur Verarbeitung von Big-Data-Strukturen: Chunking: Teilen Sie den Datensatz auf und verarbeiten Sie ihn in Blöcken, um den Speicherverbrauch zu reduzieren. Generator: Generieren Sie Datenelemente einzeln, ohne den gesamten Datensatz zu laden, geeignet für unbegrenzte Datensätze. Streaming: Lesen Sie Dateien oder fragen Sie Ergebnisse Zeile für Zeile ab, geeignet für große Dateien oder Remote-Daten. Externer Speicher: Speichern Sie die Daten bei sehr großen Datensätzen in einer Datenbank oder NoSQL.

Fünf große Entwicklungstrends in der AEC/O-Branche im Jahr 2024

Apr 19, 2024 pm 02:50 PM

Fünf große Entwicklungstrends in der AEC/O-Branche im Jahr 2024

Apr 19, 2024 pm 02:50 PM

AEC/O (Architecture, Engineering & Construction/Operation) bezieht sich auf die umfassenden Dienstleistungen, die Architekturdesign, Ingenieurdesign, Bau und Betrieb in der Bauindustrie anbieten. Im Jahr 2024 steht die AEC/O-Branche angesichts des technologischen Fortschritts vor sich ändernden Herausforderungen. In diesem Jahr wird voraussichtlich die Integration fortschrittlicher Technologien stattfinden, was einen Paradigmenwechsel in Design, Bau und Betrieb einläuten wird. Als Reaktion auf diese Veränderungen definieren Branchen Arbeitsprozesse neu, passen Prioritäten an und verbessern die Zusammenarbeit, um sich an die Bedürfnisse einer sich schnell verändernden Welt anzupassen. Die folgenden fünf großen Trends in der AEC/O-Branche werden im Jahr 2024 zu Schlüsselthemen und empfehlen den Weg in eine stärker integrierte, reaktionsfähigere und nachhaltigere Zukunft: integrierte Lieferkette, intelligente Fertigung

Erfahrungsaustausch in der C++-Entwicklung: praktische Erfahrung in der C++-Big-Data-Programmierung

Nov 22, 2023 am 09:14 AM

Erfahrungsaustausch in der C++-Entwicklung: praktische Erfahrung in der C++-Big-Data-Programmierung

Nov 22, 2023 am 09:14 AM

Im Internetzeitalter ist Big Data zu einer neuen Ressource geworden. Mit der kontinuierlichen Verbesserung der Big-Data-Analysetechnologie ist die Nachfrage nach Big-Data-Programmierung immer dringlicher geworden. Als weit verbreitete Programmiersprache sind die einzigartigen Vorteile von C++ bei der Big-Data-Programmierung immer deutlicher hervorgetreten. Im Folgenden werde ich meine praktischen Erfahrungen in der C++-Big-Data-Programmierung teilen. 1. Auswahl der geeigneten Datenstruktur Die Auswahl der geeigneten Datenstruktur ist ein wichtiger Bestandteil beim Schreiben effizienter Big-Data-Programme. In C++ gibt es eine Vielzahl von Datenstrukturen, die wir verwenden können, z. B. Arrays, verknüpfte Listen, Bäume, Hash-Tabellen usw.

Anwendung von Algorithmen beim Aufbau einer 58-Porträt-Plattform

May 09, 2024 am 09:01 AM

Anwendung von Algorithmen beim Aufbau einer 58-Porträt-Plattform

May 09, 2024 am 09:01 AM

1. Hintergrund des Baus der 58-Portrait-Plattform Zunächst möchte ich Ihnen den Hintergrund des Baus der 58-Portrait-Plattform mitteilen. 1. Das traditionelle Denken der traditionellen Profiling-Plattform reicht nicht mehr aus. Der Aufbau einer Benutzer-Profiling-Plattform basiert auf Data-Warehouse-Modellierungsfunktionen, um Daten aus mehreren Geschäftsbereichen zu integrieren, um genaue Benutzerporträts zu erstellen Und schließlich muss es über Datenplattformfunktionen verfügen, um Benutzerprofildaten effizient zu speichern, abzufragen und zu teilen sowie Profildienste bereitzustellen. Der Hauptunterschied zwischen einer selbst erstellten Business-Profiling-Plattform und einer Middle-Office-Profiling-Plattform besteht darin, dass die selbst erstellte Profiling-Plattform einen einzelnen Geschäftsbereich bedient und bei Bedarf angepasst werden kann. Die Mid-Office-Plattform bedient mehrere Geschäftsbereiche und ist komplex Modellierung und bietet allgemeinere Funktionen. 2.58 Benutzerporträts vom Hintergrund der Porträtkonstruktion im Mittelbahnsteig 58

Diskussion über die Gründe und Lösungen für das Fehlen eines Big-Data-Frameworks in der Go-Sprache

Mar 29, 2024 pm 12:24 PM

Diskussion über die Gründe und Lösungen für das Fehlen eines Big-Data-Frameworks in der Go-Sprache

Mar 29, 2024 pm 12:24 PM

Im heutigen Big-Data-Zeitalter sind Datenverarbeitung und -analyse zu einer wichtigen Unterstützung für die Entwicklung verschiedener Branchen geworden. Als Programmiersprache mit hoher Entwicklungseffizienz und überlegener Leistung hat die Go-Sprache im Bereich Big Data nach und nach Aufmerksamkeit erregt. Im Vergleich zu anderen Sprachen wie Java, Python usw. verfügt die Go-Sprache jedoch über eine relativ unzureichende Unterstützung für Big-Data-Frameworks, was einigen Entwicklern Probleme bereitet hat. In diesem Artikel werden die Hauptgründe für das Fehlen eines Big-Data-Frameworks in der Go-Sprache untersucht, entsprechende Lösungen vorgeschlagen und anhand spezifischer Codebeispiele veranschaulicht. 1. Gehen Sie zur Sprache

KI, digitale Zwillinge, Visualisierung ... Höhepunkte der Yizhiwei-Herbst-Produkteinführungskonferenz 2023!

Nov 14, 2023 pm 05:29 PM

KI, digitale Zwillinge, Visualisierung ... Höhepunkte der Yizhiwei-Herbst-Produkteinführungskonferenz 2023!

Nov 14, 2023 pm 05:29 PM

Die Produkteinführung im Herbst 2023 von Yizhiwei ist erfolgreich abgeschlossen! Lassen Sie uns gemeinsam die Highlights der Konferenz Revue passieren lassen! 1. Intelligente, integrative Offenheit, die es digitalen Zwillingen ermöglicht, produktiv zu werden. Ning Haiyuan, Mitbegründer von Kangaroo Cloud und CEO von Yizhiwei, sagte in seiner Eröffnungsrede: Beim diesjährigen strategischen Treffen des Unternehmens haben wir die Hauptrichtung der Produktforschung und -entwicklung als festgelegt „Intelligente inklusive Offenheit“ „Drei Kernfähigkeiten“, wobei wir uns auf die drei Kernschlüsselwörter „intelligente inklusive Offenheit“ konzentrieren, schlagen wir außerdem das Entwicklungsziel vor, „digitale Zwillinge zu einer Produktivkraft zu machen“. 2. EasyTwin: Entdecken Sie eine neue Digital-Twin-Engine, die einfacher zu verwenden ist 1. Erkunden Sie von 0.1 bis 1.0 weiterhin die Digital-Twin-Fusion-Rendering-Engine, um bessere Lösungen mit ausgereiftem 3D-Bearbeitungsmodus, praktischen interaktiven Blaupausen und umfangreichen Modellressourcen zu erhalten

Erste Schritte: Verwendung der Go-Sprache zur Verarbeitung großer Datenmengen

Feb 25, 2024 pm 09:51 PM

Erste Schritte: Verwendung der Go-Sprache zur Verarbeitung großer Datenmengen

Feb 25, 2024 pm 09:51 PM

Als Open-Source-Programmiersprache hat die Go-Sprache in den letzten Jahren nach und nach große Aufmerksamkeit und Verwendung gefunden. Es wird von Programmierern wegen seiner Einfachheit, Effizienz und leistungsstarken Funktionen zur gleichzeitigen Verarbeitung bevorzugt. Auch im Bereich der Big-Data-Verarbeitung verfügt die Go-Sprache über großes Potenzial. Sie kann zur Verarbeitung großer Datenmengen, zur Leistungsoptimierung und zur guten Integration in verschiedene Big-Data-Verarbeitungstools und Frameworks eingesetzt werden. In diesem Artikel stellen wir einige grundlegende Konzepte und Techniken der Big-Data-Verarbeitung in der Go-Sprache vor und zeigen anhand spezifischer Codebeispiele, wie die Go-Sprache verwendet wird.

Big-Data-Verarbeitung in C++-Technologie: Wie nutzt man In-Memory-Datenbanken, um die Big-Data-Leistung zu optimieren?

May 31, 2024 pm 07:34 PM

Big-Data-Verarbeitung in C++-Technologie: Wie nutzt man In-Memory-Datenbanken, um die Big-Data-Leistung zu optimieren?

May 31, 2024 pm 07:34 PM

Bei der Verarbeitung großer Datenmengen kann die Verwendung einer In-Memory-Datenbank (z. B. Aerospike) die Leistung von C++-Anwendungen verbessern, da sie Daten im Computerspeicher speichert, wodurch Festplatten-E/A-Engpässe vermieden und die Datenzugriffsgeschwindigkeiten erheblich erhöht werden. Praxisbeispiele zeigen, dass die Abfragegeschwindigkeit bei Verwendung einer In-Memory-Datenbank um mehrere Größenordnungen schneller ist als bei Verwendung einer Festplattendatenbank.