Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die bevorstehende Veröffentlichung von GPT4 ist vergleichbar mit dem menschlichen Gehirn und viele Branchenführer können nicht still sitzen!

Die bevorstehende Veröffentlichung von GPT4 ist vergleichbar mit dem menschlichen Gehirn und viele Branchenführer können nicht still sitzen!

Die bevorstehende Veröffentlichung von GPT4 ist vergleichbar mit dem menschlichen Gehirn und viele Branchenführer können nicht still sitzen!

Autor |. Xu Jiecheng

Rezensent |. 100 Billionen, wie groß ist diese Zahl? Wenn Sie die Superkraft haben, jeden Tag 5 Millionen Lottoscheine zu gewinnen, müssen Sie, wenn Sie das ganze Geld sparen, ohne zu essen oder zu trinken, immer noch etwa 5.500 Jahre leben, um 100 Billionen an Vermögen zu sparen. Allerdings stehen die 100 Billionen, über die ich heute mit Ihnen sprechen möchte, nicht hinter den begehrten Einheiten wie „RMB“ und „Dollor“. Die 100 Billionen hier beziehen sich auf die Anzahl der Parameter im Besitz von OpenAI, einem Forschungsunternehmen für künstliche Intelligenz, das von vielen Technologiemagnaten aus dem Silicon Valley mitgegründet wurde und im Begriff ist, die vierte Generation des generativen Pre-Training Transformer-GPT-4 herauszubringen.

Um es allen zu erleichtern, diese Daten intuitiver zu verstehen, können wir das menschliche Gehirn für den Vergleich mit GPT-4 verwenden. Unter normalen Umständen verfügt ein normales menschliches Gehirn über etwa 80–100 Milliarden Neuronen und etwa 100 Billionen Synapsen. Diese Neuronen und Synapsen steuern direkt fast alle Gedanken, Urteile und Verhaltensweisen eines Menschen in hundert Lebensjahren, und GPT-4 verfügt über so viele Parameter wie Synapsen im menschlichen Gehirn. Was ist also das Potenzial eines so großen dichten neuronalen Netzwerks? Welche Überraschungen wird uns die Entstehung von GPT-4 bringen? Haben wir wirklich die Fähigkeit, ein menschliches Gehirn zu erschaffen?

Bevor wir uns mit diesen spannenden Themen befassen, sollten wir zunächst die Entwicklungsgeschichte mehrerer „Vorgänger“ von GPT-4 verstehen.

1. GPT: Es ist einfach ein Blockbuster

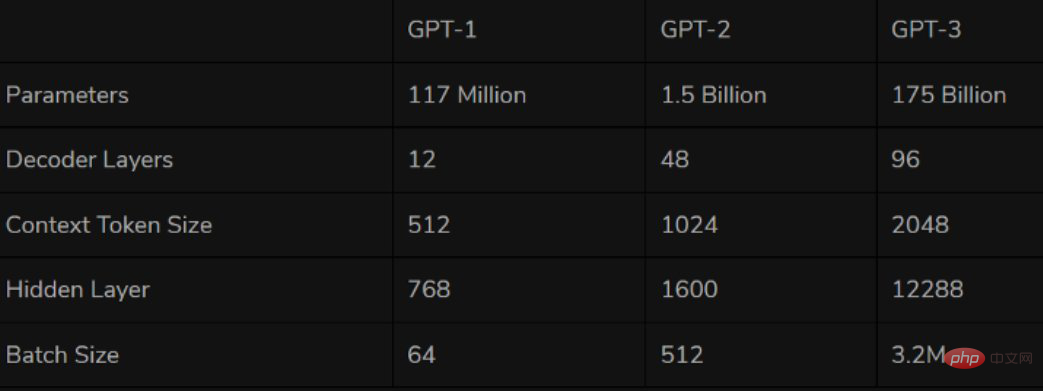

Das erste GPT-Serienmodell GPT-1 wurde 2018 geboren, dem ersten Jahr dessen, was wir oft als NLP-Vorschulungsmodell bezeichnen. Als erstes auf Transformer basierendes Vortrainingsmodell verwendet GPT-1 zwei Phasen des Vortrainings + FineTuning, wobei der Decoder von Transformer als Feature-Extraktor verwendet wird. Es stapelt insgesamt 12 Ebenen und verfügt über 110 Millionen Parameter „Einzelnes „Sprachmodell“ als Trainingsaufgabe.

Leistungsmäßig verfügt GPT-1 über eine gewisse Generalisierungsfähigkeit und kann bei NLP-Aufgaben eingesetzt werden, die nichts mit Supervisionsaufgaben zu tun haben. Zu den häufig verwendeten Aufgaben gehören:

Natürliches Denken: Bestimmen Sie die Beziehung zwischen zwei Sätzen (Eindämmung, Widerspruch, Neutralität).- Frage und Antwort und vernünftiges Denken: Geben Sie einen Artikel und mehrere Antworten ein und geben Sie die Genauigkeit des Satzes aus Antwort

- Semantische Ähnlichkeitserkennung: Bestimmen Sie, ob die Semantik zweier Sätze zusammenhängt

- Klassifizierung: Bestimmen Sie, zu welcher Kategorie der Eingabetext gehört

Obwohl GPT-1 einige Auswirkungen auf nicht debuggte Aufgaben hat, ist seine Generalisierungsfähigkeit weitaus geringer Die Feinabstimmung ist eine überwachte Aufgabe, daher kann GPT-1 nur als einigermaßen gutes Sprachverständnis-Tool und nicht als Konversations-KI angesehen werden.

Ein Jahr nach der Einführung von GPT-1 kam 2019 planmäßig auch GPT-2 auf den Markt. Im Vergleich zu seinem großen Bruder GPT-1 hat GPT-2 nicht allzu viele strukturelle Neuerungen und Designs am ursprünglichen Netzwerk vorgenommen. Es wurden lediglich mehr Netzwerkparameter und ein größerer Datensatz verwendet: Das größte Modell verfügt über insgesamt 48 Schichten Parameter Der Betrag erreicht 1,5 Milliarden, und das Lernziel verwendet ein unbeaufsichtigtes Vortrainingsmodell, um überwachte Aufgaben auszuführen.

Quelle: Twitter

Quelle: Twitter

Was die Leistung angeht, scheinen die Bemühungen von OpenAI wirklich einige Wunder gebracht zu haben. Zusätzlich zu seiner Verständnisfähigkeit hat GPT-2 zum ersten Mal in seiner Generation ein starkes Talent gezeigt: Zusammenfassungen lesen, chatten, weiterschreiben, Geschichten erfinden und sogar Fake News generieren, Phishing-E-Mails senden oder sich online als andere ausgeben, sind alles ein Kinderspiel. Nachdem GPT-2 „größer geworden“ war, demonstrierte es eine Reihe universeller und leistungsstarker Fähigkeiten und erzielte die damals beste Leistung bei mehreren spezifischen Sprachmodellierungsaufgaben. Kein Wunder, dass OpenAI damals sagte: „GPT-2 sei zu gefährlich für die Veröffentlichung.“

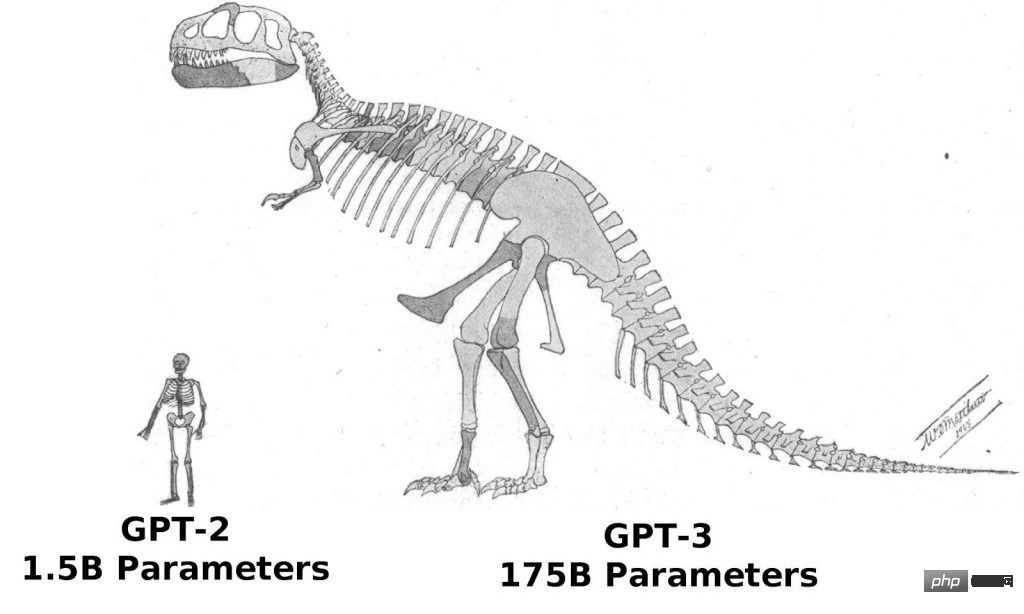

Seit dem Erfolg von GPT-2 ist der Glaube von OpenAI an den „Herkules“ immer fester geworden. GPT-3 folgt weiterhin der Entwicklungsidee der Mikroinnovation und der schnellen Expansion. Abgesehen davon, dass der Transformer in GPT-3 die Sparse-Struktur anwendet, gibt es fast keinen Unterschied in der Struktur von GPT-3 und GPT-2. In Bezug auf die „Kraft“ hat das GPT-3-Modell 96 Schichten erreicht und die Trainingsparameter haben 175 Milliarden erreicht (mehr als das Zehnfache von GPT-2).

Und GPT-3 hat erneut die Vision von OpenAI bewiesen. Aufgrund der stärkeren Leistung und deutlich mehr Parameter enthält GPT-3 mehr Thementexte, was offensichtlich besser ist als die vorherige Generation von GPT-2. Als derzeit größtes dichtes neuronales Netzwerk kann GPT-3 Webseitenbeschreibungen in entsprechende Codes umwandeln, menschliche Erzählungen nachahmen, benutzerdefinierte Gedichte erstellen, Spielskripte generieren und sogar verstorbene Philosophen nachahmen und so den wahren Sinn des Lebens vorhersagen. Und GPT-3 erfordert keine Feinabstimmung, sondern erfordert nur wenige Beispiele des Ausgabetyps (ein wenig Lernaufwand), um schwierige Grammatikprobleme zu lösen. Man kann sagen, dass GPT-3 offenbar alle unsere Vorstellungen von Sprachexperten erfüllt hat.

2. Den Turing-Test vollständig bestanden, um die Schwelle für Lernen und kommerzielle Nutzung zu senken.

Dieselbe Frage: „GPT-3 ist bereits sehr leistungsfähig. Worauf können wir uns bei GPT-4 sonst noch freuen?“

Wie wir alle wissen, ist der Turing-Test die wichtigste Methode zum Testen der Intelligenz eines KI-Systems. Wir sind immer noch nicht in der Lage, das Konzept mit wissenschaftlich quantifizierbaren Standards zu testen Wenn der Turing-Test definiert ist, ist er derzeit eine der wenigen praktikablen Testmethoden, mit denen festgestellt werden kann, ob die andere Partei über menschliche Intelligenz verfügt. Um ein Sprichwort zu verwenden: Wenn etwas aussieht wie eine Ente, geht wie eine Ente und quakt wie eine Ente, dann ist es eine Ente. Wenn das KI-System den Turing-Test erfolgreich bestehen kann, bedeutet dies, dass das System über menschliches Denken verfügt und den Menschen in einigen Aspekten ersetzen kann. Koreanischen IT-Medienberichten zufolge berichtet die Branche seit Mitte November, dass GPT-4 den Turing-Test vollständig bestanden hat. Der Geschäftsführer des südkoreanischen Vodier AI-Unternehmens, Nam Se-dong, sagte kürzlich in einem Interview mit der südkoreanischen Zeitung „Economic News“: „Obwohl die Nachricht, dass GPT-4 den Turing-Test bestanden hat, nicht offiziell bestätigt wurde, sollte die Nachricht durchaus glaubwürdig sein.“ 🎜🎜##🎜 🎜#

Auch Sam Altman, ein Techniker und aktueller CEO von OpenAI, schien diese Information auf seinem Twitter zu bestätigen. Altman twitterte am 10. November und ahmte dabei einen klassischen Satz der „Star Wars“-Figur Darth Vader nach: „Seien Sie nicht stolz auf diese technologische Panik, die Sie geschaffen haben. Die Fähigkeit, den Turing-Test zu bestehen, ist im Original nicht vorhanden.“ was man angesichts der Gewalt tun kann.

Fotoquelle: Twitter

Fotoquelle: Twitter

一An Der Geschäftsführer eines KI-Start-up-Unternehmens analysierte: „Wenn GPT-4 den Turing-Test wirklich perfekt besteht, werden seine Auswirkungen ausreichen, um eine ‚technologische Panik‘ in der KI-Welt auszulösen, also wird Altman die Figur von Darth Vader verwenden.“ diese Informationen zu veröffentlichen.“

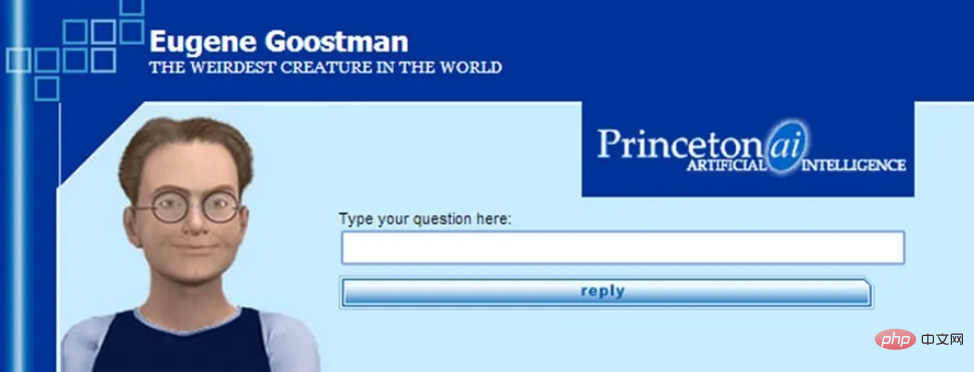

Wenn GPT-4 den Turing-Test ohne Einschränkungen besteht, wird es tatsächlich Geschichte schreiben. Obwohl einige KI-Modelle zuvor behauptet haben, den Turing-Test zu bestehen, wurden sie von der KI-Branche nie einstimmig anerkannt. Dies liegt daran, dass die Standards und Regeln des Turing-Tests nicht klar sind und viele Modelle einige „blinde Flecken“ im Test geschickt ausnutzen. Ein typisches Beispiel ist das 2014 von der University of Reading in Großbritannien ins Leben gerufene KI-Modell „Eugene“. Damals behauptete die University of Reading gegenüber den Richtern, dass es sich bei dem Modell um einen 13-jährigen ukrainischen Jungen handele Als der Algorithmus keine gute Antwort geben konnte, ging die Jury damals davon aus, dass dies daran lag, dass es sich bei der Testperson um ein ausländisches Kind handelte.

Quelle: Internet

Quelle: Internet

Obwohl das Bild Der Turing-Test ist kein absoluter Bezugspunkt für die KI-Technologie, aber als ältester und bekanntester KI-Technologietest bisher hat der Turing-Test immer noch große symbolische Bedeutung. Wenn GPT-4 den Turing-Test wirklich offiziell und definitiv besteht, dann wird es höchstwahrscheinlich den bisher größten Meilenstein in der KI-Branche schaffen.

Darüber hinaus wird GPT-4 im Gegensatz zu GPT-3 höchstwahrscheinlich mehr als nur ein Sprachmodell sein. OpenAI-Chefwissenschaftler Ilya Sutskever hat dies einmal in seinem multimodalen Artikel angedeutet: „Text selbst kann viele Informationen über die Welt ausdrücken, aber er ist schließlich unvollständig, weil wir auch in einer visuellen Welt leben.“ Daher einige Branchenexperten gehen davon aus, dass GPT-4 multimodal sein wird und Audio-, Text-, Bild- und sogar Videoeingaben akzeptieren kann, und gehen davon aus, dass der Whisper-Audiodatensatz von OpenAI zur Erstellung von GPT-4-Textdaten verwendet wird. Dies bedeutet auch, dass GPT-4 keine Einschränkungen mehr beim Empfang und der Verarbeitung externer Informationen haben wird.

Der Grund, warum die Branche GPT-4 Aufmerksamkeit schenkt, liegt höchstwahrscheinlich darin, dass die tatsächliche kommerzielle Schwelle von GPT-4 niedriger sein wird als die von herkömmlichem GPT-3. Von Unternehmen, die bislang aus Kosten- und Infrastrukturgründen nicht in der Lage waren, verwandte Technologien zu nutzen, wird erwartet, dass sie auch GPT-4 nutzen. GPT-4 befindet sich derzeit in der letzten Phase der Listung und wird zwischen Dezember dieses Jahres und Februar nächsten Jahres veröffentlicht. Alberto Garcia, Analyst bei Cambridge AI Research, veröffentlichte einen Blog und prognostizierte: „GPT-4 wird sich mehr auf die Optimierung der Datenverarbeitung konzentrieren, sodass die Lernkosten von GPT-4 voraussichtlich niedriger sein werden als die von GPT-3.“ Das Lernen Die Kosten pro Folge von GPT-4 werden wahrscheinlich von Millionen Dollar für GPT-3 auf etwa 1 Million Dollar gesenkt.

3. Verschiedene Wege führen zum gleichen Ziel: Die Simulation des menschlichen Gehirns kann schneller gehen

Wenn die oben genannten Informationen alle wahr sind, dann Derzeit können wir davon ausgehen, dass mit der Veröffentlichung von -4 der Bereich der Deep-Learning-Forschung im nächsten Jahr eine große Anzahl fortgeschrittenerer, natürlicherer und nahezu unmöglich zu unterscheidender Authentizität einläuten wird Chat-Service-Roboter können auf dieser Grundlage auch in verschiedenen Branchen auftauchen. Es werden auch mehr hochwertige personalisierte KI-Dienste entstehen, und wir werden höchstwahrscheinlich erstmals eine barrierefreie Kommunikation erreichen.

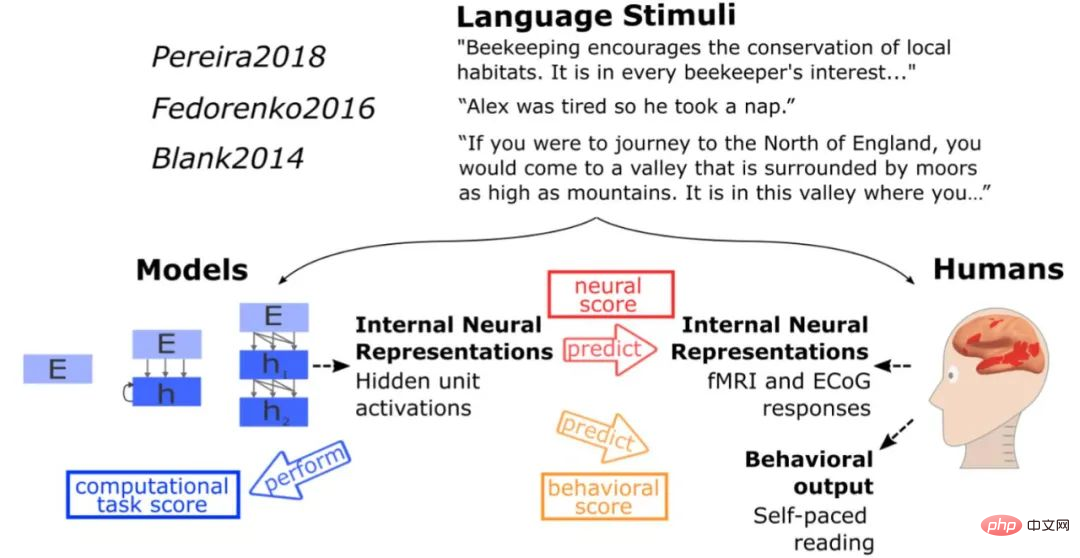

Kehren wir zum eingangs erwähnten Thema der Schaffung oder Simulation menschlicher Gehirne zurück. Obwohl das neuronale Netzwerk in GPT-3 nicht versucht, das menschliche Gehirn direkt zu imitieren, weist die von GPT-3 vorgestellte Sprachverarbeitungsmethode laut einer Studie des MIT gewisse Ähnlichkeiten mit den Lösungen auf, die während der Evolution des menschlichen Gehirns erzielt wurden. Wenn derselbe Reiz wie das menschliche Testgehirn in das Modell eingegeben wurde, erhielt das Modell die gleiche Art von Aktivierung wie das menschliche Gehirn, und in mehr als 40 Sprachmodelltests zog GPT-3 nahezu perfekte Schlussfolgerungen Die Funktion ähnelt tatsächlich der des Sprachverarbeitungszentrums des menschlichen Gehirns. In diesem Zusammenhang sagte auch Daniel Yamins, Assistenzprofessor für Psychologie und Informatik an der Stanford University: „Das Netzwerk der künstlichen Intelligenz imitiert das Gehirn nicht direkt, aber am Ende sieht es aus wie das Gehirn. Das zeigt in gewisser Weise, dass es so ist.“ Es scheint eine Kluft zwischen künstlicher Intelligenz und der Natur zu geben.“

Fotoquelle: Internet

davon Es ist ersichtlich, dass die Modelle der GPT-Serie zwar nicht direkt die Designideen der Simulation von Gehirnstrukturen im Blue Brain Project übernehmen, die präsentierten Ergebnisse jedoch unseren Erwartungen näher zu sein scheinen als die des Blue Brain Project. Wenn diese Forschungsrichtung also wirklich machbar ist und GPT-4 in einigen Aspekten auf der Grundlage von GPT-3 einen Durchbruch erzielen kann, werden wir dem Ziel, einige Funktionen des menschlichen Gehirns zu simulieren, einen Schritt näher kommen.

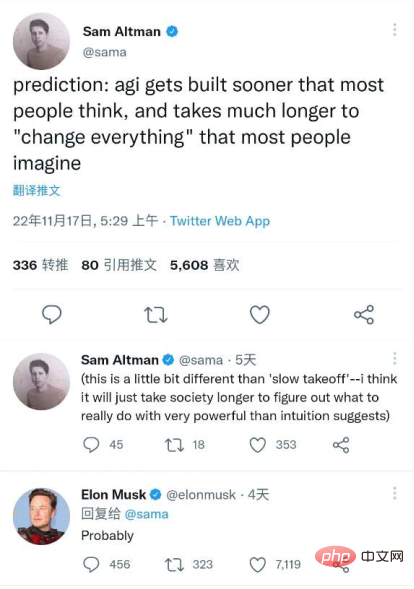

Abschließend möchte ich mit einem Zitat aus dem jüngsten Beitrag von OpenAI-CEO Sam Altman auf Twitter schließen, der auch von „Silicon Valley Iron Man“ Elon Musk gelobt wurde. Anerkennung – „Allgemeine künstliche Intelligenz wird sich schneller etablieren, als sich die meisten Menschen vorstellen, und sie wird über einen langen Zeitraum alles ‚verändern‘, was sich die meisten Menschen vorstellen.“

Fotoquelle: Twitter

Referenzlink :

https://dzone.com/articles/what-can-you-do-with-the-openai-gpt-3-lingual-mod

https : //analyticsindiamag.com/gpt-4-is-almost-here-and-it-looks-better-than-anything-else/

https://analyticsindiamag.com/openais-whisper - might-hold-the-key-to-gpt4/

Das obige ist der detaillierte Inhalt vonDie bevorstehende Veröffentlichung von GPT4 ist vergleichbar mit dem menschlichen Gehirn und viele Branchenführer können nicht still sitzen!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1383

1383

52

52

Neue Funktion in PHP Version 5.4: So verwenden Sie aufrufbare Typhinweisparameter, um aufrufbare Funktionen oder Methoden zu akzeptieren

Jul 29, 2023 pm 09:19 PM

Neue Funktion in PHP Version 5.4: So verwenden Sie aufrufbare Typhinweisparameter, um aufrufbare Funktionen oder Methoden zu akzeptieren

Jul 29, 2023 pm 09:19 PM

Neue Funktion der PHP5.4-Version: So verwenden Sie aufrufbare Typhinweisparameter, um aufrufbare Funktionen oder Methoden zu akzeptieren. Einführung: Die PHP5.4-Version führt eine sehr praktische neue Funktion ein: Sie können aufrufbare Typhinweisparameter verwenden, um aufrufbare Funktionen oder Methoden zu akzeptieren. Mit dieser neuen Funktion können Funktionen und Methoden entsprechende aufrufbare Argumente ohne zusätzliche Prüfungen und Konvertierungen direkt angeben. In diesem Artikel stellen wir die Verwendung von aufrufbaren Typhinweisen vor und stellen einige Codebeispiele bereit.

Was bedeuten Produktparameter?

Jul 05, 2023 am 11:13 AM

Was bedeuten Produktparameter?

Jul 05, 2023 am 11:13 AM

Produktparameter beziehen sich auf die Bedeutung von Produktattributen. Zu den Bekleidungsparametern gehören beispielsweise Marke, Material, Modell, Größe, Stil, Stoff, anwendbare Gruppe, Farbe usw.; zu den Lebensmittelparametern gehören Marke, Gewicht, Material, Gesundheitslizenznummer, anwendbare Gruppe, Farbe usw.; Dazu gehören Marke, Größe, Farbe, Herkunftsort, anwendbare Spannung, Signal, Schnittstelle und Leistung usw.

PHP-Warnung: Lösung für in_array() erwartet Parameter

Jun 22, 2023 pm 11:52 PM

PHP-Warnung: Lösung für in_array() erwartet Parameter

Jun 22, 2023 pm 11:52 PM

Während des Entwicklungsprozesses kann es vorkommen, dass wir auf die folgende Fehlermeldung stoßen: PHPWarning: in_array()expectsparameter. Diese Fehlermeldung wird bei Verwendung der Funktion in_array() angezeigt. Sie kann durch eine falsche Parameterübergabe der Funktion verursacht werden. Werfen wir einen Blick auf die Lösung dieser Fehlermeldung. Zunächst müssen Sie die Rolle der Funktion in_array() klären: Überprüfen Sie, ob ein Wert im Array vorhanden ist. Der Prototyp dieser Funktion ist: in_a

i9-12900H Parameterbewertungsliste

Feb 23, 2024 am 09:25 AM

i9-12900H Parameterbewertungsliste

Feb 23, 2024 am 09:25 AM

Der i9-12900H ist ein 14-Kern-Prozessor und die Threads sind ebenfalls sehr hoch. Einige Parameter wurden verbessert und können den Benutzern ein hervorragendes Erlebnis bieten . Überprüfung der Parameterbewertung des i9-12900H: 1. Der i9-12900H ist ein 14-Kern-Prozessor, der die q1-Architektur und die 24576-KB-Prozesstechnologie übernimmt und auf 20 Threads aktualisiert wurde. 2. Die maximale CPU-Frequenz beträgt 1,80! 5,00 GHz, was hauptsächlich von der Arbeitslast abhängt. 3. Im Vergleich zum Preis ist es sehr gut geeignet. Das Preis-Leistungs-Verhältnis ist sehr gut und für einige Partner, die eine normale Nutzung benötigen, sehr gut geeignet. i9-12900H Parameterbewertung und Leistungsbenchmarks

Sicherheitsüberprüfung des C++-Funktionsparametertyps

Apr 19, 2024 pm 12:00 PM

Sicherheitsüberprüfung des C++-Funktionsparametertyps

Apr 19, 2024 pm 12:00 PM

Die Sicherheitsüberprüfung von C++-Parametertypen stellt durch Überprüfungen zur Kompilierungszeit, Laufzeitüberprüfungen und statischen Behauptungen sicher, dass Funktionen nur Werte erwarteter Typen akzeptieren, wodurch unerwartetes Verhalten und Programmabstürze verhindert werden: Typüberprüfung zur Kompilierungszeit: Der Compiler überprüft die Typkompatibilität. Überprüfung des Laufzeittyps: Verwenden Sie Dynamic_cast, um die Typkompatibilität zu überprüfen und eine Ausnahme auszulösen, wenn keine Übereinstimmung vorliegt. Statische Behauptung: Typbedingungen zur Kompilierzeit geltend machen.

C++-Programm zum Ermitteln des Werts der Umkehrfunktion des hyperbolischen Sinus, wobei ein gegebener Wert als Argument verwendet wird

Sep 17, 2023 am 10:49 AM

C++-Programm zum Ermitteln des Werts der Umkehrfunktion des hyperbolischen Sinus, wobei ein gegebener Wert als Argument verwendet wird

Sep 17, 2023 am 10:49 AM

Hyperbelfunktionen werden mithilfe von Hyperbeln anstelle von Kreisen definiert und entsprechen gewöhnlichen trigonometrischen Funktionen. Es gibt den Verhältnisparameter in der hyperbolischen Sinusfunktion aus dem angegebenen Winkel im Bogenmaß zurück. Aber machen Sie das Gegenteil, oder anders gesagt. Wenn wir einen Winkel aus einem hyperbolischen Sinus berechnen wollen, benötigen wir eine umgekehrte hyperbolische trigonometrische Operation wie die hyperbolische Umkehrsinusoperation. In diesem Kurs wird gezeigt, wie Sie die hyperbolische Umkehrsinusfunktion (asinh) in C++ verwenden, um Winkel mithilfe des hyperbolischen Sinuswerts im Bogenmaß zu berechnen. Die hyperbolische Arkussinusoperation folgt der folgenden Formel -$$\mathrm{sinh^{-1}x\:=\:In(x\:+\:\sqrt{x^2\:+\:1})}, Wo\:In\:ist\:natürlicher Logarithmus\:(log_e\:k)

Kann ein Sprachmodell mit 10 Milliarden Parametern nicht ausgeführt werden? Ein chinesischer Arzt vom MIT schlug die SmoothQuant-Quantifizierung vor, die den Speicherbedarf um die Hälfte reduzierte und die Geschwindigkeit um das 1,56-fache erhöhte!

Apr 13, 2023 am 09:31 AM

Kann ein Sprachmodell mit 10 Milliarden Parametern nicht ausgeführt werden? Ein chinesischer Arzt vom MIT schlug die SmoothQuant-Quantifizierung vor, die den Speicherbedarf um die Hälfte reduzierte und die Geschwindigkeit um das 1,56-fache erhöhte!

Apr 13, 2023 am 09:31 AM

Obwohl große Sprachmodelle (LLM) eine starke Leistung aufweisen, kann die Anzahl der Parameter leicht Hunderte oder Hunderte von Milliarden erreichen, und der Bedarf an Computerausrüstung und Speicher ist so groß, dass sich normale Unternehmen diese nicht leisten können. Bei der Quantisierung handelt es sich um eine gängige Komprimierungsoperation, die einen Teil der Modellleistung im Austausch für eine schnellere Inferenzgeschwindigkeit und einen geringeren Speicherbedarf opfert, indem die Genauigkeit der Modellgewichte (z. B. 32 Bit auf 8 Bit) verringert wird. Bei LLMs mit mehr als 100 Milliarden Parametern können die vorhandenen Komprimierungsmethoden jedoch weder die Genauigkeit des Modells aufrechterhalten, noch können sie effizient auf der Hardware ausgeführt werden. Kürzlich haben Forscher vom MIT und NVIDIA gemeinsam eine universelle Post-Training-Quantisierung (GPQ) vorgeschlagen.

Erweiterte Verwendung von Referenzparametern und Zeigerparametern in C++-Funktionen

Apr 21, 2024 am 09:39 AM

Erweiterte Verwendung von Referenzparametern und Zeigerparametern in C++-Funktionen

Apr 21, 2024 am 09:39 AM

Referenzparameter in C++-Funktionen (im Wesentlichen Variablenaliase; durch Ändern der Referenz wird die Originalvariable geändert) und Zeigerparameter (Speichern der Speicheradresse der Originalvariablen, Ändern der Variablen durch Dereferenzierung des Zeigers) werden beim Übergeben und Ändern von Variablen unterschiedlich verwendet. Referenzparameter werden oft verwendet, um Originalvariablen (insbesondere große Strukturen) zu ändern, um Kopieraufwand bei der Übergabe an Konstruktoren oder Zuweisungsoperatoren zu vermeiden. Zeigerparameter werden verwendet, um flexibel auf Speicherorte zu zeigen, dynamische Datenstrukturen zu implementieren oder Nullzeiger zur Darstellung optionaler Parameter zu übergeben.