Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Google und MIT schlagen ein einheitliches Framework MAGE vor: Repräsentationslernen übertrifft MAE und unbeaufsichtigte Bilderzeugung übertrifft Latent Diffusion

Google und MIT schlagen ein einheitliches Framework MAGE vor: Repräsentationslernen übertrifft MAE und unbeaufsichtigte Bilderzeugung übertrifft Latent Diffusion

Google und MIT schlagen ein einheitliches Framework MAGE vor: Repräsentationslernen übertrifft MAE und unbeaufsichtigte Bilderzeugung übertrifft Latent Diffusion

Erkennung und Generierung sind die beiden Kernaufgaben im Bereich der künstlichen Intelligenz. Wenn sie zu einem einheitlichen System zusammengeführt werden können, sollten sich diese beiden Aufgaben ergänzen. Tatsächlich sind Modelle wie BERT [1] bei der Verarbeitung natürlicher Sprache nicht nur in der Lage, qualitativ hochwertigen Text zu generieren, sondern auch Merkmale aus dem Text zu extrahieren.

Im Bereich Computer Vision werden jedoch die meisten aktuellen Bilderzeugungsmodelle und Erkennungsmodelle separat trainiert, ohne die Synergie dieser beiden Aufgaben vollständig zu nutzen. Dies ist vor allem darauf zurückzuführen, dass die Modelle der Bilderzeugung und Bilderkennung in der Regel wesentliche strukturelle Unterschiede aufweisen: Die Eingabe der Bilderzeugung besteht aus niedrigdimensionalen Merkmalen oder Rauschen, und die Ausgabe ist im Gegensatz dazu ein hochdimensionales Originalbild Die Eingabe der Bilderkennung ist ein hochdimensionales Originalbild, während die Ausgabe niedrigdimensionale Merkmale ist.

Kürzlich haben Forscher vom MIT und Google Research eine Methode zum Repräsentationslernen vorgeschlagen, die auf der semantischen Bildmaskierung basiert und zum ersten Mal die Bildgenerierung und das Repräsentationslernen in einem einheitlichen Framework ermöglicht und bei mehreren Datensätzen eine gute SOTA-Leistung erzielt. Das Forschungspapier wurde vom CVPR 2023 angenommen und der relevante Code und das vorab trainierte Modell waren Open Source.

- Papieradresse: https://arxiv.org/abs/2211.09117

- Codeadresse: https://github.com/LTH14/mage

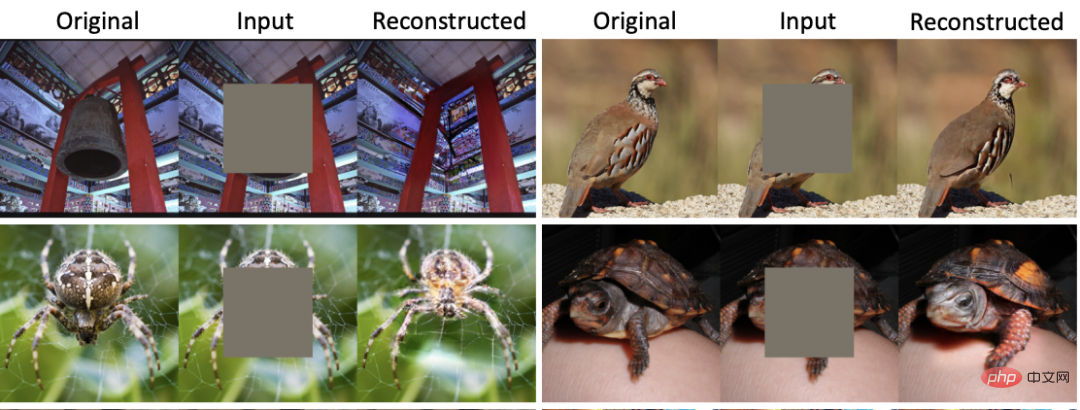

Auf der CVPR 2022 schlug MAE [2] eine auf Bildmasken (MIM) basierende Repräsentationslernmethode vor und erzielte bei mehreren Teilaufgaben sehr gute Ergebnisse. Mit einer Maskierungsrate von bis zu 75 % kann MAE ein Bild rekonstruieren, das der Semantik des Originalbilds weitgehend entspricht, wodurch das Netzwerk selbstüberwacht Merkmale im Bild lernen kann. Wie in Abbildung 1 dargestellt, treten jedoch schwerwiegende Unschärfe- und Verzerrungsprobleme auf, obwohl das von MAE rekonstruierte Bild ähnliche semantische Informationen wie das Originalbild aufweist. Ähnliche Probleme treten bei allen MIM-basierten Repräsentationslernmethoden auf. Gleichzeitig mangelt es aktuellen generativen Modellen, ob Diffusionsmodelle oder GANs, an der Fähigkeit, qualitativ hochwertige Bildmerkmale zu extrahieren. Abbildung 1: Vergleich der MAE- und MAGE-Rekonstruktion , wodurch ein einheitliches Bilderzeugungs- und Merkmalsextraktionsmodell erreicht wurde. Im Gegensatz zur Maskierungsmethode, bei der MIM direkt auf das Bild einwirkt, schlägt MAGE eine Modellierungsmethode für maskierte Bildtoken vor, die auf bildsemantischen Symbolen basiert. Wie in der Abbildung gezeigt, verwendet MAGE zunächst den VQGAN [3]-Encoder, um das Originalbild in diskrete semantische Symbole umzuwandeln. Danach maskiert MAGE es nach dem Zufallsprinzip und verwendet die transformatorbasierte Encoder-Decoder-Struktur, um die Maske zu rekonstruieren. Die rekonstruierten semantischen Symbole können verwendet werden, um das Originalbild über den VQGAN-Decoder zu generieren. Durch die Verwendung unterschiedlicher Maskierungsraten im Training kann MAGE sowohl generative Modelle (nahezu 100 % Maskierungsrate) als auch Repräsentationslernen (50 %–80 % Maskierungsrate) trainieren. Wie in Abbildung 1 dargestellt, verfügt das von MAGE rekonstruierte Bild nicht nur über semantische Informationen, die mit dem Originalbild übereinstimmen, sondern kann auch die Vielfalt und Authentizität des generierten Bildes sicherstellen. Abbildung 2: MAGE-Strukturdiagramm

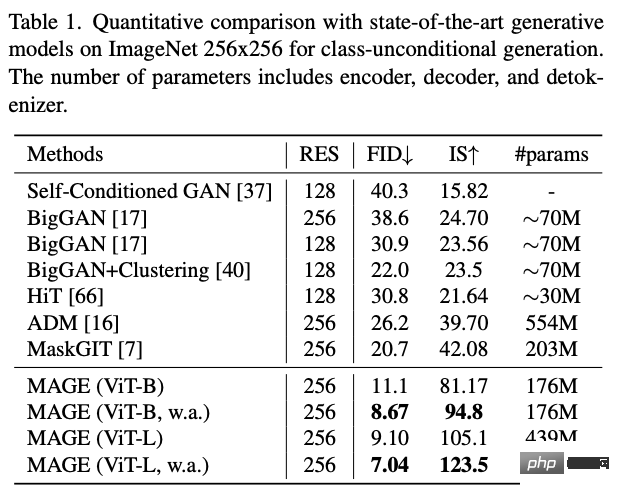

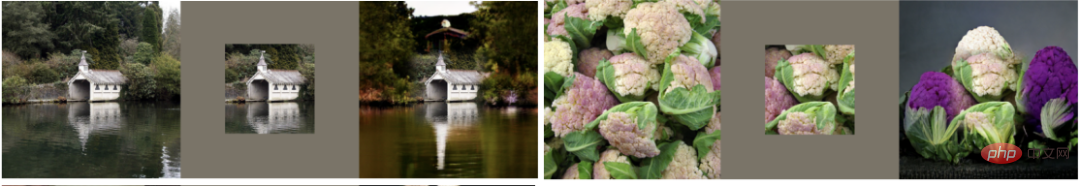

In der unbeaufsichtigten Bildgenerierungsaufgabe von ImageNet sank der FID von MAGE von zuvor > 20 auf 7,04 und erreichte sogar das Niveau der überwachten Bildgenerierung (der FID der überwachten latenten Diffusion auf ImageNet beträgt 3,60). :

#🎜. 🎜 ## 🎜🎜#

#🎜. 🎜 ## 🎜🎜#

Abbildung 3: Beispiel für die unbeaufsichtigte MAGE-Bildgenerierung #MAGE kann auch verschiedene Bildbearbeitungsaufgaben ausführen, einschließlich Bild-Inpainting, Outpainting und Uncropping:

#🎜🎜 #

# 🎜 🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#Abbildung 4: Mage Bildbearbeitungsbeispiel

#🎜🎜 #

In Bezug auf das Repräsentationslernen hat sich MAGE im Vergleich zur aktuellen MIM-Methode bei Aufgaben wie der linearen ImageNet-Prüfung erheblich verbessert , Wenig-Schuss-Lernen und Transferlernen und kann das aktuelle optimale selbstüberwachte Lernniveau erreichen oder übertreffen.

Dieser Artikel soll es sagen das Bild Generierung und Repräsentationslernen vereinen. Zu diesem Zweck schlägt der Autor dieses Artikels MAGE vor, ein selbstüberwachtes Lernframework, das auf bildsemantischer Maskierung basiert. Dieses Framework ist einfach und effizient und erreicht oder übertrifft erstmals die SOTA-Leistung sowohl bei der Bilderzeugung als auch beim Repräsentationslernen. Interessierte Leser können den Originaltext des Artikels einsehen, um weitere Forschungsdetails zu erfahren.

Dieser Artikel soll es sagen das Bild Generierung und Repräsentationslernen vereinen. Zu diesem Zweck schlägt der Autor dieses Artikels MAGE vor, ein selbstüberwachtes Lernframework, das auf bildsemantischer Maskierung basiert. Dieses Framework ist einfach und effizient und erreicht oder übertrifft erstmals die SOTA-Leistung sowohl bei der Bilderzeugung als auch beim Repräsentationslernen. Interessierte Leser können den Originaltext des Artikels einsehen, um weitere Forschungsdetails zu erfahren.

Das obige ist der detaillierte Inhalt vonGoogle und MIT schlagen ein einheitliches Framework MAGE vor: Repräsentationslernen übertrifft MAE und unbeaufsichtigte Bilderzeugung übertrifft Latent Diffusion. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Wie man Deepseek kommentiert

Feb 19, 2025 pm 05:42 PM

Wie man Deepseek kommentiert

Feb 19, 2025 pm 05:42 PM

Deepseek ist ein leistungsstarkes Informations -Abruf -Tool. .

So suchen Sie Deepseek

Feb 19, 2025 pm 05:39 PM

So suchen Sie Deepseek

Feb 19, 2025 pm 05:39 PM

Deepseek ist eine proprietäre Suchmaschine, die nur schneller und genauer in einer bestimmten Datenbank oder einem bestimmten System sucht. Bei der Verwendung wird den Benutzern empfohlen, das Dokument zu lesen, verschiedene Suchstrategien auszuprobieren, Hilfe und Feedback zur Benutzererfahrung zu suchen, um die Vorteile optimal zu nutzen.

Sesame Open Door Exchange -Webseite Registrierung Link Gate Trading App Registrierung Website Neueste

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange -Webseite Registrierung Link Gate Trading App Registrierung Website Neueste

Feb 28, 2025 am 11:06 AM

In diesem Artikel wird der Registrierungsprozess der Webversion Sesam Open Exchange (GATE.IO) und die Gate Trading App im Detail vorgestellt. Unabhängig davon, ob es sich um eine Webregistrierung oder eine App -Registrierung handelt, müssen Sie die offizielle Website oder den offiziellen App Store besuchen, um die Genuine App herunterzuladen, und dann den Benutzernamen, das Kennwort, die E -Mail, die Mobiltelefonnummer und die anderen Informationen eingeben und eine E -Mail- oder Mobiltelefonüberprüfung abschließen.

Warum kann der Bybit -Exchange -Link nicht direkt heruntergeladen und installiert werden?

Feb 21, 2025 pm 10:57 PM

Warum kann der Bybit -Exchange -Link nicht direkt heruntergeladen und installiert werden?

Feb 21, 2025 pm 10:57 PM

Warum kann der Bybit -Exchange -Link nicht direkt heruntergeladen und installiert werden? Bitbit ist eine Kryptowährungsbörse, die den Benutzern Handelsdienste anbietet. Die mobilen Apps der Exchange können aus den folgenden Gründen nicht direkt über AppStore oder Googleplay heruntergeladen werden: 1. App Store -Richtlinie beschränkt Apple und Google daran, strenge Anforderungen an die im App Store zulässigen Anwendungsarten zu haben. Kryptowährungsanträge erfüllen diese Anforderungen häufig nicht, da sie Finanzdienstleistungen einbeziehen und spezifische Vorschriften und Sicherheitsstandards erfordern. 2. Die Einhaltung von Gesetzen und Vorschriften In vielen Ländern werden Aktivitäten im Zusammenhang mit Kryptowährungstransaktionen reguliert oder eingeschränkt. Um diese Vorschriften einzuhalten, kann die Bitbit -Anwendung nur über offizielle Websites oder andere autorisierte Kanäle verwendet werden

Sesame Open Door Trading Platform Download Mobile Version Gateio Trading Platform Download -Adresse

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Mobile Version Gateio Trading Platform Download -Adresse

Feb 28, 2025 am 10:51 AM

Es ist wichtig, einen formalen Kanal auszuwählen, um die App herunterzuladen und die Sicherheit Ihres Kontos zu gewährleisten.

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Mar 18, 2025 pm 12:15 PM

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Mar 18, 2025 pm 12:15 PM

Dieser Artikel empfiehlt die Top Ten Ten Cryptocurrency -Handelsplattformen, die es wert sind, auf Binance, OKX, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, BYDFI und Xbit -dezentrale Börsen geachtet zu werden. Diese Plattformen haben ihre eigenen Vorteile in Bezug auf Transaktionswährungsmenge, Transaktionstyp, Sicherheit, Konformität und Besonderheiten. Die Auswahl einer geeigneten Plattform erfordert eine umfassende Überlegung, die auf eigener Handelserfahrung, Risikotoleranz und Investitionspräferenzen basiert. Ich hoffe, dieser Artikel hilft Ihnen dabei, den besten Anzug für sich selbst zu finden

Binance Binance Offizielle Website Neueste Version Anmeldeportal

Feb 21, 2025 pm 05:42 PM

Binance Binance Offizielle Website Neueste Version Anmeldeportal

Feb 21, 2025 pm 05:42 PM

Befolgen Sie diese einfachen Schritte, um auf die neueste Version des Binance -Website -Login -Portals zuzugreifen. Gehen Sie zur offiziellen Website und klicken Sie in der oberen rechten Ecke auf die Schaltfläche "Anmeldung". Wählen Sie Ihre vorhandene Anmeldemethode. Geben Sie Ihre registrierte Handynummer oder E -Mail und Kennwort ein und vervollständigen Sie die Authentifizierung (z. B. Mobilfifizierungscode oder Google Authenticator). Nach einer erfolgreichen Überprüfung können Sie auf das neueste Version des offiziellen Website -Login -Portals von Binance zugreifen.

Die neueste Download -Adresse des Bitgets im Jahr 2025: Schritte zum Erhalten der offiziellen App

Feb 25, 2025 pm 02:54 PM

Die neueste Download -Adresse des Bitgets im Jahr 2025: Schritte zum Erhalten der offiziellen App

Feb 25, 2025 pm 02:54 PM

Dieser Leitfaden enthält detaillierte Download- und Installationsschritte für die offizielle Bitget Exchange -App, die für Android- und iOS -Systeme geeignet ist. Der Leitfaden integriert Informationen aus mehreren maßgeblichen Quellen, einschließlich der offiziellen Website, dem App Store und Google Play, und betont Überlegungen während des Downloads und des Kontoverwaltung. Benutzer können die App aus offiziellen Kanälen herunterladen, einschließlich App Store, offizieller Website APK Download und offizieller Website -Sprung sowie vollständige Registrierung, Identitätsüberprüfung und Sicherheitseinstellungen. Darüber hinaus deckt der Handbuch häufig gestellte Fragen und Überlegungen ab, wie z.