In früheren Artikeln wurde bereits mehrfach erwähnt, dass wir eine Low-Code-Plattform hauptsächlich für ToB-Unternehmen entwickeln, um Unternehmen dabei zu helfen, ihre Informatisierungskonstruktion zu verbessern und zu ihrer digitalen Transformation beizutragen.

Das Ziel der digitalen Transformation ist es, Kosten zu senken und die Effizienz zu steigern. Sie spiegelt sich vor allem in der Fähigkeit wider, Prototypen schnell bereitzustellen und mit Kunden vor dem Verkauf zu kommunizieren, sowie in der effizienten Lieferung während des Implementierungsprozesses , und verschiedene nach dem Verkauf auftretende Probleme können sofort beantwortet werden.

ChatGPT erfreut sich in letzter Zeit weiterhin großer Beliebtheit und jeden Tag können neue Anwendungen entdeckt werden. Kann ChatGPT also mit unseren Low-Code-Produkten kombiniert werden? Oder welche Effizienzsteigerung kann diese große Sprachmodellidee für Low-Code bringen?

Tatsächlich haben einige Giganten dies bereits getan.

Salesforce kündigte die Einführung des neuen Produkts EinsteinGPT an, eines auf LLM-Technologie basierenden Produkts, das sich in die Hauptwebanwendung von Salesforce integriert und das OpenAI ChatGPT-Modell nutzt, um zu verfolgen, wie oft Vertriebsmitarbeiter potenzielle Kunden kontaktieren und automatisch Marketing-E-Mails schreiben, ohne dass E-Mails manuell geschrieben werden müssen .

Andererseits kündigte Microsoft auch die Erweiterung der ChatGPT-Technologie auf die Power Platform an. Power Platform ist ein Low-Code-Produkt von Microsoft, das in „Zwei Low-Code-Bücher, die ich kürzlich gelesen habe“ vorgestellt wird. Das bedeutet, dass Power Virtual Agents und AI Builder auf Power Platform mit ChatGPT-Codierungsfunktionen aktualisiert wurden, sodass Benutzer ihre eigenen Anwendungen mit wenig oder gar keiner Codierung entwickeln können.

Salesforce wendet es auf Geschäftsfunktionen an und Microsoft erweitert die Plattformfunktionen. Für uns geht es im Pre-Sales und bei der Implementierung darum, Anwendungen schnell zu erstellen, und im After-Sales müssen wir Probleme schnell lösen. Daher gibt es zwei Richtungen:

1 Verbesserung der Effizienz der Anwendungskonstruktion.

2. Bauen Sie ein intelligentes Frage- und Antwortsystem auf.

Die aktuellen Projektumsetzungsschritte sind wie folgt:

Nachdem Low-Code-Produkte die Funktionen von ChatGPT integrieren, wird das System wie folgt aussehen:

Zum Beispiel: Geben Sie in das Dialogfeld ein, um die Spaltenbreite des Projektnamens der aktuellen Liste auf 500 anzupassen. Zu diesem Zeitpunkt müssen Sie in der Lage sein, die Parameter zu identifizieren: Projektname und Breite 500, und das wissen Sie müssen die Schnittstelle aufrufen, um die Spaltenbreite anzupassen.

Nachdem die bestehende Low-Code-Plattform im Hintergrund verschiedene Konfigurationen abgeschlossen hat und auf „Speichern“ klickt, sammelt das Frontend alle Daten und übergibt sie an die Schnittstelle. Die Schnittstelle hat eine relativ grobe Granularität und speichert viele Inhalte auf einmal. Im obigen Beispiel wird jedoch eine Spalte angepasst. Das Festlegen der Spaltenbreite erfordert eine Schnittstelle, die eine sehr feine Körnung der Schnittstelle erfordert. Daher ist die Transformation der Schnittstellengranularität der erste Schritt, um Intelligenz zu erreichen.

Wie oben erwähnt, handelt es sich bei der Möglichkeit zur Integration von ChatGPT nicht um eine direkte Schnittstelle zu ChatGPT, sodass sie immer noch recht schwierig zu implementieren ist. Es gibt jedoch eine Zeitspanne, bis sich eine neue Technologie durchsetzt und auf dem ToB-Markt völlig populär wird. Solange die Richtung stimmt, ist auf jeden Fall Zeit für die Vorbereitung.

Aktuell gibt es mehrere Probleme im Projektumsetzungsprozess, weshalb ein intelligentes Fragesystem sehr wichtig ist:

Die aktuelle Methode besteht darin, Dokumente zu durchsuchen. Im Laufe der Jahre wurden viele Dokumente angesammelt, z. B.: Geschäftsszenarien, Betriebshandbücher, FAQ-Handbücher zur Implementierung usw., die jedoch auf der Suche nach Schlüsselwörtern basieren. Verwenden Sie die Schlüsselwortsuche. Es gibt mehrere Probleme:

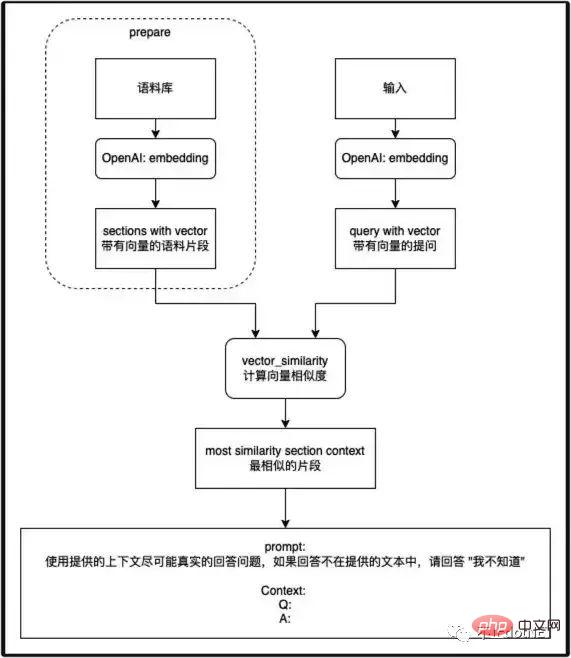

Folgt man den Ideen von ChatGPT, sieht die Logik des intelligenten Frage- und Antwortsystems so aus:

Zu dieser Frage habe ich Herrn Zhang Shanyou auf Knowledge Planet gestellt. Das Bild unten wurde von Zhang Shanyou zur Verfügung gestellt:

Baoyu beantwortete ähnliche Fragen auch auf Twitter:

https://twitter-thread .com /t/1641656561650249730.

Die von Zhang Shanyou und Baoyu bereitgestellten Parameter basieren jedoch alle auf der OpenAI-Schnittstelle. Gibt es eine Möglichkeit, dies zu erreichen, ohne sich auf OpenAI zu verlassen? Dies erfordert weitere Studien und Forschung.

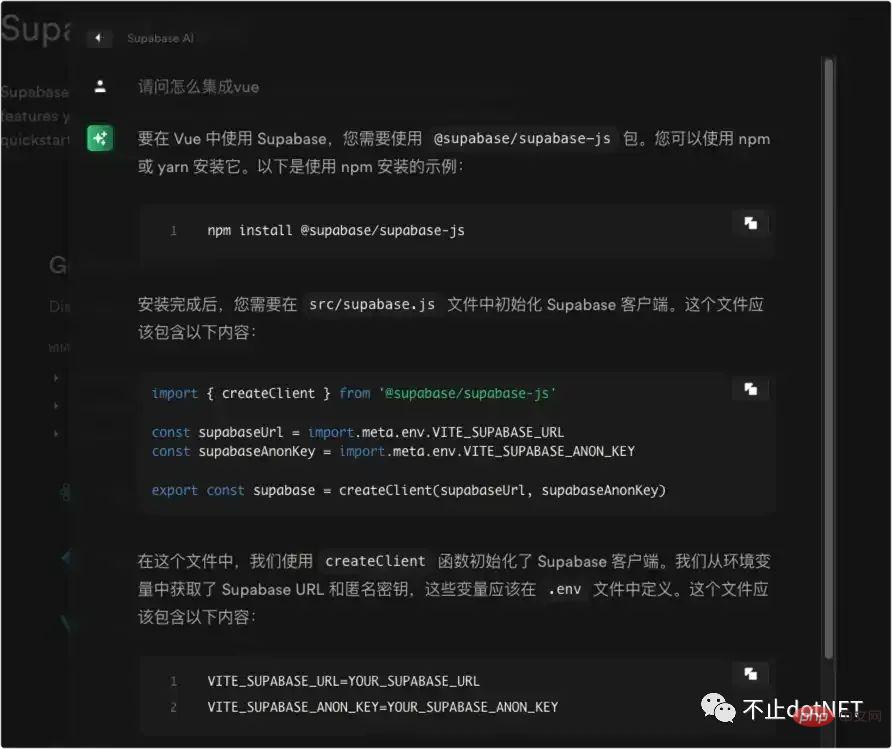

Ich habe kürzlich gesehen, dass die Supabase-Produktdokumentation KI-Fragen und Antworten bereitstellt (https://supabase.com/docs). Zusammenfassend möchte ich sagen, dass ich eine genaue Antwort auf der Grundlage natürlicher Spracheingaben geben möchte.

Die Zukunft ist da, sowohl Produkte als auch Einzelpersonen müssen weiter lernen und sich weiterentwickeln, um nicht ausgelöscht zu werden.

Das obige ist der detaillierte Inhalt vonGedanken zu Low-Code-Produkten von ChatGPT. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!