Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Warum ist Selbstüberwachung effektiv? Die 243-seitige Princeton-Doktorarbeit „Understanding Self-supervised Representation Learning' erläutert umfassend die drei Arten von Methoden: kontrastives Lernen, Sprachmodellierung und Selbstvorhersage.

Warum ist Selbstüberwachung effektiv? Die 243-seitige Princeton-Doktorarbeit „Understanding Self-supervised Representation Learning' erläutert umfassend die drei Arten von Methoden: kontrastives Lernen, Sprachmodellierung und Selbstvorhersage.

Warum ist Selbstüberwachung effektiv? Die 243-seitige Princeton-Doktorarbeit „Understanding Self-supervised Representation Learning' erläutert umfassend die drei Arten von Methoden: kontrastives Lernen, Sprachmodellierung und Selbstvorhersage.

Pre-Training hat sich als alternatives und wirksames Paradigma zur Überwindung dieser Mängel herausgestellt, bei dem Modelle zunächst mithilfe leicht verfügbarer Daten trainiert und dann zur Lösung nachgelagerter interessanter Aufgaben verwendet werden, und zwar mit viel weniger gekennzeichneten Daten als beim überwachten Lernen.

Die Verwendung unbeschrifteter Daten für das Pre-Training, also das selbstüberwachte Lernen, ist besonders revolutionär und hat sich in verschiedenen Bereichen als erfolgreich erwiesen: Text, Vision, Sprache usw.

Dies wirft eine interessante und herausfordernde Frage auf: Warum sollte ein Vortraining an unbeschrifteten Daten scheinbar nicht zusammenhängende nachgelagerte Aufgaben unterstützen? .edu/handle/88435/dsp01t435gh21h

Dieses Papier präsentiert einige Arbeiten, schlägt einen theoretischen Rahmen vor und etabliert ihn, um zu untersuchen, warum selbstüberwachtes Lernen für nachgelagerte Aufgaben von Vorteil ist.

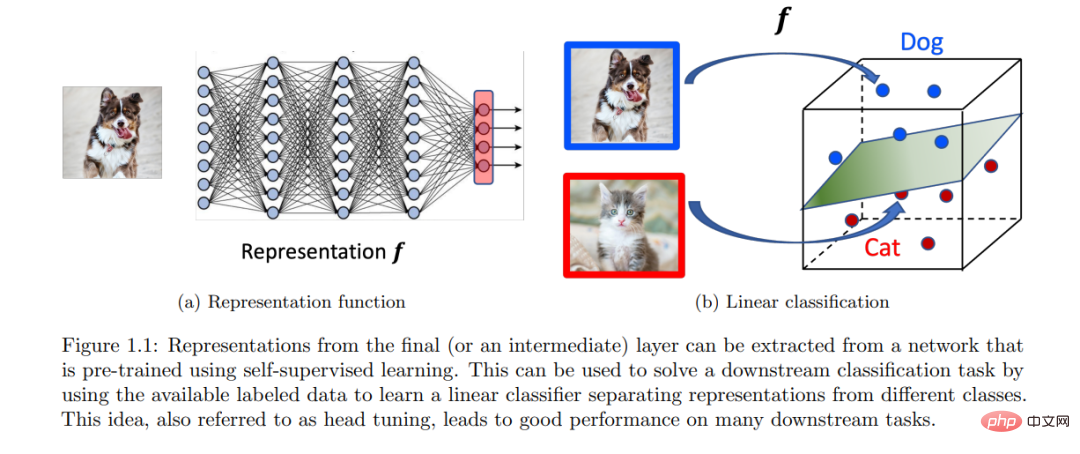

Dieses Framework eignet sich für kontrastives Lernen, autoregressive Sprachmodellierung und auf Selbstvorhersage basierende Methoden. Die Kernidee dieses Frameworks besteht darin, dass das Vortraining dabei hilft, eine niedrigdimensionale Darstellung der Daten zu erlernen, was anschließend dazu beiträgt, die nachgelagerten Aufgaben von Interesse mit linearen Klassifikatoren zu lösen, die weniger beschriftete Daten erfordern.

Ein häufiges Thema ist die Formalisierung der idealen Eigenschaften unbeschrifteter Datenverteilungen für die Erstellung selbstüberwachter Lernaufgaben. Bei entsprechender Formalisierung kann gezeigt werden, dass durch eine ungefähre Minimierung des korrekten Ziels vor dem Training Downstream-Signale extrahiert werden können, die implizit in unbeschrifteten Datenverteilungen codiert sind. Abschließend zeigen wir, dass dieses Signal mithilfe eines linearen Klassifikators aus der erlernten Darstellung dekodiert werden kann und so eine Formalisierung für den Transfer von „Fähigkeiten und Wissen“ über Aufgaben hinweg bereitstellt.

EINFÜHRUNG

Der Bereich maschinelles Lernen und künstliche Intelligenz hat im letzten Jahrzehnt enorme Fortschritte bei der Entwicklung von Agenten und datengesteuerten Problemlösungen gemacht. Mit ersten Erfolgen bei anspruchsvollen Benchmarks für überwachtes Lernen wie ImageNet [Deng et al., 2009] führten Innovationen im Deep Learning anschließend zu Modellen mit übermenschlicher Leistung bei vielen solcher Benchmarks in verschiedenen Bereichen. Das Training solcher aufgabenspezifischen Modelle ist sicherlich beeindruckend und hat einen enormen praktischen Wert. Es besteht jedoch eine wichtige Einschränkung darin, dass große beschriftete oder kommentierte Datensätze erforderlich sind, was oft teuer ist. Darüber hinaus erhofft man sich aus Intelligenzperspektive allgemeinere Modelle, die wie Menschen [Ahn und Brewer, 1993] aus früheren Erfahrungen lernen, diese zu Fähigkeiten oder Konzepten zusammenfassen und diese Fähigkeiten oder Konzepte zur Lösung neuer Aufgaben nutzen können wenig oder keine Demonstration. Schließlich lernen Babys viel durch Beobachtung und Interaktion ohne explizite Aufsicht. Diese Einschränkungen inspirierten zu einem alternativen Paradigma für das Vortraining.

Der Schwerpunkt dieses Artikels liegt auf dem Vortraining unter Verwendung der oft großen Mengen unbeschrifteter verfügbarer Daten. Die Idee, unbeschriftete Daten zu verwenden, ist seit langem ein interessanter Punkt beim maschinellen Lernen, insbesondere beim unbeaufsichtigten und halbüberwachten Lernen.

Der Schwerpunkt dieses Artikels liegt auf dem Vortraining unter Verwendung der oft großen Mengen unbeschrifteter verfügbarer Daten. Die Idee, unbeschriftete Daten zu verwenden, ist seit langem ein interessanter Punkt beim maschinellen Lernen, insbesondere beim unbeaufsichtigten und halbüberwachten Lernen.

Während selbstüberwachtes Lernen empirisch erfolgreich war und weiterhin vielversprechend ist, mangelt es über eine grobe Intuition hinaus immer noch an einem guten theoretischen Verständnis seiner Funktionsweise. Diese beeindruckenden Erfolge werfen interessante Fragen auf, da a priori unklar ist, warum ein Modell, das für eine Aufgabe trainiert wurde, bei einer anderen, scheinbar nicht zusammenhängenden Aufgabe helfen sollte, d. h. warum das Training für Aufgabe a bei Aufgabe b helfen sollte. Während ein vollständiges theoretisches Verständnis von SSL (und Deep Learning im Allgemeinen) schwierig und schwer zu erreichen ist, kann das Verständnis dieses Phänomens auf jeder Abstraktionsebene bei der Entwicklung prinzipiellerer Algorithmen helfen. Die Forschungsmotivation dieses Artikels lautet:

Warum hilft das Training zu selbstüberwachten Lernaufgaben (unter Verwendung großer Mengen unbeschrifteter Daten) bei der Lösung datenknapper nachgelagerter Aufgaben? Wie kann der Transfer von „Wissen und Fähigkeiten“ formalisiert werden?

Obwohl es eine große Literatur zum überwachten Lernen gibt, unterscheidet sich die Generalisierung von SSL-Aufgabe → Downstream-Aufgabe grundlegend von der Generalisierung von Trainingssatz → Testsatz beim überwachten Lernen. Für überwachtes Lernen für nachgelagerte Klassifizierungsaufgaben kann beispielsweise ein Modell, das auf einem Trainingssatz von Eingabe-Label-Paaren trainiert wurde, die aus einer unbekannten Verteilung stammen, direkt für die Auswertung eines unbekannten Testsatzes verwendet werden, der aus derselben Verteilung stammt. Diese Grundverteilung stellt die Verbindung vom Trainingssatz zum Testsatz her. Der konzeptionelle Zusammenhang zwischen SSL-Aufgabe und Downstream-Aufgabe ist jedoch weniger klar, da die in der SSL-Aufgabe verwendeten unbeschrifteten Daten kein klares Signal über Downstream-Labels haben. Dies bedeutet, dass ein Modell, das für eine SSL-Aufgabe vorab trainiert wurde (z. B. Vorhersage eines Teils der Eingabe aus dem Rest), nicht direkt für nachgelagerte Aufgaben verwendet werden kann (z. B. Vorhersage einer Klassenbezeichnung anhand der Eingabe). Daher erfordert der Transfer von „Wissen und Fähigkeiten“ einen zusätzlichen Trainingsschritt unter Verwendung einiger gekennzeichneter Daten, idealerweise weniger als das, was für überwachtes Lernen von Grund auf erforderlich ist. Jedes theoretische Verständnis der Verallgemeinerung von SSL-Aufgaben → Downstream-Aufgaben muss sich mit den folgenden Fragen befassen: „Welche eigentliche Rolle spielen unbeschriftete Daten?“ und „Wie werden vorab trainierte Modelle für Downstream-Aufgaben verwendet?“ Dieses Papier zielt auf die Downstream-Aufgaben der Klassifizierung ab Treffen Sie Verteilungsannahmen für unbeschriftete Daten und nutzen Sie die Idee des Repräsentationslernens, um diese Probleme zu untersuchen:

(a) (Verteilungsannahme) Die Verteilung unbeschrifteter Daten enthält implizit Informationen über die nachgelagerte Klassifizierungsaufgabe von Interesse.

(b) (Darstellungslernen) Ein Modell, das vorab auf eine entsprechende SSL-Aufgabe trainiert wurde, kann dieses Signal durch erlernte Darstellungen kodieren, die dann zur Lösung nachgelagerter Klassifizierungsaufgaben mit linearen Klassifikatoren verwendet werden können.

Punkt (a) zeigt, dass bestimmte Struktureigenschaften, die nicht gekennzeichnet sind, uns implizit Hinweise auf nachfolgende nachgelagerte Aufgaben geben, und selbstüberwachtes Lernen kann dabei helfen, dieses Signal aus den Daten herauszuarbeiten. Punkt (b) schlägt eine einfache und empirisch effektive Möglichkeit vor, vorab trainierte Modelle zu verwenden und dabei die erlernten Darstellungen des Modells zu nutzen. Dieser Artikel identifiziert und quantifiziert die Verteilungseigenschaften unbeschrifteter Daten mathematisch und zeigt, dass gute Darstellungen für verschiedene SSL-Methoden wie kontrastives Lernen, Sprachmodellierung und Selbstvorhersage erlernt werden können. Im nächsten Abschnitt befassen wir uns mit der Idee des Repräsentationslernens und erklären formal, warum selbstüberwachtes Lernen nachgelagerte Aufgaben unterstützt.

Das obige ist der detaillierte Inhalt vonWarum ist Selbstüberwachung effektiv? Die 243-seitige Princeton-Doktorarbeit „Understanding Self-supervised Representation Learning' erläutert umfassend die drei Arten von Methoden: kontrastives Lernen, Sprachmodellierung und Selbstvorhersage.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Heute diskutieren wir darüber, wie Deep-Learning-Technologie die Leistung von visionbasiertem SLAM (Simultaneous Localization and Mapping) in komplexen Umgebungen verbessern kann. Durch die Kombination von Methoden zur Tiefenmerkmalsextraktion und Tiefenanpassung stellen wir hier ein vielseitiges hybrides visuelles SLAM-System vor, das die Anpassung in anspruchsvollen Szenarien wie schlechten Lichtverhältnissen, dynamischer Beleuchtung, schwach strukturierten Bereichen und starkem Jitter verbessern soll. Unser System unterstützt mehrere Modi, einschließlich erweiterter Monokular-, Stereo-, Monokular-Trägheits- und Stereo-Trägheitskonfigurationen. Darüber hinaus wird analysiert, wie visuelles SLAM mit Deep-Learning-Methoden kombiniert werden kann, um andere Forschungen zu inspirieren. Durch umfangreiche Experimente mit öffentlichen Datensätzen und selbst abgetasteten Daten demonstrieren wir die Überlegenheit von SL-SLAM in Bezug auf Positionierungsgenauigkeit und Tracking-Robustheit.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren