Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Eine GPU kann 3D-Modelle in Sekundenschnelle erstellen! Das neue Werk von OpenAI: Point-E kann mithilfe von Text 3D-Punktwolkenmodelle generieren

Eine GPU kann 3D-Modelle in Sekundenschnelle erstellen! Das neue Werk von OpenAI: Point-E kann mithilfe von Text 3D-Punktwolkenmodelle generieren

Eine GPU kann 3D-Modelle in Sekundenschnelle erstellen! Das neue Werk von OpenAI: Point-E kann mithilfe von Text 3D-Punktwolkenmodelle generieren

Wo ist der nächste Durchbruch, der die KI-Welt im Sturm erobern wird?

Viele Leute gehen davon aus, dass es sich um einen 3D-Modellgenerator handelt.

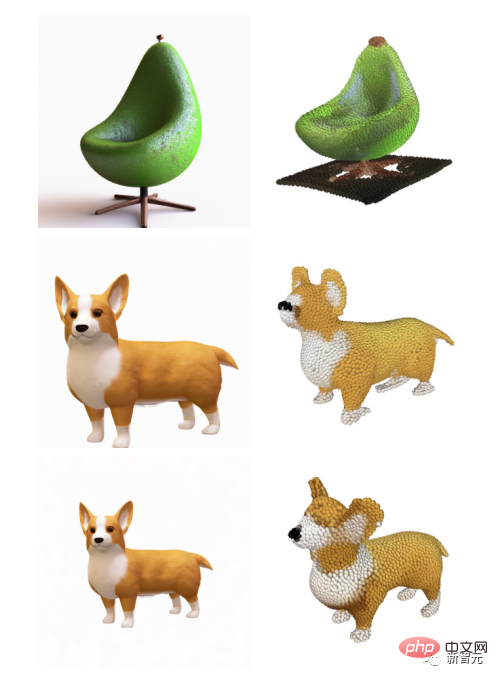

Nachdem DALL-E 2 zu Beginn des Jahres alle mit seinem genialen Pinsel überraschte, veröffentlichte OpenAI am Dienstag sein neuestes Bildgenerierungsmodell „POINT-E“, das direkt 3D-Modelle aus Text generieren kann.

Link zum Papier: https://arxiv.org/pdf/2212.08751.pdf

Im Vergleich zu Konkurrenten (wie Googles DreamFusion), die mehrere GPUs benötigen, um mehrere Stunden lang zu arbeiten, PUNKT - E generiert 3D-Bilder in wenigen Minuten mit nur einer einzigen GPU.

Nach dem eigentlichen Test durch den Editor kann POINT-E 3D-Bilder grundsätzlich in Sekunden nach der Eingabeaufforderung ausgeben. Darüber hinaus unterstützt das Ausgabebild auch benutzerdefinierte Bearbeitung, Speicherung und andere Funktionen.

Adresse: https://huggingface.co/spaces/openai/point-e

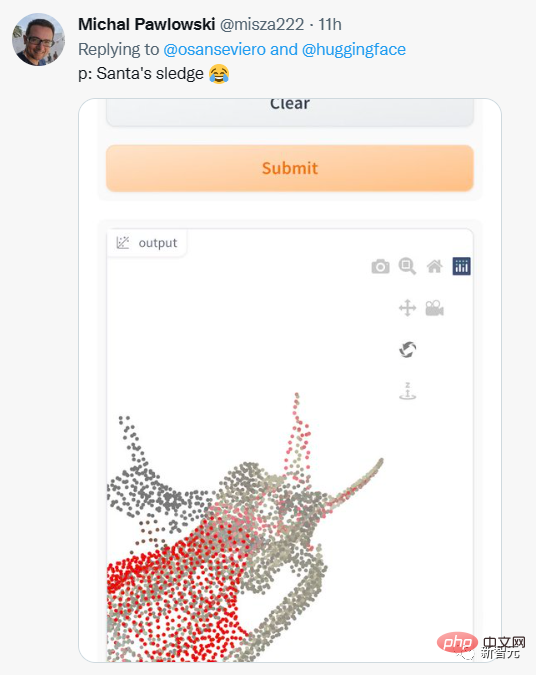

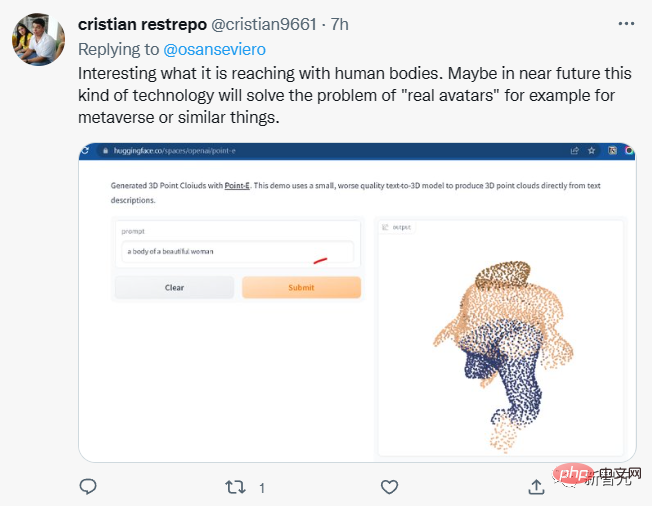

Internetnutzer begannen auch, verschiedene Eingabeaufforderungen auszuprobieren.

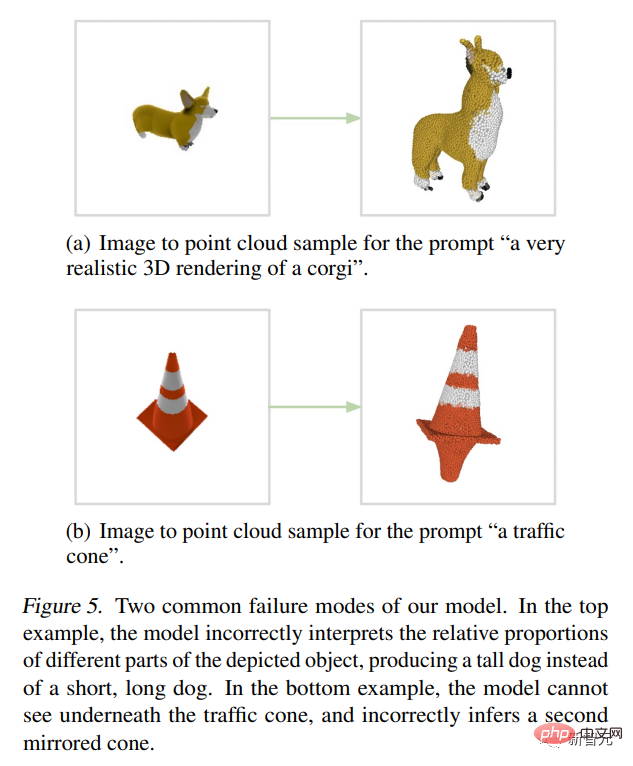

Aber die Ausgabeergebnisse sind nicht immer zufriedenstellend.

Einige Internetnutzer sagten, dass POINT-E möglicherweise in der Lage sein könnte, Metas Metaversum-Vision zu verwirklichen?

Es ist zu beachten, dass POINT-E 3D-Bilder durch eine Punktwolke (Punktwolke) generiert, bei der es sich um einen Datensatz von Punkten im Raum handelt.

Einfach ausgedrückt geht es darum, Daten über ein dreidimensionales Modell zu sammeln, um Punktwolkendaten zu erhalten, die eine 3D-Form im Raum darstellen.

Punktwolken sind aus rechnerischer Sicht einfacher zu synthetisieren, sie können jedoch nicht die empfindliche Form oder Textur von Objekten erfassen, was derzeit ein Manko von Point-E ist.

Um diese Einschränkung zu beheben, trainierte das Point-E-Team ein zusätzliches künstliches Intelligenzsystem, um die Punktwolken von Point-E in Netze umzuwandeln.

Point-E-Punktwolke in Netz umwandeln

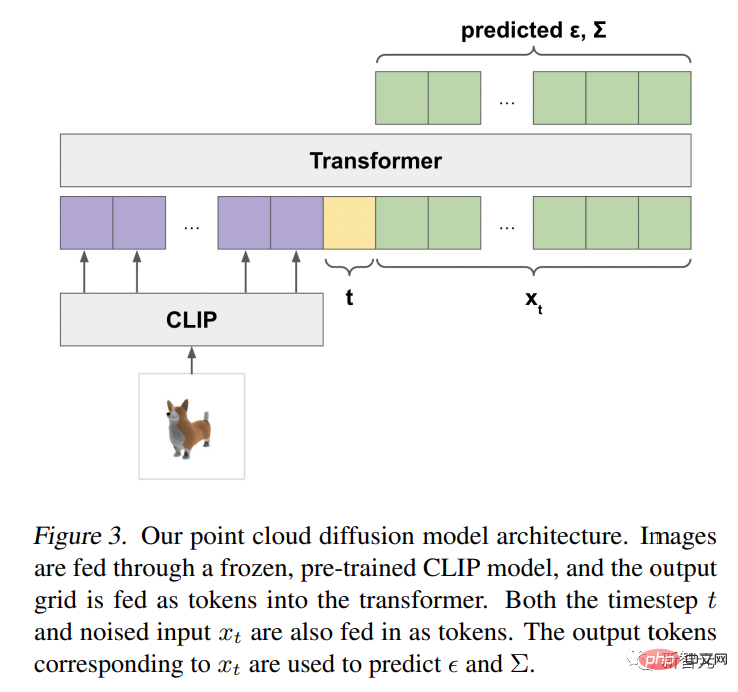

Über das unabhängige Netzgenerierungsmodell hinaus besteht Point-E aus zwei Modellen:

Ein Text-zu-Bild-Konvertierungsmodell (Text -zu-Bild-Modell) und Bildkonvertierung 3D-Modell (Bild-zu-3D-Modell).

Das Text-zu-Bild-Konvertierungsmodell ähnelt DALL-E 2 und Stable Diffusion von OpenAI und wird auf beschrifteten Bildern trainiert, um den Zusammenhang zwischen Wörtern und visuellen Konzepten zu verstehen.

Dann wird ein Satz gepaarter Bilder mit 3D-Objekten in das 3D-Transformationsmodell eingespeist, damit das Modell lernt, effizient zwischen den beiden zu transformieren.

Wenn eine Eingabeaufforderung eingegeben wird, generiert das Text-Bild-Konvertierungsmodell ein synthetisches Renderobjekt, das dem Bildkonvertierungs-3D-Modell zugeführt wird, das dann eine Punktwolke generiert.

OpenAI-Forscher sagen, dass Point-E anhand eines Datensatzes von Millionen von 3D-Objekten und zugehörigen Metadaten trainiert wurde.

Aber es ist nicht perfekt. Das Bild-zu-3D-Modell von Point-E kann manchmal Bilder im Text-zu-Bild-Modell nicht verstehen, was zu Formen führt, die nicht mit dem Texthinweis übereinstimmen. Dennoch ist es um Größenordnungen schneller als frühere, hochmoderne Technologien.

Sie schrieben in der Arbeit:

Obwohl unsere Methode bei der Auswertung schlechter abschneidet als der Stand der Technik, generiert sie Proben in einem Bruchteil der Zeit. Dies kann es für bestimmte Anwendungen praktischer machen und qualitativ hochwertigere 3D-Objekte entdecken.

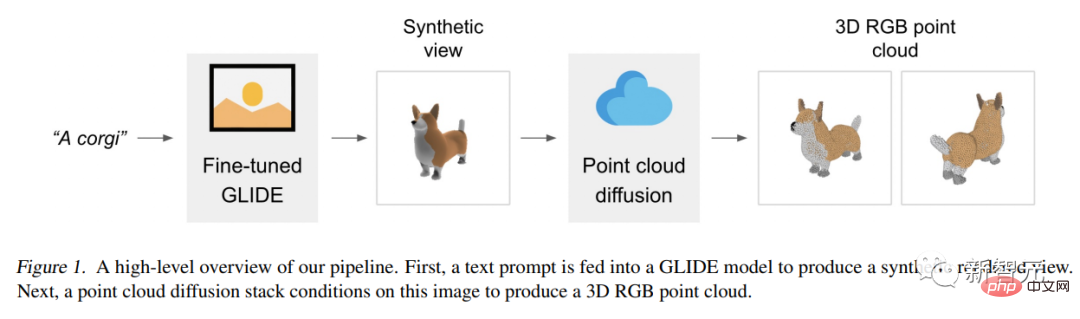

Point-E-Architektur und Betriebsmechanismus

Das Point-E-Modell verwendet zunächst ein Text-zu-Bild-Diffusionsmodell, um eine einzelne synthetische Ansicht zu generieren, und verwendet dann ein zweites Diffusionsmodell, um eine 3D-Punktwolke zu generieren wird generiert von Bilder sind bedingt.

Obwohl diese Methode in Bezug auf die Qualität der Stichproben immer noch nicht auf dem neuesten Stand ist, ist sie ein bis zwei Größenordnungen schneller, was für einige Anwendungsfälle einen praktischen Kompromiss darstellt.

Die folgende Abbildung ist ein High-Level-Pipeline-Diagramm des Modells:

Anstatt ein einzelnes Generationsmodell zu trainieren und Punktwolken basierend auf dem Text direkt zu generieren, unterteilen wir den Generierungsprozess in drei Schritte.

Erstellen Sie zunächst eine umfassende Ansicht basierend auf dem Texttitel.

Als nächstes generieren Sie eine grobe Punktwolke (1.024 Punkte) basierend auf der synthetischen Ansicht.

Abschließend wurde eine feine Punktwolke (4.096 Punkte) generiert, die auf der Punktwolke mit niedriger Auflösung und der synthetischen Ansicht basiert.

Nachdem wir Modelle an Millionen von 3D-Modellen trainiert hatten, stellten wir fest, dass das Datenformat und die Qualität der Datensätze stark variierten, was uns dazu veranlasste, verschiedene Nachbearbeitungsschritte zu entwickeln, um eine höhere Datenqualität sicherzustellen.

Um alle Daten in ein gemeinsames Format zu konvertieren, haben wir Blender verwendet, um jedes 3D-Modell aus 20 zufälligen Kamerawinkeln in RGBAD-Bilder zu rendern (Blender unterstützt mehrere 3D-Formate und verfügt über eine optimierte Rendering-Engine).

Für jedes Modell normalisiert ein Blender-Skript das Modell in einen Begrenzungswürfel, konfiguriert Standardbeleuchtungseinstellungen und exportiert schließlich ein RGBAD-Bild mithilfe der integrierten Echtzeit-Rendering-Engine von Blender.

Verwenden Sie dann „Rendern“, um jedes Objekt in eine farbige Punktwolke umzuwandeln. Zunächst wird für jedes Objekt eine dichte Punktwolke erstellt, indem die Punkte für jedes Pixel in jedem RGBAD-Bild gezählt werden. Diese Punktwolken enthalten in der Regel Hunderttausende ungleichmäßig verteilter Punkte. Daher verwenden wir auch die Stichprobe der am weitesten entfernten Punkte, um eine einheitliche 4K-Punktwolke zu erstellen.

Durch die direkte Erstellung von Punktwolken aus Renderings können wir verschiedene Probleme vermeiden, die beim direkten Abtasten aus einem 3D-Netz, beim Abtasten von in einem Modell enthaltenen Punkten oder bei der Verarbeitung von 3D-Modellen, die in ungewöhnlichen Dateiformaten gespeichert sind, auftreten können.

Schließlich verwenden wir verschiedene Heuristiken, um die Häufigkeit minderwertiger Modelle in unserem Datensatz zu reduzieren.

Zuerst eliminieren wir planare Objekte, indem wir die SVD jeder Punktwolke berechnen und behalten nur die Objekte bei, deren minimaler Singulärwert höher als ein bestimmter Schwellenwert ist.

Als nächstes gruppieren wir den Datensatz nach CLIP-Features (für jedes Objekt mitteln wir die Features über alle Renderings).

Wir haben festgestellt, dass einige Cluster viele Modellkategorien von geringer Qualität enthielten, während andere Cluster vielfältiger oder interpretierbarer zu sein schienen.

Wir teilen diese Cluster in mehrere Buckets unterschiedlicher Qualität auf und verwenden eine gewichtete Mischung der resultierenden Buckets als unseren endgültigen Datensatz.

Anwendungsaussichten

OpenAI-Forscher wiesen darauf hin, dass die Punktwolke von Point-E auch zur Erstellung realer Objekte verwendet werden kann, beispielsweise für den 3D-Druck.

Mit zusätzlichen Mesh-Konvertierungsmodellen kann das System auch in Spiel- und Animationsentwicklungs-Workflows einsteigen.

Während alle Augen derzeit auf 2D-Kunstgeneratoren gerichtet sind, könnte die Modellsynthese-KI der nächste große Umbruch in der Branche sein.

3D-Modelle werden häufig in Film und Fernsehen, Innenarchitektur, Architektur und verschiedenen wissenschaftlichen Bereichen verwendet.

Derzeit dauert die Herstellung von 3D-Modellen in der Regel mehrere Stunden, und das Aufkommen von Point-E gleicht dieses Manko einfach aus.

Forscher sagen, dass Point-E zum jetzigen Zeitpunkt noch viele Mängel aufweist, wie etwa aus Trainingsdaten geerbte Vorurteile und fehlende Schutzmaßnahmen für Modelle, die zur Erstellung gefährlicher Objekte verwendet werden könnten.

Point-E ist nur ein Ausgangspunkt, sie hoffen, dass es „weitere Arbeiten“ im Bereich der Text-zu-3D-Synthese inspirieren wird.

Das obige ist der detaillierte Inhalt vonEine GPU kann 3D-Modelle in Sekundenschnelle erstellen! Das neue Werk von OpenAI: Point-E kann mithilfe von Text 3D-Punktwolkenmodelle generieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

1. Einleitung In den letzten Jahren haben sich YOLOs aufgrund ihres effektiven Gleichgewichts zwischen Rechenkosten und Erkennungsleistung zum vorherrschenden Paradigma im Bereich der Echtzeit-Objekterkennung entwickelt. Forscher haben das Architekturdesign, die Optimierungsziele, Datenerweiterungsstrategien usw. von YOLO untersucht und erhebliche Fortschritte erzielt. Gleichzeitig behindert die Verwendung von Non-Maximum Suppression (NMS) bei der Nachbearbeitung die End-to-End-Bereitstellung von YOLO und wirkt sich negativ auf die Inferenzlatenz aus. In YOLOs fehlt dem Design verschiedener Komponenten eine umfassende und gründliche Prüfung, was zu erheblicher Rechenredundanz führt und die Fähigkeiten des Modells einschränkt. Es bietet eine suboptimale Effizienz und ein relativ großes Potenzial zur Leistungsverbesserung. Ziel dieser Arbeit ist es, die Leistungseffizienzgrenze von YOLO sowohl in der Nachbearbeitung als auch in der Modellarchitektur weiter zu verbessern. zu diesem Zweck