Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Amazon steigt mit großem Bekanntheitsgrad in den ChatGPT-Krieg ein und veröffentlicht kostenlos das große Titan-Modell und den KI-Programmierassistenten CEO: Change all experience

Amazon steigt mit großem Bekanntheitsgrad in den ChatGPT-Krieg ein und veröffentlicht kostenlos das große Titan-Modell und den KI-Programmierassistenten CEO: Change all experience

Amazon steigt mit großem Bekanntheitsgrad in den ChatGPT-Krieg ein und veröffentlicht kostenlos das große Titan-Modell und den KI-Programmierassistenten CEO: Change all experience

Über Nacht kam Amazon zum „Überholen in einer Kurve“.

Während alle großen Technologiegiganten auf der ganzen Welt das derzeit beliebteste große Modell, AIGC, annehmen, vermittelt Amazon nur einen Eindruck: Stealth.

Obwohl AWS großen Model-Star-Unternehmen wie Hugging Face und Stability AI Rechenleistung für maschinelles Lernen zur Verfügung gestellt hat, gibt Amazon die Einzelheiten der Zusammenarbeit selten bekannt. Einige Internetnutzer haben gezählt, dass Amazon in den vergangenen Finanzberichtssitzungen KI fast kein Mal erwähnt hat.

Aber jetzt hat sich die Einstellung von Amazon dramatisch geändert.

Am 13. April veröffentlichte Andy Jassy, CEO von Amazon, den jährlichen Aktionärsbrief 2022, in dem er erklärte, er sei zuversichtlich, dass Amazon die Kosten kontrollieren und weiterhin in neue Wachstumsbereiche investieren könne. In seinem Brief erklärte er, dass Amazon in Zukunft stark in die derzeit beliebten Bereiche Large-Scale Language Models (LLM) und generative künstliche Intelligenz (KI) investieren werde.

Jassy sagte, dass Amazon in den letzten Jahrzehnten maschinelles Lernen in einer Vielzahl von Anwendungen eingesetzt hat. Das Unternehmen entwickelt derzeit ein eigenes großes Sprachmodell, das das Potenzial hat, „fast jedes Kundenerlebnis“ zu verbessern.

Bevor er zu Ende sprach, wurden das große Modell und die Dienste von Amazon vorgestellt.

„Die meisten Unternehmen wollen große Sprachmodelle verwenden, aber wirklich nützliche Sprachmodelle erfordern Milliarden von Dollar und Jahre zum Trainieren, und die Leute wollen das nicht durchmachen“, sagte Andy Jassy. „Sie möchten also ein bereits sehr umfangreiches Basismodell verbessern und es dann für ihre eigenen Zwecke anpassen. Das ist Bedrock.“

Amazon-Version von ChatGPT: Teil seines Cloud-Dienstes.

Große Modelle

In seiner neuesten Ankündigung stellte AWS eine neue Reihe von Modellen vor – gemeinsam „Amazon Titan“ genannt.

Modelle der Titan-Serie sind in zwei Typen unterteilt: Der eine ist ein Textmodell für die Inhaltsgenerierung und der andere ist ein Einbettungsmodell, das Vektoreinbettungen zum Erstellen effizienter Suchfunktionen usw. erstellen kann.

Das Textgenerierungsmodell ähnelt dem GPT-4 von OpenAI (aber hinsichtlich der Leistung nicht unbedingt identisch) und kann Aufgaben wie das Schreiben von Blogbeiträgen und E-Mails, das Zusammenfassen von Dokumenten und das Extrahieren von Informationen aus Datenbanken ausführen. Einbettungsmodelle übersetzen Texteingaben (z. B. Wörter und Phrasen) in numerische Darstellungen, sogenannte Einbettungen, die die Semantik des Textes enthalten.

ChatGPT- und Microsoft Bing-Chatbots, die auf dem OpenAI-Sprachmodell basieren, erzeugen manchmal ungenaue Informationen. Dies ist auf ein Verhalten namens „Halluzination“ zurückzuführen, bei dem die Ausgabe überzeugend aussieht, aber tatsächlich nichts mit den Trainingsdaten zu tun hat.

AWS-Vizepräsident Bratin Saha sagte gegenüber CNBC, dass Amazon „sehr großen Wert auf Genauigkeit legt“ und darauf achtet, dass sein Titan-Modell qualitativ hochwertige Antworten liefert.

Kunden können Titan-Modelle mit ihren eigenen Daten anpassen. Ein anderer Vizepräsident sagte jedoch, dass die Daten niemals zum Trainieren von Titan-Modellen verwendet würden, um sicherzustellen, dass andere Kunden, einschließlich Wettbewerber, nicht am Ende von den Daten profitieren.

Sivasubramanian und Saha lehnten es ab, über die Größe der Titan-Modelle zu sprechen oder die Daten zu identifizieren, die Amazon zum Trainieren verwendet hat, und Saha wollte nicht den Prozess beschreiben, den Amazon verfolgte, um problematische Teile der Trainingsdaten des Modells zu entfernen.

Cloud-Dienst

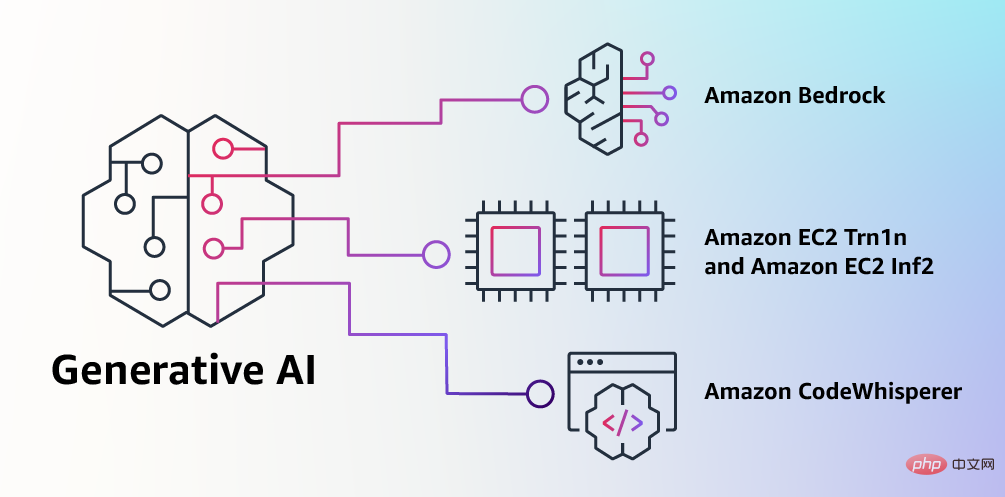

Die Veröffentlichung des Titan-Modells ist eigentlich Teil von Amazons „Bedrock“-Plan. Amazon, der weltweit größte Cloud-Infrastrukturanbieter, wird ein so schnell wachsendes Feld natürlich nicht Konkurrenten wie Google und Microsoft überlassen.

Das Bedrock-Projekt wurde einen Monat nach der Veröffentlichung von GPT-4 durch OpenAI gestartet. Damals hatte Microsoft Milliarden von Dollar in OpenAI investiert und OpenAI über seinen Cloud-Dienst Azure Rechenleistung zur Verfügung gestellt. Dies ist der stärkste Wettbewerb, dem das AWS-Geschäft von Amazon jemals ausgesetzt war.

Der Bedrock-Clouddienst ähnelt der Engine hinter dem ChatGPT-Chatbot, der vom von Microsoft unterstützten Startup OpenAI betrieben wird. Amazon Web Services wird über seinen generativen KI-Dienst Bedrock Zugriff auf Modelle wie Titan ermöglichen.

Der von diesem Dienst unterstützte anfängliche Basismodellsatz umfasst auch Modelle von AI21, Anthropic und Stability AI sowie die von Amazon selbst entwickelten neuen Modelle der Titan-Serie. Das Debüt von Bedrock ist ein Vorläufer der Partnerschaften, die AWS in den letzten Monaten mit Start-ups im Bereich generative KI geschlossen hat.

Der Hauptvorteil von Bedrock besteht darin, dass Benutzer es in den Rest der AWS-Cloud-Plattform integrieren können. Dies bedeutet, dass Unternehmen einfacher auf die im Amazon S3-Objektspeicherdienst gespeicherten Daten zugreifen und von den AWS-Zugriffskontroll- und Governance-Richtlinien profitieren können.

Amazon gibt derzeit nicht bekannt, wie viel der Bedrock-Service kosten wird, da es sich noch um eine begrenzte Vorschau handelt. Ein Sprecher sagte, Kunden könnten sich auf eine Warteliste setzen. Zuvor haben Microsoft und OpenAI Preise für die Nutzung von GPT-4 angekündigt, die bei einigen Cent pro 1.000 Token beginnen, wobei ein Token etwa vier englischen Zeichen entspricht, während Google die Preise für sein PaLM-Sprachmodell noch nicht bekannt gegeben hat.

KI-Programmierassistent, kostenlos und offen für Einzelpersonen

Wir wissen, dass Programmierung einer der Bereiche sein wird, in denen generative KI-Technologie schnell eingesetzt werden wird. Heutzutage verbringen Softwareentwickler viel Zeit damit, relativ einfachen und undifferenzierten Code zu schreiben und viel Zeit damit, komplexe neue Tools und Techniken zu erlernen, die sich ständig weiterentwickeln. Dadurch bleibt den Entwicklern nur sehr wenig Zeit, tatsächlich innovative Funktionen und Dienste zu entwickeln.

Um dieses Problem zu lösen, werden Entwickler versuchen, Codeausschnitte aus dem Internet zu kopieren und sie dann zu ändern. Dabei kann es jedoch passieren, dass sie versehentlich ungültigen Code und Code mit Sicherheitsrisiken kopieren. Diese Methode des Suchens und Kopierens verschwendet auch die Zeit der Entwickler für den Geschäftsaufbau.

Generative KI kann diese mühsame Arbeit erheblich reduzieren, indem sie größtenteils undifferenzierten Code „schreibt“, sodass Entwickler Code schneller schreiben können und mehr Zeit haben, sich auf kreativere Programmierarbeiten zu konzentrieren.

Im Jahr 2022 kündigte Amazon den Start der Amazon CodeWhisperer-Vorschau an . Dieser KI-Programmierassistent nutzt ein eingebettetes Basismodell, um Codevorschläge in Echtzeit basierend auf den in natürlicher Sprache beschriebenen Entwicklerkommentaren und vorhandenem Code in der IDE zu generieren und so die Arbeitseffizienz zu verbessern. Die Vorschauversion stieß bei den Entwicklern auf begeisterte Resonanz: Benutzer erledigten Aufgaben durchschnittlich 57 % schneller und mit einer um 27 % höheren Erfolgsquote als diejenigen, die den Programmierassistenten nicht nutzten.

Jetzt gibt Amazon bekannt, dass CodeWhisperer offiziell verfügbar, kostenlos und für alle Einzelbenutzer ohne Qualifikation oder Nutzungszeitbeschränkung offen ist. Beinhaltet außerdem Zitatverfolgung und 50 Sicherheitsscans pro Monat. Nutzer müssen sich lediglich per E-Mail registrieren und benötigen kein Amazon-Cloud-Service-Konto. Unternehmenskunden können die Professional-Version wählen, die erweiterte Verwaltungsfunktionen umfasst.

Zusätzlich zu Python, Java, JavaScript, TypeScript und C# hat CodeWhisperer Unterstützung für 10 neue Entwicklungssprachen hinzugefügt, darunter Go, Kotlin, Rust, PHP und SQL. Entwickler können über das Amazon Toolkit-Plug-in in integrierten Entwicklungsumgebungen wie VS Code, IntelliJ IDEA, Amazon Cloud9 auf CodeWhisperer zugreifen und es kann auch in der Amazon Lambda-Konsole verwendet werden.

Amazon sagt, dass CodeWhisperer nicht nur aus Milliarden Zeilen öffentlichen Codes lernt, sondern auch auf dem Code von Amazon trainiert wird. Daher ist es derzeit die genaueste, schnellste und sicherste Möglichkeit, Code für Amazon-Cloud-Dienste, einschließlich Amazon EC2 und mehr, zu generieren.

Von KI-Programmierassistenten generierter Code kann versteckte Sicherheitslücken enthalten, daher bietet CodeWhisperer als einziger integrierte Sicherheitsscanfunktionen (aktiviert durch automatisierte Inferenz). Diese Funktion findet schwer zu erkennende Schwachstellen und gibt Empfehlungen zur Behebung, z. B. solche im Top 10 Open Web Application Security Project (OWASP) und solche, die nicht den Best Practices der kryptografischen Bibliothek entsprechen.

Um Entwicklern bei der verantwortungsvollen Entwicklung von Code zu helfen, filtert CodeWhisperer außerdem Codevorschläge heraus, die als voreingenommen oder unfair angesehen werden könnten. Da Kunden möglicherweise auf Open-Source-Codequellen verweisen oder eine Genehmigung für deren Nutzung einholen müssen, ist CodeWhisperer gleichzeitig auch der einzige Programmierassistent, der verdächtige Open-Source-Codevorschläge filtern und markieren kann.

Zusammenfassung

Amazon ist seit mehr als 20 Jahren im KI-Bereich tätig und AWS hat bereits mehr als 100.000 KI-Kunden. Amazon habe eine optimierte Version von Titan verwendet, um Suchergebnisse über seine Homepage bereitzustellen, sagte Sivasubramanian.

Allerdings ist Amazon nur eines der großen Unternehmen, das generative KI-Funktionen einführte, nachdem ChatGPT auf den Markt kam und populär wurde. Expedia, HubSpot, Paylocity und Spotify setzen sich alle für die Integration der OpenAI-Technologie ein, Amazon hingegen nicht. „Wir handeln immer dann, wenn alles bereit ist und die gesamte Technologie bereits vorhanden ist“, sagte Sivasubramanian. Durch den Einsatz eines benutzerdefinierten KI-Prozessors möchte Amazon sicherstellen, dass Bedrock einfach zu bedienen und kostengünstig ist.

Derzeit bereiten sich Unternehmen wie C3.ai, Pegasystems und Salesforce auf die Einführung von Amazon Bedrock vor.

Das obige ist der detaillierte Inhalt vonAmazon steigt mit großem Bekanntheitsgrad in den ChatGPT-Krieg ein und veröffentlicht kostenlos das große Titan-Modell und den KI-Programmierassistenten CEO: Change all experience. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1369

1369

52

52

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Bei der Konvertierung von Zeichenfolgen in Objekte in Vue.js wird JSON.Parse () für Standard -JSON -Zeichenfolgen bevorzugt. Bei nicht standardmäßigen JSON-Zeichenfolgen kann die Zeichenfolge durch Verwendung regelmäßiger Ausdrücke verarbeitet und Methoden gemäß dem Format oder dekodierten URL-kodiert reduziert werden. Wählen Sie die entsprechende Methode gemäß dem String -Format aus und achten Sie auf Sicherheits- und Codierungsprobleme, um Fehler zu vermeiden.

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der MySQL -Primärschlüssel kann nicht leer sein, da der Primärschlüssel ein Schlüsselattribut ist, das jede Zeile in der Datenbank eindeutig identifiziert. Wenn der Primärschlüssel leer sein kann, kann der Datensatz nicht eindeutig identifiziert werden, was zu Datenverwirrung führt. Wenn Sie selbstsinkrementelle Ganzzahlsspalten oder UUIDs als Primärschlüssel verwenden, sollten Sie Faktoren wie Effizienz und Raumbelegung berücksichtigen und eine geeignete Lösung auswählen.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Lösungen für den Dienst, der nach der MySQL -Installation nicht gestartet werden kann

Apr 08, 2025 am 11:18 AM

Lösungen für den Dienst, der nach der MySQL -Installation nicht gestartet werden kann

Apr 08, 2025 am 11:18 AM

MySQL hat sich geweigert, anzufangen? Nicht in Panik, lass es uns ausprobieren! Viele Freunde stellten fest, dass der Service nach der Installation von MySQL nicht begonnen werden konnte, und sie waren so ängstlich! Mach dir keine Sorgen, dieser Artikel wird dich dazu bringen, ruhig damit umzugehen und den Mastermind dahinter herauszufinden! Nachdem Sie es gelesen haben, können Sie dieses Problem nicht nur lösen, sondern auch Ihr Verständnis von MySQL -Diensten und Ihren Ideen zur Fehlerbehebungsproblemen verbessern und zu einem leistungsstärkeren Datenbankadministrator werden! Der MySQL -Dienst startete nicht und es gibt viele Gründe, von einfachen Konfigurationsfehlern bis hin zu komplexen Systemproblemen. Beginnen wir mit den häufigsten Aspekten. Grundkenntnisse: Eine kurze Beschreibung des Service -Startup -Prozesses MySQL Service Startup. Einfach ausgedrückt, lädt das Betriebssystem MySQL-bezogene Dateien und startet dann den MySQL-Daemon. Dies beinhaltet die Konfiguration