Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Das weltweit erste wirklich Open-Source-ChatGPT-Großmodell Dolly 2.0, das nach Belieben für die kommerzielle Nutzung modifiziert werden kann

Das weltweit erste wirklich Open-Source-ChatGPT-Großmodell Dolly 2.0, das nach Belieben für die kommerzielle Nutzung modifiziert werden kann

Das weltweit erste wirklich Open-Source-ChatGPT-Großmodell Dolly 2.0, das nach Belieben für die kommerzielle Nutzung modifiziert werden kann

Wie wir alle wissen, ist OpenAI nicht offen, wenn es um ChatGPT geht. Die Open-Source-Modelle der Alpaca-Serie sind aufgrund von Problemen wie Datensätzen auch „auf akademische Forschungsanwendungen beschränkt“. Um Einschränkungen zu umgehen, ist hier ein großes Modell, das sich auf 100 % Open Source konzentriert.

Am 12. April veröffentlichte Databricks Dolly 2.0, eine weitere neue Version des ChatGPT-ähnlichen Large Language Model (LLM), das der menschlichen Interaktivität (Anweisungen folgt) ähnelt und vor zwei Wochen veröffentlicht wurde.

Databricks sagt, dass Dolly 2.0 das erste richtlinienkonforme Open-Source-LLM der Branche ist, das auf einem transparenten und frei verfügbaren Datensatz basiert, der ebenfalls Open Source ist und für kommerzielle Zwecke verfügbar ist. Dies bedeutet, dass Dolly 2.0 zum Erstellen kommerzieller Anwendungen verwendet werden kann, ohne für den API-Zugriff bezahlen oder Daten mit Dritten teilen zu müssen.

- Projektlink: https://huggingface.co/databricks/dolly-v2-12b

- Datensatz: https://github.com/databrickslabs/dolly/tree/ master /data

Laut Ali Ghodsi, CEO von Databricks, gibt es zwar andere große Modelle, die für kommerzielle Zwecke genutzt werden können, „sie sprechen jedoch nicht wie Dolly 2.0 mit Ihnen.“ Und basierend auf dem Dolly 2.0-Modell: Benutzer können die Trainingsdaten ändern und verbessern, da sie unter einer Open-Source-Lizenz frei verfügbar sind. So können Sie Ihre eigene Version von Dolly erstellen.

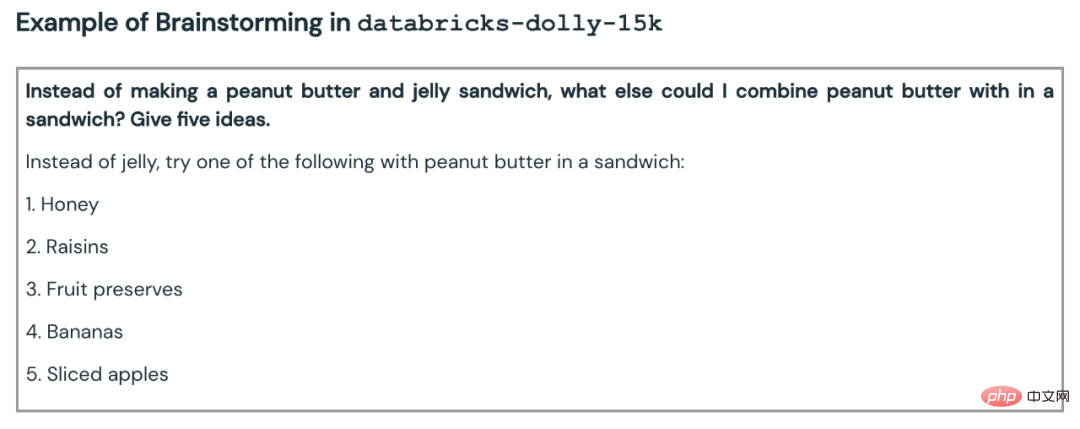

Databricks hat auch den Datensatz veröffentlicht, an dem Dolly 2.0 verfeinert wurde, mit dem Namen databricks-dolly-15k. Dabei handelt es sich um einen Korpus aus mehr als 15.000 Datensätzen, der von Tausenden von Databricks-Mitarbeitern generiert wurde. Databricks nennt ihn „den ersten von Menschen erstellten Open-Source-Anweisungskorpus, der speziell entwickelt wurde, um großen Sprachen die Demonstration der magischen Interaktivität von ChatGPT zu ermöglichen“

Wie Dolly 2.0 geboren wurde

In den letzten zwei Monaten haben Industrie und Wissenschaft OpenAI eingeholt und eine Welle von ChatGPT-ähnlichen großen Modellen vorgeschlagen, die Anweisungen befolgen. Diese Versionen werden von vielen Definitionen als Open Source (bzw Sorgen Sie für ein gewisses Maß an Offenheit oder eingeschränkten Zugang. Unter ihnen hat Metas LLaMA die meiste Aufmerksamkeit auf sich gezogen, was zu einer großen Anzahl weiter verbesserter Modelle geführt hat, wie zum Beispiel Alpaca, Koala, Vicuna und Databricks‘ Dolly 1.0.

Aber andererseits unterliegen viele dieser „offenen“ Modelle „industriellen Zwängen“, weil sie auf Datensätzen trainiert werden, deren Begriffe darauf ausgelegt sind, die kommerzielle Nutzung einzuschränken – wie etwa die 52.000 Frage- und Antwortdaten des StanfordAlpaca-Projekts set wird basierend auf der Ausgabe von OpenAIs ChatGPT trainiert. Und die Nutzungsbedingungen von OpenAI enthalten eine Regel, die besagt, dass Sie die Dienste von OpenAI nicht nutzen dürfen, um mit ihnen zu konkurrieren.

Databricks dachte über einen Weg nach, dieses Problem zu lösen: Der neu vorgeschlagene Dolly 2.0 ist ein 12-Milliarden-Parameter-Sprachmodell, das auf der Open-Source-Pythia-Modellreihe EleutherAI basiert und speziell für eine kleine Open-Source-Anweisung optimiert ist Datensatzkorpus (databricks-dolly- 15k), dieser Datensatz wurde von Databricks-Mitarbeitern erstellt und die Lizenzbedingungen erlauben die Nutzung, Änderung und Erweiterung für jeden Zweck, einschließlich akademischer oder kommerzieller Anwendungen.

Bisher befanden sich Modelle, die auf die Ausgabe von ChatGPT trainiert wurden, in einer rechtlichen Grauzone. „Die gesamte Community ist um dieses Problem herumgeschlichen und jeder bringt diese Modelle auf den Markt, aber keines davon ist im Handel erhältlich“, sagte Ghodsi. „Deshalb sind wir so aufgeregt.“

„Alle anderen wollen größer werden, aber wir sind eigentlich an etwas Kleinerem interessiert“, sagte Ghodsi über Dollys Miniaturwaage. „Zweitens haben wir alle Antworten durchgesehen und sie waren von hoher Qualität.“

Ghodsi sagte, er glaube, dass Dolly 2.0 einen „Schneeball“-Effekt auslösen werde, der es anderen im Bereich der künstlichen Intelligenz ermöglichen würde, mitzumachen und andere Alternativen vorzuschlagen . Er erklärte, dass Beschränkungen der kommerziellen Nutzung eine große Hürde seien, die es zu überwinden gilt: „Wir sind jetzt begeistert, weil wir endlich einen Weg gefunden haben, das Problem zu umgehen. Ich garantiere Ihnen, dass Sie Leute sehen werden, die diese 15.000 Probleme auf die reale Welt anwenden. Jedes Modell da.“ Das heißt, sie werden sehen, wie viele dieser Modelle plötzlich ein wenig magisch werden und man mit ihnen interagieren kann.“

Hand-Rubbing-Datensatz

Um die Gewichte für das Dolly 2.0-Modell herunterzuladen, besuchen Sie einfach die Databricks Hugging Face-Seite und besuchen Sie das Dolly-Repo von databricks-labs, um den Datensatz databricks-dolly-15k herunterzuladen.

Der Datensatz „databricks-dolly-15k“ enthält 15.000 hochwertige, von Menschen generierte Eingabeaufforderungs-/Antwortpaare, geschrieben von mehr als 5.000 Databricks-Mitarbeitern im März und April 2023, speziell entwickelte Anweisungen zum Optimieren großer Sprachmodelle . Diese Trainingsaufzeichnungen sind natürlich, ausdrucksstark und so konzipiert, dass sie ein breites Spektrum an Verhaltensweisen abbilden, vom Brainstorming und der Inhaltserstellung bis hin zur Informationsextraktion und -zusammenfassung.

Gemäß den Lizenzbedingungen dieses Datensatzes (Creative Commons Attribution-ShareAlike 3.0 Unported License) kann jeder diesen Datensatz für jeden Zweck, einschließlich kommerzieller Anwendungen, nutzen, ändern oder erweitern.

Derzeit ist dieser Datensatz der erste von Menschen erstellte Open-Source-Anweisungsdatensatz .

Warum so einen Datensatz erstellen? Das Team erklärte in einem Blogbeitrag auch, warum.

Ein wichtiger Schritt bei der Erstellung von Dolly 1.0 oder jeder Direktive, die LLM folgt, besteht darin, das Modell anhand eines Datensatzes aus Direktiven- und Antwortpaaren zu trainieren. Das Training von Dolly 1.0 kostet 30 US-Dollar und verwendet einen Datensatz, der vom Alpaca-Team der Stanford University mithilfe der OpenAI-API erstellt wurde.

Nachdem Dolly 1.0 veröffentlicht wurde, wollten viele Leute es ausprobieren, und einige Benutzer wollten dieses Modell auch kommerziell nutzen.

Aber der Trainingsdatensatz enthält die Ausgabe von ChatGPT, und wie das Stanford-Team betont, versuchen die Nutzungsbedingungen zu verhindern, dass irgendjemand ein Modell erstellt, das mit OpenAI konkurriert.

Bisher unterlagen alle bekannten Richtlinienkonformitätsmodelle (Alpaca, Koala, GPT4All, Vicuna) dieser Einschränkung: Die kommerzielle Nutzung war verboten. Um dieses Problem zu lösen, begann Dollys Team nach Möglichkeiten zu suchen, einen neuen Datensatz ohne Einschränkungen bei der kommerziellen Nutzung zu erstellen.

Konkret erfuhr das Team aus einem von OpenAI veröffentlichten Forschungspapier, dass das ursprüngliche InstructGPT-Modell anhand eines Datensatzes trainiert wurde, der aus 13.000 Verhaltensdemonstrationen bei der Befolgung von Anweisungen bestand. Davon inspiriert machten sie sich unter der Leitung von Databricks-Mitarbeitern daran, ähnliche Ergebnisse zu erzielen.

Es stellt sich heraus, dass das Generieren von 13.000 Fragen und Antworten schwieriger ist als gedacht. Denn jede Antwort muss original sein und darf nicht von ChatGPT oder irgendwo im Web kopiert werden, da sonst der Datensatz „verschmutzt“ wird. Aber Databricks hat mehr als 5.000 Mitarbeiter und sie waren sehr an LLM interessiert. Deshalb führte das Team ein Crowdsourcing-Experiment durch, bei dem ein Datensatz mit höherer Qualität erstellt wurde als der, den 40 Annotatoren für OpenAI erstellt hatten.

Natürlich ist diese Arbeit zeit- und arbeitsintensiv. Um alle zu motivieren, hat das Team einen Wettbewerb ins Leben gerufen, bei dem die besten 20 Kommentatoren Überraschungspreise erhalten. Gleichzeitig listeten sie auch 7 ganz konkrete Aufgaben auf:

- Offene Fragen und Antworten: Zum Beispiel: „Warum mögen die Leute Comedy-Filme?“ oder „Was ist die Hauptstadt Frankreichs?“ andere müssen auf das Wissen der ganzen Welt zurückgreifen;

- Geschlossene Fragen und Antworten: Diese Fragen können mit nur einem Absatz an Informationen aus der Referenz beantwortet werden. Wenn man beispielsweise einen Wikipedia-Absatz über Atome betrachtet, könnte man fragen: „Wie ist das Verhältnis von Protonen zu Neutronen im Kern?“; : Hier kopiert der Annotator einen Absatz aus Wikipedia und extrahiert Entitäten oder andere sachliche Informationen aus dem Absatz, wie z. B. Gewicht oder Maße; #Informationen auf Wikipedia zusammenfassend: Dazu wurde den Annotatoren eine Passage aus Wikipedia zur Verfügung gestellt und gebeten, diese zu destillieren eine kurze Zusammenfassung;

- #🎜🎜 #Brainstorming: Diese Aufgabe erfordert eine offene Ideenfindung und eine Liste möglicher Optionen. Zum Beispiel: „Welche lustigen Aktivitäten kann ich dieses Wochenende mit meinen Freunden unternehmen?“; Treffen Sie Urteile (z. B. ob es sich bei den Elementen in einer Liste um Tiere, Mineralien oder Gemüse handelt) oder beurteilen Sie die Attribute einer Passage, z. B. die Stimmung eines Filmrezension;

- Kreatives Schreiben: Zu den Aufgaben gehört das Schreiben von etwas wie einem Gedicht oder einem Liebesbrief.

- Hier einige Beispiele:

- # 🎜🎜#

- Das Team war zunächst skeptisch, 10.000 Ergebnisse zu erreichen. Aber mit dem nächtlichen Bestenlistenspiel gelang es, in einer Woche 15.000 Ergebnisse zu erzielen.

Dann brach das Team das Spiel ab, weil es Bedenken hatte, „die Produktivität der Mitarbeiter zu binden“ (was Sinn macht).

Kommerzielle Machbarkeit

Nachdem der Datensatz schnell erstellt war, begann das Team, über kommerzielle Anwendungen nachzudenken.

Sie wollen ein Open-Source-Modell erstellen, das kommerziell genutzt werden kann. Obwohl databricks-dolly-15k viel kleiner ist als Alpaca (der Datensatz, auf dem Dolly 1.0 trainiert wurde), weist das auf EleutherAI pythia-12b basierende Dolly 2.0-Modell ein qualitativ hochwertiges Befehlsfolgeverhalten auf.

Im Nachhinein ist das nicht überraschend. Schließlich enthalten viele in den letzten Monaten veröffentlichte Datensätze zur Befehlsoptimierung synthetische Daten, die häufig Halluzinationen und sachliche Fehler enthalten.

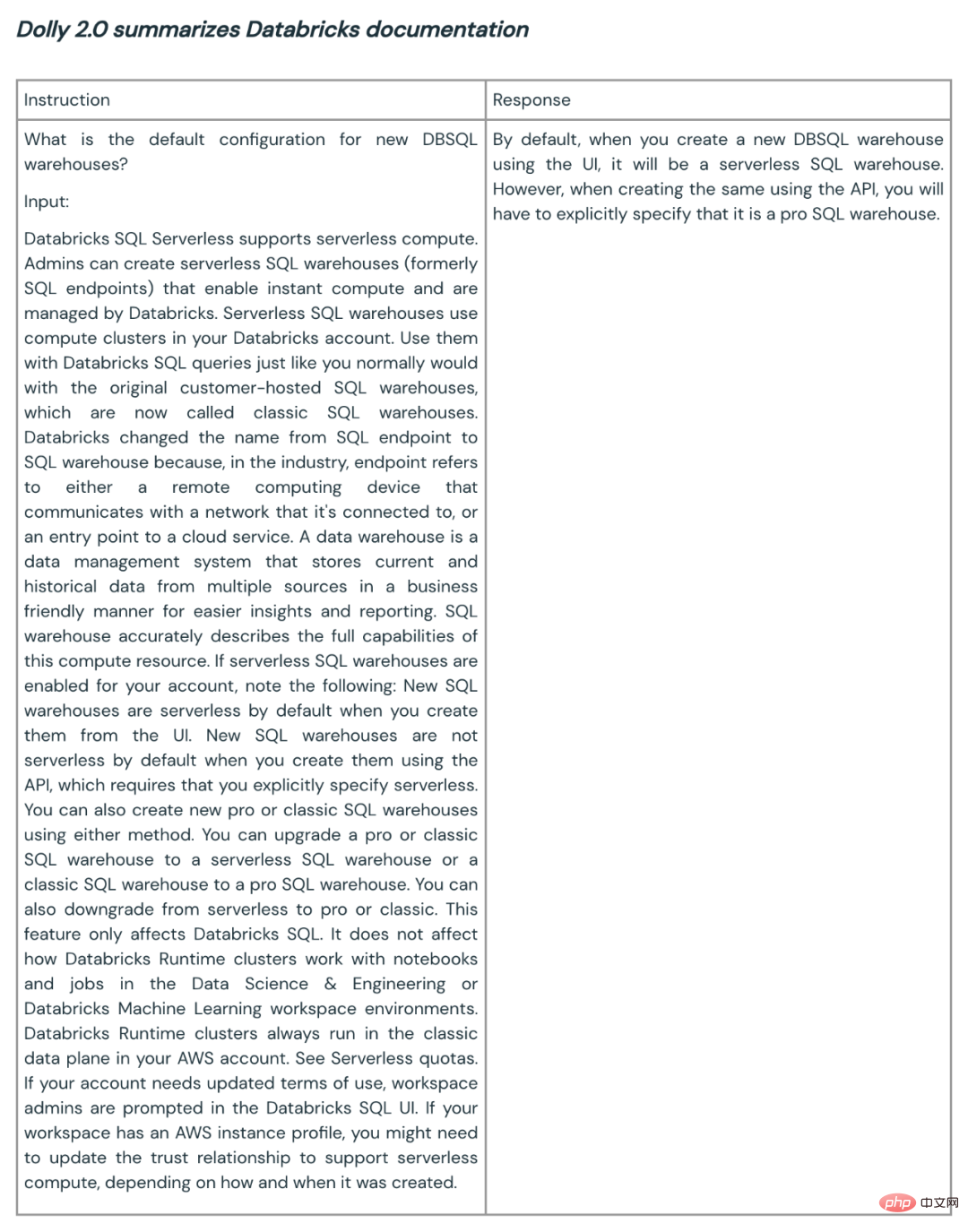

databricks-dolly-15k hingegen wird von Profis erstellt, ist von hoher Qualität und enthält ausführliche Antworten auf die meisten Aufgaben.Hier sind einige Beispiele für die Verwendung von Dolly 2.0 zur Zusammenfassung und Inhaltserstellung:

#🎜🎜 #

Dolly Das Team sagt, dass basierend auf dem ersten Kundenfeedback solche Funktionen verfügbar sein könnten im gesamten Unternehmen für eine Vielzahl von Anwendungen. Denn viele Unternehmen hoffen, über eigene Modelle zu verfügen, um qualitativ hochwertigere Modelle für ihre eigenen spezifischen Domänenanwendungen zu erstellen, anstatt ihre sensiblen Daten an Dritte weiterzugeben.

Die Open Source von Dolly 2 ist ein guter Anfang für den Aufbau eines besseren Ökosystems für große Modelle. Open-Source-Datensätze und -Modelle fördern Kommentare, Forschung und Innovation und tragen dazu bei, dass jeder von den Fortschritten in der KI-Technologie profitiert. Das Dolly-Team geht davon aus, dass das neue Modell und der Open-Source-Datensatz als Grundlage für zahlreiche Folgearbeiten dienen und zu leistungsfähigeren Sprachmodellen führen werden.

Das obige ist der detaillierte Inhalt vonDas weltweit erste wirklich Open-Source-ChatGPT-Großmodell Dolly 2.0, das nach Belieben für die kommerzielle Nutzung modifiziert werden kann. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Zehn empfohlene Open-Source-Tools für kostenlose Textanmerkungen

Mar 26, 2024 pm 08:20 PM

Zehn empfohlene Open-Source-Tools für kostenlose Textanmerkungen

Mar 26, 2024 pm 08:20 PM

Bei der Textanmerkung handelt es sich um die Arbeit mit entsprechenden Beschriftungen oder Tags für bestimmte Inhalte im Text. Sein Hauptzweck besteht darin, zusätzliche Informationen zum Text für eine tiefere Analyse und Verarbeitung bereitzustellen, insbesondere im Bereich der künstlichen Intelligenz. Textanmerkungen sind für überwachte maschinelle Lernaufgaben in Anwendungen der künstlichen Intelligenz von entscheidender Bedeutung. Es wird zum Trainieren von KI-Modellen verwendet, um Textinformationen in natürlicher Sprache genauer zu verstehen und die Leistung von Aufgaben wie Textklassifizierung, Stimmungsanalyse und Sprachübersetzung zu verbessern. Durch Textanmerkungen können wir KI-Modellen beibringen, Entitäten im Text zu erkennen, den Kontext zu verstehen und genaue Vorhersagen zu treffen, wenn neue ähnliche Daten auftauchen. In diesem Artikel werden hauptsächlich einige bessere Open-Source-Textanmerkungstools empfohlen. 1.LabelStudiohttps://github.com/Hu

15 empfohlene kostenlose Open-Source-Bildanmerkungstools

Mar 28, 2024 pm 01:21 PM

15 empfohlene kostenlose Open-Source-Bildanmerkungstools

Mar 28, 2024 pm 01:21 PM

Bei der Bildanmerkung handelt es sich um das Verknüpfen von Beschriftungen oder beschreibenden Informationen mit Bildern, um dem Bildinhalt eine tiefere Bedeutung und Erklärung zu verleihen. Dieser Prozess ist entscheidend für maschinelles Lernen, das dabei hilft, Sehmodelle zu trainieren, um einzelne Elemente in Bildern genauer zu identifizieren. Durch das Hinzufügen von Anmerkungen zu Bildern kann der Computer die Semantik und den Kontext hinter den Bildern verstehen und so den Bildinhalt besser verstehen und analysieren. Die Bildanmerkung hat ein breites Anwendungsspektrum und deckt viele Bereiche ab, z. B. Computer Vision, Verarbeitung natürlicher Sprache und Diagramm-Vision-Modelle. Sie verfügt über ein breites Anwendungsspektrum, z. B. zur Unterstützung von Fahrzeugen bei der Identifizierung von Hindernissen auf der Straße und bei der Erkennung und Diagnose von Krankheiten durch medizinische Bilderkennung. In diesem Artikel werden hauptsächlich einige bessere Open-Source- und kostenlose Bildanmerkungstools empfohlen. 1.Makesens

Der Quellcode von 25 KI-Agenten ist jetzt öffentlich, inspiriert von Stanfords „Virtual Town' und „Westworld'

Aug 11, 2023 pm 06:49 PM

Der Quellcode von 25 KI-Agenten ist jetzt öffentlich, inspiriert von Stanfords „Virtual Town' und „Westworld'

Aug 11, 2023 pm 06:49 PM

Zuschauer, die mit „Westworld“ vertraut sind, wissen, dass diese Show in einem riesigen High-Tech-Themenpark für Erwachsene in der Zukunftswelt spielt. Die Roboter haben ähnliche Verhaltensfähigkeiten wie Menschen und können sich an das erinnern, was sie sehen und hören, und die Kernhandlung wiederholen. Jeden Tag werden diese Roboter zurückgesetzt und in ihren Ausgangszustand zurückversetzt. Nach der Veröffentlichung des Stanford-Artikels „Generative Agents: Interactive Simulacra of Human Behavior“ ist dieses Szenario nicht mehr auf Filme und Fernsehserien beschränkt Szene in Smallvilles „Virtual Town“ 》Übersichtskarten-Papieradresse: https://arxiv.org/pdf/2304.03442v1.pdf

Empfohlen: Ausgezeichnetes JS-Open-Source-Projekt zur Gesichtserkennung und -erkennung

Apr 03, 2024 am 11:55 AM

Empfohlen: Ausgezeichnetes JS-Open-Source-Projekt zur Gesichtserkennung und -erkennung

Apr 03, 2024 am 11:55 AM

Die Technologie zur Gesichtserkennung und -erkennung ist bereits eine relativ ausgereifte und weit verbreitete Technologie. Derzeit ist JS die am weitesten verbreitete Internetanwendungssprache. Die Implementierung der Gesichtserkennung und -erkennung im Web-Frontend hat im Vergleich zur Back-End-Gesichtserkennung Vor- und Nachteile. Zu den Vorteilen gehören die Reduzierung der Netzwerkinteraktion und die Echtzeiterkennung, was die Wartezeit des Benutzers erheblich verkürzt und das Benutzererlebnis verbessert. Die Nachteile sind: Es ist durch die Größe des Modells begrenzt und auch die Genauigkeit ist begrenzt. Wie implementiert man mit js die Gesichtserkennung im Web? Um die Gesichtserkennung im Web zu implementieren, müssen Sie mit verwandten Programmiersprachen und -technologien wie JavaScript, HTML, CSS, WebRTC usw. vertraut sein. Gleichzeitig müssen Sie auch relevante Technologien für Computer Vision und künstliche Intelligenz beherrschen. Dies ist aufgrund des Designs der Webseite erwähnenswert

Das multimodale Dokumentenverständnis-Großmodell Alibaba 7B gewinnt neue SOTA

Apr 02, 2024 am 11:31 AM

Das multimodale Dokumentenverständnis-Großmodell Alibaba 7B gewinnt neue SOTA

Apr 02, 2024 am 11:31 AM

Neues SOTA für multimodale Dokumentverständnisfunktionen! Das Alibaba mPLUG-Team hat die neueste Open-Source-Arbeit mPLUG-DocOwl1.5 veröffentlicht, die eine Reihe von Lösungen zur Bewältigung der vier großen Herausforderungen der hochauflösenden Bildtexterkennung, des allgemeinen Verständnisses der Dokumentstruktur, der Befolgung von Anweisungen und der Einführung externen Wissens vorschlägt. Schauen wir uns ohne weitere Umschweife zunächst die Auswirkungen an. Ein-Klick-Erkennung und Konvertierung von Diagrammen mit komplexen Strukturen in das Markdown-Format: Es stehen Diagramme verschiedener Stile zur Verfügung: Auch eine detailliertere Texterkennung und -positionierung ist einfach zu handhaben: Auch ausführliche Erläuterungen zum Dokumentverständnis können gegeben werden: Sie wissen schon, „Document Understanding“. " ist derzeit ein wichtiges Szenario für die Implementierung großer Sprachmodelle. Es gibt viele Produkte auf dem Markt, die das Lesen von Dokumenten unterstützen. Einige von ihnen verwenden hauptsächlich OCR-Systeme zur Texterkennung und arbeiten mit LLM zur Textverarbeitung zusammen.

Gerade erschienen! Ein Open-Source-Modell zum Generieren von Bildern im Anime-Stil mit einem Klick

Apr 08, 2024 pm 06:01 PM

Gerade erschienen! Ein Open-Source-Modell zum Generieren von Bildern im Anime-Stil mit einem Klick

Apr 08, 2024 pm 06:01 PM

Lassen Sie mich Ihnen das neueste AIGC-Open-Source-Projekt vorstellen – AnimagineXL3.1. Dieses Projekt ist die neueste Version des Text-zu-Bild-Modells mit Anime-Thema und zielt darauf ab, Benutzern ein optimiertes und leistungsfähigeres Erlebnis bei der Generierung von Anime-Bildern zu bieten. Bei AnimagineXL3.1 konzentrierte sich das Entwicklungsteam auf die Optimierung mehrerer Schlüsselaspekte, um sicherzustellen, dass das Modell neue Höhen in Bezug auf Leistung und Funktionalität erreicht. Zunächst erweiterten sie die Trainingsdaten, um nicht nur Spielcharakterdaten aus früheren Versionen, sondern auch Daten aus vielen anderen bekannten Anime-Serien in das Trainingsset aufzunehmen. Dieser Schritt erweitert die Wissensbasis des Modells und ermöglicht ihm ein umfassenderes Verständnis verschiedener Anime-Stile und Charaktere. AnimagineXL3.1 führt eine neue Reihe spezieller Tags und Ästhetiken ein

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins

1,3 ms dauert 1,3 ms! Tsinghuas neueste Open-Source-Architektur für mobile neuronale Netzwerke RepViT

Mar 11, 2024 pm 12:07 PM

1,3 ms dauert 1,3 ms! Tsinghuas neueste Open-Source-Architektur für mobile neuronale Netzwerke RepViT

Mar 11, 2024 pm 12:07 PM

Papieradresse: https://arxiv.org/abs/2307.09283 Codeadresse: https://github.com/THU-MIG/RepViTRepViT funktioniert gut in der mobilen ViT-Architektur und zeigt erhebliche Vorteile. Als nächstes untersuchen wir die Beiträge dieser Studie. In dem Artikel wird erwähnt, dass Lightweight-ViTs bei visuellen Aufgaben im Allgemeinen eine bessere Leistung erbringen als Lightweight-CNNs, hauptsächlich aufgrund ihres Multi-Head-Selbstaufmerksamkeitsmoduls (MSHA), das es dem Modell ermöglicht, globale Darstellungen zu lernen. Allerdings wurden die architektonischen Unterschiede zwischen Lightweight-ViTs und Lightweight-CNNs noch nicht vollständig untersucht. In dieser Studie integrierten die Autoren leichte ViTs in die effektiven