Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Was sind die Merkmale eines Netzwerks, das für den Antrieb von AIGC geeignet ist?

Was sind die Merkmale eines Netzwerks, das für den Antrieb von AIGC geeignet ist?

Was sind die Merkmale eines Netzwerks, das für den Antrieb von AIGC geeignet ist?

2023 ist das Jahr, in dem die KI-Technologie für künstliche Intelligenz immer beliebter wird.

Die großen AIGC-Modelle ChatGPT, GPT-4 und Wen

Als alter Mann in der Kommunikation beschäftigt sich Xiao Zaojun neben dem AIGC-Großmodell selbst mehr mit der Kommunikationstechnologie hinter dem Modell. Was für ein leistungsstarkes Netzwerk unterstützt den Betrieb von AIGC? Welche Veränderungen wird die KI-Welle außerdem für traditionelle Netzwerke mit sich bringen?

█ AIGC, wie viel Rechenleistung braucht es?

Wie wir alle wissen, sind Daten, Algorithmen und Rechenleistung die drei Grundelemente für die Entwicklung künstlicher Intelligenz.

Die zuvor erwähnten großen AIGC-Modelle sind nicht nur wegen der massiven Dateneinspeisung, die ihnen zugrunde liegen, so leistungsstark, sondern auch, weil die Algorithmen ständig weiterentwickelt und aktualisiert werden. Noch wichtiger ist, dass sich das Ausmaß der menschlichen Rechenleistung bis zu einem gewissen Grad weiterentwickelt hat. Die leistungsstarke Computerinfrastruktur kann die Computeranforderungen von AIGC vollständig unterstützen.

Mit der Entwicklung von AIGC sind die Parameter des Trainingsmodells von Hunderten Milliarden auf Billionen gestiegen. Um ein derart umfangreiches Training abzuschließen, hat die Anzahl der von der zugrunde liegenden Schicht unterstützten GPUs ebenfalls die Größenordnung von 10.000 Karten erreicht.

Nehmen Sie ChatGPT als Beispiel. Sie nutzten die Supercomputing-Infrastruktur von Microsoft. Es heißt, dass 10.000 V100-GPUs verwendet wurden, um einen Cluster mit hoher Bandbreite zu bilden. Ein Training erfordert etwa 3640 PF-Tage Rechenleistung (d. h. 1 Billiarde Berechnungen pro Sekunde, läuft über 3640 Tage).

Die FP32-Rechenleistung eines V100 beträgt 0,014 PFLOPS (Rechenleistungseinheit, entspricht 1 Billiarde Gleitkommaoperationen pro Sekunde). Zehntausend V100, das sind 140 PFLOPS.

Mit anderen Worten: Wenn die GPU-Auslastung 100 % beträgt, dauert es 3640 ÷ 140 = 26 (Tage), um eine Trainingssitzung abzuschließen.

Es ist unmöglich, dass die GPU-Auslastung 100 % erreicht (die von OpenAI angenommene Auslastung), 26 mal dreimal, was 78 Tagen entspricht.

Es ist ersichtlich, dass die GPU-Rechenleistung und die GPU-Auslastung einen großen Einfluss auf das Training großer Modelle haben.

Dann stellt sich die Frage: Was ist der größte Faktor, der die GPU-Auslastung beeinflusst?

Die Antwort lautet: das Internet.

Zehntausende oder sogar Zehntausende GPUs benötigen als Rechencluster eine enorme Bandbreite für die Interaktion mit dem Speichercluster. Wenn der GPU-Cluster außerdem Trainingsberechnungen durchführt, sind diese nicht unabhängig, sondern gemischt und parallel. Zwischen GPUs findet ein großer Datenaustausch statt, der ebenfalls eine enorme Bandbreite erfordert.

Wenn das Netzwerk nicht stark ist und die Datenübertragung langsam ist, muss die GPU auf Daten warten, was zu einer geringeren Auslastung führt. Mit abnehmender Auslastung nimmt die Schulungszeit zu, die Kosten steigen und die Benutzererfahrung verschlechtert sich.

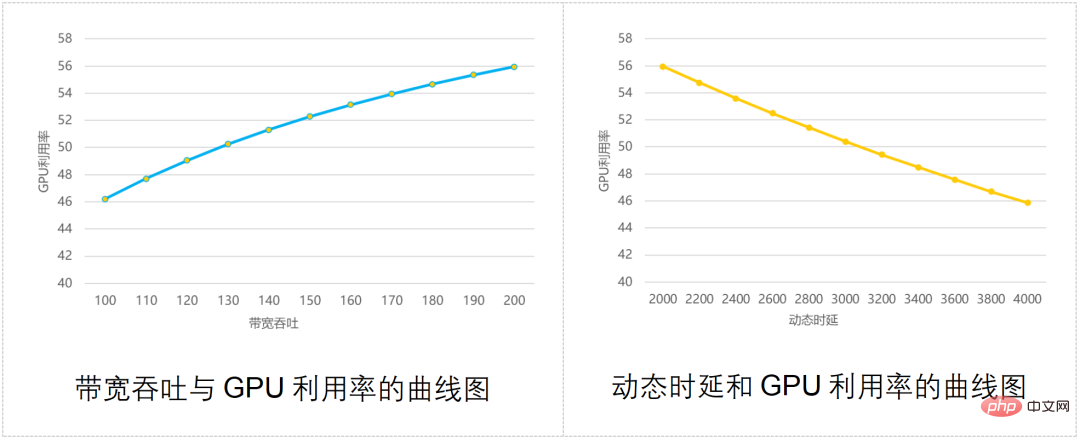

Die Branche hat einmal ein Modell zur Berechnung der Beziehung zwischen Netzwerkbandbreitendurchsatz, Kommunikationsverzögerung und GPU-Auslastung erstellt, wie in der folgenden Abbildung dargestellt:

Wie Sie sehen können, ist die GPU umso höher, je stärker der Netzwerkdurchsatz ist Auslastung: Je höher die Auslastung; je größer die dynamische Kommunikationsverzögerung, desto geringer ist die GPU-Auslastung.

Kurz gesagt: Spielen Sie nicht mit großen Models ohne ein gutes Netzwerk.

█ Welche Art von Netzwerk kann den Betrieb von AIGC unterstützen?

Um die durch KI-Cluster-Computing verursachten Netzwerkanpassungen zu bewältigen, hat sich die Branche auch viele Möglichkeiten überlegt.

Es gibt drei hauptsächliche traditionelle Antwortstrategien: Infiniband, RDMA und modulare Switches. Werfen wir einen kurzen Blick auf jeden von ihnen.

Infiniband-Netzwerke

Infiniband-Netzwerke (wörtlich übersetzt als „Technologie mit unendlicher Bandbreite“, abgekürzt als IB) sollten Kindern, die sich mit Datenkommunikation befassen, vertraut sein.

Dies ist derzeit der beste Weg, ein Hochleistungsnetzwerk mit extrem hoher Bandbreite aufzubauen, das keine Überlastung und geringe Latenz erreicht. Was ChatGPT und GPT-4 nutzen, soll Infiniband-Netzwerke sein.

Wenn das Infiniband-Netzwerk einen Nachteil hat, dann ist es ein Wort: teuer. Im Vergleich zu herkömmlichen Ethernet-Netzwerken werden die Kosten für Infiniband-Netzwerke um ein Vielfaches höher sein. Diese Technologie ist relativ geschlossen. Derzeit gibt es in der Branche nur einen ausgereiften Anbieter, und die Benutzer haben kaum eine Wahl.

- RDMA-Netzwerk

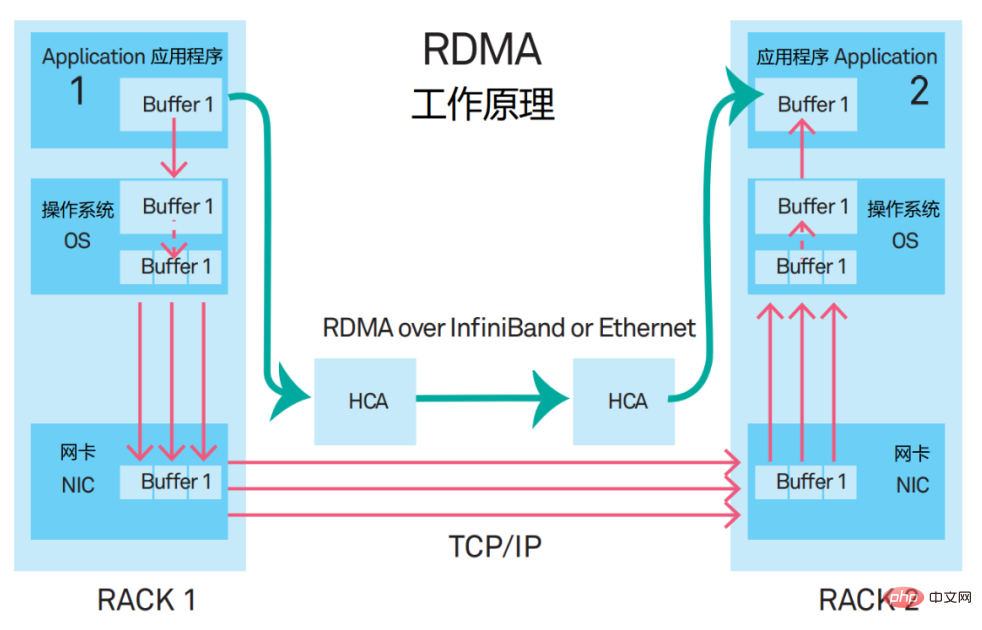

Der vollständige Name von RDMA ist Remote Direct Memory Access. Es handelt sich um einen neuartigen Kommunikationsmechanismus. Bei der RDMA-Lösung durchlaufen Anwendungsdaten nicht mehr die CPU und das komplexe Betriebssystem, sondern kommunizieren direkt mit der Netzwerkkarte, was nicht nur den Durchsatz deutlich verbessert, sondern auch die Latenz reduziert.

Als RDMA erstmals vorgeschlagen wurde, wurde es über das InfiniBand-Netzwerk übertragen. Jetzt wird RDMA schrittweise auf Ethernet übertragen.

Derzeit basiert die Mainstream-Netzwerklösung für Hochleistungsnetzwerke auf dem Protokoll RoCE v2 (RDMA over Converged Ethernet, RDMA basierend auf Converged Ethernet). . Richten Sie ein Netzwerk ein, das RDMA unterstützt.

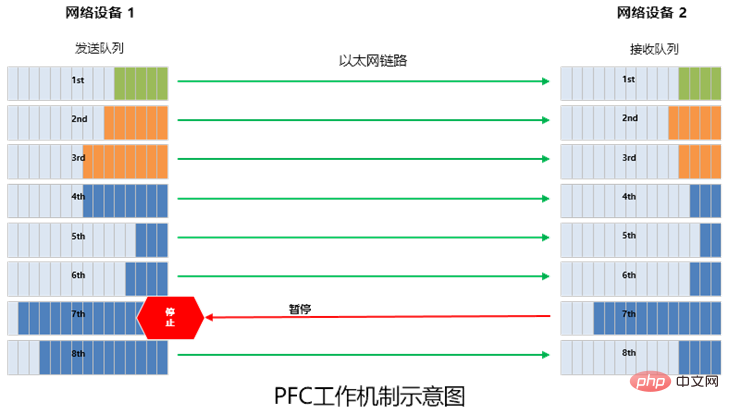

Diese Lösung verfügt über zwei wichtige Matching-Technologien, nämlich PFC (Priority Flow Control, prioritätsbasierte Flusskontrolle) und ECN (Explicit Congestion Notification, explizite Überlastung). Benachrichtigung). Hierbei handelt es sich um Technologien, die entwickelt wurden, um eine Überlastung der Verbindung zu vermeiden. Wenn sie jedoch häufig ausgelöst werden, führt dies dazu, dass der Absender den Versand unterbricht oder verlangsamt, wodurch die Kommunikationsbandbreite verringert wird. (Sie werden auch weiter unten erwähnt) #

Einige ausländische Internetunternehmen hoffen, modulare Switches (DNX-Chip + VOQ-Technologie) zu verwenden, um den Anforderungen beim Aufbau leistungsstarker Netzwerke gerecht zu werden.

- DNX: eine Chipserie von broadcom

VOQ: Virtual Output Queue, virtuelle Ausgabewarteschlange#🎜🎜 ##🎜 🎜#

Diese Lösung scheint machbar, steht aber auch vor den folgenden Herausforderungen.

Zuallererst sind die Erweiterungsmöglichkeiten modularer Switches durchschnittlich. Die Größe des Gehäuses begrenzt die maximale Anzahl von Ports. Wenn Sie einen größeren Cluster aufbauen möchten, müssen Sie ihn horizontal über mehrere Gehäuse erweitern.

Zweitens verbraucht die Ausstattung modularer Schalter viel Strom. Im Gehäuse befinden sich zahlreiche Linecard-Chips, Fabric-Chips, Lüfter usw. Der Stromverbrauch eines einzelnen Geräts beträgt mehr als 20.000 Watt, einige sogar mehr als 30.000 Watt zu hoch.

Drittens verfügt ein einzelnes Gerät eines modularen Switches über eine große Anzahl von Ports und eine große Fehlerdomäne.

Aus den oben genannten Gründen eignen sich modulare Switch-Geräte nur für den Einsatz von KI-Computing-Clustern in kleinem Maßstab.

Die oben genannten sind alle traditionelle Lösungen. Da diese traditionellen Lösungen nicht funktionieren, müssen wir natürlich neue Wege finden.

Also erschien eine brandneue Lösung namens DDC.

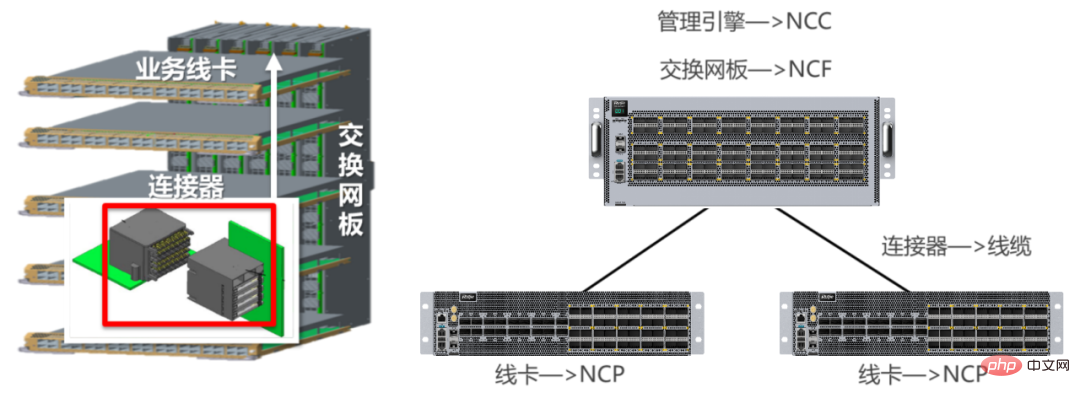

Rahmenausrüstung, allgemein unterteilt in Es besteht aus zwei Teilen: der Schaltnetzplatine (Backplane) und der Service Line Card (Board Card), die über Steckverbinder miteinander verbunden sind.

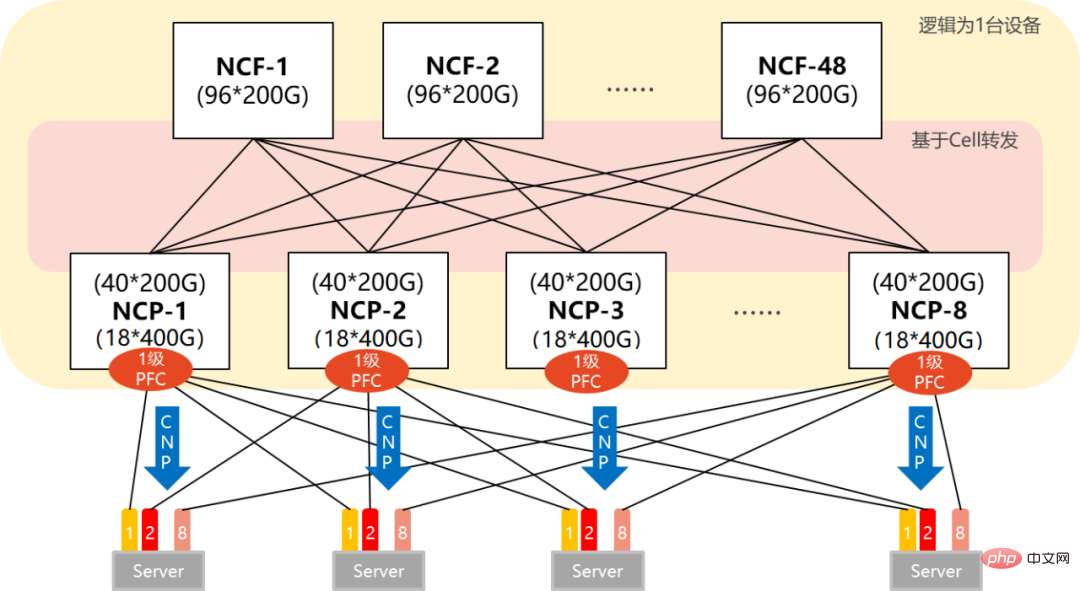

Die DDC-Lösung verwandelt die Switching-Netzwerkkarte in ein NCF-Gerät und die Business-Line-Karte in ein NCP-Gerät. Aus Steckverbindern werden optische Fasern. Auch die Managementfunktion modularer Geräte wird in der DDC-Architektur zum NCC.

NCF: Network Cloud Fabric (Netzwerk-Cloud-Management-Steuerungsebene)

NCC: Network Cloud Controller (Network Cloud Controller)

DDC wechselt von zentral zu verteilt Danach Die Skalierbarkeit wurde erheblich verbessert. Es kann die Netzwerkskala flexibel entsprechend der Größe des KI-Clusters gestalten.

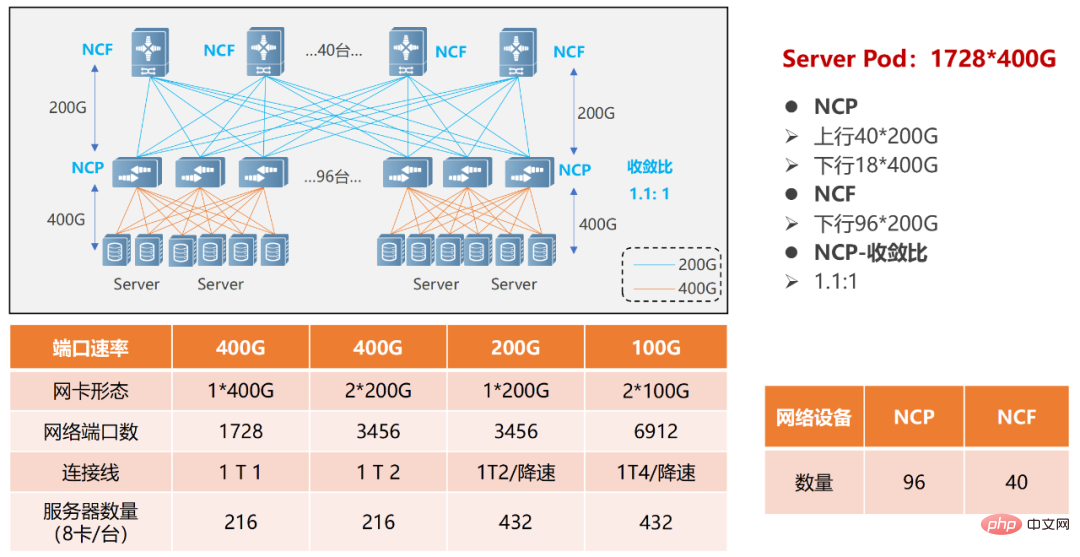

Lassen Sie uns zwei Beispiele nennen (Einzel-POD-Vernetzung und Multi-POD-Vernetzung).

Einzelne POD-Vernetzung

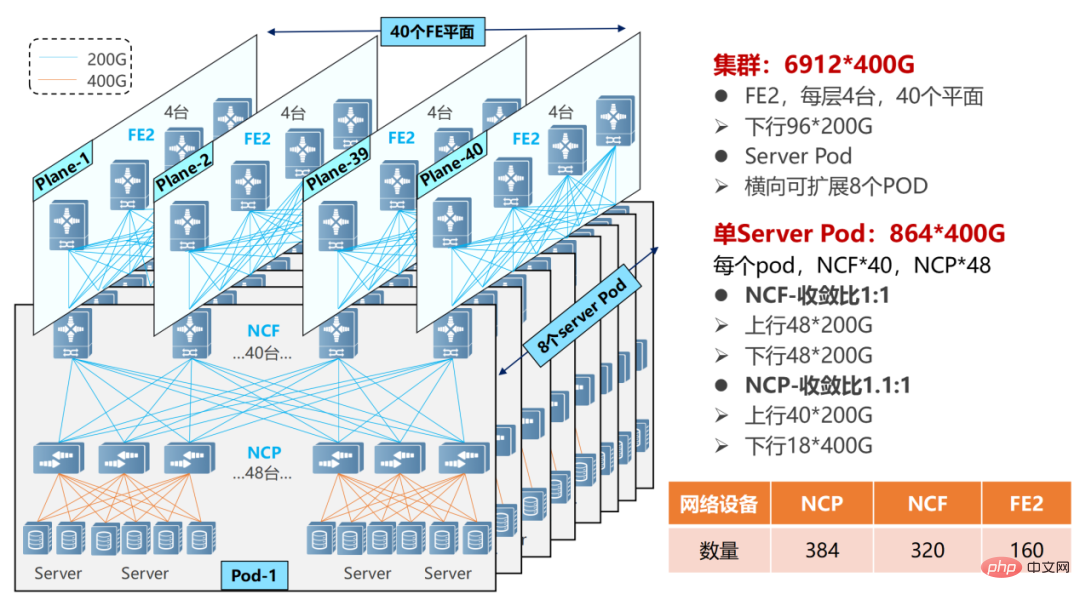

Mehrstufige POD-Vernetzung, der Umfang kann größer werden.

In einem POD-Netzwerk mit mehreren Ebenen muss das NCF-Gerät die Hälfte der SerDes opfern, um eine Verbindung zum NCF der zweiten Ebene herzustellen. Daher nutzt ein einzelner POD derzeit 48 NCPs für den Zugriff, mit insgesamt 18 400G-Schnittstellen im Downlink.

Mehrere POD-Vernetzung

Ein einzelner POD kann 864 400G-Schnittstellen (48×18) unterstützen. Durch horizontales Hinzufügen von PODs (8) kann die Skalierung erweitert werden und das Gesamtsystem kann maximal 6912 400G-Netzwerkports (864×8) unterstützen.

NCP verfügt über 40 200G-Uplinks und stellt eine Verbindung zu 40 NCFs im POD her. Das NCF im POD verwendet 48 200G-Schnittstellen, und die 48 200G-Schnittstellen sind vor dem NCF der zweiten Ebene in eine Gruppe von 12 unterteilt. Die NCF der zweiten Ebene verwendet 40 Ebenen (Ebene), jede Ebene verfügt über 4 NCF-Ps, was 40 NCFs im POD entspricht.

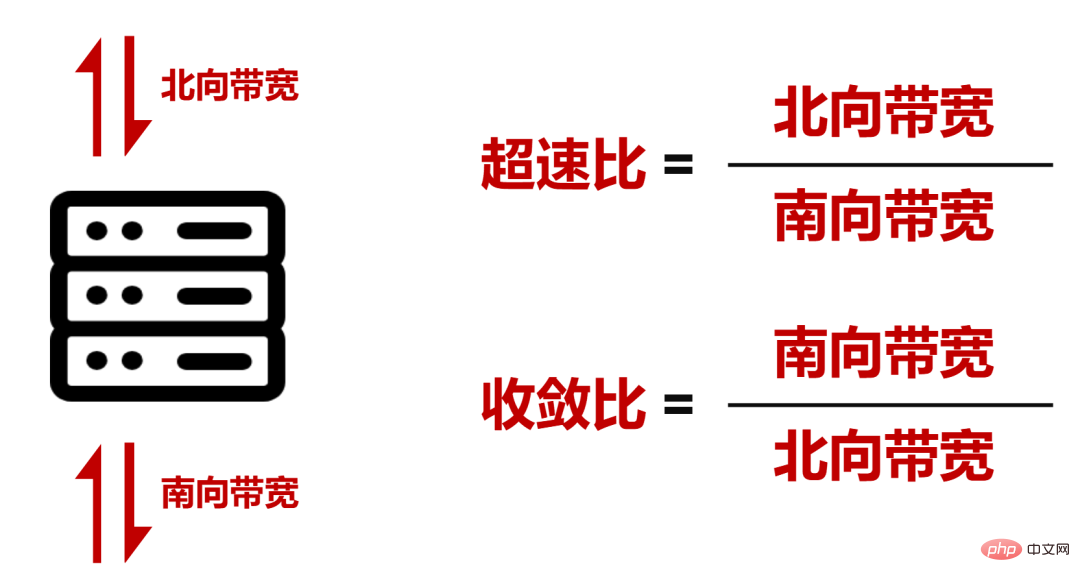

Es wurde ein Übergeschwindigkeitsverhältnis von 1,1:1 (die Bandbreite in Richtung Norden ist größer als die Bandbreite in Richtung Süden) innerhalb des POD des gesamten Netzwerks erreicht, während zwischen dem POD und ein Konvergenzverhältnis von 1:1 (Bandbreite in Richtung Süden/Bandbreite in Richtung Norden) erreicht wurde die sekundäre NCF-Bandbreite).

...

Der Netzwerkbetriebsprozess ist jedoch komplex, und DDC muss sich auch in Bezug auf Verzögerungsresistenz, Lastausgleich und Verwaltungseffizienz verbessern.

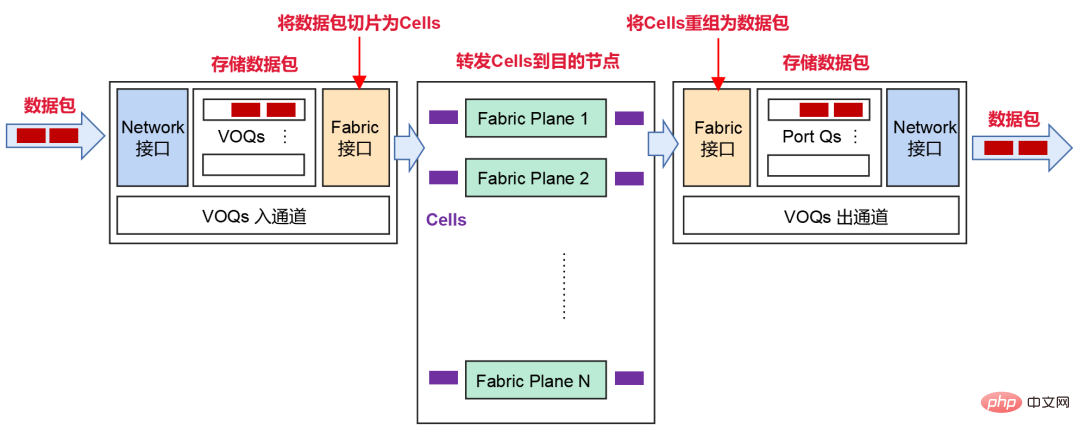

Basierend auf dem VOQ+Cell-Weiterleitungsmechanismus zur Bekämpfung von Paketverlusten

Nachdem der Absender das Datenpaket vom Netzwerk erhalten hat, wird es zur Speicherung in VOQ (Virtual Output Queue) eingeordnet.

Bevor ein Datenpaket gesendet wird, sendet NCP zunächst eine Gutschriftsnachricht, um festzustellen, ob der Empfänger über genügend Pufferspeicher verfügt, um diese Nachrichten zu verarbeiten.

Wenn das Empfangsende in Ordnung ist, wird das Paket in Zellen (kleine Abschnitte des Pakets) fragmentiert und die Last dynamisch auf den Zwischen-Fabric-Knoten (NCF) verteilt.

Abfragemechanismus

Dieser Mechanismus nutzt den Cache vollständig aus und kann Paketverluste erheblich reduzieren oder sogar Paketverluste verursachen. Die Neuübertragung von Daten wird reduziert und die Kommunikationsverzögerung insgesamt ist stabiler und geringer, was die Bandbreitennutzung und damit die Effizienz des Geschäftsdurchsatzes verbessern kann.

- PFC-Single-Hop-Bereitstellung zur Vermeidung von Deadlocks

Wie bereits erwähnt, wird im verlustfreien RDMA-Netzwerk die PFC-Technologie (priority-based flow control) zur Flusskontrolle eingeführt.

Einfach ausgedrückt besteht PFC darin, 8 virtuelle Kanäle auf einer Ethernet-Verbindung zu erstellen und jedem virtuellen Kanal eine entsprechende Priorität zuzuweisen, sodass jeder der virtuellen Kanäle unabhängig angehalten und neu gestartet werden kann, während dies für andere virtuelle Kanäle möglich ist Der Verkehr im Kanal verläuft ohne Unterbrechung.

PFC kann eine warteschlangenbasierte Flusskontrolle implementieren, weist jedoch auch ein Problem auf, nämlich einen Deadlock.

Der sogenannte Deadlock ist ein „Stillstand“, der durch eine Überlastung mehrerer Switches aufgrund von Schleifen und anderen Gründen verursacht wird (der Cache-Verbrauch jedes Ports überschreitet den Schwellenwert), und alle warten auf die Freigabe durch die andere Partei Ressourcen“ (Verkehr zu allen Switches wird dauerhaft blockiert).

Mit der DDC-Vernetzung gibt es kein Deadlock-Problem von PFC. Denn aus Sicht des gesamten Netzwerks können alle NCPs und NCFs als ein Gerät betrachtet werden. Für den AI-Server ist der gesamte DDC nur ein Schalter und es gibt keine mehrstufigen Schalter. Daher gibt es keinen Deadlock.

Darüber hinaus kann gemäß dem Datenweiterleitungsmechanismus von DDC ECN (Explicit Congestion Notification) an der Schnittstelle eingesetzt werden.

Sobald das Netzwerkgerät unter dem ECN-Mechanismus eine Überlastung im RoCE v2-Verkehr erkennt (der interne Kredit- und Cache-Mechanismus kann Burst-Verkehr nicht unterstützen), sendet es CNP (Congestion Notification Packets, Überlastungsbenachrichtigungsnachrichten) an den Server. ), was eine Geschwindigkeitsreduzierung erfordert.

- Verteiltes Betriebssystem, Verbesserung der Zuverlässigkeit

Schließlich schauen wir uns die Management-Kontrollebene an.

Wir haben bereits erwähnt, dass in der DDC-Architektur die Verwaltungsfunktion modularer Geräte zum NCC (Network Cloud Controller) wird. NCC ist sehr wichtig. Wenn eine Einzelpunktmethode verwendet wird, führt ein Fehler zum Ausfall des gesamten Netzwerks.

Um solche Probleme zu vermeiden, kann DDC die zentralisierte Steuerungsebene von NCC aufheben und ein verteiltes Betriebssystem (Betriebssystem) erstellen.

Basierend auf einem verteilten Betriebssystem kann es Geräte über Standardschnittstellen (Netconf, GRPC usw.) basierend auf einem SDN-Betriebs- und Wartungscontroller konfigurieren und verwalten. In diesem Fall werden alle NCPs und NCFs unabhängig verwaltet und verfügen über unabhängige Steuerungs- und Verwaltungsebenen, was die Zuverlässigkeit des Systems erheblich verbessert und die Bereitstellung erleichtert.

█ Der kommerzielle Fortschritt von DDC

Zusammenfassend lässt sich sagen, dass DDC im Vergleich zu herkömmlichen Netzwerken erhebliche Vorteile hinsichtlich Netzwerkgröße, Erweiterungsmöglichkeiten, Zuverlässigkeit, Kosten und Bereitstellungsgeschwindigkeit aufweist. Es ist das Produkt von Netzwerktechnologie-Upgrades und bietet eine Idee zur Untergrabung der ursprünglichen Netzwerkarchitektur, wodurch die Entkopplung der Netzwerkhardware, die Vereinheitlichung der Netzwerkarchitektur und die Erweiterung der Weiterleitungskapazität realisiert werden können.

Die Branche hat die OpenMPI-Testsuite verwendet, um vergleichende Simulationstests zwischen Rahmengeräten und herkömmlichen Netzwerkgeräten durchzuführen. Die Schlussfolgerung des Tests lautet: Im All-to-All-Szenario wird die Bandbreitennutzung von Frame-Geräten im Vergleich zu herkömmlichen Netzwerken um etwa 20 % erhöht (entsprechend einer Steigerung der GPU-Auslastung um etwa 8 %).

Gerade aufgrund der erheblichen Leistungsvorteile von DDC ist diese Technologie inzwischen zur wichtigsten Entwicklungsrichtung der Branche geworden. Ruijie Networks übernahm beispielsweise die Führung bei der Einführung zweier lieferbarer DDC-Produkte, nämlich des 400G-NCP-Switches RG-S6930-18QC40F1 und des 200G-NCF-Switches RG-X56-96F1. Der RG-S6930-18QC40F1-Switch ist 2U hoch und bietet 18 400G-Panel-Ports, 40 200G Fabric-Inline-Ports, 4 Lüfter und 2 Netzteile.

Der RG-X56-96F1-Switch ist 4U hoch und bietet 96 200G Fabric-Inline-Ports, 8 Lüfter und 4 Netzteile.

Es wird berichtet, dass Ruijie Networks weiterhin Produkte in Form von 400G-Ports entwickeln und auf den Markt bringen wird.

█Abschlussworte

Der Aufstieg von AIGC hat eine neue Runde technologischer Revolution in der Internetbranche eingeleitet.

Wir sehen, dass sich immer mehr Unternehmen diesem Weg anschließen und am Wettbewerb teilnehmen. Dies bedeutet, dass Upgrades der Netzwerkinfrastruktur dringend erforderlich sind.

Das Aufkommen von DDC wird die Fähigkeiten der Netzwerkinfrastruktur erheblich verbessern. Es wird nicht nur effektiv auf die Herausforderungen reagieren, die die KI-Revolution für die Netzwerkinfrastruktur mit sich bringt, sondern auch die digitale Transformation der gesamten Gesellschaft unterstützen den Beginn des Zeitalters der digitalen Intelligenz für die Menschheit beschleunigen.

Das obige ist der detaillierte Inhalt vonWas sind die Merkmale eines Netzwerks, das für den Antrieb von AIGC geeignet ist?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

![WLAN-Erweiterungsmodul ist gestoppt [Fix]](https://img.php.cn/upload/article/000/465/014/170832352052603.gif?x-oss-process=image/resize,m_fill,h_207,w_330) WLAN-Erweiterungsmodul ist gestoppt [Fix]

Feb 19, 2024 pm 02:18 PM

WLAN-Erweiterungsmodul ist gestoppt [Fix]

Feb 19, 2024 pm 02:18 PM

Wenn es ein Problem mit dem WLAN-Erweiterungsmodul Ihres Windows-Computers gibt, kann dies dazu führen, dass Sie nicht mehr mit dem Internet verbunden sind. Diese Situation ist oft frustrierend, aber glücklicherweise enthält dieser Artikel einige einfache Vorschläge, die Ihnen helfen können, dieses Problem zu lösen und Ihre drahtlose Verbindung wieder ordnungsgemäß funktionieren zu lassen. Behebung, dass das WLAN-Erweiterbarkeitsmodul nicht mehr funktioniert Wenn das WLAN-Erweiterbarkeitsmodul auf Ihrem Windows-Computer nicht mehr funktioniert, befolgen Sie diese Vorschläge, um das Problem zu beheben: Führen Sie die Netzwerk- und Internet-Fehlerbehebung aus, um drahtlose Netzwerkverbindungen zu deaktivieren und wieder zu aktivieren. Starten Sie den WLAN-Autokonfigurationsdienst neu. Ändern Sie die Energieoptionen. Ändern Erweiterte Energieeinstellungen Netzwerkadaptertreiber neu installieren Einige Netzwerkbefehle ausführen Schauen wir uns das nun im Detail an

So beheben Sie einen Win11-DNS-Serverfehler

Jan 10, 2024 pm 09:02 PM

So beheben Sie einen Win11-DNS-Serverfehler

Jan 10, 2024 pm 09:02 PM

Um auf das Internet zuzugreifen, müssen wir beim Herstellen einer Verbindung zum Internet das richtige DNS verwenden. Wenn wir die falschen DNS-Einstellungen verwenden, wird auf die gleiche Weise ein DNS-Serverfehler angezeigt. Zu diesem Zeitpunkt können wir versuchen, das Problem zu lösen, indem wir in den Netzwerkeinstellungen auswählen, ob DNS automatisch abgerufen werden soll Lösungen. So beheben Sie den Win11-Netzwerk-DNS-Serverfehler. Methode 1: DNS zurücksetzen 1. Klicken Sie zunächst in der Taskleiste auf „Start“, suchen Sie die Symbolschaltfläche „Einstellungen“ und klicken Sie darauf. 2. Klicken Sie dann in der linken Spalte auf den Optionsbefehl „Netzwerk & Internet“. 3. Suchen Sie dann rechts die Option „Ethernet“ und klicken Sie zur Eingabe. 4. Klicken Sie anschließend in der DNS-Serverzuweisung auf „Bearbeiten“ und stellen Sie schließlich DNS auf „Automatisch (D.)“ ein

Beheben Sie „fehlgeschlagene Netzwerkfehler'-Downloads auf Chrome, Google Drive und Fotos!

Oct 27, 2023 pm 11:13 PM

Beheben Sie „fehlgeschlagene Netzwerkfehler'-Downloads auf Chrome, Google Drive und Fotos!

Oct 27, 2023 pm 11:13 PM

Was ist das Problem „Download aufgrund eines Netzwerkfehlers fehlgeschlagen“? Bevor wir uns mit den Lösungen befassen, wollen wir zunächst verstehen, was das Problem „Netzwerkfehler-Download fehlgeschlagen“ bedeutet. Dieser Fehler tritt normalerweise auf, wenn die Netzwerkverbindung während des Downloads unterbrochen wird. Dies kann verschiedene Gründe haben, wie z. B. eine schwache Internetverbindung, Netzwerküberlastung oder Serverprobleme. Wenn dieser Fehler auftritt, wird der Download gestoppt und eine Fehlermeldung angezeigt. Wie kann ein fehlgeschlagener Download mit Netzwerkfehler behoben werden? Die Meldung „Netzwerkfehler beim Herunterladen fehlgeschlagen“ kann beim Zugriff auf oder beim Herunterladen erforderlicher Dateien zu einem Hindernis werden. Unabhängig davon, ob Sie Browser wie Chrome oder Plattformen wie Google Drive und Google Fotos verwenden, wird dieser Fehler auftreten und Unannehmlichkeiten verursachen. Nachfolgend finden Sie Punkte, die Ihnen bei der Navigation und Lösung dieses Problems helfen sollen

Fix: WD My Cloud wird unter Windows 11 nicht im Netzwerk angezeigt

Oct 02, 2023 pm 11:21 PM

Fix: WD My Cloud wird unter Windows 11 nicht im Netzwerk angezeigt

Oct 02, 2023 pm 11:21 PM

Wenn WDMyCloud unter Windows 11 nicht im Netzwerk angezeigt wird, kann dies ein großes Problem sein, insbesondere wenn Sie Backups oder andere wichtige Dateien darin speichern. Dies kann ein großes Problem für Benutzer sein, die häufig auf Netzwerkspeicher zugreifen müssen. In der heutigen Anleitung zeigen wir Ihnen daher, wie Sie dieses Problem dauerhaft beheben können. Warum wird WDMyCloud nicht im Windows 11-Netzwerk angezeigt? Ihr MyCloud-Gerät, Ihr Netzwerkadapter oder Ihre Internetverbindung sind nicht richtig konfiguriert. Die SMB-Funktion ist nicht auf dem Computer installiert. Dieses Problem kann manchmal durch einen vorübergehenden Fehler in Winsock verursacht werden. Was soll ich tun, wenn meine Cloud nicht im Netzwerk angezeigt wird? Bevor wir mit der Behebung des Problems beginnen, können Sie einige Vorprüfungen durchführen:

Was soll ich tun, wenn die Erde in der unteren rechten Ecke von Windows 10 angezeigt wird, wenn ich nicht auf das Internet zugreifen kann? Verschiedene Lösungen für das Problem, dass die Erde in Win10 nicht auf das Internet zugreifen kann

Feb 29, 2024 am 09:52 AM

Was soll ich tun, wenn die Erde in der unteren rechten Ecke von Windows 10 angezeigt wird, wenn ich nicht auf das Internet zugreifen kann? Verschiedene Lösungen für das Problem, dass die Erde in Win10 nicht auf das Internet zugreifen kann

Feb 29, 2024 am 09:52 AM

In diesem Artikel wird die Lösung für das Problem vorgestellt, dass das Globussymbol im Win10-Systemnetzwerk angezeigt wird, aber nicht auf das Internet zugreifen kann. Der Artikel enthält detaillierte Schritte, die den Lesern helfen sollen, das Problem des Win10-Netzwerks zu lösen, das zeigt, dass die Erde keinen Zugriff auf das Internet hat. Methode 1: Direkt neu starten. Überprüfen Sie zunächst, ob das Netzwerkkabel nicht richtig eingesteckt ist und ob das Breitband im Rückstand ist. In diesem Fall müssen Sie den Router oder das optische Modem neu starten. Wenn auf dem Computer keine wichtigen Dinge erledigt werden, können Sie den Computer direkt neu starten. Die meisten kleineren Probleme können durch einen Neustart des Computers schnell behoben werden. Wenn festgestellt wird, dass die Breitbandanbindung nicht im Rückstand ist und das Netzwerk normal ist, ist das eine andere Sache. Methode 2: 1. Drücken Sie die [Win]-Taste oder klicken Sie auf [Startmenü] in der unteren linken Ecke. Klicken Sie im sich öffnenden Menüelement auf das Zahnradsymbol über dem Netzschalter.

Das Videogenerierungsartefakt PixVerse, das Charaktere vereint und Szenen verändert, wurde von Internetnutzern gespielt und seine überragende Konsistenz ist zu einem „Killerzug' geworden.

Apr 01, 2024 pm 02:11 PM

Das Videogenerierungsartefakt PixVerse, das Charaktere vereint und Szenen verändert, wurde von Internetnutzern gespielt und seine überragende Konsistenz ist zu einem „Killerzug' geworden.

Apr 01, 2024 pm 02:11 PM

Ein weiterer Doppelklick ist das Debüt einer neuen Funktion. Wollten Sie schon immer den Hintergrund einer Figur in einem Bild ändern, aber die KI erzeugt immer den Effekt „Das Objekt ist weder die Person noch das Objekt“. Selbst in ausgereiften Generierungstools wie Midjourney und DALL・E sind einige Prompt-Fähigkeiten erforderlich, um die Charakterkonsistenz aufrechtzuerhalten. Andernfalls ändern sich die Charaktere und Sie erzielen nicht die gewünschten Ergebnisse. Diesmal ist es jedoch Ihre Chance. Die neue „Character-Video“-Funktion des AIGC-Tools PixVerse kann Ihnen dabei helfen. Darüber hinaus können dynamische Videos generiert werden, um Ihre Charaktere lebendiger zu machen. Geben Sie ein Bild ein und Sie erhalten die entsprechenden dynamischen Videoergebnisse. Auf der Grundlage der Beibehaltung der Konsistenz der Charaktere ermöglichen die reichhaltigen Hintergrundelemente und die Charakterdynamik die generierten Ergebnisse

Fix: Netzwerkverbindungsproblem, das den Zugriff auf das Internet im abgesicherten Modus von Windows 11 verhindert

Sep 23, 2023 pm 01:13 PM

Fix: Netzwerkverbindungsproblem, das den Zugriff auf das Internet im abgesicherten Modus von Windows 11 verhindert

Sep 23, 2023 pm 01:13 PM

Im abgesicherten Modus mit Netzwerkbetrieb keine Internetverbindung auf Ihrem Windows 11-Computer zu haben, kann frustrierend sein, insbesondere bei der Diagnose und Behebung von Systemproblemen. In diesem Leitfaden besprechen wir die möglichen Ursachen des Problems und listen wirksame Lösungen auf, um sicherzustellen, dass Sie im abgesicherten Modus auf das Internet zugreifen können. Warum gibt es im abgesicherten Modus mit Netzwerk kein Internet? Der Netzwerkadapter ist inkompatibel oder wird nicht richtig geladen. Firewalls, Sicherheitssoftware oder Antivirensoftware von Drittanbietern können Netzwerkverbindungen im abgesicherten Modus stören. Der Netzwerkdienst wird nicht ausgeführt. Malware-Infektion Was soll ich tun, wenn das Internet im abgesicherten Modus unter Windows 11 nicht genutzt werden kann? Bevor Sie erweiterte Fehlerbehebungsschritte durchführen, sollten Sie die folgenden Prüfungen in Betracht ziehen: Stellen Sie sicher, dass Sie Folgendes verwenden

Überprüfen Sie die Netzwerkverbindung: lol kann keine Verbindung zum Server herstellen

Feb 19, 2024 pm 12:10 PM

Überprüfen Sie die Netzwerkverbindung: lol kann keine Verbindung zum Server herstellen

Feb 19, 2024 pm 12:10 PM

LOL kann keine Verbindung zum Server herstellen. Bitte überprüfen Sie das Netzwerk. In den letzten Jahren sind Online-Spiele für viele Menschen zu einer täglichen Unterhaltungsaktivität geworden. Unter ihnen ist League of Legends (LOL) ein sehr beliebtes Multiplayer-Onlinespiel, das die Teilnahme und das Interesse von Hunderten Millionen Spielern auf sich zieht. Wenn wir jedoch LOL spielen, stoßen wir manchmal auf die Fehlermeldung „Verbindung zum Server nicht möglich, bitte überprüfen Sie das Netzwerk“, was den Spielern zweifellos einige Probleme bereitet. Als nächstes werden wir die Ursachen und Lösungen dieses Fehlers besprechen. Zunächst besteht möglicherweise das Problem, dass LOL keine Verbindung zum Server herstellen kann