Fünf vielversprechende KI-Modelle für die Bildübersetzung

Bild-zu-Bild-Übersetzung

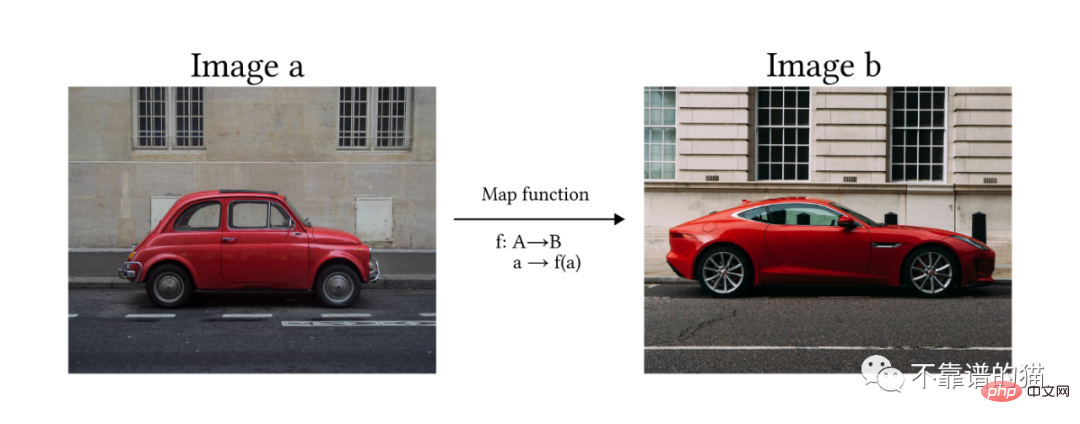

Gemäß der Definition von Solanki, Nayyar und Naved im Artikel ist die Bild-zu-Bild-Übersetzung der Prozess der Konvertierung eines Bildes von einer Domäne in eine Ein weiteres Ziel besteht darin, die Zuordnung zwischen Eingabebildern und Ausgabebildern zu lernen.

Mit anderen Worten, wir hoffen, dass das Modell ein Bild a in ein anderes Bild b umwandeln kann, indem es die Zuordnungsfunktion f lernt.

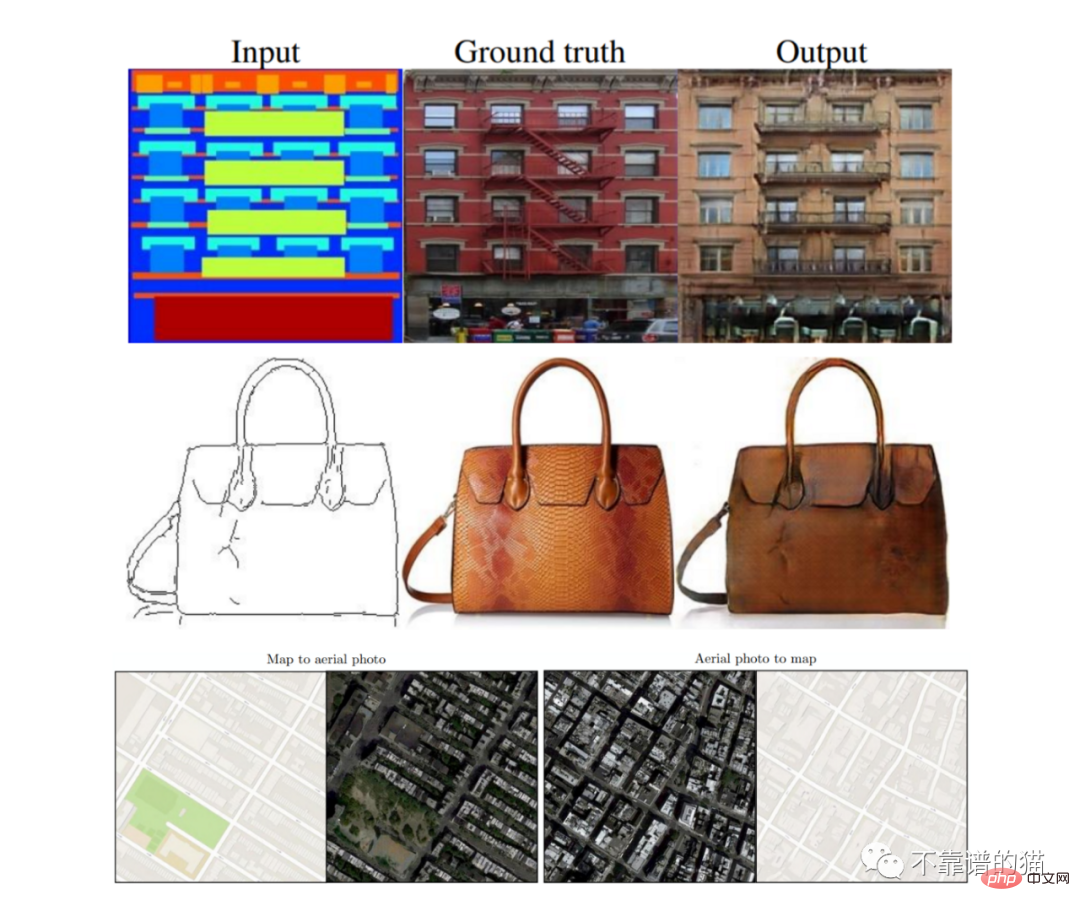

Jemand fragt sich vielleicht, welchen Nutzen diese Modelle haben und welche Relevanz sie in der Welt der künstlichen Intelligenz haben. Es gibt in der Regel viele Anwendungen, und sie beschränken sich nicht nur auf Kunst oder Grafikdesign. Beispielsweise ist die Möglichkeit, ein Bild aufzunehmen und es in ein anderes Bild umzuwandeln, um synthetische Daten (z. B. ein segmentiertes Bild) zu erstellen, für das Training selbstfahrender Automodelle sehr nützlich. Eine weitere getestete Anwendung ist das Kartendesign, bei dem das Modell beide Transformationen durchführen kann (Satellitenansicht in Karte und umgekehrt). Image-Flip-Transformationen können auch auf die Architektur angewendet werden, wobei Modelle Empfehlungen zum Abschließen unvollendeter Projekte geben.

Eine der überzeugendsten Anwendungen der Bildkonvertierung besteht darin, eine einfache Zeichnung in eine wunderschöne Landschaft oder ein Gemälde umzuwandeln.

5 Die vielversprechendsten KI-Modelle für die Bildübersetzung

In den letzten Jahren wurden mehrere Methoden entwickelt, um das Problem der Bildübersetzung durch die Nutzung generativer Modelle zu lösen . Die am häufigsten verwendeten Methoden basieren auf der folgenden Architektur: Generative Adversarial Network (GAN) #Diffusion Model (DVAE)

- Transformers

- Pix2Pix

- Pix2Pix ist ein Modell, das auf bedingtem GAN basiert. Das bedeutet, dass seine Architektur aus einem Generatornetzwerk (G) und einem Diskriminator (D) besteht. Beide Netzwerke werden in einem kontradiktorischen Spiel trainiert, bei dem Gs Ziel darin besteht, neue Bilder zu generieren, die dem Datensatz ähneln, und D entscheiden muss, ob das Bild generiert wird (gefälscht) oder aus dem Datensatz stammt (wahr).

- Die Hauptunterschiede zwischen Pix2Pix und anderen GAN-Modellen sind: (1) Der erste Generator verwendet ein Bild als Eingabe, um den Generierungsprozess zu starten, während normales GAN zufälliges Rauschen verwendet. (2) Pix2Pix ist ein vollständig überwachtes Modell, was bedeutet, dass der Datensatz aus Bildpaaren aus zwei Domänen besteht.

U-Net : besteht aus zwei Modulen (Downsampling und Upsampling). Das Eingabebild wird mithilfe von Faltungsschichten auf eine Reihe kleinerer Bilder (sogenannte Feature-Maps) reduziert, die dann über transponierte Faltungen hochgesampelt werden, bis die ursprünglichen Eingabeabmessungen erreicht sind. Es gibt Sprungverbindungen zwischen Downsampling und Upsampling.

Patch-Diskriminator: Faltungsnetzwerk, seine Ausgabe ist eine Matrix, wobei jedes Element das Bewertungsergebnis eines Teils (Patches) des Bildes ist. Es umfasst den L1-Abstand zwischen dem generierten und dem realen Bild, um sicherzustellen, dass der Generator lernt, anhand des Eingabebilds die richtige Funktion abzubilden. Wird auch Markov genannt, da es auf der Annahme beruht, dass Pixel aus verschiedenen Patches unabhängig sind.

- Pix2Pix-Ergebnisse

- Unüberwachte Bild-zu-Bild-Übersetzung (EINHEIT)

Das Modell geht zunächst davon aus, dass zwei Domänen (A und B) einen gemeinsamen latenten Raum (Z) teilen. Intuitiv können wir uns diesen latenten Raum als eine Zwischenstufe zwischen den Bildbereichen A und B vorstellen. Wenn wir also das Beispiel „Malen-zu-Bild“ verwenden, können wir denselben latenten Raum nutzen, um ein Gemäldebild rückwärts zu erzeugen oder um ein atemberaubendes Bild vorwärts zu sehen (siehe Abbildung X).

Das Modell geht zunächst davon aus, dass zwei Domänen (A und B) einen gemeinsamen latenten Raum (Z) teilen. Intuitiv können wir uns diesen latenten Raum als eine Zwischenstufe zwischen den Bildbereichen A und B vorstellen. Wenn wir also das Beispiel „Malen-zu-Bild“ verwenden, können wir denselben latenten Raum nutzen, um ein Gemäldebild rückwärts zu erzeugen oder um ein atemberaubendes Bild vorwärts zu sehen (siehe Abbildung X).

In der Abbildung: (a) gemeinsamer latenter Raum. (b) UNIT-Architektur: G2-Generator, D1-, D2-Diskriminator. Gestrichelte Linien stellen gemeinsame Schichten zwischen Netzwerken dar.

UNIT-Modell wird unter einem Paar VAE-GAN-Architekturen (siehe oben) entwickelt, wobei die letzte Schicht des Encoders (E1, E2) und die erste Schicht des Generators (G1, G2) ist geteilt.

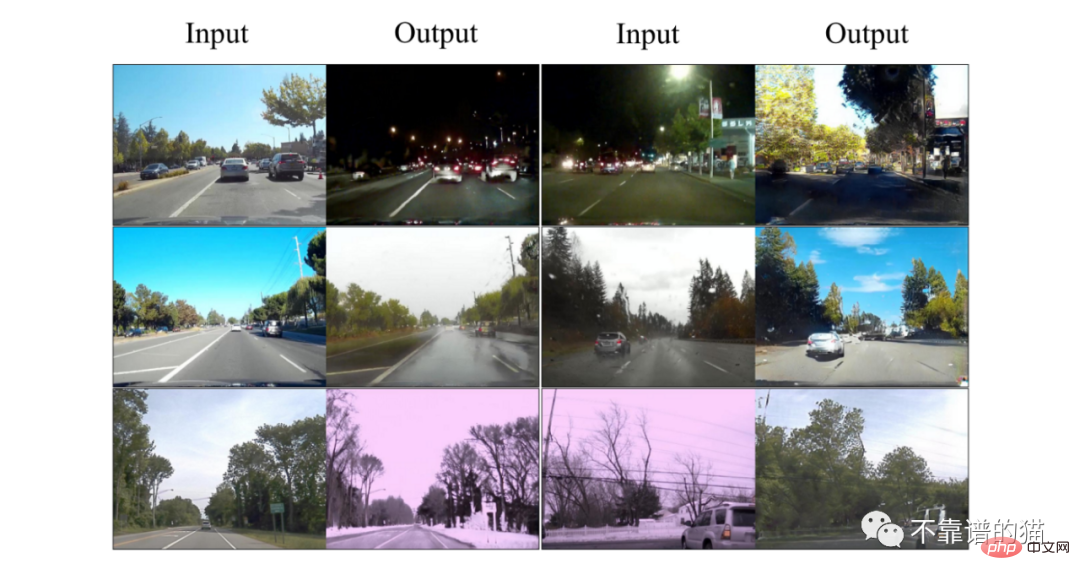

UNIT-ErgebnissePalettePalette ist ein bedingtes Diffusionsmodell, das von Google Research entwickelt wurde Gruppe in Kanada. Das Modell ist darauf trainiert, vier verschiedene Aufgaben im Zusammenhang mit der Bildkonvertierung auszuführen, was zu qualitativ hochwertigen Ergebnissen führt: (i) Kolorierung: Hinzufügen von Farbe zu Graustufenbildern

(i) Kolorierung: Hinzufügen von Farbe zu Graustufenbildern

In dem Artikel untersuchen die Autoren den Unterschied zwischen einem allgemeinen Multitasking-Modell und mehreren spezialisierten Modellen, die beide für eine Million Iterationen trainiert wurden. Die Architektur des Modells basiert auf dem klassenbedingten U-Net-Modell von Dhariwal und Nichol 2021 und verwendet eine Stapelgröße von 1024 Bildern für 1 Mio. Trainingsschritte. Lärmpläne als Hyperparameter vorverarbeiten und abstimmen, unterschiedliche Pläne für Training und Vorhersage verwenden.

Palette-Ergebnisse

Vision Transformers (ViT)

Bitte beachten Sie, dass die folgenden beiden Modelle zwar nicht speziell für die Bildtransformation entwickelt wurden, aber einen Fortschritt darstellen, leistungsstarke Modelle wie Transformer in den Bereich der Computer Vision zu bringen . Ein offensichtlicher Schritt wurde getan.

Vision Transformers (ViT) ist eine Modifikation der Transformers-Architektur (Vaswani et al., 2017) und wurde für die Bildklassifizierung entwickelt. Das Modell verwendet Bilder als Eingabe und gibt die Wahrscheinlichkeit der Zugehörigkeit zu jeder definierten Klasse aus.

Das Hauptproblem besteht darin, dass Transformer so konzipiert sind, dass sie eindimensionale Sequenzen als Eingabe verwenden, keine zweidimensionalen Matrizen. Zum Sortieren empfehlen die Autoren, das Bild in kleine Teile aufzuteilen und sich das Bild als Sequenz (oder Satz im NLP) und die Teile als Token (oder Wörter) vorzustellen.

Um es kurz zusammenzufassen: Wir können den gesamten Prozess in drei Phasen unterteilen:

1) Einbetten: Kleine Teile teilen und glätten → lineare Transformation anwenden → Klassen-Tag hinzufügen (dieses Tag dient als Bildzusammenfassung, die bei der Klassifizierung berücksichtigt wird) →Positionseinbettung

2) Transformer-Encoder-Block: Platzieren Sie die eingebetteten Patches in einer Reihe von Transformer-Encoder-Blöcken. Der Aufmerksamkeitsmechanismus lernt, auf welche Teile des Bildes er sich konzentrieren soll.

3) Klassifizierungs-MLP-Header: Leiten Sie die Klassentoken durch den MLP-Header, der die endgültige Wahrscheinlichkeit ausgibt, dass das Bild zu jeder Klasse gehört.

Vorteile der Nutzung von ViT: Die Regelung bleibt unverändert. Im Vergleich zu CNN wird Transformer nicht durch die Übersetzung (Änderung der Position von Elementen) im Bild beeinflusst.

Nachteile: Für das Training ist eine große Menge an beschrifteten Daten erforderlich (mindestens 14 Millionen Bilder).

TransGAN

TransGAN ist ein transformbasiertes GAN-Modell, das für die Bilderzeugung ohne Verwendung von Faltungsschichten entwickelt wurde. Stattdessen bestehen der Generator und der Diskriminator aus einer Reihe von Transformatoren, die durch Upsampling- und Downsampling-Blöcke verbunden sind.

Der Vorwärtsdurchlauf des Generators nimmt ein 1D-Array zufälliger Rauschproben und leitet sie durch den MLP. Intuitiv können wir uns das Array als Satz und die Pixelwerte als Wörter vorstellen (beachten Sie, dass ein Array mit 64 Elementen in ein 8✕8-Bild mit einem Kanal umgeformt werden kann. Als nächstes wendet der Autor eine Reihe von Transformatoren an). Blöcke, auf die jeweils eine Upsampling-Ebene folgt, die die Größe des Arrays (Bildes) verdoppelt.

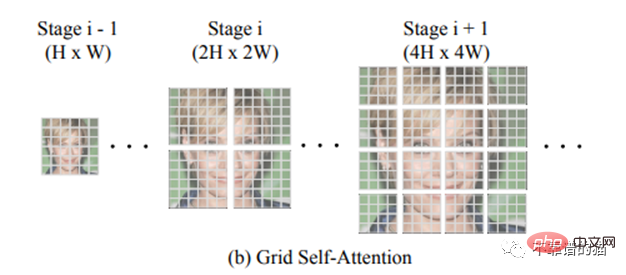

Ein Schlüsselmerkmal von TransGAN ist die Grid-Selbstaufmerksamkeit. Bei hochdimensionalen Bildern (d. h. sehr langen Arrays 32✕32 = 1024) kann die Anwendung des Transformators zu explosiven Kosten des Selbstaufmerksamkeitsmechanismus führen, da Sie jedes Pixel des 1024-Arrays mit allen 255 möglichen Pixeln vergleichen müssen ( RGB-Dimension). Anstatt also die Korrespondenz zwischen einem bestimmten Token und allen anderen Token zu berechnen, unterteilt die Gitter-Selbstaufmerksamkeit die volldimensionale Feature-Map in mehrere nicht überlappende Gitter und berechnet die Token-Interaktionen in jedem lokalen Gitter.

Die Diskriminatorarchitektur ist dem zuvor zitierten ViT sehr ähnlich.

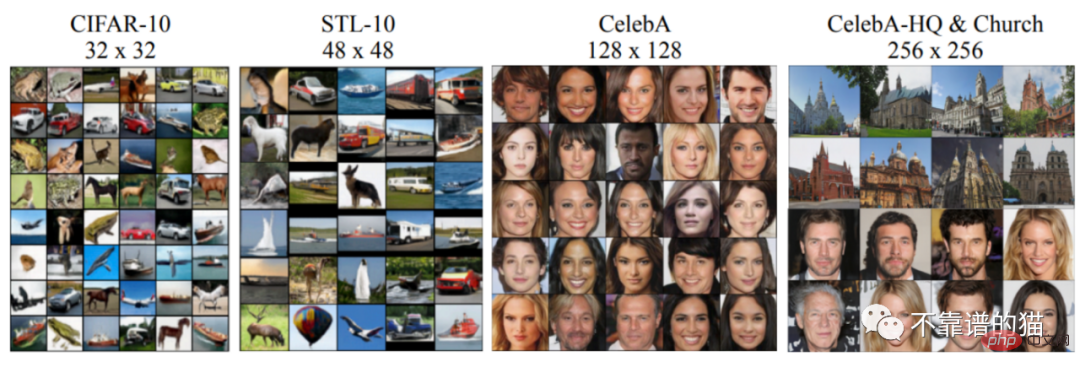

TransGAN-Ergebnisse für verschiedene Datensätze

Das obige ist der detaillierte Inhalt vonFünf vielversprechende KI-Modelle für die Bildübersetzung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Verbessern Sie die Produktivität, Effizienz und Genauigkeit der Entwickler, indem Sie eine abrufgestützte Generierung und ein semantisches Gedächtnis in KI-Codierungsassistenten integrieren. Übersetzt aus EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, Autor JanakiramMSV. Obwohl grundlegende KI-Programmierassistenten natürlich hilfreich sind, können sie oft nicht die relevantesten und korrektesten Codevorschläge liefern, da sie auf einem allgemeinen Verständnis der Softwaresprache und den gängigsten Mustern beim Schreiben von Software basieren. Der von diesen Coding-Assistenten generierte Code eignet sich zur Lösung der von ihnen zu lösenden Probleme, entspricht jedoch häufig nicht den Coding-Standards, -Konventionen und -Stilen der einzelnen Teams. Dabei entstehen häufig Vorschläge, die geändert oder verfeinert werden müssen, damit der Code in die Anwendung übernommen wird

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Sieben coole technische Interviewfragen für GenAI und LLM

Jun 07, 2024 am 10:06 AM

Um mehr über AIGC zu erfahren, besuchen Sie bitte: 51CTOAI.x Community https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou unterscheidet sich von der traditionellen Fragendatenbank, die überall im Internet zu sehen ist erfordert einen Blick über den Tellerrand hinaus. Large Language Models (LLMs) gewinnen in den Bereichen Datenwissenschaft, generative künstliche Intelligenz (GenAI) und künstliche Intelligenz zunehmend an Bedeutung. Diese komplexen Algorithmen verbessern die menschlichen Fähigkeiten, treiben Effizienz und Innovation in vielen Branchen voran und werden zum Schlüssel für Unternehmen, um wettbewerbsfähig zu bleiben. LLM hat ein breites Anwendungsspektrum und kann in Bereichen wie der Verarbeitung natürlicher Sprache, der Textgenerierung, der Spracherkennung und Empfehlungssystemen eingesetzt werden. Durch das Lernen aus großen Datenmengen ist LLM in der Lage, Text zu generieren

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Maschinelles Lernen ist ein wichtiger Zweig der künstlichen Intelligenz, der Computern die Möglichkeit gibt, aus Daten zu lernen und ihre Fähigkeiten zu verbessern, ohne explizit programmiert zu werden. Maschinelles Lernen hat ein breites Anwendungsspektrum in verschiedenen Bereichen, von der Bilderkennung und der Verarbeitung natürlicher Sprache bis hin zu Empfehlungssystemen und Betrugserkennung, und es verändert unsere Lebensweise. Im Bereich des maschinellen Lernens gibt es viele verschiedene Methoden und Theorien, von denen die fünf einflussreichsten Methoden als „Fünf Schulen des maschinellen Lernens“ bezeichnet werden. Die fünf Hauptschulen sind die symbolische Schule, die konnektionistische Schule, die evolutionäre Schule, die Bayes'sche Schule und die Analogieschule. 1. Der Symbolismus, auch Symbolismus genannt, betont die Verwendung von Symbolen zum logischen Denken und zum Ausdruck von Wissen. Diese Denkrichtung glaubt, dass Lernen ein Prozess der umgekehrten Schlussfolgerung durch das Vorhandene ist

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

SK Hynix wird am 6. August neue KI-bezogene Produkte vorstellen: 12-Layer-HBM3E, 321-High-NAND usw.

Aug 01, 2024 pm 09:40 PM

SK Hynix wird am 6. August neue KI-bezogene Produkte vorstellen: 12-Layer-HBM3E, 321-High-NAND usw.

Aug 01, 2024 pm 09:40 PM

Laut Nachrichten dieser Website vom 1. August hat SK Hynix heute (1. August) einen Blogbeitrag veröffentlicht, in dem es ankündigt, dass es am Global Semiconductor Memory Summit FMS2024 teilnehmen wird, der vom 6. bis 8. August in Santa Clara, Kalifornien, USA, stattfindet viele neue Technologien Generation Produkt. Einführung des Future Memory and Storage Summit (FutureMemoryandStorage), früher Flash Memory Summit (FlashMemorySummit), hauptsächlich für NAND-Anbieter, im Zusammenhang mit der zunehmenden Aufmerksamkeit für die Technologie der künstlichen Intelligenz wurde dieses Jahr in Future Memory and Storage Summit (FutureMemoryandStorage) umbenannt Laden Sie DRAM- und Speicheranbieter und viele weitere Akteure ein. Neues Produkt SK Hynix wurde letztes Jahr auf den Markt gebracht

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

Herausgeber |. KX Im Bereich der Arzneimittelforschung und -entwicklung ist die genaue und effektive Vorhersage der Bindungsaffinität von Proteinen und Liganden für das Arzneimittelscreening und die Arzneimitteloptimierung von entscheidender Bedeutung. Aktuelle Studien berücksichtigen jedoch nicht die wichtige Rolle molekularer Oberflächeninformationen bei Protein-Ligand-Wechselwirkungen. Auf dieser Grundlage schlugen Forscher der Universität Xiamen ein neuartiges Framework zur multimodalen Merkmalsextraktion (MFE) vor, das erstmals Informationen über Proteinoberfläche, 3D-Struktur und -Sequenz kombiniert und einen Kreuzaufmerksamkeitsmechanismus verwendet, um verschiedene Modalitäten zu vergleichen Ausrichtung. Experimentelle Ergebnisse zeigen, dass diese Methode bei der Vorhersage von Protein-Ligand-Bindungsaffinitäten Spitzenleistungen erbringt. Darüber hinaus belegen Ablationsstudien die Wirksamkeit und Notwendigkeit der Proteinoberflächeninformation und der multimodalen Merkmalsausrichtung innerhalb dieses Rahmens. Verwandte Forschungen beginnen mit „S