Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

„Aufruf zur Innovation: UCL Wang Jun diskutiert die Theorie und Anwendungsaussichten der allgemeinen künstlichen Intelligenz von ChatGPT'

„Aufruf zur Innovation: UCL Wang Jun diskutiert die Theorie und Anwendungsaussichten der allgemeinen künstlichen Intelligenz von ChatGPT'

„Aufruf zur Innovation: UCL Wang Jun diskutiert die Theorie und Anwendungsaussichten der allgemeinen künstlichen Intelligenz von ChatGPT'

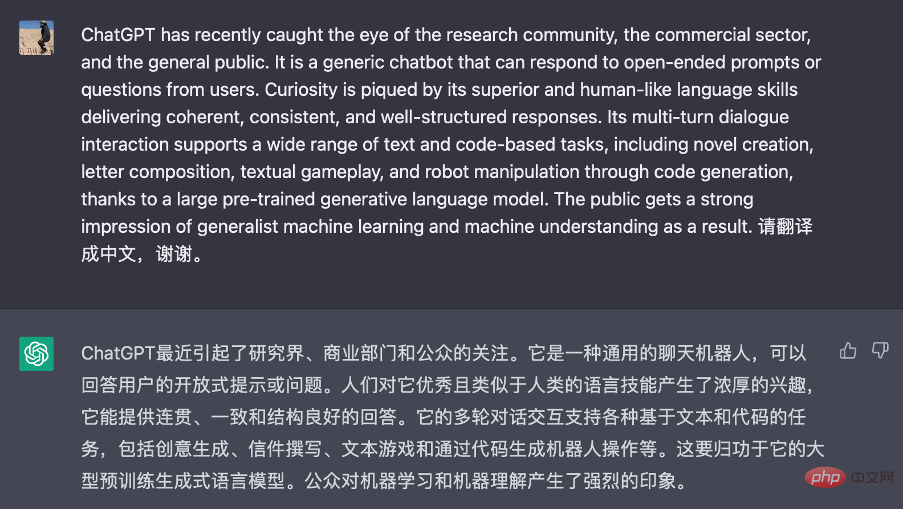

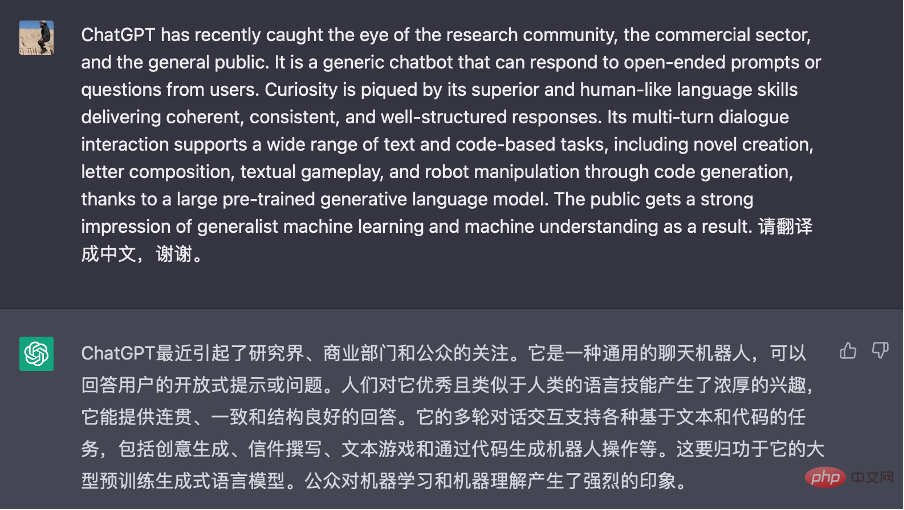

*Dieser Artikel wurde ursprünglich auf Englisch verfasst, Die chinesische Übersetzung wurde von ChatGPT erstellt und wird so dargestellt, wie sie ist, mit einigen zur Korrektur markierten Unklarheiten (rote und gelbe Teile). Das englische Manuskript finden Sie im Anhang. Der Autor stellte fest, dass die Unzulänglichkeiten der ChatGPT-Übersetzung häufig auf den Mangel an flüssigem Ausdruck im englischen Originalmanuskript zurückzuführen sind. Interessierte Leser sollten es entsprechend lesen.

ChatGPT hat in letzter Zeit die Aufmerksamkeit der Forschungsgemeinschaft, der Geschäftswelt und der breiten Öffentlichkeit auf sich gezogen. Es handelt sich um einen allgemeinen Chatbot, der offene Eingabeaufforderungen oder Fragen von Benutzern beantworten kann. Es machte neugierig auf seine bemerkenswerten, menschenähnlichen Sprachkenntnisse, die es ihm ermöglichen, zusammenhängende, konsistente und gut strukturierte Antworten zu geben. Dank eines großen vorab trainierten generativen Sprachmodells unterstützen seine mehrstufigen Konversationsinteraktionen eine Vielzahl text- und codebasierter Aufgaben, darunter die Erstellung von Romanen, Wortspiele und sogar Robotermanipulation durch Codegenerierung. Dies lässt die Öffentlichkeit glauben, dass allgemeines maschinelles Lernen und maschinelles Verständnis bald erreichbar sein werden.

Wenn man tiefer gräbt, kann man feststellen, dass beim Hinzufügen von Programmiercode als Trainingsdaten bestimmte Argumentationsfähigkeiten, ein gesundes Menschenverstandsverständnis und sogar Gedankenketten (eine Reihe von Zwischenschritten des Denkens) entstehen können, wenn das Modell einen bestimmten Wert erreicht Skala. Obwohl diese neue Entdeckung aufregend ist und neue Möglichkeiten für die Forschung und Anwendung künstlicher Intelligenz eröffnet, wirft sie mehr Fragen auf, als sie löst. Könnten diese „aufkommenden“ Fähigkeiten beispielsweise als Frühindikatoren für fortgeschrittene Intelligenz dienen, oder handelt es sich einfach nur um naive Nachahmungen menschlichen Verhaltens? Könnte die weitere Ausweitung bereits umfangreicher Modelle zur Schaffung einer künstlichen allgemeinen Intelligenz (AGI) führen, oder handelt es sich bei diesen Modellen nur vordergründig um KI mit begrenzten Fähigkeiten? Wenn diese Fragen beantwortet werden, könnten sie zu grundlegenden Veränderungen in der Theorie und Anwendung der künstlichen Intelligenz führen. Daher fordern wir dringend, nicht nur den Erfolg von ChatGPT zu wiederholen, sondern, was noch wichtiger ist, bahnbrechende Forschung und neue Anwendungsentwicklung in den folgenden Bereichen der künstlichen Intelligenz voranzutreiben (dies ist keine vollständige Liste):

1 . Neue Theorie des maschinellen Lernens, jenseits von

auf Aufgabe basierend auf spezifisch Das etablierte Paradigma des maschinellen Lernens Induktives Denken ist eine Art des Denkens, bei dem wir auf der Grundlage früherer Beobachtungen Schlussfolgerungen über die Welt ziehen. Maschinelles Lernen kann grob als induktives Denken betrachtet werden, da es vergangene (Trainings-)Daten nutzt, um die Leistung bei neuen Aufgaben zu verbessern. Am Beispiel der maschinellen Übersetzung umfasst ein typischer maschineller Lernprozess die folgenden vier Hauptschritte:

Müssen englische Sätze ins Chinesische übersetzen: E → C,

2. Sammeln Sie Daten, z. B. Satzpaare {E → C},

3. Trainieren Sie ein Modell, z. B. ein tiefes neuronales Netzwerk, indem Sie Eingabe {E} und Ausgabe {C} verwenden,4 Modellieren Sie unbekannte Datenpunkte. Geben Sie beispielsweise einen neuen englischen Satz E' ein, geben Sie die chinesische Übersetzung C' aus und bewerten Sie das Ergebnis.

Wie oben gezeigt, isoliert traditionelles maschinelles Lernen das Training jeder spezifischen Aufgabe. Daher muss der Prozess für jede neue Aufgabe zurückgesetzt und von Schritt 1 bis Schritt 4 erneut ausgeführt werden, wobei alle erworbenen Kenntnisse (Daten, Modelle usw.) aus vorherigen Aufgaben verloren gehen. Wenn Sie beispielsweise Französisch ins Chinesische übersetzen möchten, benötigen Sie ein anderes Modell.

Unter diesem Paradigma konzentriert sich die Arbeit von Theoretikern des maschinellen Lernens auf das Verständnis der Fähigkeit eines Lernmodells, von Trainingsdaten auf unsichtbare Testdaten zu verallgemeinern. Eine häufige Frage ist beispielsweise, wie viele Stichproben im Training benötigt werden, um eine bestimmte Fehlergrenze bei der Vorhersage unsichtbarer Testdaten zu erreichen. Wir wissen, dass induktive Bias Bias (d. h. Vorkenntnisse oder A-priori-Annahmen) notwendig sind, damit ein Lernmodell seine nicht aufgetretenen Ergebnisse vorhersagen kann. Dies liegt daran, dass der Ausgabewert in der unbekannten Situation völlig willkürlich ist und es unmöglich ist, das Problem zu lösen, ohne bestimmte Annahmen zu treffen. Das berühmte No-Free-Lunch-Theorem verdeutlicht außerdem, dass jede induktive Verzerrung nur bei bestimmten Problemstellungen funktioniert und an anderer Stelle scheitern kann, wenn das angenommene A-priori-Wissen falsch ist.

Abbildung 1 Screenshot von ChatGPT für maschinelle Übersetzung. Benutzeraufforderungen enthalten nur Anweisungen, es sind keine Demonstrationsbeispiele erforderlich.

Während die obige Theorie immer noch gilt, hat das Aufkommen grundlegender Sprachmodelle möglicherweise unsere Herangehensweise an maschinelles Lernen verändert. Der neue maschinelle Lernprozess kann wie folgt aussehen (am Beispiel des maschinellen Übersetzungsproblems, siehe Abbildung 1):

1.API greift auf grundlegende Sprachmodelle zu, die von anderen trainiert wurden, z. B. auf Schulungen für verschiedene Dokumente, einschließlich gepaarter Englisch/Chinesisch Korpora-Modell.

2. Entwerfen Sie eine geeignete Textbeschreibung (Eingabeaufforderung genannt) für die jeweilige Aufgabe, basierend auf wenigen oder keinen Beispielen, z. B. Eingabeaufforderung = {einige Beispiele E ➔ C}. 3. Bedingt durch die Eingabeaufforderung und neue Testdatenpunkte generiert das Sprachmodell eine Antwort, indem es beispielsweise E‘ an die Eingabeaufforderung anhängt und C‘ aus dem Modell generiert.

4. Interpretieren Sie die Antwort als vorhergesagtes Ergebnis.

Wie in Schritt 1 gezeigt, dient das grundlegende Sprachmodell als

universelleone-size-fits-all Wissensdatenbank. Mithilfe der in Schritt 2 bereitgestellten Hinweise und des Kontexts kann das Basissprachmodell anhand einer kleinen Anzahl von Demonstrationsbeispielen angepasst werden, um ein bestimmtes Ziel oder Problem zu lösen. Während die obige Pipeline in erster Linie auf textbasierte Probleme beschränkt ist, kann man davon ausgehen, dass sie mit der Weiterentwicklung vorab trainierter Basismodelle über verschiedene Modalitäten hinweg (siehe Abschnitt 3) zum Standard für maschinelles Lernen wird. Dies könnte notwendige Missionshürden abbauen und den Weg für „Künstliche Allgemeine Intelligenz“ (AGI) ebnen. Es ist jedoch noch im Anfangsstadium herauszufinden, wie die Demo-Beispiele im Hinweistext funktionieren werden. Aus früheren Arbeiten wissen wir nun, dass das Format des Demo-Beispiels wichtiger ist als die Richtigkeit der Beschriftungen (z. B. müssen wir, wie in Abbildung 1 gezeigt, keine übersetzten Beispiele bereitstellen, , sondern nur

). Die Sprachbeschreibung muss bereitgestellt werden), aber gibt es theoretische Grenzen für seine Anpassungsfähigkeit, wie im „No Free Lunch“-Theorem dargelegt? Kann das Wissen über den Kontext und die in den Eingabeaufforderungen genannten Gebote für die zukünftige Verwendung in das Modell integriert werden? Diese Fragen werden gerade erst erforscht. Daher fordern wir ein neues Verständnis und neue Prinzipien dieser neuen Form des kontextuellen Lernens und ihrer theoretischen Grenzen und Eigenschaften, beispielsweise die Untersuchung, wo die Grenzen der Generalisierung liegen.

2. Verbessern Sie Ihr Denkvermögen

Wir stehen am Rande einer aufregenden Ära, in der alle unsere Sprach- und Verhaltensdaten für das Training ausgewertet (und in riesige Computermodelle integriert) werden können. Dies ist eine große Errungenschaft, da unsere gesamte kollektive Erfahrung und Zivilisation zur späteren Nutzung in einer (versteckten) Wissensbasis (in Form künstlicher neuronaler Netze) zusammengefasst werden kann. Tatsächlich geht man davon aus, dass ChatGPT und das große Basismodell eine gewisse Denkfähigkeit und möglicherweise sogar ein gewisses Verständnis für den Geisteszustand anderer aufweisen (Theory of Mind). Dies wird durch Datenanpassung (maskierte Sprachtoken-Vorhersagen als Trainingssignale) und Nachahmung (menschliches Verhalten) erreicht. Ob diese vollständig datengesteuerte Strategie jedoch zu mehr Intelligenz führen wird, ist fraglich.

Um diesen Punkt zu veranschaulichen, nehmen Sie das Beispiel, wie man einem Agenten (Agent) beibringt, wie man Schach spielt. Selbst wenn der Agent (Agent) Zugriff auf eine unbegrenzte Menge menschlicher Schachspieldaten hätte, wäre es sehr schwierig, eine neue Strategie zu generieren, die besser als die vorhandenen Daten ist, indem man einfach die bestehende Strategie nachahmt. Mithilfe dieser Daten kann man jedoch ein Verständnis für die Welt aufbauen (z. B. die Regeln eines Spiels) und sie zum „Denken“ verwenden (einen Simulator in seinem Gehirn aufbauen, um Feedback zu sammeln, um bessere Strategien zu entwickeln). Dies unterstreicht die Bedeutung der induktiven Voreingenommenheit; anstatt einfach einen Brute-Force-Ansatz zu verwenden, muss der lernende Agent (Agent) über ein bestimmtes Modell der Welt verfügen, um sich selbst zu verbessern.

Daher ist es dringend erforderlich, die neuen Fähigkeiten der zugrunde liegenden Modelle eingehend zu untersuchen und zu verstehen. Zusätzlich zu den Sprachkenntnissen befürworten wir den Erwerb praktischer Denkfähigkeiten durch das Studium der zugrunde liegenden Mechanismen. Ein vielversprechender Ansatz besteht darin, sich von den Neuro- und Hirnwissenschaften inspirieren zu lassen, um die Mechanismen des menschlichen Denkens zu entschlüsseln und die Entwicklung von Sprachmodellen voranzutreiben. Gleichzeitig erfordert der Aufbau einer soliden Theorie des Geistes möglicherweise auch ein tiefes Verständnis des Multi-Agenten-Lernens und seiner zugrunde liegenden Prinzipien.

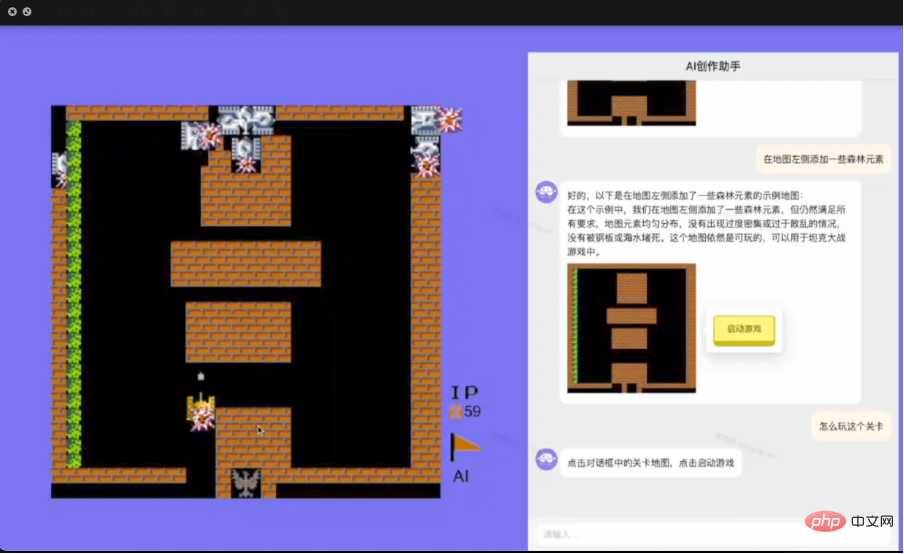

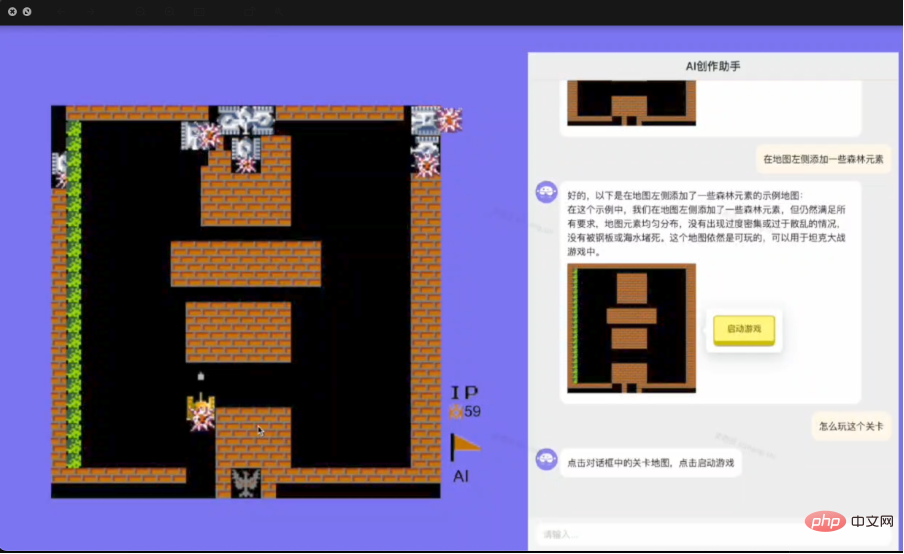

3. Von AI Generated Content (AIGC) zu AI Generated Action (AIGA)

Die von der menschlichen Sprache entwickelte implizite Semantik ist entscheidend für das grundlegende Sprachmodell. Wie man dies ausnutzen kann, ist ein Schlüsselthema im allgemeinen maschinellen Lernen. Sobald der semantische Raum beispielsweise mit anderen Medien (z. B. Fotos, Videos und Tönen) oder anderen Formen menschlicher und maschineller Verhaltensdaten (z. B. Flugbahnen/Aktionen von Robotern) in Einklang gebracht wird, können wir für sie jederzeit semantische Interpretationsmöglichkeiten erhalten zusätzliche Kosten. Auf diese Weise wird maschinelles Lernen (Vorhersage, Generierung und Entscheidungsfindung) allgemein und zerlegbar. Der Umgang mit der modalübergreifenden Ausrichtung stellt jedoch eine erhebliche Schwierigkeit dar, mit der wir konfrontiert sind, da das Kommentieren von Beziehungen arbeitsintensiv ist. Darüber hinaus wird die Abstimmung menschlicher Werte schwierig, wenn viele Interessengruppen im Konflikt stehen.

Ein grundlegender Nachteil von ChatGPT besteht darin, dass es nur direkt mit Menschen kommunizieren kann. Sobald jedoch eine ausreichende Ausrichtung an der Außenwelt hergestellt ist, sollte das zugrunde liegende Sprachmodell in der Lage sein, zu lernen, wie es mit einer Vielzahl von Akteuren und Umgebungen interagiert. Dies ist wichtig, da es seinen Denkfähigkeiten und der sprachbasierten Semantik umfassendere Anwendungen und Fähigkeiten verleiht, die über das bloße Führen einer Konversation hinausgehen. Beispielsweise könnte es zu einem universellen Agenten (Agent) entwickelt werden, der im Internet surfen, Computer steuern und Roboter manipulieren kann. Daher ist es umso wichtiger, Verfahren zu implementieren, die sicherstellen, dass die Antworten von Agenten (Agenten) (normalerweise in Form von generierten Aktionen) sicher, zuverlässig, unvoreingenommen und vertrauenswürdig sind.

Abbildung 2 zeigt ein Beispiel für die Interaktion von AIGA mit einer Spiel-Engine, um den Prozess der Entwicklung von Videospielen zu automatisieren.

4. Die Theorie der Multi-Agenten-Interaktion mit grundlegenden Sprachmodellen

ChatGPT nutzt kontextbezogenes Lernen und Prompt Engineering, um mehrere Gesprächsrunden mit Personen in einer einzigen Sitzung zu steuern, d Bei der Eingabeaufforderung werden die gesamten vorherigen Konversationen (Fragen und Antworten) als zusätzlicher Kontext zum Erstellen der Antwort an das System gesendet. Dies ist ein einfaches konversationsgesteuertes Markov-Entscheidungsprozess-Modell (MDP):

{Status = Kontext, Aktion = Antwort, Belohnung = Bewertung „Gefällt mir/Gefällt mir nicht“}.

Obwohl diese Strategie effektiv ist, hat sie die folgenden Nachteile: Erstens liefert die Eingabeaufforderung nur eine Beschreibung der Antwort des Benutzers, aber die wahre Absicht des Benutzers wird möglicherweise nicht explizit angegeben und muss abgeleitet werden. Vielleicht kann ein leistungsstarkes Modell wie der Partially Observable Markov Decision Process (POMDP), der zuvor für Konversations-Bots vorgeschlagen wurde, verborgene Benutzerabsichten genau modellieren.

Zweitens zielt ChatGPT zunächst auf die Generierung einer angepassten Sprache ab, wobei die Sprachanpassungsfähigkeit für das Training genutzt wird, und verwendet dann menschliche Bezeichnungen für das Training/die Feinabstimmung mit Konversationszielen. Aufgrund der Offenheit der Plattform stimmen die tatsächlichen Benutzerziele und -vorgaben möglicherweise nicht mit den Schulungs-/Feinabstimmungsprämien überein. Um die Gleichgewichte und Interessenkonflikte zwischen Menschen und Agenten (Agenten) zu untersuchen, könnte es sich lohnen, eine spieltheoretische Perspektive einzunehmen.

5. Neue Anwendungen

Wie ChatGPT gezeigt hat, glauben wir, dass das grundlegende Sprachmodell zwei einzigartige Eigenschaften aufweist, die die treibende Kraft für zukünftige maschinelles Lernen und grundlegende Sprachmodellanwendungen sein werden. Das erste sind seine überlegenen Sprachkenntnisse, während das zweite seine eingebetteten semantischen und frühen Denkfähigkeiten (in Form der menschlichen Sprache) sind. Ersteres wird als Schnittstelle die Eintrittsbarriere für die Anwendung von maschinellem Lernen erheblich verringern, während letzteres den Anwendungsbereich von maschinellem Lernen erheblich fördern wird.

Wie der in Teil 1 vorgestellte neue Lernprozess zeigt, beseitigen Eingabeaufforderungen und kontextbezogenes Lernen den Engpass beim Data Engineering und den Aufwand, der zum Erstellen und Trainieren von Modellen erforderlich ist. Darüber hinaus können wir durch die Nutzung von Denkfähigkeiten jede Teilaufgabe einer schwierigen Aufgabe automatisch aufschlüsseln und lösen. Daher wird es viele Branchen und Anwendungsbereiche erheblich verändern. In Internetunternehmen sind konversationsbasierte Schnittstellen offensichtliche Anwendungen für Web- und mobile Suche, Empfehlungssysteme und Werbung. Da wir jedoch an schlüsselwortbasierte URL-Inverted-Index-Suchsysteme gewöhnt sind, ist die Umstellung nicht einfach. Den Menschen muss beigebracht werden, längere Abfragen und natürliche Sprache als Abfragen zu verwenden. Darüber hinaus sind zugrunde liegende Sprachmodelle oft starr und unflexibel. Ihnen fehlen aktuelle Informationen über aktuelle Ereignisse. Sie beschwören oft Fakten herauf und bieten keine Abruf- und Überprüfungsmöglichkeiten. Daher benötigen wir ein sofortiges Basismodell, das sich im Laufe der Zeit dynamisch weiterentwickeln kann.

Daher fordern wir die Entwicklung neuer Anwendungen, unter anderem in den folgenden Bereichen:

-

Innovation

NeuheitSpitzentechnik, Prozess- und Softwareunterstützung. - Modellbasierte Websuche, Empfehlung und Anzeigengenerierung; ein neues Geschäftsmodell für Conversational Advertising.

- Technologie für konversationsbasierte IT-Dienste, Softwaresysteme, drahtlose Kommunikation (personalisierte Nachrichtensysteme) und Kundendienstsysteme.

- Generieren Sie Robotic Process Automation (RPA) sowie Softwaretests und -validierung aus zugrunde liegenden Sprachmodellen.

- KI-unterstützte Programmierung.

- Ein neues Tool zur Content-Generierung für die Kreativbranche.

-

Vereinheitlicht Sprachmodelle mit Operations Research

Operations Research, Enterprise Intelligence und Optimierung. - Eine Möglichkeit, große Basismodelle im Cloud Computing effizient und kostengünstig bereitzustellen.

-

Entwickeln Sie Grundmodelle für Reinforcement Learning, Multi-Agent Learning und andere künstliche Intelligenz

Entscheidungsfindung. - Sprachgestützte Robotik.

- Grundlegende Modelle und Inferenz für kombinatorische Optimierung, Electronic Design Automation (EDA) und Chipdesign.

Über den Autor

Wang Jun, Professor für Informatik am University College London (UCL), Mitbegründer und Dekan des Shanghai Digital Brain Institute, untersucht hauptsächlich Entscheidungsintelligenz und große modellbezogene Forschung, einschließlich maschinellem Lernen, verstärkendem Lernen und Multi- Agent, Data Mining, Computational Advertising, Empfehlungssysteme usw. Er hat mehr als 200 wissenschaftliche Arbeiten und zwei wissenschaftliche Monographien veröffentlicht, mehrere Auszeichnungen für die beste Arbeit gewonnen und das Team bei der Entwicklung des weltweit ersten Multi-Agenten-Entscheidungsmodells und des weltweit ersten multimodalen Entscheidungsmodells geleitet.

Anhang:

Aufruf zur Innovation: Post-ChatGPT-Theorien der künstlichen allgemeinen Intelligenz und ihre Anwendungen

ChatGPT hat kürzlich die Aufmerksamkeit der Forschungsgemeinschaft, des kommerziellen Sektors und der allgemeinen Öffentlichkeit auf sich gezogen Es handelt sich um einen generischen Chatbot, der auf offene Eingabeaufforderungen oder Fragen von Benutzern reagieren kann und durch seine überlegenen und menschenähnlichen Sprachkenntnisse kohärente, konsistente und gut strukturierte Antworten liefert Dank eines großen vorab trainierten generativen Sprachmodells gibt es ein breites Spektrum an text- und codebasierten Aufgaben, darunter Romanerstellung, Briefkomposition, Text-Gameplay und sogar Robotermanipulation Lernverständnis ist sehr bald erreichbar.

Wenn man tiefer gräbt, entdeckt man möglicherweise, dass bestimmte Denkfähigkeiten, das Verständnis des gesunden Menschenverstandes und sogar die Gedankenkette (eine Reihe von Zwischenschlüssen) beeinträchtigt werden, wenn man Programmiercode als Trainingsdaten hinzufügt Schritte) können als neue Fähigkeiten auftreten [1], wenn Modelle eine bestimmte Größe erreichen. Die neue Erkenntnis ist zwar aufregend und eröffnet neue Möglichkeiten für die KI-Forschung und -Anwendungen, sie wirft jedoch mehr Fragen auf, als sie löst. Dienen sie beispielsweise als früher Indikator für höhere Intelligenz, oder handelt es sich dabei lediglich um eine naive Nachahmung menschlichen Verhaltens, die durch Daten enorm verborgen wird? Würde die weitere Ausweitung bereits vorhandener Modelle zur Geburt der künstlichen allgemeinen Intelligenz (AGI) führen, oder handelt es sich bei diesen Modellen lediglich um eine bloße Nachahmung menschlichen Verhaltens? oberflächlich intelligent mit eingeschränkten Fähigkeiten? Wenn diese Fragen beantwortet werden, können sie zu grundlegenden Veränderungen in der Theorie und den Anwendungen der künstlichen Intelligenz führen die folgenden Bereiche der künstlichen Intelligenz (keine vollständige Liste):

1.Neue Theorie des maschinellen Lernens, die über das etablierte Paradigma des aufgabenspezifischen maschinellen Lernens hinausgeht

Induktives Denken ist eine Art des Denkens Dabei können wir Schlussfolgerungen über die Welt auf der Grundlage vergangener Beobachtungen ziehen, und zwar in dem Sinne, dass es vergangene (Trainings-)Daten nutzt, um die Leistung bei neuen Aufgaben zu verbessern Die Lernpipeline umfasst die folgenden vier Hauptschritte:

1.Definieren Sie das spezifische Problem, z. B. Übersetzen von englischen Sätzen ins Chinesische: E→C,

2. Sammeln Sie die Daten, z. B. Satzpaare { E→C } ,

3.Trainieren Sie ein Modell, z. B. ein tiefes neuronales Netzwerk mit Eingaben {E} und Ausgaben {C},

4. Wenden Sie das Modell auf einen unsichtbaren Datenpunkt an, z. B. geben Sie ein neues Englisch ein Satz E‘ und eine chinesische Übersetzung C‘ ausgeben und das Ergebnis auswerten.

Wie oben gezeigt, isoliert traditionelles maschinelles Lernen das Training für jede spezifische Aufgabe. Daher muss man für jede neue Aufgabe den Prozess ab Schritt zurücksetzen und wiederholen 1 bis Schritt 4, wobei alle erworbenen Kenntnisse (Daten, Modelle usw.) aus früheren Aufgaben verloren gehen. Beispielsweise benötigen Sie ein anderes Modell, wenn Sie Französisch ins Chinesische übersetzen möchten, anstatt vom Englischen ins Chinesische Unter diesem Paradigma konzentriert sich die Arbeit von Theoretikern des maschinellen Lernens hauptsächlich darauf, die Generalisierungsfähigkeit eines Lernmodells von den Trainingsdaten auf die unsichtbaren Testdaten zu verstehen [2, 3]. Eine häufige Frage wäre beispielsweise, wie viele Proben wir im Training benötigen, um eine bestimmte Fehlergrenze für die Vorhersage unsichtbarer Testdaten zu erreichen. Wir wissen, dass ein induktiver Bias (d. h. Vorwissen oder Vorannahmen) erforderlich ist, damit ein Lernmodell Ergebnisse vorhersagen kann, auf die es noch nicht gestoßen ist. Dies liegt daran, dass der Ausgabewert unter unbekannten Umständen völlig willkürlich ist und es daher unmöglich ist, das Problem anzugehen, ohne bestimmte Annahmen zu treffen. Das berühmte No-Free-Lunch-Theorem [5] besagt außerdem, dass jede induktive Voreingenommenheit eine Einschränkung hat; Es ist nur für eine bestimmte Gruppe von Problemen geeignet und kann an anderer Stelle scheitern, wenn das vorausgesetzte Vorwissen falsch ist.

Abbildung 1 Ein Screenshot von ChatGPT, das für die maschinelle Übersetzung verwendet wird. Die Eingabeaufforderung enthält nur Anweisungen und es ist kein Demonstrationsbeispiel erforderlich.

Während die oben genannten Theorien immer noch gelten, hat die Einführung von Foundation-Language-Modellen möglicherweise unseren Ansatz für maschinelles Lernen verändert. Die neue Pipeline für maschinelles Lernen könnte wie folgt aussehen (unter Verwendung desselben maschinellen Übersetzungsproblems als Beispiel; siehe Abbildung 1):

1.API-Zugriff auf ein Foundation-Sprachmodell, das an anderer Stelle von anderen trainiert wurde, z. B. ein Modell, das mit Diversity trainiert wurde Dokumente, einschließlich Paring-Korpus aus Englisch/Chinesisch,

2. Entwerfen Sie mit einigen oder gar keinem Beispiel eine geeignete Textbeschreibung (sogenannter Prompt) für die jeweilige Aufgabe, z. B. Prompt = {awen Beispiele E→C },

3. Abhängig von der Eingabeaufforderung und einem gegebenen neuen Testdatenpunkt generiert das Sprachmodell die Antwort, z. B. E' an die Eingabeaufforderung anhängen und C' aus dem Modell generieren,

4.Interpretieren Sie die Antwort als das vorhergesagte Ergebnis.

Wie in Schritt 1 gezeigt, dient das Foundation-Language-Modell als einheitlicher Wissensspeicher. Die in Schritt 2 vorgestellte Eingabeaufforderung (und der Kontext) ermöglichen die Anpassung des Foundation-Language-Modells an ein bestimmtes Ziel oder Problem mit nur wenigen Demonstrationsbeispielen. Während die oben genannte Pipeline in erster Linie auf textbasierte Probleme beschränkt ist, kann man davon ausgehen, dass sie im Zuge der weiteren Entwicklung vorab trainierter, modalitätsübergreifender (siehe Abschnitt 3) Grundlagenmodelle zum Standard für maschinelles Lernen im Allgemeinen werden wird. Dies könnte die notwendigen Aufgabenbarrieren abbauen und den Weg für AGI ebnen.

Aber es ist noch am Anfang, festzustellen, wie die Demonstrationsbeispiele in einem Aufforderungstext funktionieren. Empirisch wissen wir jetzt aus einigen frühen Arbeiten [2], dass das Format der Demonstrationsbeispiele wichtiger ist als die Richtigkeit der Beschriftungen (wie beispielsweise in Abbildung 1 dargestellt, müssen wir keine Beispielübersetzung bereitstellen, sind es aber). erforderlich, um Sprachunterricht zu erteilen), aber gibt es irgendwelche theoretischen Grenzen für seine Anpassungsfähigkeit, wie im No-Free-Lunch-Theorem dargelegt? Kann das in den Eingabeaufforderungen (Schritt 2) angegebene kontext- und anweisungsbasierte Wissen für die zukünftige Verwendung in das Modell integriert werden? Wir kratzen mit diesen Anfragen nur an der Oberfläche. Wir fordern daher ein neues Verständnis und neue Prinzipien hinter dieser neuen Form des kontextbezogenen Lernens und seinen theoretischen Einschränkungen und Eigenschaften, wie z. B. Generalisierungsgrenzen.

Abbildung 2 Eine Illustration von AIGA zum Entwerfen von Computerspielen.

2.Entwickeln von Denkfähigkeiten

Wir stehen am Rande einer aufregenden Ära, in der alle unsere Sprach- und Verhaltensdaten ausgewertet werden können, um ein riesiges computergestütztes Modell zu trainieren (und von diesem zu absorbieren). Es ist eine enorme Leistung, da unsere gesamte kollektive Erfahrung und Zivilisation in einer einzigen (verborgenen) Wissensbasis (in Form künstlicher neuronaler Netze) für die spätere Nutzung zusammengefasst werden könnte. Tatsächlich wird gesagt, dass ChatGPT- und Large-Foundation-Modelle eine gewisse Denkfähigkeit aufweisen. Sie könnten sogar bis zu einem gewissen Grad die mentalen Zustände anderer erfassen (Theory of Mind) [6]. Dies wird durch Datenanpassung (Vorhersage maskierter Sprachtokens als Trainingssignale) und Nachahmung (von menschlichem Verhalten) erreicht. Es ist jedoch fraglich, ob diese vollständig datengesteuerte Strategie uns mehr Intelligenz bringen wird.

Um diesen Gedanken zu veranschaulichen, können Sie beispielsweise einem Agenten beibringen, wie man Schach spielt. Selbst wenn der Agent Zugriff auf eine unbegrenzte Menge menschlicher Spieldaten hat, wird es für ihn sehr schwierig sein, durch bloße Nachahmung bestehender Richtlinien neue Richtlinien zu generieren, die optimaler sind als die bereits in den Daten vorhandenen. Mithilfe der Daten kann man jedoch ein Verständnis für die Welt entwickeln (z. B. die Spielregeln) und sie zum „Denken“ nutzen (in seinem Gehirn einen Simulator konstruieren, der Feedback sammelt, um optimalere Richtlinien zu erstellen). Dies unterstreicht die Bedeutung der induktiven Vorspannung; Anstelle einfacher roher Gewalt wird von einem lernenden Agenten erwartet, dass er über ein Modell der Welt verfügt und dieses aus den Daten ableitet, um sich selbst zu verbessern.

Daher besteht ein dringender Bedarf, die neuen Fähigkeiten von Stiftungsmodellen gründlich zu untersuchen und zu verstehen. Neben den Sprachkenntnissen befürworten wir die Erforschung des Erwerbs tatsächlicher Denkfähigkeit durch die Untersuchung der zugrunde liegenden Mechanismen [9]. Ein vielversprechender Ansatz wäre, sich von den Neuro- und Gehirnwissenschaften inspirieren zu lassen, um die Mechanismen des menschlichen Denkens zu entschlüsseln und die Entwicklung von Sprachmodellen voranzutreiben. Gleichzeitig erfordert der Aufbau einer soliden Theory of Mind möglicherweise auch fundierte Kenntnisse des Multiagentenlernens [10,11] und seiner zugrunde liegenden Prinzipien.

3.Von AI Generating Content (AIGC) zu AI Generating Action (AIGA)

#🎜 🎜#Die implizite Semantik, die auf der Grundlage menschlicher Sprachen entwickelt wurde, ist ein wesentlicher Bestandteil grundlegender Sprachmodelle. Wie man es nutzt, ist ein entscheidendes Thema für allgemeines maschinelles Lernen. Sobald der semantische Raum beispielsweise mit anderen Medien (z. B. Fotos, Videos und Tönen) oder anderen Formen von Daten aus menschlichen und maschinellen Verhaltensweisen, z. B. Flugbahnen/Aktionen von Robotern, in Einklang gebracht wird, erwerben wir für diese semantische Interpretationskapazitäten ohne zusätzliche Daten Kosten [7, 14]. Auf diese Weise wäre maschinelles Lernen (Vorhersage, Generierung und Entscheidungsfindung) generisch und zerlegbar. Dennoch stellt der Umgang mit der modalitätsübergreifenden Ausrichtung eine erhebliche Hürde für uns dar, da die Kennzeichnung der Beziehungen arbeitsintensiv ist. Darüber hinaus wird die Angleichung menschlicher Werte schwierig, wenn zahlreiche Parteien widersprüchliche Interessen haben.

Ein grundlegender Nachteil von ChatGPT besteht darin, dass es nur direkt mit Menschen kommunizieren kann. Sobald jedoch eine ausreichende Ausrichtung auf die Außenwelt hergestellt ist, sollten grundlegende Sprachmodelle in der Lage sein, zu lernen, wie sie mit verschiedenen Parteien und Umgebungen interagieren [7, 14]. Dies ist von Bedeutung, da es die sprachbasierte Argumentationsfähigkeit und Semantik für breitere Anwendungen und Fähigkeiten über die Konversation hinaus stärken wird. Beispielsweise könnte es sich zu einem generalistischen Agenten entwickeln, der im Internet navigieren [7], Computer steuern [13] und Roboter manipulieren kann [12]. Daher wird es immer wichtiger, Verfahren zu implementieren, die sicherstellen, dass die Antworten des Agenten (häufig in Form generierter Aktionen) sicher, zuverlässig, unvoreingenommen und vertrauenswürdig sind.

Abbildung 2 zeigt eine Demonstration von AIGA [7] für die Interaktion mit einer Spiel-Engine, um den Prozess der Entwicklung eines Videospiels zu automatisieren.

4.Multiagenten-Theorien der Interaktion mit Grundsprachmodellen

ChatGPT nutzt kontextbezogenes Lernen und Prompt Engineering, um den Multi-Turn-Dialog mit Personen in einer einzigen Sitzung voranzutreiben, d. h. bei gegebener Frage oder Aufforderung wird die gesamte vorherige Konversation (Fragen und Antworten) als zusätzlicher Kontext an das System gesendet Konstruieren Sie die Antwort. Es handelt sich um ein unkompliziertes Markov-Entscheidungsprozess-Modell (MDP) für Konversationen:

{Zustand = Kontext, Aktion = Antwort, Belohnung = Bewertung mit Daumen hoch/runter}.

Diese Strategie ist zwar effektiv, weist jedoch die folgenden Nachteile auf: Erstens liefert eine Eingabeaufforderung lediglich eine Beschreibung der Antwort des Benutzers, die tatsächliche Absicht des Benutzers wird jedoch möglicherweise nicht explizit angegeben und muss abgeleitet werden. Ein robustes Modell, wie es zuvor für Konversations-Bots vorgeschlagen wurde, wäre möglicherweise ein teilweise beobachtbarer Markov-Entscheidungsprozess (POMDP), der eine verborgene Benutzerabsicht genau modelliert.

Zweitens wird ChatGPT zunächst mithilfe der Sprachfitness und dann anhand menschlicher Bezeichnungen für Konversationsziele trainiert. Aufgrund des offenen Charakters der Plattform stimmen die tatsächlichen Absichten und Ziele des Benutzers möglicherweise nicht mit den trainierten/feinabgestimmten Belohnungen überein. Um das Gleichgewicht und die widersprüchlichen Interessen von Menschen und Agenten zu untersuchen, kann es sich lohnen, eine spieltheoretische Perspektive einzunehmen [9].

5.Neuartige Anwendungen

Wie ChatGPT bewiesen hat, gibt es zwei charakteristische Merkmale von Foundation-Language-Modellen, von denen wir glauben, dass sie die treibende Kraft hinter zukünftigen maschinellen Lern- und Foundation-Language-Modellanwendungen sein werden. Das erste sind seine überlegenen sprachlichen Fähigkeiten, während das zweite seine eingebetteten Semantik- und frühen Denkfähigkeiten (in Form der menschlichen Sprache) sind. Als Schnittstelle wird ersteres die Eintrittsbarriere für angewandtes maschinelles Lernen erheblich verringern, während letzteres die Art und Weise, wie maschinelles Lernen angewendet wird, erheblich verallgemeinern wird.

Wie in der in Abschnitt 1 vorgestellten neuen Lernpipeline gezeigt, beseitigen Eingabeaufforderungen und kontextbezogenes Lernen den Engpass beim Data Engineering und den Aufwand, der zum Erstellen und Trainieren eines Modells erforderlich ist. Darüber hinaus könnte die Ausnutzung der Argumentationsfähigkeiten es uns ermöglichen, jede Teilaufgabe einer schwierigen Aufgabe automatisch zu analysieren und zu lösen. Daher wird es zahlreiche Branchen und Anwendungsbereiche dramatisch verändern. In internetbasierten Unternehmen ist die dialogbasierte Schnittstelle eine offensichtliche Anwendung für Web- und mobile Suche, Empfehlungssysteme und Werbung. Da wir jedoch an das schlüsselwortbasierte URL-Inverted-Index-Suchsystem gewöhnt sind, ist die Änderung nicht einfach. Den Menschen muss beigebracht werden, längere Abfragen und natürliche Sprache als Abfragen zu verwenden. Darüber hinaus sind Foundation-Language-Modelle typischerweise starr und unflexibel. Es fehlt der Zugang zu aktuellen Informationen über aktuelle Ereignisse. Sie halluzinieren in der Regel Fakten und bieten keine Abruf- und Überprüfungsmöglichkeiten. Daher benötigen wir ein Just-in-Time-Grundlagenmodell, das sich im Laufe der Zeit dynamisch weiterentwickeln kann.

Wir fordern daher neuartige Anwendungen, unter anderem in den folgenden Bereichen:

- Neuartiges Prompt-Engineering, dessen Verfahren und Softwareunterstützung.

- Generative und modellbasierte Websuche, Empfehlung und Werbung; neuartige Geschäftsmodelle für Konversationswerbung.

- Techniken für dialogbasierte IT-Dienste, Softwaresysteme, drahtlose Kommunikation (personalisierte Nachrichtensysteme) und Kundendienstsysteme.

- Automatisierungsgenerierung aus grundlegenden Sprachmodellen für Robotic Process Automation (RPA). ) und Softwaretest und -verifizierung.

- KI-unterstützte Programmierung.

- Neuartige Tools zur Content-Generierung für die Kreativbranche.

- Vereinigung von Sprachmodellen mit Operations Research und Enterprise Intelligence und Optimierung.

- Effizient und kostengünstige Methoden zur Bereitstellung großer Basismodelle im Cloud Computing.

- Grundlagenmodelle für Verstärkungslernen und Multiagentenlernen und andere Entscheidungsbereiche.

- Sprachgestützte Robotik.

- Grundlagenmodelle und Argumentation für kombinatorische Optimierung, EDA und Chipdesign.

Das obige ist der detaillierte Inhalt von„Aufruf zur Innovation: UCL Wang Jun diskutiert die Theorie und Anwendungsaussichten der allgemeinen künstlichen Intelligenz von ChatGPT'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

DALL-E 3 wurde im September 2023 offiziell als deutlich verbessertes Modell gegenüber seinem Vorgänger eingeführt. Er gilt als einer der bisher besten KI-Bildgeneratoren und ist in der Lage, Bilder mit komplexen Details zu erstellen. Zum Start war es jedoch exklusiv

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Verbessern Sie die Produktivität, Effizienz und Genauigkeit der Entwickler, indem Sie eine abrufgestützte Generierung und ein semantisches Gedächtnis in KI-Codierungsassistenten integrieren. Übersetzt aus EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, Autor JanakiramMSV. Obwohl grundlegende KI-Programmierassistenten natürlich hilfreich sind, können sie oft nicht die relevantesten und korrektesten Codevorschläge liefern, da sie auf einem allgemeinen Verständnis der Softwaresprache und den gängigsten Mustern beim Schreiben von Software basieren. Der von diesen Coding-Assistenten generierte Code eignet sich zur Lösung der von ihnen zu lösenden Probleme, entspricht jedoch häufig nicht den Coding-Standards, -Konventionen und -Stilen der einzelnen Teams. Dabei entstehen häufig Vorschläge, die geändert oder verfeinert werden müssen, damit der Code in die Anwendung übernommen wird

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

Herausgeber |. KX Im Bereich der Arzneimittelforschung und -entwicklung ist die genaue und effektive Vorhersage der Bindungsaffinität von Proteinen und Liganden für das Arzneimittelscreening und die Arzneimitteloptimierung von entscheidender Bedeutung. Aktuelle Studien berücksichtigen jedoch nicht die wichtige Rolle molekularer Oberflächeninformationen bei Protein-Ligand-Wechselwirkungen. Auf dieser Grundlage schlugen Forscher der Universität Xiamen ein neuartiges Framework zur multimodalen Merkmalsextraktion (MFE) vor, das erstmals Informationen über Proteinoberfläche, 3D-Struktur und -Sequenz kombiniert und einen Kreuzaufmerksamkeitsmechanismus verwendet, um verschiedene Modalitäten zu vergleichen Ausrichtung. Experimentelle Ergebnisse zeigen, dass diese Methode bei der Vorhersage von Protein-Ligand-Bindungsaffinitäten Spitzenleistungen erbringt. Darüber hinaus belegen Ablationsstudien die Wirksamkeit und Notwendigkeit der Proteinoberflächeninformation und der multimodalen Merkmalsausrichtung innerhalb dieses Rahmens. Verwandte Forschungen beginnen mit „S

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

Laut Nachrichten dieser Website vom 5. Juli veröffentlichte GlobalFoundries am 1. Juli dieses Jahres eine Pressemitteilung, in der die Übernahme der Power-Galliumnitrid (GaN)-Technologie und des Portfolios an geistigem Eigentum von Tagore Technology angekündigt wurde, in der Hoffnung, seinen Marktanteil in den Bereichen Automobile und Internet auszubauen Anwendungsbereiche für Rechenzentren mit künstlicher Intelligenz, um höhere Effizienz und bessere Leistung zu erforschen. Da sich Technologien wie generative künstliche Intelligenz (GenerativeAI) in der digitalen Welt weiterentwickeln, ist Galliumnitrid (GaN) zu einer Schlüssellösung für nachhaltiges und effizientes Energiemanagement, insbesondere in Rechenzentren, geworden. Auf dieser Website wurde die offizielle Ankündigung zitiert, dass sich das Ingenieurteam von Tagore Technology im Rahmen dieser Übernahme mit GF zusammenschließen wird, um die Galliumnitrid-Technologie weiterzuentwickeln. G

SK Hynix wird am 6. August neue KI-bezogene Produkte vorstellen: 12-Layer-HBM3E, 321-High-NAND usw.

Aug 01, 2024 pm 09:40 PM

SK Hynix wird am 6. August neue KI-bezogene Produkte vorstellen: 12-Layer-HBM3E, 321-High-NAND usw.

Aug 01, 2024 pm 09:40 PM

Laut Nachrichten dieser Website vom 1. August hat SK Hynix heute (1. August) einen Blogbeitrag veröffentlicht, in dem es ankündigt, dass es am Global Semiconductor Memory Summit FMS2024 teilnehmen wird, der vom 6. bis 8. August in Santa Clara, Kalifornien, USA, stattfindet viele neue Technologien Generation Produkt. Einführung des Future Memory and Storage Summit (FutureMemoryandStorage), früher Flash Memory Summit (FlashMemorySummit), hauptsächlich für NAND-Anbieter, im Zusammenhang mit der zunehmenden Aufmerksamkeit für die Technologie der künstlichen Intelligenz wurde dieses Jahr in Future Memory and Storage Summit (FutureMemoryandStorage) umbenannt Laden Sie DRAM- und Speicheranbieter und viele weitere Akteure ein. Neues Produkt SK Hynix wurde letztes Jahr auf den Markt gebracht