Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Das Harbin Institute of Technology und das Nanyang Institute of Technology schlagen das weltweit erste Modell zur „multimodalen DeepFake-Erkennung und -Positionierung' vor: Damit gibt AIGC keinen Platz zum Verstecken von Fälschungen

Das Harbin Institute of Technology und das Nanyang Institute of Technology schlagen das weltweit erste Modell zur „multimodalen DeepFake-Erkennung und -Positionierung' vor: Damit gibt AIGC keinen Platz zum Verstecken von Fälschungen

Das Harbin Institute of Technology und das Nanyang Institute of Technology schlagen das weltweit erste Modell zur „multimodalen DeepFake-Erkennung und -Positionierung' vor: Damit gibt AIGC keinen Platz zum Verstecken von Fälschungen

Aufgrund der schnellen Entwicklung visueller generativer Modelle wie Stable Diffusion können hochauflösende Gesichtsbilder automatisch gefälscht werden, was zu einem immer schwerwiegenderen DeepFake-Problem führt.

Mit dem Aufkommen großer Sprachmodelle wie ChatGPT kann auch leicht eine große Anzahl gefälschter Artikel generiert und böswillig falsche Informationen verbreitet werden.

Zu diesem Zweck wurde eine Reihe von Single-Modal-Erkennungsmodellen entwickelt, um mit der Fälschung der oben genannten AIGC-Technologie in Bild- und Textmodalitäten umzugehen. Diese Methoden können jedoch mit der multimodalen Manipulation gefälschter Nachrichten in neuen Fälschungsszenarien nicht gut umgehen.

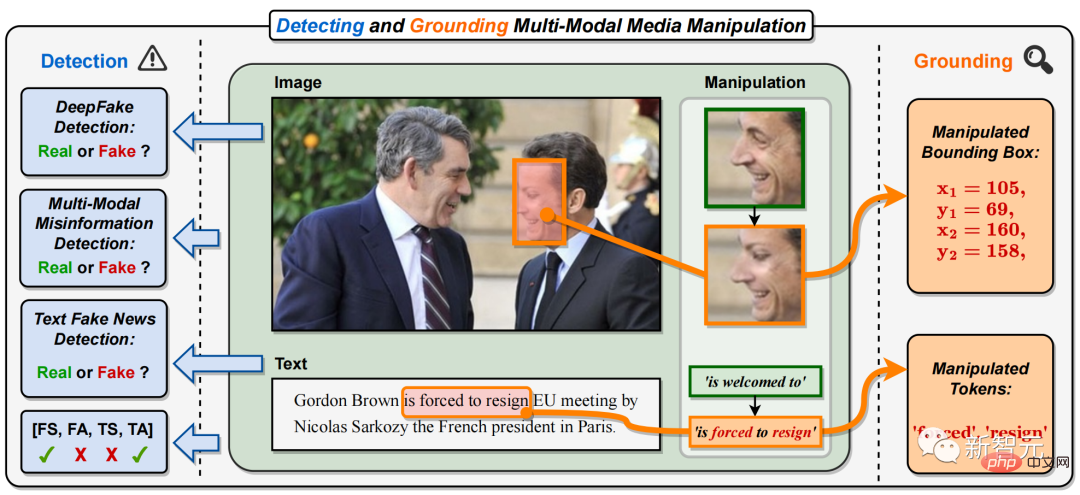

Konkret handelt es sich bei der multimodalen Medienmanipulation um die Gesichter wichtiger Persönlichkeiten auf den Bildern verschiedener Nachrichtenberichte (das Gesicht des französischen Präsidenten in Abbildung 1). ersetzt wurden, wurden die Schlüsselphrasen oder Wörter im Text manipuliert (in Abbildung 1 wurde die positive Phrase „ist willkommen zu“ durch die negative Phrase „ist zum Rücktritt gezwungen“) manipuliert.

Dies wird die Identität wichtiger Nachrichtenfiguren ändern oder vertuschen sowie die Bedeutung von Nachrichtentexten modifizieren oder in die Irre führen, wodurch eine multimodale Verbreitung gefälschter Nachrichten auf a entsteht großflächig im Internet. Abbildung 1. In diesem Dokument wird die Aufgabe vorgeschlagen, multimodale Medienmanipulationen zu erkennen und zu lokalisieren (DGM# 🎜🎜#4). Im Gegensatz zu bestehenden einmodalen DeepFake-Erkennungsaufgaben sagt DGM

4 nicht nur die wahre und falsche Klassifizierung eingegebener Bild-Text-Paare voraus, sondern versucht auch, feinkörnigere Manipulationstypen zu erkennen und Bildmanipulationen zu lokalisieren Bereiche und Text manipulierte Wörter. Zusätzlich zur binären Klassifizierung von wahr und falsch bietet diese Aufgabe eine umfassendere Erklärung und ein tieferes Verständnis der Manipulationserkennung.

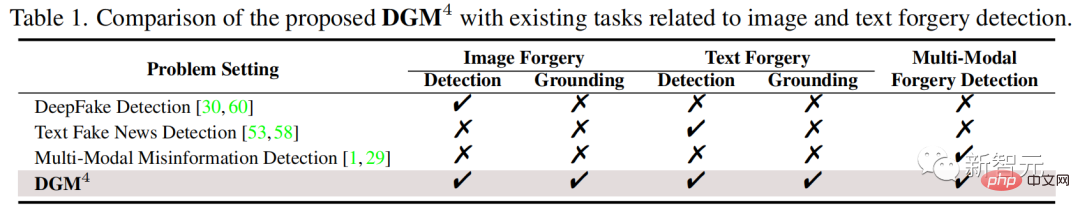

Tabelle 1: Vorgeschlagenes DGM4#🎜 🎜# Vergleich mit bestehenden Aufgaben im Zusammenhang mit der Erkennung von Bild- und Textfälschungen

Aufgaben zur Erkennung und Lokalisierung multimodaler Medienfälschungen

Aufgaben zur Erkennung und Lokalisierung multimodaler Medienfälschungen

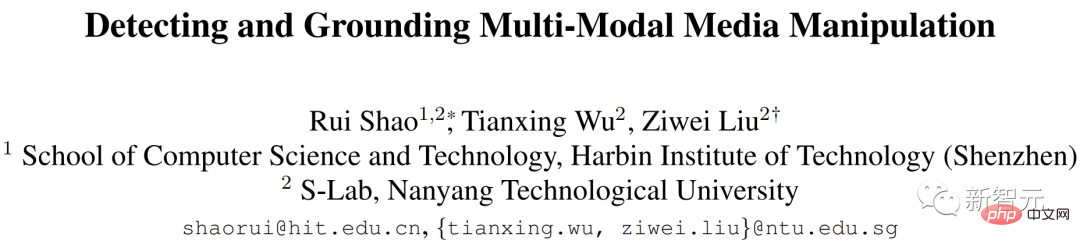

#🎜 🎜#Zum Verständnis Um dieser neuen Herausforderung gerecht zu werden, schlugen Forscher des Harbin Institute of Technology (Shenzhen) und des Nanyang Institute of Technology die Aufgabe vor, multimodale Medienmanipulation (DGM4) zu erkennen und zu lokalisieren, ein entwickeltes und Open-Source-DGM#🎜 🎜#4 Datensatz und schlug auch ein multimodales hierarchisches Manipulationsinferenzmodell vor. Derzeit ist diese Arbeit in CVPR 2023 enthalten.

auf. Art Eiszapfen Adresse: https://arxiv.org/abs/2304.02556

GitHub: https://github.com/rshaojimmy /MultiModal-DeepFake Projekthomepage: https://rshaojimmy.github.io/Projects/MultiModal-DeepFake

Wie in Abbildung 1 und Tabelle 1 gezeigt, Erkennung und Erdung multimodaler Medienmanipulation (DGM# 🎜🎜#4)) Der Unterschied zwischen und der bestehenden Single-Modal-Manipulationserkennung ist:

1) unterscheidet sich von der bestehenden DeepFake-Bilderkennung und gefälschte Texterkennungsmethoden können nur einzelne erkennen -modale gefälschte Informationen, während DGM4 die gleichzeitige Erkennung multimodaler Manipulationen in Bild-Text-Paaren erfordert;

2) Im Gegensatz zu bestehenden Die DeepFake-Erkennung, die sich auf die binäre Klassifizierung konzentriert, DGM4 berücksichtigt außerdem die Lokalisierung von manipulierten Bildbereichen und manipulierten Textwörtern. Dies erfordert, dass das Erkennungsmodell umfassendere und tiefergehende Überlegungen zur Manipulation zwischen Bild-Text-Modalitäten anstellt.

Multimodale Medienmanipulationsdatensätze erkennen und lokalisierenZur Unterstützung der Forschung zu DGM4, z.B Wie in Abbildung 2 dargestellt, trägt diese Arbeit zum weltweit ersten Datensatz

zur Erkennung und Lokalisierung multimodaler Medienmanipulation (DGM4) bei.

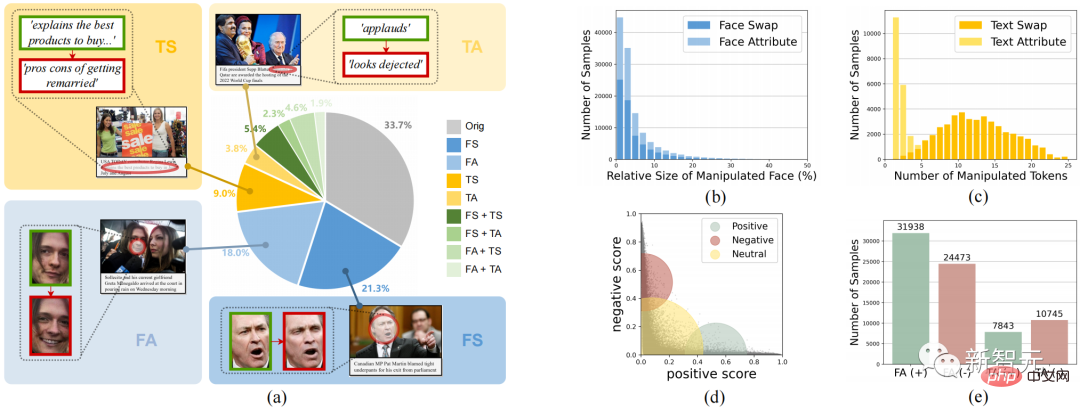

Abbildung 2. Der DGM-Datensatz 4 , Manipulation von Textattributen (TA).

Abbildung 2 zeigt die gesamten statistischen Informationen von DGM4, einschließlich (a) der Verteilung der Anzahl der Manipulationsarten; (b) die manipulierten Bereiche der meisten Bilder sind klein, insbesondere bei der Manipulation von Gesichtsattributen; (c) ) Bei Textattributmanipulationen werden weniger Wörter manipuliert als bei Textersatzmanipulationen. (e) Anzahl der Stichproben für jeden Manipulationstyp.

Diese Daten generierten insgesamt 230.000 Bild-Text-Paar-Samples, darunter 77.426 Original-Bild-Text-Paare und 152.574 manipulierte Sample-Paare. Die manipulierten Beispielpaare umfassen 66722 Gesichtsersatzmanipulationen, 56411 Gesichtsattributmanipulationen, 43546 Textersatzmanipulationen und 18588 Textattributmanipulationen.Multimodales hierarchisches Manipulations-Inferenzmodell

Dieser Artikel geht davon aus, dass multimodale Manipulationen subtile semantische Inkonsistenzen zwischen den Modalitäten verursachen. Daher ist die Erkennung der modalübergreifenden semantischen Inkonsistenz manipulierter Proben durch Fusion und Ableitung semantischer Merkmale zwischen Modalitäten die Hauptidee dieses Artikels zur Behandlung von DGM4

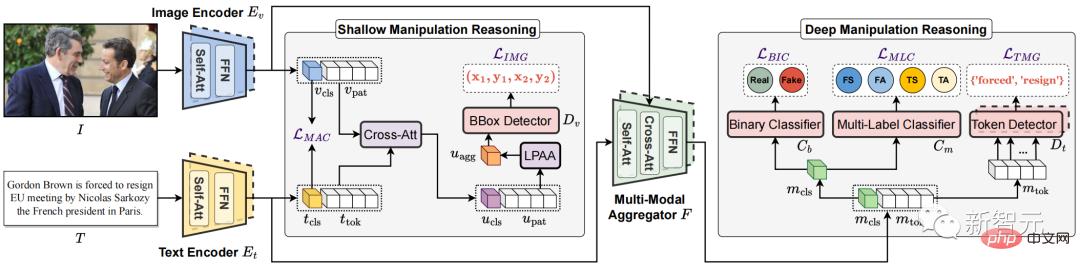

.Abbildung 3. Das vorgeschlagene multimodale hierarchische Manipulationsinferenzmodell HierArchical Multi-modal Manipulation rEasoning tTransformer (HAMMER)

vor Multimodales hierarchisches Manipulations-Inferenzmodell HierArchischer multimodaler Manipulations-Reasoning-Transformer (HAMMER).

Dieses Modell basiert auf der Modellarchitektur der multimodalen semantischen Fusion und Argumentation basierend auf der Twin-Tower-Struktur und implementiert die Erkennung und Lokalisierung multimodaler Manipulationen durch flache und tiefe Manipulationsbegründung auf feinkörniger Ebene Ebene.Wie in Abbildung 3 gezeigt, weist das HAMMER-Modell insbesondere die folgenden zwei Merkmale auf:

1) Beim flachen Manipulationsargumentieren durch manipulationsbewusstes kontrastives Lernen (Manipulation-Aware Contrastive Learning)

Zur Ausrichtung der Einzelmodale semantische Merkmale von Bildern und Texten, die vom Bild-Encoder und Text-Encoder extrahiert werden. Gleichzeitig nutzen die eingebetteten Einzelmodalfunktionen den Cross-Attention-Mechanismus für die Informationsinteraktion, und die „Local Patch Attentional Aggregation“ ist darauf ausgelegt, den Bildmanipulationsbereich zu lokalisieren Der modalitätsbewusste Kreuzaufmerksamkeitsmechanismus im multimodalen Aggregator wird verwendet, um multimodale semantische Merkmale weiter zu verschmelzen. Auf dieser Grundlage werden ein spezielles multimodales Sequenz-Tagging und eine multimodale Multi-Label-Klassifizierung durchgeführt, um Textmanipulationswörter zu lokalisieren und feinkörnigere Manipulationstypen zu erkennen.Experimentelle Ergebnisse

Wie unten gezeigt, zeigen die experimentellen Ergebnisse, dass der vom Forschungsteam vorgeschlagene HAMMER multimodale Medienmanipulationen im Vergleich zu multimodalen und monomodalen Erkennungsmethoden genauer erkennen und lokalisieren kann.

Abbildung 4. Visualisierung der Ergebnisse der multimodalen Manipulationserkennung und -lokalisierung

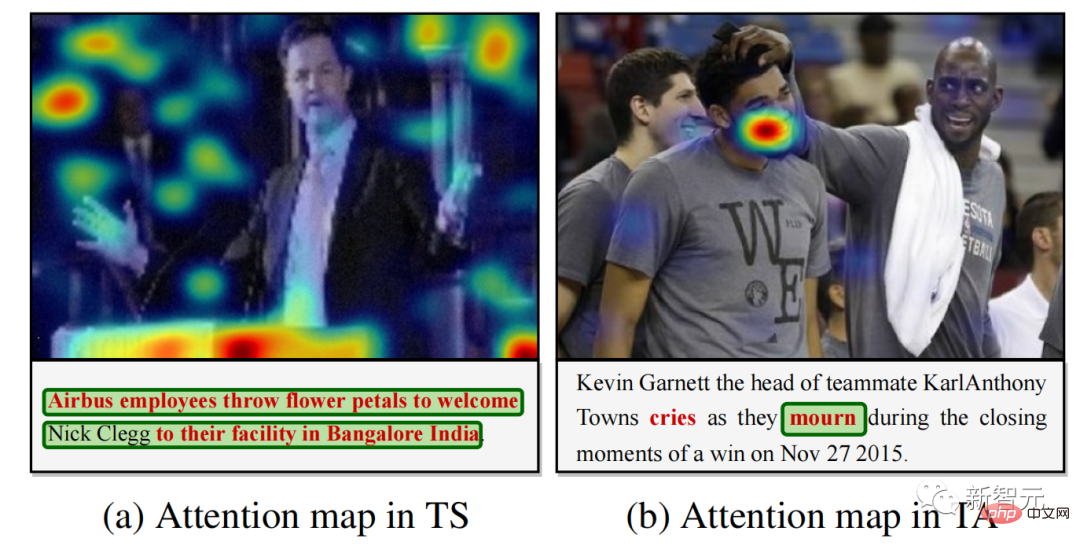

Abbildung 5. Modell der Aufmerksamkeitsvisualisierung der Manipulationserkennung für manipulierten Text

Abbildung 4 bietet einige multimodale visuelle Darstellungen Die Ergebnisse der Manipulationserkennung und -lokalisierung zeigen, dass HAMMER Manipulationserkennungs- und -lokalisierungsaufgaben gleichzeitig präzise durchführen kann. Abbildung 5 zeigt die Ergebnisse der Modellaufmerksamkeitsvisualisierung für manipulierte Wörter und zeigt weiter, dass HAMMER eine multimodale Manipulationserkennung und -lokalisierung durchführt, indem es sich auf Bildbereiche konzentriert, die semantisch nicht mit dem manipulierten Text übereinstimmen.

Zusammenfassung

- Diese Arbeit schlägt ein neues Forschungsthema vor: die Aufgabe, multimodale Medienmanipulationen zu erkennen und zu lokalisieren, um mit multimodalen Fake News umzugehen.

- Diese Arbeit liefert den ersten groß angelegten Datensatz zur Erkennung und Lokalisierung multimodaler Medienmanipulationen und liefert detaillierte und umfangreiche Anmerkungen zur Manipulationserkennung und -ortung. Das Team ist davon überzeugt, dass es künftige Forschungen zur multimodalen Erkennung gefälschter Nachrichten unterstützen kann.

- Diese Arbeit schlägt ein leistungsstarkes multimodales hierarchisches Manipulationsinferenzmodell als gute Ausgangslösung für dieses neue Thema vor.

Der Code und der Datensatz-Link dieser Arbeit wurden auf dem GitHub dieses Projekts geteilt. Jeder ist herzlich willkommen, dieses GitHub-Repo zu starten und den DGM4-Datensatz und HAMMER zu verwenden, um DGM4-Probleme zu untersuchen. Im Bereich DeepFake geht es nicht nur um die Einzelmodalitätserkennung von Bildern, sondern auch um ein umfassenderes multimodales Manipulationserkennungsproblem, das dringend gelöst werden muss!

Das obige ist der detaillierte Inhalt vonDas Harbin Institute of Technology und das Nanyang Institute of Technology schlagen das weltweit erste Modell zur „multimodalen DeepFake-Erkennung und -Positionierung' vor: Damit gibt AIGC keinen Platz zum Verstecken von Fälschungen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.