Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

30.000 A100 sind zu teuer und 300 Leute bei Microsoft haben 5 Jahre lang heimlich ihre eigenen KI-Chips entwickelt! TSMC 5nm, ChatGPT spart etwa 30 %

30.000 A100 sind zu teuer und 300 Leute bei Microsoft haben 5 Jahre lang heimlich ihre eigenen KI-Chips entwickelt! TSMC 5nm, ChatGPT spart etwa 30 %

30.000 A100 sind zu teuer und 300 Leute bei Microsoft haben 5 Jahre lang heimlich ihre eigenen KI-Chips entwickelt! TSMC 5nm, ChatGPT spart etwa 30 %

Um ChatGPT zu trainieren, hat Microsoft genug Geld ausgegeben.

Die gesamte von ChatGPT verbrauchte Rechenleistung beträgt etwa 3640PF-Tage. Wenn sie eine Billiarde Mal pro Sekunde berechnet wird, dauert die Berechnung 3640 Tage.

Microsoft hat mehr als 30.000 NVIDIA A100-Chips verbunden, um für Hunderte Millionen Dollar einen maßgeschneiderten Supercomputer für OpenAI zu bauen.

Wenn dieser Verbrauch anhält, kann Microsofts Geldbeutel ihn möglicherweise nicht mehr aushalten.

Tatsächlich wird der Plan, Nvidia-Chips auszutauschen, seit 2019 heimlich im Unternehmen umgesetzt.

Die Informationen berichteten, dass Microsoft vor etwa 5 Jahren mit der Entwicklung eines Chips mit dem internen Codenamen „Athena“ begann und von 300 Personen gemeinsam entwickelt wurde.

Der ursprüngliche Plan war, den 5-nm-Prozess von TSMC zu verwenden.

Selbst entwickelte Athena soll NVIDIA herausfordern

Unnötig zu erwähnen, dass „Athena“ speziell für das Training großer Sprachmodelle (LLM) entwickelt wurde.

Wenn Microsoft nun alle GPT-4-Funktionen in FamilyMart-Buckets integrieren möchte, einschließlich Bing, Microsoft 365 und GitHub, wird es definitiv eine Menge Rechenleistungsunterstützung benötigen.

Erschreckenderweise könnten die Kosten für die Entwicklung eines Chips wie Athena etwa 100 Millionen US-Dollar pro Jahr betragen.

Beim Training von Modellen können Forscher die Funktionen von „Athena“ nutzen, um neue Daten zu verarbeiten und gleichzeitig Rückschlüsse zu ziehen.

Auf diese Weise wurde die bisherige Situation, dass für die Verarbeitung von KI-Software dedizierte Computer verwendet werden mussten, gemildert. Schließlich waren Computer, die speziell für die Ausführung von KI eingesetzt wurden, noch nie ausreichend.

Denn bisher hat nur Nvidia diese Art von Chips hergestellt, und der Mangel an Angeboten hat die gesamte Technologiebranche zu diesem Mangel geführt.

Genau aus diesem Grund muss Microsoft für einige interne Teams dedizierte Chips bereitstellen.

Zuvor hatte das Forschungsunternehmen SemiAnalysis geschätzt, dass ChatGPT 700.000 US-Dollar pro Tag verbraucht, wobei jede Abfrage 0,36 Cent kostet.

Wenn „Athena“ wettbewerbsfähig ist, können die Kosten für jeden Chip um 1/3 gesenkt werden.

Tracy Woo, leitende Cloud-Analystin bei Forrester Research, sagte, dass die Explosion der KI große Unternehmen dazu veranlasst habe, sich darauf einzulassen, und dass der Mangel an Chips nicht nur Druck auf die Zulieferer, sondern auch auf KI-Technologieunternehmen ausübe. .

Große Technologieunternehmen wie Google und Amazon verfügen über genügend Kapital, um ihre eigenen Chips zu entwerfen und zu entwickeln, und andere Unternehmen müssen mit dem Tempo Schritt halten.

Zurück zu Microsofts „Athena“.

Tatsächlich war der Zeitpunkt der Veröffentlichung des KI-Chip-Projekts von Microsoft rein zufällig und nicht geplant.

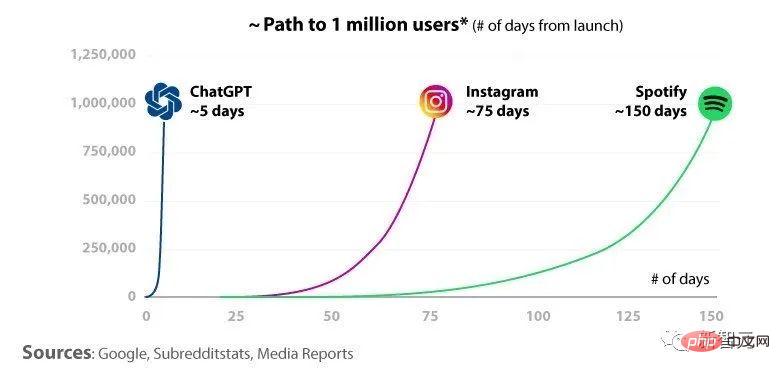

Zu Beginn dieses Jahres haben OpenAI und Microsoft einen qualitativen Sprung in der LLM-Ausbildung gemacht. Mit der Angelegenheit vertraute Personen sagten, dass die Veröffentlichung von ChatGPT das Internet explodierte und Microsoft aus diesem Grund den Start von „Athena“ hastig beschleunigt habe.

Wissen Sie, ChatGPT hat mehr als 100 Millionen Benutzer.

Es wird vorhergesagt, dass Microsoft „Athena“ bereits im nächsten Jahr in großem Umfang einsetzen wird, auch innerhalb von Microsoft und OpenAI. Worüber sie immer noch zögern, ist die Frage, ob „Athena“ den Kunden der Azure-Cloud-Computing-Dienste zur Verfügung gestellt werden soll.

Microsoft gab an, dass die meisten Kunden ihr eigenes LLM nicht trainieren müssen und daher keinen Chip-Segen benötigen.

Wenn man es jedoch wirklich geben will, muss Microsoft es besser machen als NVIDIA. Schließlich sind die Chips von NVIDIA seit fünfzehn Jahren fleißig und bei allen Entwicklern ein Verkaufsschlager.

Dylan Patel, Chefanalyst beim Forschungsunternehmen SemiAnalysis, sagte, dass die Betriebskosten von ChatGPT etwa 700.000 US-Dollar pro Tag betragen, was etwa 0,36 Cent pro Abfrage entspricht. Die Hauptursache dieser Kosten ist der Server, der zu teuer ist.

Aber wenn OpenAI sein selbst entwickeltes „Athena“ nutzt und Nvidia schlagen kann, dann können die Kosten um ein Drittel gesenkt werden.

Er erklärte weiter, dass Microsoft hofft, LLM in Zukunft auch in allen seinen Anwendungen wie Bing, Office 365, GitHub usw. einzusetzen. Wenn Sie für die Bereitstellung weiterhin aktuelle Hardware verwenden, wird dies jedes Jahr mehrere zehn Milliarden Dollar kosten.

Darüber hinaus verfügen die von Microsoft selbst entwickelten Chips über eine weitere Datenunterstützung.

Microsoft-Führungskräfte prognostizieren, wie viele Grafikprozessoren zur Unterstützung der KI-Arbeit benötigt werden. Einer der mit der Angelegenheit vertrauten Personen sagte, dass es unerschwinglich teuer wäre, sich ausschließlich auf Nvidia-Chips zu verlassen.

Obwohl Microsoft und NVIDIA erst letztes Jahr ein Kooperationsprojekt zum Bau von Supercomputern vereinbart haben, konkurriert „Athena“ in Bezug auf Chips immer noch mit den Produkten von NVIDIA.

NVIDIA lehnte jedoch eine Stellungnahme zu diesem sensiblen Thema ab.

Das obige ist der detaillierte Inhalt von30.000 A100 sind zu teuer und 300 Leute bei Microsoft haben 5 Jahre lang heimlich ihre eigenen KI-Chips entwickelt! TSMC 5nm, ChatGPT spart etwa 30 %. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

Einstiegsadresse für die internationale Bing-Version von Microsoft (Einstieg in die Bing-Suchmaschine)

Mar 14, 2024 pm 01:37 PM

Einstiegsadresse für die internationale Bing-Version von Microsoft (Einstieg in die Bing-Suchmaschine)

Mar 14, 2024 pm 01:37 PM

Bing ist eine von Microsoft eingeführte Online-Suchmaschine. Die Suchfunktion ist sehr leistungsfähig und verfügt über zwei Eingänge: die inländische Version und die internationale Version. Wo sind die Eingänge zu diesen beiden Versionen? Wie greife ich auf die internationale Version zu? Werfen wir einen Blick auf die Details unten. Zugang zur Website der chinesischen Version von Bing: https://cn.bing.com/ Zugang zur Website der internationalen Version von Bing: https://global.bing.com/ Wie greife ich auf die internationale Version von Bing zu? 1. Geben Sie zunächst die URL ein, um Bing zu öffnen: https://www.bing.com/ 2. Sie sehen, dass es Optionen für nationale und internationale Versionen gibt. Wir müssen nur die internationale Version auswählen und die Schlüsselwörter eingeben.

Microsoft veröffentlicht das kumulative August-Update für Win11: Verbesserung der Sicherheit, Optimierung des Sperrbildschirms usw.

Aug 14, 2024 am 10:39 AM

Microsoft veröffentlicht das kumulative August-Update für Win11: Verbesserung der Sicherheit, Optimierung des Sperrbildschirms usw.

Aug 14, 2024 am 10:39 AM

Laut Nachrichten dieser Website vom 14. August veröffentlichte Microsoft während des heutigen August-Patch-Dienstags kumulative Updates für Windows 11-Systeme, darunter das Update KB5041585 für 22H2 und 23H2 sowie das Update KB5041592 für 21H2. Nachdem das oben genannte Gerät mit dem kumulativen Update vom August installiert wurde, sind die mit dieser Site verbundenen Versionsnummernänderungen wie folgt: Nach der Installation des 21H2-Geräts wurde die Versionsnummer auf Build22000.314722H2 erhöht. Die Versionsnummer wurde auf Build22621.403723H2 erhöht. Nach der Installation des Geräts wurde die Versionsnummer auf Build22631.4037 erhöht. Die Hauptinhalte des KB5041585-Updates für Windows 1121H2 sind wie folgt: Verbesserung: Verbessert

Microsoft Edge-Upgrade: Funktion zum automatischen Speichern von Passwörtern verboten? ! Die Benutzer waren schockiert!

Apr 19, 2024 am 08:13 AM

Microsoft Edge-Upgrade: Funktion zum automatischen Speichern von Passwörtern verboten? ! Die Benutzer waren schockiert!

Apr 19, 2024 am 08:13 AM

Neuigkeiten vom 18. April: Kürzlich berichteten einige Benutzer des Microsoft Edge-Browsers, die den Canary-Kanal nutzten, dass sie nach dem Upgrade auf die neueste Version festgestellt hätten, dass die Option zum automatischen Speichern von Passwörtern deaktiviert sei. Nach einer Untersuchung stellte sich heraus, dass es sich hierbei um eine geringfügige Anpassung nach dem Browser-Upgrade und nicht um eine Aufhebung der Funktionalität handelte. Vor der Verwendung des Edge-Browsers für den Zugriff auf eine Website berichteten Benutzer, dass der Browser ein Fenster öffnete, in dem sie gefragt wurden, ob sie das Anmeldekennwort für die Website speichern wollten. Nachdem Sie sich zum Speichern entschieden haben, gibt Edge bei der nächsten Anmeldung automatisch die gespeicherte Kontonummer und das gespeicherte Passwort ein, was den Benutzern großen Komfort bietet. Aber das neueste Update ähnelt einer Optimierung, bei der die Standardeinstellungen geändert werden. Benutzer müssen das Speichern des Passworts auswählen und dann in den Einstellungen das automatische Ausfüllen des gespeicherten Kontos und Passworts manuell aktivieren.

Das Vollbild-Popup von Microsoft fordert Benutzer von Windows 10 auf, sich zu beeilen und auf Windows 11 zu aktualisieren

Jun 06, 2024 am 11:35 AM

Das Vollbild-Popup von Microsoft fordert Benutzer von Windows 10 auf, sich zu beeilen und auf Windows 11 zu aktualisieren

Jun 06, 2024 am 11:35 AM

Laut Nachrichten vom 3. Juni sendet Microsoft aktiv Vollbildbenachrichtigungen an alle Windows 10-Benutzer, um sie zu einem Upgrade auf das Betriebssystem Windows 11 zu ermutigen. Dabei handelt es sich um Geräte, deren Hardwarekonfigurationen das neue System nicht unterstützen. Seit 2015 hat Windows 10 fast 70 % des Marktanteils eingenommen und seine Dominanz als Windows-Betriebssystem fest etabliert. Der Marktanteil liegt jedoch weit über dem Marktanteil von 82 %, und der Marktanteil übersteigt den von Windows 11, das 2021 erscheinen wird, bei weitem. Obwohl Windows 11 seit fast drei Jahren auf dem Markt ist, ist die Marktdurchdringung immer noch langsam. Microsoft hat angekündigt, den technischen Support für Windows 10 nach dem 14. Oktober 2025 einzustellen, um sich stärker darauf zu konzentrieren

Die Funktion von Microsoft Win11 zum Komprimieren von 7z- und TAR-Dateien wurde von den Versionen 24H2 auf 23H2/22H2 herabgestuft

Apr 28, 2024 am 09:19 AM

Die Funktion von Microsoft Win11 zum Komprimieren von 7z- und TAR-Dateien wurde von den Versionen 24H2 auf 23H2/22H2 herabgestuft

Apr 28, 2024 am 09:19 AM

Laut Nachrichten dieser Website vom 27. April hat Microsoft Anfang dieses Monats das Vorschauversionsupdate für Windows 11 Build 26100 auf den Canary- und Dev-Kanälen veröffentlicht, das voraussichtlich eine mögliche RTM-Version des Windows 1124H2-Updates werden wird. Die wichtigsten Änderungen in der neuen Version sind der Datei-Explorer, die Integration von Copilot, die Bearbeitung von PNG-Dateimetadaten, die Erstellung von TAR- und 7z-komprimierten Dateien usw. @PhantomOfEarth hat herausgefunden, dass Microsoft einige Funktionen der 24H2-Version (Germanium) auf die 23H2/22H2-Version (Nickel) übertragen hat, beispielsweise die Erstellung von TAR- und 7z-komprimierten Dateien. Wie im Diagramm gezeigt, unterstützt Windows 11 die native Erstellung von TAR

Microsoft Edge-Browser-Update: Funktion „Bild vergrößern' hinzugefügt, um die Benutzererfahrung zu verbessern

Mar 21, 2024 pm 01:40 PM

Microsoft Edge-Browser-Update: Funktion „Bild vergrößern' hinzugefügt, um die Benutzererfahrung zu verbessern

Mar 21, 2024 pm 01:40 PM

Einer Nachricht vom 21. März zufolge hat Microsoft kürzlich seinen Microsoft Edge-Browser aktualisiert und eine praktische „Bild vergrößern“-Funktion hinzugefügt. Wenn Benutzer den Edge-Browser verwenden, können Benutzer diese neue Funktion jetzt ganz einfach im Popup-Menü finden, indem sie einfach mit der rechten Maustaste auf das Bild klicken. Noch praktischer ist, dass Benutzer auch mit der Maus über das Bild fahren und dann die Strg-Taste doppelklicken können, um schnell die Funktion zum Vergrößern des Bildes aufzurufen. Nach Angaben des Herausgebers wurde der neueste veröffentlichte Microsoft Edge-Browser im kanarischen Kanal auf neue Funktionen getestet. Die stabile Version des Browsers hat außerdem offiziell die praktische Funktion „Bild vergrößern“ eingeführt, die Benutzern ein komfortableres Durchsuchen von Bildern ermöglicht. Darauf haben auch ausländische Wissenschafts- und Technologiemedien geachtet

Microsoft plant, NTLM in Windows 11 in der zweiten Jahreshälfte 2024 auslaufen zu lassen und vollständig auf Kerberos-Authentifizierung umzustellen

Jun 09, 2024 pm 04:17 PM

Microsoft plant, NTLM in Windows 11 in der zweiten Jahreshälfte 2024 auslaufen zu lassen und vollständig auf Kerberos-Authentifizierung umzustellen

Jun 09, 2024 pm 04:17 PM

In der zweiten Hälfte des Jahres 2024 veröffentlichte der offizielle Microsoft-Sicherheitsblog eine Nachricht als Reaktion auf den Aufruf der Sicherheits-Community. Das Unternehmen plant, das in der zweiten Jahreshälfte 2024 veröffentlichte NTLAN Manager (NTLM)-Authentifizierungsprotokoll in Windows 11 zu eliminieren, um die Sicherheit zu verbessern. Nach bisherigen Erläuterungen hat Microsoft bereits zuvor ähnliche Schritte unternommen. Am 12. Oktober letzten Jahres schlug Microsoft in einer offiziellen Pressemitteilung einen Übergangsplan vor, der darauf abzielt, NTLM-Authentifizierungsmethoden auslaufen zu lassen und mehr Unternehmen und Benutzer dazu zu bewegen, auf Kerberos umzusteigen. Um Unternehmen zu helfen, die möglicherweise Probleme mit fest verdrahteten Anwendungen und Diensten haben, nachdem sie die NTLM-Authentifizierung deaktiviert haben, stellt Microsoft IAKerb und zur Verfügung

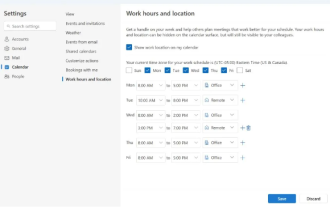

Microsoft bringt neue Version von Outlook für Windows auf den Markt: umfassende Aktualisierung der Kalenderfunktionen

Apr 27, 2024 pm 03:44 PM

Microsoft bringt neue Version von Outlook für Windows auf den Markt: umfassende Aktualisierung der Kalenderfunktionen

Apr 27, 2024 pm 03:44 PM

In den Nachrichten vom 27. April gab Microsoft bekannt, dass es bald einen Test einer neuen Version des Outlook für Windows-Clients veröffentlichen wird. Dieses Update konzentriert sich hauptsächlich auf die Optimierung der Kalenderfunktion mit dem Ziel, die Arbeitseffizienz der Benutzer zu verbessern und den täglichen Arbeitsablauf weiter zu vereinfachen. Die Verbesserung der neuen Version des Outlook für Windows-Clients liegt in seiner leistungsfähigeren Kalenderverwaltungsfunktion. Jetzt können Benutzer persönliche Arbeitszeit- und Standortinformationen einfacher teilen und so die Besprechungsplanung effizienter gestalten. Darüber hinaus verfügt Outlook über benutzerfreundliche Einstellungen, die es Benutzern ermöglichen, Besprechungen so einzustellen, dass sie automatisch früher enden oder später beginnen. Dies bietet Benutzern mehr Flexibilität, unabhängig davon, ob sie Besprechungsräume wechseln, eine Pause einlegen oder eine Tasse Kaffee vereinbaren möchten . entsprechend