Interpretation von TaskMatrix.AI

ChatGPT demonstriert beeindruckend leistungsstarke Dialog-, Kontextlern- und Codegenerierungsfunktionen für eine Vielzahl von Open-Domain-Aufgaben, und das erworbene gesunde Wissen kann auch Lösungszusammenfassungen auf hoher Ebene für domänenspezifische Aufgaben generieren. Welche anderen Probleme muss ChatGPT jedoch zusätzlich zu leistungsfähigeren Lern-, Verständnis- und Generierungsfunktionen lösen?

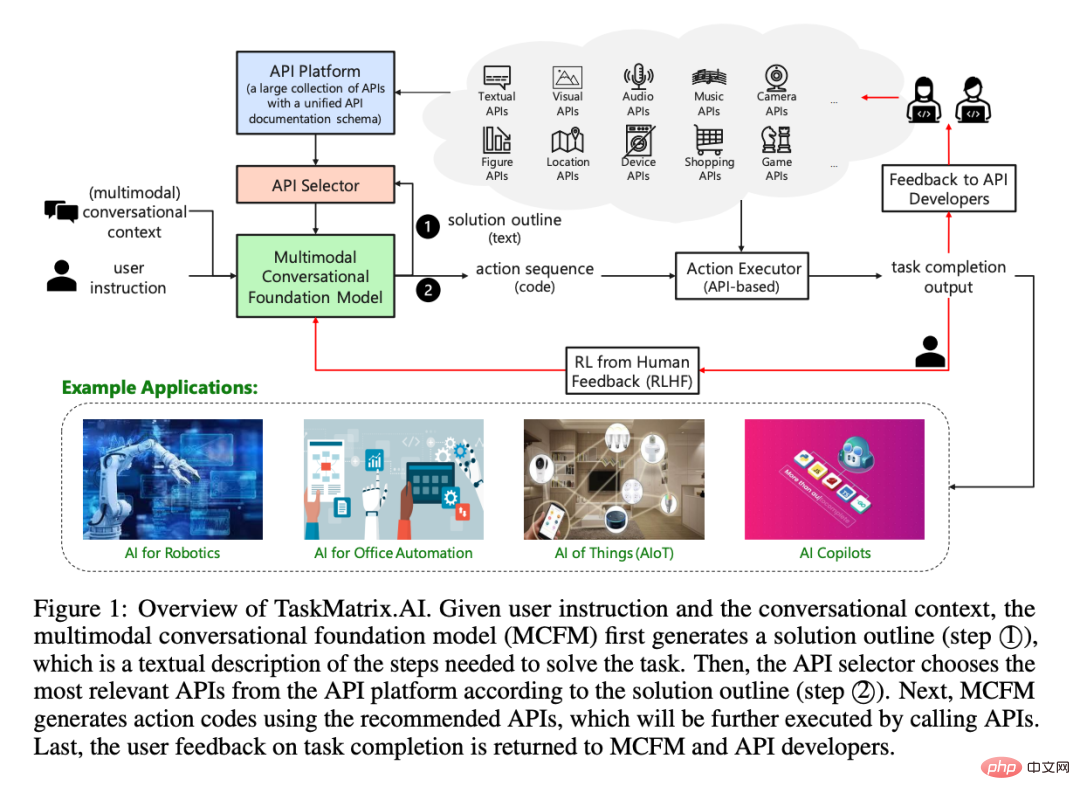

Microsoft hat kürzlich TaskMatrix.AI veröffentlicht, das möglicherweise eine weitere Richtung im Ökosystem der künstlichen Intelligenz darstellt und Basismodelle mit Millionen von APIs verbindet, um Aufgaben zu erledigen. Es ist möglicherweise auch eine Kombination aus Toolformer und chatGPT eine weitere Zukunft für LLM.

1. Problem

ChatGPT oder GPT-4 haben bei einigen Spezialaufgaben immer noch Schwierigkeiten, weil ihnen beim Vortraining nicht genügend domänenspezifische Daten fehlen oder sie eine schlechte Leistung erbringen. Es treten häufig Fehler auf in neuronalen Netzwerkberechnungen, die Aufgaben genau ausführen müssen. Andererseits gibt es viele bestehende Modelle und Systeme (symbolisch oder neuronal netzwerkbasiert), die einige domänenspezifische Aufgaben sehr gut erfüllen können. Aufgrund unterschiedlicher Implementierungen oder Arbeitsmechanismen sind sie jedoch nicht mit dem Basismodell kompatibel.

Darüber hinaus gibt es unzählige Anwendungsfälle für KI, die nicht nur in der digitalen Welt, sondern auch in der physischen Welt bei einer Vielzahl von Aufgaben helfen können, von der Fotoverarbeitung bis zur Steuerung von Smart-Home-Geräten liegen oft außerhalb der Vorstellungskraft.

Daher besteht Bedarf an einem Mechanismus, der das Basismodell nutzen kann, um eine Gliederung einer Aufgabenlösung vorzuschlagen und dann automatisch einige Unteraufgaben in der Gliederung mit vorgefertigten Modellen und System-APIs abzugleichen besondere Fähigkeiten, um sie zu vervollständigen. TaskMatrix.AI ist ein solcher Mechanismus.

2. TaskMatrix.AI Übersicht

TaskMatrix.AI bedient eine Vielzahl von Aufgaben durch die Kombination von Basismodellen mit vorhandenen Modellen und APIs. Hier sind die Aufgaben, die TaskMatrix.AI ausführen kann:

- Künstliche Intelligenz kann verschiedene Arten von Eingaben (wie Text, Bilder, Videos, Audio und Code) mithilfe des zugrunde liegenden Modells verstehen Als Kernsystem führt es digitale und physische Aufgaben aus und generiert dann Code zum Aufrufen von APIs, um die Aufgaben abzuschließen.

- TaskMatrix.AI verfügt über eine API-Plattform, die als Repository für Aufgaben in verschiedenen Domänen dient. Alle APIs auf dieser Plattform verfügen über ein einheitliches Dokumentationsformat, was die Verwendung des Basismodells erleichtert und Entwicklern das Hinzufügen neuer APIs erleichtert.

- TaskMatrix.AI verfügt über starke lebenslange Lernfähigkeiten, da es seine Fähigkeiten zur Bewältigung neuer Aufgaben erweitern kann, indem es der API-Plattform neue APIs mit spezifischer Funktionalität hinzufügt.

- Die Antworten von TaskMatrix.AI sind besser interpretierbar, da sowohl die Aufgabenlösungslogik (d. h. der Operationscode) als auch die Ergebnisse der API verständlich sind.

3. TaskMatrix.AI de Architecture

Die Gesamtarchitektur von TaskMatrix.AI und seine vier Hauptkomponenten:

- #🎜 🎜#Multimodal Conversation Foundation Model (MCFM): Es ist für die Kommunikation mit Benutzern, das Verständnis ihrer Ziele und ihres (multimodalen) Kontexts sowie die Generierung von ausführbarem Code basierend auf APIs zur Erledigung spezifischer Aufgaben verantwortlich.

- API-Plattform: Bietet ein einheitliches API-Dokumentationsschema zum Speichern von Millionen von APIs mit unterschiedlichen Funktionen und ermöglicht API-Entwicklern oder -Eigentümern das Registrieren, Aktualisieren und Löschen ihrer APIs.

- API-Auswahl: Empfehlen Sie relevante APIs basierend auf dem Verständnis von MCFM für Benutzerbefehle.

- API-Executor: Führen Sie den generierten Operationscode aus, indem Sie die entsprechende API aufrufen und die Zwischen- und Endausführungsergebnisse zurückgeben.

Diese 4 Subsysteme arbeiten zusammen, um TaskMatrix.AI zu ermöglichen, Benutzerziele zu verstehen und basierend auf dem ausführbaren Code von auszuführen die API. Das Multimodal Conversation Foundation Model (MCFM) dient als Hauptschnittstelle für die Benutzerkommunikation und kann multimodale Kontexte verstehen. API Platform bietet ein einheitliches API-Dokumentationsschema und einen Ort zum Speichern von Millionen von APIs. Der API-Selektor nutzt das Verständnis von MCFM für die Ziele des Benutzers, um relevante APIs zu empfehlen. Schließlich führt der API-Executor den von der entsprechenden API generierten Operationscode aus und gibt die Ergebnisse zurück. Darüber hinaus nutzte das Team auch Reinforcement Learning with Human Feedback (RLHF)-Technologie, um ein Belohnungsmodell zu trainieren, das die Aufgabenmatrix (taskMatrix) optimieren kann. Diese Methode kann MCFM- und API-Selektoren dabei helfen, optimale Strategien zu finden und die Leistung komplexer Aufgaben zu verbessern.

3.1 Multimodales Konversationsbasismodell (MCFM) MCFM verfügt über vier Eingaben: Parameter des Basismodells, API-Plattform, Benutzeranweisungen und Sitzungskontext. Anhand dieser Eingaben generiert das Modell Betriebscode, um die Anweisungen des Benutzers auszuführen. Darüber hinaus sollte ein ideales multimodales Konversationsrahmenmodell (MCFM) die folgenden vier Hauptmerkmale aufweisen:- Erhalten Sie multimodale Eingaben und generieren Sie ausführbaren Code basierend auf aufgabenspezifischen APIs.

- Extrahieren Sie spezifische Aufgaben aus Benutzeranweisungen und schlagen Sie eine Lösungsskizze vor.

- Erfahren Sie anhand der Dokumentation, wie Sie die API verwenden und sie basierend auf dem gesunden Menschenverstand und dem API-Nutzungsverlauf einer bestimmten Aufgabe zuordnen.

- Enthält einen expliziten Code-Überprüfungsmechanismus zur Bestätigung der Zuverlässigkeit und Vertrauenswürdigkeit.

ChatGPT und GPT-4 sind zwei Beispiele für Modelle mit diesen für MCFM erforderlichen Funktionen. GPT-4 ist jedoch besser geeignet, da es multimodale Eingaben unterstützt.

3.2 API-Plattform

Die API-Plattform hat zwei Hauptfunktionen: das Speichern von APIs und die Verwaltung der Entwickler oder Eigentümer von APIs. Die API-Plattform verfügt über eine einheitliche API-Dokumentvorlage, die fünf Aspekte jedes API-Dokuments enthält:

- API-Name: Bietet einen Überblick über die API und dient als Einstiegspunkt für Operationsausführende.

- Parameterliste: Einschließlich Eingabeparameter und Rückgabewerte hat jeder Parameter einen Namen, eine Beschreibung, einen Datentyp und einen Standardwert.

- API-Beschreibung: Enthält Informationen über die Funktionalität der API, ihre Funktionsweise, Ein- und Ausgaben sowie mögliche Fehler oder Ausnahmen.

- Anwendungsbeispiel (optional): Zeigen Sie, wie Sie die API verwenden.

- Kompositionsanleitung (optional): Bietet Anleitung zur Kombination mehrerer APIs, um komplexe Benutzeranweisungen zu vervollständigen. Die

- API-Plattform hat zwei Hauptfunktionen: Speicherung von APIs und Verwaltung von APIs durch Entwickler oder Eigentümer.

API-Beschreibungsbeispiel: Öffnen Sie eine Datei

<code>API Name: open_local_fileAPI Parameter: (file_path:string, model:string="r"). file_path: string, the pathname (absolute or relative to the current working directory) of the file to be opened.mode: string="r", the mode is an optional string that specifies the mode in which the file is opened. It defaults to "r" which means open for reading in text mode. Other common values are "w" for writing. This file will return a File object or OSError.API Description: Open the file and return a corresponding file object. If the file cannot be opened,an OSError is raised.Usage Example: f = open_local_file("example.txt", "w")Composition Instructions: Open should be used before reading and editing. The file should be closed by close_local_file after all operations.</code>3.3 API-Selektor

Der API-Selektor dient dazu, die API von der API-Plattform zu identifizieren und auszuwählen, die den Aufgabenanforderungen am besten entspricht. Durch den Abruf semantisch relevanter APIs kann die Fülle an APIs einer API-Plattform reduziert werden. API-Selektoren können Modulstrategien verwenden, um verwandte APIs schnell zu finden.

Modulstrategie bezieht sich auf die Methode, APIs basierend auf ihren Domänen in bestimmte Pakete oder Module zu organisieren. Jedes Modul entspricht einem bestimmten Bereich, beispielsweise visuellen Modellen, Mathematik, spezifischer Software oder physischer Ausrüstung. Mithilfe dieser Strategie kann der API-Selektor schnell relevante APIs finden, die den Missionsanforderungen und der Lösungsskizze entsprechen, wie sie von MCFM verstanden werden. Dieser Ansatz trägt dazu bei, den API-Auswahlprozess zu vereinfachen und erleichtert das Abrufen semantisch relevanter APIs von der API-Plattform.

3.4 Action Executor

Action Executor dient zum Ausführen von Aktionscode. KI verwendet einen Aktionsausführer, um eine Vielzahl von APIs auszuführen, von einfachen HTTP-Anfragen bis hin zu komplexen Algorithmen oder KI-Modellen, die mehrere Eingabeparameter erfordern.

Aktionsausführer benötigen außerdem einen Überprüfungsmechanismus, um die Genauigkeit und Zuverlässigkeit zu verbessern und zu bestätigen, ob die Ergebnisse des generierten Codes den von Menschen vorgegebenen Aufgaben entsprechen.

3.5 Human-Centered Reinforcement Learning (RLHF)

TaskMatrix.AI wird RLHF nutzen, um MCFM- und API-Selektoren zu verbessern und so eine bessere Leistung bei komplexen Aufgaben zu erzielen.

RLHF wird sich der Optimierung von API-Selektoren widmen und dabei ein trainiertes Belohnungsmodell verwenden, das auf API-Feedback basiert:

- Feedback an API-Entwickler

- API-Entwickler erhalten Feedback dazu, ob ihre API zur Vervollständigung des Aufgabenfeedbacks verwendet wird.

Dies ermöglicht die Erstellung einer API-Dokumentation auf die optimierteste Art und Weise, um eine bestimmte API zu verwenden.

4. Anwendungsfälle von TaskMatrix

Bei welchen Aufgaben kann KI helfen?

TaskMatrix. KI kombiniert mit kontinuierlichen Entwicklungen bei zugrunde liegenden Modellen, Cloud-Diensten, Robotik und dem Internet der Dinge hat das Potenzial, eine zukünftige Welt mit erhöhter Produktivität und Kreativität zu schaffen.

4.1 Visualisierungsaufgabe

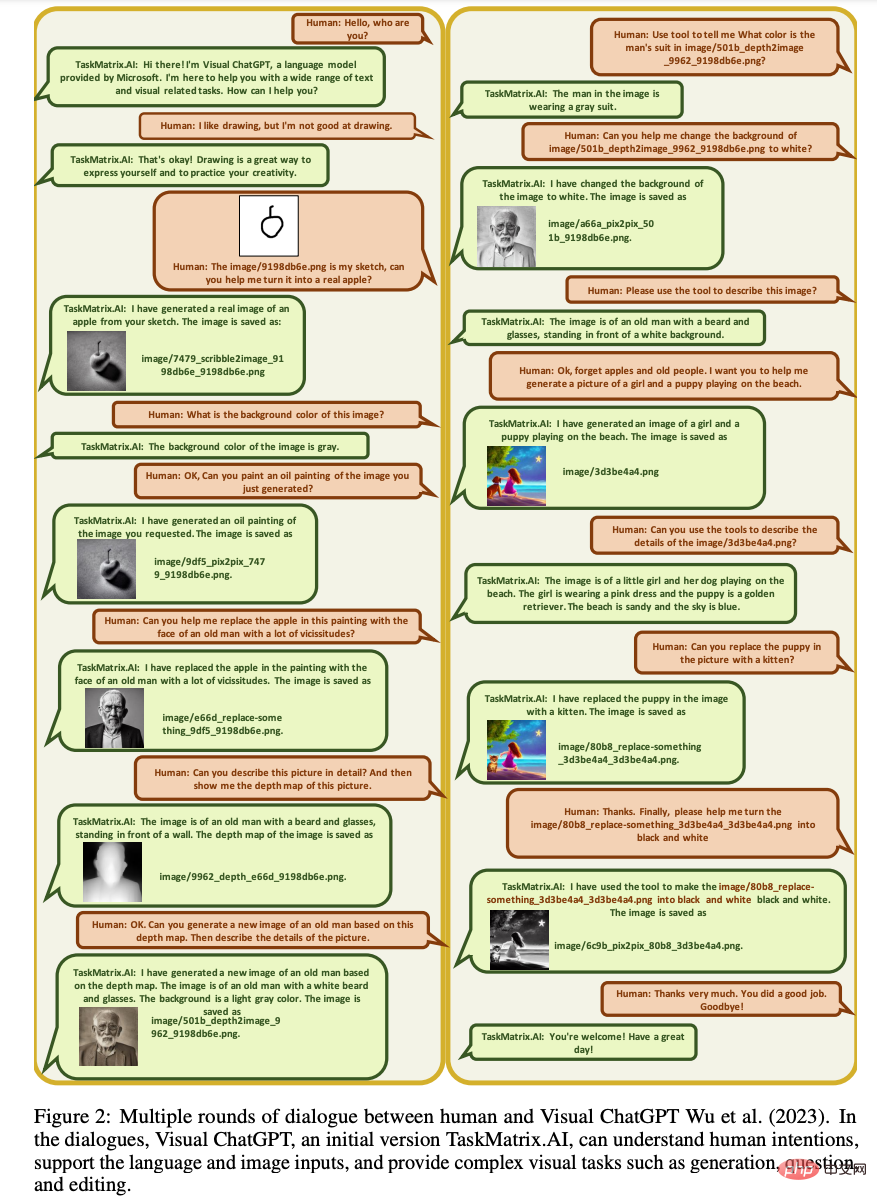

Basierend auf den multimodalen Eigenschaften von MCFM kann TaskMatrix.AI Visualisierungsaufgaben ausführen und Sprache und Bilder als Eingabe verwenden. Einige der visuellen Aufgaben, die es ausführen kann, zeigt das Bild unten, wie TaskMatrix.AI auf VisualChatGPT aufbaut und VQA-Aufgaben besser bewältigen kann.

Bildbearbeitung zum Löschen oder Ersetzen von Objekten im Bild, auch über TaskMatrix.AI. Mithilfe von Bildverarbeitungstechniken oder Computeralgorithmen „Image-to-Sketch/Depth/Hed/Line“ können Bilder in Skizzen, Tiefe, Gesamtkantenerkennung oder Linien umgewandelt werden. „Skizze/Tiefe/Hed/Linie-zu-Bild“ ist das Gegenteil von oben: Es wird ein Bild basierend auf den angegebenen Optionen generiert.

Das Bild unten zeigt ein Beispiel dafür, wie TaskMatrix.AI mithilfe von drei API-Aufrufen (Bild-Fragen und Antworten, Bildunterschriften und Objekte im Bild ersetzen) in einer Lösungsskizze definiert und ausgeführt wird.

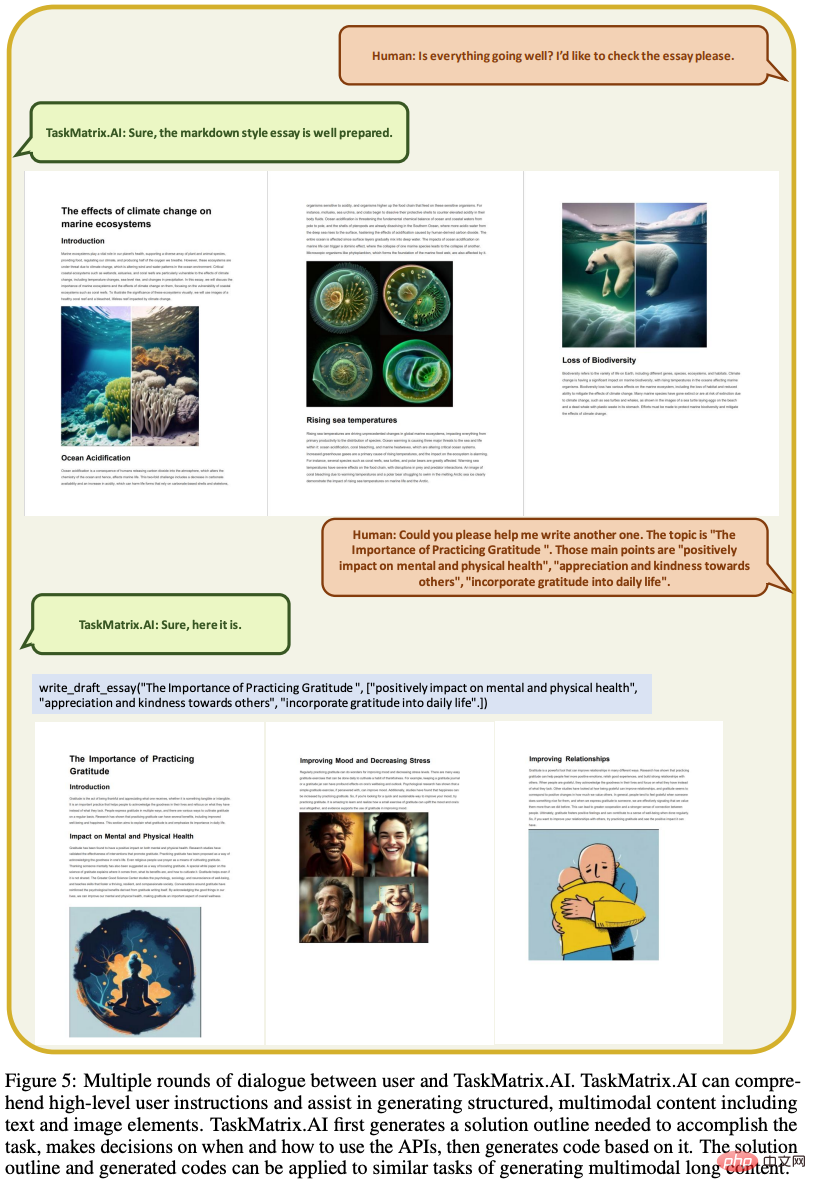

4.2 Generierung multimodaler langer Inhalte

Ein weiterer Anwendungsfall für TaskMatrix.AI ist die Erstellung großer multimodaler (Bild- und Text-)Inhalte, um die Zeichenbeschränkungen anderer Modelle aufzuheben.

Im folgenden Beispiel können wir sehen, wie TaskMatrix.AI allgemeine Anweisungen des Benutzers entgegennimmt und eine vernünftige Antwort generiert.

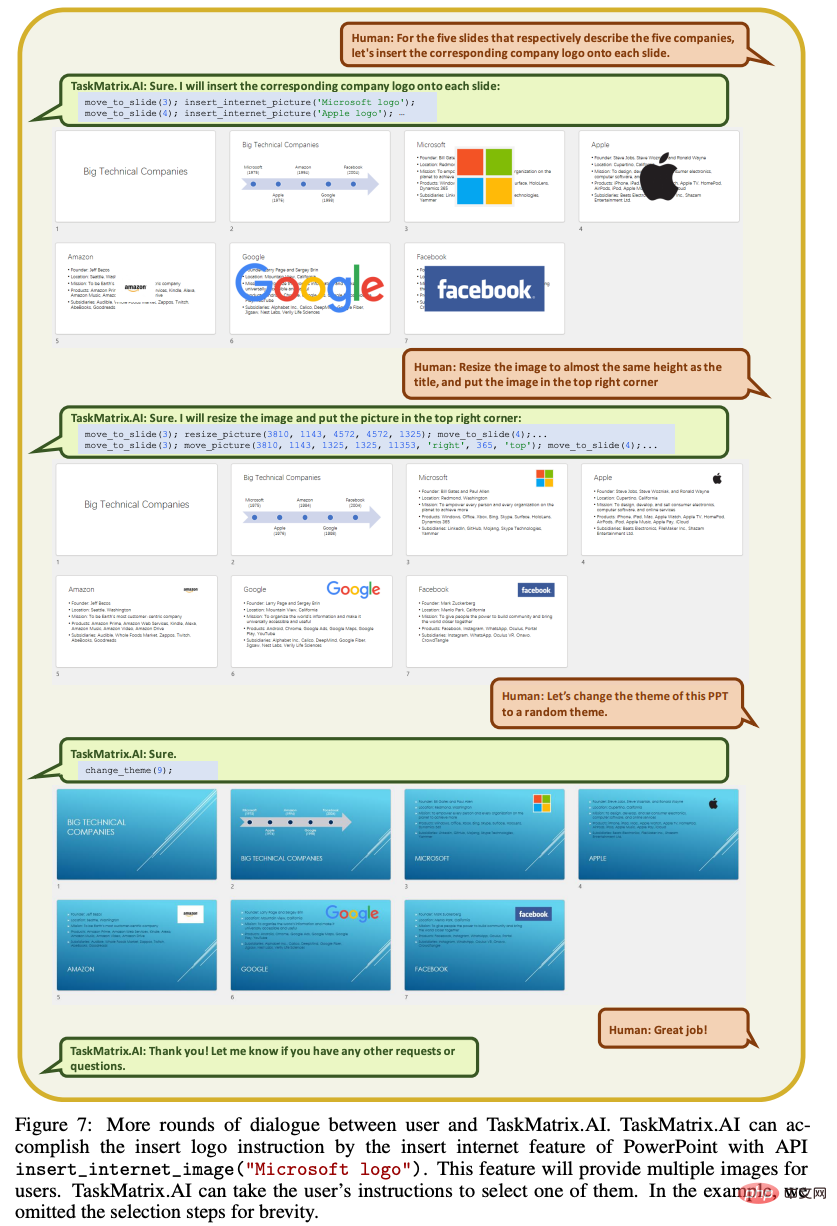

4.3 Büroautomatisierung

TaskMatrix.AI kann die Arbeitsbelastung im Büro leicht reduzieren, indem es Benutzeranweisungen versteht, die über Sprache empfangen werden, und Aufgaben automatisiert. Darüber hinaus ermöglicht es die Nutzung komplexer Software ohne umfangreiche Schulung, sodass sich die Mitarbeiter auf dringendere Aufgaben konzentrieren können.

Das folgende Beispiel zeigt ein Gespräch zwischen TaskMatrix.AI und jemandem, der beim Erstellen von PowerPoint-Folien verschiedene APIs verwendet.

4.4 Nutzung von Cloud-Diensten

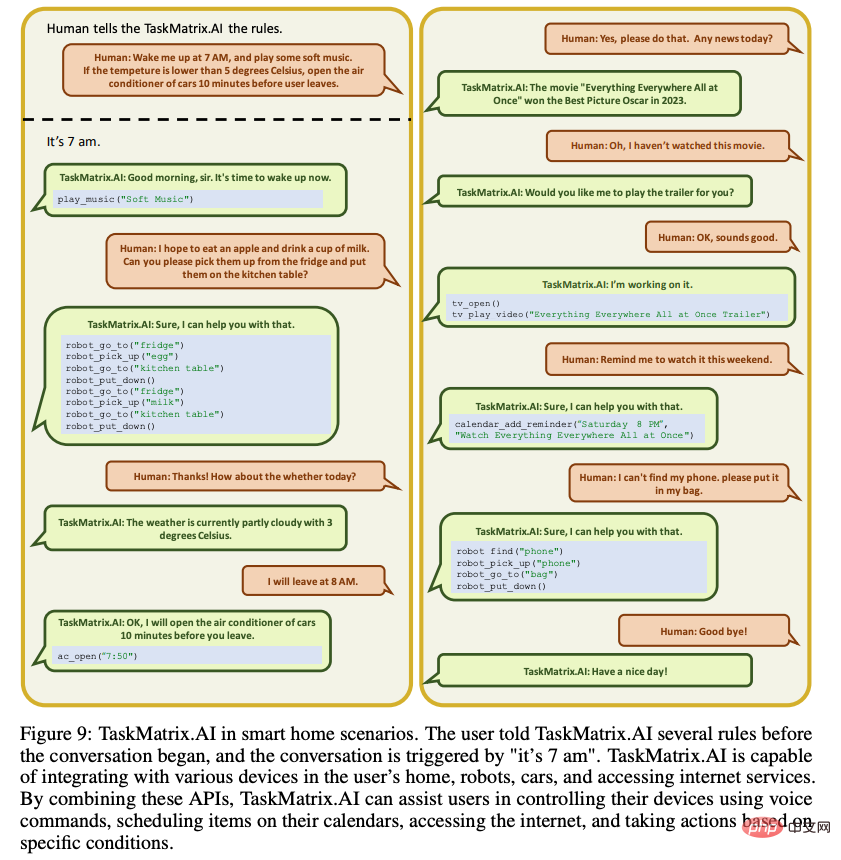

TaskMatrix.AI kann wie eine Smart-Home-Automatisierung funktionieren, mit allen Geräten im Haus kommunizieren und als zentraler Verbindungspunkt zwischen ihnen fungieren. Das Bild unten zeigt ein Gespräch zwischen einer Person und TaskMatrix.AI, das hauseigene Robotersoftware und -hardware nutzt, um tägliche Aufgaben zu erledigen.

Darüber hinaus kann TaskMatrix.AI in vielen anderen Szenarien verwendet werden. Die einzige Voraussetzung ist, dass es APIs wie den Zugriff auf Metaverse oder Web3 nutzen kann. 5. Herausforderungen von TaskMatrix.AI Verschiedene Eingaben, von Lernen aus menschlichem Feedback bis hin zum Einsatz von gesundem Menschenverstand, um Aufgaben in höchster Qualität zu erledigen. Die Bestimmung des für TaskMatrix.AI erforderlichen Mindestsatzes an Modalitäten und deren Schulung bleibt eine Herausforderung.

Die Erstellung und Wartung einer Plattform, auf der Millionen von APIs gehostet werden, erfordert die Lösung verschiedener Herausforderungen, die Erstellung von API-Dokumentationen, die API-Qualitätssicherung und API-Erstellungsempfehlungen. Auf dieser Grundlage sollten API-Plattformen API-Entwicklern weitere Anleitungen zur Erstellung neuer APIs zur Lösung dieser Aufgaben bieten.

Die Verwendung von Millionen von APIs zur Vervollständigung von Benutzeranweisungen bringt neue Herausforderungen mit sich, die über die Freitextgenerierung hinausgehen, und es ist von entscheidender Bedeutung, MCFM relevante APIs zur Lösung spezifischer Aufgaben zu empfehlen. Bei komplexen Aufgaben kann TaskMatrix.AI möglicherweise nicht sofort eine Lösung finden. Stattdessen sollte MCFM mit dem Benutzer interagieren und verschiedene mögliche Lösungen ausprobieren, um die am besten geeignete Lösung zu finden.

- Sicherheit und Datenschutz können ein Problem sein und erfordern eine Überprüfung, ob das Modell die Benutzeranweisungen befolgt und nichts tut, was über die Absicht des Benutzers hinausgeht. Die Datenübertragung sollte sicher sein und einen autorisierten Datenzugriff ermöglichen, wenn verschiedene APIs aus verschiedenen Domänen integriert werden, die Zugriff auf vertrauliche Daten erfordern.

- TaskMatrix.AI erfordert eine Personalisierungsstrategie, um einzelne Entwickler beim Erstellen ihrer eigenen personalisierten KI-Schnittstellen zu unterstützen und Benutzern zu helfen, ihre eigenen persönlichen Assistenten zu haben. Die Reduzierung der Skalierungskosten und die Anpassung an die geringe Anzahl von Beispielen der Benutzer sind Herausforderungen.

- 6. Zusammenfassung

- Rückblickend wird „die Zahl der KIs alle 18 Monate verdoppelt“ zu einem neuen Gesetz.

- TaskMatrix.AI integriert zugrunde liegende Modelle mit Millionen bestehender Modelle und System-APIs, was zu einer „superkünstlichen Intelligenz“ führt, die in der Lage ist, eine Vielzahl digitaler und physischer Aufgaben auszuführen. Als KI-Plattform ermöglicht es Menschen, große Modelle und APIs zu nutzen, um eine Vielzahl unterschiedlicher Aufgaben auszuführen. Es kann jede gängige Aufgabe bewältigen (z. B. PPT-Folien erstellen oder einen Reinigungsroboter steuern, um das Haus nach einem Zeitplan zu reinigen), was uns produktiver und kreativer macht.

Das obige ist der detaillierte Inhalt vonInterpretation von TaskMatrix.AI. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

Die Installation von MySQL auf CentOS umfasst die folgenden Schritte: Hinzufügen der entsprechenden MySQL Yum -Quelle. Führen Sie den Befehl mySQL-server aus, um den MySQL-Server zu installieren. Verwenden Sie den Befehl mySQL_SECURE_INSTALLATION, um Sicherheitseinstellungen vorzunehmen, z. B. das Festlegen des Stammbenutzerkennworts. Passen Sie die MySQL -Konfigurationsdatei nach Bedarf an. Tune MySQL -Parameter und optimieren Sie Datenbanken für die Leistung.

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

Eine vollständige Anleitung zum Anzeigen von GitLab -Protokollen unter CentOS -System In diesem Artikel wird in diesem Artikel verschiedene GitLab -Protokolle im CentOS -System angezeigt, einschließlich Hauptprotokolle, Ausnahmebodi und anderen zugehörigen Protokollen. Bitte beachten Sie, dass der Log -Dateipfad je nach GitLab -Version und Installationsmethode variieren kann. Wenn der folgende Pfad nicht vorhanden ist, überprüfen Sie bitte das GitLab -Installationsverzeichnis und die Konfigurationsdateien. 1. Zeigen Sie das Hauptprotokoll an. Verwenden Sie den folgenden Befehl, um die Hauptprotokolldatei der GitLabRails-Anwendung anzuzeigen: Befehl: Sudocat/var/log/gitlab/gitlab-rails/production.log Dieser Befehl zeigt das Produkt an

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Pytorch Distributed Training on CentOS -System erfordert die folgenden Schritte: Pytorch -Installation: Die Prämisse ist, dass Python und PIP im CentOS -System installiert sind. Nehmen Sie abhängig von Ihrer CUDA -Version den entsprechenden Installationsbefehl von der offiziellen Pytorch -Website ab. Für CPU-Schulungen können Sie den folgenden Befehl verwenden: PipinstallTorChTorChVisionTorChaudio Wenn Sie GPU-Unterstützung benötigen, stellen Sie sicher, dass die entsprechende Version von CUDA und CUDNN installiert ist und die entsprechende Pytorch-Version für die Installation verwenden. Konfiguration der verteilten Umgebung: Verteiltes Training erfordert in der Regel mehrere Maschinen oder mehrere Maschinen-Mehrfach-GPUs. Ort

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek:

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.