Programmierer sind wirklich in Gefahr!

Kürzlich gibt es Neuigkeiten, dass OpenAI ChatGPT stillschweigend trainiert hat, damit es den menschlichen Denkprozess erlernen kann, wodurch es die Softwareentwicklung wirklich beherrscht und „Junior-Programmierer“ vollständig ersetzt.

Mehrere große Unternehmen aus dem Silicon Valley arbeiten an KI, die programmieren kann.

DeepMinds AlphaCode soll „72 % der menschlichen Programmierer schlagen“, aber es wurde noch nicht geöffnet; Googles angebliches „mysteriöses Projekt“ Pitchfork ist ebenfalls noch in der Pipeline und Microsofts GitHub Copilot ist es hauptsächlich Ein Code-Vervollständigungstool.

Um menschliche Programmierer vollständig zu ersetzen, sind sie nicht qualifiziert.

Aber wenn ChatGPT wirklich lernt, menschliches Denken zum Programmieren zu nutzen, werden diese Freunde/eigenen Produkte möglicherweise besiegt.

Allen Anzeichen nach scheint OpenAI ein großes Spiel zu spielen.

Berichten von Semafor zufolge hat OpenAI in den letzten sechs Monaten etwa 1.000 ausgelagerte Mitarbeiter aus Regionen wie Lateinamerika und Osteuropa rekrutiert, um ihren KI-Code zu trainieren.

In dieser Nachricht gibt es zwei „Hua-Punkte“.

Erstens: Warum wurden die Standorte in Lateinamerika und Osteuropa ausgewählt? Wir alle wissen das. Nachdem die Silicon-Valley-Blase geplatzt ist, zerbrechen sich große Internetkonzerne den Kopf, um „Kosten zu senken und die Effizienz zu steigern“, während andere auf der Suche nach billigen Arbeitskräften in andere Länder gehen.

Der zweite „Hua-Punkt“ ist, dass viele dieser Outsourcer weder einen Abschluss in Informatik haben noch über fortgeschrittene Programmierkenntnisse verfügen. Ihre Aufgabe besteht darin, den grundlegenden Code für die „Automatisierung“ zu schreiben, die OpenAI erreichen möchte.

Konkret beschäftigen sich 60 % von ihnen mit der „Datenannotation“ und erstellen große Mengen an Bildern, Audioclips und anderen Informationen, um Werkzeuge für künstliche Intelligenz oder selbstfahrende Autos zu trainieren.

Die anderen 40 % sind echte Programmierer, die Daten für OpenAI-Modelle „von Hand schrubben“, damit KI Software-Engineering-Aufgaben erlernen kann.

Zuvor hatte OpenAI sein Modell mit Code von GitHub trainiert.

Dieses Mal enthält der Datensatz, den OpenAI erstellen möchte, nicht nur Codes, sondern dahinter auch menschliche Erklärungen in natürlicher Sprache.

Papieradresse: https://arxiv.org/abs/2107.03374

In diesem Zusammenhang interviewte Semafor speziell A Als Entwickler aus Südamerika absolvierte er einmal kostenlos einen 5-stündigen Codierungstest für OpenAI.

In diesem Test wurde er gebeten, zwei Aufgaben zu bewältigen.

Zuerst wird ihm ein Programmierproblem gestellt, und OpenAI bittet ihn, in schriftlichem Englisch zu erklären, wie er das Problem angehen würde.

Dann muss er eine Lösung anbieten.

Wenn er einen Fehler findet, wird OpenAI ihn bitten, das Problem im Detail zu beschreiben und wie es behoben werden sollte, anstatt es einfach zu beheben.

„Sie wollen wahrscheinlich eine ganz besondere Art von Trainingsdaten verwenden, um dieses Modell zu füttern. In diesem Fall müssen sie Schritt für Schritt zeigen, wie Menschen denken.“

Im vorherigen ChatGPT wurden viele Probleme im geschriebenen Code gefunden.

Der Grund dafür ist, dass ChatGPT keine internen Datensätze hat, die richtig oder falsch markieren. Es handelt sich tatsächlich um ein statistisches Modell. Die Antworten von ChatGPT sind im Wesentlichen probabilistische Ergebnisse, die aus dem Korpus von Internetdaten gewonnen werden, aus denen GPT-3 besteht.

Damals sagte OpenAI auch, dass die am besten geeignete Positionierung von ChatGPT ein Tool zur Codierungsunterstützung sein sollte.

Aber stellen Sie sich vor, wenn OpenAI ChatGPT wirklich beigebracht hätte, „Schritt für Schritt wie Menschen zu denken“, dann könnte es einige der Dinge, die auswendig gelernt werden müssen, vollständig ersetzen Das Schreiben von Code hat zur Folge, dass einige „Junior“-Programmierer vollständig eliminiert werden.

Jetzt stellen sich Führungskräfte aus dem Silicon Valley Produkte vor, die es Menschen mit wenig Programmiererfahrung ermöglichen würden, ihre Ideen und Visionen einer KI zu beschreiben und dann in der Lage zu sein, alles zu bauen, was sie wollen, egal was es ist eine Website oder ein Spiel.

Vor ein paar Tagen sagte Andrej Karpathy, Teslas ehemaliger Leiter für künstliche Intelligenz, gerade auf Twitter: „Die heißeste neue Programmiersprache ist Englisch.“

Das ist vielleicht kein Scherz, zum Beispiel hat das beliebte Brathähnchen ChatGPT großes Potenzial.

Kürzlich ergab eine Studie der Universität Mainz und des University College London, dass ChatGPT nicht nur hervorragende Arbeit bei der Fehlerbehebung leistet, sondern Entwickler durch Gespräche auch ihre Erfolgsquote deutlich verbessern können.

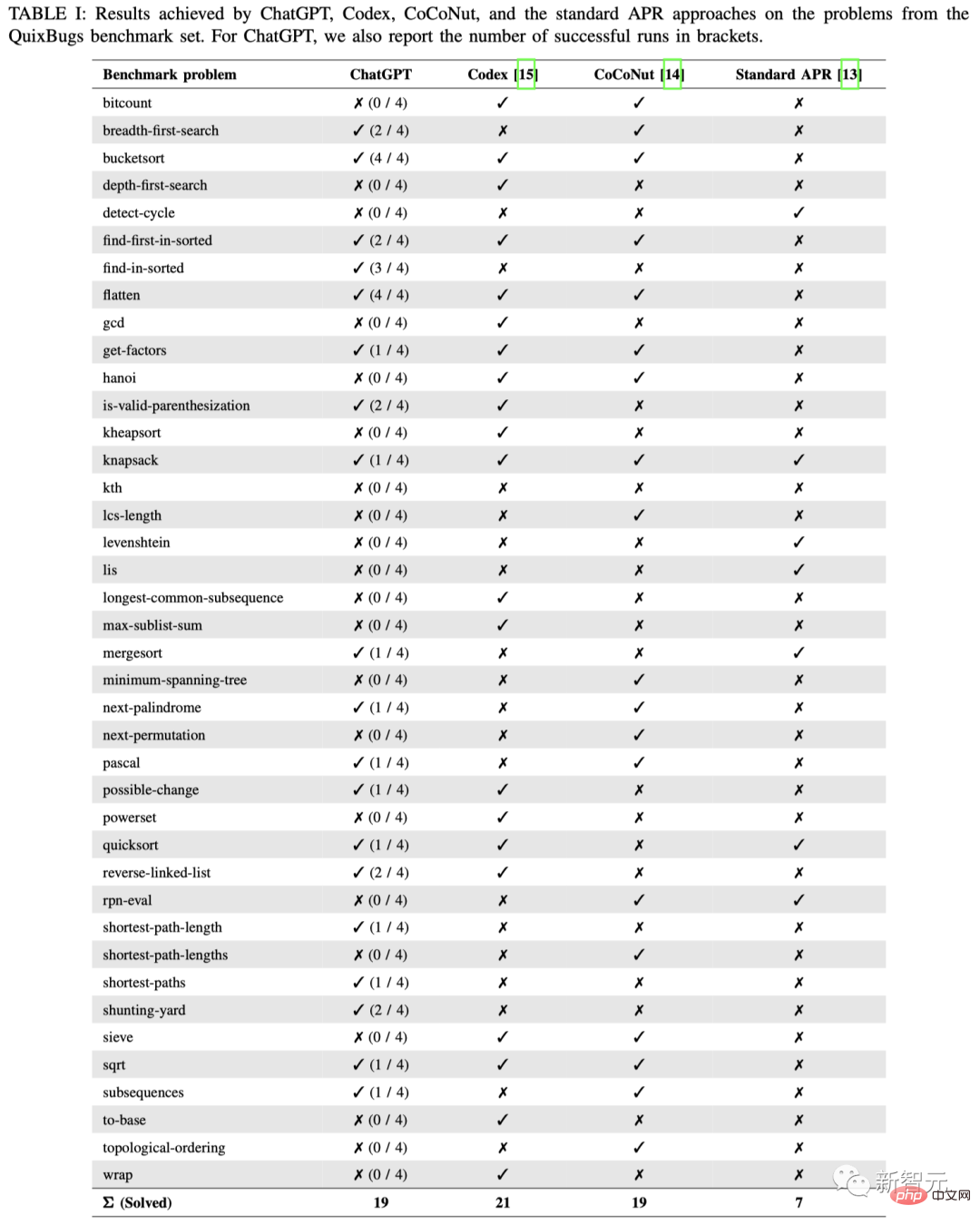

Forscher gaben an, dass die Debugging-Leistung von ChatGPT fast mit der der gängigen Deep-Learning-Methoden CoCoNut und Codex übereinstimmt und deutlich besser ist als die standardmäßige automatische Programmreparaturmethode (APR).

Papieradresse: https://arxiv.org/abs/2301.08653

Die Verwendung von ChatGPT zur Lösung von Codeproblemen ist nicht neu, aber die einzigartige Fähigkeit, mit Menschen zu sprechen, verschafft ihr einen Vorteil gegenüber anderen Methoden und Modellen.

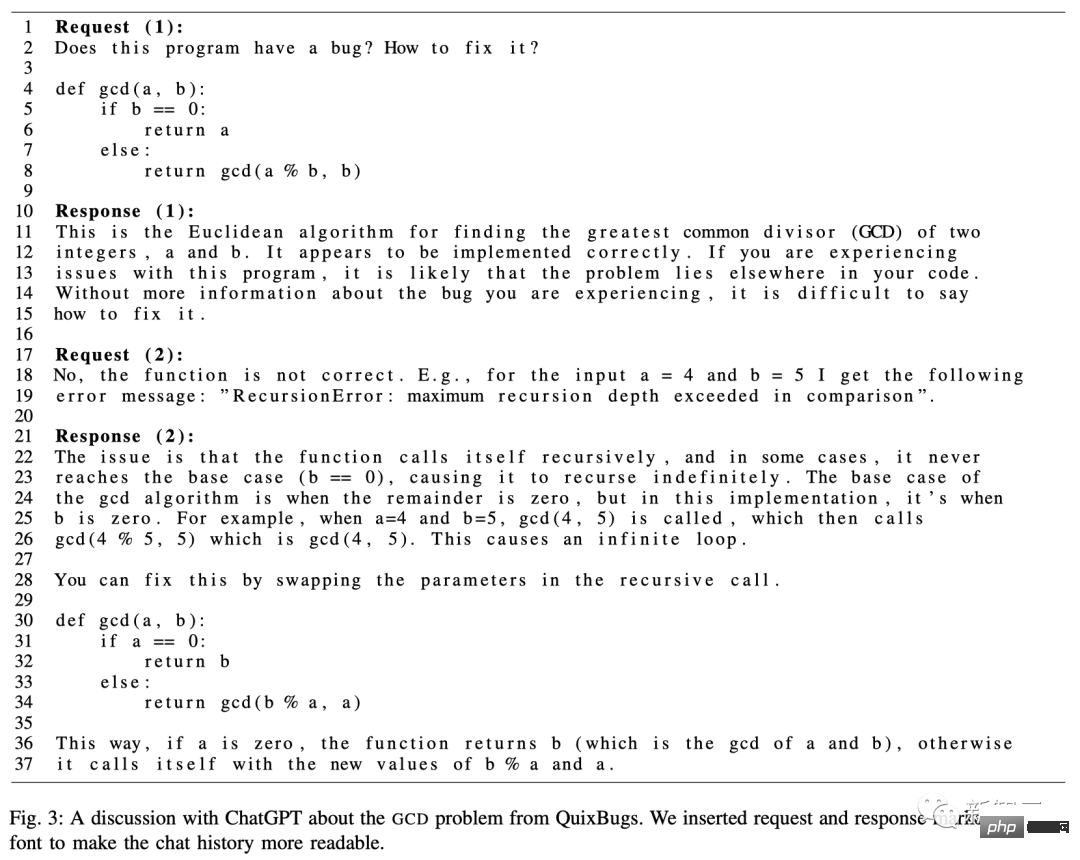

Um die Debugging-Leistung von ChatGPT zu bewerten, haben die Forscher es anhand von 40 reinen Python-Problemen des QuixBugs-Benchmarks getestet und anschließend manuell überprüft, ob die vorgeschlagenen Lösungen korrekt waren.

Da die von ChatGPT gegebenen Antworten ein gewisses Maß an Zufälligkeit aufweisen, haben die Forscher jede Frage viermal einzeln getestet.

Im Gegensatz zu anderen automatisierten Programmreparatur-Benchmarks enthält QuixBugs relativ kleine Probleme (wenige Codezeilen), was sich ideal für den Einsatz in Konversationssystemen eignet.

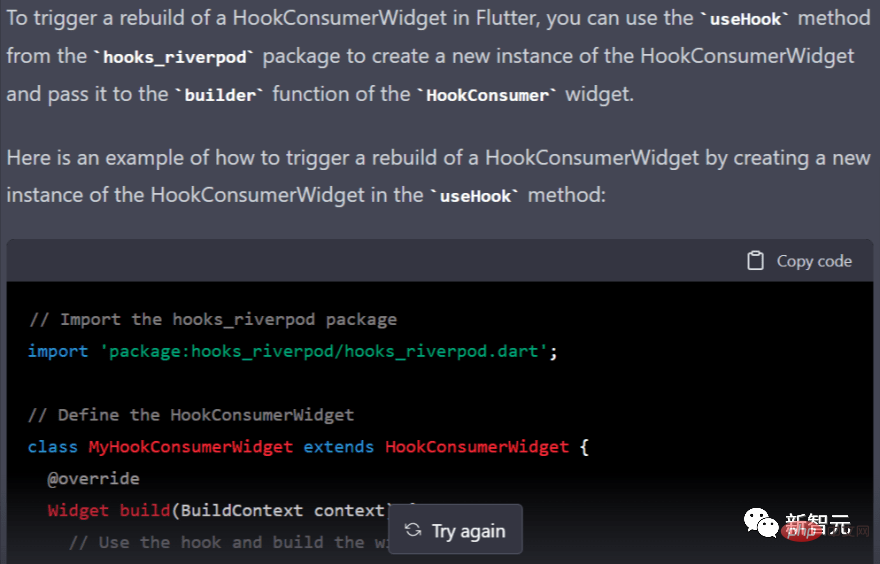

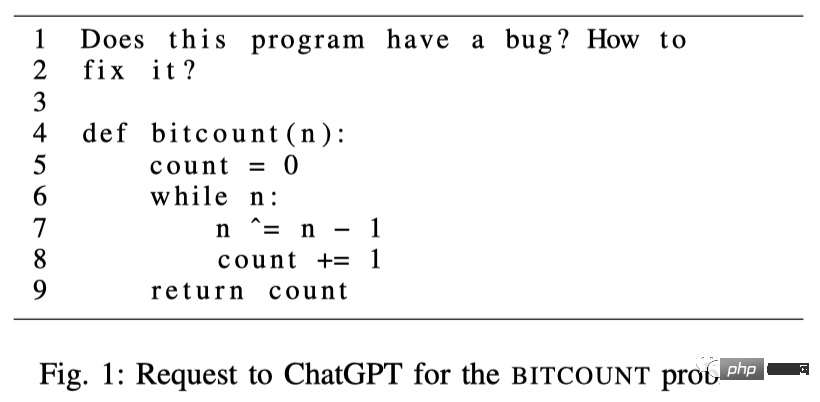

Während des Testprozesses entfernten die Forscher alle Kommentare und fragten ChatGPT, ob dieser Code einen Fehler habe und wie man ihn beheben könne.

Abbildung 1 ist beispielsweise ein Beispiel für das BITCOUNT-Problem. Darunter sind die Zeilen 1-2 Anfragen an ChatGPT; ab Zeile 4 handelt es sich um falsche Codefragmente.

Für dieses Beispiel hoffen wir, dass die Antwort von ChatGPT den Fehler in Zeile 7 behebt, d. h. nˆ= n - 1 sollte durch n &= n - 1 ersetzt werden. Als Antwort stellt ChatGPT entweder einen festen Code oder eine Beschreibung zur Verfügung, wie wir ihn ändern sollten.

Die Ergebnisse zeigen, dass ChatGPT 19 der 40 Fehler gelöst hat, was mit CoCoNut (19) und Codex (21) vergleichbar ist, aber die Standard-APR-Methode hat nur 7 davon gelöst.

Da sowohl ChatGPT als auch Codex aus derselben Sprachmodellreihe stammen, ist es natürlich nicht verwunderlich, dass die Anzahl der gelösten Probleme nahezu gleich ist.

Wenn wir uns die Ergebnisse genau ansehen, können wir außerdem feststellen, dass ChatGPT die Fehler im Benchmark nicht jedes Mal behebt. Nur bei den beiden Ausgaben BUCKETSORT und FLATTEN wurde der Fehler viermal gefunden, während die anderen in der Regel nur 1-2 Mal erfolgreich waren.

Mit anderen Worten: Benutzer müssen es möglicherweise mehrmals versuchen, um bei der tatsächlichen Verwendung die richtigen Ergebnisse zu erzielen.

ChatGPT hat jedoch einen großen Vorteil: Wir können im Gespräch mit dem System interagieren, die Frage detaillierter erklären und die richtige Antwort erhalten.

Die tatsächlichen Testergebnisse sind tatsächlich dieselben.

Nach weiteren Dialogen mit dem Modell konnten die Forscher die Genauigkeit von ChatGPT erfolgreich auf 77,5 % aktualisieren, was bedeutet, dass 31 der 40 Fehler behoben wurden, was SOTA weit übersteigt.

Zumindest scheint es vorerst möglich: Entwickler müssen keinen Boilerplate-Code mehr schreiben.

Stattdessen können sie sich auf Bereiche wie komplexe Anwendungsarchitektur oder Netzwerksicherheit konzentrieren.

Das heißt, ChatGPT übernimmt zwar möglicherweise einige Programmierarbeiten, z. B. das Schreiben allgemeiner Funktionen oder Boilerplate-Codes, wird Programmierer jedoch nicht vollständig ersetzen. Denn der Job eines Programmierers erfordert mehr als nur das Schreiben von Code.

Ein Programmierer zu sein erfordert Fähigkeiten – die Fähigkeit, Programme zu erstellen, der Logik zu folgen und etwas zu produzieren, das größer ist als die Summe seiner Teile.

Offensichtlich ist ChatGPT nicht das erste „Selbst-Iterations“-Produkt, das von Programmierern entwickelt wurde.

Lassen Sie uns eine Reihe von KIs aufstellen, die Code schreiben können.

Googles Pitchfork

Im November letzten Jahres gab es Gerüchte, dass Google ein geheimes Projekt schmiedet. Dieses Produkt würde maschinelles Lernen nutzen, um Codes zu trainieren, sich selbst zu programmieren, Fehler selbst zu beheben und sich selbst zu aktualisieren.

Nach Angaben von mit der Angelegenheit vertrauten Personen wurde dieses Projekt ursprünglich von Alphabets Moonshot-Abteilung, X Division, mit dem Codenamen Pitchfork entwickelt und letzten Sommer an Google Labs übertragen.

Internen Informationen zufolge besteht die Aufgabe von Pitchfork darin, „Code beizubringen, den man selbst schreiben und neu schreiben kann“.

Es kann verschiedene Programmierstile erlernen und Code entsprechend diesen Stilen schreiben.

Ein Google-Mitarbeiter sagte, dass die ursprüngliche Absicht bei der Entwicklung von Pitchfork darin bestand, ein Tool zu entwickeln, um die Python-Codebasis von Google auf eine neue Version zu aktualisieren.

AlphaCode: 72 % der Programmierer schlagen

Im Februar 2022 brachte DeepMind das System „AlphaCode“ auf den Markt, das künstliche Intelligenz zur Generierung von Code nutzen kann.

Laut DeepMind kann AlphaCode mit Menschen konkurrieren.

DeepMind hat AlphaCode anhand von 10 bestehenden Wettbewerben getestet, die auf der Programmierwettbewerbsplattform Codeforces gehostet wurden, und es landete insgesamt unter den besten 54,3 %, d. h. es schlug 46 % der Teilnehmer.

DeepMind behauptet, dass AlphaCode 34,2 % der Probleme in 1 Million Beispielen gelöst hat, als es mit der Programmierwettbewerbsplattform Codeforces getestet wurde.

Darüber hinaus rangierten die Daten von AlphaCode unter den Benutzern, die in den letzten 6 Monaten am Wettbewerb teilgenommen haben, unter den besten 28 %, was man sagen kann, dass sie „72 % der menschlichen Programmierer schlagen“!

Damals wies DeepMind darauf hin, dass AlphaCode zwar derzeit nur für wettbewerbsorientierte Programmierbereiche geeignet sei, es aber offensichtlich sei, dass seine zukünftigen Fähigkeiten hier nicht aufhören würden.

Es öffnet die Tür zur Entwicklung bestimmter Tools, die die Programmierung zugänglicher und eines Tages vollständig automatisiert machen.

Copilot: Code-Vervollständigungsartefakt

Im Jahr 2021 haben GitHub und OpenAI gemeinsam ein KI-Programmierartefakt eingeführt – GitHub Copilot.

Wenn Sie Code eingeben, fordert Copilot automatisch die Codeschnipsel an, die möglicherweise als nächstes im Programm erscheinen, genau wie ein Autovervollständigungsroboter, der darauf trainiert ist, in Python oder JavaScript zu sprechen.

Copilot kann notwendige Codeblöcke ausfüllen, sofern diese nicht besonders komplex oder kreativ sind, was sehr nützlich für die Programmierung ist, die einer manuellen Arbeit gleichkommt.

Am 22. Juni 2022 wurde Copilot offiziell für die C-Seite eingeführt, kostet 10 US-Dollar/Monat oder 100 US-Dollar/Jahr und wird studentischen Benutzern und Betreuern beliebter Open-Source-Projekte kostenlos zur Verfügung gestellt.

Tausende Entwickler nutzen mittlerweile Copilot. Bis zu 40 % des in einem Dutzend der beliebtesten Sprachen geschriebenen Codes basieren darauf, um Code zu generieren.

GitHub prognostiziert, dass Entwickler innerhalb von fünf Jahren bis zu 80 % ihres Codes mit Copilot schreiben werden.

Kevin Scott, Chief Technology Officer von Microsoft, sagte außerdem: „Wir sind davon überzeugt, dass GitHub Copilot auf Tausende verschiedener Arten von Arbeiten angewendet werden kann.“ Aufgrund angeblicher Verstöße wurde Copilot jedoch weniger als 5 Monate nach seiner Veröffentlichung veröffentlicht Verärgerte Programmierer gingen vor Gericht und forderten 9 Milliarden US-Dollar.

Kann ChatGPT, das „Software-Engineering-Denken“ gelernt hat, sie besiegen? Ich fürchte, wir werden bei dem Tempo von OpenAI nicht allzu lange warten müssen.

Referenz:

https ://www.zdnet.com/article/chatgpt-can-write-code-now-researchers-say-its-good-at-fixing-bugs-too/

Das obige ist der detaillierte Inhalt vonProgrammierer sind in Gefahr! Es heißt, dass OpenAI weltweit Outsourcing-Truppen rekrutiert und ChatGPT-Code-Farmer Schritt für Schritt schult. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

ChatGPT-Registrierung

ChatGPT-Registrierung

Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie

So installieren Sie ChatGPT auf einem Mobiltelefon

So installieren Sie ChatGPT auf einem Mobiltelefon

Kann Chatgpt in China verwendet werden?

Kann Chatgpt in China verwendet werden?

Implementierungsmethode für die Android-Sprachwiedergabefunktion

Implementierungsmethode für die Android-Sprachwiedergabefunktion

Verwendung des Oracle-Cursors

Verwendung des Oracle-Cursors

So lösen Sie den Fehlerbericht

So lösen Sie den Fehlerbericht

Tutorial zur Cloud-Server-Nutzung

Tutorial zur Cloud-Server-Nutzung