Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Einheitliche KI-Entwicklung: Google OpenXLA ist Open Source und integriert alle Frameworks und KI-Chips

Einheitliche KI-Entwicklung: Google OpenXLA ist Open Source und integriert alle Frameworks und KI-Chips

Einheitliche KI-Entwicklung: Google OpenXLA ist Open Source und integriert alle Frameworks und KI-Chips

Auf der Google Cloud Next 2022-Veranstaltung im Oktober letzten Jahres wurde das OpenXLA-Projekt offiziell vorgestellt, ein Open-Source-KI-Framework, das von Google und Technologieunternehmen wie Alibaba, AMD, Arm, Amazon, Intel, NVIDIA und gefördert wird Andere Technologieunternehmen setzen sich dafür ein, verschiedene Frameworks für maschinelles Lernen zusammenzuführen, um Entwicklern für maschinelles Lernen die Möglichkeit zu geben, Frameworks und Hardware proaktiv auszuwählen.

Am Mittwoch gab Google bekannt, dass das OpenXLA-Projekt offiziell Open Source ist.

Projektlink: https://github.com /openxla/xla

OpenXLA beschleunigt maschinelles Lernen durch die Erstellung eines einheitlichen Machine-Learning-Compilers, der mit vielen verschiedenen Machine-Learning-Frameworks und Hardwareplattformen zusammenarbeitet. Anwendungsbereitstellung und -bereitstellung größere Code-Portabilität. Dies ist ein bedeutendes Projekt für die KI-Forschung und -Anwendungen, und Jeff Dean hat es auch in sozialen Netzwerken beworben.

Heutzutage werden die Entwicklung und Bereitstellung von maschinellem Lernen durch eine fragmentierte Infrastruktur behindert. Die Auswirkungen Diese Infrastrukturen können je nach Framework, Hardware und Anwendungsfall variieren. Diese Isolation begrenzt die Geschwindigkeit, mit der Entwickler arbeiten können, und schafft Hindernisse für die Portabilität, Effizienz und Produktion von Modellen.

Am 8. März haben Google und andere mit der Eröffnung des OpenXLA-Projekts, das die Repositorys XLA, StableHLO und IREE umfasst, einen wichtigen Schritt zur Beseitigung dieser Hindernisse unternommen. Schritt.

OpenXLA ist ein Open-Source-ML-Compiler-Ökosystem, das gemeinsam von Branchenführern im Bereich KI/maschinelles Lernen entwickelt wurde. Zu den Mitwirkenden gehören Alibaba, AWS, AMD, Apple, Arm, Cerebras, Google, Graphcore, Hugging Face, Intel, Meta und Nvidia. Es ermöglicht Entwicklern, Modelle aus allen führenden Frameworks für maschinelles Lernen zu kompilieren und zu optimieren, um sie effizient zu trainieren und auf einer Vielzahl von Hardware bereitzustellen. Entwickler, die OpenXLA verwenden, können erhebliche Verbesserungen bei der Trainingszeit, dem Durchsatz, der Service-Latenz und letztendlich bei den Release- und Rechenkosten beobachten.

Herausforderungen für Einrichtungen der maschinellen Lerntechnologie

Während die KI-Technologie in die praktische Phase eintritt, nutzen Entwicklungsteams in vielen Branchen maschinelles Lernen, um reale Lösungen zu finden -weltliche Herausforderungen wie die Vorhersage und Prävention von Krankheiten, personalisierte Lernerfahrungen und die Erforschung der Physik schwarzer Löcher.

Da die Anzahl der Modellparameter exponentiell wächst und sich der Rechenaufwand für Deep-Learning-Modelle alle sechs Monate verdoppelt, sind Entwickler bestrebt, die Leistung und Auslastung der Infrastruktur zu maximieren. Eine große Anzahl von Teams nutzt eine Vielzahl von Hardwaremodellen, von energieeffizienten ASICs speziell für maschinelles Lernen im Rechenzentrum bis hin zu KI-Edge-Prozessoren, die schnellere Reaktionszeiten bieten. Um die Effizienz zu verbessern, verwenden diese Hardwaregeräte dementsprechend angepasste und einzigartige Algorithmen und Softwarebibliotheken.

Aber wenn es andererseits keinen universellen Compiler gibt, der verschiedene Hardwaregeräte mit den verschiedenen heute verwendeten Frameworks (wie TensorFlow, PyTorch) verbindet, wird man es tun Es erfordert viel Aufwand, maschinelles Lernen effektiv durchzuführen. In der Praxis müssen Entwickler die Modelloperationen für jedes Hardwareziel manuell optimieren. Das bedeutet, dass die Verwendung benutzerdefinierter Softwarebibliotheken oder das Schreiben gerätespezifischen Codes Domänenkenntnisse erfordert.

Dies ist ein paradoxes Ergebnis. Der Einsatz spezialisierter Technologie zur Verbesserung der Effizienz führt zu isolierten, nicht verallgemeinerbaren Pfaden über Frameworks und Hardware hinweg, was wiederum zu hohen Wartungskosten führt Dies führt zu einer Anbieterbindung und verlangsamt den Fortschritt der maschinellen Lernentwicklung.

Lösungen und Ziele

Das OpenXLA-Projekt bietet einen hochmodernen ML-Compiler, der mit der Komplexität der ML-Infrastruktur skaliert. Die Grundpfeiler sind Leistung, Skalierbarkeit, Portabilität, Flexibilität und Benutzerfreundlichkeit. Mit OpenXLA streben wir danach, das größere Potenzial der KI in der realen Welt auszuschöpfen, indem wir die Entwicklung und Bereitstellung von KI beschleunigen.

OpenXLA zielt darauf ab:

- Ermöglicht Entwicklern das einfache Kompilieren und Kompilieren für eine Vielzahl von Hardware in ihrem bevorzugten Framework mit einer einheitlichen Compiler-API, die mit jedem Framework funktioniert und auf dedizierte Geräte-Backends und Optimierungen zugreift. Optimieren Sie jedes Modell.

- Bietet branchenführende Leistung für aktuelle und neue Modelle und kann auch auf mehrere Hosts und Beschleuniger skaliert werden, um die Einschränkungen der Edge-Bereitstellung zu erfüllen und auf neue Modellarchitekturen zu verallgemeinern die Zukunft.

- Erstellen Sie eine mehrschichtige und skalierbare Compilerplattform für maschinelles Lernen, die Entwicklern MLIR-basierte Komponenten bietet, die für ihre individuellen Anwendungsfälle neu konfiguriert werden können und für einen an die Hardware angepassten Kompilierungsprozess verwendet werden.

AI/ML Leaders Community

Die Herausforderungen, denen wir heute in der Infrastruktur für maschinelles Lernen gegenüberstehen, sind riesig, das kann keine einzelne Organisation Diese Herausforderungen allein effektiv bewältigen können. Die OpenXLA-Community bringt Entwickler und Branchenführer zusammen, die auf verschiedenen Ebenen des KI-Stacks tätig sind – von Frameworks bis hin zu Compilern, Laufzeiten und Chips – und ist daher ideal geeignet, die Fragmentierung, die wir im ML-Bereich beobachten, anzugehen.

Als Open-Source-Projekt hält sich OpenXLA an die folgenden Grundsätze:

- Gleich Status: Einzelpersonen tragen gleichermaßen bei, unabhängig von ihrer Zugehörigkeit. Technische Führungskräfte sind diejenigen, die am meisten Zeit und Energie investieren.

- Respektieren Sie die Kultur: Von allen Mitgliedern wird erwartet, dass sie die Projektwerte und den Verhaltenskodex einhalten, unabhängig von ihrer Position in der Gemeinschaft.

- Skalierbare, effiziente Governance: Kleine Teams treffen konsensbasierte Entscheidungen mit klaren, aber selten genutzten Upgrade-Pfaden.

- Transparenz: Alle Entscheidungen und Begründungen sollten für die Öffentlichkeit klar sichtbar sein.

OpenXLA-Ökosystem: Leistung, Skalierbarkeit und Portabilität

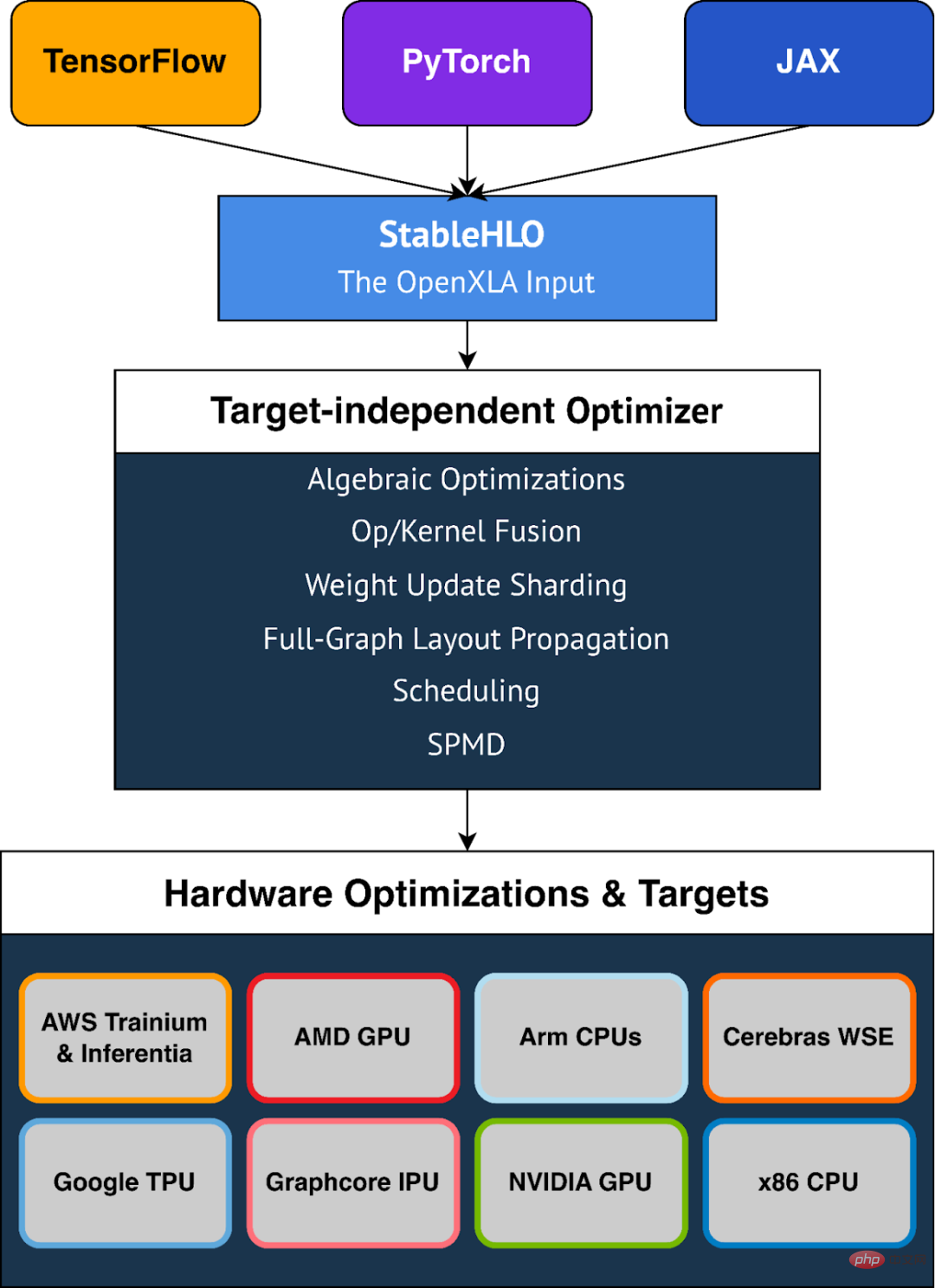

OpenXLA eliminiert die Entwicklung maschinellen Lernens mit modularen Toolchains. Es wird von allen führenden Unternehmen unterstützt Frameworks über eine gemeinsame Compiler-Schnittstelle, nutzt portable standardisierte Modelldarstellungen und stellt domänenspezifischen Compilern leistungsstarke zielorientierte und hardwarespezifische Optimierungen zur Verfügung. Die Toolchain umfasst XLA, StableHLO und IREE, die alle MLIR nutzen: eine Compiler-Infrastruktur, die es ermöglicht, Modelle für maschinelles Lernen konsistent auf Hardware darzustellen, zu optimieren und auszuführen.

OpenXLA Key Highlights

#🎜. 🎜 #Umfang der Anwendungsfälle für maschinelles Lernen

Die aktuelle Nutzung von OpenXLA deckt das Spektrum der ML-Anwendungsfälle ab, einschließlich DeepMinds AlphaFold, GPT2 und Swin auf Alibaba Cloud-Modellen wie z als Transformer verfügen über eine umfassende Ausbildung sowie multimodale LLM-Schulungen auf Amazon.com. Kunden wie Waymo nutzen OpenXLA für Echtzeit-Inferenz im Fahrzeug. Darüber hinaus wird OpenXLA verwendet, um Stable Diffusion-Dienste auf lokalen Maschinen zu optimieren, die mit AMD RDNA™ 3 ausgestattet sind.

Beste Leistung, sofort einsatzbereit

OpenXLA Use Developers kann die Modellleistung problemlos beschleunigen, ohne gerätespezifischen Code schreiben zu müssen. Es verfügt über umfassende Funktionen zur Modelloptimierung, einschließlich der Vereinfachung algebraischer Ausdrücke, der Optimierung des speicherinternen Datenlayouts und der Verbesserung der Planung, um die Spitzenspeichernutzung und den Kommunikationsaufwand zu reduzieren. Fortschrittliche Operator-Fusion und Kernel-Generierung tragen dazu bei, die Geräteauslastung zu verbessern und den Bedarf an Speicherbandbreite zu reduzieren.

Workloads einfach skalieren

Effiziente Parallelisierungsalgorithmen entwickeln Sehr zeitaufwändig und erfordert Fachwissen. Mit Funktionen wie GSPMD müssen Entwickler nur eine Teilmenge der Schlüsseltensoren mit Anmerkungen versehen, die dann vom Compiler verwendet werden können, um automatisch parallele Berechnungen zu generieren. Dadurch entfällt der erhebliche Aufwand für die Partitionierung und effiziente Parallelisierung von Modellen über mehrere Hardware-Hosts und Beschleuniger hinweg. #? --the-box-Unterstützung, einschließlich AMD- und NVIDIA-GPUs, x86-CPUs und ARM-Architekturen sowie ML-Beschleuniger wie Google TPU, AWS Trainium und Inferentia, Graphcore IPU, Cerebras Wafer-Scale Engine und mehr. OpenXLA unterstützt auch TensorFlow, PyTorch und JAX über StableHLO, eine tragbare Ebene, die als Eingabeformat für OpenXLA verwendet wird.

Flexibilität

OpenXLA bietet Benutzern die Flexibilität, Modell-Hotspots manuell anzupassen. Erweiterungsmechanismen wie benutzerdefinierte Aufrufe ermöglichen es Benutzern, Deep-Learning-Grundelemente in CUDA, HIP, SYCL, Triton und anderen Kernelsprachen zu schreiben, um die Hardwarefunktionen voll auszunutzen.

StableHLO

StableHLO ist eine tragbare Schicht zwischen ML-Frameworks und ML-Compilern, eine Reihe von Operationen, die High-Level-Operationen (HLO) für Dynamik, Quantisierung und Sparsity unterstützen. Darüber hinaus kann es in MLIR-Bytecode serialisiert werden, um Kompatibilitätsgarantien zu bieten. Alle wichtigen ML-Frameworks (JAX, PyTorch, TensorFlow) können StableHLO erzeugen. Im Jahr 2023 plant Google eine enge Zusammenarbeit mit dem PyTorch-Team, um die Integration mit PyTorch Version 2.0 zu erreichen.

Das obige ist der detaillierte Inhalt vonEinheitliche KI-Entwicklung: Google OpenXLA ist Open Source und integriert alle Frameworks und KI-Chips. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1375

1375

52

52

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Bei der Konvertierung von Zeichenfolgen in Objekte in Vue.js wird JSON.Parse () für Standard -JSON -Zeichenfolgen bevorzugt. Bei nicht standardmäßigen JSON-Zeichenfolgen kann die Zeichenfolge durch Verwendung regelmäßiger Ausdrücke verarbeitet und Methoden gemäß dem Format oder dekodierten URL-kodiert reduziert werden. Wählen Sie die entsprechende Methode gemäß dem String -Format aus und achten Sie auf Sicherheits- und Codierungsprobleme, um Fehler zu vermeiden.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

Zusammenfassung: Es gibt die folgenden Methoden zum Umwandeln von VUE.JS -String -Arrays in Objektarrays: Grundlegende Methode: Verwenden Sie die Kartenfunktion, um regelmäßige formatierte Daten zu entsprechen. Erweitertes Gameplay: Die Verwendung regulärer Ausdrücke kann komplexe Formate ausführen, müssen jedoch sorgfältig geschrieben und berücksichtigt werden. Leistungsoptimierung: In Betracht ziehen die große Datenmenge, asynchrone Operationen oder effiziente Datenverarbeitungsbibliotheken können verwendet werden. Best Practice: Clear Code -Stil, verwenden Sie sinnvolle variable Namen und Kommentare, um den Code präzise zu halten.

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen