Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Integration von GPT-Großmodellprodukten, WakeData neue Runde von Produkt-Upgrades

Integration von GPT-Großmodellprodukten, WakeData neue Runde von Produkt-Upgrades

Integration von GPT-Großmodellprodukten, WakeData neue Runde von Produkt-Upgrades

Kürzlich hat WakeData (im Folgenden als „WakeData“ bezeichnet) eine neue Runde von Produktfähigkeits-Upgrades abgeschlossen.

Auf der Produkteinführungskonferenz im November 2022 wurden die „drei Festlegungen“ von WakeData zum Ausdruck gebracht: stets fest in Technologie investieren, die wissenschaftlichen und technologischen Fähigkeiten umfassend festigen und die Fähigkeit zur Anpassung an Kernprodukte stets stärken; Lokalisierung, Unterstützung inländischer Chips, Betriebssysteme, Datenbanken, Middleware, nationale Geheimalgorithmen usw. und Erzielung einer lokalen Substitution ausländischer Hersteller im gleichen Bereich, die das Ökosystem immer fest umarmt und eine Win-Win-Situation mit Partnern schafft.

WakeData setzt eine neue Runde der Produktfähigkeitsverbesserungen fort und stützt sich auf seine Technologieakkumulation in den letzten fünf Jahren und seine Praxis in der Immobilien-, Einzelhandels-, Automobil- und anderen Branchen sowie vertikalen Bereichen und hat gemeinsam Branchenriesen mit privatisierten Einsatzfähigkeiten entwickelt Mit strategischen Partnern wird das Modell WakeMind mehr Unternehmen dabei helfen, sich zu revolutionieren, die Effizienz zu verbessern und die Produktivität im AIGC-Zeitalter weiter zu steigern.

Drei Hauptplattformschichten des WakeMind-Modells

Modellschicht: Die Mutterschiffplattform wird WakeMind mit privatisierten Bereitstellungs- und Branchenanpassungsfunktionen als Kernmotor verwenden und wurde mit großen Modellen wie ChatGPT verbunden und unterstützt auch den Zugriff auf mehrere große Modellfunktionen wie Wen Xinyiyan, Tongyi Qianwen usw.

Plattformebene: WakeMind basiert auf Prompt Engineering, Plugin, LangChain und anderen Methoden, um effiziente Dialogfunktionen mit Zugriff auf große Modelle zu erreichen. Auf der Grundlage des Zero-Sample-Learnings kann das Modell Kontextinformationen durch Prompt- und Plugin-Management besser verstehen, indem es Branchenkorpus einspeist, das Modell schnell Branchenwissen erlernen und über Branchen und vertikale Bereiche nachdenken und argumentieren kann.

Anwendungsschicht: Die WakeMind-Mutterschiffplattform bietet zugrunde liegende Funktionen, ermöglicht Produktanwendungen und Branchenszenarien nacheinander durch trägergestützte Flugzeuge und verbessert die interne Produktivität des Unternehmens.

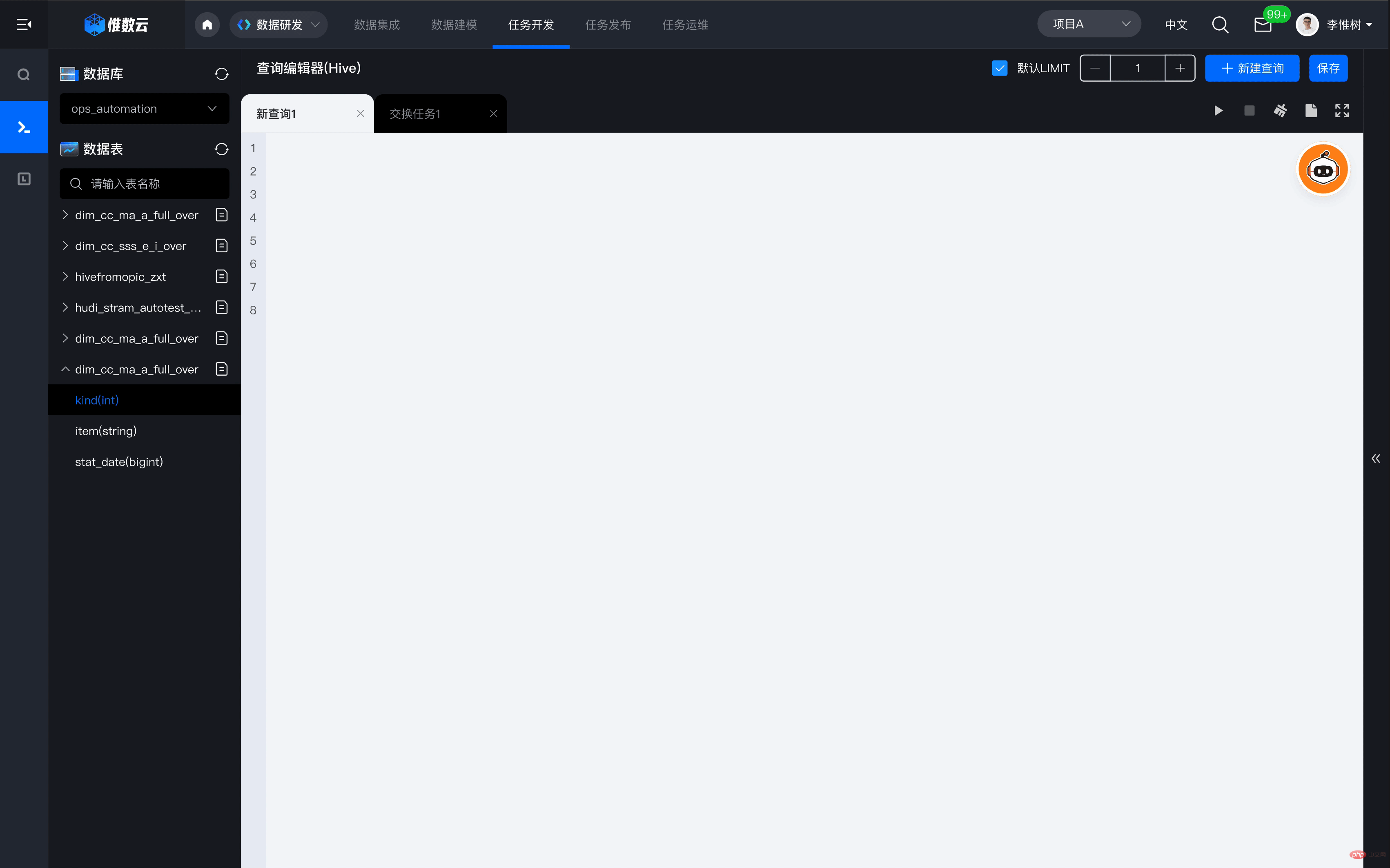

Wie stärkt beispielsweise die Mothership-Plattform die Weishu Cloud? Beim Aufbau und der Nutzung von Datenbeständen mit Hilfe der Weishu Cloud Platform müssen Unternehmen häufig eine große Anzahl professioneller Datenentwicklungsingenieure investieren, um sich an der Geschäftsbedarfsanalyse und Datenentwicklungsarbeit zu beteiligen, und es wird eine große Anzahl langwieriger Entwicklungsaufgaben anfallen Dies führt dazu, dass der gesamte Datenwertrealisierungszyklus verlängert wird. Basierend auf der Ermächtigung von WakeMind kann Weishu Cloud nur durch Textinteraktion automatisch entsprechende Datenabfrageanweisungen generieren und die Abfrage mit einem Klick ausführen, was die Effizienz der Datenabfrage, -analyse und -entwicklung erheblich verbessern und den technischen Schwellenwert für Daten umfassend senken kann nutzen, um das Ziel zu erreichen, Daten für alle verfügbar zu machen.

Drei Hauptmerkmale des WakeMind-Modells

1) Die Anzahl der Parameter eignet sich besser für industrielle und vertikale Feldszenarien. Um Inhalte auf menschlicher Ebene zu erreichen, müssen KI-generierte Inhalte häufig auf „Vortraining + Feinabstimmung“ großer Modelle basieren. WakeData hat sich mit dem branchenweit führenden Hersteller multimodaler vorab trainierter Großmodelle mit Hunderten von Milliarden Dollar zusammengetan von Parametern zur Komprimierung durch Wissensdestillation und dynamische Quantifizierung mit 10 Milliarden Parametern, basierend auf P-Tuning V2, können die Parameter, die einer Feinabstimmung bedürfen, auf ein Tausendstel des Originals reduziert werden. Dadurch wird der Rechenaufwand für die Feinabstimmung erheblich reduziert.

2) Texterstellung und Codegenerierung mit branchenspezifischen und vertikalen Feldfunktionen.

3) Unterstützen Sie den privatisierten Einsatz und die industrielle Anpassung. Führende Unternehmen in Branchen oder vertikalen Bereichen hoffen auf die Möglichkeit, den Einsatz und die branchenspezifische Anpassung großer Modelle zu privatisieren. Wie man ein effektives Vortraining mit kleinen Lernproben und geringem Rechenleistungsverbrauch durchführt, ist zur technischen Schwelle für industriell angepasste Modelle geworden. Die Ansammlung der Branchendaten und vertikalen Felddaten von WakeData wird es großen Branchenmodellen ermöglichen, über Branchen-Know-how zu verfügen und einzigartige Wettbewerbsvorteile zu schaffen.

Gleichzeitig übernimmt WakeMind die Transformer-Architektur, um Zehntausende von Befehlsfolge-Beispieldaten auf selbstanweisende Weise zu generieren. Es verwendet SFT (Supervised Fine-Tuning), RLHF und andere Technologien, um eine Absichtsausrichtung zu erreichen Durch INT8 können die Argumentationskosten erheblich gesenkt werden.

Großes Modell und industriell vorab trainiertes großes Modell

Seit OpneAI ChatGPT veröffentlicht hat, hat es einen enormen Einfluss auf die Welt gehabt. Das dahinter stehende Large Language Model (LLM) und RLHF (Reinforcement Learning from Human Feedback), ein Sprachmodell, das auf der Grundlage menschlichen Feedbacks mithilfe von Reinforcement Learning optimiert wurde, haben große Beachtung gefunden.

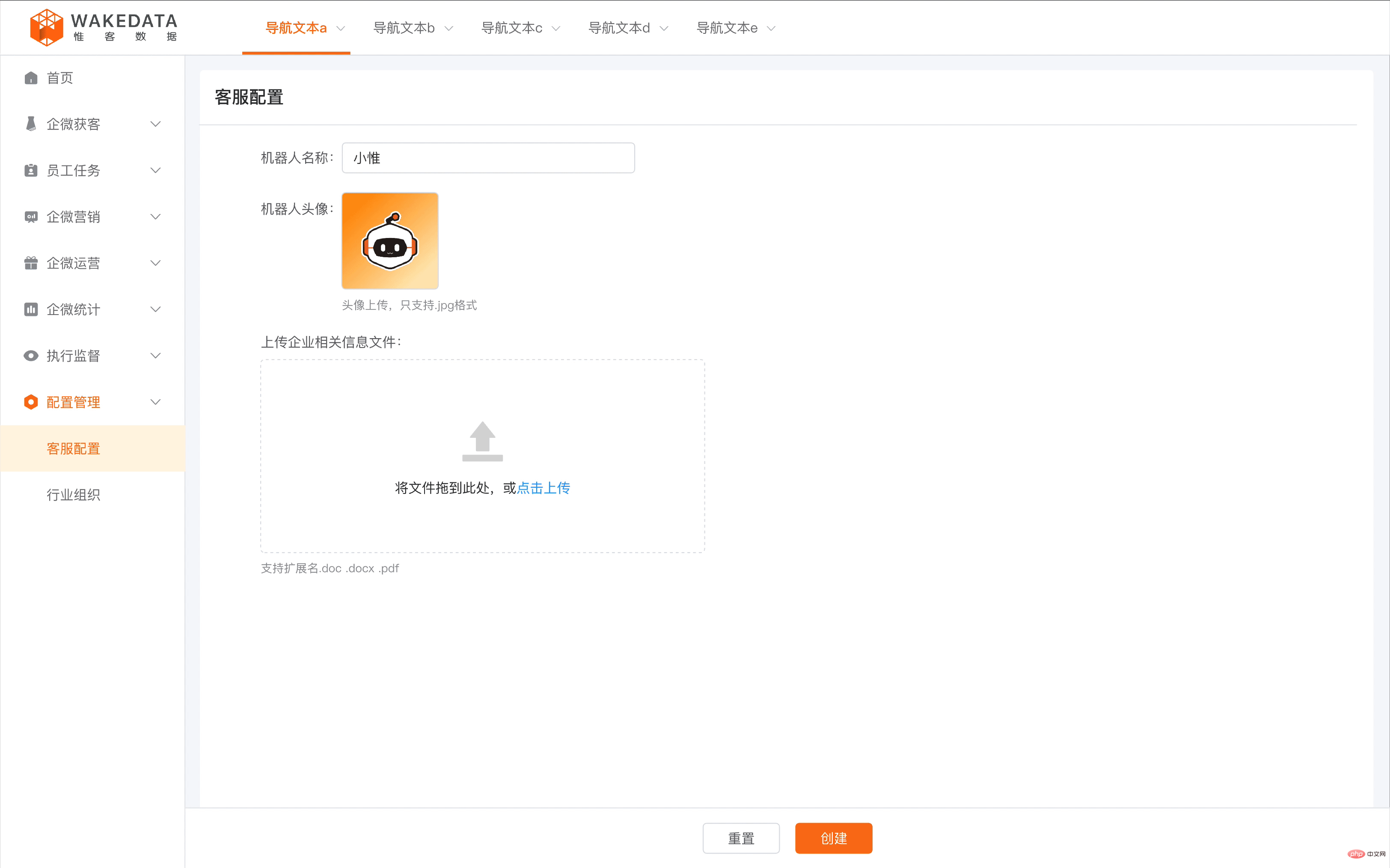

WakeData hat seit seinen Anfängen 11 KI-Modelle in den Bereichen NLP, Lebenslauf, Sprache und anderen Bereichen veröffentlicht. Darunter verfügt das große NLP-Semantikanalysemodell über die häufigsten Anwendungsszenarien. Beispielsweise ist SCRM in der Immobilien-, Automobil-, Markeneinzelhandels- und anderen Branchen mit geringer Frequenz und hohem Kundenstückpreis eine der effektivsten Methoden zur Verwaltung potenzieller Kunden und bestehender Kunden. Durch die Ansammlung von Branchenkorpus und spezifischer Vorschulung ermöglicht WakeData der KI, ein tiefes Verständnis der Branche zu entwickeln. Sie kann rund um die Uhr während des Gesprächs schnell auf Kundenfragen reagieren und Kunden-Tags basierend auf Gesprächsinformationen automatisch extrahieren Verbessern Sie die Auflösung von Kundenporträts.

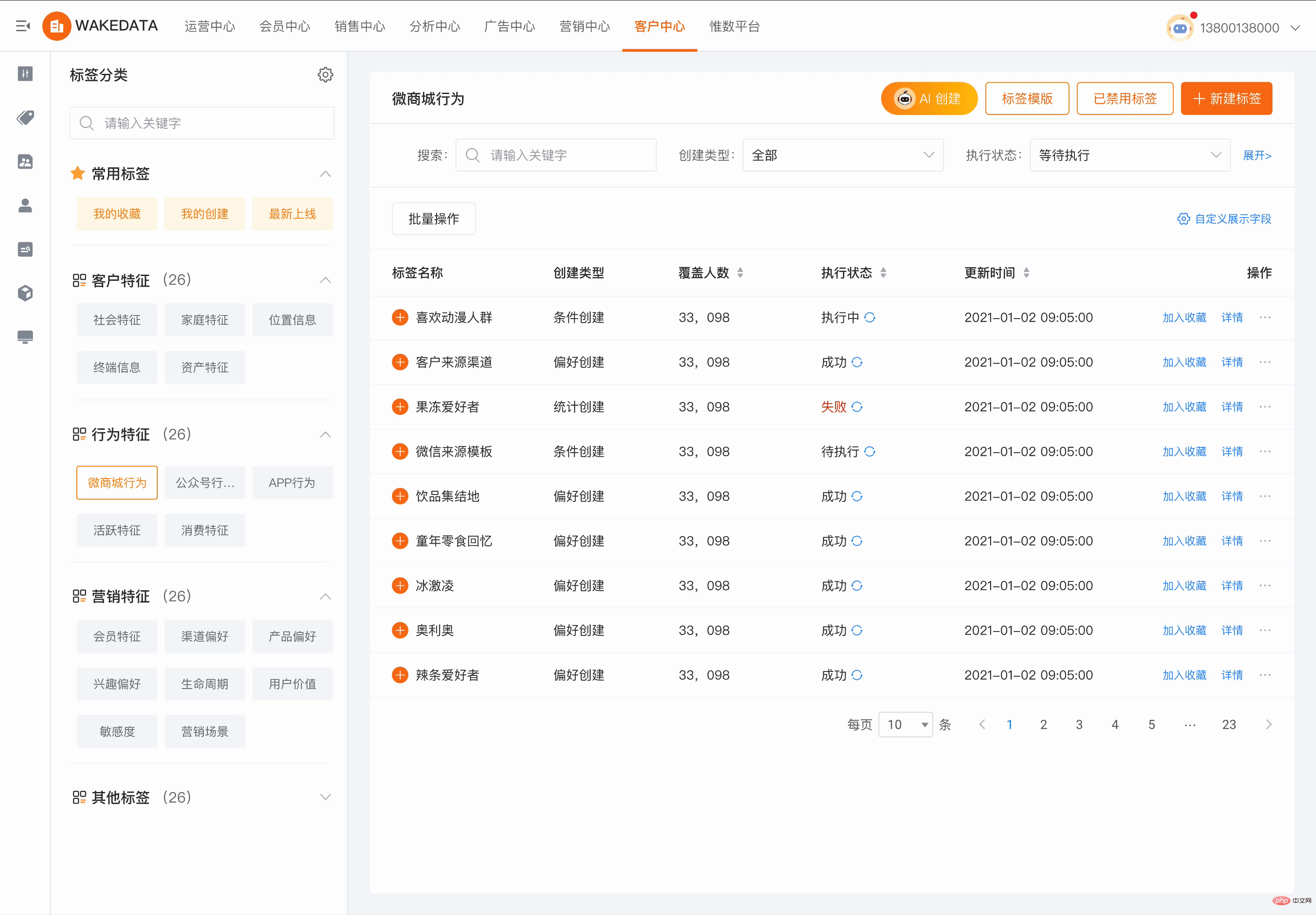

Bei WakeData decken die KI-Funktionen großer Modelle alles ab, von der Erstellung zugrunde liegender Kundendatenbestände über Kunden-Geschäftsreisen und Geschäftsregeln auf mittlerer Ebene bis hin zu Multi-Touch-Point-Marketing-Links auf oberer Ebene Das kann für den gesamten digitalen Kunden funktionieren. Die Fähigkeit, „Kosten zu senken, die Effizienz zu verbessern und zu stärken“. Im Bereich der CDP-Kundendatenplattform mussten Betreiber beispielsweise früher umständliche Regeln entwerfen, um die geeigneten Zielkundengruppen auszuwählen. Jetzt kann KI durch einfache Sprachbeschreibung und Dialog dabei helfen, die entsprechenden Zielkundengruppen zu finden, wodurch die Kosten erheblich reduziert werden Die Kosten für die Nutzung und das Lernen werden gesenkt und die Effizienz der Nutzung und das interaktive Erlebnis werden sprunghaft verbessert.

Im Bereich der MA-Marketingautomatisierung wurden die Produkte von WakeData mit dem WeChat-Ökosystem, Douyin, Xiaohongshu und anderen Berührungspunkten verbunden und unterstützen die automatisierte Erstellung von Marketingreisen und bieten eine umfangreiche Bibliothek mit Reisevorlagen, die Folgendes erreichen kann: „Echtzeitiger, persönlicher, personalisierter“ Benutzerkontakt. Ein wichtiger Teil davon ist die Erstellung personalisierter Marketingmaterialien, einschließlich Text, Bildern, gemischten Grafiken und Text usw. Große KI-Modelle können die Effizienz und Qualität dieses Teils erheblich verbessern und gleichzeitig die Kosten senken.

Wenn das Mitgliedschaftssystem im Bereich der Treuemitgliedschaft verschiedene Branchen und Geschäftsformate umfasst, wird es Herausforderungen bei der Vereinheitlichung der Mitgliedschaftsregeln und der Mitgliederressourcen geben. Das KI-Großmodell von WakeData basiert auf der Prompt-Engine, die auf einer großen Menge an Branchenerfahrung basiert und Korpustraining: Durch ein einfaches Gespräch, in dem die Merkmale und Geschäftsanforderungen verschiedener Geschäftsmitglieder beschrieben werden, können die Zuordnungslogik und das Kombinationsschema verschiedener Mitgliedschaftsregeln automatisch generiert werden.

Die Praxis großer Modelle in Branchen und vertikalen Bereichen hat sich bewährt.

Drei Phasen des Geschäftsweges von WakeMind

1) 2018–2021, eigene Modellanwendung und Kommerzialisierungsexplorationsphase. Basierend auf den drei grundlegenden Produktlinien Weishu Cloud, Weike Cloud und Kunlun Platform von WakeData wird das selbst entwickelte NLP-Großmodell umfassend erforscht und in vertikalen Bereichen wie Immobilien, neuer Einzelhandel, Automobile und digitales Marketing praktiziert.

2) 2022-2023, WakeMind-Veröffentlichung und Bauzeit der Mutterschiffplattform. WakeData arbeitet mit strategischen Partnern zusammen, um die Forschung und Entwicklung des branchenweit großen Modells WakeMind zu beschleunigen. Durch die Mothership-Plattform hat WakeMind die Möglichkeit, Branchen- und Branchenbereiche anzupassen, die Bereitstellung zu privatisieren und verfügt über die allgemeinen Zugriffs- und Verwaltungsfunktionen große Modelle zur Erzielung vorteilhafter Ergänzungen des Szenarios, die nicht durch eigene Modelle abgedeckt werden können.

3) Im Jahr 2023 und darüber hinaus wird der Bewerbungszeitraum für das WakeMind-Modell vollständig eingetragen. Basierend auf den Fähigkeiten der Mothership-Plattform ist WakeMind vollständig mit Produktlinien wie Weike Cloud, Weishu Cloud und Kunlun Platform verbunden. Durch die Anhäufung von Branchenwissen, die Optimierung von Branchenszenarien und die zeitnahe technische Schulung der Branche verbessert WakeMind die Branchenfähigkeiten von das Modell und wird größere kommerzielle Anwendungen in den Bereichen Immobilien, neuer Einzelhandel, Automobil und anderen Branchen einführen. Gleichzeitig hat WakeData selbst damit begonnen, seine eigene Produktivitätsrevolution zu verwirklichen, die auf den Fähigkeiten der WakeMind-Mutterschiffplattform basiert.

Wie WakeData KI nutzt, um Produktivität freizusetzen

WakeDatas Mission ist definiert als „Daten aufwecken“ und ist seit vielen Jahren im Bereich der Big-Data-Plattformen tätig. Als TOB-Enterprise-Services-Unternehmen sieht WakeData große Chancen in der „Verwendung großer Modelle“ und deckt die Verwendung großer Modelle in zwei Aspekten ab: Einerseits integriert es große Modelle in Produkte und andererseits hilft es Interne Unternehmen von Designern, Programmierern und anderen nutzen große Modelle für die Produktentwicklung und die Lieferung von Kundenprojekten.

Es gibt zwei Grundelemente für den Zugriff und die Anwendung großer Modelle, anwendbarere Szenarien und Big-Data-KI-Funktionen. Die beiden Hauptprodukte „Weike Cloud“ und „Weishu Cloud“ sind für den Zugriff auf große Modelle vorgesehen . Weike Cloud kann große Modelltools auf Basis digitaler Branchenanwendungen bequemer und nahtloser verbinden, und Kunden müssen sich nicht um die komplexe Konfiguration und technische Optimierung hinter der Anwendung kümmern. Weike Cloud kann zeitnahe Optimierungsprojekte und vertikale Modelle auf Basis von Branchenhilfeszenarien anwenden . Dies ist auch der Produktlösungsvorteil, an dem WakeData immer festgehalten hat: Plattform + Anwendung.

Gleichzeitig unterteilt WakeData große Modellzugangsprodukte in zwei Kategorien. Die eine basiert auf dem Produkt- und Branchenzugangszugang. Der Schwerpunkt dieser Zugangsart liegt auf der Optimierung von Erfahrung und Branchenwissen, um Kunden schnell und bequem zu helfen Der zweite Typ besteht darin, vertikale Szenarien auf der Grundlage von Produktarchitekturen und großen Open-Source-Modellen zu optimieren. Gleichzeitig entspricht er den Anforderungen großer Kunden Durch Branchenverständnis kann das Modell kontinuierlich optimiert und aufrechterhalten werden, um die Wettbewerbsfähigkeit solcher Kunden in vertikalen Branchen sicherzustellen.

„Unternehmen müssen große Modelle in die digitale Transformation und das digitale Kundenmanagement integrieren. Big Data und Szenarien sind zwei Schlüsselelemente.“

Unter normalen Umständen erfordern große Modelle eine große Datenmenge für ein effektives Training, daher ist es von entscheidender Bedeutung, über die Fähigkeiten einer industriellen Datenplattform zu verfügen. Kürzlich hat die Cyberspace Administration of China die „Measures for the Management of Generative Artificial Intelligence Services (Draft for Comments)“ veröffentlicht, in denen insbesondere die Rechtskonformität von Trainings- und Pre-Training-Datenquellen sowie die Authentizität, Genauigkeit und Objektivität hervorgehoben werden und Vielfalt der Daten. Die Wertanwendungsszenarien großer Modelle sind ein wichtiger Faktor bei der Entwicklung und Kommerzialisierung großer Modelle. Die sogenannten Szenarien beziehen sich auf den Zweck der von uns trainierten Modelle und darauf, ob sie unter der Voraussetzung der Einhaltung gesetzlicher Vorschriften einen Kernwert für das Unternehmen schaffen können .

Li Kechen glaubt, dass Szenarien Umgebungen sind, in denen große Modelle verwendet werden, und dass die Grundlage von Big Data und KI-Technologie Fähigkeiten sind; Unternehmen mit Branchenszenarien und Branchendaten werden bei der Akquise großer Unternehmen schneller und effektiver sein Modellfähigkeiten.

Die beiden Kernproduktlinien von WakeData sind die Kombination dieser beiden Elemente. Weishu Cloud verfügt als Datenplattform der neuen Generation über leistungsstarke Eed-to-End-Datenverarbeitungsfunktionen für Big Data Die Kundenverwaltungsplattform Weike Cloud umfasst CDP, MA, SCRM, Loyalty und andere Suiten und verfügt über eine große Anzahl von Geschäftsanwendungsszenarien. Durch die Strategie der tiefgreifenden Kultivierung in vertikalen Branchen verfügt sie über ein stärkeres Branchen-Know-how und ein besseres Verständnis der Branche. Viele wertvolle Trainingsbeispieldaten. Weishu Cloud wird Version 5.0 im Jahr 2022 veröffentlichen. Die Funktionen zur Datenintegration, Datenberechnung, Datenanalyse und -verwaltung, Datenvisualisierung und Datenassetisierung bieten alle branchenführende Vorteile. Diese datenseitigen Vorteile sind im Zeitalter großer Modelle auch zu Wettbewerbshindernissen für industrialisierte Anwendungen der künstlichen Intelligenz geworden.

„In WakeData wurde zunächst eine Arbeitsatmosphäre geschaffen, die die Produktivitätsfreisetzung fördert. WakeMind-Funktionen wurden in Bereichen wie Produktdesign, Entwicklungstests und Marketingabläufen eingesetzt. Die erste Anwendung hat einen Menschen erreicht.“ Effizienzsteigerung um 20 % Während die Produktentwicklung beschleunigt wird, verbessert sich auch die Effizienz der Kundenprojektabwicklung und spart Zeit und Kosten bei der digitalen Projektumsetzung der Kunden“, sagte Qian Yong, CTO von WakeData.

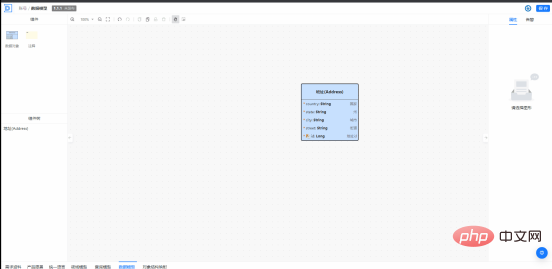

Die Kunlun-Plattform besteht aus drei Teilen: Basis-Cloud, Entwicklungs-Cloud und integrierte Cloud. Sie ist eine sehr wichtige Cloud-native Technologiebasis im Prozess der WakeData-Produktentwicklung und -Implementierung. Kunlun Platform Development Cloud wird von WakeMind unterstützt und erforscht bereits Anwendungen wie „basierend auf der Produktdokumentation, die Unterstützung bei der Erstellung des entsprechenden Architekturdesigns und des Datenmodelldesigns und die anschließende Unterstützung bei der Generierung von Code und der Erkennung der Korrektheit des Codes“. Beispielsweise kann WakeMind bei der Förderung des domänengesteuerten Designs beim Erlernen von DDD helfen und Ingenieure bei der Domänenmodellierung im Prozess der Datenmodellierung unterstützen. Datenmodelle können durch Interaktion mit natürlicher Sprache erstellt, geändert, automatisch ergänzt und verbessert werden. und eine schnelle Produktion kann während des Produktentwicklungsprozesses durch die Eingabe von Produktdokumenten, das Extrahieren und Generieren eines Produktglossars und die Bereitstellung detaillierter Erklärungen usw. erreicht werden. Für normale Ingenieure kann die Entwicklungseffizienz beim Generieren von Regelcode, beim automatischen Generieren von Komponententests, bei Codeüberprüfungen und in Bereichen wie der Optimierung erheblich verbessert werden.

WakeMind bietet einen Assistenten zur Erstellung von Texten, der allen zur Verfügung steht.

Die Marketingabteilung erstellt mithilfe von Text to Video von AI schnell eine Marketing-Wachstumsmatrix.

Die Stärkung von Branchen und vertikalen Bereichen durch AIGC ist ein unvermeidlicher Trend und seit seiner Gründung auch der zentrale Entwicklungspfad von WakeData. WakeData hat stets eine offene und offene Haltung gegenüber ChatGPT-ähnlichen Technologien und Diensten bewahrt und sich aktiv daran beteiligt. Basierend auf der Strategie, sich auf industrialisierte Betriebe zu konzentrieren, hat WakeData seinen Weg zur Wertschöpfung und Kommerzialisierung fest im Griff. Das große Branchenmodell WakeMind von WakeMind wird mehr Unternehmen dabei helfen, sich selbst zu revolutionieren, die Effizienz zu verbessern und die Produktivität im AIGC-Zeitalter weiter zu steigern.

Die Stärkung von Branchen und vertikalen Bereichen durch AIGC ist ein unvermeidlicher Trend und seit seiner Gründung auch der zentrale Entwicklungspfad von WakeData. WakeData hat stets eine offene und offene Haltung gegenüber ChatGPT-ähnlichen Technologien und Diensten bewahrt und sich aktiv daran beteiligt. Basierend auf der Strategie, sich auf industrialisierte Betriebe zu konzentrieren, hat WakeData seinen Weg zur Wertschöpfung und Kommerzialisierung fest im Griff. Das große Branchenmodell WakeMind von WakeMind wird mehr Unternehmen dabei helfen, sich selbst zu revolutionieren, die Effizienz zu verbessern und die Produktivität im AIGC-Zeitalter weiter zu steigern.

Das obige ist der detaillierte Inhalt vonIntegration von GPT-Großmodellprodukten, WakeData neue Runde von Produkt-Upgrades. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1379

1379

52

52

Die große Model-App Tencent Yuanbao ist online! Hunyuan wird zu einem Allround-KI-Assistenten aufgerüstet, der überall hin mitgenommen werden kann

Jun 09, 2024 pm 10:38 PM

Die große Model-App Tencent Yuanbao ist online! Hunyuan wird zu einem Allround-KI-Assistenten aufgerüstet, der überall hin mitgenommen werden kann

Jun 09, 2024 pm 10:38 PM

Am 30. Mai kündigte Tencent ein umfassendes Upgrade seines Hunyuan-Modells an. Die auf dem Hunyuan-Modell basierende App „Tencent Yuanbao“ wurde offiziell eingeführt und kann in den App-Stores von Apple und Android heruntergeladen werden. Im Vergleich zur Hunyuan-Applet-Version in der vorherigen Testphase bietet Tencent Yuanbao Kernfunktionen wie KI-Suche, KI-Zusammenfassung und KI-Schreiben für Arbeitseffizienzszenarien. Yuanbaos Gameplay ist außerdem umfangreicher und bietet mehrere Funktionen für KI-Anwendungen , und neue Spielmethoden wie das Erstellen persönlicher Agenten werden hinzugefügt. „Tencent strebt nicht danach, der Erste zu sein, der große Modelle herstellt.“ Liu Yuhong, Vizepräsident von Tencent Cloud und Leiter des großen Modells von Tencent Hunyuan, sagte: „Im vergangenen Jahr haben wir die Fähigkeiten des großen Modells von Tencent Hunyuan weiter gefördert.“ . In die reichhaltige und umfangreiche polnische Technologie in Geschäftsszenarien eintauchen und gleichzeitig Einblicke in die tatsächlichen Bedürfnisse der Benutzer gewinnen

Das große Bytedance Beanbao-Modell wurde veröffentlicht. Der Full-Stack-KI-Dienst Volcano Engine unterstützt Unternehmen bei der intelligenten Transformation

Jun 05, 2024 pm 07:59 PM

Das große Bytedance Beanbao-Modell wurde veröffentlicht. Der Full-Stack-KI-Dienst Volcano Engine unterstützt Unternehmen bei der intelligenten Transformation

Jun 05, 2024 pm 07:59 PM

Tan Dai, Präsident von Volcano Engine, sagte, dass Unternehmen, die große Modelle gut implementieren wollen, vor drei zentralen Herausforderungen stehen: Modelleffekt, Inferenzkosten und Implementierungsschwierigkeiten: Sie müssen über eine gute Basisunterstützung für große Modelle verfügen, um komplexe Probleme zu lösen, und das müssen sie auch Dank der kostengünstigen Inferenzdienste können große Modelle weit verbreitet verwendet werden, und es werden mehr Tools, Plattformen und Anwendungen benötigt, um Unternehmen bei der Implementierung von Szenarien zu unterstützen. ——Tan Dai, Präsident von Huoshan Engine 01. Das große Sitzsackmodell feiert sein Debüt und wird häufig genutzt. Das Polieren des Modelleffekts ist die größte Herausforderung für die Implementierung von KI. Tan Dai wies darauf hin, dass ein gutes Modell nur durch ausgiebigen Gebrauch poliert werden kann. Derzeit verarbeitet das Doubao-Modell täglich 120 Milliarden Text-Tokens und generiert 30 Millionen Bilder. Um Unternehmen bei der Umsetzung groß angelegter Modellszenarien zu unterstützen, wird das von ByteDance unabhängig entwickelte Beanbao-Großmodell durch den Vulkan gestartet

Mithilfe der Shengteng-KI-Technologie hilft das Qinling·Qinchuan-Transportmodell Xi'an beim Aufbau eines intelligenten Transportinnovationszentrums

Oct 15, 2023 am 08:17 AM

Mithilfe der Shengteng-KI-Technologie hilft das Qinling·Qinchuan-Transportmodell Xi'an beim Aufbau eines intelligenten Transportinnovationszentrums

Oct 15, 2023 am 08:17 AM

„Hohe Komplexität, hohe Fragmentierung und Cross-Domain“ waren schon immer die Hauptprobleme auf dem Weg zur digitalen und intelligenten Modernisierung der Transportbranche. Kürzlich ist das „Qinling·Qinchuan Traffic Model“ mit einer Parameterskala von 100 Milliarden, das gemeinsam von China Science Vision, der Bezirksregierung Xi'an Yanta und dem Xi'an Future Artificial Intelligence Computing Center entwickelt wurde, auf den Bereich des intelligenten Transports ausgerichtet und bietet Dienstleistungen für Xi'an und die umliegenden Gebiete. Die Region wird ein Dreh- und Angelpunkt für intelligente Transportinnovationen sein. Das „Qinling·Qinchuan Traffic Model“ kombiniert Xi'ans umfangreiche lokale verkehrsökologische Daten in offenen Szenarien, den ursprünglich von China Science Vision unabhängig entwickelten fortschrittlichen Algorithmus und die leistungsstarke Rechenleistung der Shengteng AI des Xi'an Future Artificial Intelligence Computing Center Überwachung des Straßennetzes, intelligente Transportszenarien wie Notfallkommando, Wartungsmanagement und öffentlicher Verkehr führen zu digitalen und intelligenten Veränderungen. Das Verkehrsmanagement weist in verschiedenen Städten und auf verschiedenen Straßen unterschiedliche Merkmale auf

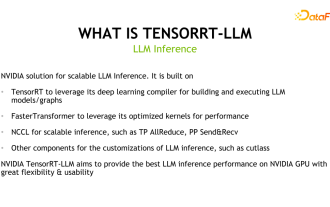

Entdeckung des NVIDIA-Inferenz-Frameworks für große Modelle: TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

Entdeckung des NVIDIA-Inferenz-Frameworks für große Modelle: TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

1. Produktpositionierung von TensorRT-LLM TensorRT-LLM ist eine von NVIDIA entwickelte skalierbare Inferenzlösung für große Sprachmodelle (LLM). Es erstellt, kompiliert und führt Berechnungsdiagramme auf der Grundlage des TensorRT-Deep-Learning-Kompilierungsframeworks aus und stützt sich auf die effiziente Kernels-Implementierung in FastTransformer. Darüber hinaus nutzt es NCCL für die Kommunikation zwischen Geräten. Entwickler können Betreiber entsprechend der Technologieentwicklung und Nachfrageunterschieden an spezifische Anforderungen anpassen, beispielsweise durch die Entwicklung maßgeschneiderter GEMM auf Basis von Entermessern. TensorRT-LLM ist die offizielle Inferenzlösung von NVIDIA, die sich der Bereitstellung hoher Leistung und der kontinuierlichen Verbesserung ihrer Praktikabilität verschrieben hat. TensorRT-LL

Benchmark GPT-4! Das große Jiutian-Modell von China Mobile hat die doppelte Registrierung bestanden

Apr 04, 2024 am 09:31 AM

Benchmark GPT-4! Das große Jiutian-Modell von China Mobile hat die doppelte Registrierung bestanden

Apr 04, 2024 am 09:31 AM

Laut Nachrichten vom 4. April hat die Cyberspace Administration of China kürzlich eine Liste registrierter großer Modelle veröffentlicht, in der das „Jiutian Natural Language Interaction Large Model“ von China Mobile enthalten ist, was darauf hinweist, dass das große Jiutian AI-Modell von China Mobile offiziell generative künstliche Intelligenz bereitstellen kann Geheimdienste nach außen. China Mobile gab an, dass dies das erste groß angelegte Modell sei, das von einem zentralen Unternehmen entwickelt wurde und sowohl die nationale Doppelregistrierung „Generative Artificial Intelligence Service Registration“ als auch die „Domestic Deep Synthetic Service Algorithm Registration“ bestanden habe. Berichten zufolge zeichnet sich Jiutians großes Modell für die Interaktion mit natürlicher Sprache durch verbesserte Branchenfähigkeiten, Sicherheit und Glaubwürdigkeit aus und unterstützt die vollständige Lokalisierung. Es hat mehrere Parameterversionen wie 9 Milliarden, 13,9 Milliarden, 57 Milliarden und 100 Milliarden gebildet. und kann flexibel in der Cloud eingesetzt werden, Edge und End sind unterschiedliche Situationen

Fortgeschrittene Praxis des industriellen Wissensgraphen

Jun 13, 2024 am 11:59 AM

Fortgeschrittene Praxis des industriellen Wissensgraphen

Jun 13, 2024 am 11:59 AM

1. Einführung in den Hintergrund Lassen Sie uns zunächst die Entwicklungsgeschichte von Yunwen Technology vorstellen. Yunwen Technology Company ... 2023 ist die Zeit, in der große Modelle vorherrschen. Viele Unternehmen glauben, dass die Bedeutung von Diagrammen nach großen Modellen stark abgenommen hat und die zuvor untersuchten voreingestellten Informationssysteme nicht mehr wichtig sind. Mit der Förderung von RAG und der Verbreitung von Data Governance haben wir jedoch festgestellt, dass eine effizientere Datenverwaltung und qualitativ hochwertige Daten wichtige Voraussetzungen für die Verbesserung der Wirksamkeit privatisierter Großmodelle sind. Deshalb beginnen immer mehr Unternehmen, darauf zu achten zu wissenskonstruktionsbezogenen Inhalten. Dies fördert auch den Aufbau und die Verarbeitung von Wissen auf einer höheren Ebene, wo es viele Techniken und Methoden gibt, die erforscht werden können. Es ist ersichtlich, dass das Aufkommen einer neuen Technologie nicht alle alten Technologien besiegt, sondern auch neue und alte Technologien integrieren kann.

Neuer Test-Benchmark veröffentlicht, der leistungsstärkste Open-Source-Llama 3 ist peinlich

Apr 23, 2024 pm 12:13 PM

Neuer Test-Benchmark veröffentlicht, der leistungsstärkste Open-Source-Llama 3 ist peinlich

Apr 23, 2024 pm 12:13 PM

Wenn die Testfragen zu einfach sind, können sowohl Spitzenschüler als auch schlechte Schüler 90 Punkte erreichen, und der Abstand kann nicht vergrößert werden ... Mit der Veröffentlichung stärkerer Modelle wie Claude3, Llama3 und später sogar GPT-5 ist die Branche in Bewegung Dringender Bedarf an einem schwierigeren und differenzierteren Benchmark-Modell. LMSYS, die Organisation hinter der großen Modellarena, brachte den Benchmark der nächsten Generation, Arena-Hard, auf den Markt, der große Aufmerksamkeit erregte. Es gibt auch die neueste Referenz zur Stärke der beiden fein abgestimmten Versionen der Llama3-Anweisungen. Im Vergleich zu MTBench, das zuvor ähnliche Ergebnisse erzielte, stieg die Arena-Hard-Diskriminierung von 22,6 % auf 87,4 %, was auf den ersten Blick stärker und schwächer ist. Arena-Hard basiert auf menschlichen Echtzeitdaten aus der Arena und seine Übereinstimmungsrate mit menschlichen Vorlieben liegt bei bis zu 89,1 %.

Xiaomi Byte schließt sich zusammen! Ein großes Modell von Xiao Ais Zugang zu Doubao: bereits auf Mobiltelefonen und SU7 installiert

Jun 13, 2024 pm 05:11 PM

Xiaomi Byte schließt sich zusammen! Ein großes Modell von Xiao Ais Zugang zu Doubao: bereits auf Mobiltelefonen und SU7 installiert

Jun 13, 2024 pm 05:11 PM

Laut Nachrichten vom 13. Juni hat Xiaomis Assistent für künstliche Intelligenz „Xiao Ai“ laut Bytes öffentlichem Bericht „Volcano Engine“ eine Zusammenarbeit mit Volcano Engine erzielt. Die beiden Parteien werden ein intelligenteres interaktives KI-Erlebnis auf der Grundlage des großen Beanbao-Modells erzielen . Berichten zufolge kann das von ByteDance erstellte groß angelegte Beanbao-Modell bis zu 120 Milliarden Text-Tokens effizient verarbeiten und täglich 30 Millionen Inhalte generieren. Xiaomi nutzte das große Doubao-Modell, um die Lern- und Denkfähigkeiten seines eigenen Modells zu verbessern und einen neuen „Xiao Ai Classmate“ zu schaffen, der nicht nur die Benutzerbedürfnisse genauer erfasst, sondern auch eine schnellere Reaktionsgeschwindigkeit und umfassendere Inhaltsdienste bietet. Wenn ein Benutzer beispielsweise nach einem komplexen wissenschaftlichen Konzept fragt, &ldq