Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Das Shanghai Digital Brain Research Institute veröffentlicht DB1, Chinas erstes großes multimodales Entscheidungsmodell, das eine schnelle Entscheidungsfindung bei äußerst komplexen Problemen ermöglichen kann

Das Shanghai Digital Brain Research Institute veröffentlicht DB1, Chinas erstes großes multimodales Entscheidungsmodell, das eine schnelle Entscheidungsfindung bei äußerst komplexen Problemen ermöglichen kann

Das Shanghai Digital Brain Research Institute veröffentlicht DB1, Chinas erstes großes multimodales Entscheidungsmodell, das eine schnelle Entscheidungsfindung bei äußerst komplexen Problemen ermöglichen kann

Kürzlich hat das Shanghai Digital Brain Research Institute (im Folgenden als „Digital Brain Research Institute“ bezeichnet) das erste groß angelegte multimodale Entscheidungsfindungsmodell für das digitale Gehirn (als DB1 bezeichnet) auf den Markt gebracht und damit die inländische Lücke in diesem Bereich geschlossen und weitere Überprüfung des Einsatzpotenzials vorab trainierter Modelle in der Text-, Grafiktext-, Reinforcement-Learning-Entscheidungsfindung und Betriebsoptimierungsentscheidungsfindung. Derzeit haben wir den DB1-Code als Open Source auf Github bereitgestellt, Projektlink: https://github.com/Shanghai-Digital-Brain-Laboratory/BDM-DB1.

Zuvor schlug das Institut für Mathematische Wissenschaften in einigen Fällen Multiagentenmodelle wie MADT (https://arxiv.org/abs/2112.02845)/MAT (https://arxiv.org/abs/2205.14953) vor Große Offline-Modelle Durch Sequenzmodellierung hat das Transformer-Modell bei einigen Einzel-/Multi-Agent-Aufgaben bemerkenswerte Ergebnisse erzielt, und die Forschung und Erforschung in dieser Richtung wird fortgesetzt.

In den letzten Jahren haben Wissenschaft und Industrie mit dem Aufkommen groß angelegter Vortrainingsmodelle weiterhin neue Fortschritte bei der Parametermenge und den multimodalen Aufgaben von Vortrainingsmodellen erzielt -Trainingsmodelle wurden auf riesigen Datenmengen trainiert. Die tiefe Modellierung von Wissen und Wissen gilt als einer der wichtigen Wege zur allgemeinen künstlichen Intelligenz. Das Digital Research Institute, das sich auf die Entscheidungsintelligenzforschung konzentriert, versuchte auf innovative Weise, den Erfolg des vorab trainierten Modells auf Entscheidungsaufgaben zu übertragen, und erzielte einen Durchbruch.

Multimodales Entscheidungsfindungs-Großmodell DB1

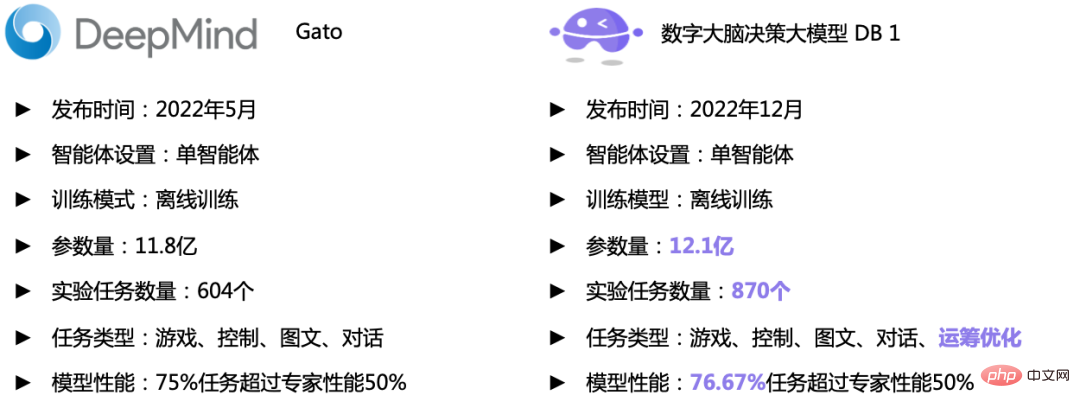

Zuvor hat DeepMind Gato gestartet, das Einzelagenten-Entscheidungsaufgaben, Mehrrundengespräche und Bild-Text-Generierungsaufgaben in einem Transformer-basierten autoregressiven Problem vereint und weiterführt 604 Es hat bei verschiedenen Aufgaben eine gute Leistung erzielt und gezeigt, dass einige einfache Entscheidungsprobleme beim Verstärkungslernen durch Sequenzvorhersage gelöst werden können, wodurch die Richtigkeit der Forschungsrichtung groß angelegter Entscheidungsmodelle des Instituts für Mathematik überprüft wird.

Diesmal reproduziert und verifiziert DB1 vom Mathematical Research Institute hauptsächlich Gato und versucht, es in Bezug auf Netzwerkstruktur und Parametermenge, Aufgabentyp und Aufgabennummer zu verbessern:

-

Parametermenge und Netzwerkstruktur : DB1-Parametermenge erreicht 1,21 Milliarden. Versuchen Sie, in Bezug auf die Parameter so nah wie möglich an Gato zu sein. Im Allgemeinen verwendet das Institute of Numerical Research eine ähnliche Struktur wie Gato (gleiche Anzahl von Decoder-Blöcken, gleiche Größe der verborgenen Ebenen usw.), jedoch in FeedForwardNetwork, da die GeGLU-Aktivierungsfunktion ein zusätzliches Drittel der Anzahl der Parameter einführt Das Institut für Mathematische Wissenschaften möchte, dass die Parametermenge nahe an Gato liegt und der verborgene Schichtzustand von 4 * n_embed-Dimensionen durch die GeGLU-Aktivierungsfunktion in 2 * n_embed-dimensionale Merkmale umgewandelt wird. Ansonsten teilen wir die Einbettungsparameter auf der Eingabe- und Ausgabekodierungsseite mit der Gato-Implementierung. Anders als bei Gato verwenden wir bei der Auswahl der Schichtnormalisierung die PostNorm-Lösung und verwenden in Attention Berechnungen mit gemischter Genauigkeit, um die numerische Stabilität zu verbessern.

- Aufgabentyp und Anzahl der Aufgaben: Die Anzahl der experimentellen Aufgaben in DB1 erreicht 870, was 44,04 % mehr als bei Gato und 2,23 % mehr als bei Gato bei >=50 % Expertenleistung ist. In Bezug auf bestimmte Aufgabentypen übernimmt DB1 größtenteils Gatos Entscheidungs-, Bild- und Textaufgaben, und die Anzahl der verschiedenen Aufgaben bleibt im Wesentlichen gleich. Aber in Bezug auf Entscheidungsaufgaben hat DB1 auch mehr als 200 reale Szenarioaufgaben eingeführt, nämlich das Travelling Salesman Problem (TSP) mit einer Skala von 100 und 200 Knoten. Bei dieser Art von Aufgabe werden 100–200 geografische Standorte zufällig ausgewählt Knoten in allen großen Städten Chinas.

Es ist ersichtlich, dass die Gesamtleistung von DB1 das gleiche Niveau wie die von Gato erreicht hat und begonnen hat, sich zu einem Domänenkörper zu entwickeln, der den tatsächlichen Geschäftsanforderungen näher kommt und NP-harte TSP-Probleme lösen kann Sehr gut, während vor Gato diese Richtung noch nicht erforscht wurde.

Vergleich der Indikatoren DB1 (rechts) und GATO (links)

Vergleich der Indikatoren DB1 (rechts) und GATO (links)

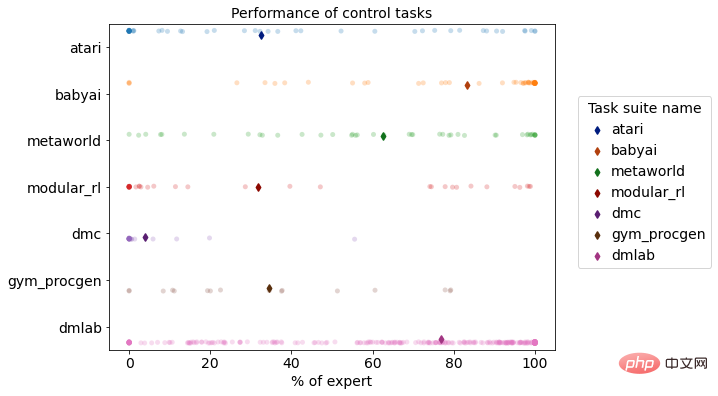

Multitask-Leistungsverteilung von DB1 in der Simulationsumgebung für Verstärkungslernen

Im Vergleich zu herkömmlichen Entscheidungsalgorithmen bietet DB1 eine gute Leistung bei der aufgabenübergreifenden Entscheidungsfindung und bei der schnellen Migration. In Bezug auf aufgabenübergreifende Entscheidungsfähigkeiten und Parametermengen hat es einen Sprung von mehreren zehn Millionen Parametern für eine einzelne komplexe Aufgabe auf Milliarden von Parametern für mehrere komplexe Aufgaben geschafft und wächst weiter und verfügt über die Fähigkeit zur Lösung Probleme in komplexen Geschäftsumgebungen. In Bezug auf die Migrationsfähigkeiten hat DB1 den Sprung von der intelligenten Vorhersage zur intelligenten Entscheidungsfindung und vom Einzelagenten zum Multiagenten geschafft und die Mängel traditioneller Methoden bei der aufgabenübergreifenden Migration ausgeglichen, sodass große Modelle erstellt werden können innerhalb des Unternehmens.

Es ist unbestreitbar, dass DB1 im Entwicklungsprozess auch auf viele Schwierigkeiten gestoßen ist. Das Institute of Digital Research hat viele Versuche unternommen, der Industrie einige Standardlösungen für das groß angelegte Modelltraining und die Speicherung von Multitask-Trainingsdaten bereitzustellen . Da die Modellparameter 1 Milliarde Parameter erreicht haben und der Aufgabenumfang riesig ist und das Training auf mehr als 100T (300B+ Tokens) Expertendaten erfolgen muss, kann das gewöhnliche Deep-Reinforcement-Learning-Trainingsframework die Anforderungen eines schnellen Trainings nicht mehr erfüllen diese Situation. Zu diesem Zweck berücksichtigt das Institut für Mathematikforschung einerseits die Rechenstruktur des verstärkenden Lernens, der Betriebsoptimierung und des Trainings großer Modelle in einer Umgebung mit einer einzelnen Maschine und mehreren Karten Es nutzt die Hardware-Ressourcen voll aus und gestaltet Module geschickt. Der Kommunikationsmechanismus zwischen den Modellen maximiert die Trainingseffizienz des Modells und verkürzt die Trainingszeit von 870 Aufgaben auf eine Woche. Andererseits sind bei der verteilten Zufallsstichprobe auch die im Trainingsprozess erforderliche Datenindizierung, -speicherung, -ladung und -vorverarbeitung zu entsprechenden Engpässen geworden. Das Forschungsinstitut des Instituts für Mathematik verwendet beim Laden des Datensatzes den verzögerten Lademodus, um das Problem zu lösen Beseitigen Sie Speicherbeschränkungen und maximieren Sie die volle Nutzung des verfügbaren Speichers. Darüber hinaus werden die verarbeiteten Daten nach der Vorverarbeitung der geladenen Daten auf der Festplatte zwischengespeichert, sodass die vorverarbeiteten Daten später direkt geladen werden können, wodurch die durch wiederholte Vorverarbeitung verursachten Zeit- und Ressourcenkosten reduziert werden.

Derzeit haben führende internationale und inländische Unternehmen und Forschungseinrichtungen wie OpenAI, Google, Meta, Huawei, Baidu und die DAMO Academy Forschungen zu multimodalen Großmodellen durchgeführt und bestimmte Kommerzialisierungsversuche unternommen, darunter „Anwenden oder Bereitstellen von Modellen“. APIs und verwandte Branchenlösungen in Ihren eigenen Produkten. Im Gegensatz dazu konzentriert sich das Institut für Mathematische Wissenschaften mehr auf Entscheidungsfragen und unterstützt Anwendungsversuche bei Entscheidungsaufgaben für Spiel-KI, TSP-Lösungsaufgaben zur Operations Research-Optimierung, Steuerungsaufgaben für Roboterentscheidungen, Lösungsaufgaben zur Black-Box-Optimierung und Multi- Runde Dialogaufgaben.

Aufgabenleistung

Betriebsoptimierung: TSP-Problemlösung

TSP-Problem mit einigen Städten in China als Knoten

Videodemonstration der Verstärkungslernaufgabe

DB1-Modell ist im Werden abgeschlossen Nach dem Offline-Lernen von 870 verschiedenen Entscheidungsaufgaben zeigten die Bewertungsergebnisse, dass 76,67 % der Aufgaben das Expertenniveau von 50 % erreichten oder übertrafen. Im Folgenden werden die Auswirkungen einiger Aufgaben demonstriert.

- Videospielszene: DB1 kann 2D-/3D-Bildeingaben empfangen und 2D-Pixelspiele wie Atari und Procgen gut ausführen. Gleichzeitig ist es auch für DMLab geeignet, eine ähnliche 3D-Bildeingabeaufgabe In der realen Welt zeigte DB1 ebenfalls eine gute Leistung.

Atari Breakout

DMLab Objektstandorte erkunden

Procgen DogBall

- Kontinuierliche Kontrollszenen: Für kontinuierliche Steuerungsaufgaben im Bereich der Robotik kann DB1 auch die Richtlinienausgabe kontinuierlicher Aktionen modellieren und Simulationsaufgaben gut abschließen.

Metaworld PlateSlide

ModularRL Cheetah

文本 - 图像任务...

- 文本生成:给出一段文字提示,生成长文本描述

- 输入提示:Digital Brain Laboratory ist ein in Shanghai ansässiges Unternehmen sind ein digitales Gehirnlabor und wir suchen eine hochqualifizierte und erfahrene Person zur Verstärkung unseres Teams in Shanghai, China.

- Dies ist eine Gelegenheit, für ein bekanntes und wachsendes Unternehmen zu arbeiten, das sich in einer schnellen Wachstumsphase befindet und um auf dem Markt Einfluss zu nehmen.

-

Dies ist eine unbefristete Vollzeitstelle.

Wir suchen einen hochqualifizierten, motivierten und erfahrenen Softwareentwickler, der ein Team von 5-10 Personen in einem hart umkämpften Umfeld leiten kann Umwelt前决策大模型的局限性与未来方向

虽然当前多模态决策预训练模型DB1 ist eine neue Version von DB1序列建模困难、专家数据强依赖等.虽然存在众多挑战,但现阶段看来多模态决策大模型是实现决策智能体从游戏走向更广泛场景, 从虚拟走向现实,在现实开放动态环境中进行自主感觉与决策,最终实现更加通用人工智能的关键探索方向之一.未来数研院将持续迭代数字大脑决策大模型, 通过更大参数量, 更有效的序列表征, 接入和支持更多任务,结合离线 / 线训练与微调,实现跨域、跨模态、跨任务的知识泛化与迁移,最终在现实应用场景下提供更通用、更高效、更低成本的决策智能决策解决方案.

Das obige ist der detaillierte Inhalt vonDas Shanghai Digital Brain Research Institute veröffentlicht DB1, Chinas erstes großes multimodales Entscheidungsmodell, das eine schnelle Entscheidungsfindung bei äußerst komplexen Problemen ermöglichen kann. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Kontexterweiterter KI-Codierungsassistent mit Rag und Sem-Rag

Jun 10, 2024 am 11:08 AM

Verbessern Sie die Produktivität, Effizienz und Genauigkeit der Entwickler, indem Sie eine abrufgestützte Generierung und ein semantisches Gedächtnis in KI-Codierungsassistenten integrieren. Übersetzt aus EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, Autor JanakiramMSV. Obwohl grundlegende KI-Programmierassistenten natürlich hilfreich sind, können sie oft nicht die relevantesten und korrektesten Codevorschläge liefern, da sie auf einem allgemeinen Verständnis der Softwaresprache und den gängigsten Mustern beim Schreiben von Software basieren. Der von diesen Coding-Assistenten generierte Code eignet sich zur Lösung der von ihnen zu lösenden Probleme, entspricht jedoch häufig nicht den Coding-Standards, -Konventionen und -Stilen der einzelnen Teams. Dabei entstehen häufig Vorschläge, die geändert oder verfeinert werden müssen, damit der Code in die Anwendung übernommen wird

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

1. Einleitung In den letzten Jahren haben sich YOLOs aufgrund ihres effektiven Gleichgewichts zwischen Rechenkosten und Erkennungsleistung zum vorherrschenden Paradigma im Bereich der Echtzeit-Objekterkennung entwickelt. Forscher haben das Architekturdesign, die Optimierungsziele, Datenerweiterungsstrategien usw. von YOLO untersucht und erhebliche Fortschritte erzielt. Gleichzeitig behindert die Verwendung von Non-Maximum Suppression (NMS) bei der Nachbearbeitung die End-to-End-Bereitstellung von YOLO und wirkt sich negativ auf die Inferenzlatenz aus. In YOLOs fehlt dem Design verschiedener Komponenten eine umfassende und gründliche Prüfung, was zu erheblicher Rechenredundanz führt und die Fähigkeiten des Modells einschränkt. Es bietet eine suboptimale Effizienz und ein relativ großes Potenzial zur Leistungsverbesserung. Ziel dieser Arbeit ist es, die Leistungseffizienzgrenze von YOLO sowohl in der Nachbearbeitung als auch in der Modellarchitektur weiter zu verbessern. zu diesem Zweck

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

Herausgeber |. KX Im Bereich der Arzneimittelforschung und -entwicklung ist die genaue und effektive Vorhersage der Bindungsaffinität von Proteinen und Liganden für das Arzneimittelscreening und die Arzneimitteloptimierung von entscheidender Bedeutung. Aktuelle Studien berücksichtigen jedoch nicht die wichtige Rolle molekularer Oberflächeninformationen bei Protein-Ligand-Wechselwirkungen. Auf dieser Grundlage schlugen Forscher der Universität Xiamen ein neuartiges Framework zur multimodalen Merkmalsextraktion (MFE) vor, das erstmals Informationen über Proteinoberfläche, 3D-Struktur und -Sequenz kombiniert und einen Kreuzaufmerksamkeitsmechanismus verwendet, um verschiedene Modalitäten zu vergleichen Ausrichtung. Experimentelle Ergebnisse zeigen, dass diese Methode bei der Vorhersage von Protein-Ligand-Bindungsaffinitäten Spitzenleistungen erbringt. Darüber hinaus belegen Ablationsstudien die Wirksamkeit und Notwendigkeit der Proteinoberflächeninformation und der multimodalen Merkmalsausrichtung innerhalb dieses Rahmens. Verwandte Forschungen beginnen mit „S

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

An der Spitze der Softwaretechnologie kündigte die Gruppe von UIUC Zhang Lingming zusammen mit Forschern der BigCode-Organisation kürzlich das StarCoder2-15B-Instruct-Großcodemodell an. Diese innovative Errungenschaft erzielte einen bedeutenden Durchbruch bei Codegenerierungsaufgaben, übertraf erfolgreich CodeLlama-70B-Instruct und erreichte die Spitze der Codegenerierungsleistungsliste. Die Einzigartigkeit von StarCoder2-15B-Instruct liegt in seiner reinen Selbstausrichtungsstrategie. Der gesamte Trainingsprozess ist offen, transparent und völlig autonom und kontrollierbar. Das Modell generiert über StarCoder2-15B Tausende von Anweisungen als Reaktion auf die Feinabstimmung des StarCoder-15B-Basismodells, ohne auf teure manuelle Annotationen angewiesen zu sein.

SK Hynix wird am 6. August neue KI-bezogene Produkte vorstellen: 12-Layer-HBM3E, 321-High-NAND usw.

Aug 01, 2024 pm 09:40 PM

SK Hynix wird am 6. August neue KI-bezogene Produkte vorstellen: 12-Layer-HBM3E, 321-High-NAND usw.

Aug 01, 2024 pm 09:40 PM

Laut Nachrichten dieser Website vom 1. August hat SK Hynix heute (1. August) einen Blogbeitrag veröffentlicht, in dem es ankündigt, dass es am Global Semiconductor Memory Summit FMS2024 teilnehmen wird, der vom 6. bis 8. August in Santa Clara, Kalifornien, USA, stattfindet viele neue Technologien Generation Produkt. Einführung des Future Memory and Storage Summit (FutureMemoryandStorage), früher Flash Memory Summit (FlashMemorySummit), hauptsächlich für NAND-Anbieter, im Zusammenhang mit der zunehmenden Aufmerksamkeit für die Technologie der künstlichen Intelligenz wurde dieses Jahr in Future Memory and Storage Summit (FutureMemoryandStorage) umbenannt Laden Sie DRAM- und Speicheranbieter und viele weitere Akteure ein. Neues Produkt SK Hynix wurde letztes Jahr auf den Markt gebracht