Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Der Evolutionsbaum großer Sprachmodelle, dies ist ein sehr detaillierter „Essen'-Leitfaden für ChatGPT

Der Evolutionsbaum großer Sprachmodelle, dies ist ein sehr detaillierter „Essen'-Leitfaden für ChatGPT

Der Evolutionsbaum großer Sprachmodelle, dies ist ein sehr detaillierter „Essen'-Leitfaden für ChatGPT

Im Prozess der eigentlichen Erkundung haben Praktiker möglicherweise Schwierigkeiten, ein für ihre Anwendung geeignetes KI-Modell zu finden: Sollten sie sich für LLM oder die Feinabstimmung eines Modells entscheiden? Welches sollte ich wählen, wenn ich LLM verwende?

Kürzlich haben Wissenschaftler von Amazon, der Texas A&M University, der Rice University und anderen Institutionen den Entwicklungsprozess von Sprachmodellen wie ChatGPT diskutiert, und ihr Artikel wurde auch von Yann LeCun retweetet.

Papier: https://arxiv.org/abs/2304.13712

Verwandte Ressourcen: https://github.com/Mooler0410/LLMsPracticalGuide

Dieser Artikel beginnt aus der Perspektive der praktischen Anwendung und diskutiert die für LLM geeigneten Aufgaben sowie die praktischen Aspekte wie Modelle, Daten und Aufgaben, die bei der Auswahl eines Modells berücksichtigt werden müssen.

1 Einleitung

In den letzten Jahren hat die rasante Entwicklung großer Sprachmodelle (LLM) eine Revolution im Bereich der Verarbeitung natürlicher Sprache (NLP) ausgelöst. Diese Modelle sind äußerst leistungsstark und versprechen, viele verschiedene Arten von NLP-Aufgaben zu lösen – vom Verstehen natürlicher Sprache (NLU) bis hin zu Generierungsaufgaben und ebnen sogar den Weg zur künstlichen allgemeinen Intelligenz (AGI). Um diese Modelle jedoch effektiv und effizient nutzen zu können, benötigen wir ein praktisches Verständnis ihrer Fähigkeiten und Grenzen sowie ein Verständnis der Daten und Aufgaben, die mit NLP verbunden sind.

Dieses Papier konzentriert sich auf verschiedene Aspekte der praktischen Anwendung von LLM in nachgelagerten NLP-Aufgaben, um Praktikern und Endbenutzern Orientierung zu geben. Das Ziel dieses Leitfadens besteht darin, den Lesern praktische und nützliche Ratschläge zu geben, ob ein LLM für eine bestimmte Aufgabe verwendet werden soll und wie das am besten geeignete LLM ausgewählt werden kann. Dabei werden viele Faktoren wie Modellgröße, Rechenanforderungen usw. berücksichtigt Spezifische Domäne. Ob es ein vorab trainiertes Modell usw. gibt. In diesem Artikel wird LLM auch aus praktischer Anwendungsperspektive vorgestellt und erklärt, was Praktikern und Endbenutzern dabei helfen kann, die Leistungsfähigkeit von LLM erfolgreich zu nutzen, um ihre eigenen NLP-Aufgaben zu lösen.

Die Struktur dieses Artikels ist: In diesem Artikel wird zunächst LLM kurz vorgestellt, in dem die wichtigsten Architekturen im GPT-Stil und BERT-Stil besprochen werden. Anschließend geben wir eine ausführliche Einführung in die Schlüsselfaktoren, die die Modellleistung in Bezug auf Daten beeinflussen, einschließlich Pre-Training-Daten, Trainingsdaten/Tuning-Daten und Testdaten. Im letzten und wichtigsten Teil befasst sich dieser Artikel mit verschiedenen spezifischen NLP-Aufgaben und stellt vor, ob LLM für wissensintensive Aufgaben, traditionelle NLU-Aufgaben und Generierungsaufgaben geeignet ist. Darüber hinaus werden die neuen Fähigkeiten und Herausforderungen beschrieben Diese Modelle erwerben weiterhin reale Anwendungsszenarien. Wir stellen detaillierte Beispiele zur Verfügung, um den Nutzen und die Grenzen von LLM in der Praxis aufzuzeigen.

Um die Fähigkeiten großer Sprachmodelle zu analysieren, werden sie in diesem Artikel mit fein abgestimmten Modellen verglichen. Wir verfügen noch nicht über einen allgemein akzeptierten Standard für die Definition von LLM und fein abgestimmte Modelle. Um eine praktische und effektive Unterscheidung zu treffen, lautet die Definition in diesem Artikel wie folgt: LLM bezieht sich auf ein großes Sprachmodell, das auf einem großen Datensatz vorab trainiert wurde, und passt die Daten nicht an bestimmte Aufgaben an Modelle sind normalerweise kleiner und werden vorab trainiert. Später wird eine weitere Feinabstimmung an kleineren aufgabenspezifischen Datensätzen vorgenommen, um ihre Leistung bei dieser Aufgabe zu optimieren.

Dieser Artikel fasst praktische Anleitungen zur Verwendung von LLM zusammen in:

- Natürliches Sprachverständnis. Wenn die tatsächlichen Daten nicht im Verteilungsbereich der Trainingsdaten liegen oder nur sehr wenige Trainingsdaten vorhanden sind, kann die hervorragende Generalisierungsfähigkeit von LLM genutzt werden.

- Erzeugung natürlicher Sprache. Nutzen Sie die Leistungsfähigkeit von LLM, um zusammenhängende, kontextbezogene und qualitativ hochwertige Texte für eine Vielzahl von Anwendungen zu erstellen.

- Wissensintensive Aufgaben. Nutzen Sie das umfangreiche in LLM gespeicherte Wissen, um Aufgaben zu bewältigen, die spezifisches Fachwissen oder allgemeines Weltwissen erfordern.

- Argumentationsfähigkeit. Verstehen und nutzen Sie die Argumentationsfähigkeiten von LLM, um die Entscheidungsfindung und Problemlösung in einer Vielzahl von Situationen zu verbessern.

2 Ein praktischer Leitfaden für Modelle

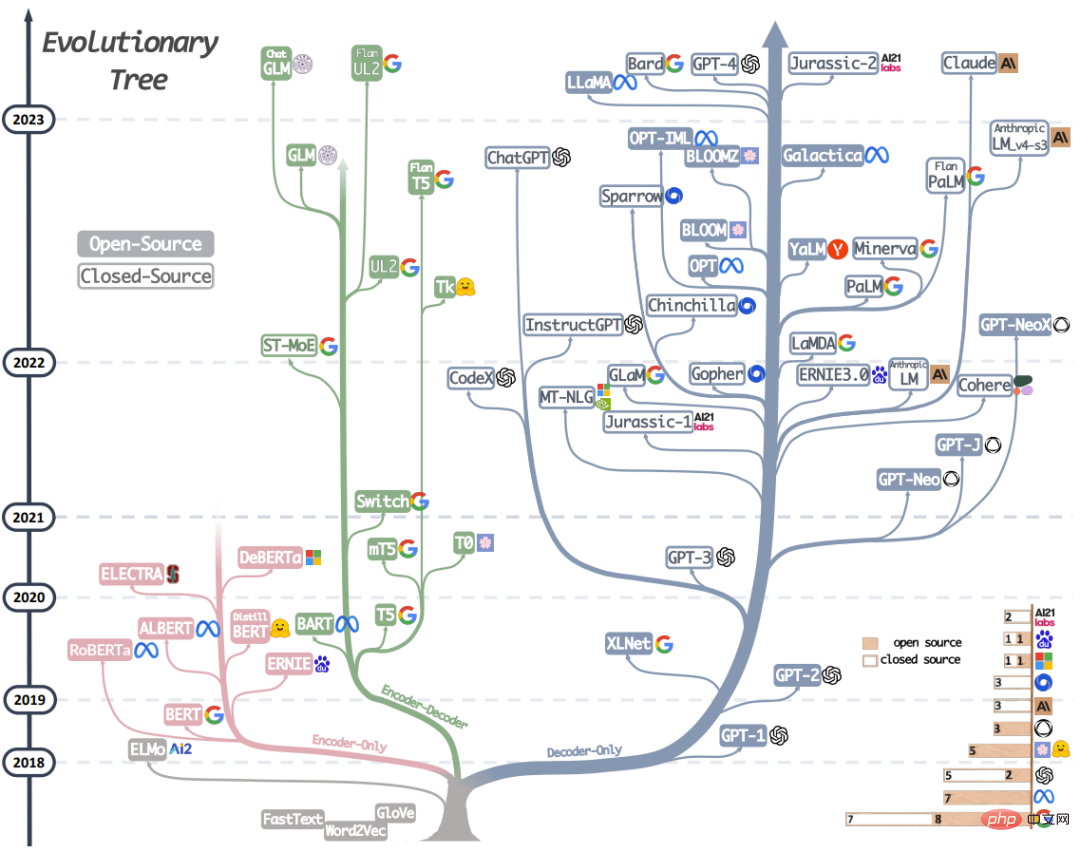

Abbildung 1: Dieser Evolutionsbaum des modernen LLM zeichnet die Entwicklung von Sprachmodellen in den letzten Jahren nach und hebt einige der bekanntesten Modelle hervor. Modelle im selben Zweig sind enger miteinander verbunden. Transformatorbasierte Modelle werden nicht in Grau dargestellt: Nur-Decoder-Modelle sind der blaue Zweig, Nur-Encoder-Modelle sind der rosa Zweig und Encoder-Decoder-Modelle sind der grüne Zweig. Die vertikale Position eines Modells auf der Zeitachse gibt an, wann es veröffentlicht wurde. Ausgefüllte Quadrate stehen für Open-Source-Modelle und leere Quadrate für Closed-Source-Modelle. Das gestapelte Balkendiagramm in der unteren rechten Ecke bezieht sich auf die Anzahl der Modelle für jedes Unternehmen und jede Institution.

In diesem Abschnitt werden die aktuell leistungsstärksten LLM-Studierenden kurz vorgestellt. Diese Modelle verfügen über unterschiedliche Trainingsstrategien, Modellarchitekturen und Anwendungsfälle. Um das Gesamtbild von LLMs klarer zu verstehen, können wir sie in zwei große Kategorien einteilen: Encoder-Decoder- oder Nur-Encoder-Sprachmodelle und Nur-Decoder-Sprachmodelle. Abbildung 1 zeigt die Entwicklung des Sprachmodells im Detail. Basierend auf diesem Evolutionsbaum können wir einige interessante Schlussfolgerungen beobachten:

a) Das reine Decoder-Modell wird allmählich zum dominierenden Modell in der LLM-Entwicklung. In den frühen Stadien der LLM-Entwicklung waren Nur-Decoder-Modelle nicht so beliebt wie Nur-Encoder-Modelle und Encoder-Decoder-Modelle. Doch nach 2021 veränderte das Aufkommen von GPT-3 das Bild der Branche und nur das Decodermodell erlebte eine explosive Entwicklung. Gleichzeitig sorgte BERT auch für ein anfängliches explosives Wachstum des Nur-Encoder-Modells, doch danach verschwand das Nur-Encoder-Modell allmählich aus dem Blickfeld.

b) OpenAI behauptet weiterhin seine führende Position in Richtung LLM, jetzt und wahrscheinlich auch in der Zukunft. Andere Unternehmen und Institutionen holen nach, um Modelle zu entwickeln, die mit GPT-3 und GPT-4 vergleichbar sind. Die führende Position von OpenAI ist möglicherweise auf seine kontinuierlichen Investitionen in Technologie zurückzuführen, auch wenn die Technologie in ihren Anfängen keine breite Anerkennung fand.

c) Meta hat herausragende Beiträge zum Open-Source-LLM und zur Förderung der LLM-Forschung geleistet. Meta zeichnet sich als eines der großzügigsten kommerziellen Unternehmen aus, wenn es um seine Beiträge zur Open-Source-Community geht, insbesondere im Zusammenhang mit LLMs, da es alle von ihm entwickelten LLMs als Open-Source-Lösungen bereitgestellt hat.

d) Die LLM-Entwicklung weist einen Trend zu Closed Source auf. In den frühen Phasen der LLM-Entwicklung (vor 2020) war die überwiegende Mehrheit der Modelle Open Source. Mit der Einführung von GPT-3 entscheiden sich Unternehmen jedoch zunehmend dafür, ihre Modelle wie PaLM, LaMDA und GPT-4 aus der Nähe zu beziehen. Daher wird es für akademische Forscher immer schwieriger, LLM-Trainingsexperimente durchzuführen. Dies hat zur Folge, dass API-basierte Forschung zum vorherrschenden Ansatz in der Wissenschaft werden könnte.

e) Das Encoder-Decoder-Modell hat noch Entwicklungsperspektiven, da Unternehmen und Institutionen diese Art von Architektur immer noch aktiv erforschen und die meisten Modelle Open Source sind. Google hat bedeutende Beiträge zu Open-Source-Encoder-Decodern geleistet. Aufgrund der Flexibilität und Vielseitigkeit des Nur-Decoder-Modells scheinen Googles Erfolgsaussichten jedoch geringer zu sein, wenn es an dieser Richtung festhält.

Tabelle 1 fasst kurz die Merkmale verschiedener repräsentativer LLMs zusammen. Tabelle 1: Eigenschaften groß angelegter Sprachmodelle

Die Entwicklung des unbeaufsichtigten Lernens natürlicher Sprache hat in letzter Zeit große Fortschritte gemacht, da Daten natürlicher Sprache leicht verfügbar sind und unbeaufsichtigte Trainingsparadigmen verwendet werden können, um extrem große Datensätze besser zu nutzen. Ein gängiger Ansatz besteht darin, verdeckte Wörter in einem Satz basierend auf dem Kontext vorherzusagen. Dieses Trainingsparadigma wird als maskiertes Sprachmodell bezeichnet. Diese Trainingsmethode ermöglicht es dem Modell, ein tieferes Verständnis der Beziehung zwischen Wörtern und ihrem Kontext zu erlangen. Diese Modelle werden mithilfe von Techniken wie der Transformer-Architektur an großen Textkorpora trainiert und haben bei vielen NLP-Aufgaben, wie z. B. Stimmungsanalyse und Erkennung benannter Entitäten, Spitzenleistungen erzielt. Zu den berühmten maskierten Sprachmodellen gehören BERT, RoBERTa und T5. Aufgrund ihrer erfolgreichen Leistung bei einer Vielzahl von Aufgaben sind maskierte Sprachmodelle zu einem wichtigen Werkzeug im Bereich der Verarbeitung natürlicher Sprache geworden.

2.2 Sprachmodell im GPT-Stil: nur Decoder

Obwohl Sprachmodellarchitekturen häufig aufgabenunabhängig sind, erfordern diese Methoden eine Feinabstimmung auf der Grundlage von Datensätzen für bestimmte nachgelagerte Aufgaben. Forscher haben herausgefunden, dass eine Vergrößerung eines Sprachmodells seine Leistung mit wenigen oder gar keinen Stichproben deutlich verbessern kann. Das erfolgreichste Modell zur Verbesserung der Leistung mit wenigen und keinen Stichproben ist das autoregressive Sprachmodell, das darauf trainiert wird, das nächste Wort basierend auf den vorherigen Wörtern in einer bestimmten Reihenfolge zu generieren. Diese Modelle werden häufig bei nachgelagerten Aufgaben wie der Texterstellung und der Beantwortung von Fragen eingesetzt. Zu den autoregressiven Sprachmodellen gehören GPT-3, OPT, PaLM und BLOOM. Das revolutionäre GPT-3 zeigte zum ersten Mal, dass das Lernen durch Hinweise und Kontext mit wenigen/null Stichproben zu vernünftigen Ergebnissen führen kann, und demonstrierte damit die Überlegenheit autoregressiver Sprachmodelle.

Es gibt auch Modelle, die für bestimmte Aufgaben optimiert sind, wie CodeX für die Codegenerierung und BloombergGPT für den Finanzbereich. Ein wichtiger neuer Durchbruch ist ChatGPT, ein für Konversationsaufgaben optimiertes GPT-3-Modell, das interaktivere, kohärentere und kontextbezogenere Konversationen für eine Vielzahl realer Anwendungen generiert.

3 Praktischer Leitfaden zu Daten

In diesem Abschnitt wird die entscheidende Rolle von Daten bei der Auswahl des richtigen Modells für nachgelagerte Aufgaben vorgestellt. Der Einfluss von Daten auf die Modelleffektivität beginnt in der Phase vor dem Training und setzt sich in der Trainings- und Inferenzphase fort.

Wichtige Punkte 1

(1) Wenn nachgelagerte Aufgaben Daten außerhalb der Verteilung verwenden, beispielsweise bei der Verwendung kontroverser Stichproben oder Datendomänenänderungen, ist die Generalisierungsfähigkeit von LLM besser als die des Feinabstimmungsmodells.

(2) Wenn die beschrifteten Daten begrenzt sind, ist LLM besser als das fein abgestimmte Modell, wenn reichlich beschriftete Daten vorhanden sind. Abhängig von den spezifischen Aufgabenanforderungen sind beide sinnvolle Optionen.

(3) Es wird empfohlen, ein Modell zu wählen, dessen für das Vortraining verwendete Datendomäne dem Datendomäne der nachgelagerten Aufgabe ähnlich ist.

4 Praktischer Leitfaden für NLP-Aufgaben

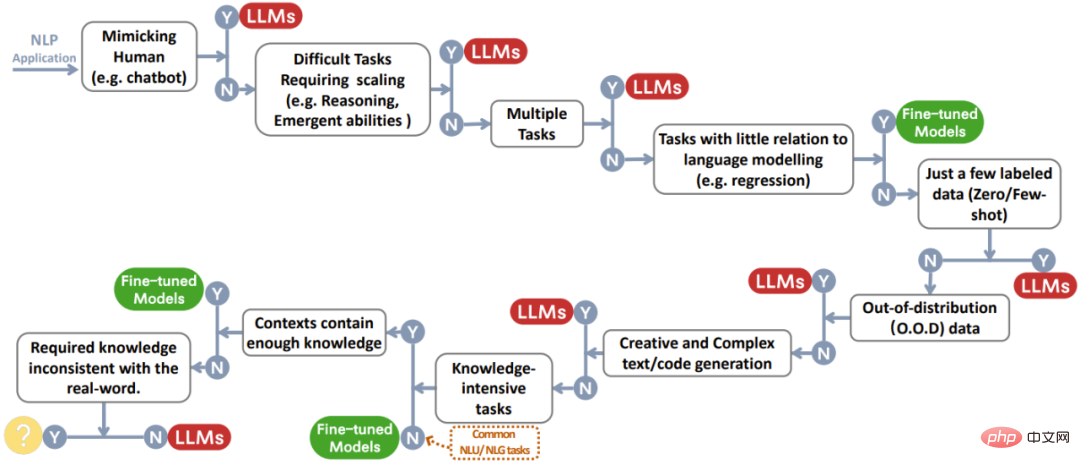

In diesem Abschnitt wird ausführlich erläutert, ob LLM für verschiedene nachgelagerte NLP-Aufgaben und die entsprechenden Modellfunktionen nützlich ist. Abbildung 2 ist ein Entscheidungsflussdiagramm, das alle Diskussionen zusammenfasst. Wenn man vor einer bestimmten Aufgabe steht, können auf Basis dieses Prozesses schnelle Entscheidungen getroffen werden.

Abbildung 2: Entscheidungsprozess des Benutzers bei der Auswahl von LLM oder einem fein abgestimmten Modell für die NLP-Anwendung. Mithilfe dieses Entscheidungsflussdiagramms können Benutzer beurteilen, ob die vorliegende Downstream-NLP-Aufgabe bestimmte Kriterien erfüllt, und anhand der Bewertungsergebnisse bestimmen, ob ein LLM oder ein fein abgestimmtes Modell für ihre Anwendung am besten geeignet ist. Im Entscheidungsprozess in der Abbildung zeigt Y an, dass die Bedingungen erfüllt sind, und N gibt an, dass die Bedingungen nicht erfüllt sind. Der gelbe Kreis neben Y für die letzte Bedingung zeigt an, dass es derzeit kein Modell gibt, das für diese Art von Anwendung gut geeignet ist.

4.1 Traditionelle NLU-Aufgaben

Traditionelle NLU-Aufgaben sind einige grundlegende Aufgaben im Bereich NLP, einschließlich Textklassifizierung, Named Entity Recognition (NER), Folgevorhersage usw. Viele dieser Aufgaben können als Zwischenschritte in größeren KI-Systemen verwendet werden, beispielsweise die Verwendung von NER für die Erstellung von Wissensgraphen.

Gilt nicht für LLM: Wenn die Aufgabe bei den meisten Aufgaben zum Verstehen natürlicher Sprache, z. B. in GLUE und SuperGLUE, bereits über umfangreiche, gut kommentierte Daten verfügt und nur sehr wenige Daten im Testsatz außerhalb der Verteilung liegen, erfolgt eine Feinabstimmung Die Leistung des Modells ist noch besser. Die Kluft zwischen kleinen, fein abgestimmten Modellen und LLMs ist auch unterschiedlich, wenn die Aufgaben und Datensätze variieren.

LLM-geeignet: Allerdings gibt es auch einige NLU-Aufgaben, die besser für die Bearbeitung durch LLM geeignet sind. Zwei repräsentative Aufgaben sind komplexe Textklassifizierungsprobleme und kontradiktorisches Denken in natürlicher Sprache.

Punkt 2

Für traditionelle Aufgaben zum Verstehen natürlicher Sprache sind fein abgestimmte Modelle normalerweise eine bessere Wahl als LLM. Wenn die Aufgabe jedoch starke Generalisierungsfähigkeiten erfordert, kann LLM hilfreich sein.

4.2 Generierungsaufgaben

Das Ziel der Generierung natürlicher Sprache besteht darin, kohärente, sinnvolle und kontextbezogene Symbolsequenzen zu erstellen, was grob zwei Hauptkategorien von Aufgaben umfasst. Die erste Aufgabenkategorie konzentriert sich auf die Konvertierung von Eingabetext in neue Symbolfolgen. Beispiele hierfür sind die Zusammenfassung von Absätzen und die maschinelle Übersetzung. Die zweite Kategorie von Aufgaben ist die „offene Generierung“, bei der das Ziel darin besteht, Texte oder Symbole von Grund auf so zu generieren, dass sie genau mit der Eingabebeschreibung übereinstimmen, z. B. beim Schreiben von E-Mails, beim Schreiben neuer Artikel, beim Erstellen fiktionaler Geschichten und beim Schreiben von Code.

Anwendbar auf LLM: Die Generierungsaufgabe erfordert, dass das Modell den Eingabeinhalt oder die Anforderungen vollständig versteht, und erfordert außerdem ein gewisses Maß an Kreativität. Darin zeichnet sich LLM aus.

Nicht anwendbares LLM: Bei den meisten Übersetzungsaufgaben mit umfangreichen Ressourcen und Übersetzungsaufgaben mit wenigen Ressourcen schneiden fein abgestimmte Modelle besser ab, wie z. B. DeltaLM+Zcode. Bei maschineller Übersetzung mit umfangreichen Ressourcen übertreffen fein abgestimmte Modelle LLMs geringfügig. Bei der maschinellen Übersetzung mit sehr wenigen Ressourcen, wie beispielsweise der Englisch-Kasachisch-Übersetzung, übertraf das fein abgestimmte Modell das LLM deutlich.

Punkt 3

Dank seiner starken Generierungsfähigkeiten und Kreativität hat LLM bei den meisten Generierungsaufgaben Vorteile.

4.3 Wissensintensive Aufgaben

Wissensintensive NLP-Aufgaben beziehen sich auf die Kategorie von Aufgaben, die stark auf Hintergrundwissen, domänenspezifischem Fachwissen oder allgemeinem Wissen aus der Praxis beruhen. Diese Aufgaben erfordern mehr als Mustererkennung oder syntaktische Analyse. Sie verlassen sich stark auf das Gedächtnis und die angemessene Nutzung von Wissen in Bezug auf bestimmte Entitäten, Ereignisse und den gesunden Menschenverstand in unserer realen Welt.

Gilt für LLM: Im Allgemeinen kann die Menge an realem Wissen, die in LLM enthalten ist, die eines fein abgestimmten Modells bei weitem übersteigen, wenn Milliarden von Trainingstokens und -parametern vorhanden sind.

Gilt nicht für LLM: Einige andere Aufgaben erfordern andere Kenntnisse als die im LLM erworbenen Kenntnisse. Das erforderliche Wissen ist nicht das, was der LLM über die reale Welt lernt. Bei einer solchen Aufgabe hat LLM keinen klaren Vorteil.

Punkt 4

(1) Dank des großen Praxiswissens ist LLM gut in der Bewältigung wissensintensiver Aufgaben. (2) LLM wird auf Schwierigkeiten stoßen, wenn die Wissensanforderungen nicht mit dem erlernten Wissen übereinstimmen oder wenn die Aufgabe nur Kontextwissen erfordert. Das Feinabstimmungsmodell kann die gleiche Leistung wie LLM erzielen.

4.4 Fähigkeit zur Skalierung

Die Erweiterung des LLM-Maßstabs (z. B. Parameter, Trainingsberechnungen usw.) kann beim Vortraining von Sprachmodellen erheblich helfen. Durch die Vergrößerung der Modellgröße wird häufig die Fähigkeit des Modells verbessert, mehrere Aufgaben zu bewältigen. Wenn man bestimmte Indikatoren berücksichtigt, zeigt die Leistung des Modells eine Potenzgesetzbeziehung mit der Modellgröße. Beispielsweise nimmt der Kreuzentropieverlust, der zur Messung der Sprachmodellierungsleistung verwendet wird, linear mit dem exponentiellen Wachstum der Modellgröße ab, was auch als „Skalierungsgesetz“ bezeichnet wird. Bei einigen Schlüsselfähigkeiten, wie z. B. dem logischen Denken, kann die Skalierung des Modells diese Fähigkeiten schrittweise von einem sehr niedrigen Niveau auf ein nutzbares Niveau verbessern, das sogar dem menschlichen Niveau nahe kommt. In diesem Unterabschnitt wird die Verwendung von LLM im Hinblick auf die Auswirkungen der Skalierung auf die Fähigkeiten und das Verhalten von LLM vorgestellt.

LLM-Anwendungsfälle beim Denken: Beim Denken geht es darum, Informationen zu verstehen, Schlussfolgerungen zu ziehen und Entscheidungen zu treffen, und ist eine Kernfähigkeit der menschlichen Intelligenz. Für NLP ist das Denken eine große Herausforderung. Viele existierende Denkaufgaben lassen sich in zwei Kategorien einteilen: logisches Denken und arithmetisches Denken. Die Modellvergrößerung kann die arithmetische Argumentationsfähigkeit von LLM erheblich verbessern. Das Denken mit gesundem Menschenverstand erfordert, dass sich der LLM nicht nur an Faktenwissen erinnert, sondern auch einige Argumentationsschritte zu den Fakten durchführt. Mit zunehmender Größe des Modells verbessern sich die Fähigkeiten zum gesunden Menschenverstand allmählich. Im Vergleich zu fein abgestimmten Modellen schneidet LLM bei den meisten Datensätzen besser ab.

LLM-Anwendungsfälle in aufstrebenden Fähigkeiten: Eine Vergrößerung der Modellgröße kann dem Modell auch einige beispiellose und wunderbare Fähigkeiten verleihen, die über die Potenzgesetzregeln hinausgehen. Diese Fähigkeiten werden „emergente Fähigkeiten“ genannt. Wie im Artikel „Emergent Abilities of Large Language Models“ definiert: Die Emergenzfähigkeit von LLM bezieht sich auf die Fähigkeit, die kleine Modelle nicht haben, aber in großen Modellen auftreten. (Weitere Interpretationen dieses Papiers finden Sie unter „Neue Arbeit von Jeff Dean und anderen: Sprachmodelle aus einem anderen Blickwinkel betrachten, Unable to Discover If the Scale Is Not Enough“). Dies bedeutet, dass wir diese Fähigkeit nicht ableiten und vorhersagen können Basierend auf der Leistungsverbesserung kleiner Modelle kann es bei einigen Aufgaben plötzlich zu einer hervorragenden Leistung kommen, sobald die Größe des Modells ein bestimmtes Niveau überschreitet. Neue Fähigkeiten sind oft unvorhersehbar und unerwartet, was dazu führen kann, dass ein Modell nicht in der Lage ist, zufällig auftretende oder unerwartete Aufgaben zu bewältigen.

Gilt nicht für LLM und das Verständnis von Emergenz: Obwohl das Modell in den meisten Fällen größer ist und eine bessere Leistung erbringt, gibt es dennoch Ausnahmen.

Bei einigen Aufgaben nimmt die Modellleistung mit zunehmender LLM-Skala ab. Dies wird auch als Phänomen der inversen Skalierung bezeichnet. Darüber hinaus beobachteten die Forscher noch ein weiteres interessantes Phänomen im Zusammenhang mit der Größenordnung, nämlich das U-förmige Phänomen. Wie der Name schon sagt, bedeutet dieses Phänomen, dass mit zunehmender Größe des LLM-Modells seine Leistung bei einer bestimmten Aufgabe zunächst besser wird, dann abnimmt und sich dann wieder verbessert.

Um die Forschung in diesem Bereich voranzutreiben, müssen wir ein tieferes Verständnis für neu entstehende Fähigkeiten, Gegenskalierungsphänomene und U-förmige Phänomene haben.

Wichtige Punkte 5

(1) Wenn die Modellgröße exponentiell zunimmt, nehmen auch die arithmetischen Argumentations- und gesunden Menschenverstandsfähigkeiten von LLM zu. (2) Mit zunehmendem Umfang des LLM können neu entstehende Fähigkeiten zufällig neue Verwendungsmöglichkeiten entdecken, beispielsweise Textverarbeitungsfähigkeiten und logische Fähigkeiten. (3) Die Modellfähigkeiten nehmen nicht immer mit der Skalierung zu, und unser Verständnis der Beziehung zwischen den Fähigkeiten großer Sprachmodelle und der Skalierung ist noch begrenzt.

4.5 Verschiedene Aufgaben

Um die Stärken und Schwächen von LLM besser zu verstehen, sprechen wir über andere Aufgaben, die oben nicht behandelt wurden.

Gilt nicht für LLM: Wenn sich die Modellziele von den Trainingsdaten unterscheiden, stößt LLM bei diesen Aufgaben häufig auf Schwierigkeiten.

Geeignet für LLM: LLM eignet sich besonders für bestimmte spezifische Aufgaben. Um einige Beispiele zu nennen: LLM ist sehr gut darin, Menschen zu imitieren. LLM kann auch zur Bewertung der Qualität bestimmter NLG-Aufgaben wie Zusammenfassung und Übersetzung verwendet werden. Einige Funktionen von LLM können auch andere Vorteile als Leistungsverbesserungen mit sich bringen, beispielsweise die Interpretierbarkeit.

Punkt 6

(1) Es gibt immer noch Platz für fein abgestimmte Modelle und domänenspezifische Modelle für Aufgaben, die weit von den vorab trainierten Zielen und Daten des LLM entfernt sind. (2) LLM ist gut darin, Menschen zu imitieren, Daten zu kommentieren und zu generieren. Sie können auch zur Qualitätsbewertung von NLP-Aufgaben verwendet werden und bieten Vorteile wie Interpretierbarkeit.

4.6 „Aufgaben“ aus der realen Welt

In diesem Abschnitt wird abschließend die Anwendung von LLM und die Feinabstimmung von Modellen auf „Aufgaben“ aus der realen Welt besprochen. Der Begriff „Aufgabe“ wird hier lose verwendet, da es im realen Umfeld im Gegensatz zu akademischen Umgebungen oft an wohlgeformten Definitionen mangelt. Viele Anforderungen an Modelle können nicht einmal als NLP-Aufgaben betrachtet werden. Die realen Herausforderungen, denen sich das Modell gegenübersieht, ergeben sich aus den folgenden drei Aspekten:

- Verrauschte/unstrukturierte Eingabe. Der Input aus der realen Welt kommt von Menschen aus der realen Welt, von denen die meisten keine Experten sind. Sie verstehen nicht, wie man angemessen mit Modellen interagiert, und sind möglicherweise nicht einmal in der Lage, Texte flüssig zu verwenden. Daher können reale Eingabedaten im Gegensatz zu den wohldefinierten formatierten Daten, die für das Vortraining oder die Feinabstimmung verwendet werden, chaotisch sein und Rechtschreibfehler, umgangssprachlichen Text und mehrsprachiges Durcheinander aufweisen.

- Aufgaben, die von der Wissenschaft nicht formalisiert wurden. Aufgaben in realen Szenarien werden von der Wissenschaft oft nicht genau definiert, und die Vielfalt geht weit über die Definition akademischer Forschungsszenarien hinaus. Benutzer stellen häufig Abfragen oder Anfragen, die nicht genau in vordefinierte Kategorien passen, und manchmal umfasst eine einzelne Abfrage mehrere Aufgaben.

- Befolgen Sie die Benutzeranweisungen. Die Anfrage des Benutzers kann mehrere implizite Absichten enthalten (z. B. spezifische Anforderungen an das Ausgabeformat) oder es ist möglicherweise nicht klar, was der Benutzer ohne Folgefragen vorherzusagen erwartet. Das Modell muss die Absichten des Benutzers verstehen und eine Ausgabe liefern, die diesen Absichten entspricht.

Im Wesentlichen werden diese realen Rätsel aus Benutzeranfragen durch Abweichungen von der Verteilung eines NLP-Datensatzes verursacht, der für eine bestimmte Aufgabe entwickelt wurde. Öffentliche NLP-Datensätze spiegeln nicht wider, wie diese Modelle verwendet werden.

Punkt 7

Im Vergleich zu Feinabstimmungsmodellen eignet sich LLM besser für die Verarbeitung realer Szenarien. Die Beurteilung der Wirksamkeit von Modellen in der realen Welt bleibt jedoch eine offene Frage.

5 Weitere Aspekte

Obwohl sich LLM für eine Vielzahl nachgelagerter Aufgaben eignet, sind noch weitere Faktoren zu berücksichtigen, wie zum Beispiel Effizienz und Zuverlässigkeit. Zu den mit der Effizienz verbundenen Problemen gehören die Schulungskosten von LLM, die Inferenzlatenz und Optimierungsstrategien für eine effiziente Parameternutzung. Im Hinblick auf Vertrauenswürdigkeit, LLM-Robustheit und Kalibrierungsfähigkeiten müssen Fairness und Bias, potenzielle Fehlerkorrelationen und Sicherheitsherausforderungen berücksichtigt werden. Kernpunkt 8(1) Wenn die Aufgabe kostensensibel ist oder strenge Latenzanforderungen hat, sollten leichtgewichtige lokale Feinabstimmungsmodelle Vorrang haben. Erwägen Sie bei der Bereitstellung und Bereitstellung Ihres Modells eine Optimierung, um die Parameter effizient zu nutzen. (2) Der Zero-Shot-Ansatz von LLM verhindert, dass Abkürzungen aus aufgabenspezifischen Datensätzen gelernt werden, was bei fein abgestimmten Modellen üblich ist. Dennoch weist LLM immer noch gewisse Probleme beim Shortcut-Lernen auf. (3) Da die potenziell schädlichen oder voreingenommenen Output- und Halluzinationsprobleme von LLM schwerwiegende Folgen haben können, sollten Sicherheitsfragen im Zusammenhang mit LLM die größte Aufmerksamkeit erhalten. Methoden wie Human Feedback versprechen eine Linderung dieser Probleme.

6 Zusammenfassung und zukünftige Herausforderungen

Dieser praktische Leitfaden bietet Einblicke in LLM und Best Practices für den Einsatz von LLM bei verschiedenen NLP-Aufgaben. Wir hoffen, dass dies Forschern und Praktikern dabei hilft, das Potenzial von LLM zu nutzen und Innovationen in der Sprachtechnologie voranzutreiben.

LLM hat natürlich auch einige Herausforderungen, die gelöst werden müssen:

- Bewerten Sie das Modell anhand realer Datensätze. Obwohl bestehende Deep-Learning-Modelle hauptsächlich anhand akademischer Standarddatensätze wie ImageNet evaluiert werden, sind akademische Standarddatensätze begrenzt und spiegeln die Leistung des Modells in der realen Welt nicht genau wider. Mit der Weiterentwicklung der Modelle wird es notwendig sein, sie anhand vielfältigerer, komplexerer und realistischerer Daten zu bewerten, die den tatsächlichen Bedarf widerspiegeln. Durch die Evaluierung von Modellen sowohl anhand akademischer als auch realer Datensätze können die Modelle gründlicher getestet werden und wir können ihre Wirksamkeit in realen Anwendungen besser verstehen. Dadurch wird sichergestellt, dass das Modell in der Lage ist, reale Probleme zu lösen und praktische, nutzbare Lösungen zu liefern.

- Modellausrichtung. Es ist wichtig sicherzustellen, dass immer leistungsfähigere und automatisiertere Modelle an menschlichen Werten und Prioritäten ausgerichtet sind. Wir müssen herausfinden, wie wir sicherstellen können, dass sich das Modell wie erwartet verhält, und nicht das Modell für unerwünschte Ergebnisse optimieren. Es ist wichtig, von Beginn des Modellentwicklungsprozesses an genaue Techniken zu integrieren. Auch die Transparenz und Interpretierbarkeit des Modells ist wichtig für die Beurteilung und Sicherstellung der Genauigkeit. Darüber hinaus zeichnet sich mit Blick auf die Zukunft eine noch schwierigere Herausforderung ab: die genaue Ausführung übermenschlicher Systeme. Obwohl diese Aufgabe derzeit unsere Anforderungen übersteigt, ist es wichtig, fortschrittliche Systeme wie Hezhun in Betracht zu ziehen und sich darauf vorzubereiten, da sie einzigartige Komplexitäten und ethische Probleme mit sich bringen können.

- Sicherheitsausrichtung. Während es wichtig ist, die existenziellen Risiken der KI zu diskutieren, brauchen wir praktische Forschung, um sicherzustellen, dass fortschrittliche KI sicher entwickelt werden kann. Dazu gehören Techniken zur Interpretierbarkeit, skalierbare Überwachung und Governance sowie formale Verifizierung von Modelleigenschaften. Bei der Konstruktion des Modells sollte Sicherheit nicht als Zusatz, sondern als integraler Bestandteil des Ganzen betrachtet werden.

- Prognostizieren Sie die Modellleistung, wenn sich ihre Größe ändert. Wenn Modellgröße und -komplexität erheblich zunehmen, ist es schwierig vorherzusagen, wie das Modell funktionieren wird. Es sollten Techniken entwickelt werden, um die Leistung von Modellen bei der Skalierung oder Verwendung neuer Architekturen besser vorhersagen zu können. Dadurch können wir Ressourcen effizienter nutzen und die Entwicklung beschleunigen. Es gibt einige Möglichkeiten: ein kleineres „Seed“-Modell zu trainieren und sein Wachstum durch Extrapolation vorherzusagen, die Auswirkungen einer Vergrößerung oder Anpassung des Modells zu simulieren und auf einem Prüfstand Modelle unterschiedlicher Größe zu iterieren, um ein Skalierungsgesetz zu erstellen. Dies gibt uns eine Vorstellung davon, wie das Modell funktionieren wird, bevor es gebaut wird.

Das obige ist der detaillierte Inhalt vonDer Evolutionsbaum großer Sprachmodelle, dies ist ein sehr detaillierter „Essen'-Leitfaden für ChatGPT. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

DALL-E 3 wurde im September 2023 offiziell als deutlich verbessertes Modell gegenüber seinem Vorgänger eingeführt. Er gilt als einer der bisher besten KI-Bildgeneratoren und ist in der Lage, Bilder mit komplexen Details zu erstellen. Zum Start war es jedoch exklusiv

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins

Das Neueste von der Universität Oxford! Mickey: 2D-Bildabgleich in 3D SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Das Neueste von der Universität Oxford! Mickey: 2D-Bildabgleich in 3D SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Projektlink vorne geschrieben: https://nianticlabs.github.io/mickey/ Anhand zweier Bilder kann die Kameraposition zwischen ihnen geschätzt werden, indem die Korrespondenz zwischen den Bildern hergestellt wird. Normalerweise handelt es sich bei diesen Entsprechungen um 2D-zu-2D-Entsprechungen, und unsere geschätzten Posen sind maßstabsunabhängig. Einige Anwendungen, wie z. B. Instant Augmented Reality jederzeit und überall, erfordern eine Posenschätzung von Skalenmetriken und sind daher auf externe Tiefenschätzer angewiesen, um die Skalierung wiederherzustellen. In diesem Artikel wird MicKey vorgeschlagen, ein Keypoint-Matching-Prozess, mit dem metrische Korrespondenzen im 3D-Kameraraum vorhergesagt werden können. Durch das Erlernen des 3D-Koordinatenabgleichs zwischen Bildern können wir auf metrische Relativwerte schließen