Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

OpenAI hat fast 100 Bosse professionell abgeworben! Große Unternehmen wie Google und Meta sind zu „Reserve-Talentpools' geworden

OpenAI hat fast 100 Bosse professionell abgeworben! Große Unternehmen wie Google und Meta sind zu „Reserve-Talentpools' geworden

OpenAI hat fast 100 Bosse professionell abgeworben! Große Unternehmen wie Google und Meta sind zu „Reserve-Talentpools' geworden

ChatGPT wurde sofort ein Hit und hat openAI, ein Start-up-Unternehmen, völlig zerstört. In nur 5 Tagen überstieg die Zahl der registrierten Benutzer weltweit 1 Million und seine Popularität ist bis heute ungebrochen.

Aber warum hat OpenAI ChatGPT erstellt? Welchen Hintergrund haben die Mitarbeiter von OpenAI?

OpenAI gewinnt den Kampf um Menschen

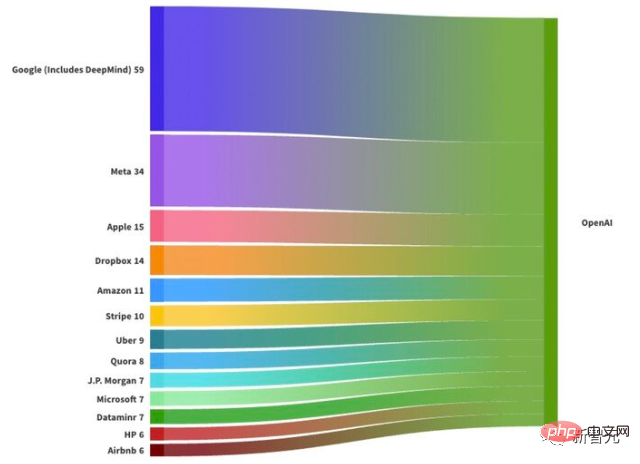

Laut der Analyse der ausländischen Medien Leadgenious Punks & Pinstripes über den Hintergrund der derzeit 736 OpenAI-Mitarbeiter kann festgestellt werden, dass fast alle Kerntalente von OpenAI von großen Technologieunternehmen stammen.

59 von ihnen arbeiteten zuvor bei Google, gefolgt von Meta (34 Personen), Apple (15 Personen), Dropbox (14 Personen) und Amazon (11 Personen).

Von den Mitarbeitern von OpenAI haben 389 in Hardware- oder Softwareunternehmen gearbeitet; 39 kommen aus der Finanzdienstleistungsbranche, darunter JP Morgan (7 ausländische Mitarbeiter), Robinhood (5) und UBS (3 Personen).

OpenAI hat den Kampf um technische Talente bereits gewonnen.

Die Forschungsergebnisse von LeadGenius schlagen auch für große Technologieunternehmen einen „Talentalarm“ Diese großen Technologieunternehmen, insbesondere Google, schenken ihren Mitarbeitern nicht genügend Aufmerksamkeit.

Viele derjenigen, die bei Google ausgeschieden sind, beschäftigen sich in Innovationslaboren (wie Alphabet eine sinnvolle Wirkung.

Und openAI kann ihnen diese Möglichkeit geben.

Darüber hinaus hat OpenAI 39 Finanzmitarbeiter eingestellt und damit die Erwartungen der Branche weit übertroffen. Bedeutet das, dass der nächste Schritt von OpenAI darin besteht, „die Finanzdienstleistungsbranche herauszufordern“?

Lisa Wardlaw, Präsidentin und Gründerin von 360 Digital Immersion, sagte: „Es ist noch zu früh, das zu sagen, aber sie bieten eine praktikable Option für Wall-Street-Talente, die nach neuen Optionen suchen.“ In der Ära, als Ge gegründet wurde Facebook brauchte man nur ein Studentenwohnheim oder eine Garage, um ein Weltklasseunternehmen zu gründen, während der Erfolg von OpenAI durch Abwerben großer Unternehmen erzielt wurde.

Google: OpenAIs Reserve-Talentpool

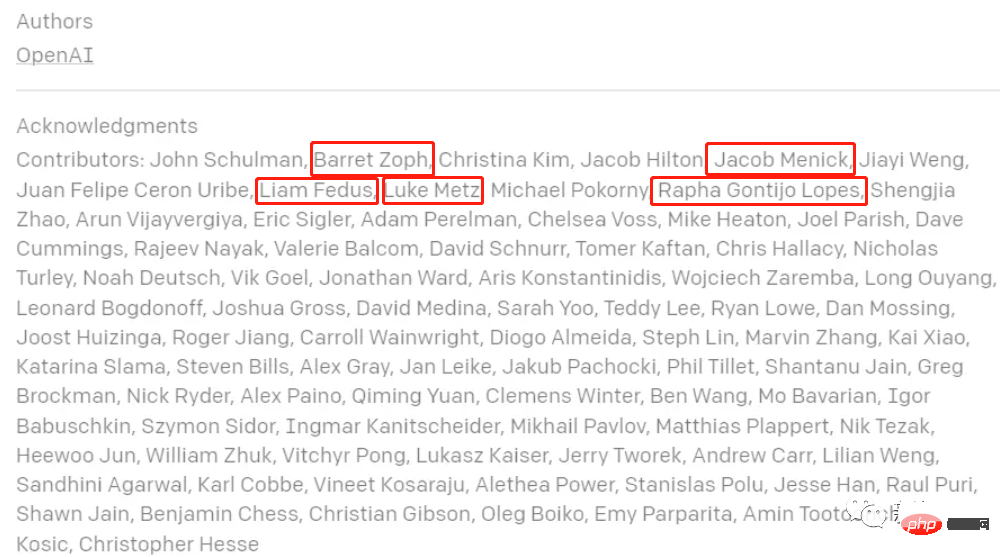

Bereits im letzten November im von ChatGPT veröffentlichten Blog-Beitrag sind im Danksagungsbereich die Namen von fünf Google-Mitarbeitern zu finden: Barret Zoph, Liam Fedus, Luke Metz, Jacob Menick, Rapha Gontijo Lope

LinkedIn zeigt, dass Barret Zoph im August 2022 Google Brain verließ und sich OpenAI anschloss, um an der Entwicklung von ChatGPT mitzuwirken. Seine Hauptforschungsrichtung ist das Training großer spärlicher Sprachmodelle und AuoML, wie z. B. Neural Structure Search (NAS). .

LinkedIn zeigt, dass Barret Zoph im August 2022 Google Brain verließ und sich OpenAI anschloss, um an der Entwicklung von ChatGPT mitzuwirken. Seine Hauptforschungsrichtung ist das Training großer spärlicher Sprachmodelle und AuoML, wie z. B. Neural Structure Search (NAS). .

Liam Fedus kam 2018 zu Google Brain und etwa im September 2022 zu OpenAI. Während seines Doktoratsstudiums an der Universität Montreal war sein Mentor der Turing-Award-Gewinner Yoshua Bengio. Seine Forschungsinteressen umfassten überwachtes, unüberwachtes und verstärkendes Lernen.

Liam Fedus kam 2018 zu Google Brain und etwa im September 2022 zu OpenAI. Während seines Doktoratsstudiums an der Universität Montreal war sein Mentor der Turing-Award-Gewinner Yoshua Bengio. Seine Forschungsinteressen umfassten überwachtes, unüberwachtes und verstärkendes Lernen.

Luke Metz kam 2016 als leitender Forschungswissenschaftler zu Google Brain. Auf seinen LinkedIn- und Twitter-Profilen wird derzeit nicht angezeigt, dass er OpenAI beigetreten ist.

Luke Metz kam 2016 als leitender Forschungswissenschaftler zu Google Brain. Auf seinen LinkedIn- und Twitter-Profilen wird derzeit nicht angezeigt, dass er OpenAI beigetreten ist.

Jacob Menick ist seit September 2015 bei DeepMind Im September 2022 kam er als Forscher zu OpenAI und schloss sein Studium am University College London mit einem Doktortitel ab. Seine Hauptforschungsrichtungen sind maschinelles Lernen, generative Muster, groß angelegtes Deep Learning, Variationsdenken, Informationstheorie und spärliche Modelle.

Jacob Menick ist seit September 2015 bei DeepMind Im September 2022 kam er als Forscher zu OpenAI und schloss sein Studium am University College London mit einem Doktortitel ab. Seine Hauptforschungsrichtungen sind maschinelles Lernen, generative Muster, groß angelegtes Deep Learning, Variationsdenken, Informationstheorie und spärliche Modelle.

Rapha Gontijo Lope schloss im Juni 2018 sein Studium am Georgia Institute of Technology ab und kam dann zu Google Brain, wo er am zweijährigen Google AI-Residency-Programm teilnahm, und kam im September 2022 zu OpenAI.

Rapha Gontijo Lope schloss im Juni 2018 sein Studium am Georgia Institute of Technology ab und kam dann zu Google Brain, wo er am zweijährigen Google AI-Residency-Programm teilnahm, und kam im September 2022 zu OpenAI.

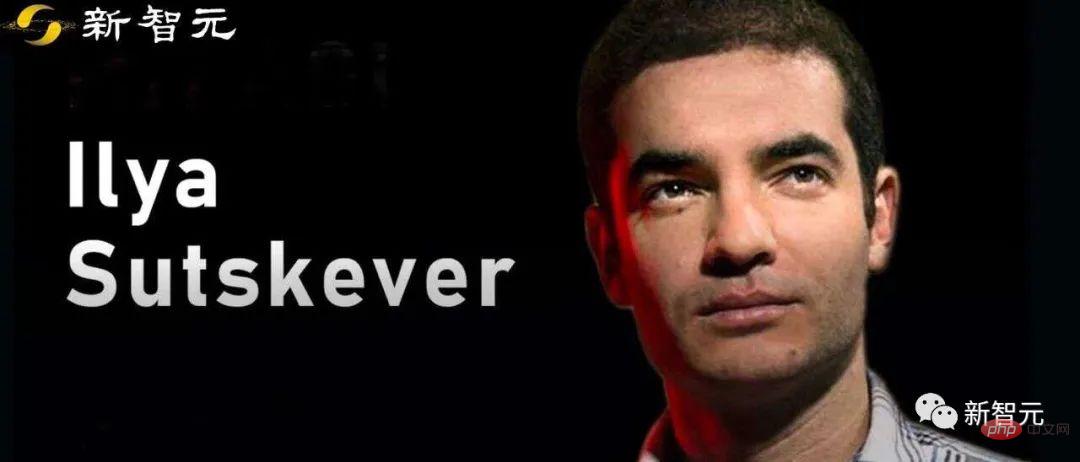

Allerdings Der größte Chef ist Ilya Sutskever, der Mitbegründer und Chefwissenschaftler von OpenAI. Er schloss 2005 sein Studium an der University of Toronto ab und promovierte 2012 in Informatik.

Allerdings Der größte Chef ist Ilya Sutskever, der Mitbegründer und Chefwissenschaftler von OpenAI. Er schloss 2005 sein Studium an der University of Toronto ab und promovierte 2012 in Informatik.

Seit seinem Abschluss arbeitete er an der Stanford University, DNN Research und Google Brain, beschäftigte sich mit der Forschung im Zusammenhang mit maschinellem Lernen und Deep Learning und gab sein Studium auf. 2015 hatte er eine zahlende Position bei Google inne, war zusammen mit Greg Brockman und anderen Mitbegründer von OpenAI und leitete die Forschung und Entwicklung der Modelle der Serien GPT-1, 2, 3 und DALLE bei OpenAI.

Google hat immer noch zu große Angst vor Risiken

Die meisten der oben genannten Mitarbeiter haben bei Google Brain gearbeitet. Einige Abteilungsmitarbeiter sagten in Interviews, dass die Arbeitskultur von Google Brain wirklich so sei Frustrierend ist neben der unangenehmen Bürokratie auch die übermäßige Zurückhaltung des Unternehmens bei neuen Produktvorschlägen, und viele Mitarbeiter denken darüber nach, zu gehen.

Darüber hinaus beschwerten sich einige Mitarbeiter darüber, dass sie einmal vorgeschlagen hatten, dass das Unternehmen der Suchmaschine eine Konversationsfunktion hinzufügen sollte, aber niemand achtete überhaupt darauf.

Allerdings ist Google Brain immer noch voller Talente und es gibt immer noch mehr als 800 Spitzenwissenschaftler aus aller Welt.

Darüber hinaus veröffentlichte AppSheet-Gründer Praveen Seshadri nach seinem Ausscheiden aus Google auch einen Blog. Er glaubte, dass Google in einem Labyrinth gefangen sei und die Mitarbeiter viel Energie für Genehmigungs- und Startprozesse, rechtliche Bewertungen und Leistung verschwendeten Evaluierungen, Executive Evaluationen, Dokumentation, Meetings, Fehlerberichte, Klassifizierungen, OKRs, H1-Pläne, nachfolgende H2-Pläne, All-Personal-Gipfeltreffen und Reorganisationen – eigentlich kann nur sehr wenig getan werden.

Gerade angesichts der Einkreisung und Unterdrückung von OpenAI und Microsoft steht Google nicht nur unter technischem Druck, sondern auch mit großen Entlassungen und anderen Problemen. Dies spiegelt in gewissem Maße wider, dass es bei Management und Mitarbeitern allgemein an Selbstbewusstsein mangelt.

Das größte Problem liegt immer noch in der Kernkultur von Google:

- Kein Missionsgefühl (keine Mission)

- Kein Gefühl der Dringlichkeit (keine Dringlichkeit)

- Exzeptionalismuswahn

- Missmanagement

Obwohl die beiden Grundwerte von Google „Nutzer respektieren“ und „ „Chancen respektieren“, in der Praxis sind diese Systeme und Prozesse jedoch bewusst darauf ausgelegt, „Risiken zu respektieren“.

Risikominderung geht über alles, und wenn alles gut geht, ist es das Wichtigste, Probleme zu vermeiden und mit steigenden Werbeeinnahmen voranzukommen:

- # 🎜🎜#Jede Zeile von Geänderter Code ist riskant, daher sind viele Zwischenprozesse erforderlich, um sicherzustellen, dass jede Codeänderung das Risiko perfekt vermeiden kann sogar eine kleine Änderung an einem kleinen Produkt veröffentlichen;

- Jede Entscheidung, die nicht offensichtlich ist, ist ein Risiko und muss von der Gruppe entschieden werden;

- #🎜🎜 #Alles, was anders gemacht wird als in der Vergangenheit ist ein Risiko, also bleiben Sie beim ursprünglichen Weg;

- Jeder Mitarbeiter, der mit Ihnen unzufrieden ist, stellt ein Karriererisiko dar, daher streben Manager eine 100-prozentige Mitarbeiterzufriedenheit an. Seien Sie vorsichtig, auch bei den Mitarbeitern mit der schlechtesten Leistung 🎜# Jede Meinungsverschiedenheit mit der Führungskette ist ein Karriererisiko. Akzeptieren Sie daher unbedingt Ihre Vorgesetzten. Fragen Sie sich beispielsweise jeden Tag: „Für wen habe ich heute Wert geschaffen?“ Wenn mehr Wert geschaffen und eine größere Wirkung erzielt werden kann, werden die Mitarbeiter härter arbeiten.

- In den Anfangsjahren hat Google hektisch Teile großer Unternehmen wie Meta abgeworben, um im „War for Talents“ seine eigenen Talentressourcen zu erweitern. Jetzt ist es zum Reserve-Talentpool von OpenAI geworden.

- Kein Wunder, dass Google nach der Popularität von ChatGPT „Alarmstufe Rot“ ausgelöst hat. Wenn es nicht auf den Schutz von Talenten achtet, werden alle von ihm ausgebildeten leitenden Forscher früher oder später abgeworben!

- Referenz:

Das obige ist der detaillierte Inhalt vonOpenAI hat fast 100 Bosse professionell abgeworben! Große Unternehmen wie Google und Meta sind zu „Reserve-Talentpools' geworden. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1363

1363

52

52

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

DALL-E 3 wurde im September 2023 offiziell als deutlich verbessertes Modell gegenüber seinem Vorgänger eingeführt. Er gilt als einer der bisher besten KI-Bildgeneratoren und ist in der Lage, Bilder mit komplexen Details zu erstellen. Zum Start war es jedoch exklusiv

Wählen Sie das Einbettungsmodell, das am besten zu Ihren Daten passt: Ein Vergleichstest von OpenAI und mehrsprachigen Open-Source-Einbettungen

Feb 26, 2024 pm 06:10 PM

Wählen Sie das Einbettungsmodell, das am besten zu Ihren Daten passt: Ein Vergleichstest von OpenAI und mehrsprachigen Open-Source-Einbettungen

Feb 26, 2024 pm 06:10 PM

OpenAI kündigte kürzlich die Einführung seines Einbettungsmodells embeddingv3 der neuesten Generation an, das seiner Meinung nach das leistungsstärkste Einbettungsmodell mit höherer Mehrsprachenleistung ist. Diese Reihe von Modellen ist in zwei Typen unterteilt: das kleinere Text-Embeddings-3-Small und das leistungsfähigere und größere Text-Embeddings-3-Large. Es werden nur wenige Informationen darüber offengelegt, wie diese Modelle entworfen und trainiert werden, und auf die Modelle kann nur über kostenpflichtige APIs zugegriffen werden. Es gab also viele Open-Source-Einbettungsmodelle. Aber wie schneiden diese Open-Source-Modelle im Vergleich zum Closed-Source-Modell von OpenAI ab? In diesem Artikel wird die Leistung dieser neuen Modelle empirisch mit Open-Source-Modellen verglichen. Wir planen, Daten zu erstellen

Ein neues Programmierparadigma, wenn Spring Boot auf OpenAI trifft

Feb 01, 2024 pm 09:18 PM

Ein neues Programmierparadigma, wenn Spring Boot auf OpenAI trifft

Feb 01, 2024 pm 09:18 PM

Im Jahr 2023 ist die KI-Technologie zu einem heißen Thema geworden und hat enorme Auswirkungen auf verschiedene Branchen, insbesondere im Programmierbereich. Die Bedeutung der KI-Technologie wird den Menschen zunehmend bewusst, und die Spring-Community bildet da keine Ausnahme. Mit der kontinuierlichen Weiterentwicklung der GenAI-Technologie (General Artificial Intelligence) ist es entscheidend und dringend geworden, die Erstellung von Anwendungen mit KI-Funktionen zu vereinfachen. Vor diesem Hintergrund entstand „SpringAI“ mit dem Ziel, den Prozess der Entwicklung von KI-Funktionsanwendungen zu vereinfachen, ihn einfach und intuitiv zu gestalten und unnötige Komplexität zu vermeiden. Durch „SpringAI“ können Entwickler einfacher Anwendungen mit KI-Funktionen erstellen, wodurch diese einfacher zu verwenden und zu bedienen sind.

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

Installationsschritte: 1. Laden Sie die ChatGTP-Software von der offiziellen ChatGTP-Website oder dem mobilen Store herunter. 2. Wählen Sie nach dem Öffnen in der Einstellungsoberfläche die Sprache aus. 3. Wählen Sie in der Spieloberfläche das Mensch-Maschine-Spiel aus 4. Geben Sie nach dem Start Befehle in das Chatfenster ein, um mit der Software zu interagieren.

Der Rust-basierte Zed-Editor ist Open Source und bietet integrierte Unterstützung für OpenAI und GitHub Copilot

Feb 01, 2024 pm 02:51 PM

Der Rust-basierte Zed-Editor ist Open Source und bietet integrierte Unterstützung für OpenAI und GitHub Copilot

Feb 01, 2024 pm 02:51 PM

Autor丨Zusammengestellt von TimAnderson丨Produziert von Noah|51CTO Technology Stack (WeChat-ID: blog51cto) Das Zed-Editor-Projekt befindet sich noch in der Vorabversionsphase und wurde unter AGPL-, GPL- und Apache-Lizenzen als Open Source bereitgestellt. Der Editor zeichnet sich durch hohe Leistung und mehrere KI-gestützte Optionen aus, ist jedoch derzeit nur auf der Mac-Plattform verfügbar. Nathan Sobo erklärte in einem Beitrag, dass in der Codebasis des Zed-Projekts auf GitHub der Editor-Teil unter der GPL lizenziert ist, die serverseitigen Komponenten unter der AGPL lizenziert sind und der GPUI-Teil (GPU Accelerated User) die Schnittstelle übernimmt Apache2.0-Lizenz. GPUI ist ein vom Zed-Team entwickeltes Produkt

Posthume Arbeit des OpenAI Super Alignment Teams: Zwei große Modelle spielen ein Spiel und die Ausgabe wird verständlicher

Jul 19, 2024 am 01:29 AM

Posthume Arbeit des OpenAI Super Alignment Teams: Zwei große Modelle spielen ein Spiel und die Ausgabe wird verständlicher

Jul 19, 2024 am 01:29 AM

Wenn die Antwort des KI-Modells überhaupt unverständlich ist, würden Sie es wagen, sie zu verwenden? Da maschinelle Lernsysteme in immer wichtigeren Bereichen eingesetzt werden, wird es immer wichtiger zu zeigen, warum wir ihren Ergebnissen vertrauen können und wann wir ihnen nicht vertrauen sollten. Eine Möglichkeit, Vertrauen in die Ausgabe eines komplexen Systems zu gewinnen, besteht darin, vom System zu verlangen, dass es eine Interpretation seiner Ausgabe erstellt, die für einen Menschen oder ein anderes vertrauenswürdiges System lesbar ist, d. h. so vollständig verständlich, dass mögliche Fehler erkannt werden können gefunden. Um beispielsweise Vertrauen in das Justizsystem aufzubauen, verlangen wir von den Gerichten, dass sie klare und lesbare schriftliche Stellungnahmen abgeben, die ihre Entscheidungen erläutern und stützen. Für große Sprachmodelle können wir auch einen ähnlichen Ansatz verfolgen. Stellen Sie bei diesem Ansatz jedoch sicher, dass das Sprachmodell generiert wird

Warten Sie nicht auf OpenAI, sondern darauf, dass Open-Sora vollständig Open Source ist

Mar 18, 2024 pm 08:40 PM

Warten Sie nicht auf OpenAI, sondern darauf, dass Open-Sora vollständig Open Source ist

Mar 18, 2024 pm 08:40 PM

Vor nicht allzu langer Zeit wurde OpenAISora mit seinen erstaunlichen Videogenerierungseffekten schnell populär und stach aus der Masse der literarischen Videomodelle hervor und rückte in den Mittelpunkt der weltweiten Aufmerksamkeit. Nach der Einführung des Sora-Trainings-Inferenzreproduktionsprozesses mit einer Kostenreduzierung von 46 % vor zwei Wochen hat das Colossal-AI-Team das weltweit erste Sora-ähnliche Architektur-Videogenerierungsmodell „Open-Sora1.0“ vollständig als Open-Source-Lösung bereitgestellt, das das gesamte Spektrum abdeckt Lernen Sie den Trainingsprozess, einschließlich der Datenverarbeitung, aller Trainingsdetails und Modellgewichte, kennen und schließen Sie sich mit globalen KI-Enthusiasten zusammen, um eine neue Ära der Videoerstellung voranzutreiben. Schauen wir uns für einen kleinen Vorgeschmack ein Video einer geschäftigen Stadt an, das mit dem vom Colossal-AI-Team veröffentlichten Modell „Open-Sora1.0“ erstellt wurde. Open-Sora1.0

Die lokale Ausführungsleistung des Embedding-Dienstes übertrifft die von OpenAI Text-Embedding-Ada-002, was sehr praktisch ist!

Apr 15, 2024 am 09:01 AM

Die lokale Ausführungsleistung des Embedding-Dienstes übertrifft die von OpenAI Text-Embedding-Ada-002, was sehr praktisch ist!

Apr 15, 2024 am 09:01 AM

Ollama ist ein superpraktisches Tool, mit dem Sie Open-Source-Modelle wie Llama2, Mistral und Gemma problemlos lokal ausführen können. In diesem Artikel werde ich vorstellen, wie man Ollama zum Vektorisieren von Text verwendet. Wenn Sie Ollama nicht lokal installiert haben, können Sie diesen Artikel lesen. In diesem Artikel verwenden wir das Modell nomic-embed-text[2]. Es handelt sich um einen Text-Encoder, der OpenAI text-embedding-ada-002 und text-embedding-3-small bei kurzen und langen Kontextaufgaben übertrifft. Starten Sie den nomic-embed-text-Dienst, wenn Sie o erfolgreich installiert haben