Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

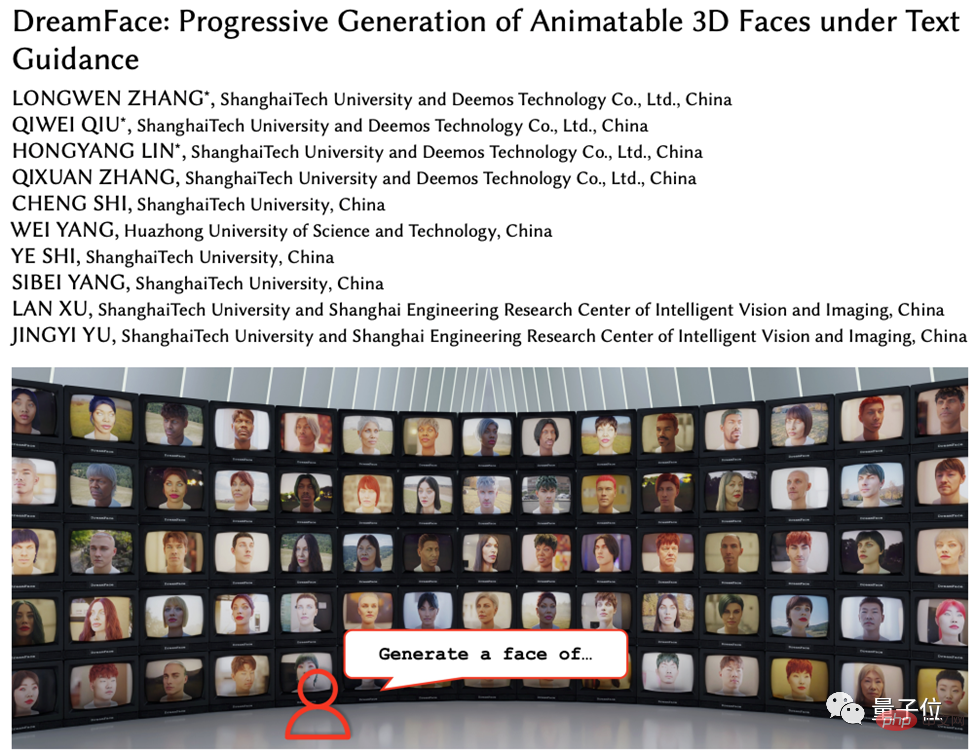

Erzeugen Sie in fünf Minuten einen digitalen 3D-Menschen von Marvel! Der amerikanische Spider-Man und der Joker können es alle und die Gesichtsdetails werden in High Definition wiederhergestellt.

Erzeugen Sie in fünf Minuten einen digitalen 3D-Menschen von Marvel! Der amerikanische Spider-Man und der Joker können es alle und die Gesichtsdetails werden in High Definition wiederhergestellt.

Erzeugen Sie in fünf Minuten einen digitalen 3D-Menschen von Marvel! Der amerikanische Spider-Man und der Joker können es alle und die Gesichtsdetails werden in High Definition wiederhergestellt.

Mit der Entwicklung der Computergrafik wird die 3D-Generierungstechnologie allmählich zu einem Forschungsschwerpunkt. Allerdings gibt es noch viele Herausforderungen bei der Generierung von 3D-Modellen aus Text oder Bildern.

Kürzlich haben Unternehmen wie Google, NVIDIA und Microsoft 3D-Generierungsmethoden auf Basis neuronaler Strahlungsfelder (NeRF) eingeführt, diese Methoden weisen jedoch Kompatibilitätsprobleme und Einschränkungen mit herkömmlicher 3D-Rendering-Software (wie Unity, Unreal Engine, Maya, usw.) seine breite Anwendung in praktischen Anwendungen.

Zu diesem Zweck schlug das Forschungs- und Entwicklungsteam von Yingmo Technology und der ShanghaiTech University ein textgesteuertes progressives 3D-Generierungsframework vor, das diese Probleme lösen soll.

Generieren Sie 3D-Assets basierend auf Textbeschreibungen

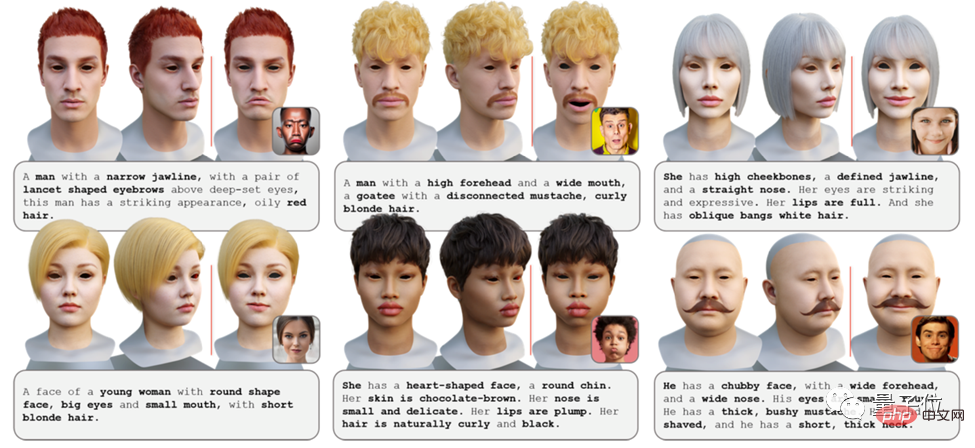

Das vom Forschungsteam vorgeschlagene textgesteuerte progressive 3D-Generierungsframework (kurz DreamFace) kombiniert das visuelle Sprachmodell, das implizite Diffusionsmodell und die physikbasierte Materialdiffusionstechnologie, um computergestützte konforme Grafikproduktionsstandard-3D-Assets.

Die Innovation dieses Frameworks liegt in seinen drei Modulen: Geometriegenerierung, physikbasierte Materialdiffusionsgenerierung und Animationsfähigkeitsgenerierung.

Diese Arbeit wurde von der Top-Zeitschrift Transactions on Graphics angenommen und wird auf der SIGGRAPH 2023, der führenden internationalen Computergrafikkonferenz, präsentiert.

Projektwebsite: https://sites.google.com/view/dreamface

Vordruckpapier: https://arxiv.org/abs/2304.03117

Webdemo: https: //hyperhuman.top

HuggingFace Space: https://huggingface.co/spaces/DEEMOSTECH/ChatAvatar

So implementieren Sie die drei Hauptfunktionen von DreamFace

DreamFace umfasst hauptsächlich drei Module, die auf der Geometriegenerierung basieren Physik Materialdiffusion und Animationsfähigkeiten werden generiert. Im Vergleich zu früheren Arbeiten zur 3D-Generierung gehören zu den Hauptbeiträgen dieser Arbeit:

- Vorgeschlagenes DreamFace, ein neuartiges Generationsschema, das aktuelle visuelle Sprachmodelle mit animierbaren und physikalisch materialisierbaren Gesichtselementen kombiniert, durch progressives Formellernen zur Trennung von Geometrie, Aussehen und Animationsmöglichkeiten.

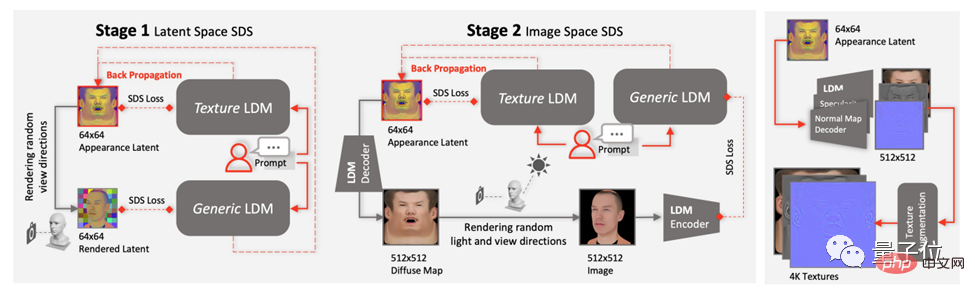

- Führt das Design der Zweikanal-Erscheinungsgenerierung ein, indem ein neuartiges Materialdiffusionsmodell mit einem vorab trainierten Modell kombiniert und gleichzeitig eine zweistufige Optimierung im latenten Raum und im Bildraum durchgeführt wird.

- Gesichtselemente mit BlendShapes oder generierten personalisierten BlendShapes werden animiert und demonstrieren zusätzlich die Verwendung von DreamFace für die Gestaltung natürlicher Charaktere.

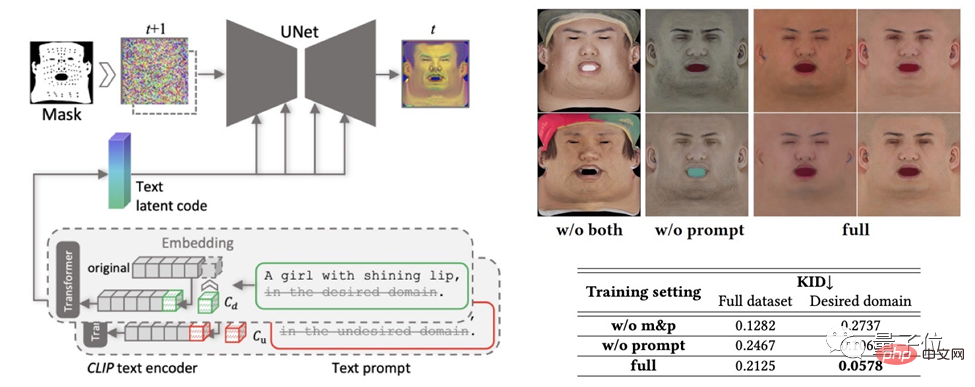

Geometriegenerierung: Dieses Modul generiert geometrische Modelle basierend auf Textaufforderungen über das CLIP-Auswahlframework (Contrastive Language-Image Pre-Training).

Stichproben Sie zunächst zufällig Kandidaten aus dem geometrischen Gesichtsparameterraum und wählen Sie dann basierend auf Textaufforderungen das grobe geometrische Modell mit der höchsten Übereinstimmungsbewertung aus.

Als nächstes werden dem groben Geometriemodell mithilfe des Implicit Diffusion Model (LDM) und der Scored Distillation Sampling (SDS)-Verarbeitung Gesichtsdetails und detaillierte Normalkarten hinzugefügt, um hochpräzise Geometrie zu erzeugen.

Physikalisch basierte Materialdiffusionsgenerierung: Dieses Modul generiert Gesichtstexturen für vorhergesagte Geometrie und Texthinweise. Zunächst wird das LDM feinabgestimmt, um zwei Diffusionsmodelle zu erhalten.

Die beiden Modelle werden dann durch ein gemeinsames Trainingsschema koordiniert, eines für die direkte Entrauschung von U-Texturkarten und das andere für überwachte gerenderte Bilder. Darüber hinaus werden eine Hinweis-Lernstrategie und eine Nicht-Gesichtsbereichsmaskierung eingesetzt, um die Qualität der generierten diffusen Karten sicherzustellen.

Abschließend wenden Sie das Super-Resolution-Modul an, um physikalisch basierte 4K-Texturen für ein hochwertiges Rendering zu generieren.

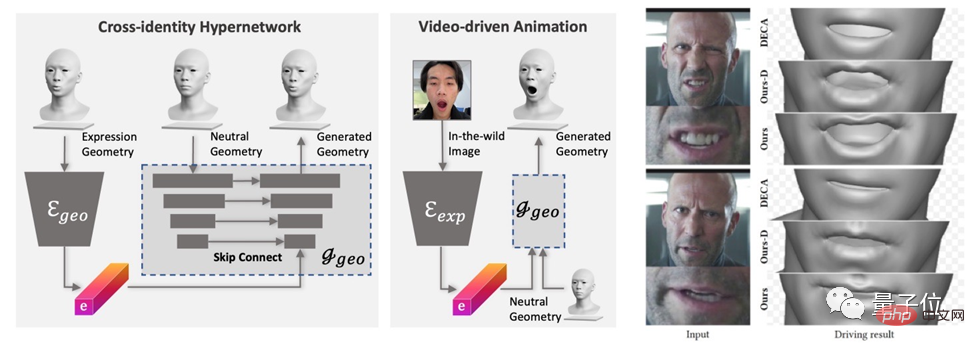

Animationsfunktionsgenerierung: Das von DreamFace generierte Modell verfügt über Animationsfunktionen. Im Gegensatz zu herkömmlichen BlendShapes-basierten Methoden animiert dieses Framework das Neutralmodell, indem es einzigartige Verformungen vorhersagt, um personalisierte Animationen zu generieren.

Trainieren Sie zunächst den geometrischen Generator, um den latenten Ausdrucksraum zu lernen, und trainieren Sie dann den Ausdrucksencoder, um Ausdrucksmerkmale aus RGB-Bildern zu extrahieren. Abschließend werden mithilfe monokularer RGB-Bilder personalisierte Animationen generiert.

Generieren Sie spezifizierte 3D-Assets in 5 Minuten

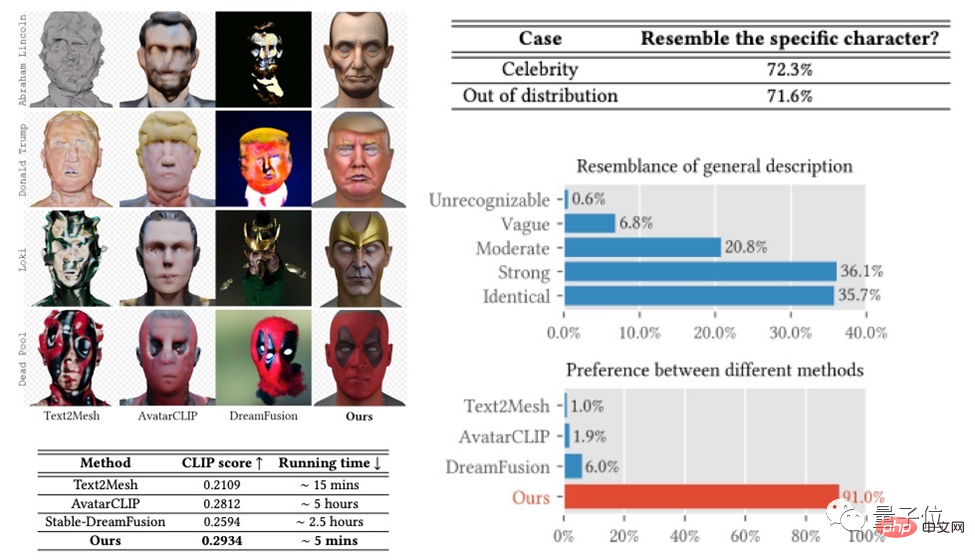

Das DreamFace-Framework hat bei Aufgaben wie der Generierung von Prominenten und Beschreibungen gute Ergebnisse erzielt und bei Benutzerbewertungen Ergebnisse erzielt, die frühere Arbeiten übertreffen.

Gleichzeitig weist es gegenüber bestehenden Methoden deutliche Laufzeitvorteile auf.

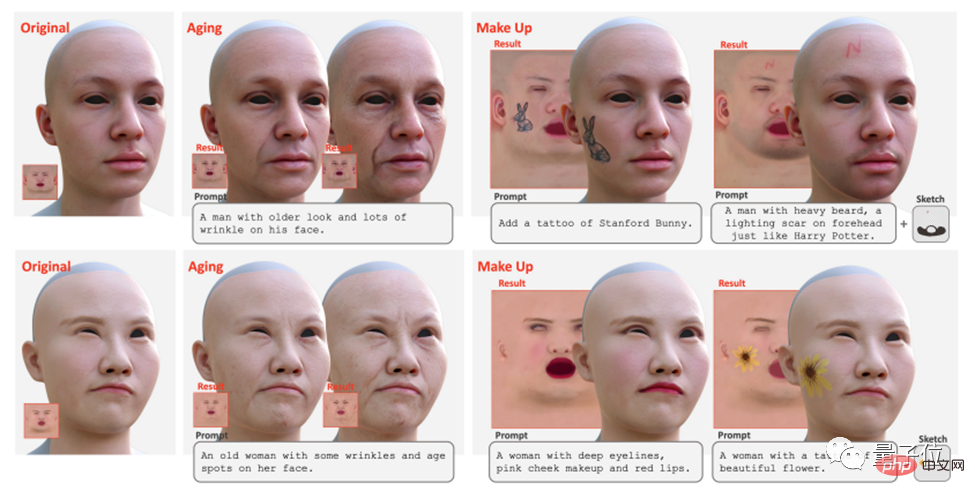

Darüber hinaus unterstützt DreamFace die Texturbearbeitung mithilfe von Tipps und Skizzen, um globale Bearbeitungseffekte (z. B. Alterung, Make-up) und lokale Bearbeitungseffekte (z. B. Tätowierungen, Bärte, Muttermale) zu erzielen.

Kann in Film, Fernsehen, Spielen und anderen Branchen verwendet werden

Als textgesteuertes progressives 3D-Generierungsframework kombiniert DreamFace das visuelle Sprachmodell, das implizite Diffusionsmodell und die physikbasierte Materialdiffusionstechnologie Erreichen Sie eine 3D-Generierung mit hoher Präzision, Effizienz und guter Kompatibilität.

Dieses Framework bietet eine effektive Lösung zur Lösung komplexer 3D-Generierungsaufgaben und soll weitere ähnliche Forschungs- und Technologieentwicklungen fördern.

Darüber hinaus wird die physikalisch basierte Materialdiffusionsgenerierung und die Generierung von Animationsfähigkeiten die Anwendung der 3D-Generierungstechnologie in der Film- und Fernsehproduktion, der Spieleentwicklung und anderen verwandten Branchen fördern.

Das obige ist der detaillierte Inhalt vonErzeugen Sie in fünf Minuten einen digitalen 3D-Menschen von Marvel! Der amerikanische Spider-Man und der Joker können es alle und die Gesichtsdetails werden in High Definition wiederhergestellt.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1379

1379

52

52

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Oben geschrieben und persönliches Verständnis des Autors. Dreidimensionales Gaussplatting (3DGS) ist eine transformative Technologie, die in den letzten Jahren in den Bereichen explizite Strahlungsfelder und Computergrafik entstanden ist. Diese innovative Methode zeichnet sich durch die Verwendung von Millionen von 3D-Gaußkurven aus, was sich stark von der Neural Radiation Field (NeRF)-Methode unterscheidet, die hauptsächlich ein implizites koordinatenbasiertes Modell verwendet, um räumliche Koordinaten auf Pixelwerte abzubilden. Mit seiner expliziten Szenendarstellung und differenzierbaren Rendering-Algorithmen garantiert 3DGS nicht nur Echtzeit-Rendering-Fähigkeiten, sondern führt auch ein beispielloses Maß an Kontrolle und Szenenbearbeitung ein. Dies positioniert 3DGS als potenziellen Game-Changer für die 3D-Rekonstruktion und -Darstellung der nächsten Generation. Zu diesem Zweck geben wir erstmals einen systematischen Überblick über die neuesten Entwicklungen und Anliegen im Bereich 3DGS.

Erfahren Sie mehr über 3D Fluent-Emojis in Microsoft Teams

Apr 24, 2023 pm 10:28 PM

Erfahren Sie mehr über 3D Fluent-Emojis in Microsoft Teams

Apr 24, 2023 pm 10:28 PM

Sie müssen bedenken, insbesondere wenn Sie Teams-Benutzer sind, dass Microsoft seiner arbeitsorientierten Videokonferenz-App eine neue Reihe von 3DFluent-Emojis hinzugefügt hat. Nachdem Microsoft letztes Jahr 3D-Emojis für Teams und Windows angekündigt hatte, wurden im Rahmen des Prozesses tatsächlich mehr als 1.800 bestehende Emojis für die Plattform aktualisiert. Diese große Idee und die Einführung des 3DFluent-Emoji-Updates für Teams wurden erstmals über einen offiziellen Blogbeitrag beworben. Das neueste Teams-Update bringt FluentEmojis in die App. Laut Microsoft werden uns die aktualisierten 1.800 Emojis täglich zur Verfügung stehen

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

0. Vorab geschrieben&& Persönliches Verständnis, dass autonome Fahrsysteme auf fortschrittlichen Wahrnehmungs-, Entscheidungs- und Steuerungstechnologien beruhen, indem sie verschiedene Sensoren (wie Kameras, Lidar, Radar usw.) verwenden, um die Umgebung wahrzunehmen, und Algorithmen und Modelle verwenden für Echtzeitanalysen und Entscheidungsfindung. Dies ermöglicht es Fahrzeugen, Verkehrszeichen zu erkennen, andere Fahrzeuge zu erkennen und zu verfolgen, das Verhalten von Fußgängern vorherzusagen usw. und sich so sicher an komplexe Verkehrsumgebungen anzupassen. Diese Technologie erregt derzeit große Aufmerksamkeit und gilt als wichtiger Entwicklungsbereich für die Zukunft des Transportwesens . eins. Aber was autonomes Fahren schwierig macht, ist herauszufinden, wie man dem Auto klarmachen kann, was um es herum passiert. Dies erfordert, dass der dreidimensionale Objekterkennungsalgorithmus im autonomen Fahrsystem Objekte in der Umgebung, einschließlich ihrer Standorte, genau wahrnehmen und beschreiben kann.

CLIP-BEVFormer: Überwacht explizit die BEVFormer-Struktur, um die Leistung der Long-Tail-Erkennung zu verbessern

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: Überwacht explizit die BEVFormer-Struktur, um die Leistung der Long-Tail-Erkennung zu verbessern

Mar 26, 2024 pm 12:41 PM

Oben geschrieben und das persönliche Verständnis des Autors: Derzeit spielt das Wahrnehmungsmodul im gesamten autonomen Fahrsystem eine entscheidende Rolle Das Steuermodul im autonomen Fahrsystem trifft zeitnahe und korrekte Urteile und Verhaltensentscheidungen. Derzeit sind Autos mit autonomen Fahrfunktionen in der Regel mit einer Vielzahl von Dateninformationssensoren ausgestattet, darunter Rundumsichtkamerasensoren, Lidar-Sensoren und Millimeterwellenradarsensoren, um Informationen in verschiedenen Modalitäten zu sammeln und so genaue Wahrnehmungsaufgaben zu erfüllen. Der auf reinem Sehen basierende BEV-Wahrnehmungsalgorithmus wird von der Industrie aufgrund seiner geringen Hardwarekosten und einfachen Bereitstellung bevorzugt, und seine Ausgabeergebnisse können problemlos auf verschiedene nachgelagerte Aufgaben angewendet werden.

Paint 3D in Windows 11: Download-, Installations- und Nutzungshandbuch

Apr 26, 2023 am 11:28 AM

Paint 3D in Windows 11: Download-, Installations- und Nutzungshandbuch

Apr 26, 2023 am 11:28 AM

Als sich das Gerücht verbreitete, dass das neue Windows 11 in der Entwicklung sei, war jeder Microsoft-Nutzer neugierig, wie das neue Betriebssystem aussehen und was es bringen würde. Nach Spekulationen ist Windows 11 da. Das Betriebssystem kommt mit neuem Design und funktionalen Änderungen. Zusätzlich zu einigen Ergänzungen werden Funktionen eingestellt und entfernt. Eine der Funktionen, die es in Windows 11 nicht gibt, ist Paint3D. Während es immer noch klassisches Paint bietet, das sich gut für Zeichner, Kritzler und Kritzler eignet, verzichtet es auf Paint3D, das zusätzliche Funktionen bietet, die sich ideal für 3D-Ersteller eignen. Wenn Sie nach zusätzlichen Funktionen suchen, empfehlen wir Autodesk Maya als beste 3D-Designsoftware. wie

Holen Sie sich mit einer einzigen Karte in 30 Sekunden eine virtuelle 3D-Frau! Text to 3D generiert einen hochpräzisen digitalen Menschen mit klaren Porendetails und lässt sich nahtlos mit Maya, Unity und anderen Produktionstools verbinden

May 23, 2023 pm 02:34 PM

Holen Sie sich mit einer einzigen Karte in 30 Sekunden eine virtuelle 3D-Frau! Text to 3D generiert einen hochpräzisen digitalen Menschen mit klaren Porendetails und lässt sich nahtlos mit Maya, Unity und anderen Produktionstools verbinden

May 23, 2023 pm 02:34 PM

ChatGPT hat der KI-Branche eine Portion Hühnerblut injiziert, und alles, was einst undenkbar war, ist heute zur gängigen Praxis geworden. Text-to-3D, das immer weiter voranschreitet, gilt nach Diffusion (Bilder) und GPT (Text) als nächster Hotspot im AIGC-Bereich und hat beispiellose Aufmerksamkeit erhalten. Nein, ein Produkt namens ChatAvatar befindet sich in einer unauffälligen öffentlichen Betaphase, hat schnell über 700.000 Aufrufe und Aufmerksamkeit erregt und wurde auf Spacesoftheweek vorgestellt. △ChatAvatar wird auch die Imageto3D-Technologie unterstützen, die 3D-stilisierte Charaktere aus KI-generierten Einzel-/Mehrperspektive-Originalgemälden generiert. Das von der aktuellen Beta-Version generierte 3D-Modell hat große Beachtung gefunden.

Das Neueste von der Universität Oxford! Mickey: 2D-Bildabgleich in 3D SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Das Neueste von der Universität Oxford! Mickey: 2D-Bildabgleich in 3D SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Projektlink vorne geschrieben: https://nianticlabs.github.io/mickey/ Anhand zweier Bilder kann die Kameraposition zwischen ihnen geschätzt werden, indem die Korrespondenz zwischen den Bildern hergestellt wird. Normalerweise handelt es sich bei diesen Entsprechungen um 2D-zu-2D-Entsprechungen, und unsere geschätzten Posen sind maßstabsunabhängig. Einige Anwendungen, wie z. B. Instant Augmented Reality jederzeit und überall, erfordern eine Posenschätzung von Skalenmetriken und sind daher auf externe Tiefenschätzer angewiesen, um die Skalierung wiederherzustellen. In diesem Artikel wird MicKey vorgeschlagen, ein Keypoint-Matching-Prozess, mit dem metrische Korrespondenzen im 3D-Kameraraum vorhergesagt werden können. Durch das Erlernen des 3D-Koordinatenabgleichs zwischen Bildern können wir auf metrische Relativwerte schließen

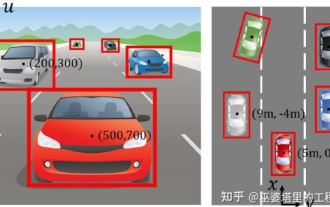

Eine ausführliche Interpretation des visuellen 3D-Wahrnehmungsalgorithmus für autonomes Fahren

Jun 02, 2023 pm 03:42 PM

Eine ausführliche Interpretation des visuellen 3D-Wahrnehmungsalgorithmus für autonomes Fahren

Jun 02, 2023 pm 03:42 PM

Für autonome Fahranwendungen ist es letztlich notwendig, 3D-Szenen wahrzunehmen. Der Grund ist einfach. Ein Fahrzeug kann nicht auf der Grundlage der aus einem Bild gewonnenen Wahrnehmungsergebnisse fahren. Selbst ein menschlicher Fahrer kann nicht auf der Grundlage eines Bildes fahren. Da die Entfernung des Objekts und die Tiefeninformationen der Szene nicht in den 2D-Wahrnehmungsergebnissen widergespiegelt werden können, sind diese Informationen der Schlüssel für das autonome Fahrsystem, um korrekte Urteile über die Umgebung zu fällen. Im Allgemeinen werden die Sichtsensoren (z. B. Kameras) autonomer Fahrzeuge über der Karosserie oder am Rückspiegel im Fahrzeuginneren installiert. Egal wo sie ist, was die Kamera erhält, ist die Projektion der realen Welt in der perspektivischen Ansicht (PerspectiveView) (Weltkoordinatensystem zu Bildkoordinatensystem). Diese Sicht ist dem menschlichen visuellen System sehr ähnlich.