Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Setzen Sie KI ein, um Tastaturkrieger und Internet-Trolle zu bekämpfen und das Leben derjenigen zu schützen, die online gemobbt werden

Setzen Sie KI ein, um Tastaturkrieger und Internet-Trolle zu bekämpfen und das Leben derjenigen zu schützen, die online gemobbt werden

Setzen Sie KI ein, um Tastaturkrieger und Internet-Trolle zu bekämpfen und das Leben derjenigen zu schützen, die online gemobbt werden

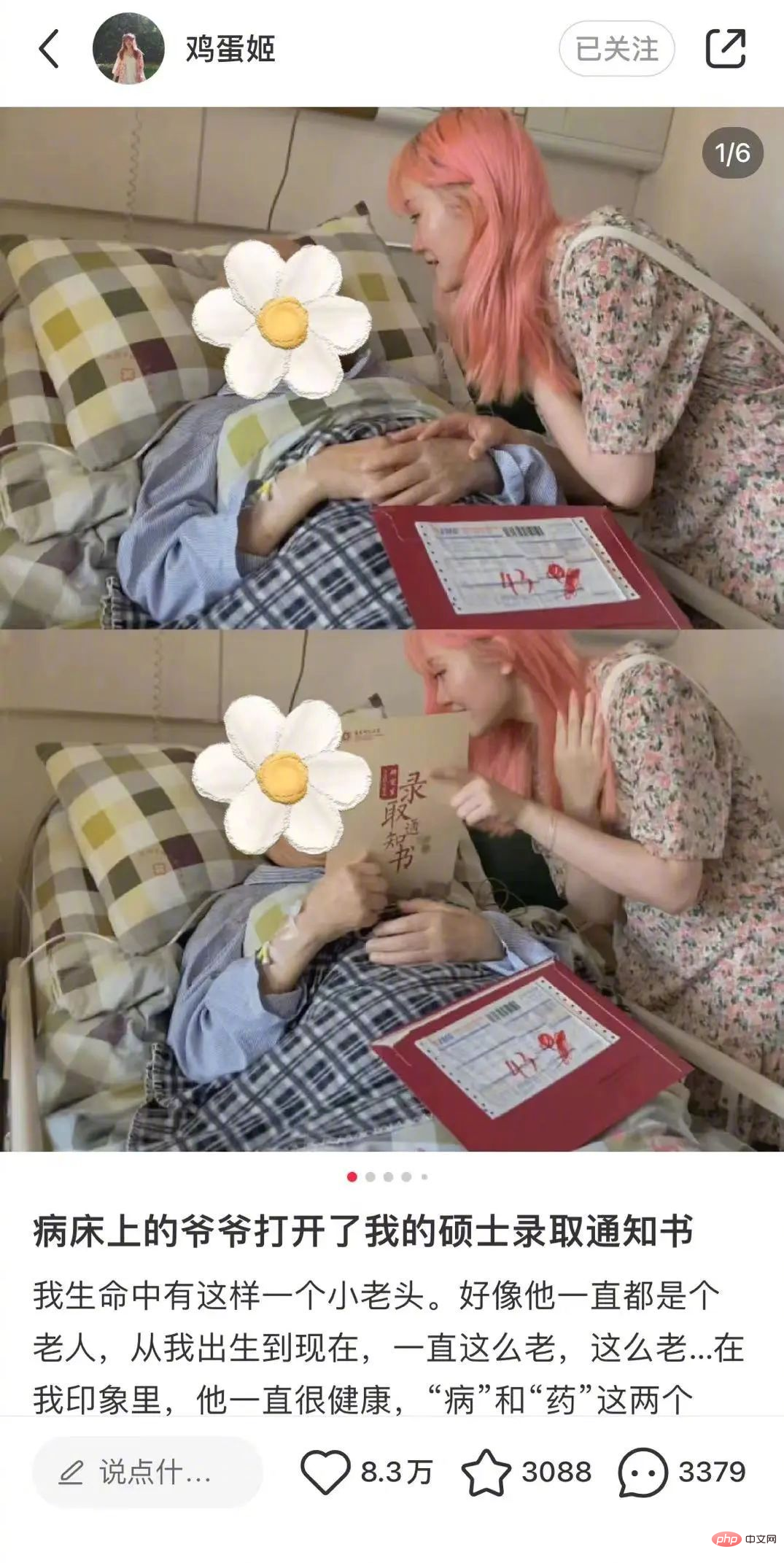

Ein 1995 geborenes Mädchen beging Selbstmord, weil sie einen Blogbeitrag online gestellt hatte.

Nach der Veröffentlichung dieses zarten Blogbeitrags stieß der Protagonist Zheng Linghua auf viele Gerüchte und Beschimpfungen.

Manche Leute stellen ihre Identität in Frage und verbreiten Gerüchte, dass sie eine „Bardame“ sei, nur weil ihre Haare rosa sind; andere verbreiten Gerüchte, dass sie eine „junge und alte Liebe“, „Chaliu“ und „Lügnerin“ sei und verbreiten Gerüchte über sie Verdienen Sie Geld, indem Sie die Krankheit Ihres Großvaters ausnutzen.

Es ist so hässlich. Obwohl viele Medien die Gerüchte widerlegten, erhielt Zheng Linghua keine Entschuldigung. Selbst als Zheng Linghua zu den legalen Waffen griff, um ihre Rechte zu verteidigen, wurde sie dennoch schikaniert.

Am Ende litt Zheng Linghua an Depressionen und beendete sein Leben vor nicht allzu langer Zeit.

Solche Dinge sind im Internet schon oft passiert. Diese Art von „schrecklichen Worten“, die die Online-Welt durchdringen, löst bei den Menschen nicht nur Ekel aus, sondern kann sogar Menschen das Leben kosten Verhalten – Cyber-Gewalt, auch „Cyber-Gewalt“ genannt.

Kann KI heute, wo KI bereits fließend mit Menschen kommunizieren kann, eine Rolle bei der Identifizierung von Cyber-Gräueltaten spielen?

Nachdem zwei große Schwierigkeiten überwunden wurden, liegt die Genauigkeit bei der Identifizierung gewalttätiger Online-Sprache bei über 90 %

Obwohl die meisten Internetplattformen einige Systeme zur Identifizierung spezieller Sprache eingeführt haben, erkennen und erkennen die meisten dieser Systeme nur Schlüsselwörter. Das Löschen ist offensichtlich nicht schlau genug, und diese Einschränkungen können mit ein wenig Aufmerksamkeit umgangen werden.

Um gewalttätige Äußerungen im Internet genau zu identifizieren, müssen tatsächlich zwei Dinge getan werden:

- Wie kann man gewalttätige Äußerungen im Internet anhand des Kontexts genau identifizieren?

- Wie erkennt man effektiv gewalttätige Online-Kommentare?

Das erste, worauf man achten sollte, ist der Inhalt von Bemerkungen zu Cyber-Gewalt, da die meisten Briefe und Nachrichten im Internet segmentiert sind und Cyber-Gewalt oft während des Gesprächs allmählich ernst wird und schließlich negative Konsequenzen hat .

Der zweite Punkt, der Anlass zur Sorge gibt, ist die Geschwindigkeit. Denn im Internet müssen zu viele Daten verarbeitet werden. Wenn die Erkennung lange dauert, hat das System keinen praktischen Nutzen und wird nicht übernommen .

Ein Forscherteam in Großbritannien hat ein neues Modell für künstliche Intelligenz namens BiCapsHate entwickelt, das diese beiden Herausforderungen bewältigt. Die Ergebnisse wurden am 19. Januar in IEEE Transactions on Computational in einem Artikel in Social Systems veröffentlicht.

Das Modell besteht aus fünf Schichten eines tiefen neuronalen Netzwerks, das mit einer Eingabeschicht beginnt, die den Eingabetext verarbeitet, dann zu einer Einbettungsschicht, die den Text in eine numerische Darstellung einbettet, und dann zu einer BiCaps-Schicht Beim Erlernen der sequentiellen und sprachlichen Kontextdarstellung bereitet die dichte Schicht das Modell für die endgültige Klassifizierung vor und die endgültige Ausgabeschicht gibt die Ergebnisse aus.

Die BiCaps-Ebene ist die wichtigste Komponente. Sie erhält über Kapselnetzwerke effektiv Kontextinformationen in verschiedene Richtungen vor und nach dem Eingabetext. Machen Sie Ihr Modell dank einer Fülle handabgestimmter flacher und tiefer Hilfsfunktionen (einschließlich Hatebase-Wörterbüchern) noch informativer. Die Forscher führten umfangreiche Experimente mit fünf Benchmark-Datensätzen durch, um die Wirksamkeit des vorgeschlagenen BiCapsHate-Modells zu demonstrieren. Die Gesamtergebnisse zeigen, dass BiCapsHate die bestehenden hochmodernen Methoden, einschließlich fBERT, HateBERT und ToxicBERT, übertrifft.

Bei ausgeglichenen und unausgeglichenen Datensätzen erreicht BiCapsHate eine F-Score-Genauigkeit von 94 % bzw. 92 %.

Schnell und kann auf GPU ausgeführt werden

Tarique Anwar ist Dozent am Fachbereich Informatik der University of York und hat an dieser Forschung teilgenommen. Er wies darauf hin, dass Online-Debatten häufig zu negativen, hasserfüllten und beleidigenden Trolling-Kommentaren führen, die nicht durch bestehende Praktiken zur Inhaltsmoderation auf Social-Media-Plattformen kontrolliert werden können.

Er sagte: „Darüber hinaus spiegeln Hassreden im Internet manchmal reale Umstände wider und führen zu Kriminalität und gewalttätigem Verhalten.“ Tariq Anwar sagte auch, dass es mehrere Beispiele dafür gibt, dass Hassreden im Internet zu körperlicher Gewalt und Unruhen führen.

Um zur Lösung dieses Problems beizutragen, hat das Team von Tariq Anwar beschlossen, BiCapsHate zu entwickeln, und es hat sehr gute Ergebnisse erzielt.

Wie Anwar betonte, kann Sprache in manchen Fällen mehrdeutig sein, d. h. ein Wort kann in einem Kontext positiv und in einem anderen negativ sein. Frühere Modelle wie HateBERT, toxicBERT und fBERT waren in dieser Hinsicht nicht gut genug. Diese künstlichen Intelligenzen können den Kontext bis zu einem gewissen Grad erfassen, aber Tariq Anwar glaubt, dass „diese immer noch nicht gut genug sind“.

Ein weiterer Vorteil von BiCapsHate ist die Fähigkeit des Modells, Berechnungen mit begrenzten Hardwareressourcen durchzuführen. „[Andere Modelle] erfordern High-End-Hardwareressourcen wie GPUs und High-End-Systeme für die Datenverarbeitung“, erklärte Tariq Anwar. „Im Gegensatz dazu kann BiCapsHate... auf einer CPU-Maschine ausgeführt werden, selbst wenn Sie nur über 8 GB Speicher verfügen.“ Es ist erwähnenswert, dass diese künstliche Intelligenz bisher nur für die Analyse von Englisch entwickelt und getestet wurde Sprache, daher muss es in andere Sprachen angepasst werden. Es ist auch weniger gut darin, beleidigende Worte mit einem milden oder subtilen hasserfüllten Ton zu erkennen, als intensivere Hassreden.

Die Forscher hoffen, als nächstes Möglichkeiten zur Beurteilung der psychischen Gesundheit von Nutzern zu untersuchen, die online Hass äußern. Wenn man befürchtet, dass die Person psychisch instabil ist und gegenüber Menschen in der realen Welt körperlich gewalttätig sein könnte, kann ein frühzeitiges Eingreifen in Betracht gezogen werden, um die Wahrscheinlichkeit zu verringern, dass dies geschieht.

Das obige ist der detaillierte Inhalt vonSetzen Sie KI ein, um Tastaturkrieger und Internet-Trolle zu bekämpfen und das Leben derjenigen zu schützen, die online gemobbt werden. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Welche Methode wird verwendet, um Strings in Objekte in Vue.js umzuwandeln?

Apr 07, 2025 pm 09:39 PM

Bei der Konvertierung von Zeichenfolgen in Objekte in Vue.js wird JSON.Parse () für Standard -JSON -Zeichenfolgen bevorzugt. Bei nicht standardmäßigen JSON-Zeichenfolgen kann die Zeichenfolge durch Verwendung regelmäßiger Ausdrücke verarbeitet und Methoden gemäß dem Format oder dekodierten URL-kodiert reduziert werden. Wählen Sie die entsprechende Methode gemäß dem String -Format aus und achten Sie auf Sicherheits- und Codierungsprobleme, um Fehler zu vermeiden.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

VUE.JS Wie kann man ein Array von String -Typ in ein Array von Objekten umwandeln?

Apr 07, 2025 pm 09:36 PM

Zusammenfassung: Es gibt die folgenden Methoden zum Umwandeln von VUE.JS -String -Arrays in Objektarrays: Grundlegende Methode: Verwenden Sie die Kartenfunktion, um regelmäßige formatierte Daten zu entsprechen. Erweitertes Gameplay: Die Verwendung regulärer Ausdrücke kann komplexe Formate ausführen, müssen jedoch sorgfältig geschrieben und berücksichtigt werden. Leistungsoptimierung: In Betracht ziehen die große Datenmenge, asynchrone Operationen oder effiziente Datenverarbeitungsbibliotheken können verwendet werden. Best Practice: Clear Code -Stil, verwenden Sie sinnvolle variable Namen und Kommentare, um den Code präzise zu halten.

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen