Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wie kann man Reinforcement Learning nutzen, um die Benutzerbindung von Kuaishou zu verbessern?

Wie kann man Reinforcement Learning nutzen, um die Benutzerbindung von Kuaishou zu verbessern?

Wie kann man Reinforcement Learning nutzen, um die Benutzerbindung von Kuaishou zu verbessern?

Das Hauptziel des Kurzvideo-Empfehlungssystems besteht darin, das DAU-Wachstum durch eine verbesserte Benutzerbindung voranzutreiben. Daher ist die Kundenbindung einer der wichtigsten Indikatoren für die Geschäftsoptimierung jeder APP. Bei der Aufbewahrung handelt es sich jedoch um ein langfristiges Feedback nach mehreren Interaktionen zwischen Benutzern und dem System, und es ist schwierig, es in ein einzelnes Element oder eine einzelne Liste zu zerlegen. Daher ist es für herkömmliche punktweise und listenweise Modelle schwierig, es direkt zu erfassen Optimieren Sie die Bindung.

Die Methode des Reinforcement Learning (RL) optimiert langfristige Belohnungen durch Interaktion mit der Umgebung und eignet sich zur direkten Optimierung der Nutzerbindung. Diese Arbeit modelliert das Aufbewahrungsoptimierungsproblem als Markov-Entscheidungsprozess (MDP) mit unendlicher Horizontanforderungsgranularität. Jedes Mal, wenn der Benutzer das Empfehlungssystem auffordert, über eine Aktion zu entscheiden, wird es verwendet, um mehrere verschiedene kurzfristige Feedbackschätzungen zu aggregieren (Beobachtungsdauer, Likes, Follows, Kommentare, Retweets usw.) Ranking-Modellbewertung. Das Ziel dieser Arbeit besteht darin, die Richtlinie zu erlernen, das kumulative Zeitintervall zwischen mehreren Benutzersitzungen zu minimieren, die Häufigkeit von App-Öffnungen zu erhöhen und dadurch die Benutzerbindung zu erhöhen.

Aufgrund der Eigenschaften des zurückgehaltenen Signals bringt die direkte Anwendung des vorhandenen RL-Algorithmus jedoch die folgenden Herausforderungen mit sich: 1) Unsicherheit: Das zurückgehaltene Signal ist nicht nur wird durch den Empfehlungsalgorithmus bestimmt, wird aber auch von vielen Faktoren beeinflusst. 2) Verzerrung: Bei unterschiedlichen Zeiträumen und Benutzergruppen gibt es Abweichungen. 3) Instabilität: Im Gegensatz zu Spielumgebungen, die sofort Belohnungen zurückgeben Retentionssignale kehren normalerweise innerhalb von Stunden bis Tagen zurück, was zu Instabilitätsproblemen beim Online-Training von RL-Algorithmen führt.

Diese Arbeit schlägt den Reinforcement Learning for User Retention-Algorithmus (RLUR) vor, um die oben genannten Herausforderungen zu lösen und die Bindung direkt zu optimieren. Durch Offline- und Online-Verifizierung kann der RLUR-Algorithmus den sekundären Aufbewahrungsindex im Vergleich zum State-of-Art-Basiswert deutlich verbessern. Der RLUR-Algorithmus wurde vollständig in der Kuaishou-App implementiert und kann kontinuierlich erhebliche Sekundärbindungs- und DAU-Umsätze erzielen. Es ist das erste Mal in der Branche, dass die RL-Technologie zur Verbesserung der Benutzerbindung in einer realen Produktionsumgebung eingesetzt wird. Diese Arbeit wurde in den WWW 2023 Industry Track aufgenommen.

Autor: Cai Qingqian, Liu Shuchang, Wang Xueliang, Zuo Tianyou, Xie Wentao, Yang Bin, Zheng Dong, Jiang Peng

Papieradresse: https://arxiv.org/pdf/2302.01724.pdf#🎜🎜 ##🎜 🎜#Problemmodellierung

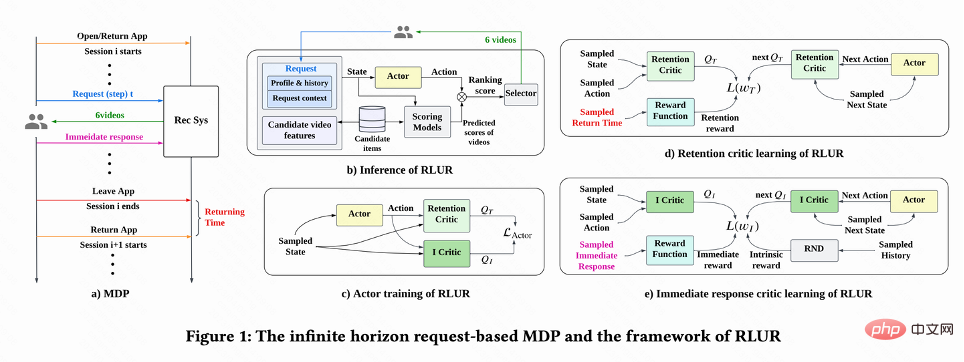

Wie in Abbildung 1(a) dargestellt, modelliert diese Arbeit das Problem der Aufbewahrungsoptimierung als unendlich Horizont Anforderungsgranularität Markov-Entscheidungsprozess (Infinite Horizon Request-based Markov Decision Process), bei dem das Empfehlungssystem der Agent und der Benutzer die Umgebung ist. Jedes Mal, wenn der Benutzer die App öffnet, wird eine neue Sitzung geöffnet. Wie in Abbildung 1(b) dargestellt, entscheidet das Empfehlungssystem jedes Mal, wenn der Benutzer

anfordert, über einen Parametervektor  #🎜 basierend auf dem Benutzerstatus #🎜 🎜# 🎜#

#🎜 basierend auf dem Benutzerstatus #🎜 🎜# 🎜# , während n Ranking-Modelle, die verschiedene kurzfristige Indikatoren (Sehzeit, Likes, Aufmerksamkeit usw.) schätzen, jedes Kandidatenvideo j#🎜🎜 bewerten #. Dann gibt die Sortierfunktion die Aktion und den Bewertungsvektor jedes Videos ein, um die Endbewertung jedes Videos zu erhalten, und wählt die 6 Videos mit der höchsten Bewertung aus, die dem Benutzer angezeigt werden sollen. Der Benutzer gibt sofortiges Feedback zurück

, während n Ranking-Modelle, die verschiedene kurzfristige Indikatoren (Sehzeit, Likes, Aufmerksamkeit usw.) schätzen, jedes Kandidatenvideo j#🎜🎜 bewerten #. Dann gibt die Sortierfunktion die Aktion und den Bewertungsvektor jedes Videos ein, um die Endbewertung jedes Videos zu erhalten, und wählt die 6 Videos mit der höchsten Bewertung aus, die dem Benutzer angezeigt werden sollen. Der Benutzer gibt sofortiges Feedback zurück . Wenn der Benutzer die App verlässt, endet die Sitzung. Wenn der Benutzer die App das nächste Mal öffnet, wird die Sitzung i+1 geöffnet. Das Zeitintervall zwischen dem Ende der vorherigen Sitzung und dem Beginn der nächsten Sitzung wird als Rückkehrzeit bezeichnet Zeit),

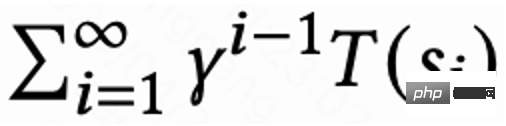

. Wenn der Benutzer die App verlässt, endet die Sitzung. Wenn der Benutzer die App das nächste Mal öffnet, wird die Sitzung i+1 geöffnet. Das Zeitintervall zwischen dem Ende der vorherigen Sitzung und dem Beginn der nächsten Sitzung wird als Rückkehrzeit bezeichnet Zeit),  . Das Ziel dieser Forschung besteht darin, eine Strategie zu trainieren, die die Summe der Rückrufzeiten für mehrere Sitzungen minimiert.

. Das Ziel dieser Forschung besteht darin, eine Strategie zu trainieren, die die Summe der Rückrufzeiten für mehrere Sitzungen minimiert.

RLUR-Algorithmus

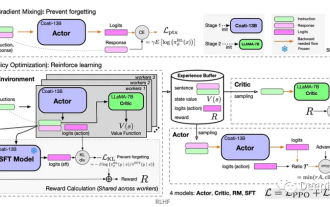

In dieser Arbeit wird zunächst erörtert, wie die kumulative Wiederbesuchszeit geschätzt werden kann, und dann werden Methoden zur Lösung mehrerer Probleme vorgeschlagen Probleme der zurückgehaltenen Signale. Schlüsselherausforderungen. Diese Methoden werden im Reinforcement Learning for User Retention-Algorithmus zusammengefasst, abgekürzt als RLUR. Wie in Abbildung 1 gezeigt( d) Wie in der Abbildung gezeigt, verwendet diese Arbeit die Zeitdifferenz-Lernmethode (TD) des DDPG-Algorithmus, um die Zeit des erneuten Besuchs abzuschätzen, da die Aktionen kontinuierlich sind.

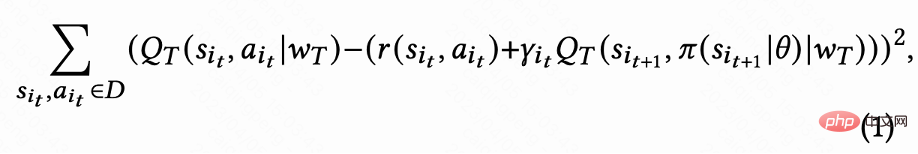

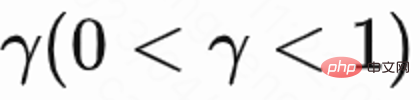

Da jede Sitzung nur eine Rückbesuchszeitbelohnung für die letzte Anfrage hat, ist die Zwischenbelohnung ist 0. Der Autor legt den Rabattfaktor

für die letzte Anfrage in jeder Sitzung auf

fest, und für andere Anfragen ist er 1 . Mit dieser Einstellung kann der exponentielle Abfall der Wiederbesuchszeit vermieden werden. Und es kann theoretisch bewiesen werden, dass Q tatsächlich die kumulative Wiederbesuchszeit mehrerer Sitzungen schätzt, wenn Verlust (1) 0 ist,

fest, und für andere Anfragen ist er 1 . Mit dieser Einstellung kann der exponentielle Abfall der Wiederbesuchszeit vermieden werden. Und es kann theoretisch bewiesen werden, dass Q tatsächlich die kumulative Wiederbesuchszeit mehrerer Sitzungen schätzt, wenn Verlust (1) 0 ist,

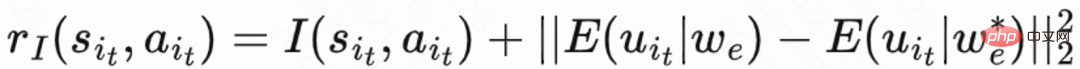

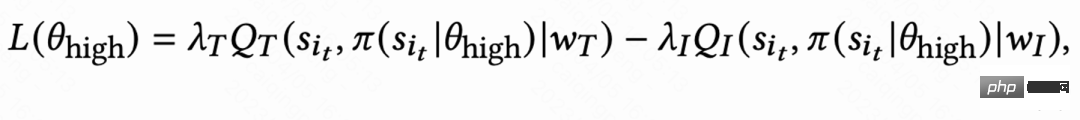

. #? 🎜#Da der Rückbesuch erst am Ende jeder Sitzung stattfindet, führt dies zu dem Problem einer geringen Lerneffizienz. Die Autoren verwenden daher heuristische Belohnungen, um das politische Lernen zu verbessern. Da kurzfristiges Feedback positiv mit der Bindung zusammenhängt, verwendet der Autor kurzfristiges Feedback als erste heuristische Belohnung. Und der Autor verwendet das Random Network Distillation (RND)-Netzwerk, um die intrinsische Belohnung jeder Probe als zweite heuristische Belohnung zu berechnen. Insbesondere verwendet das RND-Netzwerk zwei identische Netzwerkstrukturen. Ein Netzwerk wird zufällig auf Festnetz initialisiert, und das andere Netzwerk passt sich dem Festnetz an, und der Anpassungsverlust wird als intrinsische Belohnung verwendet. Wie in Abbildung 1 (e) gezeigt, lernt diese Arbeit ein separates Kritikernetzwerk, um die Summe aus kurzfristigem Feedback und intrinsischer Belohnung zu schätzen, um die Beeinträchtigung heuristischer Belohnungen auf Bindungsbelohnungen zu verringern. Das ist  .

.

Das Problem der Unsicherheit lösen

Das Problem der Unsicherheit lösen

# 🎜🎜#Da die Zeit des Rückbesuchs von vielen anderen Faktoren als den Empfehlungen beeinflusst wird, ist die Unsicherheit hoch, was sich auf den Lerneffekt auswirkt. Diese Arbeit schlägt eine Regularisierungsmethode vor, um die Varianz zu reduzieren: Schätzen Sie zunächst ein Klassifizierungsmodell , um die Wahrscheinlichkeit der Wiederbesuchszeit abzuschätzen, dh ob die geschätzte Wiederbesuchszeit kürzer als #🎜 ist 🎜##🎜 🎜# Verwenden Sie dann die Markov-Ungleichung, um die Untergrenze der Rückbesuchszeit zu ermitteln,

; Verwenden Sie schließlich die tatsächliche Rückbesuchszeit/geschätzte Rückkehr Untergrenze der Besuchszeit als regulierte Gegenbesuchsprämie.

aufgrund unterschiedliche Aktivitäten Die Verhaltensgewohnheiten hochaktiver Benutzer sind sehr unterschiedlich und die Anzahl der Trainingsproben ist deutlich höher als die von niedrig aktiven Benutzern hochaktive Benutzer. Um dieses Problem zu lösen, erlernt diese Arbeit zwei unabhängige Strategien für verschiedene Gruppen mit hoher und niedriger Aktivität und verwendet unterschiedliche Datenströme für das Training. Der Schauspieler minimiert die Rückbesuchszeit und maximiert gleichzeitig die Zusatzbelohnung. Wie in Abbildung 1(c) dargestellt, beträgt der Akteurverlust am Beispiel der Gruppe mit hoher Aktivität:

Lösen Sie das Instabilitätsproblem

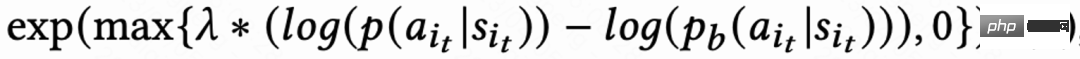

Aufgrund der Signalverzögerung der Rückbesuchszeit kehrt sie normalerweise innerhalb weniger Stunden bis zu mehreren Tagen zurück, was dazu führt, dass das RL-Online-Training instabil wird. Die direkte Verwendung vorhandener Methoden zum Klonen von Verhalten schränkt entweder die Lerngeschwindigkeit erheblich ein oder kann kein stabiles Lernen garantieren. Daher schlägt diese Arbeit eine neue sanfte Regularisierungsmethode vor, die darin besteht, den Akteurverlust mit einem weichen Regularisierungskoeffizienten zu multiplizieren: Wenn die Strategie und die Beispielstrategie groß sind, wird der Verlust kleiner und das Lernen stabiler. Wenn die Lerngeschwindigkeit stabil wird, wird der Verlust wieder größer und die Lerngeschwindigkeit beschleunigt sich. Wenn

, bedeutet dies, dass es keine Einschränkungen für den Lernprozess gibt.

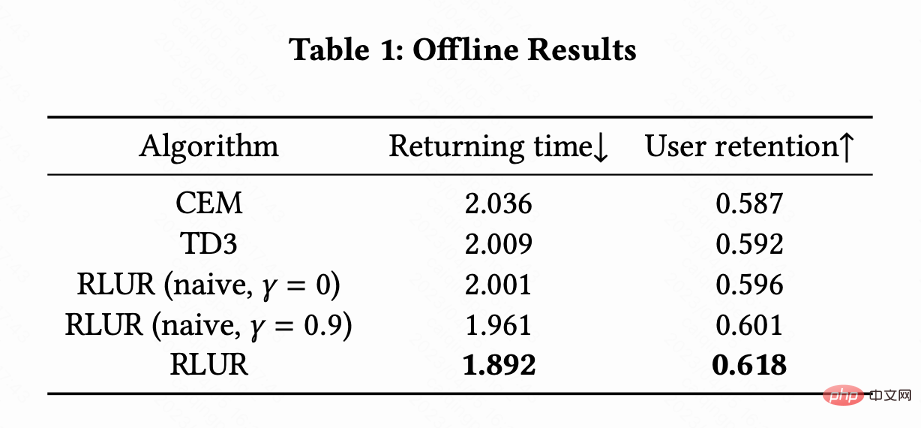

Diese Arbeit vergleicht RLUR mit dem Reinforcement-Learning-Algorithmus TD3 von State of the Art und der Black-Box-Optimierungsmethode Cross Entropy Method (CEM) am öffentlichen Datensatz KuaiRand. In dieser Arbeit wird zunächst ein Aufbewahrungssimulator erstellt, der auf dem KuaiRand-Datensatz basiert und drei Module umfasst: unmittelbares Feedback des Benutzers, Verlassen der Sitzung durch Benutzer und erneuter Besuch der App durch den Benutzer. Anschließend wird diese Bewertungsmethode des Aufbewahrungssimulators verwendet.

und

wird gezeigt, dass der Algorithmus zur Minimierung der Rückbesuchszeit mehrerer Sitzungen besser ist als die Minimierung der Rückbesuchszeit einer einzelnen Sitzung.

wird gezeigt, dass der Algorithmus zur Minimierung der Rückbesuchszeit mehrerer Sitzungen besser ist als die Minimierung der Rückbesuchszeit einer einzelnen Sitzung.

Online-Experiment

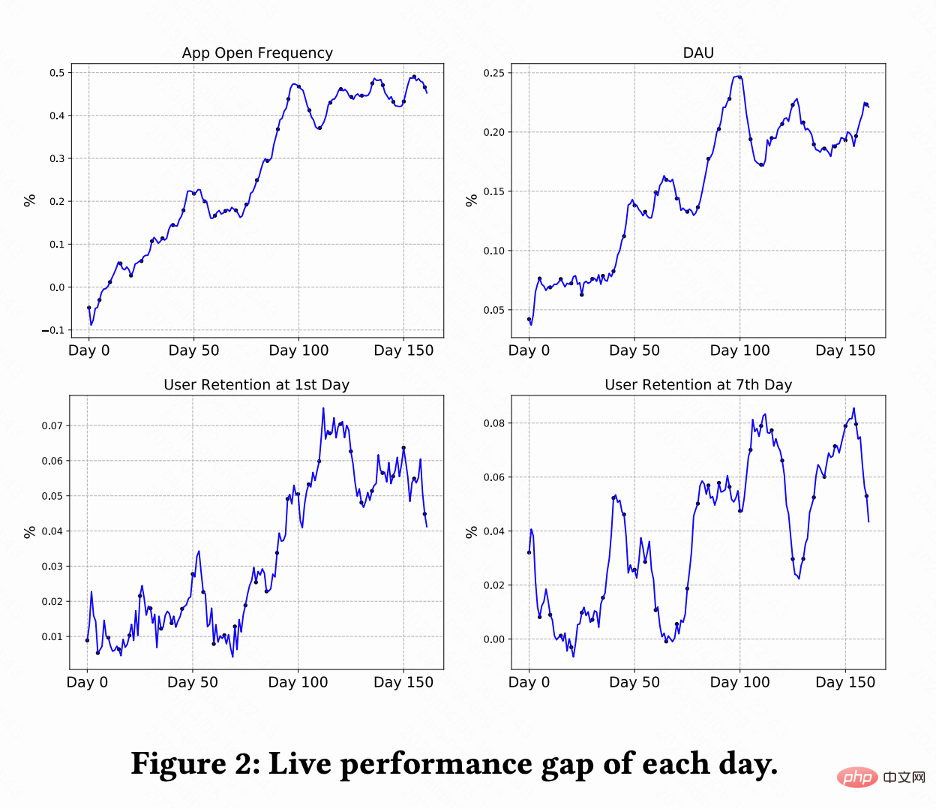

Diese Arbeit führt A/B-Tests auf dem Kuaishou-Kurzvideoempfehlungssystem durch, um RLUR- und CEM-Methoden zu vergleichen. Abbildung 2 zeigt die Verbesserungsprozentsätze der App-Öffnungshäufigkeit, DAU, Erstbindung und Siebtbindung im Vergleich zu RLUR bzw. CEM. Es lässt sich feststellen, dass die Häufigkeit der App-Öffnungen allmählich zunimmt und sich sogar von 0 auf 100 Tage annähert. Es führt auch zu Verbesserungen bei den Zweitbindungs-, Siebtenbindungs- und DAU-Indikatoren (0,1 % DAU und 0,01 % Zweitbindungsverbesserung gelten als statistisch signifikant).

Diese Arbeit führt A/B-Tests auf dem Kuaishou-Kurzvideoempfehlungssystem durch, um RLUR- und CEM-Methoden zu vergleichen. Abbildung 2 zeigt die Verbesserungsprozentsätze der App-Öffnungshäufigkeit, DAU, Erstbindung und Siebtbindung im Vergleich zu RLUR bzw. CEM. Es lässt sich feststellen, dass die Häufigkeit der App-Öffnungen allmählich zunimmt und sich sogar von 0 auf 100 Tage annähert. Es führt auch zu Verbesserungen bei den Zweitbindungs-, Siebtenbindungs- und DAU-Indikatoren (0,1 % DAU und 0,01 % Zweitbindungsverbesserung gelten als statistisch signifikant).

Diese Arbeit untersucht, wie die Benutzerbindung von Empfehlungssystemen durch RL-Technologie verbessert werden kann. Diese Arbeit modelliert die Aufbewahrungsoptimierung als Markov-Entscheidungsprozess mit unendlicher Horizont-Anforderungsgranularität Optimieren Sie die Signalspeicherung direkt und bewältigen Sie effektiv mehrere wichtige Herausforderungen der Signalspeicherung. Der RLUR-Algorithmus wurde vollständig in der Kuaishou-App implementiert und kann erhebliche sekundäre Bindungs- und DAU-Umsätze erzielen. Im Hinblick auf zukünftige Arbeiten ist die Frage, wie man Offline-Reinforcement Learning, Decision Transformer und andere Methoden nutzen kann, um die Benutzerbindung effektiver zu verbessern, eine vielversprechende Richtung.

Das obige ist der detaillierte Inhalt vonWie kann man Reinforcement Learning nutzen, um die Benutzerbindung von Kuaishou zu verbessern?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

CLIP-BEVFormer: Überwacht explizit die BEVFormer-Struktur, um die Leistung der Long-Tail-Erkennung zu verbessern

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: Überwacht explizit die BEVFormer-Struktur, um die Leistung der Long-Tail-Erkennung zu verbessern

Mar 26, 2024 pm 12:41 PM

Oben geschrieben und das persönliche Verständnis des Autors: Derzeit spielt das Wahrnehmungsmodul im gesamten autonomen Fahrsystem eine entscheidende Rolle Das Steuermodul im autonomen Fahrsystem trifft zeitnahe und korrekte Urteile und Verhaltensentscheidungen. Derzeit sind Autos mit autonomen Fahrfunktionen in der Regel mit einer Vielzahl von Dateninformationssensoren ausgestattet, darunter Rundumsichtkamerasensoren, Lidar-Sensoren und Millimeterwellenradarsensoren, um Informationen in verschiedenen Modalitäten zu sammeln und so genaue Wahrnehmungsaufgaben zu erfüllen. Der auf reinem Sehen basierende BEV-Wahrnehmungsalgorithmus wird von der Industrie aufgrund seiner geringen Hardwarekosten und einfachen Bereitstellung bevorzugt, und seine Ausgabeergebnisse können problemlos auf verschiedene nachgelagerte Aufgaben angewendet werden.

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Zu den häufigsten Herausforderungen, mit denen Algorithmen für maschinelles Lernen in C++ konfrontiert sind, gehören Speicherverwaltung, Multithreading, Leistungsoptimierung und Wartbarkeit. Zu den Lösungen gehören die Verwendung intelligenter Zeiger, moderner Threading-Bibliotheken, SIMD-Anweisungen und Bibliotheken von Drittanbietern sowie die Einhaltung von Codierungsstilrichtlinien und die Verwendung von Automatisierungstools. Praktische Fälle zeigen, wie man die Eigen-Bibliothek nutzt, um lineare Regressionsalgorithmen zu implementieren, den Speicher effektiv zu verwalten und leistungsstarke Matrixoperationen zu nutzen.

Tiefgreifendes Q-Learning-Verstärkungslernen mit der Roboterarmsimulation von Panda-Gym

Oct 31, 2023 pm 05:57 PM

Tiefgreifendes Q-Learning-Verstärkungslernen mit der Roboterarmsimulation von Panda-Gym

Oct 31, 2023 pm 05:57 PM

Reinforcement Learning (RL) ist eine Methode des maschinellen Lernens, die es einem Agenten ermöglicht, durch Versuch und Irrtum zu lernen, wie er sich in seiner Umgebung verhält. Agenten werden dafür belohnt oder bestraft, dass sie Maßnahmen ergreifen, die zu den gewünschten Ergebnissen führen. Im Laufe der Zeit lernt der Agent, Maßnahmen zu ergreifen, die seine erwartete Belohnung maximieren. RL-Agenten werden normalerweise mithilfe eines Markov-Entscheidungsprozesses (MDP) trainiert, einem mathematischen Rahmen zur Modellierung sequentieller Entscheidungsprobleme. MDP besteht aus vier Teilen: Zustand: eine Reihe möglicher Zustände der Umgebung. Aktion: Eine Reihe von Aktionen, die ein Agent ausführen kann. Übergangsfunktion: Eine Funktion, die die Wahrscheinlichkeit des Übergangs in einen neuen Zustand anhand des aktuellen Zustands und der aktuellen Aktion vorhersagt. Belohnungsfunktion: Eine Funktion, die dem Agenten für jede Conversion eine Belohnung zuweist. Das Ziel des Agenten besteht darin, eine Richtlinienfunktion zu erlernen.

Entdecken Sie die zugrunde liegenden Prinzipien und die Algorithmusauswahl der C++-Sortierfunktion

Apr 02, 2024 pm 05:36 PM

Entdecken Sie die zugrunde liegenden Prinzipien und die Algorithmusauswahl der C++-Sortierfunktion

Apr 02, 2024 pm 05:36 PM

Die unterste Ebene der C++-Sortierfunktion verwendet die Zusammenführungssortierung, ihre Komplexität beträgt O(nlogn) und bietet verschiedene Auswahlmöglichkeiten für Sortieralgorithmen, einschließlich schneller Sortierung, Heap-Sortierung und stabiler Sortierung.

Kann künstliche Intelligenz Kriminalität vorhersagen? Entdecken Sie die Möglichkeiten von CrimeGPT

Mar 22, 2024 pm 10:10 PM

Kann künstliche Intelligenz Kriminalität vorhersagen? Entdecken Sie die Möglichkeiten von CrimeGPT

Mar 22, 2024 pm 10:10 PM

Die Konvergenz von künstlicher Intelligenz (KI) und Strafverfolgung eröffnet neue Möglichkeiten zur Kriminalprävention und -aufdeckung. Die Vorhersagefähigkeiten künstlicher Intelligenz werden häufig in Systemen wie CrimeGPT (Crime Prediction Technology) genutzt, um kriminelle Aktivitäten vorherzusagen. Dieser Artikel untersucht das Potenzial künstlicher Intelligenz bei der Kriminalitätsvorhersage, ihre aktuellen Anwendungen, die Herausforderungen, denen sie gegenübersteht, und die möglichen ethischen Auswirkungen der Technologie. Künstliche Intelligenz und Kriminalitätsvorhersage: Die Grundlagen CrimeGPT verwendet Algorithmen des maschinellen Lernens, um große Datensätze zu analysieren und Muster zu identifizieren, die vorhersagen können, wo und wann Straftaten wahrscheinlich passieren. Zu diesen Datensätzen gehören historische Kriminalstatistiken, demografische Informationen, Wirtschaftsindikatoren, Wettermuster und mehr. Durch die Identifizierung von Trends, die menschliche Analysten möglicherweise übersehen, kann künstliche Intelligenz Strafverfolgungsbehörden stärken

Verbesserter Erkennungsalgorithmus: zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern

Jun 06, 2024 pm 12:33 PM

Verbesserter Erkennungsalgorithmus: zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern

Jun 06, 2024 pm 12:33 PM

01Ausblicksübersicht Derzeit ist es schwierig, ein angemessenes Gleichgewicht zwischen Detektionseffizienz und Detektionsergebnissen zu erreichen. Wir haben einen verbesserten YOLOv5-Algorithmus zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern entwickelt, der mehrschichtige Merkmalspyramiden, Multierkennungskopfstrategien und hybride Aufmerksamkeitsmodule verwendet, um die Wirkung des Zielerkennungsnetzwerks in optischen Fernerkundungsbildern zu verbessern. Laut SIMD-Datensatz ist der mAP des neuen Algorithmus 2,2 % besser als YOLOv5 und 8,48 % besser als YOLOX, wodurch ein besseres Gleichgewicht zwischen Erkennungsergebnissen und Geschwindigkeit erreicht wird. 02 Hintergrund und Motivation Mit der rasanten Entwicklung der Fernerkundungstechnologie wurden hochauflösende optische Fernerkundungsbilder verwendet, um viele Objekte auf der Erdoberfläche zu beschreiben, darunter Flugzeuge, Autos, Gebäude usw. Objekterkennung bei der Interpretation von Fernerkundungsbildern

Anwendung von Algorithmen beim Aufbau einer 58-Porträt-Plattform

May 09, 2024 am 09:01 AM

Anwendung von Algorithmen beim Aufbau einer 58-Porträt-Plattform

May 09, 2024 am 09:01 AM

1. Hintergrund des Baus der 58-Portrait-Plattform Zunächst möchte ich Ihnen den Hintergrund des Baus der 58-Portrait-Plattform mitteilen. 1. Das traditionelle Denken der traditionellen Profiling-Plattform reicht nicht mehr aus. Der Aufbau einer Benutzer-Profiling-Plattform basiert auf Data-Warehouse-Modellierungsfunktionen, um Daten aus mehreren Geschäftsbereichen zu integrieren, um genaue Benutzerporträts zu erstellen Und schließlich muss es über Datenplattformfunktionen verfügen, um Benutzerprofildaten effizient zu speichern, abzufragen und zu teilen sowie Profildienste bereitzustellen. Der Hauptunterschied zwischen einer selbst erstellten Business-Profiling-Plattform und einer Middle-Office-Profiling-Plattform besteht darin, dass die selbst erstellte Profiling-Plattform einen einzelnen Geschäftsbereich bedient und bei Bedarf angepasst werden kann. Die Mid-Office-Plattform bedient mehrere Geschäftsbereiche und ist komplex Modellierung und bietet allgemeinere Funktionen. 2.58 Benutzerporträts vom Hintergrund der Porträtkonstruktion im Mittelbahnsteig 58

Fügen Sie SOTA in Echtzeit hinzu und explodieren Sie! FastOcc: Schnellere Inferenz und ein einsatzfreundlicher Occ-Algorithmus sind da!

Mar 14, 2024 pm 11:50 PM

Fügen Sie SOTA in Echtzeit hinzu und explodieren Sie! FastOcc: Schnellere Inferenz und ein einsatzfreundlicher Occ-Algorithmus sind da!

Mar 14, 2024 pm 11:50 PM

Oben geschrieben & Das persönliche Verständnis des Autors ist, dass im autonomen Fahrsystem die Wahrnehmungsaufgabe eine entscheidende Komponente des gesamten autonomen Fahrsystems ist. Das Hauptziel der Wahrnehmungsaufgabe besteht darin, autonome Fahrzeuge in die Lage zu versetzen, Umgebungselemente wie auf der Straße fahrende Fahrzeuge, Fußgänger am Straßenrand, während der Fahrt angetroffene Hindernisse, Verkehrszeichen auf der Straße usw. zu verstehen und wahrzunehmen und so flussabwärts zu helfen Module Treffen Sie richtige und vernünftige Entscheidungen und Handlungen. Ein Fahrzeug mit autonomen Fahrfähigkeiten ist in der Regel mit verschiedenen Arten von Informationserfassungssensoren ausgestattet, wie z. B. Rundumsichtkamerasensoren, Lidar-Sensoren, Millimeterwellenradarsensoren usw., um sicherzustellen, dass das autonome Fahrzeug die Umgebung genau wahrnehmen und verstehen kann Elemente, die es autonomen Fahrzeugen ermöglichen, beim autonomen Fahren die richtigen Entscheidungen zu treffen. Kopf