Wie verwende ich CountVectorizer in Pythons sklearn?

Einführung

Offizielle Dokumentation von CountVectorizer.

Vektorisieren Sie eine Dokumentensammlung in eine Zählmatrix.

Wenn Sie kein A-priori-Wörterbuch bereitstellen und keinen Analysator zur Merkmalsauswahl verwenden, entspricht die Anzahl der Merkmale dem durch die Analyse der Daten ermittelten Wortschatz.

Datenvorverarbeitung

Zwei Methoden: 1. Sie können es ohne Wortsegmentierung direkt in das Modell einfügen. 2. Sie können den chinesischen Text zuerst segmentieren.

Der durch die beiden Methoden erzeugte Wortschatz wird sehr unterschiedlich sein. Spezifische Demonstrationen werden später gegeben.

import jieba

import re

from sklearn.feature_extraction.text import CountVectorizer

#原始数据

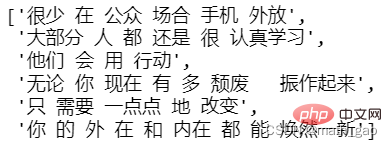

text = ['很少在公众场合手机外放',

'大部分人都还是很认真去学习的',

'他们会用行动来',

'无论你现在有多颓废,振作起来',

'只需要一点点地改变',

'你的外在和内在都能焕然一新']

#提取中文

text = [' '.join(re.findall('[\u4e00-\u9fa5]+',tt,re.S)) for tt in text]

#分词

text = [' '.join(jieba.lcut(tt)) for tt in text]

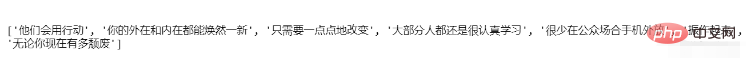

text

Erstellen Sie das Modell

Trainieren Sie das Modell

#构建模型 vectorizer = CountVectorizer() #训练模型 X = vectorizer.fit_transform(text)

Alle Vokabeln: model.get_feature_names()

#所有文档汇集后生成的词汇 feature_names = vectorizer.get_feature_names() print(feature_names)

Vokabeln, die ohne Wortsegmentierung generiert wurden

Vokabeln, die nach der Wortsegmentierung generiert wurden

Zählmatrix :

Das obige ist der detaillierte Inhalt vonWie verwende ich CountVectorizer in Pythons sklearn?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1369

1369

52

52

Was ist die Funktion der C -Sprachsumme?

Apr 03, 2025 pm 02:21 PM

Was ist die Funktion der C -Sprachsumme?

Apr 03, 2025 pm 02:21 PM

Es gibt keine integrierte Summenfunktion in der C-Sprache, daher muss sie selbst geschrieben werden. Die Summe kann erreicht werden, indem das Array durchquert und Elemente akkumulieren: Schleifenversion: Die Summe wird für die Schleifen- und Arraylänge berechnet. Zeigerversion: Verwenden Sie Zeiger, um auf Array-Elemente zu verweisen, und eine effiziente Summierung wird durch Selbststillstandszeiger erzielt. Dynamisch Array -Array -Version zuweisen: Zuordnen Sie Arrays dynamisch und verwalten Sie selbst den Speicher selbst, um sicherzustellen, dass der zugewiesene Speicher befreit wird, um Speicherlecks zu verhindern.

Ist DifferiDItistinginginging verwandt?

Apr 03, 2025 pm 10:30 PM

Ist DifferiDItistinginginging verwandt?

Apr 03, 2025 pm 10:30 PM

Obwohl eindeutig und unterschiedlich mit der Unterscheidung zusammenhängen, werden sie unterschiedlich verwendet: Unterschieds (Adjektiv) beschreibt die Einzigartigkeit der Dinge selbst und wird verwendet, um Unterschiede zwischen den Dingen zu betonen; Das Unterscheidungsverhalten oder die Fähigkeit des Unterschieds ist eindeutig (Verb) und wird verwendet, um den Diskriminierungsprozess zu beschreiben. In der Programmierung wird häufig unterschiedlich, um die Einzigartigkeit von Elementen in einer Sammlung darzustellen, wie z. B. Deduplizierungsoperationen; Unterscheidet spiegelt sich in der Gestaltung von Algorithmen oder Funktionen wider, wie z. B. die Unterscheidung von ungeraden und sogar Zahlen. Bei der Optimierung sollte der eindeutige Betrieb den entsprechenden Algorithmus und die Datenstruktur auswählen, während der unterschiedliche Betrieb die Unterscheidung zwischen logischer Effizienz optimieren und auf das Schreiben klarer und lesbarer Code achten sollte.

Wer bekommt mehr Python oder JavaScript bezahlt?

Apr 04, 2025 am 12:09 AM

Wer bekommt mehr Python oder JavaScript bezahlt?

Apr 04, 2025 am 12:09 AM

Es gibt kein absolutes Gehalt für Python- und JavaScript -Entwickler, je nach Fähigkeiten und Branchenbedürfnissen. 1. Python kann mehr in Datenwissenschaft und maschinellem Lernen bezahlt werden. 2. JavaScript hat eine große Nachfrage in der Entwicklung von Front-End- und Full-Stack-Entwicklung, und sein Gehalt ist auch beträchtlich. 3. Einflussfaktoren umfassen Erfahrung, geografische Standort, Unternehmensgröße und spezifische Fähigkeiten.

Wie versteht man! X in c?

Apr 03, 2025 pm 02:33 PM

Wie versteht man! X in c?

Apr 03, 2025 pm 02:33 PM

! X Understanding! X ist ein logischer Nicht-Operator in der C-Sprache. Es booleschen den Wert von x, dh wahre Änderungen zu falschen, falschen Änderungen an True. Aber seien Sie sich bewusst, dass Wahrheit und Falschheit in C eher durch numerische Werte als durch Boolesche Typen dargestellt werden, ungleich Null wird als wahr angesehen und nur 0 wird als falsch angesehen. Daher handelt es sich um negative Zahlen wie positive Zahlen und gilt als wahr.

Was bedeutet Summe in der C -Sprache?

Apr 03, 2025 pm 02:36 PM

Was bedeutet Summe in der C -Sprache?

Apr 03, 2025 pm 02:36 PM

Es gibt keine integrierte Summenfunktion in C für die Summe, kann jedoch implementiert werden durch: Verwenden einer Schleife, um Elemente nacheinander zu akkumulieren; Verwenden eines Zeigers, um auf die Elemente nacheinander zuzugreifen und zu akkumulieren; Betrachten Sie für große Datenvolumina parallele Berechnungen.

Bedarf die Produktion von H5 -Seiten eine kontinuierliche Wartung?

Apr 05, 2025 pm 11:27 PM

Bedarf die Produktion von H5 -Seiten eine kontinuierliche Wartung?

Apr 05, 2025 pm 11:27 PM

Die H5 -Seite muss aufgrund von Faktoren wie Code -Schwachstellen, Browserkompatibilität, Leistungsoptimierung, Sicherheitsaktualisierungen und Verbesserungen der Benutzererfahrung kontinuierlich aufrechterhalten werden. Zu den effektiven Wartungsmethoden gehören das Erstellen eines vollständigen Testsystems, die Verwendung von Versionstools für Versionskontrolle, die regelmäßige Überwachung der Seitenleistung, das Sammeln von Benutzern und die Formulierung von Wartungsplänen.

Wie erhalten Sie Echtzeit-Anwendungs- und Zuschauerdaten auf der Arbeit von 58.com?

Apr 05, 2025 am 08:06 AM

Wie erhalten Sie Echtzeit-Anwendungs- und Zuschauerdaten auf der Arbeit von 58.com?

Apr 05, 2025 am 08:06 AM

Wie erhalte ich dynamische Daten von 58.com Arbeitsseite beim Kriechen? Wenn Sie eine Arbeitsseite von 58.com mit Crawler -Tools kriechen, können Sie auf diese begegnen ...

Kopieren Sie den Liebescode und fügen Sie den Liebescode kostenlos kopieren und einfügen

Apr 04, 2025 am 06:48 AM

Kopieren Sie den Liebescode und fügen Sie den Liebescode kostenlos kopieren und einfügen

Apr 04, 2025 am 06:48 AM

Das Kopieren und Einfügen des Codes ist nicht unmöglich, sollte aber mit Vorsicht behandelt werden. Abhängigkeiten wie Umgebung, Bibliotheken, Versionen usw. im Code stimmen möglicherweise nicht mit dem aktuellen Projekt überein, was zu Fehlern oder unvorhersehbaren Ergebnissen führt. Stellen Sie sicher, dass der Kontext konsistent ist, einschließlich Dateipfade, abhängiger Bibliotheken und Python -Versionen. Wenn Sie den Code für eine bestimmte Bibliothek kopieren und einfügen, müssen Sie möglicherweise die Bibliothek und ihre Abhängigkeiten installieren. Zu den häufigen Fehlern gehören Pfadfehler, Versionskonflikte und inkonsistente Codestile. Die Leistungsoptimierung muss gemäß dem ursprünglichen Zweck und den Einschränkungen des Codes neu gestaltet oder neu gestaltet werden. Es ist entscheidend, den Code zu verstehen und den kopierten kopierten Code zu debuggen und nicht blind zu kopieren und einzufügen.