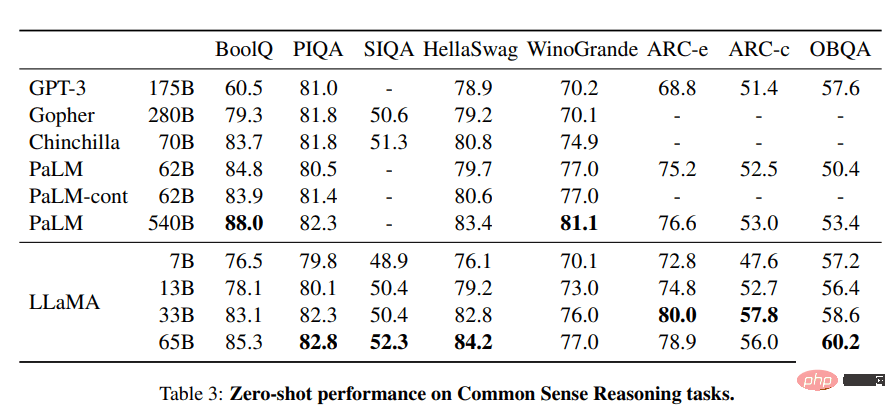

Das LLaMA-Projekt enthält eine Reihe grundlegender Sprachmodelle im Bereich von 7 bis 65 Milliarden. Die Parameter sind nicht gleich. Diese Modelle werden auf Millionen von Token trainiert, und zwar vollständig auf öffentlich verfügbaren Datensätzen. Damit übertraf LLaMA-13B GPT-3 (175B), während LLaMA-65B eine ähnliche Leistung erbrachte wie die besten Modelle wie Chinchilla-70B und PaLM-540B.

Bild von LLaMA: Open and Efficient Foundation Language Models (arxiv.org)“ [https://arxiv.org/abs/2302.13971]# 🎜🎜#

GitHub: facebookresearch/llama [https://github.com/facebookresearch/ llama]

Demo: Baize Lora 7B [https://huggingface.co/spaces/project -baize/Baize-7B]

2.Alpaca

- Alpaka-Ansprüche der Stanford University Es kann mit ChatGPT konkurrieren und jeder kann es für weniger als 600 US-Dollar replizieren. Alpaca 7B ist eine Weiterentwicklung des LLaMA 7B-Modells anhand einer 52K-Anleitung und einer anschließenden Demonstration.

- Trainingsinhalte|Bilder vom Stanford University CRFM

- Ressourcen:

Blog: Stanford University CRFM. [https://crfm.stanford.edu/2023/03/13/alpaca.html]GitHub: tatsu-lab/stanford_alpaca [https://github.com/tatsu-lab/stanford_alpaca ]Demo: Alpaca-LoRA (die offizielle Demo ist verloren gegangen, dies ist eine Wiedergabe des Alpaca-Modells) [https://huggingface.co/spaces/tloen/alpaca-lora]#🎜 🎜##🎜 🎜#

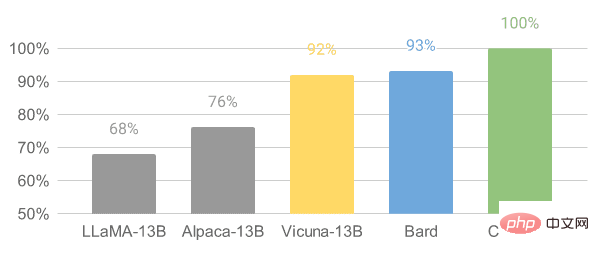

3.Vicuna

Vicuna basiert auf dem LLaMA-Modell auf von Benutzern geteilten Gesprächen ShareGPT Nehmen Sie Feineinstellungen vor. Das Vicuna-13B-Modell hat mehr als 90 % der Qualität von OpenAI ChatGPT und Google Bard erreicht. Außerdem übertraf es die Modelle LLaMA und Stanford Alpaca in 90 % der Fälle. Die Kosten für die Ausbildung eines Vicuna betragen etwa 300 US-Dollar.

Blogbeitrag: „Vicuna : Ein Open-Source-Chatbot, der GPT-4 mit 90 %* ChatGPT-Qualität beeindruckt“ [https://vicuna.lmsys.org/]GitHub:lm-sys/FastChat [https://github .com/lm-sys/FastChat#fine-tuning]

Demo: FastChat (lmsys.org) [https://chat.lmsys.org/]

# 🎜🎜#

4.OpenChatKit

4.OpenChatKit

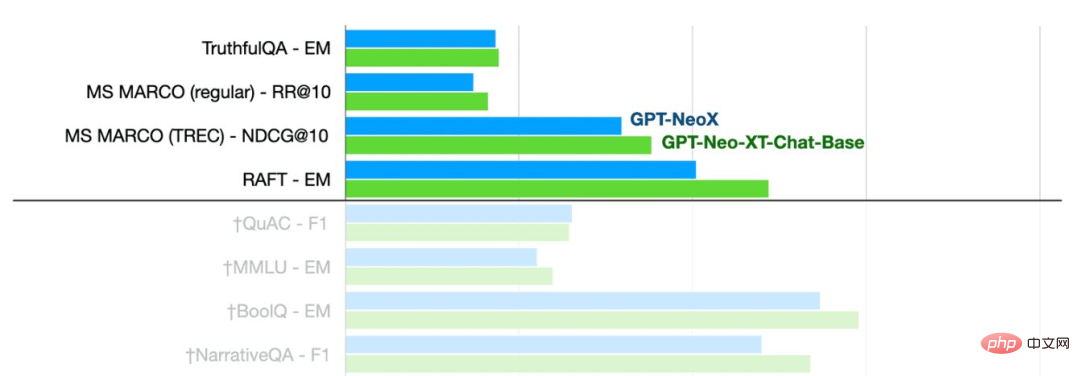

OpenChatKit: Die Open-Source-ChatGPT-Alternative ist ein komplettes Toolkit zum Erstellen von Chatbots. Es bietet große Sprachmodelle zum Trainieren eigener Anweisungsanpassungen der Benutzer, fein abgestimmte Modelle, ein skalierbares Abrufsystem zum Aktualisieren von Bot-Antworten und Anweisungen zum Filtern der Bot-Überprüfung von Fragen.

-

- Bild von TOGETHER

- Wie Sie sehen können, schneidet das GPT-NeoXT-Chat-Base-20B-Modell gut ab Frage und Antwort, Extraktion und Die Leistung bei Klassifizierungsaufgaben ist besser als im Basismodus GPT-NoeX.

Quelle:

Blogbeitrag: „Ankündigung von OpenChatKit“ – TOGETHER [https://www.together.xyz/blog/openchatkit] GitHub: togethercomputer/OpenChatKit [https://github.com/togethercomputer/OpenChatKit]

Demo: OpenChatKit [https://huggingface.co/spaces/togethercomputer/OpenChatKit]#🎜 🎜#

Modellkarte: togethercomputer/GPT-NeoXT-Chat-Base-20B [https://huggingface.co/togethercomputer/GPT-NeoXT-Chat-Base-20B]

# 🎜🎜#

# 🎜🎜#

5.GPT4ALL

GPT4ALL ist ein Community-Projekt und wird auf einem umfangreichen Hilfsinteraktionskorpus trainiert, einschließlich Code, Geschichten, Beschreibungen und Dialogrunden. Das Team stellte den Datensatz, die Modellgewichte, den Datenverwaltungsprozess und den Trainingscode zur Verfügung, um Open Source zu ermöglichen. Darüber hinaus haben sie eine quantisierte 4-Bit-Version des Modells veröffentlicht, die auf einem Laptop ausgeführt werden kann. Sie können sogar einen Python-Client verwenden, um Modellinferenzen auszuführen.

-

- Bilder von GPT4ALL

- Quelle:

- Technischer Bericht: GPT4All [https://s3.amazonaws.com/static.nomic.ai/gpt4all/2023_GPT4All_Technical_Report.pdf]

- GitHub: nomic-ai/gpt4al [https://github.com/nomic-ai /gpt4all]

- Demo: GPT4All (inoffiziell). [https://huggingface.co/spaces/rishiraj/GPT4All]

- Modellkarte: nomic-ai/gpt4all-lora · Hugging Face [https://huggingface.co/nomic-ai/gpt4all-lora]

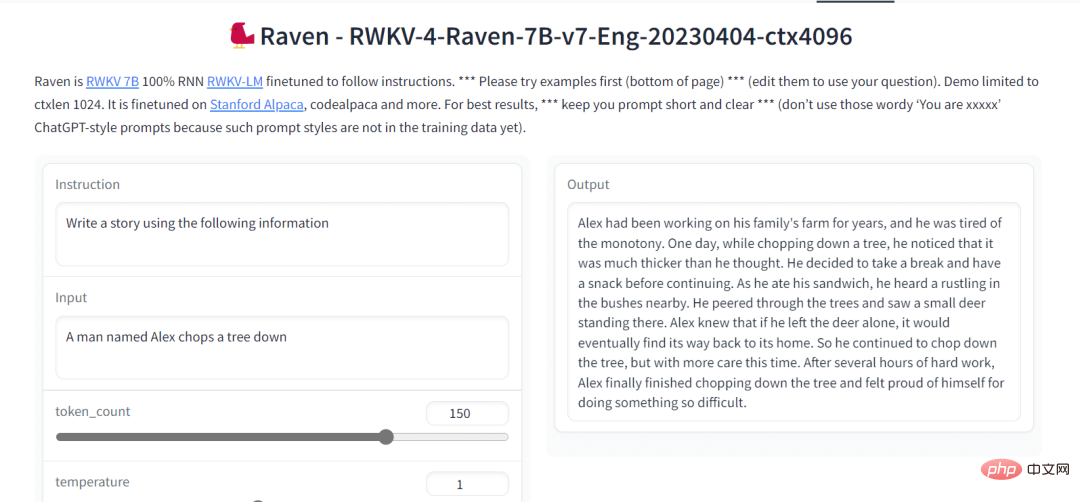

6.Raven RWKV

Raven RWKV 7B ist ein Open-Source-Chatbot, der auf dem RWKV-Sprachmodell basiert und ähnliche Ergebnisse wie ChatGPT generiert. Dieses Modell verwendet RNN, das hinsichtlich Qualität und Skalierbarkeit mit dem Transformator mithalten kann, gleichzeitig schneller ist und VRAM spart. Raven ist auf Stanford Alpaca, Code-Alpaca und weitere Datensätze abgestimmt.

Bild von Raven RWKV 7B

Quelle:

- GitHub: BlinkDL/ChatRWKV [https://github.com/BlinkDL/ChatRWKV]

- Demo: Raven RWKV 7B [https://huggingface.co /spaces/BlinkDL/Raven-RWKV-7B]

- Modellkarte: BlinkDL/rwkv-4-raven [https://huggingface.co/BlinkDL/rwkv-4-raven]

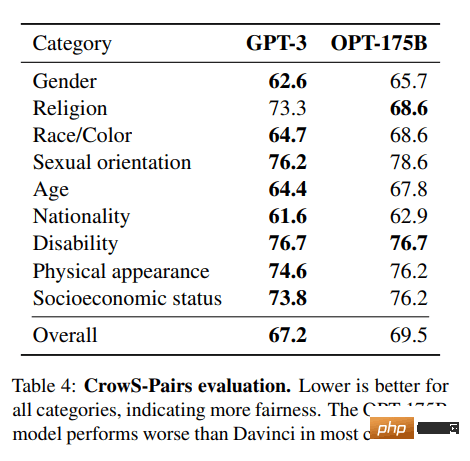

7.OPT

OPT: Das Open Pre-Trained Transformer-Sprachmodell ist nicht so leistungsstark wie ChatGPT, zeigt aber hervorragende Fähigkeiten beim Zero-Shot- und Few-Shot-Lernen und bei der Stereotyp-Bias-Analyse. Für bessere Ergebnisse kann es auch in Alpa, Colossal-AI, CTranslate2 und FasterTransformer integriert werden. HINWEIS: Der Grund, warum es in die Liste aufgenommen wird, ist seine Beliebtheit, da es in der Kategorie Textgenerierung 624.710 Downloads pro Monat gibt.

Bild von (arxiv.org)

Ressource:

- Forschungspapier: „OPT: Open Pre-trained Transformer Language Models (arxiv.org)“ [https://arxiv.org/abs/2205.01068 ]

- GitHub: facebookresearch/metaseq [https://github.com/facebookresearch/metaseq]

- Demo: Ein Wasserzeichen für LLMs [https://huggingface.co/spaces/tomg-group-umd/lm-watermarking]

- Modellkarte: facebook/opt-1.3b [https://huggingface.co/facebook/opt-1.3b]

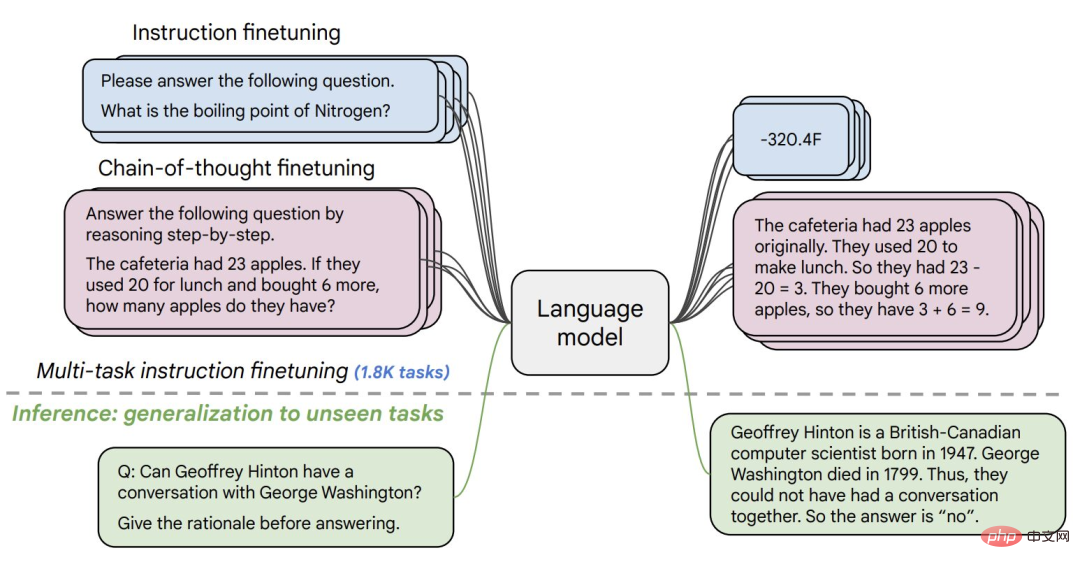

8.Flan-T5-XXL

Flan-T5-XXL Der T5 Das Modell wird anhand des in Form von Anweisungen ausgedrückten Datensatzes feinabgestimmt. Durch die Feinabstimmung der Anweisungen wurde die Leistung verschiedener Modellklassen wie PaLM, T5 und U-PaLM erheblich verbessert. Das Flan-T5-XXL-Modell ist auf mehr als 1000 zusätzliche Aufgaben abgestimmt und deckt mehr Sprachen ab.

Bild von Flan-T5-XXL

Quelle:

- Forschungspapier: „Scaling Instruction-Fine Tuned Language Models“ [https://arxiv.org/pdf/2210.11416.pdf]

- GitHub: google-research/t5x [https://github.com/google-research/t5x]

- Demo: Chat Llm Streaming [https://huggingface.co/spaces/olivierdehaene/chat-llm-streaming]

- Modellkarte :google/flan-t5-xxl [https://huggingface.co/google/flan-t5-xxl?text=Q%3A+%28+False+or+not+False+or+False+%29+is%3F +A%3A+Lassen Sie%27s+Schritt+für+Schritt+denken]

Zusammenfassung

Es stehen viele große Open-Source-Modelle zur Auswahl. In diesem Artikel geht es um 8 der beliebtesten großen Modelle.

Das obige ist der detaillierte Inhalt vonWir stellen acht kostenlose und quelloffene Großmodelllösungen vor, da ChatGPT und Bard zu teuer sind.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

4.OpenChatKit

4.OpenChatKit # 🎜🎜#

# 🎜🎜#

ChatGPT-Registrierung

ChatGPT-Registrierung

Inländische kostenlose ChatGPT-Enzyklopädie

Inländische kostenlose ChatGPT-Enzyklopädie

So installieren Sie ChatGPT auf einem Mobiltelefon

So installieren Sie ChatGPT auf einem Mobiltelefon

Kann Chatgpt in China verwendet werden?

Kann Chatgpt in China verwendet werden?

Warum startet mein Telefon ständig neu?

Warum startet mein Telefon ständig neu?

Die übergeordnete Vue-Komponente ruft die Methode der untergeordneten Komponente auf

Die übergeordnete Vue-Komponente ruft die Methode der untergeordneten Komponente auf

Verwendung der sqrt-Funktion in Java

Verwendung der sqrt-Funktion in Java

Welches Format ist PDF?

Welches Format ist PDF?