Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die EMNLP-Konferenz 2022 ist offiziell abgeschlossen, der beste Langbeitrag, der beste Kurzbeitrag und weitere Auszeichnungen wurden bekannt gegeben

Die EMNLP-Konferenz 2022 ist offiziell abgeschlossen, der beste Langbeitrag, der beste Kurzbeitrag und weitere Auszeichnungen wurden bekannt gegeben

Die EMNLP-Konferenz 2022 ist offiziell abgeschlossen, der beste Langbeitrag, der beste Kurzbeitrag und weitere Auszeichnungen wurden bekannt gegeben

Kürzlich fand in Abu Dhabi, der Hauptstadt der Vereinigten Arabischen Emirate, die EMNLP 2022 statt, die Top-Konferenz im Bereich der Verarbeitung natürlicher Sprache.

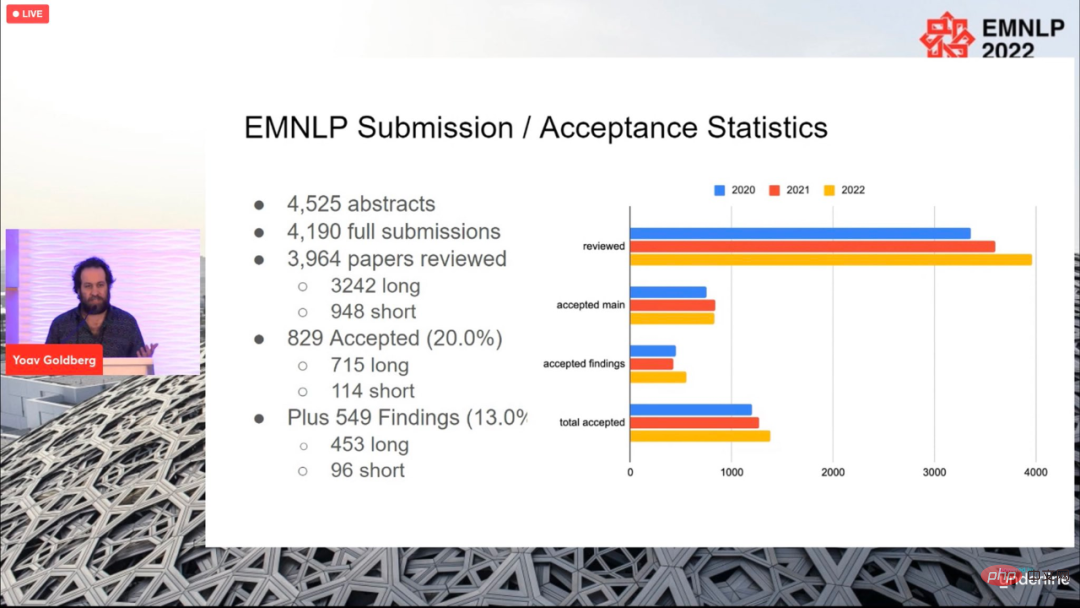

Für die diesjährige Konferenz wurden insgesamt 4190 Beiträge eingereicht und schließlich 829 Beiträge angenommen (715 lange Beiträge, 114 Beiträge), mit einer Gesamtannahmequote von 20 %, was sich nicht wesentlich von der vorherigen unterscheidet Jahre.

Die Konferenz endete am 11. Dezember Ortszeit, und auch die Paper Awards für dieses Jahr wurden bekannt gegeben, darunter der beste lange Paper (1 Stück), der beste kurze Paper (1 Stück) und der beste Demopapier (1 Artikel).

Best Long Paper

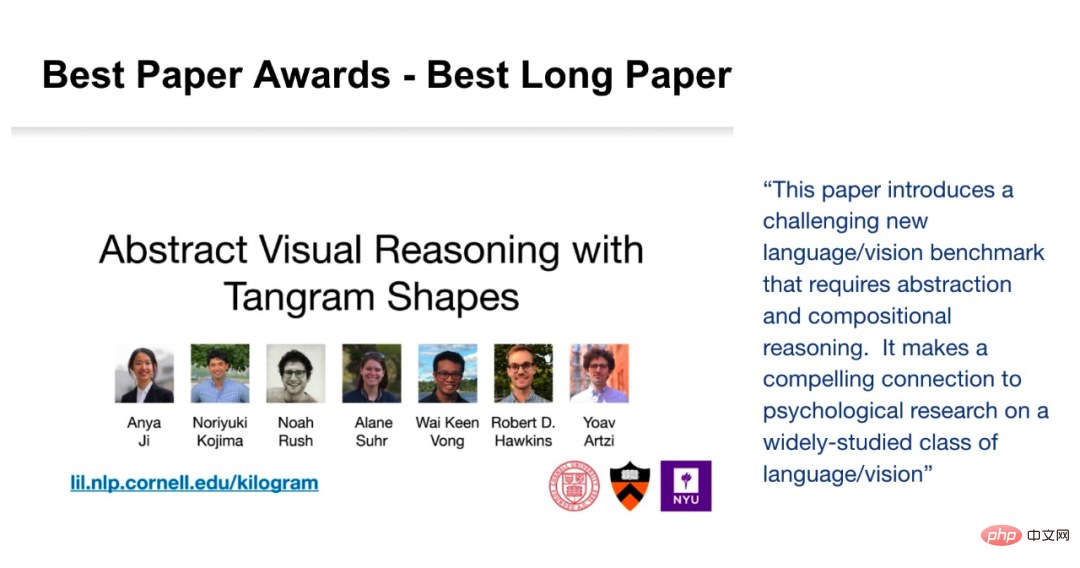

Paper: Abstract Visual Reasoning with Tangram Shapes

- Autoren: Anya Ji, Noriyuki Kojima, Noah Rush, Alane Suhr, Wai Keen Vong, Robert D. Hawkins, Yoav Artzi. Institutionen: Cornell University, New York University, Allen Institute, Princeton University Zusammenfassung:

- In diesem Artikel stellt der Forscher „KiloGram“ vor, eine Ressourcenbibliothek zum Studium des abstrakten visuellen Denkens von Menschen und Maschinen. KiloGram verbessert die vorhandenen Ressourcen auf zwei Arten erheblich. Zunächst kuratierten und digitalisierten die Forscher 1.016 Formen und schufen so eine Sammlung, die zwei Größenordnungen größer war als die in bestehenden Arbeiten verwendeten. Diese Sammlung erweitert die Abdeckung des gesamten Spektrums an Benennungsvarianten erheblich und bietet eine umfassendere Perspektive auf das menschliche Benennungsverhalten. Zweitens behandelt die Sammlung jedes Tangram nicht als einzelne Gesamtform, sondern als Vektorform, die aus den ursprünglichen Puzzleteilen besteht. Diese Zerlegung ermöglicht das Nachdenken über ganze Formen und ihre Teile. Die Forscher nutzten diese neue Sammlung digitaler Puzzle-Grafiken, um eine große Menge an Textbeschreibungsdaten zu sammeln, die die große Vielfalt des Benennungsverhaltens widerspiegeln.

- Die Forscher nutzten Crowdsourcing, um den Annotationsprozess zu erweitern, indem sie für jede Form mehrere Annotationen sammelten, um die Verteilung der von ihr hervorgerufenen Annotationen anstelle einer einzelnen Stichprobe darzustellen. Insgesamt wurden 13.404 Anmerkungen gesammelt, die jeweils ein vollständiges Objekt und seine zerlegten Teile beschreiben. Das Potenzial von KiloGram ist umfangreich. Wir nutzten diese Ressource, um die Fähigkeiten des abstrakten visuellen Denkens neuerer multimodaler Modelle zu bewerten und stellten fest, dass vorab trainierte Gewichte begrenzte Fähigkeiten des abstrakten Denkens aufwiesen, die sich mit der Feinabstimmung erheblich verbesserten. Sie stellten außerdem fest, dass explizite Beschreibungen das abstrakte Denken sowohl von Menschen als auch von Modellen erleichtern, insbesondere wenn Sprache und visuelle Eingaben gemeinsam kodiert werden.

Abbildung 1 ist ein Beispiel für zwei Tangrams mit jeweils zwei unterschiedlichen Anmerkungen. Jede Anmerkung enthält eine Beschreibung der gesamten Form (in Fettdruck), eine Segmentierung der Teile (in Farbe) und einen Namen für jedes Teil (mit jedem Teil verbunden). Das obere Beispiel zeigt eine geringe Variabilität für nahezu perfekte Übereinstimmung, während das untere Beispiel eine hohe Variabilität für Sprach- und Segmentierungsdivergenz zeigt.

KiloGram-Adresse: https://lil.nlp.cornell.edu/kilogram

Die Nominierungen für den besten Long Paper für diese Konferenz stammen von Kayo Yin und Graham Neubig Von zwei Forschern erhalten.

Aufsatz: Interpretation von Sprachmodellen mit kontrastiven Erklärungen

- Autor: Kayo Yin, Graham Neubig

Aufsatz: Die Interpretierbarkeitsmethode des Modells ist Wird oft zur Erklärung von NLP verwendet Modellieren Sie Entscheidungen zu Aufgaben wie der Textklassifizierung, bei denen der Ausgaberaum relativ klein ist. Bei der Anwendung auf die Sprachgenerierung besteht der Ausgaberaum jedoch oft aus Zehntausenden von Tokens, und diese Methoden können keine aussagekräftigen Erklärungen liefern. Sprachmodelle müssen verschiedene Merkmale berücksichtigen, um ein Token vorherzusagen, z. B. seine Wortart, Numerus, Zeitform oder Semantik. Da bestehende Erklärungsmethoden Belege für alle diese Merkmale in einer einzigen Erklärung vereinen, ist diese für das menschliche Verständnis weniger interpretierbar.

Um verschiedene Entscheidungen bei der Sprachmodellierung zu unterscheiden, untersuchen Forscher Sprachmodelle, die sich auf kontrastive Erklärungen konzentrieren. Sie suchen nach auffälligen Eingabe-Tokens und erklären, warum das Modell einen Token vorhergesagt hat, einen anderen jedoch nicht. Untersuchungen zeigen, dass kontrastive Erklärungen bei der Validierung wichtiger grammatikalischer Phänomene viel besser sind als nicht-kontrastive Erklärungen und dass sie die Simulierbarkeit kontrastiver Modelle für menschliche Beobachter erheblich verbessern. Die Forscher identifizierten auch gegensätzliche Entscheidungsgruppen, für die das Modell ähnliche Beweise verwendete, und konnten beschreiben, welche Eingabetoken das Modell bei verschiedenen Entscheidungen zur Sprachgenerierung verwendete. 🔜

Autor : Jitkapat Sawatphol, Nonthakit Chaiwong, Can Udomcharoenchaikit, Sarana NutanongInstitution: VISTEC Institute of Science and Technology, Thailand

In dieser Studie schlugen die Forscher die Autorschaft vor Präsentation Regularisierung, ein Destillationsframework, das die themenübergreifende Leistung verbessert und auch mit unbekannten Autoren umgehen kann. Dieser Ansatz kann auf jedes Modell der Autorendarstellung angewendet werden. Experimentelle Ergebnisse zeigen, dass in der themenübergreifenden Einstellung die Leistung von 4/6 verbessert wird. Gleichzeitig zeigt die Analyse der Forscher, dass in Datensätzen mit einer großen Anzahl von Themen themenübergreifende Trainings-Shards Probleme mit dem Verlust von Themeninformationen haben, wodurch ihre Fähigkeit zur Bewertung themenübergreifender Attribute geschwächt wird.

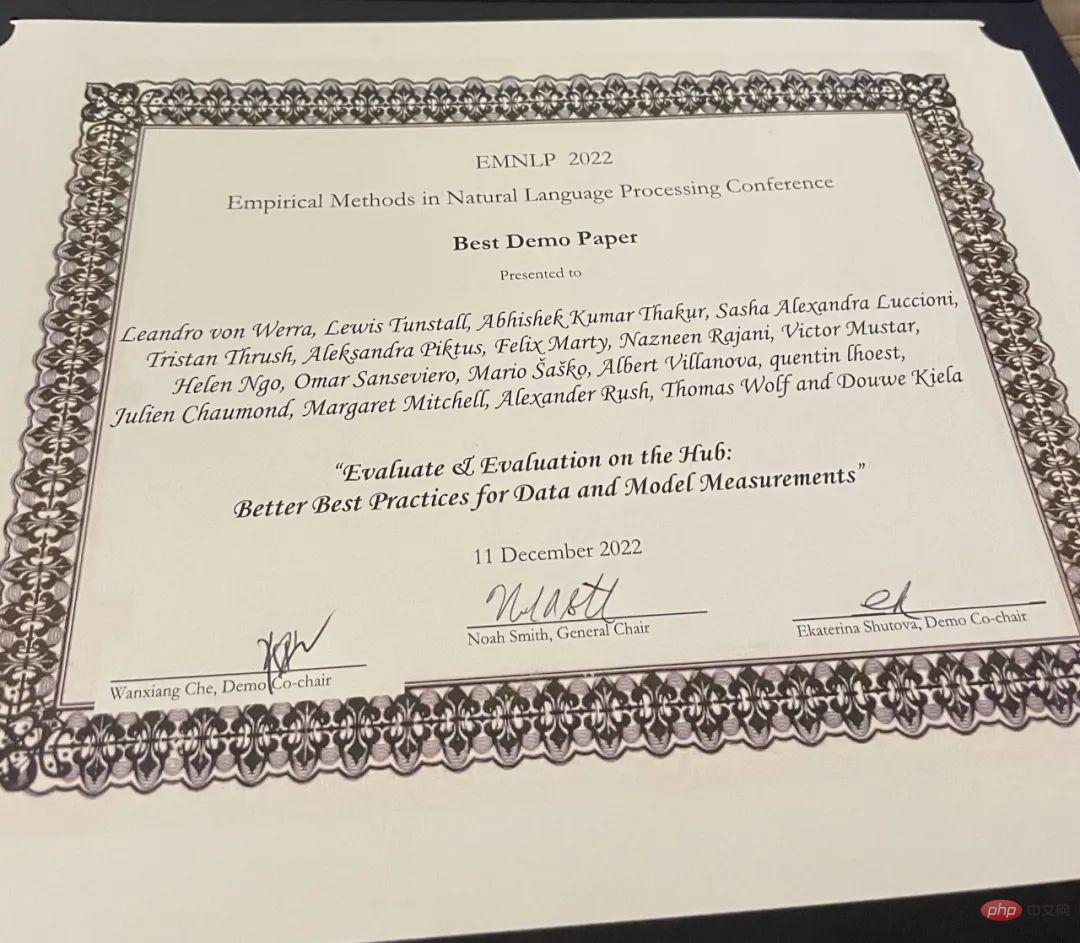

- Bestes Demo-Paper

- Paper: Evaluate & Evaluation on the Hub: Better Best Practices for Data and Model Measurements

Autoren: Leandro von Werra, Lewis Tunstall, Abhishek Thakur, Alexandra Sasha Luccioni et al. Institution: Hugging Face Beurteilung ist ein Maschine Als wichtiger Bestandteil des Lernens (ML) stellt diese Forschung Evaluate and Evaluation on Hub vor – eine Reihe von Tools, die bei der Bewertung von Modellen und Datensätzen in ML helfen. Evaluate ist eine Bibliothek zum Vergleich verschiedener Modelle und Datensätze, die verschiedene Metriken unterstützt. Die Evaluate-Bibliothek soll die Reproduzierbarkeit von Bewertungen unterstützen, den Bewertungsprozess dokumentieren und den Umfang der Bewertungen erweitern, um weitere Aspekte der Modellleistung abzudecken. Es umfasst mehr als 50 effiziente Spezifikationsimplementierungen für eine Vielzahl von Domänen und Szenarien, interaktive Dokumentation und die Möglichkeit, Implementierungs- und Evaluierungsergebnisse einfach zu teilen.

Projektadresse: https://github.com/huggingface/evaluate

Das obige ist der detaillierte Inhalt vonDie EMNLP-Konferenz 2022 ist offiziell abgeschlossen, der beste Langbeitrag, der beste Kurzbeitrag und weitere Auszeichnungen wurden bekannt gegeben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

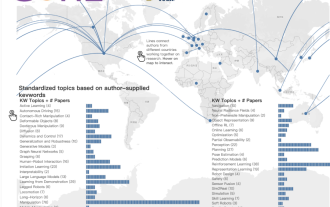

ICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte

Oct 04, 2023 pm 08:37 PM

ICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte

Oct 04, 2023 pm 08:37 PM

ICCV2023, die Top-Computer-Vision-Konferenz in Paris, Frankreich, ist gerade zu Ende gegangen! Der diesjährige Preis für das beste Papier ist einfach ein „Kampf zwischen Göttern“. Zu den beiden Arbeiten, die den Best Paper Award gewannen, gehörte beispielsweise ControlNet, eine Arbeit, die das Gebiet der vinzentinischen Graphen-KI untergrub. Seitdem ControlNet als Open-Source-Lösung verfügbar ist, hat es auf GitHub 24.000 Sterne erhalten. Ob es sich um Diffusionsmodelle oder den gesamten Bereich der Computer Vision handelt, die Auszeichnung für dieses Papier ist wohlverdient. Die lobende Erwähnung für die beste Arbeit ging an eine andere ebenso berühmte Arbeit, Metas „Separate Everything“ „Model SAM“. Seit seiner Einführung ist „Segment Everything“ zum „Benchmark“ für verschiedene Bildsegmentierungs-KI-Modelle geworden, auch für solche, die von hinten kamen.

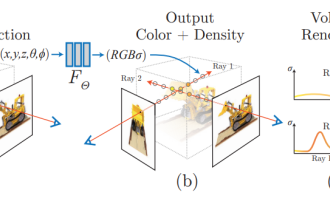

NeRF und die Vergangenheit und Gegenwart des autonomen Fahrens, eine Zusammenfassung von fast 10 Artikeln!

Nov 14, 2023 pm 03:09 PM

NeRF und die Vergangenheit und Gegenwart des autonomen Fahrens, eine Zusammenfassung von fast 10 Artikeln!

Nov 14, 2023 pm 03:09 PM

Seit Neural Radiance Fields im Jahr 2020 vorgeschlagen wurde, hat die Zahl verwandter Arbeiten exponentiell zugenommen. Es hat sich nicht nur zu einem wichtigen Zweig der dreidimensionalen Rekonstruktion entwickelt, sondern ist auch allmählich an der Forschungsgrenze als wichtiges Werkzeug für autonomes Fahren aktiv geworden . NeRF ist in den letzten zwei Jahren plötzlich aufgetaucht, hauptsächlich weil es die Merkmalspunktextraktion und -anpassung, die epipolare Geometrie und Triangulation, PnP plus Bündelanpassung und andere Schritte der traditionellen CV-Rekonstruktionspipeline und sogar die Netzrekonstruktion, Kartierung und Lichtverfolgung überspringt , direkt aus 2D Das Eingabebild wird verwendet, um ein Strahlungsfeld zu lernen, und dann wird aus dem Strahlungsfeld ein gerendertes Bild ausgegeben, das einem echten Foto nahekommt. Mit anderen Worten: Lassen Sie ein implizites dreidimensionales Modell, das auf einem neuronalen Netzwerk basiert, zur angegebenen Perspektive passen

Auch Papierillustrationen können mithilfe des Diffusionsmodells automatisch generiert werden und werden auch vom ICLR akzeptiert.

Jun 27, 2023 pm 05:46 PM

Auch Papierillustrationen können mithilfe des Diffusionsmodells automatisch generiert werden und werden auch vom ICLR akzeptiert.

Jun 27, 2023 pm 05:46 PM

Generative KI hat die Community der künstlichen Intelligenz im Sturm erobert. Sowohl Einzelpersonen als auch Unternehmen sind daran interessiert, entsprechende modale Konvertierungsanwendungen wie Vincent-Bilder, Vincent-Videos, Vincent-Musik usw. zu erstellen. In jüngster Zeit haben mehrere Forscher von wissenschaftlichen Forschungseinrichtungen wie ServiceNow Research und LIVIA versucht, Diagramme in Aufsätzen basierend auf Textbeschreibungen zu erstellen. Zu diesem Zweck schlugen sie eine neue Methode von FigGen vor, und das entsprechende Papier wurde auch als TinyPaper in ICLR2023 aufgenommen. Adresse des Bildpapiers: https://arxiv.org/pdf/2306.00800.pdf Manche Leute fragen sich vielleicht: Was ist so schwierig daran, die Diagramme im Papier zu erstellen? Wie hilft dies der wissenschaftlichen Forschung?

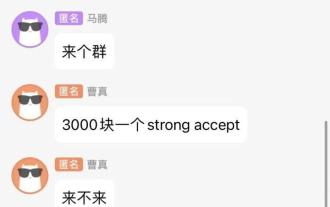

Chat-Screenshots enthüllen versteckte Regeln für KI-Rezensenten! AAAI 3000 Yuan ist stark zu akzeptieren?

Apr 12, 2023 am 08:34 AM

Chat-Screenshots enthüllen versteckte Regeln für KI-Rezensenten! AAAI 3000 Yuan ist stark zu akzeptieren?

Apr 12, 2023 am 08:34 AM

Gerade als die Einreichungsfrist für AAAI 2023-Papiere näher rückte, erschien plötzlich ein Screenshot eines anonymen Chats in der AI-Einreichungsgruppe auf Zhihu. Einer von ihnen behauptete, er könne „3.000 Yuan pro starkem Akzept“ anbieten. Sobald die Nachricht bekannt wurde, erregte sie sofort öffentliche Empörung unter den Internetnutzern. Aber beeilen Sie sich noch nicht. Zhihu-Chef „Fine Tuning“ sagte, dass dies höchstwahrscheinlich nur ein „verbales Vergnügen“ sei. Laut „Fine Tuning“ sind Begrüßungen und Bandenkriminalität in jedem Bereich unvermeidbare Probleme. Mit dem Aufkommen von OpenReview werden die verschiedenen Nachteile von cmt immer deutlicher. Der Spielraum für kleine Kreise wird in Zukunft kleiner, aber es wird immer Platz geben. Denn es handelt sich um ein persönliches Problem und nicht um ein Problem mit dem Einreichungssystem und -mechanismus. Wir stellen Open R vor

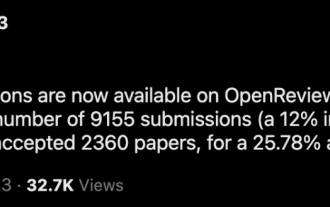

CVPR-Rangliste 2023 veröffentlicht, die Akzeptanzrate beträgt 25,78 %! 2.360 Beiträge wurden angenommen und die Zahl der Einreichungen stieg auf 9.155

Apr 13, 2023 am 09:37 AM

CVPR-Rangliste 2023 veröffentlicht, die Akzeptanzrate beträgt 25,78 %! 2.360 Beiträge wurden angenommen und die Zahl der Einreichungen stieg auf 9.155

Apr 13, 2023 am 09:37 AM

Gerade hat CVPR 2023 eine Erklärung herausgegeben, in der es heißt: In diesem Jahr haben wir eine Rekordzahl von 9.155 Beiträgen erhalten (ein Anstieg von 12 % gegenüber CVPR 2022) und 2.360 Beiträge angenommen, was einer Annahmequote von 25,78 % entspricht. Laut Statistik stieg die Zahl der Einreichungen beim CVPR in den sieben Jahren von 2010 bis 2016 lediglich von 1.724 auf 2.145. Nach 2017 stieg sie rasant an und trat in eine Phase rasanten Wachstums ein. Im Jahr 2019 überstieg sie erstmals die 5.000-Marke, und bis 2022 lag die Zahl der Einreichungen bei 8.161. Wie Sie sehen, wurden in diesem Jahr insgesamt 9.155 Beiträge eingereicht, was einen Rekord darstellt. Nachdem sich die Epidemie abgeschwächt hat, wird der diesjährige CVPR-Gipfel in Kanada stattfinden. In diesem Jahr wird das Format einer eingleisigen Konferenz übernommen und die traditionelle mündliche Auswahl entfällt. Google-Recherche

Das chinesische Team gewann die Auszeichnungen „Best Paper' und „Best System Paper' und die CoRL-Forschungsergebnisse wurden bekannt gegeben.

Nov 10, 2023 pm 02:21 PM

Das chinesische Team gewann die Auszeichnungen „Best Paper' und „Best System Paper' und die CoRL-Forschungsergebnisse wurden bekannt gegeben.

Nov 10, 2023 pm 02:21 PM

Seit ihrer ersten Veranstaltung im Jahr 2017 hat sich die CoRL zu einer der weltweit führenden akademischen Konferenzen an der Schnittstelle von Robotik und maschinellem Lernen entwickelt. CoRL ist eine themenspezifische Konferenz für Roboterlernforschung, die mehrere Themen wie Robotik, maschinelles Lernen und Steuerung, einschließlich Theorie und Anwendung, abdeckt. Die CoRL-Konferenz 2023 findet vom 6. bis 9. November in Atlanta, USA, statt. Nach offiziellen Angaben wurden in diesem Jahr 199 Arbeiten aus 25 Ländern für CoRL ausgewählt. Beliebte Themen sind Operationen, Reinforcement Learning und mehr. Obwohl CoRL von kleinerem Umfang ist als große akademische KI-Konferenzen wie AAAI und CVPR, wird die Beliebtheit von Konzepten wie großen Modellen, verkörperter Intelligenz und humanoiden Robotern in diesem Jahr zunehmen, aber auch relevante Forschung verdient Aufmerksamkeit

Microsofts neues heißes Papier: Transformer expandiert auf 1 Milliarde Token

Jul 22, 2023 pm 03:34 PM

Microsofts neues heißes Papier: Transformer expandiert auf 1 Milliarde Token

Jul 22, 2023 pm 03:34 PM

Da jeder seine eigenen großen Modelle weiter aktualisiert und iteriert, ist auch die Fähigkeit von LLM (großes Sprachmodell), Kontextfenster zu verarbeiten, zu einem wichtigen Bewertungsindikator geworden. Beispielsweise unterstützt das Star-Modell GPT-4 32.000 Token, was 50 Textseiten entspricht. Anthropic wurde von einem ehemaligen Mitglied von OpenAI gegründet und hat die Token-Verarbeitungsfähigkeiten von Claude auf 100.000 erhöht, was ungefähr 75.000 Wörtern entspricht entspricht der Zusammenfassung von „Harry Potter“ mit einem Klick 》Teil Eins. In der neuesten Studie von Microsoft wurde Transformer dieses Mal direkt auf 1 Milliarde Token erweitert. Dies eröffnet neue Möglichkeiten zur Modellierung sehr langer Sequenzen, beispielsweise die Behandlung eines gesamten Korpus oder sogar des gesamten Internets als eine Sequenz. Zum Vergleich: üblich