LiDAR-Sensortechnologielösung unter extremen Wetterbedingungen

01 Zusammenfassung

Autonome Fahrzeuge sind auf verschiedene Sensoren angewiesen, um Informationen über die Umgebung zu sammeln. Da das Verhalten des Fahrzeugs umweltbewusst geplant wird, ist seine Zuverlässigkeit aus Sicherheitsgründen von entscheidender Bedeutung. Aktive Lidar-Sensoren sind in der Lage, genaue 3D-Darstellungen von Szenen zu erstellen, was sie zu einer wertvollen Ergänzung des Umweltbewusstseins autonomer Fahrzeuge macht. Die Leistung von LiDAR ändert sich bei widrigen Wetterbedingungen wie Nebel, Schnee oder Regen aufgrund von Lichtstreuung und Okklusion. Diese Einschränkung hat in letzter Zeit zu einer umfangreichen Forschung zu Methoden zur Abmilderung der Verschlechterung der Wahrnehmungsleistung geführt.

In diesem Artikel werden verschiedene Aspekte der LiDAR-basierten Umgebungserfassung zum Umgang mit widrigen Wetterbedingungen gesammelt, analysiert und diskutiert. Besprochen werden Themen wie die Verfügbarkeit geeigneter Daten, die Verarbeitung und Entrauschung von Rohpunktwolken, robuste Wahrnehmungsalgorithmen und Sensorfusion zur Minderung von durch widriges Wetter verursachten Mängeln. Darüber hinaus identifiziert das Papier die dringendsten Lücken in der aktuellen Literatur und zeigt vielversprechende Forschungsrichtungen auf.

02 Einführung

LiDAR-Sensoren finden in letzter Zeit immer mehr Beachtung im Bereich des autonomen Fahrens [1]. Es liefert spärliche, aber genaue Tiefeninformationen und ist damit eine wertvolle Ergänzung zu eingehender untersuchten Sensoren wie Kameras und Radar. Ein Lidar-Sensor ist ein aktiver Sensor, das heißt er sendet Lichtimpulse aus, die von der Umgebung reflektiert werden. Der Sensor erfasst dann das reflektierte Licht und misst anhand der verstrichenen Zeit den Abstand zur Umgebung. Neben der Zeit können auch andere Eigenschaften ausgewertet werden, beispielsweise die Lichtmenge und die Signalausdehnung. In den meisten Fällen werden mechanische Komponenten mit mehreren Laserdioden kombiniert, um eine dünne Punktwolke der gesamten Szene zu erzeugen [1]. Es gibt verschiedene Sensoren auf dem Markt.

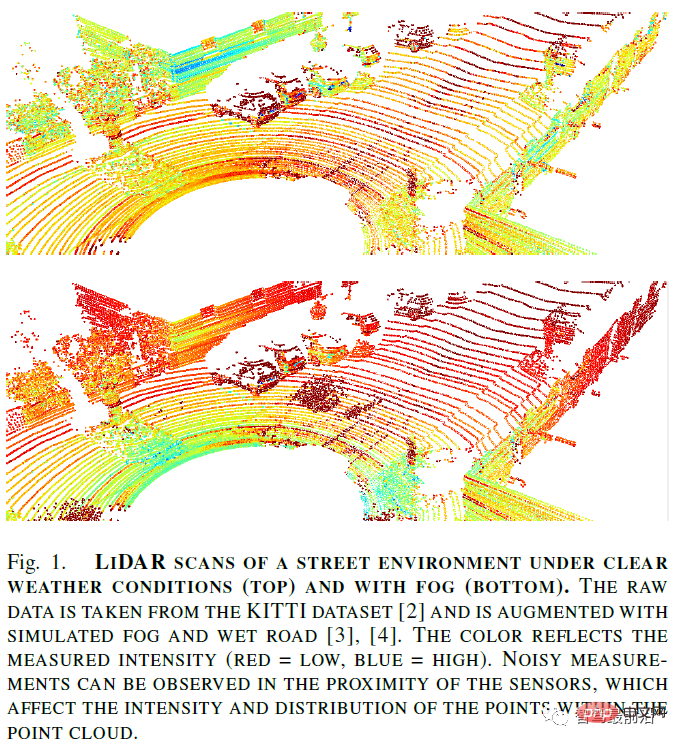

LiDAR-Sensoren haben bei widrigen Wetterbedingungen verschiedene Nachteile. Erstens kann es bei Temperaturen unter dem Gefrierpunkt zum Einfrieren des Sensors oder zu anderen mechanischen Komplikationen kommen. Für den Grad der Verschlechterung spielen interne und strukturelle Faktoren wie Sensorik, Modell und Montageort eine Rolle. Darüber hinaus kann widriges Wetter Intensitätswerte, Punktanzahlen und andere Punktwolkeneigenschaften beeinflussen (siehe Abbildung 1). Im Allgemeinen wird das emittierte Licht zurückgestreut oder umgelenkt, wenn aufgrund von Staub oder Unwettern Partikel in der Luft angetroffen werden. Dies führt zu verrauschten Abstands- und Reflexionsmessungen in der Punktwolke, da einige Laserimpulse vorzeitig zum Sensor zurückkehren oder in der Atmosphäre verloren gehen. Rauschen ist besonders schädlich, wenn Szenenerkennungsalgorithmen angewendet werden. In solchen sicherheitskritischen Anwendungsfällen ist die Aufrechterhaltung einer zuverlässig hohen Vorhersageleistung besonders wichtig. Daher sind Gegenmaßnahmen erforderlich, um die Verschlechterung der Lidar-Sensorleistung unter widrigen Wetterbedingungen zu minimieren oder zumindest die Einschränkungen des Sensors in realen Szenarien zu erkennen.

Die meisten hochmodernen Algorithmen basieren auf Deep-Learning-Algorithmen (DL), die auf großen Datenmengen basieren, um universelle Eigenschaften der Umgebung abzuleiten. Während es eine Forschungsrichtung gibt, die sich auf die unbeaufsichtigte Wahrnehmung konzentriert, erfordern die meisten neueren Arbeiten eine entsprechende Kennzeichnung von Rohdaten. Dazu gehören Begrenzungsrahmen zur Objekterkennung und punktweise Klassenbezeichnungen zur semantischen Segmentierung. Die manuelle Beschriftung spärlicher und verrauschter Punktwolken ist nicht nur schwierig, sondern auch kostspielig und fehleranfällig. Besonders interessant ist daher die Frage, wie man bestehende Punktwolken mit wetterspezifischem Rauschen simulieren bzw. anreichern kann.

Obwohl es umfangreiche Untersuchungen zur Analyse des Leistungsabfalls von Lidar-Sensoren unter extremen Wetterbedingungen gibt, fehlt eine umfassende Zusammenfassung zu algorithmischen Gegenmaßnahmen zur Verbesserung der Wahrnehmung. Darüber hinaus befassten sich Untersuchungen zum autonomen Fahren bei extremen Wetterbedingungen mit der wetterbedingten Sensorverschlechterung, identifizierten jedoch keine wetterbedingten Probleme, die speziell für Lidar-Sensoren gelten. In diesem Artikel werden verschiedene Methoden zur Bewältigung widriger Wetterbedingungen für die Lidar-Sensorik zusammengefasst und analysiert. Daher behandelt das Papier dieses Thema aus drei verschiedenen Perspektiven:

- Datenverfügbarkeit: reale und synthetische Datensätze zur Entwicklung robuster Lidar-Wahrnehmungsalgorithmen;

- Punktwolkenmanipulation: sensorspezifische Wetterrobustheit und wahrnehmungsunabhängig Punktwolkenverarbeitung (z. B. Wetterklassifizierung, Punktwolken-Entrauschung);

- Robuste Wahrnehmung: Ein robuster Wahrnehmungsalgorithmus, der die Wahrnehmung anpassen oder verbessern kann, indem er mehrere Sensoren zusammenführt und während des Trainings die allgemeine Robustheit des Modells anpasst, um mit wetterbedingten Einflüssen umzugehen Lärm in Punktwolken.

Abschließend fassen wir die fehlenden Lücken in der aktuellen Technologie und die vielversprechendsten Forschungsrichtungen zusammen.

03 Ungünstige Wetterdaten

Um ein DL-Modell für jede Art von Wahrnehmungsaufgabe zu trainieren, ist eine große Datenmenge erforderlich. Bei den noch vorherrschenden überwachten Methoden müssen diese Daten sogar durch automatisierte Etikettierungsmethoden oder manuell gekennzeichnet werden. In jedem Fall ist die Beschaffung genau gekennzeichneter, spärlicher LIDAR-Daten teuer und umständlich und wird zusätzlich erschwert, wenn die Rohpunktwolke durch wetterbedingtes Rauschen verfälscht wird.

Daher werden wertvolle Datensätze mit hochwertigen Labels benötigt. Im Allgemeinen gibt es drei Möglichkeiten, LIDAR-Punktwolken mit wettercharakteristischen Rauschmustern zu erhalten: reale Aufnahmen, erweiterte Punktwolken und simulierte Punktwolken. Die erste wurde mithilfe eines Testfahrzeugs mit geeigneter Sensorkonfiguration bei extremen Wetterbedingungen erstellt. Der letztere Ansatz erfordert physikalische Modelle oder DL-basierte Methoden, um Teile oder ganze Punktwolken zu erstellen.

Datensätze aus der realen Welt

Die meisten vorhandenen Datensätze für Lidar-Wahrnehmungsbenchmarks wurden unter günstigen Wetterbedingungen aufgezeichnet. Um die entwickelten Wahrnehmungsalgorithmen in der realen Welt nutzen zu können, muss der zugrunde liegende Datensatz alle Wetterbedingungen widerspiegeln. Neben klaren Wetterbedingungen gibt es umfangreiche Datensätze, die explizit Regen, Schnee und Nebel umfassen.

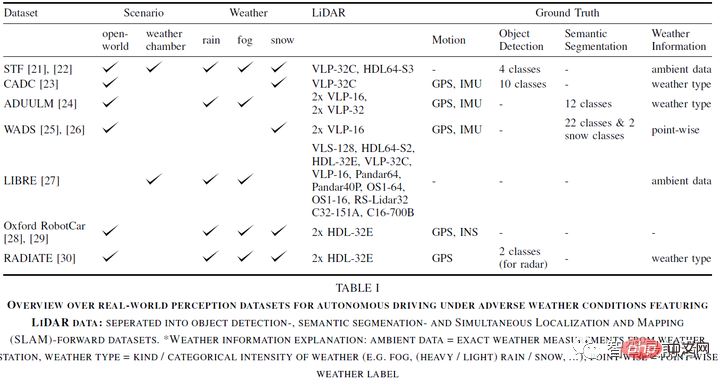

Tabelle I zeigt einen Überblick über öffentlich verfügbare Datensätze, die zur Untersuchung der Lidar-Wahrnehmung bei Unwettern verwendet werden. Die Datensätze wurden unter unterschiedlichen Bedingungen aufgenommen und variieren stark in der Größe. Die meisten davon wurden tatsächlich in realen Fahrszenarien aufgezeichnet, während zwei davon (teilweise) aus Wetterkammern stammten. Wetterkammern haben den Vorteil, dass sie eine vollständige Kontrolle über die Wetterbedingungen und die Umgebung, d. h. im Hinblick auf Hindernisse, haben. Dennoch spiegeln sie die realen Situationen nicht vollständig wider.

Darüber hinaus verwendet jeder Datensatz ein anderes Sensor-Setup. [27] speziell Benchmarking von Lidar-Herstellern und -Modellen unter extremen Wetterbedingungen. Zusätzlich zu LiDAR-Sensoren bieten alle Datensätze RGB-Kameraaufzeichnungen, und einige Datensätze umfassen sogar Radar-, Stereo-, Ereignis-, Gated- oder Infrarotkameras.

Diese Datensätze sollen verschiedene Wahrnehmungs- und Fahraufgaben autonomer Fahrzeuge lösen. Fast alle Sensorkonfigurationen (außer [21]) umfassen Positionierungs- und Bewegungssensoren, nämlich GPS/GNSS und IMU. Daher eignen sie sich zum Entwickeln und Testen von SLAM-Algorithmen. Alle Datensätze bieten Beschriftungen für die Objekterkennung oder punktweise Segmentierung, mit Ausnahme von [29], das nur Bewegungs-GT bereitstellt.

Schließlich enthalten alle Datensätze einige Metadaten zu den Wetterbedingungen. Dies ist entscheidend für die Entwicklung nahezu aller Arten von Wahrnehmungsmodellen bei extremen Wetterbedingungen. Zumindest für eine gründliche Überprüfung ist es von entscheidender Bedeutung, die Intensität und Art der umgebenden Wetterbedingungen zu verstehen. Nur ein Datensatz liefert punktuelle Wetterkennzeichnungen, nämlich Schneefall am Straßenrand und Schneeansammlung.

Der Vorteil eines Datensatzes, der aus realen Datensätzen besteht, besteht darin, dass er äußerst realistisch ist. Der Nachteil besteht darin, dass Beschriftungen für aufgezeichnete Szenen nur teilweise verfügbar sind (Punkt für Punkt) oder, wenn die Daten in einer Wetterkammer aufgezeichnet werden, auf komplexere reale Szenarien beschränkt sind. Die manuelle Punkt-für-Punkt-Beschriftung von LIDAR-Punktwolken unter widrigen Wetterbedingungen stellt eine besondere Herausforderung dar, da es in vielen Fällen unpraktisch ist, Störechos oder Rauschen vom tatsächlich reflektierten Signal zu unterscheiden.

Weather Augmentation

Die Ausweitung ungünstiger Wettereffekte auf vorhandene Datensätze bietet eine effiziente Möglichkeit, große Datenmengen zu generieren, anstatt neue Datensätze mühsam mit unterschiedlichen ungünstigen Wettereffekten zu sammeln und zu kennzeichnen. In der Regel werden physikalisch oder empirisch basierte Augmentationsmodelle verwendet, um bestimmte ungünstige Wettereffekte in Punktwolken mit klarem Wetter zu verstärken, unabhängig davon, ob sie aus der realen Welt oder aus Simulationen stammen. Dies ermöglicht es, Szenen zu erhalten, die durch wetterspezifisches Rauschen verfälscht sind, während alle interessanten Randfälle und Anmerkungen, die bereits im Datensatz vorhanden sind, erhalten bleiben.

Die Augmentationsmethode definiert die Zuordnung von klaren Wetterpunkten zu entsprechenden Punkten unter widrigen Wetterbedingungen. Zu diesem Zweck wird häufig auf das theoretische Lidar-Modell in [32] zurückgegriffen, das die Auswirkungen von ungünstigem Regen, Nebel und Schnee modelliert. Es modelliert die empfangene Intensitätsverteilung als lineares System, indem es den ausgesendeten Impuls mit der Szenenreaktion faltet. Die Szenenreaktion modelliert Reflexionen von festen Objekten sowie Rückstreuung und Dämpfung aufgrund von Unwettern.

Eine praktischere Nebelverbesserung wird in [9] eingeführt, die direkt auf Punktwolken angewendet werden kann. Sie basiert auf der maximalen Sichtweite, die eine Funktion der Messintensität, der Lidar-Parameter und der optischen Sichtweite bei Nebel ist. Wenn die Entfernung eines klaren Wetterpunkts geringer ist als die maximale Betrachtungsentfernung, erscheint ein zufälliger Streupunkt, oder der Punkt geht mit einer bestimmten Wahrscheinlichkeit verloren. Das Modell berücksichtigt Niederschläge, indem es Sichtbarkeitsparameter und Streuwahrscheinlichkeiten in Niederschlagsraten umwandelt.

Allerdings ignorieren diese Modelle die Strahldivergenz der ausgesendeten Lidar-Pulse, die zur Regenverstärkung berücksichtigt werden. Hier wird die Anzahl der Schnittpunkte eines überabgetasteten Strahls, der die Strahldivergenz simuliert, mit einem kugelförmigen Regentropfen berechnet. Wenn die Anzahl der Schnittpunkte einen bestimmten Schwellenwert überschreitet, wird ein Streupunkt hinzugefügt. Die Augmentationsmethode in [35] erweitert diesen Ansatz so, dass fehlende Punkte möglich sind. Darüber hinaus funktioniert es gut bei Schnee und Nebel.

Eine weitere Verbesserung für Nebel, Schnee und Regen wird in [36] eingeführt. Das Modell arbeitet im Leistungsbereich und verlässt sich beispielsweise nicht auf die Berechnung von Kreuzungspunkten wie die zuvor diskutierten Methoden. Darüber hinaus wird eine rechnerisch effizientere Strategie zur Abtastung der Streupunktentfernung verwendet, um die Strahldivergenz zu simulieren. Typischerweise vergleicht das Modell zunächst die von festen Objekten und zufällig ausgewählten Streukörpern reflektierte gedämpfte Leistung mit einem abstandsabhängigen Rauschschwellenwert. Streupunkte werden hinzugefügt, wenn ihre Kraft die Kraft des festen Objekts übersteigt. Liegt ein Punkt unterhalb der distanzabhängigen Rauschschwelle, geht der Punkt verloren.

Neben physikbasierten Modellen können auch empirische Modelle zur Erweiterung genutzt werden. Empirische Methoden zur Verbesserung des von anderen Fahrzeugen aufgewirbelten Sprühnebels finden sich in [38]. Im Mittelpunkt dieses Modells steht die Beobachtung aus speziellen Experimenten, dass Sprays in Clustern organisiert sind. Ein weiterer datengesteuerter Ansatz wird in [39] vorgeschlagen, der auf Sprühszenen aus dem Waymo-Datensatz basiert. In [40] wird eine rechenintensivere Spray-Enhancement-Methode vorgeschlagen, die auf einem Renderer mit einer Physik-Engine basiert.

Schließlich können DL-basierte Methoden zur Verbesserung ungünstiger Wetterbedingungen angewendet werden. In [41] wird, inspiriert von der Bild-zu-Bild-Übersetzung, eine auf generativen gegnerischen Netzwerken (GAN) basierende Methode vorgeschlagen, die in der Lage ist, Punktwolken von sonnigen in neblige oder regnerische Tage umzuwandeln. Sie verglichen ihre Ergebnisse qualitativ mit echten Nebel- und Regenwolken aus Wetterkammern.

Die Beurteilung der Qualität und des Realismus von Augmentationsmethoden ist jedoch eine Herausforderung. Einige Autoren nutzen Wetterkammern oder andere kontrollierte Umgebungen, um Vergleiche mit realen Wettereffekten zu ermöglichen. Darüber hinaus gilt eine Erweiterungsmethode im Allgemeinen als realistisch, wenn sie zur wahrgenommenen Leistung unter realen widrigen Wetterbedingungen beiträgt.

04 Punktwolkenverarbeitung und Rauschunterdrückung

In diesem Abschnitt werden Methoden zum Umgang mit widrigen Wetterbedingungen vorgestellt, die auf Sensorik oder Punktwolken basieren, also unabhängig von der eigentlichen Erfassungsaufgabe. Daher analysiert das Papier die allgemeine sensorbezogene Wetterrobustheit und die Möglichkeit, den Grad der Leistungsverschlechterung in Abhängigkeit von den Wetterbedingungen abzuschätzen. Darüber hinaus gibt es zahlreiche Studien zur Entfernung von wetterbedingtem Rauschen aus Lidar-Punktwolken mithilfe klassischer Entrauschungsmethoden und DL.

Sensorbedingte Wetterrobustheit

Je nach Technologie, Ausstattung und Konfiguration sind verschiedene Lidar-Modelle mehr oder weniger von den Wetterbedingungen betroffen. Aufgrund von Augensicherheitseinschränkungen und der Unterdrückung von Umgebungslicht dominieren zwei Betriebswellenlängen von Lidar-Sensoren: 905 nm und 1550 nm, wobei 905 nm der am häufigsten verfügbare Sensor ist. Dies ist teilweise auf die bessere Leistung bei widrigen Wetterbedingungen zurückzuführen, d. h. auf eine geringere Absorption durch Regentropfen, ein besseres Reflexionsvermögen bei Schnee und eine geringere Verschlechterung bei Nebel. Für eine umfassende Diskussion der Lidar-Technologie und Wellenlängen unter extremen Wetterbedingungen verweisen wir auf [17].

Darüber hinaus wurde die Leistung von Full Waveform Lidar (FWL) unter extremen Wetterbedingungen untersucht. FWL misst nicht nur ein oder zwei Echos, sondern alle schwächeren Echos und misst so effektiv mehr Lärm, sammelt aber auch mehr Informationen über die Umgebung. Obwohl FWL hohe Rechenressourcen erfordert, hat es sich für die Analyse des umgebenden Mediums als nützlich erwiesen, was die Grundlage dafür bilden kann, selbst sich ändernde Bedingungen zu verstehen und dynamisch anzupassen.

Abschätzung der Sensorverschlechterung und Wetterklassifizierung

Da sich Lidar-Sensoren bei unterschiedlichen Wetterbedingungen unterschiedlich verschlechtern, ist die Schätzung des Grads der Sensorverschlechterung der erste Schritt bei der Verarbeitung beschädigter Lidar-Punktwolken. Bei der Entwicklung von Methoden zur besseren Identifizierung von Erfassungsgrenzen wurden Fortschritte erzielt, um zu verhindern, dass sich Fehlerkennungen auf nachgelagerte Aufgaben übertragen.

Erstens legen einige Studien zur Charakterisierung der Sensordegradation unter verschiedenen Wetterbedingungen eine solide Grundlage für die Kalibrierung und Weiterentwicklung von Sensoren bei extremen Wetterbedingungen, obwohl ihre Wetterklassifizierungsfähigkeiten noch nicht bewertet wurden. Die erste Arbeit zur tatsächlichen Simulation der Auswirkungen von Regenfällen auf Lidar-Sensoren wird in

[33] vorgestellt. Die Autoren schlagen ein mathematisches Modell vor, das aus der Lidar-Gleichung abgeleitet ist und eine Schätzung der Leistungsverschlechterung auf der Grundlage der Niederschlagsmenge und der maximalen Erfassungsreichweite ermöglicht.

In nachfolgenden Forschungsarbeiten wurde die Abschätzung der Sensorverschlechterung unter extremen Wetterbedingungen als Anomalieerkennungsaufgabe und Verifizierungsaufgabe formuliert. Ersteres verwendet ein DL-basiertes Modell, das darauf ausgelegt ist, eine latente Darstellung zu erlernen, die einen klaren LiDAR-Scan von einem verregneten LiDAR-Scan unterscheidet, wodurch das Ausmaß der Leistungsverschlechterung quantifiziert werden kann. Der letztere Ansatz schlägt die Verwendung von Reinforcement Learning (RL)-Modellen vor, um Fehler in Objekterkennungs- und -verfolgungsmodellen zu identifizieren.

Während die oben genannten Methoden darauf abzielen, die Verschlechterung der Sensorleistung selbst zu quantifizieren, konzentriert sich eine andere Reihe von Studien auf die Klassifizierung der Umgebungswetterbedingungen (d. h. klar, regnerisch, Nebel und Schnee). Zufriedenstellende Ergebnisse wurden mit Hilfe klassischer Methoden des maschinellen Lernens (k-nächste Nachbarn und Support-Vektor-Maschinen) erzielt, die auf handgefertigten Funktionen von LiDAR-Punktwolken basieren: [10] schlug einen Funktionssatz zur Durchführung einer punktweisen Wetterklassifizierung vor.

[51] entwickelte ein probabilistisches Modell für die Frame-für-Frame-Regression der Niederschlagsrate. In Zusammenarbeit mit Experten leiteten sie genaue Niederschlagsmengen aus LIDAR-Punktwolken ab.

Es ist zu beachten, dass die meisten Methoden auf Daten trainiert und ausgewertet werden, die von Wetterkammern gesammelt werden. Während die Fähigkeit, die Wetterbedingungen sorgfältig zu kontrollieren, eine hohe Reproduzierbarkeit ermöglicht, spiegeln die Daten oft nicht genau die realen Bedingungen wider. Um die Klassifizierungsfähigkeit jeder Methode zu bewerten, ist eine gründliche Untersuchung realer Daten erforderlich [50].

Punktwolken-Entrauschung

Wettereffekte spiegeln sich in LiDAR-Punktwolken als spezifische Rauschmuster wider. Wie in Abschnitt 1 erwähnt, können sie Einfluss auf Faktoren wie die Anzahl der Messungen in der Punktwolke und den maximalen Erfassungsbereich haben. Punktwolken können mit verschiedenen Methoden entrauscht werden, um eindeutige Messungen zu rekonstruieren, anstatt die Punktwolke mit wetterspezifischem Rauschen zu ergänzen. Zusätzlich zu den klassischen Filteralgorithmen sind kürzlich einige DL-basierte Entrauschungsarbeiten erschienen.

Neben der Anwendung von Wahrnehmungsaufgaben wie der Objekterkennung auf entrauschten Punktwolken sind Metriken wie Präzision (Erhaltung von Umgebungsmerkmalen) und Rückruf (Herausfiltern von wetterbedingtem Rauschen) entscheidend für die Bewertung der Leistung klassischer Filtermethoden. Um diese Metriken zu berechnen, sind Punkt-für-Punkt-Markierungen erforderlich, um Wetterkategorien wie Schneepartikel zu berücksichtigen.

Radius Outlier Removal (ROR) filtert Rauschen basierend auf der Nachbarschaft eines beliebigen Punktes. Bei Lidar-Messungen entfernter Objekte wird dies problematisch, da die Punktwolke von Natur aus dünner wird. Fortgeschrittene Methoden gehen dieses Problem an, indem sie den Schwellenwert basierend auf der Erfassungsentfernung dynamisch anpassen (Dynamic Radius Outlier Removal (DROR)) oder den durchschnittlichen Abstand zu den Nachbarn jedes Punkts in der Punktwolke berücksichtigen (Statistical Outlier Removal). Beide Verfahren weisen hohe Laufzeiten auf und sind daher für autonomes Fahren nahezu ungeeignet. Fast Clustering Statistical Outlier Removal (FCSOR) und Dynamic Statistical Outlier Removal (DSOR) schlagen beide Methoden vor, um die Rechenlast zu reduzieren und gleichzeitig Wetterartefakte aus Punktwolken zu entfernen.

Die Rauschunterdrückungsmethode von Lidar am Straßenrand basiert auf einem Hintergrundmodell historischer Daten (das zur Reparatur von Sensoren am Straßenrand verwendet werden kann) in Kombination mit den Grundprinzipien der klassischen Rauschunterdrückung zur Identifizierung dynamischer Punkte. [57] filterten Wettergeräusche von realen Objekten mithilfe von Intensitätsschwellen. Leider ist dies nicht ohne weiteres auf Lidar-Sensoren anwendbar, die an fahrenden Fahrzeugen montiert sind.

Im Gegensatz zu klassischen Entrauschungsmethoden ist die DL-basierte Lidar-Punktwolken-Entrauschung aufgrund der Fähigkeit des Modells, die zugrunde liegende Struktur des Wetterrauschens direkt zu verstehen, beliebt: Erstens wurden auf Convolutional Neural Network (CNN) basierende Modelle für eine effektive Wetterentrauschung verwendet. Durch die Verwendung zeitlicher Daten zur Differenzierung wird die wetterspezifische Rauschunterdrückung weiter genutzt, da sich Wetterrauschen natürlich häufiger ändert als der Szenenhintergrund oder sogar Objekte innerhalb der Szene. CNN-basierte Methoden (insbesondere Voxel-basierte Methoden) übertreffen klassische Entrauschungsmethoden hinsichtlich der Rauschfilterung. Da GPUs außerdem schneller rechnen, sind ihre Inferenzzeiten kürzer.

Zusätzlich zu überwachten CNN-Methoden sind auch unbeaufsichtigte Methoden wie CycleGANs in der Lage, verrauschte Punktwolkeneingaben in klare Lidar-Scans umzuwandeln. Ihre Natur ist jedoch immer noch verrauscht und die resultierenden Punktwolken lassen sich nur schwer auf ihre Authentizität überprüfen.

05 Robuste LiDAR-Wahrnehmung

Obwohl es gute Bemühungen gibt, die durch widrige Wetterbedingungen verursachte Feldverschiebung zu reduzieren, gibt es mehrere Möglichkeiten, LiDAR-Wahrnehmungsmodelle unabhängig von der Datenqualität robuster zu machen Geräuschpegel. Hier gibt es drei Arbeitsabläufe: Nutzung der Sensorfusion, Verbesserung des Trainings durch Datenanreicherung mit wetterspezifischem Rauschen oder ein allgemeiner Ansatz zur Modellrobustheit gegenüber Domänenverschiebungen, um Leistungseinbußen auszugleichen. Es ist zu beachten, dass Sensorfusionsverfahren die einzigen sind, die neben der Objekterkennung auch mehrere Sensoraufgaben lösen können. Nach bestem Wissen der Arbeit gibt es keine Literatur zu anderen Wahrnehmungsaufgaben wie der semantischen Segmentierung.

Sensorfusion zur Bewältigung von Unwettern nutzen

Generell lässt sich sagen, dass jeder Sensor in der Sensorgruppe für autonomes Fahren seine Vor- und Nachteile hat. Die häufigsten Sensoren dieser Sensorgruppe sind RGB-Kameras, Radar und Lidar. Wie in Abschnitt 1 erwähnt, wird die Lidar-Wahrnehmung beeinträchtigt, wenn auf sichtbare Partikel in der Luft wie Staub, Regen, Schnee oder Nebel trifft. Die Kamera reagiert empfindlicher auf starken Lichteinfall und Halo-Effekte. Radar wiederum ist gegen beides immun, verfügt jedoch nicht über die Fähigkeit, statische Objekte und feine Strukturen zu erkennen. Daher ist es notwendig, verschiedene Sensoren zu verschmelzen, um ihre jeweiligen Mängel abzumildern und eine robuste Wahrnehmung unter verschiedenen Umgebungsbedingungen zu fördern.

Frühe Arbeiten zur Sensorfusion zur Bekämpfung der negativen Auswirkungen des Wetters auf die Sensorwahrnehmung konzentrierten sich auf die Entwicklung robuster Datenkorrelationsrahmen. Aktuelle Forschungsströme nutzen DL-basierte Methoden für eine robuste multimodale Wahrnehmung und befassen sich hauptsächlich mit der Frage der frühen versus späten Fusion, um Robustheit unter widrigen Wetterbedingungen zu erreichen.

Die Wahl der vorderen oder hinteren Fusion scheint von der Sensorauswahl, der Datendarstellung und der erwarteten Ausfallrate abzuhängen. Unter der Annahme, dass nicht alle fusionierten Sensoren im gleichen Ausmaß beeinträchtigt sind und mindestens einer von ihnen voll funktionsfähig ist, scheint die späte Fusion besser zu sein als die frühe Fusion. In diesem Fall ist das Modell in der Lage, den Sensorfluss selbstständig zu verarbeiten, sich auf funktionierende Sensoren zu verlassen und fehlerhafte Sensoren zu ignorieren. Stattdessen hilft die frühe Fusion von Radar- und Lidar-Tiefenkarten dabei, Fehlerkennungen zu filtern und saubere Scans zu erzielen.

Die Datendarstellung ist ein weiterer Faktor, der teilweise zur Beantwortung der Frage der frühen versus späten Fusion beiträgt. Die Vogelperspektive (BEV) von LiDAR-Sensoren erleichtert die Objekterkennung erheblich, indem sie die Auflösung von Objekten verbessert. Daher erleidet jedes Modell, das gelernt hat, sich auf die entsprechenden LIDAR-Funktionen zu verlassen, einen Leistungsverlust, wenn die LIDAR-Daten beschädigt sind. Der vollständige Sensorausfall konnte mithilfe eines Lehrer-Schüler-Netzwerks erfolgreich behoben werden.

Letztendlich basieren einige Sensorfusionsmethoden auf der Kombination früher und später Fusion in einem einzigen Modell und nutzen Konzepte wie zeitliche Daten und regionalbasierte Fusion [72] oder Aufmerksamkeitskarten [73]. Eine weitere Möglichkeit ist die in [21] vorgeschlagene Fusion der adaptiven Entropiekontrolle.

Neben der Vorhersageleistung sollte auch die Modelllaufzeit bei der Entwicklung neuer Wahrnehmungsmethoden berücksichtigt werden. [68] führten eine neue Metrik ein, die die Vorhersageleistung, die die räumliche Segmentierung vorantreibt, mit der Inferenzlaufzeit kombiniert. Interessanterweise erzielte das reine Lidar-Modell bei dieser Kennzahl die höchste Punktzahl.

Es besteht kein Zweifel daran, dass es praktisch ist, einen Sensorausfall bei widrigen Wetterbedingungen mit einem nicht betroffenen Sensor zu kompensieren. Wenn jedoch daran gearbeitet wird, die Wahrnehmung bei widrigen Wetterbedingungen ausschließlich mithilfe von Lidar zu verbessern, können sicherheitskritische Anwendungen wie das autonome Fahren zuverlässiger werden.

Verbesserung des Trainings durch Datenerweiterung

Während Datenerweiterung in DL-Trainingsstrategien weit verbreitet ist, ist die Erzeugung von wetterspezifischem Rauschen eine besondere Herausforderung. Abschnitt 2 stellt verschiedene Methoden zur Erzeugung spezifischer Wettergeräusche in Lidar-Punktwolken vor. Die Nutzung der Datenerweiterung während des Trainings von Wahrnehmungsmodellen ist ein radialer Ansatz zur Punktwolken-Entrauschung, der in III diskutiert wurde. Das Ziel besteht nicht darin, wetterbedingte Geräusche zu entfernen, sondern das Modell an genau diese Geräusche zu gewöhnen. Es hat sich gezeigt, dass die Wetterverstärkung im Hinblick auf die Robustheit wirksamer ist als die Rauschunterdrückung, was wertvolle Hinweise darauf liefert, welche Forschungsrichtungen in Zukunft im Vordergrund stehen sollten.

Im Allgemeinen haben einige Arbeiten die Vorteile einer solchen Datenerweiterung zur Trainingszeit durch die Auswertung dieser Daten in der Aufgabe 3D-Objekterkennung demonstriert.

Viele Arbeiten befassen sich mit dem Problem, den besten Feature-Extraktor für eine robuste Lidar-Wahrnehmung unter extremen Wetterbedingungen auszuwählen. Punktbasierte und voxelisierte Methoden scheinen zumindest im Hinblick auf die Objekterkennung weniger von verstärkten Wettereffekten betroffen zu sein, was darauf hindeutet, dass durch eine sorgfältige Auswahl von Wahrnehmungsmodellen eine gewisse Robustheit erreicht werden kann. Darüber hinaus scheint es eine Wechselwirkung zwischen der Modellarchitektur und durch Unwetter verursachten Punktwolkenschäden zu geben. Die in [4] vorgeschlagene Feuchtgebietserweiterung half nur einigen Modellen und zeigte, dass durch Strahlenstreuung verursachte Erkennungsprobleme je nach Modellarchitektur mehr oder weniger schwerwiegend sind.

Darüber hinaus scheinen die Größe und Form von Objekten eine Rolle beim Grad der Leistungsverschlechterung eines Erkennungsmodells zu spielen. Das bedeutet, dass kleinere und unterrepräsentierte Klassen, wie etwa die Radfahrerklasse im STF-Datensatz, anfälliger für Wetterveränderungen sind als besser repräsentierte Klassen, wie etwa Autos und Fußgänger. Daher ist die Anzahl der (klaren) annotierten Objekte im Trainingssatz ein guter Indikator für die Objekterkennungsleistung auch unter widrigen Wetterbedingungen. Dies zeigt, dass wettergestütztes Training nicht nur zur Verbesserung der Erkennungsleistung bei klarem Wetter beiträgt, sondern interessanterweise auch den gegenteiligen Effekt zu haben scheint.

Robuster Wahrnehmungsalgorithmus

Während Fusionsmethoden mit komplementären Sensoren den wetterbedingten Leistungsabfall jedes Sensors mildern können, können sie nur als Lösung für aktuelle praktische Probleme dienen. Änderungen der Wetterbedingungen können als Sonderfall der Domänenübertragung betrachtet werden, und daher können die zur Überbrückung der Domänenlücke entwickelten Methoden auf die Domänenübertragung von Wetter zu Wetter (z. B. Sonne/Nebel/Schnee) angewendet werden. [77] bieten einen umfassenden Überblick über adaptive Methoden im aktuellen Stand der Technik, befassen sich jedoch hauptsächlich mit Problemen im Zusammenhang mit unterschiedlichen Sensorauflösungen oder verfügbaren Daten und deren Bezeichnungen.

In [78] schlugen die Autoren eine Domänenübertragung von Datensatz zu Datensatz vor, die indirekt Wetteränderungen einschließt. Sie verwendeten eine Lehrer-Schüler-Umgebung zur Objekterkennung, bei der die Lehrer für Waymo Open (sonnige Tage) geschult wurden und Etiketten für teils Waymo Open und teils Kirkland (regnerische Tage) erstellten, während die Schüler in allen Etiketten geschult und auf Kirkland angewendet wurden. Interessanterweise schienen die Schüler die Zieldomäne besser zu verallgemeinern, was darauf hindeutet, dass sie mit Unwettern zurechtkamen. Es ist jedoch zu beachten, dass Domänenlücken nicht auf Änderungen zwischen Wetterbedingungen beschränkt sind und andere Faktoren wie Sensorauflösung und Kennzeichnungsstrategien wetterbedingte Lücken überdecken können. Die Autoren von

[79] schlugen eine robuste Objekterkennungspipeline vor, die einen Aufmerksamkeitsmechanismus und eine globale kontextbezogene Merkmalsextraktion umfasst und es dem Modell ermöglicht, wetterbedingte Geräusche zu ignorieren und gleichzeitig die gesamte Szene zu verstehen. Obwohl ihre Methode in beiden Domänen (KITTI, sonnig und CADC, regnerisch) gleichzeitig nicht gut funktioniert, liefert das gemeinsame Training auf Basis des maximalen Differenzverlusts vielversprechende Ergebnisse und schneidet sowohl in der Quell- als auch in der Zieldomäne gut ab. Auch hier ist unklar, welche Elemente des Modells auf Änderungen der Wetterbedingungen selbst zurückzuführen sind, da die Variation von Datensatz zu Datensatz sehr stark zu sein scheint.

[80] konzentriert sich auf die Minderung der wetterbedingten Sensorbeeinträchtigung von RGB-Kameras und Lidar. Obwohl sie die Sensorfusion (abgeleitet von der in [21] vorgeschlagenen Entropiefusion) sowie die Datenerweiterung von zwei Sensoren nutzen, fördern ihre Arbeiten stark die Verwendung einer Reihe von Methoden zur Überbrückung der Lücke mit mehreren unbekannten Zieldomänen zur Zielerkennung. Dies erreichen sie durch die Einführung von Domänendiskriminatoren und selbstüberwachtem Lernen durch Pre-Training-Strategien. Ihre Ergebnisse zeigen, dass sich ihre multimodale Multiobjekt-Domänenanpassungsmethode beispielsweise gut auf Nebelszenen übertragen lässt.

06 Diskussion und Schlussfolgerung

In diesem Umfragepapier skizziert dieses Papier die aktuellen Forschungsrichtungen in der Lidar-basierten Umgebungswahrnehmung für autonomes Fahren unter extremen Wetterbedingungen. Das Papier bietet eine eingehende Analyse und Diskussion der Verfügbarkeit von Trainingsdaten für Deep-Learning-Algorithmen, wahrnehmungsunabhängiger Punktwolkenverarbeitungstechniken zur Erkennung von Wetterbedingungen und zur Rauschunterdrückung von Lidar-Scans sowie modernste Methoden für eine robuste Lidar-Wahrnehmung . Im Folgenden werden die vielversprechendsten Forschungsrichtungen zusammengefasst und verbleibende Lücken identifiziert.

Ungünstige Wetterdaten: Es gibt mehrere autonome Fahrdatensätze einschließlich Lidar-Sensoren, die auch widrige Wetterbedingungen abdecken. Die meisten von ihnen bieten Objektbezeichnungen, aber nur eines verfügt über punktuelle Klassenbezeichnungen. Es ist klar, dass geeignete reale Datensätze benötigt werden, um die wachsende Zahl von Deep-Learning-basierten Lidar-Sensoralgorithmen zu trainieren und zu validieren. Einige Arbeiten verwenden wetterspezifische Datenanreicherung, um ungünstige Wettereffekte zu simulieren, es fehlt jedoch eine Methode zur Bewertung der Realitätsnähe der erzeugten Anreicherungen.

Punktwolkenverarbeitung und Rauschunterdrückung: Verschiedene Lidar-Technologien reagieren unterschiedlich auf widrige Wetterbedingungen. Während die Sensorverschlechterung unter extremen Wetterbedingungen intensiv untersucht wurde, mangelt es an einer systematischen Analyse der Auswirkungen auf Sensoralgorithmen. Hier werden Methoden zur Abschätzung der Sensordegradation nützlich sein. Darüber hinaus gibt es derzeit laufende Forschungen zum Cloud-Denoising, doch bestehende statistische Methoden haben sich als weniger effektiv erwiesen als die Verwendung von Methoden zur Wetterverstärkung im Training. Moderne Methoden, etwa auf Basis von CNNs oder GANs, könnten diese Lücke schließen.

Robuste Lidar-Sensorik: Viele Forschungsarbeiten konzentrieren sich auf die Eindämmung der Sensorverschlechterung mithilfe der Sensorfusion. Obwohl dies zu überzeugenden Ergebnissen führte, sollte die Verbesserung der Wahrnehmungsfähigkeiten allein durch Lidar bei widrigen Wetterbedingungen nicht übersehen werden. Ausgefeilte Domänenanpassungsmethoden wie Anomalieerkennung oder Unsicherheitsmodellierung können zur Lösung dieses Problems beitragen. Die Beobachtung des Vorhandenseins von wetterbedingtem Lärm in Lidar-Punktwolken aus einer anderen Perspektive könnte neue Forschungsströme eröffnen, die die durch widrige Wetterbedingungen verursachten Lücken im Feld schließen. Die Qualität der Untersuchung von Lücken in diesem Bereich lässt das Potenzial eines allgemeinen Ansatzes zur Domänenanpassung erkennen.

Das obige ist der detaillierte Inhalt vonLiDAR-Sensortechnologielösung unter extremen Wetterbedingungen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Beherrschen Sie die Koordinatensystemkonvertierung wirklich? Multisensorik-Themen, die für das autonome Fahren unverzichtbar sind

Oct 12, 2023 am 11:21 AM

Beherrschen Sie die Koordinatensystemkonvertierung wirklich? Multisensorik-Themen, die für das autonome Fahren unverzichtbar sind

Oct 12, 2023 am 11:21 AM

Der erste Pilot- und Schlüsselartikel stellt hauptsächlich mehrere häufig verwendete Koordinatensysteme in der autonomen Fahrtechnologie vor und erläutert, wie die Korrelation und Konvertierung zwischen ihnen abgeschlossen und schließlich ein einheitliches Umgebungsmodell erstellt werden kann. Der Schwerpunkt liegt hier auf dem Verständnis der Umrechnung vom Fahrzeug in den starren Kamerakörper (externe Parameter), der Kamera-in-Bild-Konvertierung (interne Parameter) und der Bild-in-Pixel-Einheitenkonvertierung. Die Konvertierung von 3D in 2D führt zu entsprechenden Verzerrungen, Verschiebungen usw. Wichtige Punkte: Das Fahrzeugkoordinatensystem und das Kamerakörperkoordinatensystem müssen neu geschrieben werden: Das Ebenenkoordinatensystem und das Pixelkoordinatensystem. Schwierigkeit: Sowohl die Entzerrung als auch die Verzerrungsaddition müssen auf der Bildebene kompensiert werden. 2. Einführung Insgesamt gibt es vier visuelle Systeme Koordinatensystem: Pixelebenenkoordinatensystem (u, v), Bildkoordinatensystem (x, y), Kamerakoordinatensystem () und Weltkoordinatensystem (). Es gibt eine Beziehung zwischen jedem Koordinatensystem,

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Oct 23, 2023 am 11:13 AM

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Oct 23, 2023 am 11:13 AM

Einige persönliche Gedanken des Autors Im Bereich des autonomen Fahrens sind mit der Entwicklung BEV-basierter Teilaufgaben/End-to-End-Lösungen hochwertige Multi-View-Trainingsdaten und der entsprechende Aufbau von Simulationsszenen immer wichtiger geworden. Als Reaktion auf die Schwachstellen aktueller Aufgaben kann „hohe Qualität“ in drei Aspekte zerlegt werden: Long-Tail-Szenarien in verschiedenen Dimensionen: z. B. Nahbereichsfahrzeuge in Hindernisdaten und präzise Kurswinkel beim Schneiden von Autos sowie Spurliniendaten . Szenen wie Kurven mit unterschiedlichen Krümmungen oder Rampen/Zusammenführungen/Zusammenführungen, die schwer zu erfassen sind. Diese basieren häufig auf der Sammlung großer Datenmengen und komplexen Data-Mining-Strategien, die kostspielig sind. Echter 3D-Wert – hochkonsistentes Bild: Die aktuelle BEV-Datenerfassung wird häufig durch Fehler bei der Sensorinstallation/-kalibrierung, hochpräzisen Karten und dem Rekonstruktionsalgorithmus selbst beeinträchtigt. das hat mich dazu geführt

4K-HD-Bilder ganz einfach verstehen! Dieses große multimodale Modell analysiert automatisch den Inhalt von Webplakaten und ist damit für Mitarbeiter sehr praktisch.

Apr 23, 2024 am 08:04 AM

4K-HD-Bilder ganz einfach verstehen! Dieses große multimodale Modell analysiert automatisch den Inhalt von Webplakaten und ist damit für Mitarbeiter sehr praktisch.

Apr 23, 2024 am 08:04 AM

Ein großes Modell, das den Inhalt von PDFs, Webseiten, Postern und Excel-Diagrammen automatisch analysieren kann, ist für Mitarbeiter nicht besonders praktisch. Das von Shanghai AILab, der Chinesischen Universität Hongkong und anderen Forschungseinrichtungen vorgeschlagene Modell InternLM-XComposer2-4KHD (abgekürzt IXC2-4KHD) macht dies Wirklichkeit. Im Vergleich zu anderen multimodalen großen Modellen, deren Auflösungsgrenze nicht mehr als 1500 x 1500 beträgt, erhöht diese Arbeit das maximale Eingabebild multimodaler großer Modelle auf eine Auflösung von über 4K (3840 x 1600) und unterstützt jedes Seitenverhältnis und 336 Pixel bis 4K Dynamische Auflösungsänderungen. Drei Tage nach seiner Veröffentlichung stand das Modell an der Spitze der Beliebtheitsliste der visuellen Frage-Antwort-Modelle von HuggingFace. Einfach zu bedienen

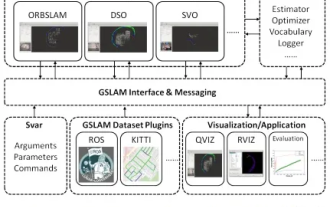

GSLAM |. Eine allgemeine SLAM-Architektur und ein Benchmark

Oct 20, 2023 am 11:37 AM

GSLAM |. Eine allgemeine SLAM-Architektur und ein Benchmark

Oct 20, 2023 am 11:37 AM

Plötzlich wurde ein 19 Jahre altes Papier namens GSLAM: A General SLAM Framework and Benchmark mit offenem Quellcode entdeckt: https://github.com/zdzhaoyong/GSLAM Gehen Sie direkt zum Volltext und spüren Sie die Qualität dieser Arbeit~1 Zusammenfassung der SLAM-Technologie hat in letzter Zeit viele Erfolge erzielt und die Aufmerksamkeit vieler High-Tech-Unternehmen auf sich gezogen. Es bleibt jedoch eine Frage, wie eine Schnittstelle zu bestehenden oder neuen Algorithmen hergestellt werden kann, um ein Benchmarking hinsichtlich Geschwindigkeit, Robustheit und Portabilität effizient durchzuführen. In diesem Artikel wird eine neue SLAM-Plattform namens GSLAM vorgeschlagen, die nicht nur Evaluierungsfunktionen bietet, sondern Forschern auch eine nützliche Möglichkeit bietet, schnell ihre eigenen SLAM-Systeme zu entwickeln.

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

Bitte beachten Sie, dass dieser kantige Mann die Stirn runzelt und über die Identität der „ungebetenen Gäste“ vor ihm nachdenkt. Es stellte sich heraus, dass sie sich in einer gefährlichen Situation befand, und als ihr dies klar wurde, begann sie schnell mit der mentalen Suche nach einer Strategie zur Lösung des Problems. Letztendlich entschloss sie sich, vom Unfallort zu fliehen, dann so schnell wie möglich Hilfe zu suchen und sofort Maßnahmen zu ergreifen. Gleichzeitig dachte die Person auf der Gegenseite das Gleiche wie sie... In „Minecraft“ gab es eine solche Szene, in der alle Charaktere von künstlicher Intelligenz gesteuert wurden. Jeder von ihnen hat eine einzigartige Identität. Das zuvor erwähnte Mädchen ist beispielsweise eine 17-jährige, aber kluge und mutige Kurierin. Sie haben die Fähigkeit, sich zu erinnern und zu denken und in dieser kleinen Stadt in Minecraft wie Menschen zu leben. Was sie antreibt, ist ein brandneues,