Xi Xiaoyao Technology Talk Original

Autor |. Xiaoxi, ZenMoore

Was ist derzeit das größte Problem mit GPT-4? Vielleicht lag es, abgesehen von der vorübergehenden Halluzination der Maschine, an der er nichts ändern konnte, an der feststeckenden Eingabelänge. Obwohl die Kontextlänge von etwa 8000 in der aktuellen normalen Version von GPT-4 für allgemeine Konversations- und Suchszenarien mehr als ausreichend sein mag, ist die aktuelle Basisversion von GPT-4 in Aspekten wie Inhaltsgenerierung und intelligentem Lesen immer noch etwas gestreckt.

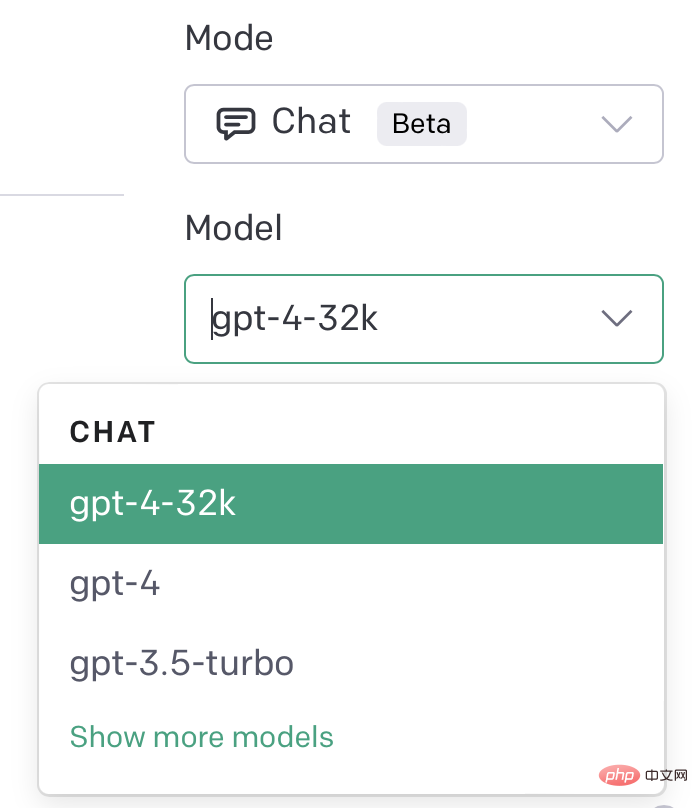

Allerdings wurde in der GPT-4-Pressekonferenz auch erwähnt, dass GPT-4 tatsächlich 32768-Token-Längen unterstützt, es jedoch noch nicht vollständig veröffentlicht wurde, sondern automatisch nacheinander aktualisiert wird. In den letzten zwei Tagen schien der Beginn von 32k GPT-4 bald bevorzustehen! Viele GPT-4-Benutzer können die GPT-4 32k-Option bereits auf ihrem PlayGround sehen.

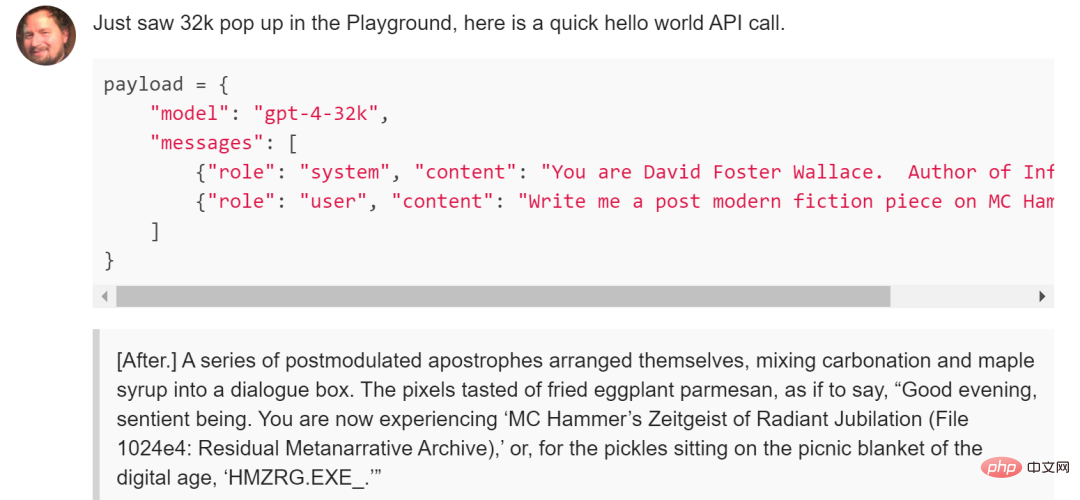

In der API können Sie auch die aktualisierte Version aufrufen, indem Sie das Modell von GPT-4-32K angeben

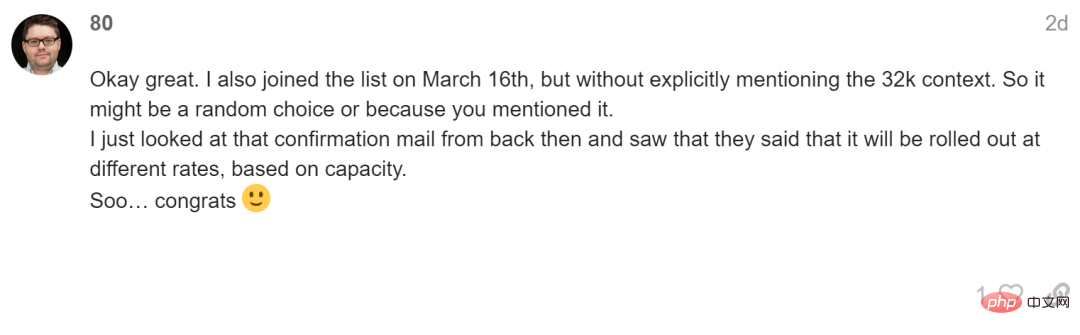

Dies sollte jedoch für einige Benutzer immer noch ein interner Test von GPT-4 sein, und das ist der Fall Das interne Testkontingent wird nicht nach dem Zeitpunkt der Bewerbung für die Warteliste freigegeben. Benutzer, die die 32k-Version des internen Tests erhalten haben, haben sich am 16. März auf die Warteliste gesetzt, es gab jedoch auch Benutzer, die sich gleichzeitig angemeldet haben und dies nicht getan haben Schalte die 32k-Version frei. Ein möglicher Grund ist, dass Nutzer, die die Closed-Beta-Version erhalten haben, bei der Registrierung ihr großes Interesse an 32k GPT-4 betont haben.

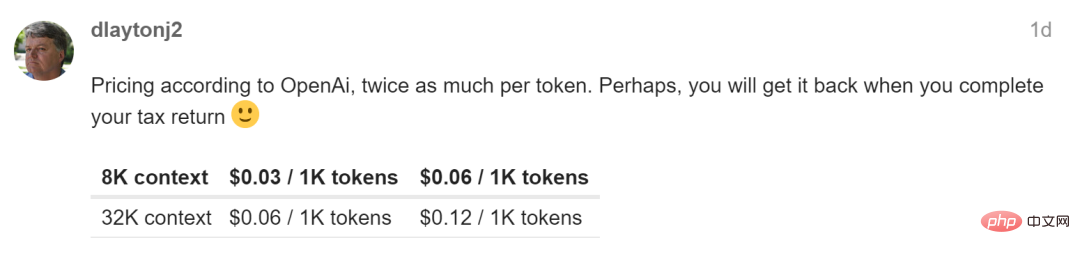

Natürlich, egal was passiert, 32k GPT-4 scheint immer näher an uns heranzukommen, also welche fantasievollen Veränderungen wird 32k GPT-4 mit sich bringen? Schließlich ist es doppelt so teuer wie die 8k-Version von GPT-4 und hat möglicherweise eine langsamere Reaktionszeit ...

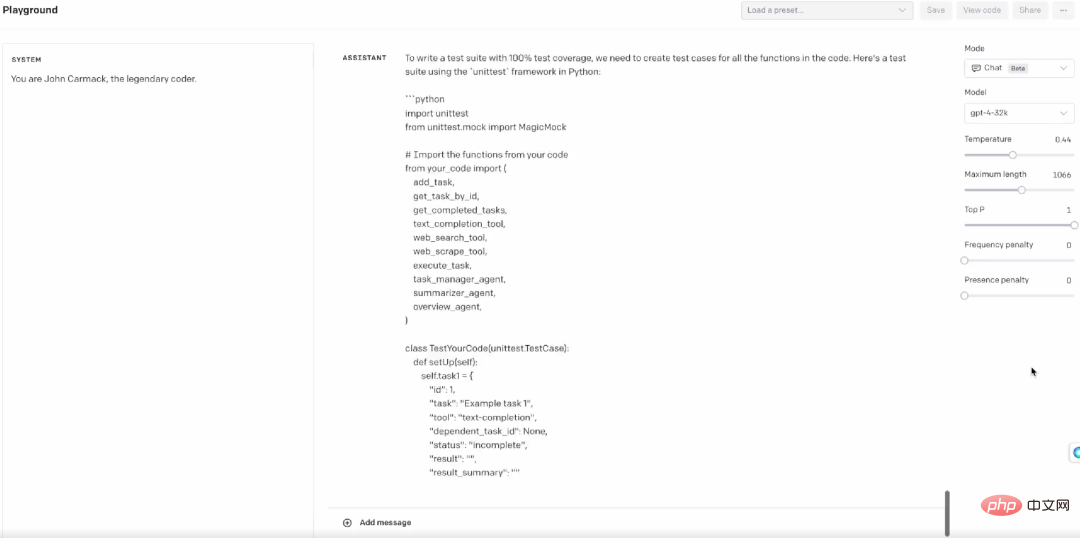

Ein Beispiel ist ein Konversationsroboter, wenn die Kontextlänge auf 50 Seiten erweitert wird Dadurch können komplexe Einbettungsprobleme, die durch das Herausschieben des 8K-Fensters verursacht werden, weitgehend vermieden werden. Ein weiteres Beispiel ist die Extraktion und Interpretation einer großen Menge komplexer Informationen wie Papiere und Forschungsberichte. Derzeit müssen die Daten durch strukturierte Methoden aufgeteilt und extrahiert werden. Die Kontextlänge von 32 KB kann diese Probleme jedoch in einem beseitigen fiel auf einen Schlag. Ein weiteres Beispiel ist ein kleiner Test des Twitter-Bloggers Matt Shumer, der GPT-4 32k mit einem Codebeispiel ausstattete und einen vollständigen Satz von Testfällen in wenigen Sekunden abschloss, was auch für das Engineering sehr nützlich ist.

Neben OpenAI gibt es auch Open-Source-Modelle, die groß angelegte Sprachmodelle mit noch größeren Kontextlängen erschließen. Dieser MPT-7B (auch bekannt als Llongboi) wurde am 5. dieses Monats veröffentlicht. Das größte Highlight von Llongboi, dessen Schulung 200.000 US-Dollar kostete, ist, dass er 64k-Kontext unterstützt und eine Vielzahl von Szenarien wie die Generierung von Inhalten bedienen kann und chatten.

Blog-Adresse: https://www.php.cn/link/894a200a66c2b57205af564d6883882a

Projektlink: https://www.php.cn/link/18fe8ebf5d52c8992581f 43 9ba783aa3

Natürlich offen Quellprojekte Die Leistung und Stabilität sind definitiv nicht mit GPT-4 vergleichbar. Nachdem einige Leute begonnen haben, Einladungen für 32k GPT-4 zu erhalten, glaube ich, dass es uns definitiv bald treffen wird, also lassen Sie uns „Hoffentlich nimmt das Tempo zu.“ Bar!

Das obige ist der detaillierte Inhalt vonGPT-4 hat mit internen Tests der Version mit 32.000 Eingabelängen begonnen! Haben Sie die Einladung erhalten?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So vergleichen Sie den Dateiinhalt zweier Versionen in Git

So vergleichen Sie den Dateiinhalt zweier Versionen in Git

Oracle klare Tabellendaten

Oracle klare Tabellendaten

Java-Rundungsmethode

Java-Rundungsmethode

Die Druckerinstallation ist fehlgeschlagen

Die Druckerinstallation ist fehlgeschlagen

So machen Sie einen Git-Commit-Fehler rückgängig

So machen Sie einen Git-Commit-Fehler rückgängig

Edge-Browser-Kompatibilitätseinstellungen

Edge-Browser-Kompatibilitätseinstellungen

So beheben Sie Fehler, die bei der GeForce-Erfahrung aufgetreten sind

So beheben Sie Fehler, die bei der GeForce-Erfahrung aufgetreten sind

So drücken Sie den Breitenwert in CSS aus

So drücken Sie den Breitenwert in CSS aus